基于多特征融合相关滤波的红外目标跟踪

韩亚君,杨德东,李 勇,李雪晴

(河北工业大学 人工智能与数据科学学院,天津 300130)

1 引 言

红外目标跟踪在生活以及军事方面有着广泛的应用,具有研究价值。因其自身所具有的分辨率低、对比度差、信噪比低、纹理信息缺失等特点,同时在目标跟踪过程中又存在着目标形变、遮挡、快速运动、旋转等需要解决的问题,从而使得红外目标跟踪成为一项较难的挑战。

红外目标跟踪算法最初是由可见光目标跟踪算法发展而来的,而在可见光目标跟踪算法中,核相关滤波器[1](KCF)、空间正则化判别式相关滤波器[2](SRDCF)和上下文感知滤波器[3](CA-CF)是相关滤波算法中兼备较好的实时性和有效性的跟踪算法,因此,有许多学者在此基础上进行了算法改进并应用于红外目标跟踪,从而解决红外目标跟踪过程中的问题。赵东[4]等提出一种基于图像引导滤波和核相关滤波的红外弱小目标跟踪算法,可以有效区分背景边缘和红外弱小目标。Asha[5]等提出了一种基于判别法和生成法相结合的红外图像目标跟踪方法。利用空间特征的核相关滤波器和像素强度特征的AdaBoost分类器两种互补方法进行并行运算,在通过判别方法获得优化位置后,通过线性搜索方法来确定最佳目标位置。刘先红[6]等将引导滤波、高斯低通滤波与非下采样方向滤波器组相结合,提出一种新的图像融合方法。杨福才[7]等提出基于稀疏编码直方图(HSC)特征和扰动感知模型(DAM)的红外目标跟踪方法,利用扰动感知模型来减轻背景干扰影响。Gao等[8]提出了一种结合背景自相关特征和目标在时空域的共性特征的红外目标协同检测模型,通过对Logistic Sigmoid函数构造非线性权重和在局部加权熵设置入口权重方法来抑制背景,然后对单个帧的密集和稀疏重构映射进行位置关联,提高区分目标和背景能力。

目标跟踪算法跟踪成功的关键之处在于特征的提取。方向梯度直方图(HOG)特征利用梯度信息,可以很好地描述图像局部的形状信息,对平移、旋转和光照变化鲁棒性强。运动特征信息能够描述目标的大致运动方向,是描述目标的一个重要视觉特征[9]。位移光流法对大目标的运动变化鲁棒性强。

受上述算法和背景感知相关滤波器跟踪算法[10]的启发,本文提出一种基于多特征融合的稳健红外目标算法,并利用空间加权窗代替余弦窗来抑制边缘效应。为了更好地验证本文算法的性能,在VOT-TIR2016数据集上进行测试,同时与15种流行算法进行比较。实验结果表明本文提出算法在精确度和成功率上的得分都得到了提升,具有一定的研究价值。

2 本文算法

针对红外目标跟踪任务中存在的问题,提出多特征融合的方法对红外目标进行跟踪,使用线性求和方式对HOG特征和运动特征的响应图进行综合,并利用空间窗加权方法代替余弦窗,更好地突出跟踪目标中心的特征,抑制边缘效应。

2.1 跟踪算法

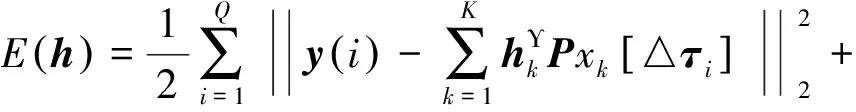

在空间域中,多通道背景感知滤波器模板[10]可通过最小化以下目标函数来实现:

(1)

其中:Q为训练样本数,K是特征通道数,y∈RT是期望响应值,T是滤波器模板维数,xk∈RT和hk∈RD分别为第k个通道的目标特征和滤波器(T≫D),P是D×T维的二进制矩阵,用于对目标特征x进行裁剪,Υ为矩阵转置符号,λ为正则化系数。

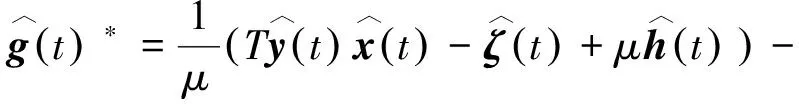

为了提高计算效率,可将上式变换到频域中进行相关计算。在频域内,目标函数可表示为:

(2)

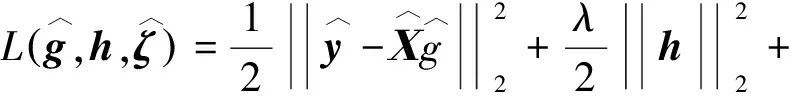

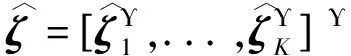

为了求解公式(2),可用增广拉格朗日函数进行扩展,可得:

(3)

(4)

(5)

采用式(6)对拉格朗日系数进行更新:

(6)

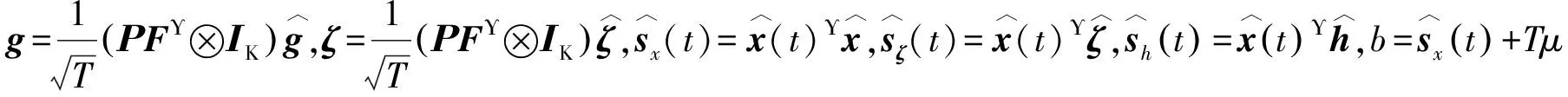

本文算法原理图如图1所示,主要跟踪步骤如表1所示。下面将对本文算法关键部分进行阐述。

图1 本文算法原理图Fig.1 Block diagram of the algorithm

表1 基于多特征融合相关滤波的红外目标跟踪算法

步骤2;对目标进行HOG特征提取,得到HOG特征响应图;步骤3:对目标进行运动特征提取,得到运动特征响应图;步骤4:进行特征融合,得到目标最终响应图,响应图的最大值即为目标预测位置;步骤5:对目标进行尺度估计;步骤6:对滤波器模板使用ADMM优化方法进行更新。

2.2 特征融合

本文算法通过融合HOG特征和运动特征来增强算法在复杂背景环境中的判别力,从而提高算法跟踪红外目标的鲁棒性。

2.2.1 HOG特征

HOG特征最早是由Nvaneet和Bill Triggs提出的,之后就成为了机器视觉中广泛使用的手工特征。提取HOG特征首先将图像灰度化,通过gamma校正法调整图像整体亮度;其次计算梯度,对x,y的梯度计算定义为:

Gx(x,y)=I(x+1,y)-I(x-1,y),

(7)

Gy(x,y)=I(x,y+1)-I(x,y-1),

(8)

其中:Gx、Gy分别是图像I的水平和垂直梯度,计算每个像素点的梯度。(x,y)点的梯度值和方向分别为下式:

(9)

(10)

梯度计算完成后,将图像划分为若干个8×8像素的胞元(cell),统计各个胞元的梯度方向直方图,将4×4大小的胞元串联成一个块(block),对块内的梯度方向直方图进行归一化就得到了目标图像的HOG特征。

2.2.2 运动特征

利用LDOF[11]计算出相邻两帧像素之间的光流,然后对其进行运动特征提取,最后得到运动特征响应值。根据[11],我们可假设对应的点应该具有相同灰度值或颜色,可用能量表示为:

(11)

其中:Ι1,Ι2:(Ω⊂2)→d分别为当前帧和前一帧图像,d=1是灰度图像,d=3是彩色图像,x:=(x,y)T为图像域Ω中的一点,l:=(u,v)T为光流域。

由于光照变化影响,匹配颜色或灰度值并不总是可靠的,可通过对梯度和光流域总变化的约束对式(11)进行补充,表达式分别为:

(12)

(13)

将上述3个约束结合在一起,可建立模型为:

E(l)=Ecolor+γEgradient+αEsmoooth,

(14)

LDOF对上式提出了优化方案,在此模型上进行了补充,增加了两项约束,分别为:

(15)

(16)

其中:f1和f2分别表示第1帧和第2帧特征向量的稀疏区域,代入所有约束项,可得到优化模型:

E(l)=Ecolor(l)+γEgradient(l)+

αEsmoooth(l)+βEmatch(l,l1)+Edesc(l1),

(17)

其中:α、β、γ为E(l)自动估计视频数据的可调参数。利用上述光流模型,可得到视频帧间的光流信息。对得到的光流信息进行运动特征提取,得到运动特征响应值。

2.3 空间窗加权

MOSSE[12]算法提出通过对目标原始像素值赋予余弦窗权重来突出靠近中心位置的目标,但对目标的边缘信息缺乏鲁棒性,导致跟踪性能下降,因此本文算法提出使用空间加权窗[13]来替代余弦窗,更加能突出目标中心位置的特征,同时也能抑制边界效应。

(18)

(19)

求ε(w)关于wm的偏导数,并让其为0,即:

(20)

(21)

k=T-1{T{w⊙x}H*-G},

(22)

s=F-1{K⊙H},

(23)

利用km和sm可以高效的计算偏导数:

(24)

2.4 计算最大响应位置

分别求出HOG特征响应值fHOG(I)和运动特征的响应值fMO(I)后,利用线性求和的方法,对其进行融合,可得到最终响应值为:

f(I)=γfHOG(I)+(I-γ)fMO(I),

(25)

得到最终响应图后,通过寻找响应图的最大值来确定目标中心位置,目标预测位置为:

pt=argmaxf(I).

(26)

2.5 模型更新

本文算法采用传统CF的线性插值模型更新策略,可对形变、尺度和光照变化鲁棒。第t帧的模型更新可用下式表示:

(27)

2.6 尺度估计

3 实验结果与分析

3.1 数据集与评价标准

本文算法是在MATLAB 2014b,Intel Core i3,主频为2.5 GHz,4G内存,64位WIN10操作系统上进行所有实验。为了保证实验结果的客观性,使用VOT-TIR2016红外目标跟踪数据集[14]对算法进行测试。该数据集共包括25个视频序列和跟踪目标所对应的11种属性,平均序列长度为740帧,分辨率从305×225到1 920×480像素不等。VOT-TIR 2016数据集与VOT-TIR 2015数据集相比,删除了Crossing,Horse和Rhino_behind_tree序列,引入了更困难的Bird,Boat1,Boat2,Car2,Dog,Excavator,Ragged,和Trees2序列。为了证明本文算法的有效性,提供本文算法和其他15种算法进行比较,分别是SRDCF[2],Staple[15],Staple_CA[3],TGPR[16],SAMF[17],DSST[18],ACT[19],KCF[1],DST[20],KCF_DP[21],RPT[22],HRP[23],KCF_MTSA[24],ASLA[25],PDMFD[26]。

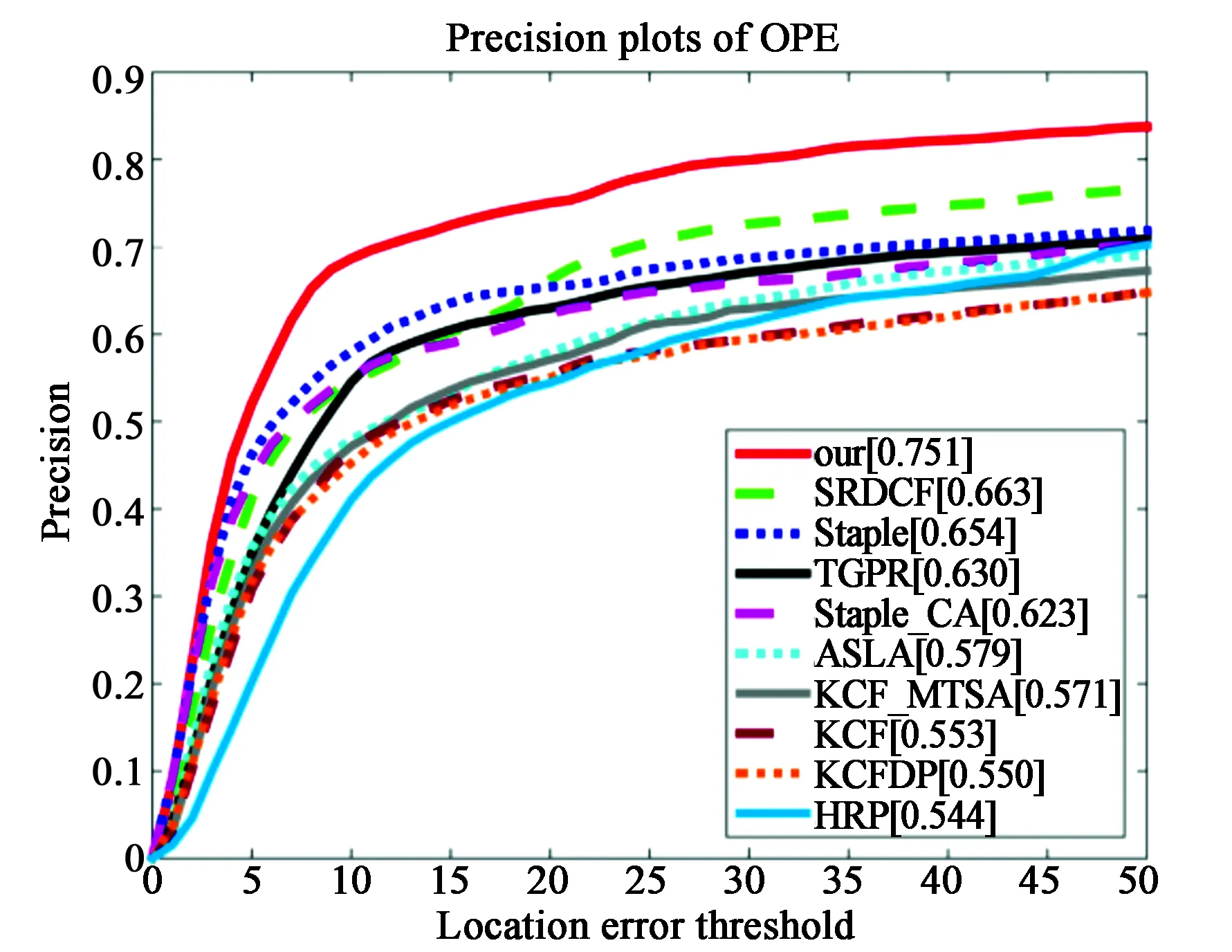

本文使用精确度(precision)和成功率(success rate)两种评价标准对本文算法的性能进行评价。精确度指的是小于中心位置误差阈值的视频帧数占总帧数的百分比,而中心位置误差定义为算法得到的跟踪目标框中心位置和标定的真实目标框的中心位置之间的欧式距离。成功率指的是跟踪目标的重叠率大于重叠率阈值的视频帧数占总帧数的百分比,重叠率定义为跟踪目标框和标定的真实目标框之间交集与并集比值[14]。

3.2 参数设置

本文通过大量的试验来确定该算法最优的参数设置,实验参数设置如下:选择31维HOG特征,cell大小设置为4×4并乘空间窗,正则化系数设置为λ=0.001,尺度池设置为5,步长为1.01。ADMM优化算法中,设置迭代次数和惩罚因子分别为2和1,第i+1次的惩罚因子用μi+1=min(μmax,βμ(i))更新,其中β=10,μ=10-3,特征融合系数设置为γHOG=0.7和γMO=0.3,更新率设置为η=0.013。

3.3 定量分析

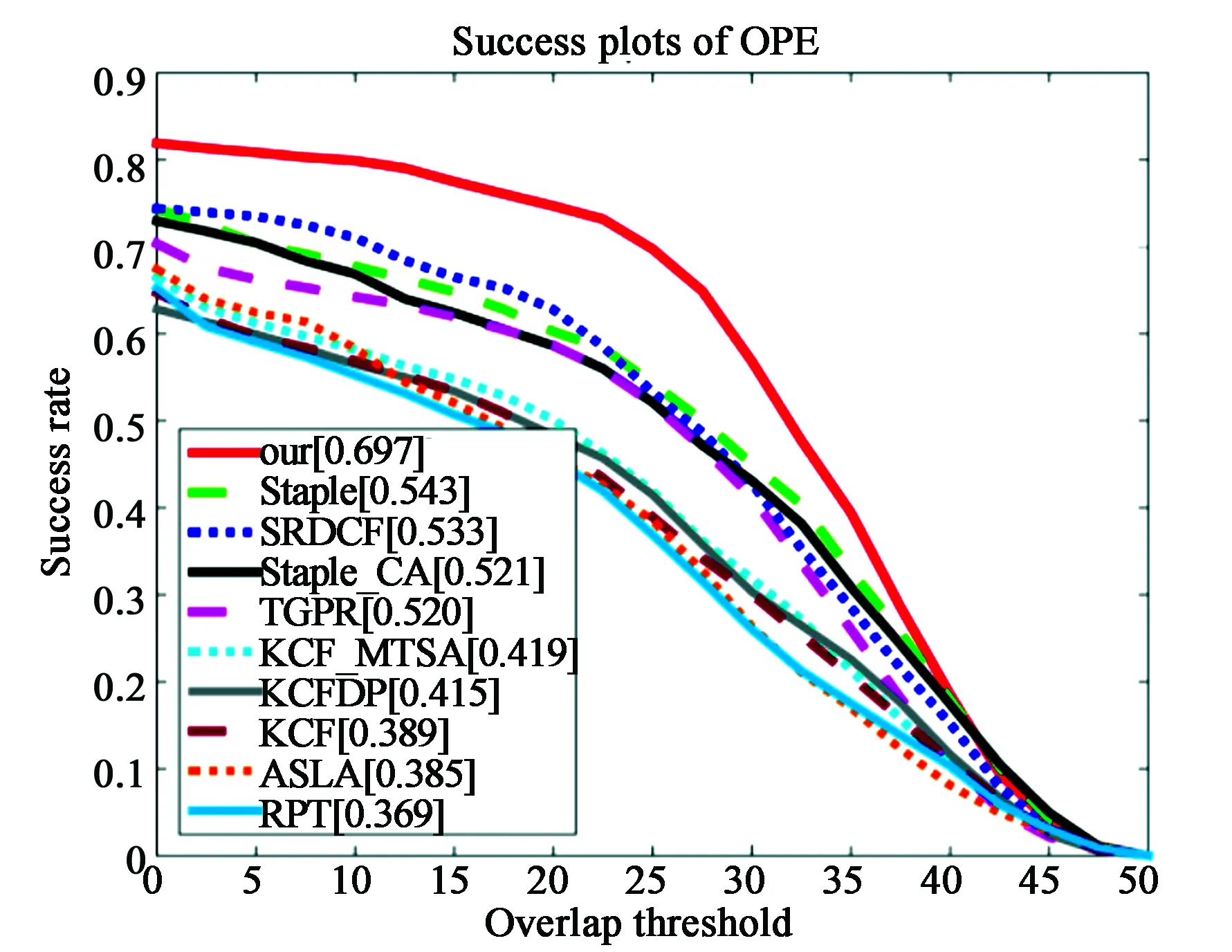

本文使用OPE(one-pass evaluation)方法[27]在所有视频序列上进行本文算法的测试。设置中心位置误差阈值为20来评估算法的精确度,设置重叠率为0.5来评估算法的成功率。为显示清晰,图2和图3分别给出结果排名前10算法的精确度图和成功率图。由图可知,本文算法与排名第二的算法相比,精确度提高了8.8%,成功率提高了15.4%,两项指标均有显著的提升,证明了本文算法的有效性和鲁棒性。

图2 25个视频序列上得到的不同算法的精确度Fig.2 Accuracy of different algorithms tested on 25 sequences

图3 25个视频序列上得到的不同算法的成功率Fig.3 Success rate of different algorithms tested on 25 sequences

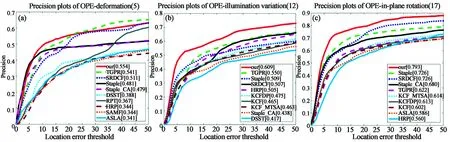

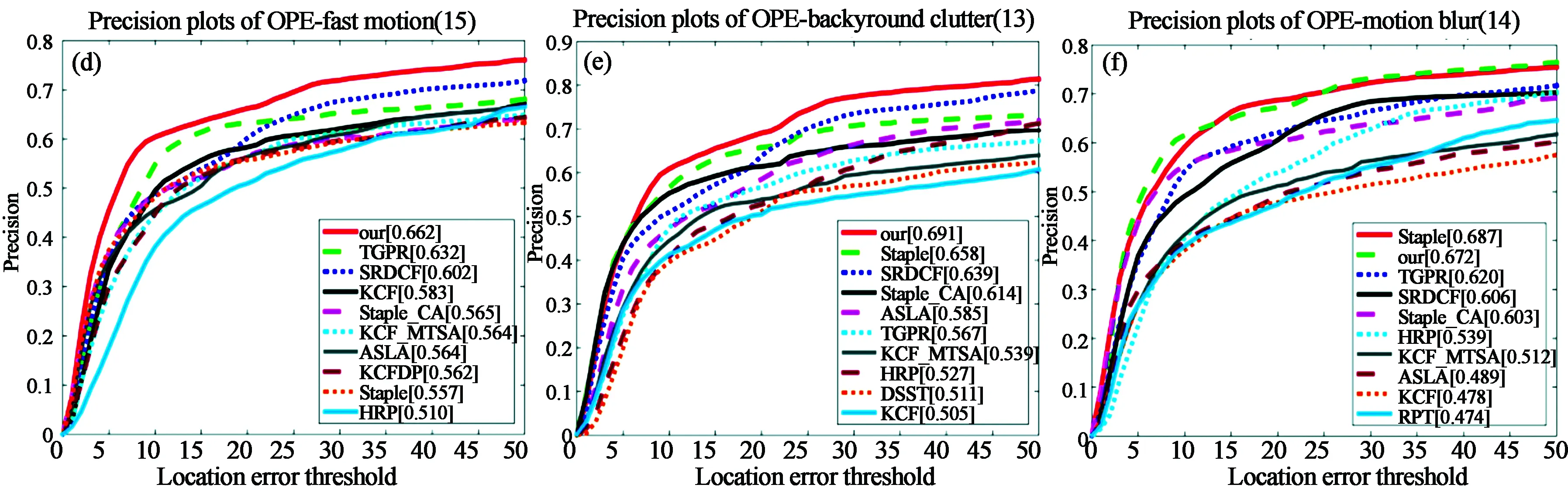

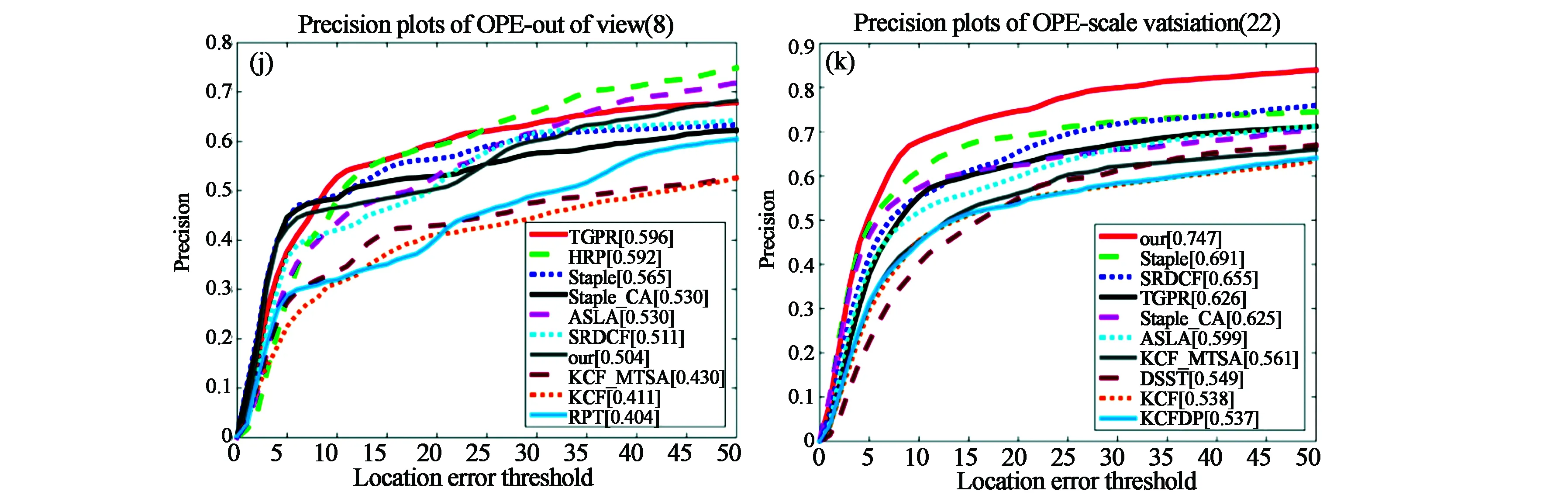

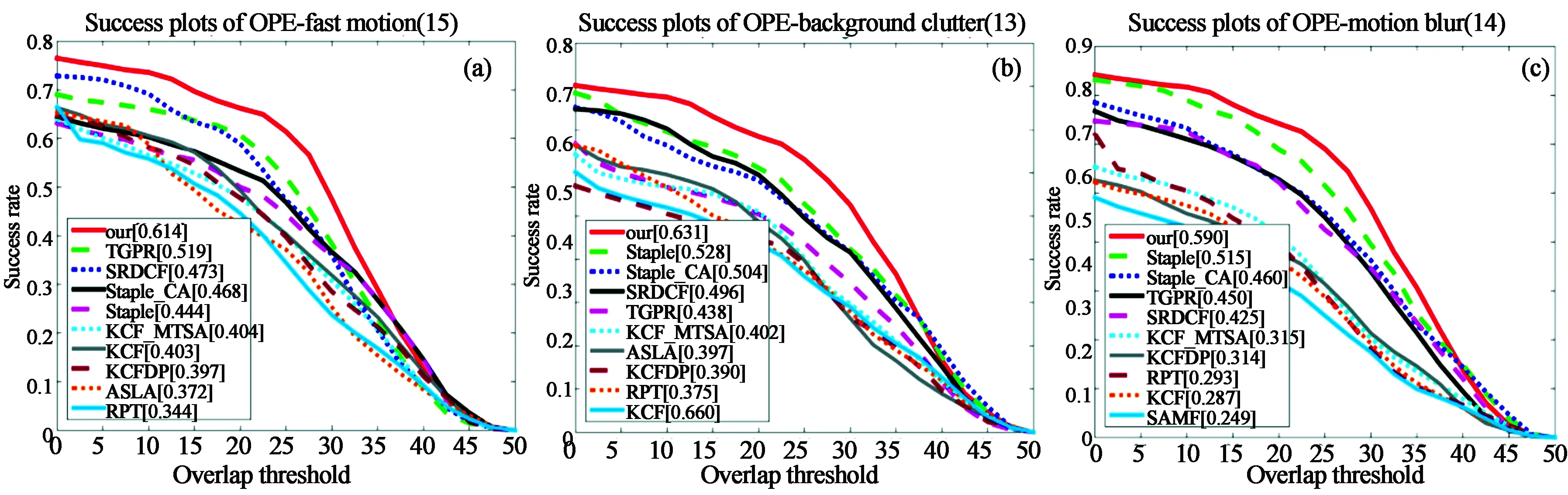

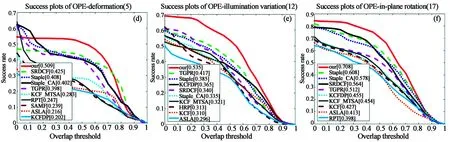

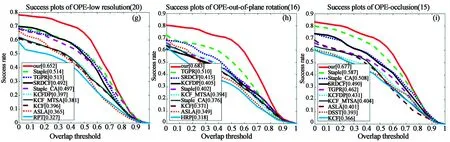

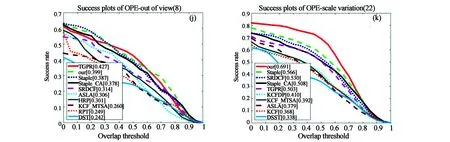

图4和图5为不同算法在11种属性上的精确度图和成功率图,为显示清晰,给出排名前十算法的结果,11种属性分别为变形(deformation)、光照变化(illustration variation)、平面内旋转(in-

图4 在11种属性上不同算法的精确度。(a)形变;(b)光照变化;(c)平面内旋转;(d)快速运动;(e)背景杂乱;(f)运动模糊;(g)低分辨率;(h)遮挡;(i)平面外旋转;(j)出视野;(k)尺度变化。Fig.4 Precision plots of different algorithms on 11 attributes. (a) Deformation; (b) Illumination variation; (c) In-plane rotation; (d) Fast motion; (e) Background clutter; (f) Motion blur; (g) Low resolution; (h) Occlusion; (i) Out-of-plane rotation; (j) Out of view; (k) Scale variation.

图5 在11种属性上不同算法的成功率。(a)形变;(b)光照变化;(c)平面内旋转;(d)快速运动;(e)背景杂乱;(f)运动模糊;(g)低分辨率;(h)遮挡;(i)平面外旋转;(j)出视野;(k)尺度变化。Fig.5 Success rate plots of different algorithms on 11 attributes. (a) Deformation; (b) Illumination variation; (c) In-plane rotation; (d) Fast motion; (e) Background clutter; (f) Motion blur; (g) Low resolution; (h) Occlusion; (i) Out-of-plane rotation; (j) Out of view; (k) Scale variation.

plane rotation)、快速运动(fast motion)、背景杂乱(background clutter)、运动模糊(motion blur)、低分辨率(low resolution)、遮挡(occlusion)、平面外旋转(out-plane rotation)、出视野(out of view)、尺度变化(scale variation)[28]。从图4中可看出,本文算法在运动模糊和出视野两种属性上精度排名第二,在其余9种属性上均表现出良好效果。可证明本文算法可以很好的处理红外目标尺度变化、变形、快速运动、平面内外旋转等问题。从图5中可看出,对于在出视野之外的属性,本文算法比排名第二的算法均有显著提高,说明融合特征以及空间窗的引入可以极大的提高算法的精确度和成功率,证明了本文算法的有效性。

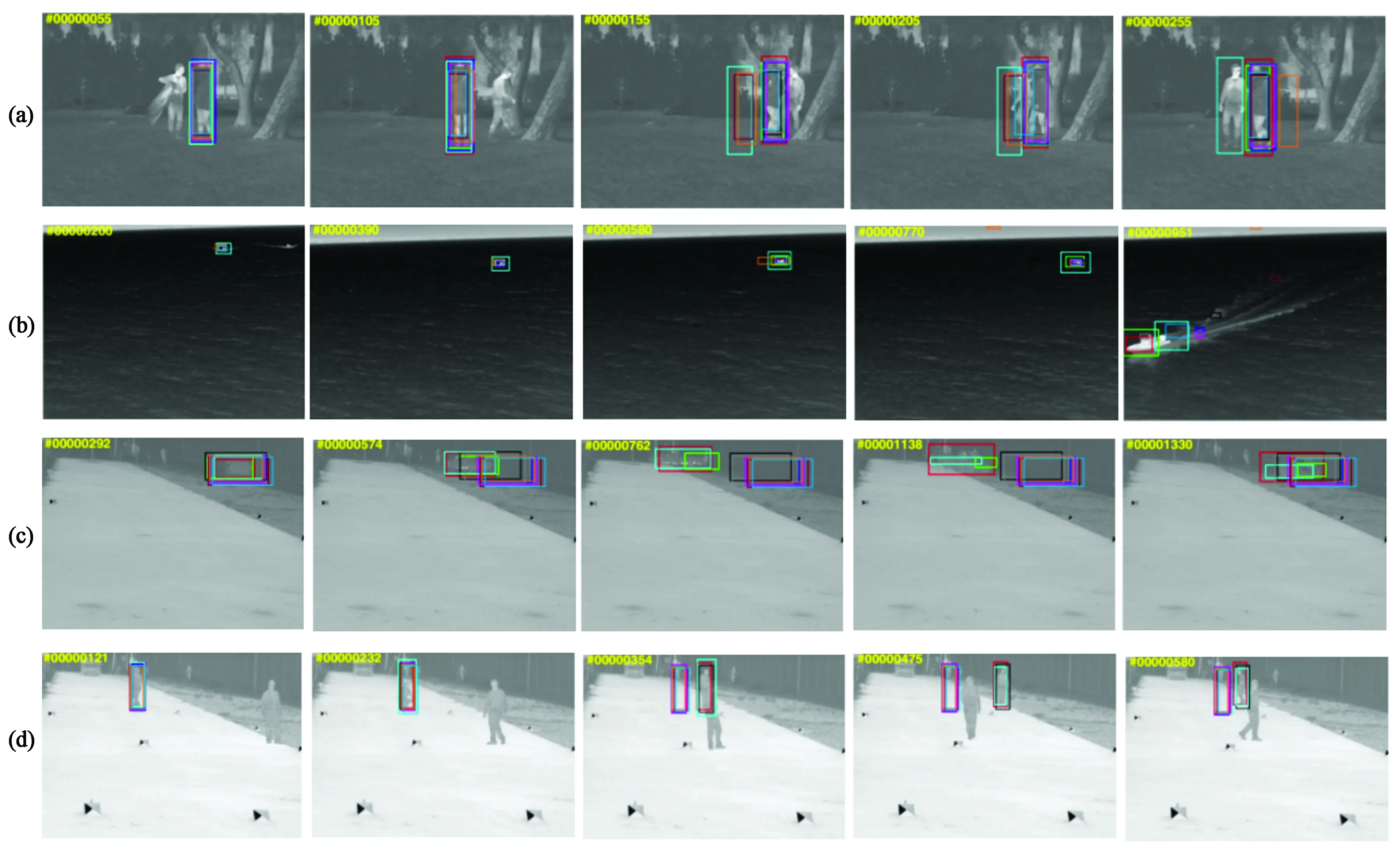

3.4 定性分析

为了更好的分析本文算法的性能,给出本文算法和其他9种算法在25个视频序列上的目标跟踪结果,如图6所示。当跟踪目标经历不同变化时,针对相应的属性进行分析和比较。

(1)形变。在birds和crouching视频序列中,当目标发生形变时,只有少数算法能够利用有效的红外信息提取关键特征,实现精准目标跟踪,本文算法为其中之一。在birds视频序列中,当目标在第105帧和第225帧发生形变时,只有本文算法和SRDCF、Staple、Staple_CA和TGPR算法能正确跟踪。在crouching视频序列中,当目标在第232帧下蹲之后又在第354帧站起来行走时,发生了较大的形变,只有本文算法和TGPR、ASLA算法没有发生漂移,能正确跟踪,说明了本文算法较好的鲁棒性。

(2)遮挡。遮挡视频序列有hiding和trees1。其中,hiding视频序列属于完全遮挡,而trees2视频序列属于部分遮挡。在hiding视频序列中,当第173帧目标完全被遮挡,第248帧目标再出现的时候,只有本文算法和HRP、ASLA算法能准确跟踪,并且在后续跟踪中,本文算法没有发生漂移。在trees1视频序列中,当目标经历遮挡后可从第272帧和第403帧看出,有4种算法跟踪失败,而本文算法能够正确跟踪,证明本文算法有很好的处理遮挡能力。

(3)平面外旋转。25个视频序列中有很多视频都具有平面外旋转属性,其中包括birds、car1、crouching、depthwise_crossing和jacket等。下面将针对car1和jacket视频序列进行该属性分析。在car1视频序列中,当目标在第574帧、第762帧、第1 138帧发生平面外旋转时,只有本文算法未发生漂移,能够准确跟踪目标,其他算法都跟踪失败。在jacket视频序列中,当目标在第586帧发生平面外旋转(转身)时,只有本文算法和SRDCF、Staple算法没有跟踪失败,得益于本文算法的特征融合,能够对红外目标正确跟踪。

(4)背景杂乱。由于红外目标缺少颜色、纹理等信息,当目标处在背景杂乱的情况下,目标跟踪十分困难。而在mixed_distractors和staturated视频序列中都存在背景杂乱的情况。下面将逐一进行分析。在mixed_distractors视频序列中,由于背景有很多相似物体,使得目标跟踪算法很容易发生漂移。在视频的第114帧,当目标经过第一个相似物体时,只有本文算法会和SRDCF算法未发生漂移,其他算法都跟踪失败,但是在后续跟踪中,SRDCF算法发生了漂移,导致跟踪失败,而本文算法可以一直很好的跟踪。在staturated视频序列中,我们可看出背景中有很多和目标相似的物体,具有很大的干扰性,而本文算法可以很好的跟踪目标。证明了本文算法适用于背景杂乱的场景,有很好的鲁棒性。

(5)尺度变化。尺度变化是目标跟踪中比较常见和基础的问题,当目标缩小时,滤波器就会学习到大量背景信息,当目标扩大时,滤波器就会跟着目标局部纹理走丢。视频序列boat2和mixed_distractors都存在尺度变化情况。在boat2视频序列中,从第951帧可看出,当目标越来越近时,目标尺度也是越来越大,只有本文算法能有效的对变化的目标进行尺度估计,其余算法都跟踪失败。在mixed_distractors视频序列中,目标在第218帧坐下时,本文算法可对目标尺度变化进行自适应估计,调整为相应大小的目标框,减少了背景信息的引入,提高了跟踪算法的精度和成功率。由此可说明本文算法尺度估计的有效性。

4 结 论

本文提出基于多特征融合的红外目标跟踪算法,在背景感知相关滤波器的框架下,对红外目标进行HOG特征和运动特征提取,通过线性求和方式对特征进行融合,使得跟踪算法对目标的形变、快速运动、遮挡等属性能有较好的鲁棒效果。同时采用空间加权窗代替传统相关滤波器中的余弦窗,更加突出目标特征,也能抑制边界效应。本文算法采用VOT TIR2016数据集进行性能测试,并和15种流行算法进行了分析和比较,结果表明,本文算法在精确度和成功率上的得分分别为0.751和0.697,在精确度和成功率方面分别提高了8.8%和15.4%,证明了本文算法的有效性和鲁棒性,具有一定的研究价值。目前本文算法不适用于红外低分辨率目标跟踪任务,对光照变化情况处理不是很好,这将是未来改进的主要方向。