机器学习在频谱大数据分析与处理上的应用*

史 通,王 洁,罗 畅,肖 军,王世强

(空军工程大学防空反导学院,西安 710051)

0 引言

在当今这个科技飞速进步的世界,各个领域产生的数据正在以前所未有的速度爆炸式扩增。大数据(big data)的概念便应运而生。然而大数据的定义不一而足,视特定场景而定。全球知名咨询公司麦肯锡给出的说法是“超越典型数据库软件工具所能获取、存储、管理和分析的数据集[1]”。

大数据的特点首先在于“大”。那么,大数据到底有多大呢?互联网数据中心报告预测,近几年的全球总数据量将从艾字节(exabyte,EB,1EB=1018B)向泽字节(zettabyte,ZB,1ZB=1021B)乃至更高的数量级增长[2]。但是大数据的价值更多地体现在隐藏于“冰山一角”之下的待开发、待挖掘的信息资源。只要得到充分的开发与挖掘,大数据就是一座无穷的宝藏。因此,大数据在世界范围内受到了越来越多的关注,大数据的浪潮正在席卷全球。

传统的方法已经无法分析与处理如此庞大又复杂的数据。如何用更加智能、深度、便捷的方法来“学习”大数据成为一项亟待解决的挑战。

学习是一种获取知识与技能以达到提升自我能力的行为方式。一般认为,机器学习是通过创建一个计算系统,使其不断地从大量的知识中学习经验,并自行改善计算性能,更好地执行下次任务。那么,大数据显然就成为了机器学习的“营养丰富的食粮”。

近年来,机器学习的新理论不断被提出,大数据的采集传输技术发展迅速,计算机的性能也得到极大提升等等,这些因素都不断推动着机器学习进一步发展[3]。机器学习已经在语音识别、图像识别、数据挖掘、机器人控制等诸多领域取得了显著的进展。

1 频谱大数据

无线通信作为通信的主要方式,技术成熟且未来发展空间巨大。顾名思义,无线通信是数据不通过实体线缆传输的一种通信方式,它是通过频谱在9 kHz到300 000 GHz之间的电磁载波来进行数据传输的。

每一种无线业务都对应于无线频谱中的某一特定的区域。现存的无线业务已经能够产生海量的频谱数据,社会的不断进步更使得频谱数据的广度和深度不断扩增。频谱大数据(big spectrum data)的存在已成事实。频谱大数据是指超越典型的频谱数据软件工具所能分析与处理的,反映电磁频谱空间状态、演化及其规律的海量的复杂的频谱数据集,主要包括以下几个方面[4]:

1)频谱状态数据,比如在不同时间、不同空间、不同频率时,信号表现出来不同特征,所产生不同的频谱状态数据。

2)用户相关数据,比如用户的地址数据,用户发送与接收的数据,用户所用设备的状态数据等等。

3)环境相关数据,不仅包含自然环境数据,如天气、地形数据,还包括电磁环境数据。

以上种种所体现出的频谱大数据的特点可以概括为4个关键词——大量(Volume)、高速(Velocity)、多样(Variety)、价值(Value)。

但是,可以看到,9 kHz到300 000 GHz之间的频谱范围是有限的,需求的激增使得无线频谱资源越来越稀缺,越来越珍贵。因此,面对有限的频谱资源和无限的频谱大数据,如何根据频谱大数据的特点有效挖掘出其中有价值的信息,并以此作出正确决策,达到提高频谱资源利用率的目的,这一问题受到了广泛的关注。而在大数据分析与处理两个方面都有突出表现的机器学习方法顺理成章地成为大家关注的焦点。

2 频谱大数据分析的机器学习方法

频谱大数据分析就是从具有大量性、高速性、多样性、价值性的频谱数据中充分挖掘出蕴藏其中的有用信息,获取统计特性,学习潜在规律。针对频谱大数据不同的特性,需要运用特定的机器学习方法。

2.1 大量性与分布并行学习

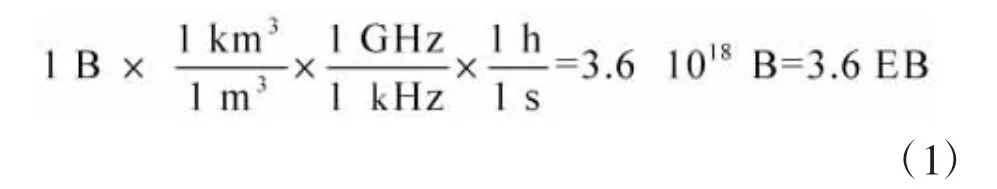

大量性是频谱大数据最基本的一个属性。单以无线频谱状态数据为例,假设1 s时间内在一个1 m3的空间中可以感知到0~1 kHz频率范围内的频谱能量值为1字节,那么1 h时间内在1个1 km3的空间中,可以感知到0~1 GHz频率范围内的频谱能量值将达到

由此可以看出,无线频谱的状态数据能够在时间、空间、频率这三大方向都得到进一步扩大,使得数据规模激增。如果再把用户相关数据和环境相关数据考虑在内,那么频谱大数据的规模将向更高的数量级扩大。

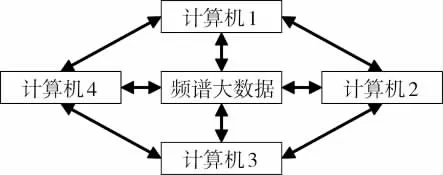

传统数据处理的方法是将小数据集中式存储于一个工作站中,再进行串行化计算。当面对大数据时,这种方法难以在所要求的时间内完成必要的计算。为应对频谱大数据的大量性,一个典型策略就是对数据进行分布式存储并行化计算,这就是分布并行学习(distributed and paralleled learning)[5]。分布式存储是空间上的分布,通过构建相互连接与通信的计算机网络系统,将频谱大数据分区成多个小块,由多台计算机分别存储,却又可以共享资源,以平衡计算负载;并行化计算是时间上的并行,对离散的数据块同时进行计算,随时并及时在最适合的计算机上运行最适合的程序,以快速解决大量且复杂的计算问题。分布并行学习的结构如图1所示。

图1 分布并行学习结构图

而分布并行学习的诸多方法中最具代表性的要属近几年十分火爆的云计算(cloud computing)。云计算是分布并行学习方法在互联网与物联网时代的再发展,它是综合了多种计算机网络技术的一大新生品[6]。

2.2 高速性与极速学习机

数据以极快的速度发送、传输和接收,这就要求计算机具有高速的、实时的处理能力。以无线网络为例,由于频谱环境的动态变化,高速的数据处理有助于推断频谱演化态势,是频谱预测和决策的重要前提。若数据处理的耗时大于频谱状态改变的时间,那么时延会使分析结果不再适用,预测结果也将毫无意义,更严重的是如果由此产生了不正确的判断与决策,那么会使得频谱的使用情况出现紊乱,降低其利用率,致使频谱资源更为紧张。因此,为应对频谱大数据的时间敏感性,高速实时的数据处理技术很值得关注与研究。

传统的方法使用梯度算法来训练学习网络,并且迭代调整网络中的所有参数,使得其速度远远不能满足实际需要。文献[7]中提出的极速学习机(Extreme Learning Machine,ELM)算法有效地解决了学习时间长这个问题。该算法其实就是一种前馈神经网络的学习算法,整个网络的结构十分简单,只有3层——输入层、一个中间隐层、输出层。整个学习过程一次完成,无需迭代,因而能达到极快的学习速度,能够满足频谱大数据高速性的需求。

但是,在实际应用中,由于新数据不断添加,ELM算法会把旧数据和新数据统一训练,时间消耗变得越来越大。而文献[8]就极具创新性地提出了新数据有序添加,旧数据学完抛弃的在线序列ELM算法,这种算法使得时间消耗降低,提高了计算速度。

当然,算法在不断改进,硬件方面也在不断突破。图形处理器(Graphic Processing Unit,GPU)平台也是采用了分布架构,并行编程的这种方式,大大提高了计算能力,缩短了计算时间。将ELM算法应用于上述的GPU平台,更能极大地提高数据实时分析的速度。

2.3 多样性与核学习

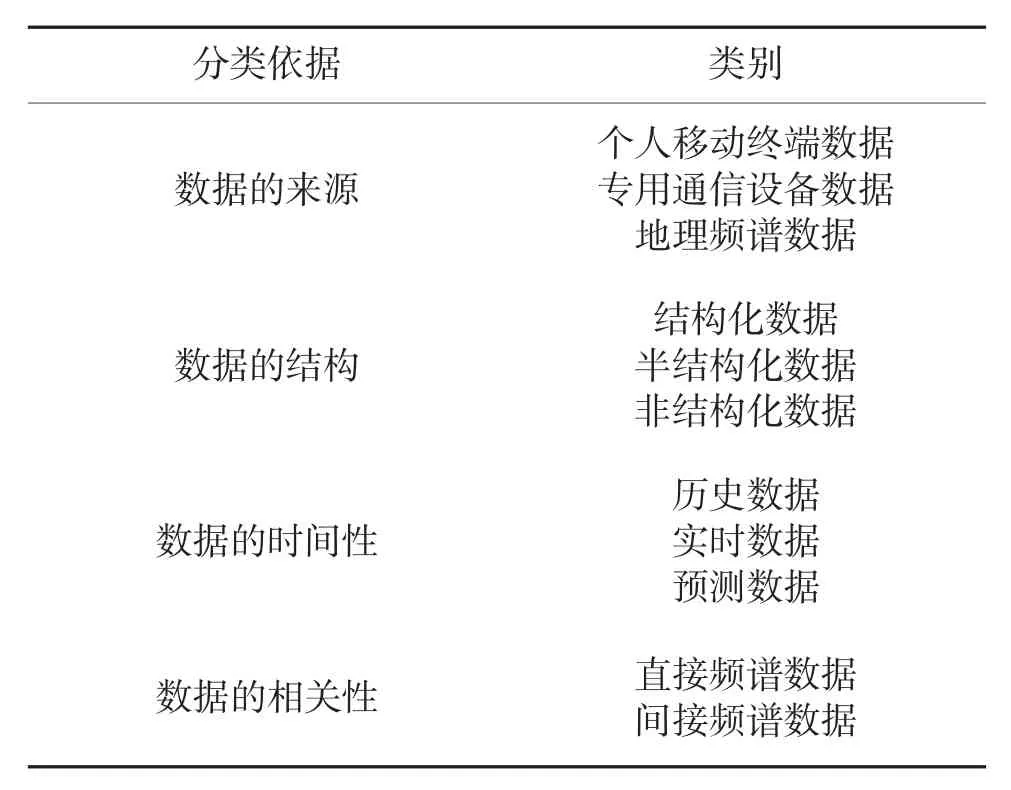

不同的分类依据可以将频谱大数据分成很多类别,比如数据的来源、数据的结构、数据的时间性以及数据的相关性等,如表1所示。这么多的类别很好地体现了频谱大数据的多样性。以数据的相关性为例,直接频谱数据主要是指频谱的占用情况、频谱质量、噪声与干扰等;间接频谱数据包括时空信息、用频设备数据、装备干扰关系等。

表1 频谱大数据的分类

对于频谱大数据的多样性,传统的数据处理方法往往因为自身局限性而显得力不从心,需要有更加智能的数据处理技术来识别分类,进而分析处理。

针对此问题,广泛应用于分类算法的核学习(kernel learning)受到了人们的关注。核学习方法的核心在于核函数,该函数可以把最原先混杂的数据映射到高维的空间中,进行非线性函数的线性化处理,使复杂问题简单化,从而完成多样化数据的区分。

这样的方法用在频谱感知的相关研究中,在非线性的频谱数据融合,以及映射后的高维空间的数据聚类等问题上表现十分突出,能够提高监测结果的准确率[9]。随着算法的不断完善与突破,多重核学习、加权核学习等延伸出的新算法的数据分析能力得到了进一步的加强。

2.4 价值性与深度学习

大数据的挖掘在于得到隐藏其中的,有重要意义的信息。然而,由于数据的大量性、高速性和多样性,在数据发送、传输和接收的整个过程中,难免存在干扰、模糊、错误、丢失等现象,使得最终所得的数据价值密度较低。频谱大数据的价值密度较低主要是因为在相邻的时间、空间、频率采集到的数据样本存在较大的冗余[10]。

频谱大数据的价值密度较低这一特点,给数据挖掘和信息提取带来了更加具有挑战性的工作。这就要求所采用的学习算法不能只浮于表面,要更加深入地进行数据挖掘,只有这样才能充分发挥大数据的价值。

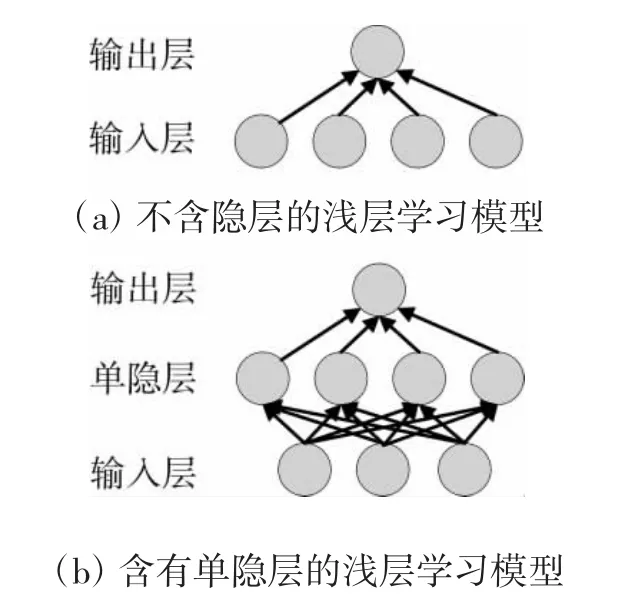

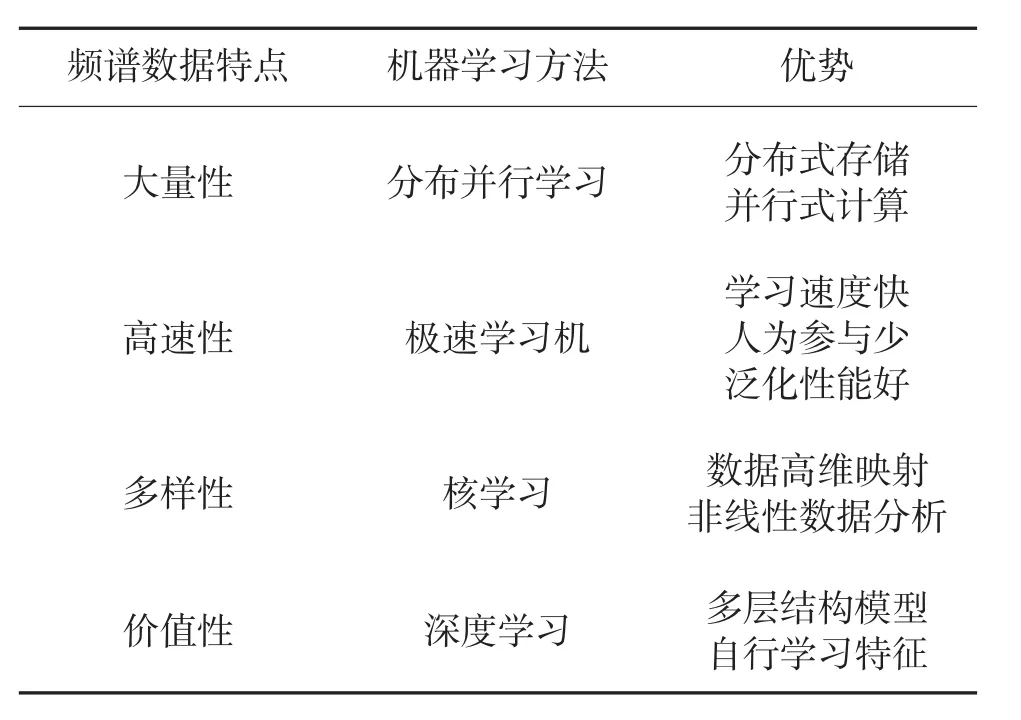

深度学习(deep learning)是传统的浅层学习(shallow learning)深度化的结果。传统的浅层学习模型在输入层和输出层之间通常不包含或者只包含一两层隐层单元,其模型如图2所示。神经网络中所包含的隐层单元通常被视为数据的特征表示。浅层学习虽然也能够完成数据的学习,但是有一定的前提,它需要输入经过专家预先选择的优秀特征,这个前提就成为影响整个系统性能的关键因素,如果特征选择好,那么学习效果就好,系统性能就好。

图2 浅层学习模型图

与传统的浅层学习算法进行比较,深度学习有以下两点不同[11]:1)强调模型结构的深度,着重建立具有类脑神经多隐层结构的计算模型;2)着力于数据特征的自我学习,对每个隐层都进行初始化,生成新的特征,最终将原始特征变换成能够对数据的原始特征产生本质刻画的高级特征。深度学习模型如图3所示。

图3 深度学习模型图

目前,在深度学习的研究领域,特征学习算法对于标记数据的分析与处理已经十分成熟了。而真实世界中存在着诸如频谱大数据这类的无标记数据。所以,对无标记数据的特征学习以及自动添加标签技术的研究必将越来越受到重视。

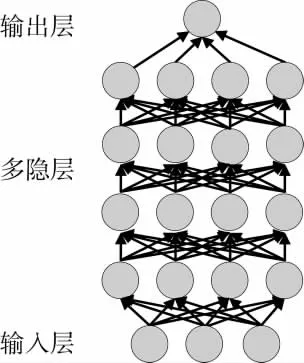

综上,面向频谱大数据的分析,讨论了对应其大量性的分布并行学习方法、高速性的极速学习机方法、多样性的核学习方法、价值性的深度学习方法,如表2所示。

表2 频谱大数据分析的机器学习方法

3 频谱大数据处理的机器学习方法

频谱大数据处理是相对于频谱大数据分析而言的,旨在对数据分析的结果进一步利用,就是依据获得的统计特性、学到的潜在规律,推断频谱演化态势,作出正确的频谱预测和决策。下面将介绍两个侧重点略有不同的用于频谱大数据处理的机器学习方法。

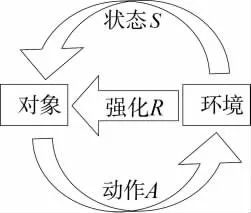

强化学习(reinforcement learning)的思想可以简单描述为奖惩机制,即对象在环境的奖励或惩罚的刺激下,学会自主决策以获得更多的奖励。

强化学习的基本模型如图4所示。对象与环境的互动可以描述为:对象根据当前状态,作出动作A,与环境发生交互,环境产生下一个状态S的同时向对象反馈一个奖惩信号R作为强化信号,对象再结合当前的状态和收到的反馈信号作出下一个动作,作出动作的依据是这个动作更有可能使得环境向对象反馈一个奖励信号,也就是正强化信号。

图4 强化学习模型图

在频谱大数据处理过程中,由于频谱状态时变,环境条件未知等因素,边学边用边完善的强化学习方法在决策问题上有很大的优势,比如可以根据信道的实时使用情况进行适当的调整,选择最优的网络,以提高频谱的利用率[10]。

博弈学习(game learning)是指若干个对象都有各自的目标,对象相互之间不断作出被允许的行为策略,最终产生各自的所得与所失。其过程可以描述为:第1步,先分辨出若干个交互对象的状态;第2步,将其分成自己想要合作和想要竞争的两个族群,这两个族群能够随机选择行动策略;第3步,提出两个相反的学习概率:P1是想要合作的族群向想要竞争的族群学习的概率,P2是想要竞争的族群向想要合作的族群学习的概率;第4步,假使经过逐步作出的行为策略,通过合作能够达到一种动态平衡,那么P2会越来越大,而P1会越来越小,即结果选择合作的群体规模越来越大,最终就会达到较好的均衡。

博弈学习目前已经成为认知无线电(Cognitive Radio,CR)领域的重要方法之一[12],该方法可以完成类似频谱拍卖的资源管理项目,也可以完成实时信道调整,选择最优网络的资源优化项目。

4 结论

本文介绍的几种机器学习方法只是管中窥豹,略见一斑,能够应用于频谱大数据分析与处理的机器学习方法还有很多。

当然,实际应用中,肯定不是某一特定方法的单独使用,也不可能是所有方法的堆叠使用。面对众多的机器学习方法,要对症下药,选择最合适的方法去解决针对性的问题;要集约高效,讲究多种方法的有机融合,相辅相成。比如,建立机器学习方法库,可供数据分析与处理系统访问。这就给频谱大数据分析与处理的智能系统树立了更高的目标。

另外随着科技的不断进步,5G移动网络、微型平台系统、个人数据隐私、涉密数据传输等问题都对通信领域的机器学习方法提出了更广泛、更严格的要求。比如,在智能手机、平板电脑等移动终端越来越普及的今天,机器学习应用于类似的微型平台是必然的发展趋势,这就需要对规模更小,速度更快,又对计算性能要求较低的机器学习方法进行更深入的研究。

总之,机器学习领域还有很长的路要走,更加智能、高效、便捷的机器学习方法有待在今后的实际工作和研究中继续探索。