人工智能视阈下的网络法核心问题*

胡 凌

一、引言

“人工智能”(以下简称AI)一词既在技术层面使用(工具、客体),也逐渐在道德与法律主体意义上进行讨论。AI首先依托于现有互联网底层架构和商业模式得到开发,原本没有那么智能的算法在运算和数据处理能力上得到提升,甚至算法本身能够自主学习,对数据进行识别、分类、决策,可应用的场景也从单一扩展到多元,最终变成通用AI。不难看出,AI这一概念容纳了相当混杂多元的对象,而人们在谈论时头脑中往往想象不同的(甚至当下不存在的)实体。如果讨论对象模糊不清,就很难对不同判断达成一致(如是否应赋予AI适格的法律主体地位1人们在讨论这一问题时,无一例外地列举AlphaGo和无人驾驶汽车,而少有人讨论已经在影响我们生活的电商、搜索引擎和新闻推送服务,因为后者无法激发论者想象中的主体感。一旦日常服务通过终端具象化,如语音音箱或送货机器人,改变人机交互方式,就会增强这种主体感。)。本文延续思考网络法核心问题的一贯视角,将AI置于互联网演变过程(特别是生产过程)中,观察AI对既有赛博空间(Cyberspace)秩序的影响,以及法律如何回应。这一视角的好处是:首先,AI依托于不同场景和商业模式,可以在当下针对特定模式的立法体系下讨论,避免在同一个标签下谈论不同层面的问题;2国家网信办自2011年成立以来,强化了对特定形态商业模式的监管,立法模式由过去统一行为立法转向不同模式特殊性立法,如《即时通信工具公众信息服务发展管理暂行规定》《互联网信息搜索服务管理规定》《互联网论坛社区服务管理规定》等。其次,可以折射出AI的生产性维度,看到AI使用背后的生产关系和政治经济利益,而这往往被实证法学忽视;最后,可以将既有网络法问题置于更加自动化、智能化的环境中,思考什么构成了中国语境下独特而持续的理论与实践问题。

以互联网为媒介的数字资本主义的重点在于价值生产。不难发现, AI时代是算法驱动的社会化生产过程演进至更为自动化的阶段,也是继云计算、大数据之后互联网进一步发展的阶段。这一阶段明显的特征在于对算法的智能开发与广泛应用,如果说前两个阶段的主题过于技术化,普通人难以理解,AI阶段则更富有戏剧性:它伴随着神奇的竞赛故事、大众媒体炒作以及耸人听闻的警告和担忧。3目前区块链和各类ICO似乎更能吸引眼球和盲目的投资者。技术公司们担心,把AI看成是未来人类的竞争者和统治者的论调会促使政府加强监管,导致这一领域的研发和投入减少,但事实上人们很快就发现,媒体、好莱坞影视剧和科幻小说中的AI并不会短时间成真,世界主要国家的政府和所有大型互联网公司都在鼓励AI研发,并将之视为未来国家间、企业间竞争的真正力量。4尽管仍然有警惕的声音,例如最近OpenAI、牛津大学、剑桥大学等14家机构和高校共同发布的《人工智能恶意使用》(The Malicious Use of Artificial Intelligence)报告。恐怖谷理论(Uncanny Valley)业已说明,人形机器人可能不会在消费者市场上受欢迎,除非它们被刻意设计得远离人形,以至于不会给人类使用者造成“同类”的反感印象,哪怕在机器人文化盛行的日本也是这样。5Yuji Sone, Japanese Robot Culture: Performance, Imagination, and Modernity, Palgrave Macmillan, 2016.相反,在现实中AI依托互联网服务大有可为,越来越深入地介入普通人生活,不局限于某类特殊技能的智能水平提升,而是通过数据分析和精准预测带来实在的经济利益。

笔者曾区分了AI及其法律的双重属性:实证性(规范性)和生产性,前者指由作为一种黑箱的AI引发的权利和责任配置问题,如谁来承担无人驾驶汽车事故的责任,这些新兴规则的生成遵循着已有的网络法规则创设模式;6Frank H. Easterbrook,“Cyberspace and the Law of the Horse”, 1996 University of Chicago Legal Forum (1996),p. 207;Lawrence Lessig,“The Law of the Horse: What Cyberlaw Might Teach”, Harvard Law Review,Vol. 113, No. 2 (Dec.,1999), pp. 501-549; Ryan Calo,“ Robotics and the Lessons of Cyberlaw” ,103 California Law Review, Vol. 103, No. 3 (2015),pp.513-563.后者则指AI作为新经济的生产要素如何受到规制和约束。7胡凌:《人工智能的法律想象》,载《文化纵横》2017年第2期。生产的维度之所以重要,是因为它延续了传统政治经济学关于经济民主、歧视、平等、劳动过程等关键问题的讨论,法律问题只是这些宏大问题的具体缩影。如果AI只是传统生产组织用以提高生产效率的工具,那么也并没有提出全新问题,但只要AI生产依托于互联网,遵循着网络生产的模式,就会延续一些和传统经济相比不同的问题,特别是劳动组织和劳动关系。实际上,AI的特殊性是互联网整体问题的映射,这未必是法律意义上的独特问题(任何新事物都可通过法律解释活动在既有概念体系中得到解释),而是需要作为一种新型权力和利益相关人出现,以争夺现实的合法性。

就生产而言,新经济业已展示出两种类型:线上信息生产与通过算法驱动供需匹配,前者用于吸引大规模用户并将其作为免费劳工,后者则体现为信息经济带动更广泛的经济活动,更为精确地对供需进行匹配。类似地,AI阶段的生产指:(1)AI正在取代越来越多的人类线上行为和劳动,以极低成本产生信息内容,吸引更多用户;(2)通过AI驱动线下资源生产更加精确,减少信息不对称,塑造价值再生产过程,并从交易双方获取最大限度的剩余价值。

网络法的核心问题在于互联网如何进行控制和生产,其微观机制和宏观架构是什么,以及更进一步,谁能控制赛博空间。8胡凌:《超越代码:从赛博空间到物理世界的控制/生产机制》,载《华东政法大学学报》2018年第1期。在生产和控制过程中,形成了两组主要关系:一是平台企业和用户的关系,一是平台企业之间的竞争关系,它们都可置于同一个生产性网络法框架中得到探讨。这些关系是辨证的,一方面共同体现了新经济内生地需要何种法律,另一方面又是不断生成演进的,是企业与用户、竞争对手不断博弈过程中形成的秩序。本文认为,AI日益成为智能架构的核心构成,关于AI的任何法律安排(无论是法律主体还是客体)都需要放在上述不断互动的关系中观察理解,而无法先验地由法律拟制确定。

本文结构如下:第二部分首先将AI置于现有网络法的架构理论下进行解释,认为AI是整个智能生态系统中不可或缺的一部分,有必要和其他互联网层面联系在一起系统讨论,而不是作为独立对象(这是任何法律主体讨论的思想根源)。第三部分讨论AI如何推进网络法的上述两对核心关系,即智能化和自动化将进一步改变用户和服务商的生产关系,同时也可能加剧不正当竞争,需要法律给予回应,划清架构边界。在讨论服务商和用户之间的关系时,AI作为法律主体的问题似乎凸显出来,在这一过程中用户并未在架构中显著增加控制能力和活动空间,AI企业的控制力反而进一步增强。第四部分继续在架构视角下讨论如何通过合同和监管处理作为黑箱的AI信息披露问题。

二、架构理论中的人工智能

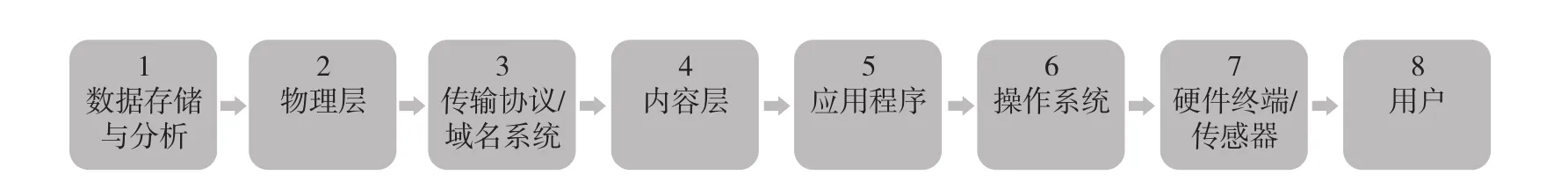

“架构”(architecture)理论或代码理论由劳伦斯·莱斯格(Lawrence Lessig)在《代码及其赛博空间中的其他法律》一书中提出,并在后续研究中不断得以扩展。9Lawrence Lessig, Code and Other Laws of Cyberspace, Basic Books, 1999.架构帮助我们理解赛博空间的权力如何出现和延伸,解释一系列网络法问题,可从横向与纵向两个维度进行讨论。10详细的讨论见胡凌:《论赛博空间的架构及其法律意蕴》,载《东方法学》2018年第3期(即出)。就横向维度而言,架构从不同场景和功能的设计得以体现,影响架构内主体行为,并可通过一些基本方式进行合并或分解。就纵向维度而言,架构包括了从硬件层、内容层到数据存储层的诸多层面(见图1):

图1 纵向架构

横向与纵向架构展示了赛博空间控制/生产的范围,AI正是其中关键一环。以架构视角观察,不难发现人们对AI的不同想象取决于对不同架构要素组合的理解和认知:

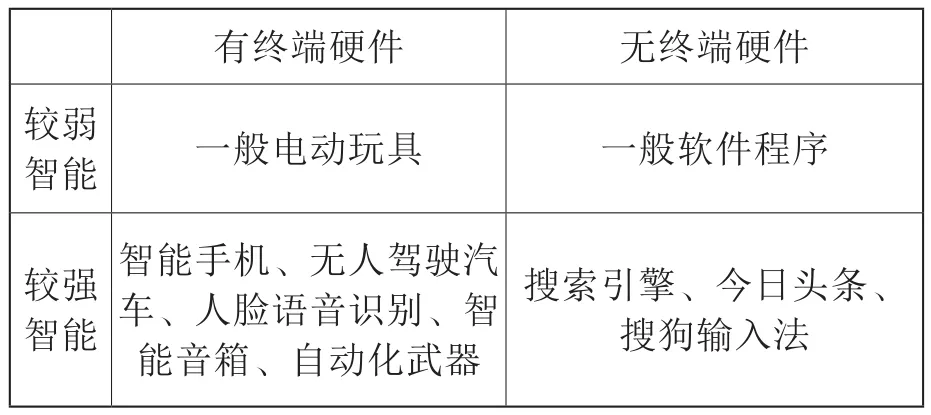

表1 AI的惯常分类

尽管大众愿意将AI设想为有形体的“机器人”,但目前相当多的AI应用都依托现有互联网服务,且出现硬软件垂直整合的趋势。按照通行的互联网商业模式,可将AI分解为“算法+第三方应用(场景)+硬件终端”,各类场景由多个算法组合控制,形成生产和交易流程,从具有强大运算能力的云端服务器进行远程控制;中层则由第三方应用开发者形成交易平台,允许用户通过终端进行交互使用;终端不过是连接线上和线下的界面,最初是智能手机,也可以演变成包括智能音箱、无人驾驶汽车在内的任何硬件。其商业目的是加强人机交互,按照分享经济思维促成大规模交易与合作。这一架构中的AI会通过账户对使用者进行认证,对账户中积累下来的用户行为数据进行分析识别,生成动态身份,并对其行为进行评分指引,预测其偏好和未来行为。11胡凌:《超越代码:从赛博空间到物理世界的控制/生产机制》,载《华东政法大学学报》2018年第1期。从这个意义上看,AI就不单纯是一个“大脑”或终端产品,而是一整套生产流程,甚至就是架构本身。

按照这个思路,也可以按照不同功能区分位于赛博空间架构不同层面的AI:

● Ⅰ类为C2C模式平台本身,通过大量数据分析精准调配资源、设计场景;

● Ⅱ类为B2C模式,向用户直接提供在线服务;

● Ⅲ类为用户的智能代理人,代理用户在平台上参与交易,但可能和I类的角色相冲突;

● Ⅳ类则是用户购买的终端智能产品。

四者之间的关系一定程度上反映出互联网架构和权力关系在过去十多年间的重大变化。互联网发展早期的智能、创新和控制力集中在无处不在的终端,经由创生性的个人电脑、端到端分布式架构以及大众分享的文化造就了我们熟悉的互联网生态。然而随着云计算兴起,越来越多的服务以信息流方式在线提供,同时应用商店模式使终端越来越变成哑终端(尽管芯片处理能力不断增加),用户在架构中的行为能力受到愈加严格的限制,一切指令都来自于智能云端。12Jonathan Zittrain, The Future of the Internet-And How to Stop It, Yale University Press, 2008.理解这一点有助于我们理解未来可能出现的形形色色的AI终端产品,表面上看是由用户购买控制,但它们并不能独立运作,需要时刻与服务商中央服务器相连更新,甚至可在一个封闭网络中相互沟通传输数据(智能物联网),使用户成为遵循许可使用协议的终端租客而非购买者。此外,Ⅰ类AI还可能通过特定方式(如许可牌照)成为寡头垄断的基础设施服务,为更多中小开发者提供计算能力和数据分析服务,也变相地推动形成巨头主导的生态系统。

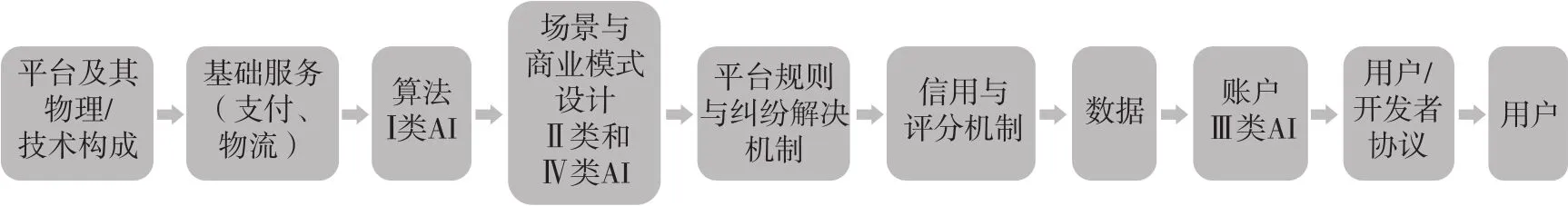

图2 架构横纵视角的整合

如果将横向与纵向视角合并,可以看到智能架构中上述四类AI的地位及其对社会主体行为的影响(见图2)。AI作为整个架构演变的引擎,对外开拓架构的疆界,对内则塑造生产关系和生产活动,与平台规则、评分机制、用户协议等一并构成了架构权力。较为完美的控制/生产体系是文字规则与代码规则保持一致,外在的用户协议与平台规范能够精确地描述变动中的算法功能,但这在实际中却难以实现,后文还将进一步讨论。

在这个智能架构中,既包含高度流动和不确定的要素,也包含稳定不变的要素。例如,架构中汇集的生产性资源是不断流动、多属的,但架构通过账户认证和识别稳定地追踪用户,并根据其数字画像加强预测降低风险;架构的硬件层面的质量要得到保证,确保符合质量安全标准,但其软件功能又需要不断更新升级,要求用户容忍配合。在这样的辩证法中,AI经济得以不断崛起演进,使AI企业与用户、竞争者的关系变得日益复杂。

三、人工智能与我们:从游乐场/商场到工厂

上文已经说明,常识能够想象和理解的AI服务会以何种方式开展。这意味着AI产品很可能进一步脱离终端用户操控,由AI企业持续保持强劲控制力,在此背景下谈论独立的AI法律人格可能会有截然不同的政治经济意蕴。本部分将这一话题放置于AI与我们(作为产销者,prosumer)的关系中,指出无论是消费者还是数字劳工,都需要认真对待更加智能化的数字架构,后者驱使互联网带来的控制/生产过程走得更远。

机器正在取代人类工作的讨论方兴未艾,13[美]杰瑞·卡普兰:《人工智能时代:人机共生下财富、工作与思维的大未来》,李盼译,浙江人民出版社2016年版;[美]埃里克·布莱恩约弗森、安德鲁·麦卡菲:《第二次机器革命:数字化技术将如何改变我们的经济与社会》,蒋永军译,中信出版社2016年版。最早反映在互联网上主要是由算法直接生成或辅助人类制作可供消费的内容,后来扩展至更多元的场景,可能的模式既包括B2C,也包括C2C。这一方面无疑影响了那些难以快速适应新技术变化的传统职业,另一方面更加便利了消费者,同时将更多熟悉数字环境的消费者转变为可产生价值的灵活劳动者。下面简要勾勒出AI生产场景的演进(即上文的Ⅱ类和Ⅳ类):

● 新闻报道、法律服务、编曲、文学创作、广告这样的初级信息编纂工作可以又快又好地由AI承担,以接近于零的边际成本向用户提供,降低用工成本。这更多是结构化的数据自动生成的结果,只要对输入的数据进行结构化整理,就可以按照一个模板生产出所需的信息产品。14AI的数据训练需要大量人类劳动的帮助,例如数据标注。参见《数据折叠:今天,那些人工智能背后标数据的人正在回家》,载“甲子光年”微信公众号,2018年2月15日。

● 机器人推手、僵尸粉、刷单和个人信息打码这样的灰/黑产的生产主要由AI实现。

● 虚拟交互或创设虚拟形象,诱使更多的用户参与使用,如直播平台和微博上的粉丝或者在线游戏虚拟对手、聊天机器人。

● 基于去世用户数据开发出虚拟人像对话服务,模拟用户生前行为和思想,实现“永生”。

● 在软件智能化基础上,将电脑和智能终端稍加改进扩展,形成各类新型终端,即会思考的机器人雏形。

对用户而言,智能服务是一个合同问题,如果他们接受一个存在大量AI拟人化生产的虚拟环境,监管者会要求企业在用户协议中披露这类信息,并提供能够验证真伪的方法,以免用户遭受欺诈造成误解。机器生产的意义在于,它不仅反映了网络空间价值生成的劳动本质,也折射出用户在互联网空间生产中转瞬即逝的地位,甚至还反映了机器生产和人类劳动之间的连续性。伴随着人工成本的增加和竞争更加激烈,我们有可能见证更多由AI创作的网络信息和文化作品(哪怕是初级的),而在未来则会出现一个完全由机器生产主导的虚拟世界。

这一过程如果逐渐成真,部分互联网平台可能会从C2C第三方平台模式转向B2C自营模式,如果前者的成本远高于后者。这当然会部分地减轻地域性监管的压力(无须为不良内容找到人类责任主体),取而代之的是针对企业统一算法的监管。但就目前法律实践而言,无论是法院还是监管者,都倾向于对网上的外在行为或结果进行认定、确定责任分担,而不是探究黑箱内部(详见第五部分)。AI无须作为法律主体接受监管,而只是互联网企业生产过程中的工具而已。即便是在搜索引擎公司强调其搜索推荐或竞价排名推广信息是“自动生成”的时候,人们也从未想过要由一个纯粹的机器算法承担责任,独立法律主体的说辞只是在为免费利用开放网络信息且承担较轻的审查责任提供理由(这一说辞仍值得重视)。如果越来越多的网络内容不但由AI自动筛选,甚至组合排序,形成某种新作品,就会涉及与当下搜索结果的排列顺序的区分,机器介入的程度越来越深使形式上的分别愈加不重要。

作为直接生产者的AI无疑会大量增加网络公共资源的供给,避免出现人类生产者动力不足的公地悲剧问题。然而,人类的生产过程,同时承载着沟通交流与合作的功能,建立起同侪之间的关系和纽带,而不简单表现为纯粹的劳动和价值交换。15Yochai Benkler, The Wealth of Networks: How Social Production Transforms Markets and Freedom, Yale University Press,2006.AI生产的增多可能逐渐会减少这类活动的文化、社会意义,使经济性成为最主要的衡量标准,同时意味着平台对公共资源池的掌控能力更强。下面将细致讨论在互联网经济基础上生发出的AI法律人格主张。

从生产的角度看,AI法律人格和地位的主张不过是延续了传统媒体对消费者人格商业利用的做法,16[澳]胡·贝弗利-史密斯:《人格的商业利用》,李志刚、缪因知译,北京大学出版社2007年版。赛博空间在宏观架构上将用户的人格(如隐私)不断转化为可持续利用的数据财产,17Lawrence Lessig,“The Architecture of Innovation” , Duke Law Journal,Vol. 51, No. 6 (Apr., 2002), pp. 1783-1801.并通过微观用户协议“知情同意”实现这一商品化过程。但有趣的是,AI产品(作为架构的延伸)最终能够积累(或要求创设)出自己的独立人格,表面上似乎能与用户保持某种平等的地位或得到法律特别保护,但更多折射出背后的AI企业财产权利,时刻受到企业的远程控制,用户并未真正脱离架构权力影响。

AI法律人格的拟制主张从一个侧面看并不复杂,在制度设计上甚至水到渠成:互联网企业拥抱以AI为基础的平台架构,同时开发出更贴近用户日常生活的、可自主思考决策的智能终端/机器人,要求赋予其某种独立而有限的责任,并与AI企业在形式上脱钩。这种思路与当下的平台责任讨论一脉相承,甚至可以看成“非法兴起”过程中的最新主张。18胡凌:《非法兴起:理解中国互联网演进的一个框架》,载《文化纵横》2016年第5期。本文无法系统设想AI产品成为法律主体可能的制度设计,从已经进行的讨论来看,至少包含以下重要方面:

● 算法自动生成的内容享有著作权,可积累个人财产。19例如,熊琦:《人工智能生成内容的著作权认定》,载《知识产权》2017年第3期。这会使网上属于公有领域的内容通过抓取和创造活动进一步私有化,而竞争对手不得侵犯;同时AI企业不会为任何侵权内容负责,但可以通过AI的再创作而间接获利,吸引消费者。

● 享有一定程度的言论自由。20Tim Wu,“Machine Speech”, U. Pa. L. Rev. , Vol.161,No.6(2013) ,pp.1495-1533.这无疑可降低对AI企业的商业言论监管要求,减轻平台审查责任,得到相关法律(如美国宪法第一修正案)的保护。

● 购买服务的用户并不实际拥有虚拟影像,它在形式上独立,但由AI企业算法控制。

● 容忍终端产品的软件瑕疵。类似于软件拆封合同,AI产品需要实时联网反馈使用数据,以确保功能稳定更新,不断增强企业的远程控制力。

● 如果智能产品包含硬件,可在消费者法律要求下承担产品质量责任。

● 有限侵权责任。AI企业为特定情况下出现的因AI运转失灵导致的侵权责任购买保险,特别是针对风险大、概率小的极端行为。但在人机交互过程中,有时很难区分责任边界,也较难取证。

● “不得伤害机器人”,智能终端不得随意破解拆分,因为它代表了AI企业的知识财产,用户也不能未经许可自行编程设计AI作为代理人进入平台服务器沟通交换数据。

● 在人机交互中有权使用用户数据,默认追踪用户,形成因人而异的AI。

● 容忍可能的广告等商业模式,不得以不正当竞争方式屏蔽。

上述列举均为业已发生的各类互联网案件/事件的延续,本身没有更多特殊性,只不过更加强调AI的“自主性”和“不可控制性”,引发人们关于“自由意志”的想象。在相关法律出台之前,来自AI企业的主张在实践中已经成形(请对比“快播案”):首先,可以通过用户协议展示,在知情同意的通行说辞下避免运营风险;其次,可以不可控为由,主张“网络中立”或“技术中立”,要求用户为自身行为负责;最后,可以算法黑箱的深度学习过程不可回溯为由,主张降低可能的信息安全保障义务。如果用户购买到的是一个完全自主的智能产品,对用户的终端能力和选择权将有极大提升,也可以真正和AI企业脱钩,但无论是目前的信息安全审查制度还是互联网商业模式,都不允许这种情况发生。

此外,人格化的结果是在人类生产过程中合法引入了超级竞争者,这可能会迅速取代更多的简易工作,并创造出更多的初级消费品。再次强调,人格化同时意味着希望人们无视AI公司背后可获得的经济利益和控制力量,重要的不是“最后一公里”产品本身是否足够智能从而在法律形式上更加独立,而是从云端到终端的整个流程代表了生产性的权力关系,有必要思考未来如何通过法律调整这种关系,使之变得更加公平,否则只是针对纯粹法律技术和拟制的研究在实质问题上改进不大。

AI带给我们的不只是游乐场或商场,也可能是无薪劳作的工厂,想象我们和AI关系的另一种方式就是数字劳工。21Trebor Scholz, Uberworked and Underpaid: How Workers Are Disrupting the Digital Economy, Polity, 2016.如前所述,由于互联网兴起的商品化逻辑没有改变,不断碎片化的人类劳动在相当时间内还会持续成为AI演进(无论是I类还是II类)的免费生产资料。AI通过大量真实数据得到训练,并不断搜集、追踪用户数据,变得更加智能。22作为劳动过程的个人数据生产也在逐渐得到讨论,同上注。松散的劳动关系是互联网成功的关键要素之一,目前一系列案件已经确认像网络主播和专车司机这样的灵活劳动力不是平台雇员,也因此无法享有社会保障、参加工会等劳动权利。23因为法律形式上是合作合同或经纪合同,实质上平台也没有进行工作安排或者控制指挥劳动过程。以低成本获得无偿劳动将继续成为AI企业不断扩展的推动力。

四、人工智能如何(不正当)竞争

除了直接生产信息内容,AI更多地用于平台经济上的调配资源、营销推荐、内容分发,甚至预测未来(上文的Ⅰ类)。这一预测本质上是依据不断生成的动态数据对个体加以追踪,更加精确地计算和判断每一次网络点击和活动会引发何种连锁反应。这种经济类型从生产资料的角度在数年前便被称为“分享经济”,因为平台试图创设生态系统,为中小生产者和消费者提供交易中介服务,但由于平台广泛搜集交易数据,撮合交易,由此获得广告收入甚至交易分成,已经深深介入交易过程,在这个意义上称为“平台经济”更加准确。随着更加成熟的AI创设出来,平台与双方交易更像是一个相互嵌入的合作过程,甚至拥有某种强大权力。24周辉:《变革与选择:私权力视角下的网络治理》,北京大学出版社2016年版。为了打造互联网入口,平台会尽可能将生产资源纳入自己的生态系统,并采取补贴优惠等活动吸引交易双方,提供良好的服务,更进一步表明平台的非中立特征。与其他平台竞争者相比,特定平台是非中立的,但对平台上流动的资源和交易而言,中立和公正性又是确保一个良好生态运转的核心。从这个意义上说,未来的公共资源池会变得更加封闭,进一步受控于核心算法,生产性而非公共性进一步得到强化。

和众多互联网导致的传统行业的衰落(实质上是生产方式的转变)类似,AI时代进一步将战火引至更多服务业,如交通、法律、医疗和教育。尽管不断有针对互联网平台的不正当竞争控诉,法律事实上反映了新经济的利益,并按照新经济的需求发生转变。在AI主导的平台时代,平台之间的不正当竞争可能会有如下新特点:

● 通过机器人爬虫不断抓取竞争对手控制下的数据和信息可能会更加猖獗,尽管法院在最近的新浪微博诉脉脉(2016)一案25北京淘友天下技术有限公司等与北京微梦创科网络技术有限公司不正当竞争纠纷二审民事判决书,(2016)京73民终588号。中确认了此类行为的不正当性,但最终需要的仍然是通过技术保护措施的硬性自我防护,而非像Robots协议这类柔性行业规范。

● 同时,关于比价插件的不正当竞争案件却反映出法院对平台利益的过度保护,忽视了插件软件的公益属性,也失去了平台价格监管的可行的替代方案。26浙江天猫网络有限公司诉上海载和网络科技有限公司不正当竞争纠纷二审民事判决书,(2017)沪73民终197号。

● 竞争者和其他交易主体会雇佣网络推手制造虚假数据,造成数据污染,反过来对平台的精确分析造成干扰;平台如果不能识别并抑制这类虚假交易,会遭受极大损失。27胡凌:《商业网络推手的演进与法律回应》,载《经济法论丛》(2017年第1辑),社会科学文献出版社2017年版。网络上有大量机器人不断破解各类在线账户(如博客)并自动发表不相关的垃圾内容,占用了相当的网络流量,也是不正当行为的一个变种。

● AI时代的任何插件、APP、软件甚至硬件都可能是由自动化和数据驱动的,这可能引发上游架构企业借助硬件优势对下游企业提出强制性要求,意图通过统一AI调动特定应用(往往以向用户推荐或投放定向广告的方式),这意味着上游企业更加强大的掌控力,甚至不惜排斥其他应用,走向垂直整合的自我封闭性。28

● 算法竞争本质上首先仍然是资源竞争和架构边界的划定。“魏则西事件”折射出AI公司(例如搜索引擎)的竞争策略是资源先占(从通用搜索转向垂直搜索),而怠于开发精确的算法,商业模式和新入口的打造使相关市场不断被颠覆,更加不需要精确算法在边际上推动获利。这一现象表明算法可能不会因单纯的市场竞争而推动改进,AI公司仍然会依靠更加省事的广告和竞价排名以及不正当竞争获利。29胡凌:《走向封闭的搜索引擎》,载《腾云》专栏:http://www.vccoo.com/v/fxzf31,2018年3月10日访问。

上述特点说明,AI时代的不正当竞争可能会围绕生产性资源和数据争夺进一步加剧,成为“非法兴起”逻辑持续的另一例证。这一争夺由AI内在驱动,表现在外则是架构之间的碰撞、排斥和冲突,从而导致更加封闭的垂直平台或生态系统,不利于推动基于生产资料创造性再利用的创新。缺乏有价值生产资料的新兴AI企业更加会利用自动化手段在赛博空间中以不正当竞争方式扩展,而且有趣的是,这种扩展往往打着用户代理人或技术中立的旗号,例如帮助用户“一键搬家”创制的内容、30《谁的用户:微博欲诉今日头条非法抓取内容》,载《21世纪经济报道》2017年8月15日。屏蔽广告31例如,“优酷诉暴风屏蔽广告案”,北京市石景山区人民法院民事判决书(2016)京0107民初5376号。或者便利传输盗版作品。这提出更多深层次的法律问题:(1)为了更加有效地利用生产资料,需要探索合作共享机制而非圈地机制,但无论是共享还是圈地,都往往是AI企业以冲突方式不断试探架构的边界而产生,法院应根据资源的有效利用程度考虑辨识是否属于不正当竞争;(2)变成底层基础设施的Ⅰ类AI企业在竞争关系上应与上层的Ⅱ类AI有所分别,防止底层企业过度整合,滥用支配地位,影响上层企业自主经营行为;(3)更重要的是,需要关注发生于架构之内的用户真实控制能力,允许用户自行开发或雇用Ⅲ类智能代理人,自主地掌握个人数据进行合作交易。

五、从架构角度看人工智能规制

前两部分内容都暗含了AI企业和产品在演进过程中受到的质疑和挑战:对消费者而言,需要确保交易公平,防止消费者剩余被过度剥夺,出现隐性歧视;对劳动者而言,需要在灵活用工环境中得到社会保障;对竞争者而言,需要划定平衡创新与秩序的架构边界。这些挑战可以通过合作协议实现,也可以经由外部监管介入推动。我们已经看到知情同意原则被广泛用于AI企业确立合法性的实践中,但在黑箱背景下仍需进一步探讨,即保持架构黑箱的技术秘密性/复杂性与特定信息披露之间的动态平衡,同时使算法对其外在活动有效地承担责任。32Finale Doshi-Velez et al., “Accountability of AI Under the Law: The Role of Explanation”, Berkman Center Research Publication 2017 Forthcoming, https://ssrn.com/abstract=3064761, accessed on March 12, 2018; Joshua A. Kroll et al.,“Accountable Algorithms ”,University of Pennsylvania Law Review, Vol. 165 (2017).

传统监管思路针对黑箱外在行为的负外部性进行约束,这是以往“技术中立”的思想根源,如果负外部性影响较大,就会认为该软件程序的设计有实质性侵权用途,但基本上没有介入黑箱之中干预。这种司法选择是有道理的,主要因为法院或监管者缺乏相关知识,哪怕是专业监管者也无法理解复杂代码的设计,只能依据其表现出来的模式加以判断。但这并不意味着黑箱的设计不受约束,当代码设计和商业模式、用户协议愈加紧密地结合在一起时,即使法院无法审查代码,仍可以审查商业模式合法性和用户协议效力。在特定情况下(特别是安全领域),除了直接针对AI产生的外在行为进行规制,也会尝试对算法本身进行管控,包括算法设计过程的伦理规则、安全性审查标准、针对代码的备案制等。软件产品的一般缺陷多少可以被拆封合同掩盖,但仍然有必要对已经出现的几类足以影响AI发展的规制方式和现象稍加讨论:

(1)AI分级,判断人机交互的程度和责任分担。现有无人驾驶汽车的分级制度为具有较大风险性的AI产品监管提供了指引,即在设计不同层次的AI服务过程中,清楚地说明在不同场景下使用者和智能服务之间的主辅关系,提供相应激励。但在实践中仍然可能出现责任不清的状况,需要合理分配举证责任。

(2)在判断软件侵权行为时对算法设计的初衷和用途实质进行判断,以决定是否彻底禁止该软件,如法院对P2P软件是否构成“实质性非侵权用途”做出的判断。这类判断并未深入软件内部,但还是对软件开发者和使用软件的行为进行了分割,这就比简单模糊的“技术中立”主张更具有可分析性和操作性。针对关键算法,开发者可以施加一定的基本功能说明义务,向监管者和用户充分合理地说明,用自然语言描述出其功能和可能的风险。

(3)信息披露与共享。由于软件缺陷会造成严重后果,一定程度的关于代码信息缺陷的披露可以帮助填补漏洞,平衡黑箱的不透明,并促使企业更自觉地加大对自身产品的安全检测。允许像“白帽子黑客”这样的第三方组织进行披露有利有弊,而在一定范围内进行的代码信息共享(包括企业间、政企间)是另一种通过信息流通发现算法缺陷的手段。

(4)监管合同。尽管无法深入AI内部,但监管者可以要求用户协议尽可能地反映算法的功能和商业模式,并在事后对合同进行形式审查,如果合同预期的效果和展示出来的功能不一致或有违公序良俗,法院就可能进行实质审查,变更或撤销涉案条款,并间接地对AI 的设计和外在效果产生影响,如广告自动推送系统的设计。问题在于,法院有时会严格按照合同法规定进行形式审查,却怠于进行实质审查,使一些用户无从得到救济。

(5)数据的清洁性。在很多情况下,法律无意干预黑箱的运作过程,只希望对黑箱处理的生产资料进行约束和清洁,从而替代对黑箱设计本身的规制,这一思路和监管者的事前规制有所不同。例如,为防止AI侵犯个人隐私,法律会要求对搜集到的个人数据进行脱敏,无法追踪到个人。

有必要看到,披露的信息并非越多越好,在披露信息的同时需要考虑信息的消化能力和认知偏差,也需兼顾AI企业的财产权利和用户自主的合理使用和操作空间,从而有利于多元的互联网创新。

六、结语

本文简要讨论了架构视角下的人工智能,以及如何理解其与使用者、竞争者之间的关系,进而帮助我们更好地理解作为网络法核心问题的控制/生产机制。至少在中国语境下,两组关系都在不断地重塑架构边界,特别是伴随AI企业扩张引起的生产关系与法律关系的诸多调整,意味着这些关系有待法律进一步确认而非固定不变,也展示出信息时代经济基础对上层建筑的巨大影响。信息技术曾许诺成为一种“解放性”技术,但从初期互联网到AI的发展过程表明,这种解放不过是把生产资源和劳动从传统组织中释放出来,给予高度流动性,组织新的生产活动而已,同时伴随着更为强劲、弥散的权力和社会控制。这就回到了架构理论的原初问题:处于赛博空间中的我们如何在微观机制和宏观架构上争取更多的自由和控制力。