多摄像机跨区域目标跟踪

石亚玲,刘正熙,熊运余

(四川大学计算机学院,成都 610065)

0 引言

在当今社会中,监控摄像头日益增多,形成了庞大而又复杂的监控网络。传统的单目摄像机下的小场景监控已经不能满足人们的需要,面对庞大的视频监控系统,如何利用计算机代替人自动处理来自多个摄像头的长时间监控视频数据,判断该目标所经过的所有摄像机形成的路径,实现对感兴趣目标的长时间持续稳定监控。由此跨摄像机目标跟踪成为当下研究热点,目前跨摄像头目标跟踪主要分为非重叠区域和重叠区域跟踪。非重叠区域跟踪即相邻摄像头之间的视域无重叠部分,可见部分有监控盲区,主要的技术难点在于摄像头关联模型。李志华[1]等提出当目标离开某摄像头视域后,检测其相邻摄像头中新出现的目标,利用新目标的SIFT特征与数据库中需匹配目标的特征进行对比,若比对成功,则将原摄像头中的目标编号赋予给新摄像头中的目标。缺点是需提前知道摄像机的拓扑结构,需要网络和服务器能够承受较大的负荷。Xiaotang Chen[2]等人在Javed[3]等人工作的基础上,提出用非监督方法构建摄像头间转移模型,利用摄像头间的时空线索和目标的外观线索实现跨摄像机跟踪,采用颜色特征转移算法(CTT)建立摄像头间外观转换模型,缺点是不同的颜色转移方向会极大的影响CCT的性能。重叠区域的跟踪即同一个目标同时出现时多个摄像头中,在这种情况下需要考虑的是图像融合。Khan和Mubarak在文献[4]中计算出重叠区域中每个摄像头的视场分界线,根据各摄像头视域间的单应关系建立目标在相邻摄像头之间的一致性。缺点是相邻摄像头的视域线必须互相可见,否则会降低置信度。

而本文提取图像的SIFT特征,形成视场分界线。当一个新目标进入某摄像机的视野范围内时,根据摄像机的视野分界线就能确定出该目标是否在其他摄像机的视野内,若该目标并未出现在其他摄像头的视野内,给予新标志;否则匹配重叠区域内候选目标中联合概率最高的目标标志。

1 基于SIFT特征匹配的视野分界线的形成

视野分界线即一个摄像机的视野边界线在另一个摄像机中的表现位置,只要在相邻摄像机的重叠区域内找到4对以上的对应点,利用投影不变量关系在重叠视域内做任意点的投影,即可生成视野分界线[5]。然而基于投影不变量的视野分界线生成算法的精度取决于对应点的精度,故本文运用SIFT[6]特征进行特征点的提取,使用RANSAC[7]算法去除误匹配,选择适合的对应点生成视野分界线。

因此如果我们需要拼接来自摄像机自Oi与Oj的两幅图像Ii与Ij,重叠区域即Oi与Oj的可见区域,其视野分界线的生成可通过以下步骤实现:

(1)分别提取Ii与Ij的SIFT特征获取关键特征点集 Fi与Fj,可以表示为 {(xt,yt)|(xt,yt)∈Ft,(xt,yt)∈It,t=i,j}。

(2)利用最近邻搜索算法[8]针对图像中的某个特征点找到与之匹配的邻近点。获取初匹配点集 M={xi,yi)↔(xj,yj)}|(xi,yi)∈Fi,(xj,yj)∈Fj}。

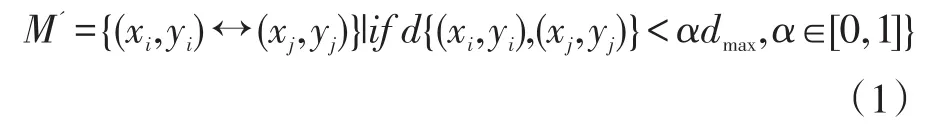

(3)采用特征的欧氏距离作为相似性度量来判定特征点对是否匹配,计算匹配结果中距离的最大值dmax,用于筛选合适的匹配点集M',规则如下:

其中d{(xi,yi),(xj,yj)}代表欧氏距离,α为筛选的阈值,α越少,匹配数量越少,匹配精度越高。

(4)对匹配点集M'采用RANSAC去除野点,获得较准确的匹配点对K'',同时获得RANSAC得到的基础矩阵H。

(5)图像Ii在Ij中相应的视野分界线可通过变换获得,即Oi在Oj的视野分界线通过Ii的边界线s的H变换进行逼近,即=Hs。

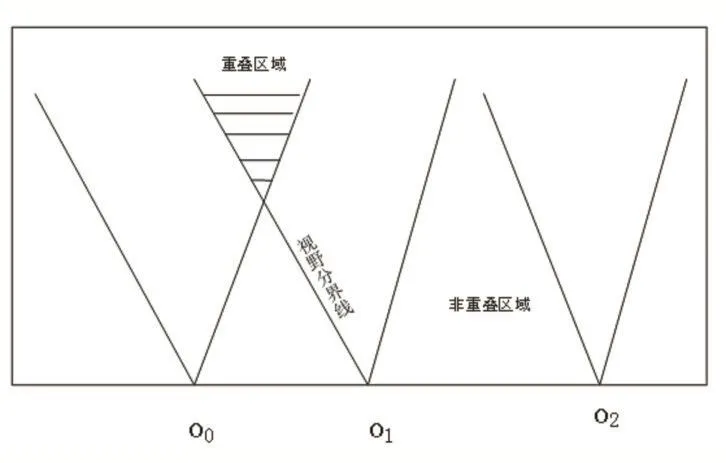

图1 相机的视野分界线示意图

2 基于视野分界线的目标交接

跨相机跟踪的主要难点为目标交接,即当一个目标从一个相机走出或者进入另一个相机是,给多摄像机中观测的同一个目标分配相同的标识。常用的目标交接算法有基于模型的算法,基于特征匹配的算法与基于视场分界线的算法等[9]。而基于视场分界线的算法不需要进行标定,简单高效,故本文以此方法进行跨摄像机的目标交接与跟踪研究。

通过上文的步骤确定了相机的视野分界线后,可以根据视野分界线将场景分为重叠区域与非重叠区域。再根据目标的位置信息与视野分界线的距离判断目标的所在区域。对相机中新进入的目标进行身份判断,并给予正确的标志。

2.1 目标的可见摄像机集合

生成相机的视野分界线之后,通过目标中心位置到视野分界线(可表示为Ax+By+C=0)的位置判断目标是否在其他摄像机视野内。如图3-1所示,对于图像坐标而言,当目标的位置位于视野分界线上方,则可以表示为Ax+By+C>0,当目标位置位于视野分界线下方,则可表示为Ax+By+C<0。

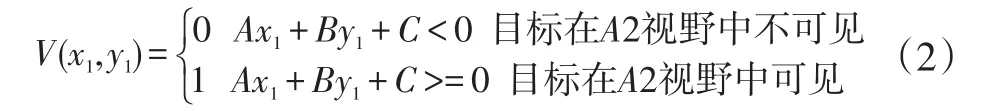

图2 目标位置与视野分界线的关系

当相机O1检测到运动目标P时,记录下其坐标位置(x1,y1)。假设相机O2在相机O1中的视野分界线为Ax+By+C=0,又假设重叠视野区域位于视野分界线下方,那么目标的可见摄像机集合可由以下式子判断:

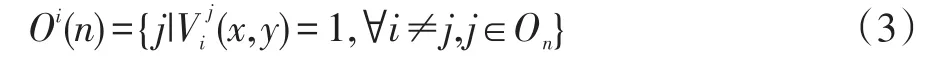

每个图像Ii都有相应的可见区域,其中Vij(x,y)=1表示(x,y)在摄像机Oj中可见,那么可计算在Oi中出现的第n个目标Tin所有可见的摄像机的集合Oi(n):

其中On表示所有摄像机的集合。

2.2 基于联合概率匹配的重叠区域跟踪算法

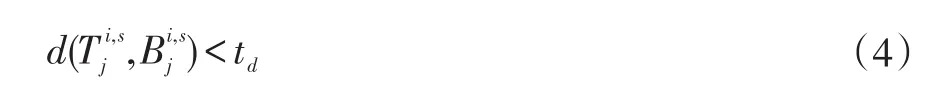

(1)获取 Oi中目标的位置信息,并对于∀Oj∈Oi(n),查找候选目标,候选目标需要满足其中心位置离视野分界线的欧式距离小于阈值td,同时满足候选目标从摄像机Oj向Oi的边s移动。

(2)若满足以上条件的候选目标不只一个,则采用联合概率匹配法,找出联合概率最高的目标,若已经被关联标签blob_id,则给加上相同的标签blob_id,否则,给和附上新的标签。若候选目标集为空,则给附上新标签。

联合概率匹配法的目的是提高目标匹配的准确度。其具体的思想如下:

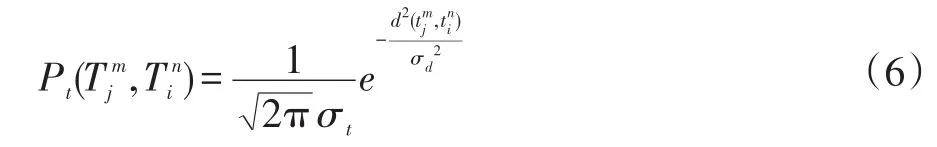

时间距离匹配度为:

其中σt用来控制时间段的范围。

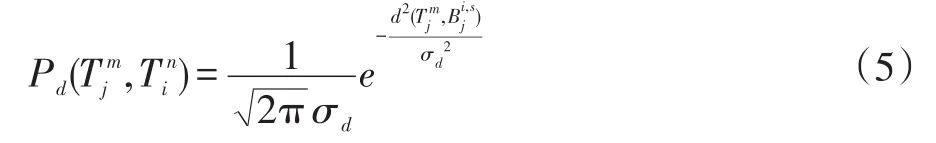

空间距离匹配度:

其中σa用来控制候选目标的区域半径范围,d(x,y)表示向量x和y的欧氏距离。

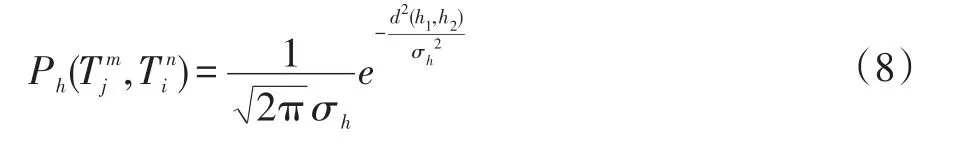

颜色直方图的相似匹配概率:

其中h1,h2分别表示,的颜色直方图,而d(h1,h2)表示两颜色直方图的欧氏距离。

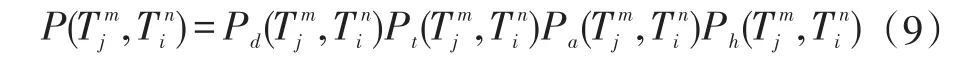

因此,对于待匹配目标Tin,候选目标与的匹配概率为 Pd,Pt,Pa,Ph的乘积,即:

2.3 基于常速度模型的非重叠区域跟踪

假设摄像机Oi与Oj为非重叠的摄像机,当从摄像机Oj消失进入Oi的“盲区”时,利用最小二乘法估算目标在“盲区”的平均速度。通过摄像机Oj中的已知脚点位置和常速度模型估算盲区中的位置。当目标进入摄像机Oi视野之后,其跟踪方法同2.2。

3 实验结果及对比

图3为真实场景中重叠场景的跨区域跟踪结果,其中红色线段代表摄像机的FOV线。

图4为真实的非重叠场景的跨区域跟踪结果,对图 4(a)中红框目标=1持续跟踪一段时间后,目标进入摄像机的非重叠区域,利用常速度模型对目标位置进行预测。目标消失一段时间之后出现在摄像机O2中,检测结果为=5,如图 4(b)所示,然后根据 2.2 的匹配方法持续跟踪,最后匹配结果为=1,见图 4(c)。

图3 重叠区域真实场景跟踪

4 结语

本文的创新点在于基于SIFT特征的视野分界线生成算法,提出基于联合概率的多摄像机跨区域跟踪算法,实现了重叠区域跟踪和非重叠区域的有效跟踪。为了验证算法的准确性,搭建了一个室外的包含重叠区域和非重叠区域的多摄像机跟踪系统。根据实验结果表明,运用此算法的跟踪系统能够实时、稳定的跟踪目标。但是本算法仍需继续改进,相信今后会出现更加鲁棒,更具扩展性,更加智能化的跨摄像头目标跟踪算法。

参考文献:

[1]李志华,陈耀武.基于多摄像头的目标连续跟踪[J].电子测量与仪器学报,2009,23(2):46-51.

[2]Chen X,Huang K,Tan T.Obeject Tracking Across Non-Overlapping Views by Learning Inter-Camera Transfer Model[J].Pattern Recognition,2014,47(3):1126-1137.

[3]Javed O,Rasheed Z,Shafique K,et al.Tracking Across Multiple Cameras with Disjoint Views[C].IEEE International Conference on Computer Vision,2003.Proceedings.2003:952-957 vol.2.

[4]Khan S,Shah M.Consistent Labeling of Tracked Objects in Multipe Cameras with Overlapping Fields of View[J].IEEE Transactions on Pattern Analysis&Machine Intelligence,2003,25(10):1355-1360.

[5]纪慧泉,黎宁.一种基于投影不变量的目标交接改进方法[J].计算机与数字工程,2012,40(4):78-80.

[6]Lowe D G,Lowe D G.Distinctive Image Features from Scale-Invariant Keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[7]Fischler M A,Bolles R C.Random Sample Consensus:a Paradigm for Model Fitting with Applications to Image Analysis and Automated Cartography[J].in Comn.of the ACM,1981,24(6):726-740.

[8]肇莹,刘红星,王仲宇,等.最近邻搜索用于分类问题的一种改进[J].南京大学学报(自然科学),2009,45(4):455-462.

[9]衡林.多摄像机视域中的运动目标检测与跟踪研究[D].南京邮电大学,2013.