基于多路图像融合的目标跟踪系统设计

梁兴建, 雷文, 陈超

(1.四川理工学院计算机学院, 四川自贡643000;2.企业信息化与物联网测控技术四川省高校重点实验室, 四川自贡643000)

基于多路图像融合的目标跟踪系统设计

梁兴建1,2, 雷文1, 陈超1

(1.四川理工学院计算机学院, 四川自贡643000;2.企业信息化与物联网测控技术四川省高校重点实验室, 四川自贡643000)

针对传统视频监控在区域面积较大的场所具有目标跟踪范围有限、小目标特征不全、数据存储浪费、信息检索复杂等问题,提出基于多路图像融合的目标跟踪系统的设计方案及相关算法。根据现有智能视频分析技术,提出基于双重机制的目标检测算法以提高目标检测效率和准确度,设计单摄像头目标跟踪与特征放大并行方案解决目标跟踪不流畅及目标特征不全的问题,提出多摄像头协同跟踪与视频图像融合算法解决大范围连续跟踪问题。实验测试表明,系统能较好地在摄像头之间连续跟踪目标,并将各摄像头获取的目标关键数据进行有效融合,数据存储量小,能满足无人值守时监测需要,具有一定的实用性和可推广性。

多摄像头;目标检测;数据融合;协同跟踪

引言

对于工厂车间、大型超市、银行、物流园区、变电站等场所,由于区域面积较大,人工巡视相当不便,通常需要建设基于多路摄像头的视频监控平台。虽然当前大量监控系统都能支持多摄像头,但是大都还处于传统视频监控阶段,基本不具备智能视频分析的能力[1-2]。目前,常规视频监控系统主要存在以下问题:

(1) 由于独立摄像头视野域的局限性,即使具有运动镜头(PTZ)功能,跟踪范围仍有很大限制[3-4]。

(2) 非智能监控通常只能完成视频录制存储,供事后查找取证,大量的摄像头数据造成了存储设备极大浪费、数据检索复杂、有用信息提取效率低下[5-6]。

(3) 传统监控系统对目标的识别能力不高,不能智能分析、联网跟踪,目标在多个摄像头中的数据难以融合关联。

为了让监控系统在无人值守环境中发挥更大的作用,本文提出基于多路图像融合的目标跟踪系统及相关设计算法,主要研究在无人值守环境下,系统通过双重机制检测特定目标和异常行为,设计单摄像头目标跟踪与特征放大并行方案,通过多摄像头拓扑模型实现摄像头之间协同跟踪及融合有价值的数据,以实现在更广阔的场景范围内长时间立体跟踪特定目标。该系统设计方案为智能视频分析技术未来产业化[7]的实现奠定了良好的技术基础。

1 系统硬件结构设计

本系统硬件设备主要由PTZ网络摄像机、网络交换机、服务器、显示屏等构成。PTZ网络摄像机和服务器通过三层网络交换机进行通信,摄像机将采集到的视频图像通过交换机传送到服务器,显示屏实时播放某个或全部摄像视频,服务器对实时视频进行分析,对具有潜在的威胁(盗窃、火灾等)的行为进行跟踪,同时对事件的原始记录进行存储,并在第一时间通知责任人。系统硬件逻辑架构如图1所示。

图1系统硬件逻辑架构图

2 系统软件模块设计

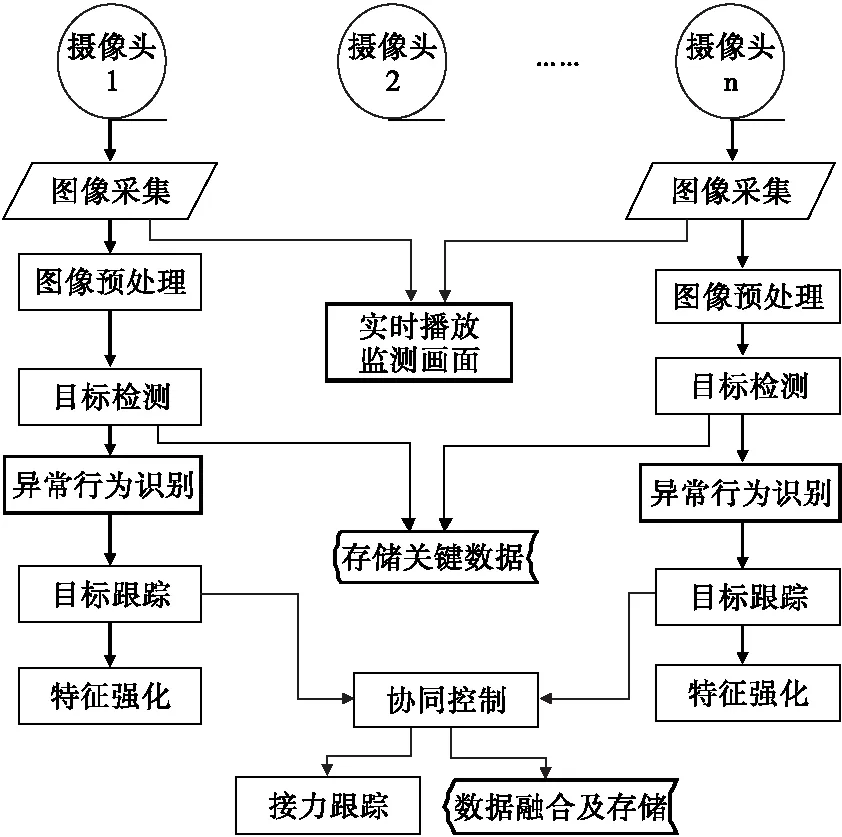

本目标跟踪系统的软件系统主要由图像采集、图像预处理、目标检测与异常行为识别、目标跟踪与特征强化、多摄像头协同及数据融合等功能模块组成,整体框架如图2所示。

图2软件整体框架图

图2中,图像采集模块主要完成从摄像头获取图像;图像预处理模块是对原始帧进行降噪、增强等操作;目标检测和异常行为识别模块主要实现画面中运动目标的有效检测提取,同时分析是否存在异常行为;目标跟踪与特征强化模块是当发现异常行为之后,自动完成云台旋转以跟踪目标,同时调整摄像头倍率,以获得目标的更多特征;多摄像头协同控制模块是当目标接近某摄像头的监视边界,根据目标运动行为预测,智能调度下一摄像头进行接力跟踪,扩大跟踪范围的同时对目标在多个摄像头之间的数据进行融合。

本设计方案在数据处理方面具有两个特色:(1)在数据存储方面,主控机仅对采集的图像进行实时视频播放,只有检测到运动目标之后才进行自动存储,这样便会抛弃大量的冗余数据,既能大大节约存储成本,又能提高对异常数据进行检索和提取的效率;(2)在数据融合方面,能将同一目标在多个摄像头出现的信息进行分析整合,形成一个连贯的运动序列,便于分析目标的运动过程,进一步提高数据检索效率。

3 系统软件实现思路及算法设计

3.1 数据采集模块

数据采集是开启(处于关闭状态的)摄像头,采集图像并进行预处理的过程。当摄像头处于关闭状态时,应先开启并调整到默认预置位,之后再进行图像的采集。为采集的原始图像由于噪声、光照、运动等原因,通常存在图像质量不高的问题,从而降低目标提取和识别的效率[8],为了消除环境对图像质量带来的影响,可通过图像预处理,如高斯滤波等算法变换来减少噪声影响[9-10],为目标特征提取和识别奠定可靠基础。同时利用多线程技术在主控机上进行实时画面播放,以便于操作人员观察实时情况。

3.2 基于双重机制的目标检测算法

由于摄像头跟踪需要旋转云台,因此场景可能会发生变化,为了提高对运动目标检测与提取的效率和准确度,本文提出基于双重机制目标检测算法。如果此时摄像头在某时刻处于无跟踪任务的静止状态,场景不会发生较大变化,此时采用快速高效的三帧差分法[11]进行目标检测;反之,如果摄像头正在转动,说明当前具有跟踪目标,同时场景也随时会发生变化,那么利用相对稳定的Mean-Shift跟踪算法[12]进行目标检测。基于双重机制目标检测算法流程如图3所示,其中min是目标面积最小阈值,根据成像距离可设为30到50个像素之间,低于该阈值将作为噪声处理。

图3基于双重机制目标检测算法流程图

下面分别对两种检测机制进行说明:

其一,针对场景不发生改变,采用三帧差分法进行目标检测,算法过程如下:

Step 1:为了使目标的位置有明显变化而能提取出完整目标轮廓,采用间隔取帧法[13],取出三帧图像,并转为灰度图像,分别记为ft1(x,y)、ft2(x,y)、ft3(x,y)。

Step 2:利用公式(1)与公式(2)分别计算t1与t2时刻、t2与t3时刻的两帧灰度图像的差异区域,分别记为R1(x,y)与R2(x,y)。两个同位置像素灰度相减,结果的绝对值超出一定的阈值T,表示该位置有差异。

(1)

(2)

其中阈值T根据当前光线强度,可设双阈值或自适应阈值等[11,14],一般情况可设在5-20之间。

Step 3:将两次差分结果得到的差异区域R1(x,y)与R2(x,y)进行一次与操作得到运动目标的基本区域I(x,y)。

I(x,y)=R1(x,y)∧R2(x,y)

(3)

Step 4:由于帧间差分法提取的目标容易产生空洞或者轮廓不连续[15],所以针对目标区域I(x,y)还需要利用形态学开闭操作,得到相对完整连续的目标图像,最后再剔除一次面积低于阈值min的噪声点,提取出运动目标。

其二,若摄像头正处于跟踪的过程中,场景会随时会发生改变,此时采用Mean-Shift跟踪算法进行目标定位,本过程可以调用系统函数完成,如OpenCV中cvMeanShift函数定义结构如下[16]:

intcvMeanShift(

constCvArr*prob_image,//目标反向投影图

CvRectwindow, //初始矩形框

CvTermCriteriacriteria, //迭代终止条件

CvConnectedComp*comp//收敛结果

);

以系统中需跟踪目标的原始图像作为感兴趣区域(Region of Interest,ROI)目标图像,通过调用cvMeanShift函数,利用comp返回结果,取出检测到的目标大小和位置。

如果在当前帧提取到了运动目标,应以视频的格式录制存储当前帧,同时更新ROI目标图像。之后进行异常行为识别,在无人值守环境下,目标非正常移动,如跑、跳、搬运等均可认为是异常行为,通过匹配异常模式库,对翻爬、开门、搬运等行为进行识别,同时截取一张图片发送监管人手机,然后根据目标运动情况,判断是否符合跟踪的条件,进入到自动跟踪模块。

如果当前帧没有检测到运动目标或异常行为,则不再进入目标跟踪流程,回到数据采集模块进行下一帧图像的获取,若连续10帧都没有检测到运动目标,则认为目标已丢失,将摄像头调整回预置位,同时关闭对该目标的视频录制文件。

3.3 单摄像头目标跟踪算法设计

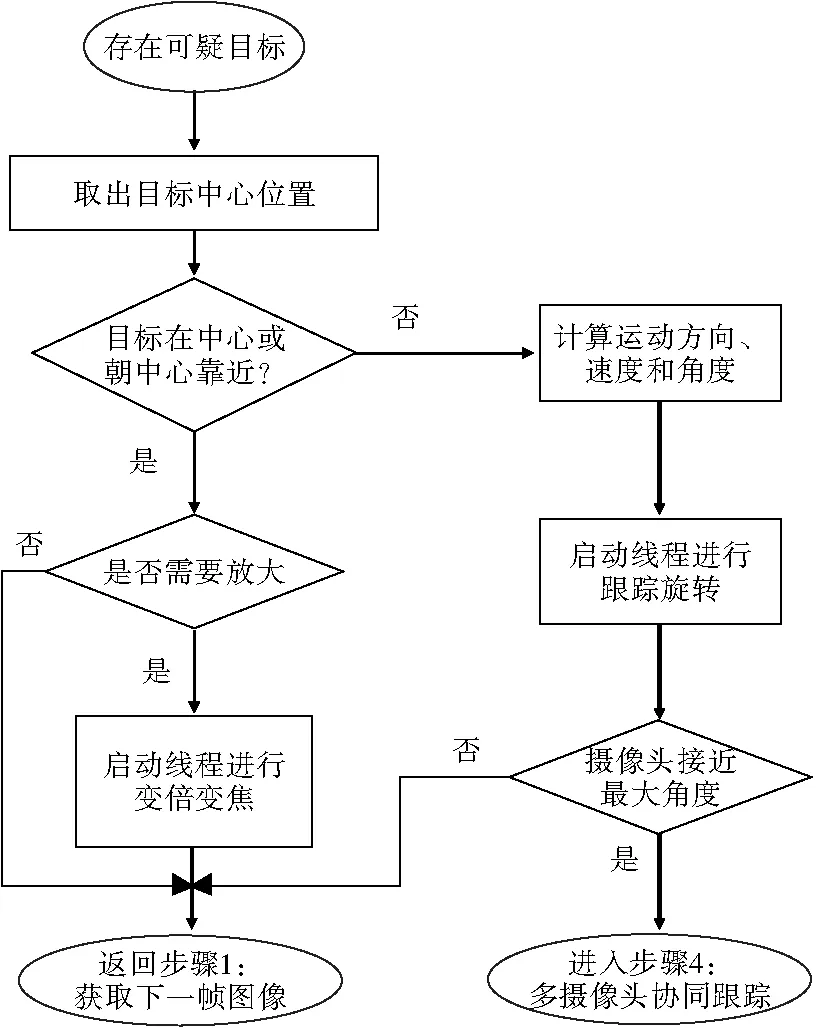

目标跟踪是在发现异常行为之后对目标进行追踪,同时强化目标的特征。该过程包含旋转云台调整跟踪角度,控制摄像头变倍变焦,从光学物理上调整目标大小,放大目标特征。云台自动控制流程如图4所示。

图4目标跟踪流程图

当提取到运动目标的中心位置和大小之后,可根据目标的所在屏幕位置,对比目标在前10帧在画面的位置,预测目标运动方向。根据运动方向,判定目标是否正处于中心范围或将达到画面中心,如果在中心范围,根据目标大小和当前放大倍率,确定是否进行物理放大目标,便于强化目标特征;如果目标有离开视野范围的趋势,一方面缩小放大倍率,扩大视野范围,另一方面,根据目标的运动方向和速度,旋转云台调整摄像头角度,保证目标在最佳视野范围。

具体算法如下:

Step 1:以水平方向为例,之前10帧图像的目标中心位置序列X记为{x10,x9,x8,x7,x6,x5,x4,x3,x2,x1},其中x1为目标在当前帧的位置。

Step 2:根据目标在相邻两帧图像的位置,利用公式(4)计算出目标帧间位移,记为di;

di=xti+1-xti

(4)

那么,之前10帧图像目标的帧间位移序列D记为{d9,d8,d7,d6,d5,d4,d3,d2,d1}。

Step 3:取帧间位移序列D的平均值记为Avg:

(5)

Step 4:根据帧间位移平均值Avg和目标在当前帧的位置,依据公式(6)计算当前应做的操作O。

(6)

其中P为图像的宽度,w为当前目标的宽度,enlarge为做放大操作,reduce为做缩小还原的操作,rotate为做旋转跟踪操作。

随着目标的运动,摄像头接近摄像的最大旋转角度,一旦目标将离开跟踪范围,则进入多摄像头协同模块,调度其他摄像头继续跟踪。

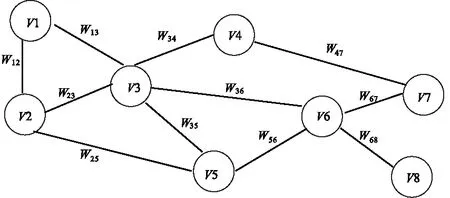

3.4 多摄像头协同与图像融合算法

当某个摄像头接近云台旋转的最大角度,目标即将离开该摄像头的跟踪范围,则需要根据目标的运行方向和速度进行目标行为预测,智能调度下一空闲摄像头连续接力跟踪目标,以达到目标联动跟踪效果。当计算出接力摄像头之后,通过摄像头间的网络拓扑计算接力摄像头需要旋转的方向和角度,然后启动线程旋转云台迎接目标的到来,在完成任务交接之后,取出原摄像头对该目标的录像视频文件作为接力摄像头的融合数据源,接力摄像头在此基础上对目标信息进行追加和融合,并形成完整的行为录像和行为轨迹。具体流程如图5所示。

图5多摄像头协同跟踪流程图

为了解决大场景协同跟踪,应根据目标的运动情况、结合地图交通路线、摄像头的部署,智能调度下一场景的摄像头。目标的位置信息应具有时间空间联系的特性,为了满足特定目标在大范围场景跟踪的实时性和鲁棒性要求,必须提高预测的准确性。因此根据摄像头的分布、朝向和视距,需构建一个完整的多摄像头拓扑模型,再利用网状结构来存储摄像头的参数,为构建摄像头调度优先模型提供计算依据。以某物流园区为例,摄像头拓扑模型如图6所示,{V1,V2,…,V8}为摄像头的分布情况,权重wij为摄像头之间的距离与朝向。

图6多摄像头拓扑模型图

当一个目标离开某一个摄像头的场景时,应迅速根据目标移动的方向、速度和摄像头拓扑模型以及邻接摄像头任务紧急情况等信息,建立摄像头调度优先模型,智能调度相关摄像头协同跟踪特定目标。然后通过上述检测算法在新摄像头的视频中检测目标,完成目标跟踪交接过程,并对重新提取目标的特征信息作为ROI目标图像进行跟踪。同时以原摄像头的视频文件为基础融合存储目标新的运动过程,并绘制目标运动轨迹。其中目标跟踪交接及数据融合算法如下:

假设目标即将离开的摄像机为V1,被调度的摄像机为V2,V1目前正在跟踪过程中记录的视频文件记为目标视频数据源S,通过公式(7)计算出V1和V2任务交接的时机,当交接操作顺利完成后,提取视频数据源S,由摄像头V2继续向视频源S追加该目标在V2中的新数据,同时V1可取消其在该目标的跟踪任务。

(7)

其中f1、f2是通过人脸检测分别在V1、V2中获取的人脸数量,w1和w2分别是V1、V2中目标的大小,x1是目标在V1中的位置,P是画面大小,根据公式(7),当V2检测到目标之后,只有同时满足三个条件:(1)V1中有人脸而V2中没有,(2)目标在V1的大小比V2还大,(3)目标还未达到V1摄像范围的边缘,才继续采用V1做跟踪该目标的主摄像机,否则将切换V2做跟踪该目标的主摄像机。

4 测试效果

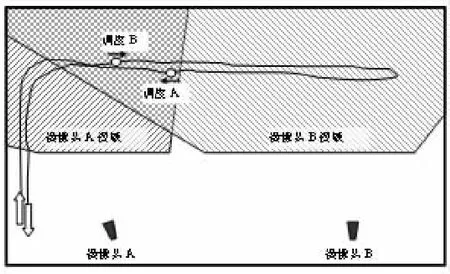

以实验室为室内环境,实验时以快速移动运动的人作为异常行为特定目标,摄像头A、B分别监控室内两个方向,两个摄像头的悬挂方式、监控范围、待测目标移动过程如图7所示。摄像头A检测到目标行为之后进行跟踪,当目标即将离开A的视域范围时需要预测目标是否有朝向B视域范围的趋势,如有则调度B摄像头待命跟踪,A、B摄像头将选择时机进行交接,交接结束后系统将两个摄像头检测的同一目标行为进行视频整合。

图7测试环境示意图

图8双摄像头协同跟踪实验

协同跟踪效果具体情况如图8所示。其中图8(a)~图8(d)为摄像头A对特定目标跟踪情况,图8(e)~图8(h)为摄像头B接受任务后对目标跟踪情况;图8(c)为目标有离开摄像头A的监控范围向摄像头B移动的趋势,系统将调度摄像头B进行目标协同跟踪;图8(d)为目标即将离开摄像头A的监控范围开始交接过程;图8(e)系统完成摄像头A、B目标跟踪任务交接,摄像头B开始跟踪目标;图8(e)~图8(h)为摄像头B在进行目标跟踪时,完成了旋转跟踪、放大特征等事项。

5 结束语

本文提出了基于多路图像融合的目标跟踪系统的设计方案及相关算法,包含该系统硬件平台搭建和软件系统设计。根据现有智能视频分析技术,提出基于双重机制的目标检测算法以提高目标检测效率和准确度;设计单摄像头目标跟踪与特征放大并行方案解决目标跟踪不流畅及目标特征不全的问题;提出多摄像头协同跟踪与视频图像融合算法解决大范围连续跟踪问题;通过仅存储关键帧,解决存储消耗高的问题。综上所述,本系统具有监控范围广、存储消耗低、数据融合便捷、目标检测方便等优势,在智能视频分析技术未来产业化具有实用性和可推广性。但是,智能视频系统仍然还有大量的挑战,如本系统仍未解决的多目标跟踪技术、复杂行为理解等方面的问题,在后期的研究中还需进一步解决。

[1] 雷雨能,张毅,田瑞娟,等.基于DM8168的哨位智能视频监控预警系统的设计[J].机电产品开发与创新,2016,29(6):114-115,102.

[2] 郑朝晖.基于NCC匹配的Camshift目标跟踪算法[J].四川理工学院学报:自然科学版,2015,28(4):37-40.

[3] CHOI H,JEONM.Data association for Non-overlapping Multi-camera Multi-object tracking based on Similarity function[C]//Proceeding of 2016 IEEE International Conference on Consumer Electronics-Asia (ICCE-Asia),Seoul,SouthKorea,October 26-28,2016:1-4.

[4] 熊江江,朱民耀.多摄像头协同跟踪机制的研究与实现[J].电视技术,2011,35(7):98-100.

[5] CANEDO-RODRIGUEZ A,ALVAREZ-SANTOS V,REGUEIRO C V,et al.Multi-agent system for fast deployment of a guide robot in unknown environments[J].Journal of Physical Agents,2012,6(1),31-41.

[6] LEE YS,LEE HJ.Multiple object tracking for fall detection in real-time surveillance system[C]//Proceedings of the 11th international conference on Advanced Communication Technology(ICACT),Gangwon-Do,SouthKorea,February 15-18,2009:2308-2312.

[7] 沈文文.小议面向多摄像机网络的智能视频分析技术[J].中国公共安全,2013(16):136-138.

[8] 浦江,姜代红.基于视觉特性的井下图像去噪新方法[J].河北大学学报:自然科学版,2014,33(1):83-88.

[9] 王学军,赵琳琳,王爽.基于主动学习的视频对象提取方法[J].吉林大学学报:工学版,2013,43(增):51-54.

[10] 柏猛,李敏花,吕英俊.基于对称性分析的棋盘图像角点检测方法[J].信息与控制,2015,44(3):276-283.

[11] 丁磊,宫宁生.基于改进的三帧差分法运动目标检测[J].电视技术,2013,37(1):151-153.

[12] 崔童,李平,曹江涛.基于视频分析技术的校园智能监控系统设计[J].石油化工高等学校学报,2012,25(2):76-80.

[13] 周艺华,曹元大,张洪欣.一种通用的渐变镜头检测方法[J].计算机应用研究,2006,23(2):250-252.

[14] 赵伟.基于内容的视频检索技术的双屏互动系统实现[J].合肥学院学报:自然科学版,2014,31(8):77-80.

[15] 王彬,马永杰,李鹏飞.结合分块的改进三帧差和背景差的运动目标检测[J].计算机系统应用,2015,24(8):155-159.

[16] BRADSKI G,KAEBLERA.学习OpenCV(中文版)[M].于仕琪,刘瑞祯,译.北京:清华大学出版社,2009.

The Design of Target Tracking System Based on Multi-channel Image Fusion

LIANGXingjian1,2,LEIWen1,CHENChao1

(1.School of Computer Science,Sichuan University of Science and Engineering, Zigong 643000, China; 2.Key Laboratory of Higher Education of Sichuan Province for Enterprise Informationalization and Internet of Things, Zigong 643000, China)

Aiming at limited target tracking range, incomplete features in small target, wastage in data storage and complex information retrieval for larger areas in the traditional video monitoring, the design of target tracking system and its algorithm based on multi-channel image fusion is put forward. According to the existing intelligent video analysis technology, the dual mechanism of target detection algorithm is proposed to improve the efficiency and accuracy of detection, single camera object tracking and feature amplification is designed to improve smooth target tracking and integrated target features, multi-camera collaborative tracking and data fusion technology is adopted to ensure continuous tracking in larger range. The tests show that the system can guarantee continuous tracking target in cameras and obtain the effective fusion of key data from each camera. It can satisfy the needs of unattended monitoring with small data storage, which is very practical and can be popularized.

multi-camera; target detection; data fusion; collaborative tracking

1673-1549(2017)06-0040-07

10.11863/j.suse.2017.06.08

2017-09-18

四川省科技计划项目(2017GZ0303);企业信息化与物联网测控技术四川省高校重点实验室基础项目(2013WYJ04);人工智能四川省重点实验室基金项目(2012RYY03)

梁兴建(1979-),男,四川成都人,副教授,硕士,主要从事智能计算与图像处理方面的研究,(E-mail)esun@suse.edu.cn

TP319

A