深度学习进化编年史:一路走来,几十年的风风雨雨

编译/房晓楠

深度学习进化编年史:一路走来,几十年的风风雨雨

编译/房晓楠

人工智能的概念提出已有60多年之久,而关于人工智能、机器学习与深度学习三者之间的关系,在许多人看来一直都是扑朔迷离。本文编译自 Import.io官方博客,作者Andrew Fogg将对这三者之间的关系进行梳理,继而讲述深度学习的成长史,了解深度学习几十年来所历经的风风雨雨。

人工智能自1956年在美国达特茅斯大会提出至今,已经走过了60多个年头,而关于人工智能的定义一直是众说纷纭。一种流传较广的定义是“所谓人工智能,就是与人类思考方式相似的计算机程序”。一般来说,根据应用范围的相应大小,可以将人工智能分为通用人工智能和应用人工智能。近年来,随着技术的发展,人工智能、机器学习和深度学习一直都是业界的热门话题,而这三者之间又具有怎样的关系?

2015年9月,谷歌搜索中机器学习的热度超过人工智能

Google Trends数据显示,自2015年起,机器学习的搜索热度远超过人工智能本身。什么是机器学习呢?一般来说,机器学习(Machine Learning)是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能。决策树学习,归纳逻辑编程,聚类,强化学习或贝叶斯网络等算法都有助于它们对输入数据进行理解。现如今,机器学习在诸如数据挖掘、计算机视觉、自然语言处理、生物特征识别和搜索引擎等领域已经具有十分广泛的应用。可以说机器学习是人工智能的一大跨越式进步,但是并不能伴其走向终点线。

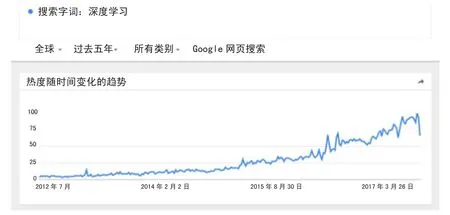

深度学习趋势图

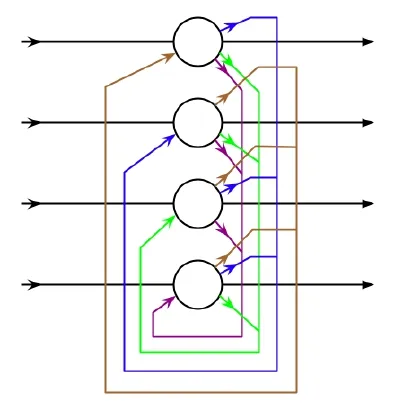

如果机器学习是人工智能的一个分支,那么深度学习就是机器学习的一个分支。而三者之间的关系可以表示为:人工智能>机器学习>深度学习。

简言之,深度学习(Deep Learning)是实现机器学习的一种方式,它是在人工神经网络(ANN)基础上发展而来的表示学习方法。它通过构建多层表示学习结构,组合原始数据中的简单特征,来实现更高层和更抽象的表示。

可以说,深度学习是目前人工智能领域最振奋人心的发展,纵观其发展历程,可以领略深度学习一路走来所展示的传奇风采。

1943年:首个神经网络的数学模型诞生

(推进者:Walter Pitts和Warren McCulloch)

显然,想要解决机器与深度学习的问题,我们首先要做的是建立一个理解人类大脑的神经网络。

1943年,逻辑学家W alter Pitts和神经科学家M cCulloch在创造首个神经网络的数学模型时解开了这个谜题。他们合著了《神经活动中固有的思维的逻辑运算》一书,在书中他们提出将数学和算法相结合的想法,旨在模仿人类思维活动。

他们的模型——通常称之为M cCulloch-Pitts神经元(M-P神经元)在今天仍然是标准模型。

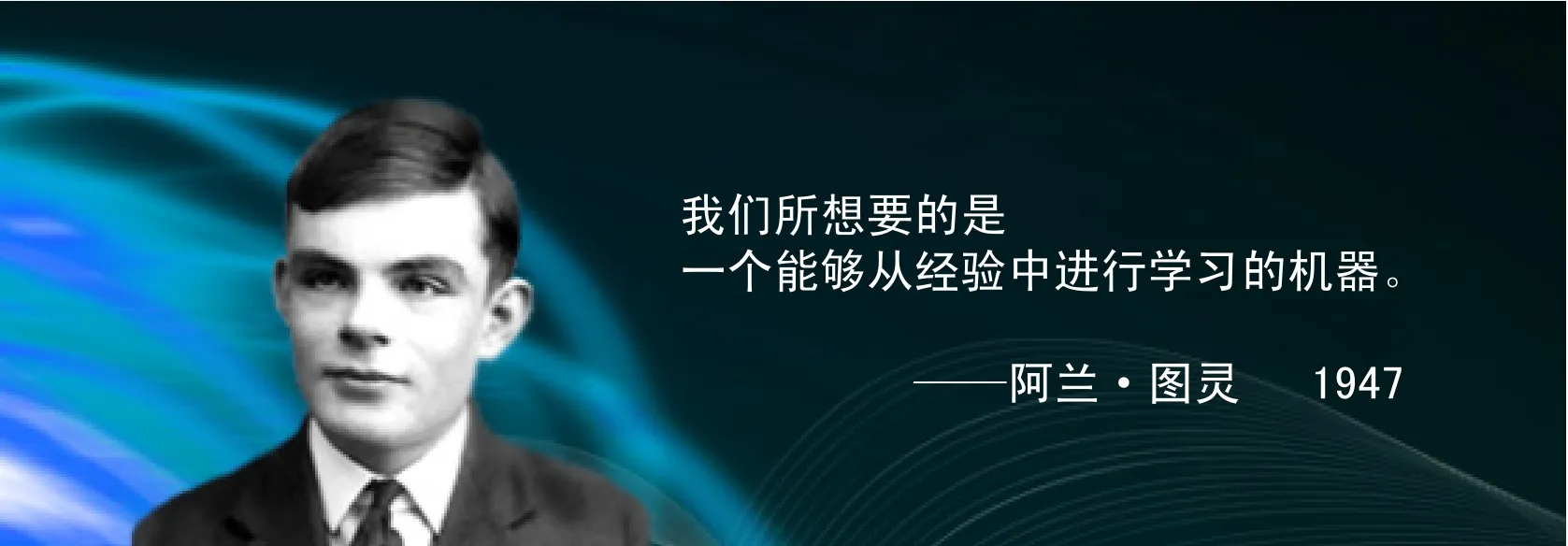

1950年:机器学习的预测

(推进者:阿兰·图灵)

图灵是一名英国数学家,因在二战中破解了德国的Enigma密码而出名。但他在数学和科学界的成就并不止于此。

1947年,他预测出机器学习的发展趋势。而他的这个预测在70年后的今天看来,仍然具有一定的指导意义。

1950年,图灵提出了一种机器算法,甚至暗示了遗传算法。他在论文《计算机器与智能》中精心设计了一种他称之为模仿人类的游戏,据此判断机器是否会“思考”,这就是后来流传甚广的图灵测试。

简单来说,图灵测试就是让计算机以文本方式与人类进行时长为5分钟的聊天,如果人类无法确定对方是机器还是人类,则该机器通过测试。

虽然一直以来这个测试的有效性颇具争议,但不得不说,这是60多年来研究人员一直努力的目标。

1957年:感知器神经网络模型问世

(推进者:Frank Rosenblatt)

1957年,心理学家Rosenblatt向康奈尔航空实验室提交了一篇题为《感知器:感知和识别的自动机》的论文。

在论文中,Rosenblatt首次提出了感知器(Perceptron)的概念。这是首个用算法精确定义神经网络的数学模型,是之后许多神经网络模型的始祖。

他宣称,自己将构建一个电子或电动机械系统,以此来学习识别不同光学、电学或色调信息模式之间的相似性。从某种程度上说,这与生物大脑的感知过程非常相似。

他的这种想法虽然看起来不具备很强的实现性,但确实埋下了自上而下学习的种子,同时也被认为是深度神经网络(DNN)的基础。

1959年:

简单细胞和复杂细胞的发现

(推进者:David H. Hubel和Torsten Wiesel)

1959年,神经生理学家和诺贝尔获得者David H. Hubel与Torsten N. W iesel联手发现初级视觉皮层中的两种细胞:简单细胞和复杂细胞。

可以说,许多人工神经网络(ANN)的发现都是启发于诸如此类的生物学观察。而此项研究虽然不是深度学习里程碑式的研究成果,但对该领域的后续研究有着重大影响。

1960年:提出控制论

(推进者:Henry J. Kel ley)

Kelley本是弗吉尼亚理工学院的航空航天和海洋工程专业的一名教授,1960年发表了论文《最佳飞行路径的梯度理论》。

他提出许多关于控制理论的观点,比如输入系统的行为以及系统行为的反馈修正等,都已在AI和ANN中得到了直接应用。它们通常用于开发训练神经网络中连续反向传播模型(也称之为错误的反向传播)的基础。

1965年:

首个有效深度学习网络的诞生

(推进者:Alexey Ivakhnenko和V.G. Lapa)

数学家Ivakhnenko及其同事Lapa等在1965年创建了首个有效深度学习网络,首次将理论和想法付诸于实践。

Ivakhnenko提出数据分组处理 (Group M ethod of Data Handling,简称GMDH)的核心技术:这是一种基于计算机数学模型的多参数数据集的归纳算法系列,能够自动建模并优化参数。此后他将其应用到神经网络中。

基于此,很多人认为Ivakhnenko是现代深度学习之父。

他的算法使用的是深度前馈多层感知器,逐层通过统计方法来寻找最佳的特征,并将其传递给系统。

1971年,Ivakhnenko在当时计算条件有限的情况下,使用GMDH创造出一个8层的深度网络,并成功演示了计算机识别系统Alpha的学习过程。

Hopf ield网络图片来源:维基媒体

1979-1980年:

ANN学会识别视觉模式

(推进者:Kunihiko Fukushima)

作为神经网络领域公认的创新者,日本的福岛邦彦(Kunihiko Fukushima)于1980年提出了“新认知机”(Neocognitron)的概念。

这是一种学习如何识别视觉模式的人工神经网络。目前,这项技术已经广泛应用于手写字符和其他模式识别、推荐系统甚至自然语言处理等任务中。同时,他的研究成果促进了首个卷积神经网络(CNN)的发展。

1982年: Hop field网络的创造

(推进者:John Hopfield)

1982年,Hopfield创立并推广了一个以他的名字命名的系统——Hopfield。

Hopfield网络是一种循环神经网络,同时也是一种综合存储系统。即使到了21世纪的今天,它仍然是一种流行的深度学习实现工具。

1985年:程序开始学会读英语单词

(推进者:Ter ry Sejnowski)

1985年,计算神经科学家Terry Sejnow ski基于他对人类学习过程的理解创建了NETtalk。

该程序学习英语单词发音的方式与人类孩童无异。同时,随着时间的推进,该程序将文本转换为语音的质量也在逐步提升。

1986年:

形状识别和词汇预测水平提高

(推进者:David Rumelhart,Geof f reyHinton和Ronald J. Wi l l iams)

1986年,Rumelhart、H inton和W illiams提出“反向传播误差算法”(BackPropagation Error Algorithm),即现在所说的BP算法。这项算法至今仍在形状识别、词汇预测等任务中有着广泛应用。

Hinton是公认的“深度学习之父”,他对神经网络有着许多贡献,诸如分散表示、延时神经网络、专家混合系统和亥姆霍兹机等。目前H inton任职于多伦多大学与Google。

1989年:机器读取手写数字

(推进者:Yann LeCun)

LeCun是深度学习领域中的另一个“摇滚明星”,他发现了如何在光学字符识别和计算机视觉上使用卷积神经网络 (CNN),因此被称为卷积网络之父。

1989年,他将卷积神经网络和反向传播理论相结合,创造出能够“读懂”手写数字的学习方法。他的系统最终用于读取NCR和其他公司的手写检查和邮政编码。

1989年:Q-learning的诞生

(推进者:Christopher Watkins)

1989,W atkins在他的博士论文《延迟奖励学习》中,提出Q-learning的概念,提高了强化学习的实用性和可行性。

这种新算法表明,可以直接学习最优控制,而不需要对马尔可夫决策过程的转移概率或预期回报进行建模。

1993年:

“非常深度学习”任务难题得以解决

(推进者:Jürgen Schmidhuber)

德国计算机科学家Schm idhuber在1993年解决了一个“非常深度学习”的任务难题,从而允许循环神经网络中包含1000个以上的层。

这是神经网络处理复杂性问题能力上的巨大飞跃。

1995年:支持向量机(SVM)

(推进者: Corinna Cor tes和VladimirVapnik)

支持向量机(SVM)自20世纪60年代问世以来,经过了数十年的改进。

目前的标准模型由Corinna Cortes和Vladim ir在1993年设计,并于1995年问世。

简单来说,SVM是一种用于识别和映射类似数据的系统,可用于文本分类、手写字符识别和图像分类。

1997年:LSTM的提出

(推进者:Jürgen Schmidhuber和SeppHochreiter)

1997年,Schm idhuber和Hochreiter提出了一种循环神经网络框架,称之为长短型记忆网络(LSTM)。

LSTM解决了长期依赖性问题,提高了循环神经网络的效率和实用性,也就是说LSTM网络可以“记住”更长时间的信息。

随着时间的推移,LSTM网络在深度学习领域中有着广泛的应用。最近,谷歌还将其应用于Android智能手机的语音识别软件中。

1998年:提出基于梯度的学习

(推进者:Yann LeCun)

1998年,Yann LeCun发表了一篇具有开创性意义的论文——《基于梯度学习的文档识别方法》,标志着LeCun在深度学习领域取得了又一大进步。

随机梯度下降算法(又称基于梯度的学习)与反向传播算法相结合,是目前常用的深度学习方法且日益表现出优良的性能。

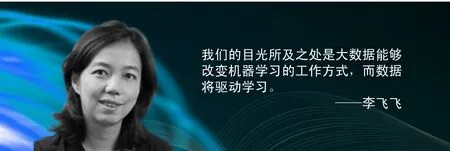

2009年:Im ageNet的创立

(推进者:李飞飞)

2009年,斯坦福大学人工智能实验室(SAIL)的教授兼负责人李飞飞创立了ImageNet,即如今全球最大的图像识别数据库。

这是一个免费的图像数据库,里面涵盖了超过1400万张图像,为研究人员、教育工作者和学生提供了有标签的图片。

数据库中的图片被打上标签并通过英文词汇数据库W ordnet管理。

2011年:AlexNet的问世

(推进者:Alex Krizhevsky)

AlexNet是2012年ImageNet竞赛冠军获得者Alex Krizhevsky设计的,是卷积神经网络的一种。借于此,Alex Krizhevsky在多个国际机器学习和深度学习竞赛中获得胜利。

AlexNet改进了LeNet5(早些年由Yann LeCun创建)。它最初只有8个层,包含5个卷积层和3个全连接层,并通过修正线性单元来加强速度和dropout。

自AlexNet问世以来,相继出现了许多更多更深的神经网络,它甚至为后续的CNN甚至是R-CNN等其他网络定下了基调。

2012年:关于猫的实验

“关于猫的实验”?这听起来是不是令你感到很困惑,但是又很可爱,其实这些都不重要,重要的是,这个实验确实使深度学习向前迈进了一大步。

实验团队同时在数千台电脑上使用一个神经网络,将1000万张从YouTube视频截来的未标记图片上传至系统,并运行。

当这种无监督学习完成时,程序已经学会如何鉴别并从中识别出猫,该程序的运行正确率约为70%,相较于以往的无监督学习程序,这个结果要好得多。但它并不完美。这个网络仅能识别出约15%的表示对象。也就是说,距离真正的智能,它仅仅迈出了很小的一步,而接下来,还有很长的路要走。

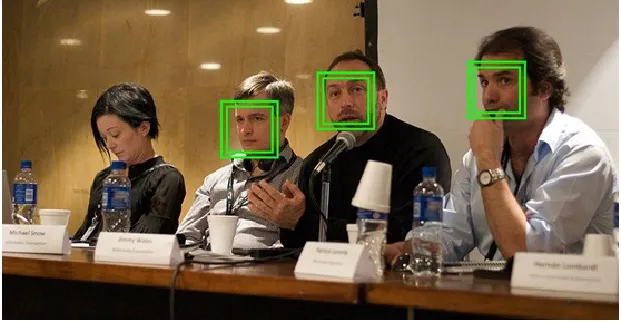

2014年:Deep Face的诞生

(推进者:Facebook团队)

Facebook团队在2014年首次公布了DeepFace的研究,通过神经网络将人脸识别的正确率提升到97.35%。这在人脸识别领域具有重大突破性意义,准确率提高了27%。谷歌也在使用类似的程序来进行人脸识别,如下图所示。

2014年:

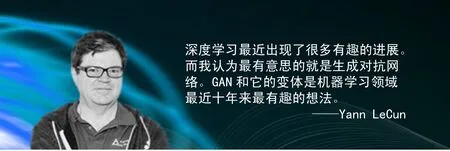

生成对抗网络(GAN)的发现

(推进者:Ian Goodfel low)

自从2014年蒙特利尔大学的Ian Goodfellow等人提出GAN的概念以来,GAN呈现出井喷式发展。同时也因其自身魅力吸引着Yann LeCun的注意,“深度学习最近出现了很多有趣的进展。而我认为最有意思的就是生成对抗网络。GAN和它的变体是机器学习领域最近十年来最有趣的想法”。

简言之,GAN里隐含了两个互相对抗的网络:生成网络与鉴别网络。生成网络负责获取样本并尝试创建能够以假乱真的样本,而鉴别网络则需要判断每个数据点是真实的还是生成的。

2016年:

各种强大的机器学习产品纷涌而出

2016年被称为人工智能的元年。在这一年里,涌现出很多基于机器和深度学习的产品和解决方案。

谷歌使用类似的程序来进行人脸识别

Cray(克雷公司),在其XC50超级计算机上使用微软的神经网络软件,和近千个英伟达Tesla P100 GPU,便可以在几个小时内完成过去几天才能完成的深度学习任务。

总结

在过去的60年里,人类在人工智能、机器学习和深度学习领域都有了不小的突破,如果将这些进展整理成一条粗略的时间线,就会从其中看到整个发展进程。

20世纪60年代:浅层神经网络;

20世纪60年代至70年代:反向传播出现;

1974年至1980年:第一次人工智能的冬天来临;

20世纪80年代:出现卷积的概念;

1987年至1993年:第二次人工智能冬天再次降临;

20世纪90年代:无监督学习的问世;

20世纪90年代至21世纪初:监督学习

重回大众视野;

2006年至今:现代深度学习流行。

如今,也许你还没有意识或感受到,却不得不承认,深度学习早已遍布在我们生活中的多个角落——它是Google的语音和图像识别,是Netflix和亚马逊的推荐引擎,是苹果的Siri,是电子邮件和短信的自动回复,是智能聊天机器人……

深度学习的下一步发展方向是什么?它会给我们带来什么?这些都是很难说的。也许就在下一个路口,也许是在几年后。对于如此复杂的学习,很难去预测它的发展时间表。

但有一件事是可以肯定的,那就是:未来一定会是非常有趣的。

房晓楠 本刊编辑