基于超像素分类的显著目标检测

李继德 李晓强 沙彩霞

(上海大学计算机工程与科学学院 上海 200444)

基于超像素分类的显著目标检测

李继德 李晓强 沙彩霞

(上海大学计算机工程与科学学院 上海 200444)

结合边界-中心先验信息与超像素分割技术提出一种新的显著性目标检测方法。首先对种子点进行分类,使得分割后的超像素具有背景或前景属性。然后,从空间和颜色两个方面对每个超像素区域计算其背景显著性和前景显著性。最后,对不同的显著性值进行融合得到最终显著性值。一方面通过实验说明空间、颜色、前景和背景等因素在显著性计算中具有重要作用;另一方面,通过与其他显著性检测算法进行比较,证明该方法优于现存的8种方法。

显著性检测 超像素分割 边界-中心知识 前景-背景

0 引 言

人类对外界信息的感知,80%是通过视觉获取的。如何让计算机拥有和人类一般高效、灵活的视觉,是人类一直不懈追求的目标。依据早期科学家对于人类视觉的研究成果可知,人类对于所见的事物不是一概全部吸收,而是有选择的接纳,学术上称这种人类所关注的部分为显著目标。相对应地,人类大脑能自动地将所见场景转化为显著图,提取出显著目标,摒弃非显著目标以进行后续的信息处理。

早期关于视觉显著性的研究是建立在生物驱动模型[1-3]的基础上,研究的问题是人眼的关注点在什么位置,其致力于寻找图像中的若干个人眼关注的点。近几年来,关于显著性的研究致力于目标级显著性检测[4-5],不同于生物驱动显著性仅致力于研究某些点在什么位置,这里研究的是显著目标在什么位置。关于目标级显著性检测的研究已经越来越受到人们的关注,因为这种方法有更好的实用性,例如显著目标检测已经广泛应用于图像分割[6-7]、自适应压缩[8]、图像检索[9]等计算机视觉技术中。

一般来说,显著性计算的复杂度较高。为简化计算量,本文用SLIC超像素[10]方法对图像进行分割,以分割后的超像素为处理单元进行显著性计算。另外,在选取种子点时用使用文献[11]中的边界-中心知识,并对种子点进行分类,使得分割后的超像素具有背景或前景属性。然后,本文从空间和颜色两个角度对每个区域计算背景显著性和前景显著性。最后,将所有因素融合得到最终显著性。

本文的显著性检测方法有以下三个方面的优势。首先,由于本文的处理单元为超像素而非像素,因此计算量得以大大缩小。其次,本文从背景、前景、颜色和空间四个方面计算显著性,并分析各个要素的重要性。最后,通过在公共数据集上的大量实验,证明本文方法优于现存的8种方法。

1 相关工作

随着显著性研究的不断发展,很多学者将显著性的研究投向于确定显著目标这一新型意义上的显著性。这种显著性在图像分割,图像自适应等图像应用领域更具有实用性。对比度是最为常用的目标级显著性模型的表示手段,依据对比的范围可分为局部对比度算法和全局对比度算法。局部对比度是指处理单元将与其附近某个邻域内的所有处理单元关于某种特征的对比度,而全局对比度是指处理单元与整个图像处理单元的对比度。

早期关于对比度的研究,着重于局部对比度[12-14]。1998年,Itti等[12]提出“中心-周边差”的概念,即典型的视觉神经对于对抗性的差异更为敏感。基于此,通过计算中心区域和周边区域关于亮度、颜色、方向三种特征的差异,得到中心区域的显著性。2008年Achanta等提出Itti方法的简化方法[14]。该文认为Itti方法之所以计算量大是因为采用了多级金字塔来计算“中心-周边差”,为减少计算量,本文采用滑动模板的方法,以同一像素为中心的大小不同的两个均值模板对图像卷积然后求差,从而简化“中心-周边差”的计算复杂度。

局部对比度应用广泛,然而大多数局部对比度方法普遍存在的缺陷是只能检测出边缘,显著目标内部则不能比较均匀地表现出来。对于这个问题,全局对比度[15-16]给出更好的解决方案。

2010年Goferman等人提出上下文内容相关的显著性检测方法[15]。为体现出上下文内容相关的特点,他们把每个像素点及其周边某个尺度范围作为处理单元。另外,通过计算每个像素与其距离最大的k个像素的平均距离,作为对全局对比度的简化。最后,将不同尺度下所得的值整合成为一个显著值。2011年Cheng等人提出基于颜色直方图对比度的显著目标检测方法和基于区域对比度的显著目标检测方法[16]。基于颜色直方图对比度的显著目标检测方法把像素对比度转化为颜色对比度,并通过对颜色的筛选和过滤,大大减少传统全局对比度方法的计算量;基于区域对比度的显著目标检测方法一方面引入了空间因素,另一方面,把对像素的处理拓展为对区域的处理,以此减少计算量。

除对比度方法外,显著性还有很多其他的表现形式。2007年Hou等人[17]提出谱残差的显著性检测方法。该方法认为显著目标就是图像中的新颖信息,将图像由空间域转化为频率域,得到的频谱图中的非平坦部分就是图像的显著信息。2012年,Wei等人[18]提出基于地形图的显著目标检测方法。该方法在图像边界是背景的假设之上,定义某个处理单元的显著性是该单元到图像边界的最短路径距离,该方法打破了常规的以对比度为核心的处理策略。2013年,Sha等[11]提出了基于边界-中心知识的显著性检测方法。该方法从背景和前景两个角度对显著性进行分析,并利用边界-中心知识对计算进行简化,从而进一步对显著性计算方法进行优化。

文献[11]把显著性计算都孤注在中心区域(作为前景区域)的选择上,若选择失误,则会影响整个算法的正确率。为克服这个缺点,本文以文献[11]的边界-中心知识为基础,结合SLIC超像素,提出基于前景-背景超像素分类的显著目标检测方法。首先,为简化计算量,本文用SLIC超像素方法对图像进行分割,以分割后的超像素为处理单元进行显著性计算。另外,为使超像素具有背景或前景属性,本文在选取种子点时结合边界-中心知识,对种子点进行了分类。然后,本文从空间和颜色两个方面对每个区域计算背景显著性和前景显著性。最后,将所有因素融合得到最终显著性。通过实验证明,本文方法在性能上优于现存的8种方法,同时,本文方法具有相对较少的计算量。

2 本文算法

2.1 背景显著性和前景显著性

文献[11]将全局对比度分解为与前景、背景相关的两个要素。通过研究发现,前景要素总是遏制前景像素的显著性,促进背景像素的显著性,对全局对比度方法产生了负面影响,使得该方法对于目标较大的情况下效果不理想。因此,文献[11]对前景要素进行了修改,使其能够与全局对比度方法所描述的显著性一致。将重新定义的前景要素和背景要素分别称为前景显著性和背景显著性。本文沿用其前景显著性与背景显著性的概念,即图像I中的任意一个像素点Ik的显著性定义为:

S(Ik)=fBSB(Ik)+fFSF(Ik)

(1)

其中,SB(Ik)、SF(Ik)分别表示像素Ik的背景显著性和前景显著性,fB和fF表示背景像素和前景像素所占图像像素的比率。

进一步地,依据纹理特征对背景区域分块,可以将背景显著性的计算转化为:

(2)

其中B={B1,B2,…,BnB},fBi表示区域Bi占整个背景B的概率,SBi(Ik)表示区域Bi对像素Ik造成的显著性影响,i=1,2,…,nB,nB表示前景区域的个数。

类似地,依据纹理特征对前景区域分块,可以将前景区域转化为:

(3)

其中,F={F1,F2,…,FnF},fFj表示区域Fj占整个背景F的概率。D(Ik,Fij)表示像素Ik与区域Fj内的像素Fij的距离,CFj(Ik)表示前景区域Fj对像素Ik产生的影响。

由于每个区域是按照像素的颜色、亮度等进行划分的,因此,可以将区域作为处理单元,这样可以减少计算量。若将所有区域合起来记作{R1,R2,…,RnB+nF},则上述处理单元就转化为Rk,k=1,2,…,nB+nF。

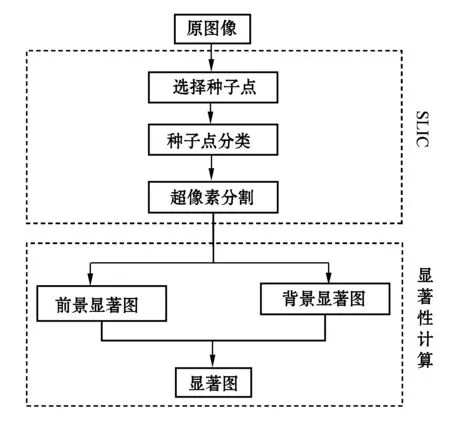

2.2 算法流程

上文分析了图像分块计算显著性的优势,本文用SLIC超像素方法实现对图像的分块。SLIC超像素分割方法是K均值方法的改进,需要选择初始种子点,然后在此基础上迭代收敛,把图像分割若干个超像素区域。

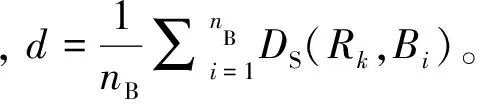

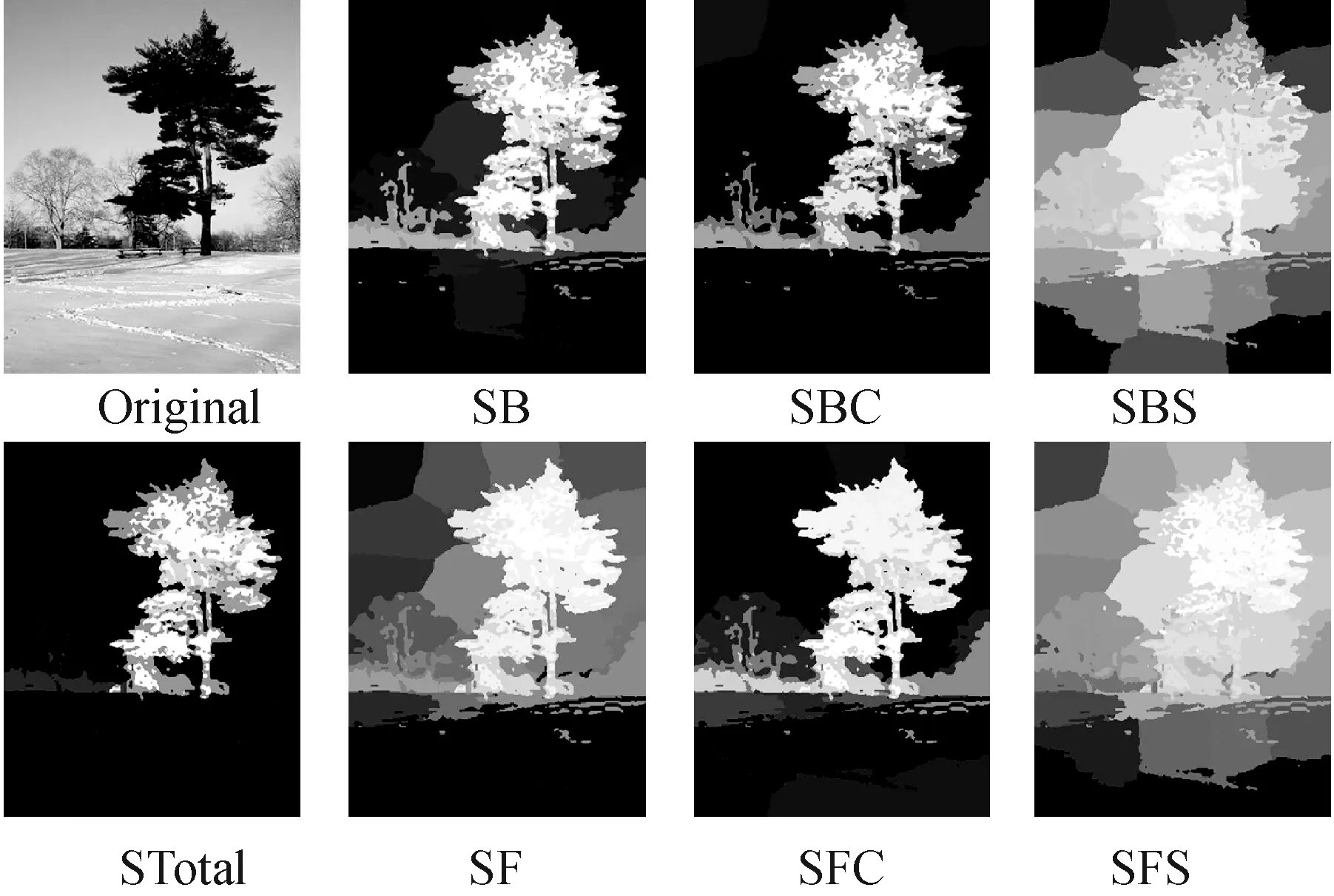

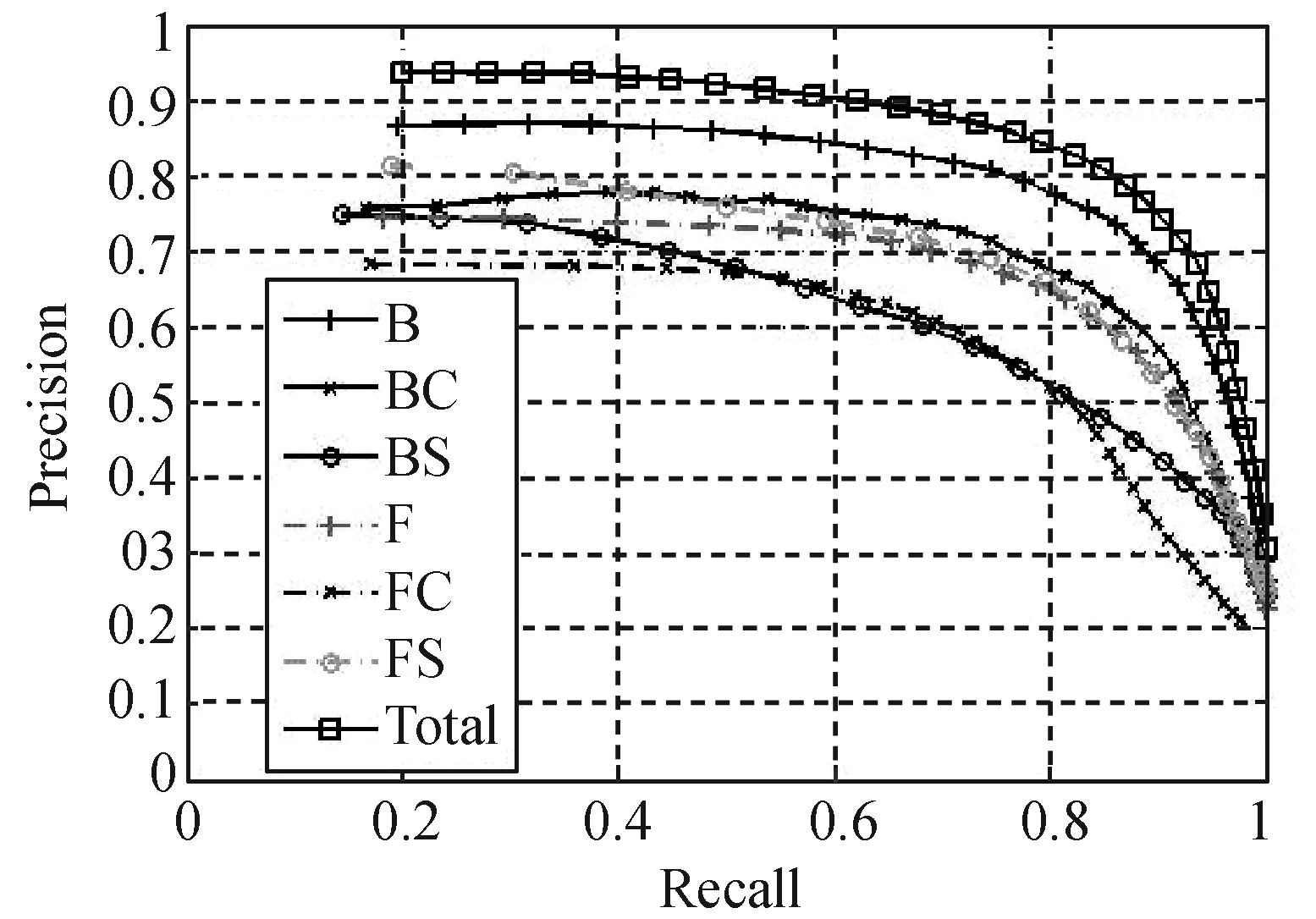

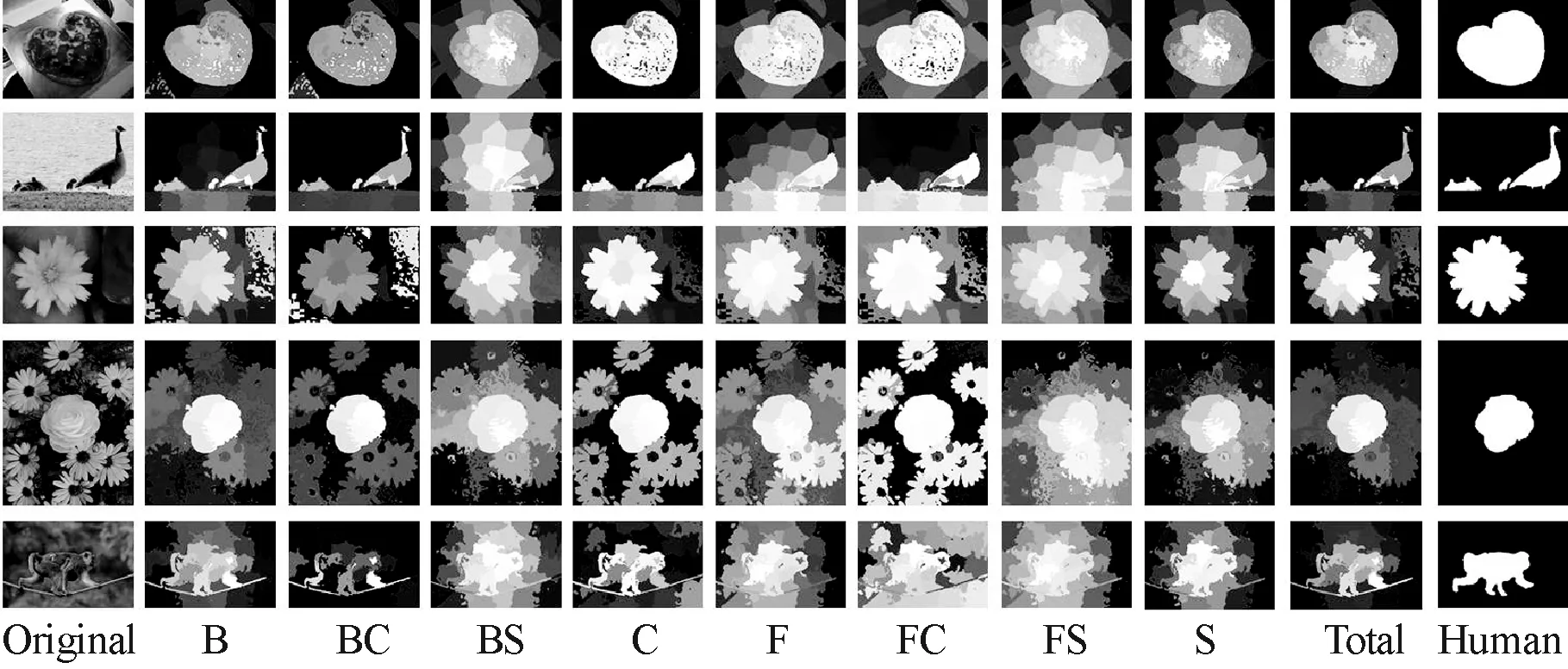

另外,上文说明了对图像进行前景、背景区域分类对于前景显著性和背景显著性计算的必要性。因此,本文需要把这些超像素分类为前景或者背景。然而,我们发现,超像素分割不会更改每个区域前景与背景的本质,只会对其边界进行细化。因此,如果在确定种子点的时候就已经对其分好类,比分割完毕后再进行分类方便得多。本文借鉴文献[11]中的边界-中心知识,在边界区域中选择背景种子点,然后对中心区域中的种子点进行分类。综上所述,可得到本文显著性算法的流程如图1所示。

图1 本文显著性算法流程图

2.3 选择种子点

SLIC超像素方法是对K均值方法的改进,需要选择初始种子点。初始种子点必须均匀分布在图像上面,这样才能对图像进行有效的分割。不同于文献[10]中的SLIC方法,本文采用对图像进行均匀分块的方式选取种子点。

本文借鉴文献[11]中的边界-中心知识选取种子点区域,以便于下一步的分类操作。边界区域的边界位置和边界宽度、中心区域的选择方式都与文献[11]中相同。

图2给出一个选择图片种子区域情况。考虑到背景的多样性,这里将边界区域共分为16个区域,上下左右各4个。另外,为了与边界区域相对应,中心区域也有16个。

图2 种子区域的选择

2.4 种子点分类

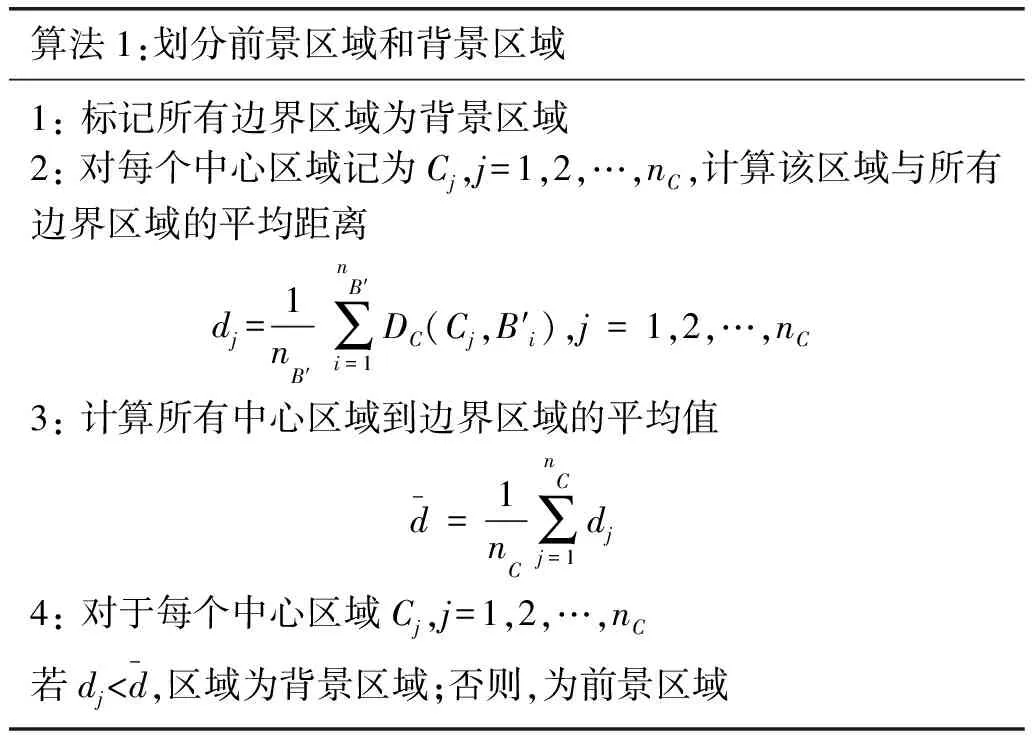

假设已经选择了若干个边界区域和中心区域。关于边界区域,依据边界准则[18],本文将其全部默认标记为背景区域。关于中心区域,由于显著目标的位置、大小具有极大的不确定性,可能位于图片中心区域的任意位置,可能占据任意多个中心区域。这种不确定性使得我们不能随意选择哪些中心区域作为背景区域或者前景区域。因此,本文对中心区域进行分类,将其分为前景区域和背景区域。本文选择的特征空间为HSV颜色空间。图3给出了选择的初始种子点在HSV空间上的分布,其中符号 “o”为边界种子, 符号“*”为中心种子。可见“*”点比较集中,“o”点比较分散,基于此,可对这些点作出分类。

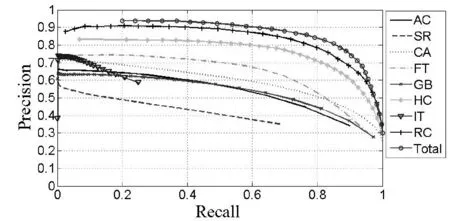

算法1:划分前景区域和背景区域1:标记所有边界区域为背景区域2:对每个中心区域记为Cj,j=1,2,…,nC,计算该区域与所有边界区域的平均距离dj=1nB′∑nB′i=1DC(Cj,B′i),j=1,2,…,nC3:计算所有中心区域到边界区域的平均值d-=1nC∑nCj=1dj4:对于每个中心区域Cj,j=1,2,…,nC若dj 图3 初始种子点在HSV空间的分布 2.5 超像素分割 所谓超像素,是指具有相似纹理、颜色、亮度等特征的相邻像素构成的图像块。它利用像素之间特征的相似程度将像素分组,可以获取图像的冗余信息,在很大程度上降低了后续图像处理任务的复杂度。 上文我们对前景以及背景区域进行初步的分类,然而,我们的目标是对整个图像计算显著性。本文引入SLIC超像素技术,一方面能够利用上文提供的均匀分块的区域作为种子点进行超像素分割,另一方面,超像素分割的结果能够提供较好的边缘分割效果,用分割得到超像素计算区域显著性相较于计算像素级显著性,其计算量可以大大减小。图4为SLIC超像素分割方法对两个图像处理的效果,可以看出该方法能够将显著目标的轮廓很好地分开,从而得到一个完整的目标。 SLIC超像素方法同时在颜色相似度和空间相近性两个方面进行考虑,通过对像素聚类生成超像素。本文的颜色相似度在HSV颜色空间上完成,而空间相近性指的是每个像素点的位置(x,y),它们共同构成一个五维的特征空间(h,s,v,x,y),在此特征空间上对像素进行聚类。 算法初始时,依据2.3节中的方法选择种子区域,计算每个区域的中心Ck=[hk,sk,vk,xk,yk]T作为种子点,即初始聚类中心。定义聚类中心Ck和某个像素点(hi,si,vi,xi,yi)的距离测度D为: (4) 其中,参数m∈[0,1]用来调整超像素间的紧密程度,m越大,越强调空间相近性,超像素间越紧密。 对于图像中的每个像素点,依据距离测度D,在其某个邻域内寻找与其最匹配的聚类中心。然后对属于每一类的像素求平均值,得到新的聚类中心。不断迭代上述过程,直至收敛。在算法最后,进行连接性操作使得聚类时一些属于同一类却不相连的类相连。至此,我们得到原图像的超像素分割结果。 2.6 显著性定义 本文所求显著性为每个区域的显著性。我们认为每个超像素区域的所有像素,在各种特征上都具有一致性,理应具有相同的显著值,因此,本文用区域的显著性代替区域中每个像素的显著性。在特征方面,本文采用的是五维特征(h,s,v,x,y)。 本文将显著性STotal分为前景显著性和背景显著性,记为SF和SB。前景显著性是指前景像素点对每个像素显著性所做的贡献,背景显著性指背景像素点对每个像素点显著性所做的贡献。由于特征的变化,这里显著性又分为颜色显著性和空间显著性。颜色显著性是指由于HSV颜色特征对显著性造成的影响,空间显著性指由于每个区域的空间位置而对显著性造成的影响。更具体地,颜色显著性又分为背景颜色显著性和前景颜色显著性,分别记为SFC和SBC。空间显著性又分为背景空间显著性和前景空间显著性,分别记为SFS和SBS。 假设一幅大小为m×n的图像,进行超像素分割后得到nB+nF个区域,表示为Rk,k=1,2,…,nB+nF,其中背景区域为Bi,i=1,2,…,nB,前景区域为Fj,j=1,2,…,nF。用DC表示颜色距离,用DS表示空间距离。 首先考虑颜色特征的影响,与文献[11]一样,超像素Rk的各个颜色显著性的定义如下: (5) (6) 关于空间特征,前人[13-14]也曾有过将其纳入显著性范畴的情况,他们大多考虑的是任意两个显著性处理单元,相距越远,显著性影响越小。然而,由于本文的超像素有类别之分,因此,本文的空间显著性也要分类考虑。 首先,对于背景超像素,若按照距离越远,显著性影响越小的角度考虑,距离其最远的超像素应该是其对面的某个超像素,然而那个超像素应该也是背景,所以并不适用。本文关于背景空间显著性的定义为: SBS(Rk)=min{d,m-d,n-d} (7) 对于前景超像素,由于前景目标比较聚集,不会出现背景超像素在图像周边环绕分布的情况,但是与颜色一样,它产生的效果应该是与整体显著性相反的。因此,距离前景超像素越近的超像素,其显著性越大,反之,显著性越小。定义如下: (8) 将背景颜色显著性与背景空间显著性结合构成背景显著性,前景颜色显著性与前景空间显著性结合构成前景显著性。颜色信息强调细节,空间信息强调位置,二者缺一不可,互相补充。因此,这里将两种特征的显著性相乘,取长补短,能够保留下来的,必是在空间和颜色都有优势的超像素。超像素Rk的背景显著性与前景显著性定义为: SB(Rk)=SBC(Rk)×SBS(Rk) (9) SF(Rk)=SFC(Rk)×SFS(Rk) (10) 同样地,为保留前景显著性与背景显著性中共同的显著目标,这里定义超像素Rk的最终显著性为: STotal(Rk)=fB·SB(Rk)+fF·SF(Rk) (11) 其中,k=1,2,…,nB+nF,fB=nB/(nB+nF),fB=nB/(nB+nF)。 图5显示对于同一幅图像,本文中提及的各种显著性算法的结果图。可以看出,通过空间和颜色、前景和背景的互补,才能达到最终的最佳状态。另外,需要注意的是,每一步显著性操作都需要对结果进行归一化,然后继续进行,才能得到最终的显著图。 图5 从左到右,从上到下依次为Original:原图像;STotal:最终显著图;SB:背景显著图;SBC:背景颜色显著图;SBS:背景空间显著图;SF:前景显著图;SFC:前景颜色显著图;SFS:前景空间显著图 3.1 数据集和评估标准 实验中的数据集是由微软亚洲研究院提供的MSRA-1000数据集[4],这是一个经典数据集,为大部分显著性检测算法所采用。这个数据集包括1000张图片,这1000张图片涉及不同的类型,包括自然图像、动物、人、室内图像,室外图像等。更重要的是,该数据集提供了手工分割显著区域的掩模图,为我们评判显著性检测算法的优劣提供了标准。本文实验环境如下:操作系统为Windows 7、CPU为Core 2.5 GHz、内存为2 GB、开发环境为Matlab2013。 本文采用大部分显著性检测算法所使用的固定阈值目标分割方法进行性能评估。首先,对得到的显著图进行二值分割,然后,将二值图与MSRA数据库中手工分割的掩模图相比较,得到不同方法的precision-recall曲线图。分析曲线图,就能比较不同方法的优劣。 获取显著目标二值分割最简单的方法是,用固定的阈值T对显著图进行分割。由于显著值是表示显著性程度的一个值,其范围为[0,255],若阈值只确定为某个固定值,对于不同的图片不具有普适性。这里动态地改变T的值,给它从0到255赋值。针对每一个阈值T,每个显著图都可以得到一个二值图,将这个二值图与手工分割掩模图进行逐像素比较,记录分类正确与错误的像素个数,计算这个阈值下,该显著性检测算法对于该图片的precision和recall,precision和recall的定义如下: (12) (13) 其中,tp表示正确分类的显著像素个数,fp表示非显著像素错误分类成显著像素的个数,fn表示显著像素错误分类成非显著像素的个数。 针对某种显著性检测算法求得的显著图,设定每一个阈值T,都能得到相对应的precision和recall,将这些(precision,recall)在图像中描绘出来,可以得到precision-recall曲线。理想的情况是一种方法既有较高的precision,又有令人满意的recall,以此我们可以对不同方法进行优劣评判。 3.2 背景、前景、空间和颜色因素的比较 首先,对本文提及的几个显著性因素进行一下比较,它们分别记为背景显著性B,前景背景显著性BC,背景空间显著性BS,前景显著性F,前景颜色显著性FC,前景空间显著性FS,最终显著性Total。另外,这里还对颜色和空间两个方面进行了比较,因此,定义了区域Rk的颜色显著性和空间显著性: SC(Rk)=SBC(Rk)×SFC(Rk) (14) SS(Rk)=SBS(Rk)×SFS(Rk) (15) 分别记这两种方法为C和S。 图6给出了B、BC、BS、F、FC、FS、Total以及C、BC、FC、S、BS、FS、Total的precision-recall曲线图。从图6(a)可以看出,背景显著性的效果好于前景显著性,因为在选取前景的过程中可能会出现误差,但是边界部分无疑大多数为背景,因此背景比前景能更好地体现显著性。在背景因素中,颜色比空间能获得更高的效果;在前景因素中,空间比颜色效果更好。从图6(b)可以看出,颜色显著性和空间显著性势均力敌,能获得差不多的效果。在颜色因素中,背景比前景效果好;在空间因素中,前景比背景效果好。 (a) B、BC、BS、F、FC、FS和Total的precision-recall曲线 (b) C,BC,FC,S,BS,FS和Total的precision-recall曲线 图7给出各种因素的显著图比较。从中可以看出,背景在寻找显著目标的能力方面强于前景,但是,背景给出的显著图没有前景的明显,即显著目标显著值不够大。通过二者结合的方式,可以把彼此的弊端去除掉,而得到相对更好的显著图。此外,颜色显著性侧重于细节,空间显著性侧重于整体的位置,二者结合才能够进行精确定位。 图7 9种不同的显著性检测算法的显著图比较。从左到右分别为原图像,B、BC、BS、C、F、FC、FS、S、Total方法的显著图和手工分割图 3.3 本文方法和各种方法的比较 我们将本文方法Total显著性与8种显著性检测算法进行比较,这8种方法分别是由Itti[10](记为IT),Harel[19](记为GB),Hou[17](记为SR),Achanta[14](记为AC),Achanta[20](记为FT),Goferman[15](记为CA)和Cheng[16](HC和RC)提出的。 图8 AC、SR、CA、FT、GB、HC、IT、RC和本文Total方法的precision-recall曲线图 图10 8种不同方法在MSRA数据集上得到的显著图。从左到右分别为原图像,AC、CA、FT、GB、HC、IT、RC、SR、本文Total方法结果和手工分割图像 图8给出IT、GB、SR、AC、FT、CA、HC、RC和本文方法Total的precision-recall曲线。可以看出,本文的Total方法比其他各种方法能够得到更高的precision和recall。 在其他几种方法中,HC和RC这两种基于全局对比度的显著性检测算法,有更大的优势。在此进一步对Total、RC和HC方法进行比较,如图9所示,给出了三种方法显著图的像素分布图,横轴表示像素值,范围为0到255,纵轴表示属于该像素值的像素在显著图中出现的概率。本文Total方法得到的显著图显著值主要集中在0和255两个值上面,且值为255的像素占多数。这样得到的显著图,效果更为明显,显著目标亮度更大,非显著目标亮度更小,很容易进行区分。也由于这个原因,Total方法的precision-recall曲线不能达到recall为0的地方。而RC方法,主要是显著值为50左右的像素占据多数,这样就导致整个显著图效果偏暗。类似地,对于HC方法,由于是逐像素处理,因此,其像素分布变化较为平滑,然而大多数的像素分布于靠近0的位置,从而整个显著图呈现较暗的效果。 图10给出AC、CA、FT、GB、IT、RC和Total方法的显著图比较。IT、SR方法是依据生物启发模型建立的,因此其显著图呈现出的特点是只能给出若干关键点,与我们的显著目标检测不符。AC、FT和GB方法属于局部对比度显著性检测算法,所得显著图仅能找出显著目标的轮廓,不能整体地突出目标,效果不甚理想。CA、HC和RC方法是基于全局对比度的显著目标检测,与Total方法相比,其显著目标亮度偏暗,且对于目标较大的情况,如手表等,往往不能正确定位。对于这些情况,Total方法由于调整了前景显著性,能很好地予以解决。 本文提出基于超像素分割的区域显著性检测算法。从边界和中心分别选择一系列区域作为种子区域,然后依据背景先验知识对种子点进行分类。将这些种子点进一步使用SLIC超像素方法迭代进行区域分割。然后,从前景、背景、颜色和空间四个角度出发求显著性,最后,将这些归一化整合得到最终显著图。该方法除超像素分割部分外,计算量特别小。另外通过实验,一方面分析了空间、颜色、前景和背景因素在显著性计算中的重要性,另一方面,与其他显著性检测算法进行了比较,证明了本文方法优于现存的8种方法。 本文成果可以用于高精度分割算法的预处理中,先用显著性算法检测出目标区域并获得其粗略边界,再使用抠图算法实现高精度分割;也可以用于图像检索,在检测到显著目标后,提取显著目标区域的特征以便进一步提高检索的准确率。 在未来的研究中,可以考虑加入纹理特征进行显著性研究。此外,需要使用更多的实验数据集对各种方法进行全面地评估。另外,可以考虑加入一些自顶向下的先验信息,这样能大大提高显著目标提取的正确率。 [1] Judd T,Ehinger K,Durand F,et al.Learning to predict where humans look[C]//Proceedings of the IEEE 12th International Conference on Computer Vision,2009:2106-2113. [2] Kootstra G,Nederveen A,Boer B D.Paying attention to symmetry[C]//Proceedings of the British Machine Vision Conference,2008:1115-1125. [3] Ramanathan S,Katti H,Sebe N,et al.An eye fixation database for saliency detection in images[C]//Proceedings of the 11th European Conference on Computer Vision,2010:30-43. [4] Martin D R,Fowlkes C,Tal D,et al.A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics[C]//Proceedings of Eighth IEEE International Conference on Computer Vision,2001:416-423. [5] 朱斐文,肖菁, 戴晨,等.一种高效的基于局部特征的显著区域检测算法[J].计算机应用与软件,2012,29(8):5-9. [6] Han J,Ngan K N,Li M,et al.Unsupervised extraction of visual attention objects in color images[J].IEEE Transactions on Circuits and Systems for Video Technology,2006,16(1):141-145. [7] Ko B C,Nam J Y.Object-of-interest image segmentation based on human attention and semantic region clustering[J].Journal of the Optical Society of America A,2006,23(10):2462-2470. [8] Christopoulos C,Skodras A,Ebrahimi T.The JPEG2000 still image coding system:an overview[J].IEEE Transactions on Consumer Electronics,2000,46(4):1103-1127. [9] Chen T,Cheng M M,Tan P,et al.Sketch2Photo:internet image montage[J].ACM Transactions on Graphics (TOG),2009,28(5):89-97. [10] Achanta R,Shaji A,Smith K,et al.SLIC superpixels compared to state-of-the-art superpixel methods[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(11):2274-2282. [11] Sha C,Li X,Shao Q,et al.Saliency detection via boundary and center priors[C]//Proceedings of the 6th International Congress on Image and Signal Processing,2013:1066-1071. [12] Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259. [13] Ma Y F,Zhang H J.Contrast-based image attention analysis by using fuzzy growing[C]//Proceedings of the Eleventh ACM International Conference on Multimedia,2003:374-381. [14] Achanta R,Estrada F,Wils P,et al.Salient region detection and segmentation[C]//Proceedings of the 6th International Conference on Computer Vision Systems,2008:66-75. [15] Goferman S,Zelnik-Manor L,Tal A.Context-aware saliency detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2010:2376-2383. [16] Cheng M M,Zhang G X,Mitra N J,et al.Global contrast based salient region detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2011:409-416. [17] Hou X,Zhang L.Saliency detection:A spectral residual approach[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2007:1-8. [18] Wei Y,Wen F,Zhu W,et al.Geodesic saliency using background priors[C]//Proceedings of the 12th European Conference on Computer Vision,2012:29-42. [19] Harel J,Koch C,Perona P.Graph-based visual saliency[C]//Proceedings of the Annual Conference on Neural Information Processing Systems,2006:545-552. [20] Achanta R,Hemami S,Estrada F,et al.Frequency-tuned salient region detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2009:1597-1604. SALIENT OBJECT DETECTION BASED ON SUPER-PIXEL CLASSIFICATION Li Jide Li Xiaoqiang Sha Caixia (SchoolofComputerEngineeringandScience,ShanghaiUniversity,Shanghai200444,China) A new salient detection method combining super-pixel segmentation with boundary-center priors is proposed.Firstly,the image is segmented by SLIC method to get super-pixel region classified as background or foreground.Then,we calculate the saliency of the regions in the respect of color and space.Finally,the fusion of different aforementioned salient value is computed as the total saliency.In the experiments,the importance of foreground,background,color,space in salient calculation are analyzed;on the other side,extensive experimental results show that the performance of this method is higher than the other 8 state-of-the-art saliency detection methods. Salient detection Super-pixel Boundary-center priors Foreground-background 2015-10-20。国家自然科学基金项目(61402279)。李继德,硕士生,主研领域:图像分析和理解。李晓强,副教授。沙彩霞,硕士。 TP3 A 10.3969/j.issn.1000-386x.2017.01.033

3 实验和讨论

4 结 语