面向数据中心网络的高速数据传输技术

秦宣龙,李大刚,都 政,陈远磊

(1. 北京大学深圳研究生院 信息工程学院,广东深圳 518055;2. 国家超级计算深圳中心(深圳云计算中心)高性能计算部,广东深圳 518055)

面向数据中心网络的高速数据传输技术

秦宣龙1,李大刚1,都政2,陈远磊2

(1. 北京大学深圳研究生院 信息工程学院,广东深圳518055;2. 国家超级计算深圳中心(深圳云计算中心)高性能计算部,广东深圳518055)

数据中心是云计算和大数据应用的基础设施,目前数据中心网络基本都是采用TCP/IP协议并基于以太网技术搭建。随着以太网的提速,TCP/IP协议及其实现方式已经无法适应高速数据传输的需求,成为网络性能进一步增长的瓶颈。在分析了现有数据中心网络的特点以及网络实现的开销和性能之后,文章对多种网络性能优化技术进行了比对和总结,并且分析了下一步的研究方向。

TCP;数据中心网络;以太网;RDMA

本文著录格式:秦宣龙,李大刚,都政,等. 面向数据中心网络的高速数据传输技术[J]. 软件,2016,37(9):01-07

0 引言

随着云计算和大数据应用的不断发展,互联网中的计算和存储服务越来越依赖于数据中心。近年来国内许多学者针对数据中心在不同场景之下的应用也展开了广泛研究[30-33]。数据中心大多基于成熟且廉价的服务器和以太网设备搭建,采用广泛使用的TCP/IP协议来完成数据的传输。随着以太网技术的快速发展以及数据中心应用对网络性能需求不断上升,通常我们通过带宽、延迟和CPU占有率来作为性能指标,而TCP越来越成为数据传输的性能瓶颈。TCP主要带来两个方面的问题,首先是数据在网络传输过程中遇到的挑战。TCP的传输控制机制依赖于端到端反馈,并采用重传机制来实现可靠传输,对数据中心常见的短流来讲调整过于缓慢;再加上慢启动和丢包时的速率减半带来的流量剧烈变化,其过于繁杂的算法机制并不适用于数据中心高带宽低延迟的情况,对于网络性能而言这都是需要提升和解决的问题。另一个方面整个TCP/IP协议栈在主机端都是通过Socket软件实现,整个数据传输过程需要CPU的参与,在高包速率情况下会大量占用CPU时间,甚至使得CPU变成数据传输的瓶颈。另外在Socket的架构下数据会在系统内存、处理器缓存和网卡缓存之间来回进行拷贝,给服务器的CPU和内存带来严重的负担。这些因素都会造成数据中心网络性能受损,为此研究者们尝试了不同思路来解决这个问题。首先提出了对TCP协议的优化,Jeonghoon[19]提出了TCP速率调整的算法,Hammann[20][27]提出了ECN标记算法,Tang[21]提出了DMA零拷贝技术等等,这些对TCP和主机端的改进在一定程度上都改善了传输性能。

为了更进一步提升数据中心网络性能,本文综述了目前常见的网络性能优化方式,第二章节论述了在保持数据中心网络整体架构不变的情况下采用硬件实现来提速网络处理能力的典型技术。在第三章节论述了从网络协议优化的角度来针对性地改进数据中心网络传输性能的主要方法。第四章节更进一步论述了将RDMA技术引入以太网架构的主要方案及其特点。最后进行了总结。

1 TCP硬件加速方案

随着以太网的速度提升,带来更高的带宽,但是TCP/IP协议是无法满足高带宽下数据中心网络的高带宽、低延迟,低CPU占有率等需求的,这些标准也是对网络性能的衡量方式,而且TCP协议在主机端的处理占用了大量CPU,当包处理量很高的时候对网络性能影响极大,在这一部分如果做到进一步优化,那对网络性能是一个极大的好处,考虑到硬件的处理速度快,使用硬件来处理部分TCP协议会对性能有一个极大的提升。

1.1TCP引擎卸载技术(TCP offload engine, TOE)

TOE是基于传统以太网结构下的一种TCP加速技术,由于数据在主机内的来回拷贝,中断处理给CPU带来过高的负载,TOE技术的中心思想是利用硬件来分担CPU对TCP/IP协议的处理所造成负担,其做法就是将部分TCP协议迁移至网卡中减少主机上CPU对协议栈的校验和检查等处理的需求,减少系统总线之间的数据复制,在处理程序的时候和传统的网卡每发送一个数据包就中断一次不同,它通过运行一个完整的数据处理进程后才触发一次中端,以此来减少主机CPU的中断次数,通过上述的方式TOE大大提升了TCP/IP的效率。

K. Kant[7]对比了使用TOE和不使用TOE情况下网络的吞吐率,在传输速度越快的网络下吞吐率提升就越明显。

W. Feng[8]在MTU为1500和9000的情况下对比了延迟,在两种情况下TOE对延迟都只提高了2微秒左右,但是对CPU的占有率下降非常大。尤其是在多服务器和多流的情况下带宽从无TOE的3000 Mbps上升到7000Mbps.

Jeffrey[9]从基本性能和部署两个问题上描述了TOE并不是很适合现有的网络。作者指出TOE作为一种TCP改进方式无疑是成功的,但是在实际上性能和各方面因素却导致了他日渐衰退的趋势。

首先从基本性能上来说,由于TOE是硬件上的实现,其更新换代的速度可能比不上CPU性能的增加速度,通过硬件做TCP引擎卸载代价过大,Sarker[10]指出现在的NIC系统产品速度可能还不够快,TOE会影响到真实环境下的性能甚至增加延迟,同时由于网卡和主机接口的复杂性,不兼容性,短时间的TCP连接都会导致浪费额外的性能。从部署上来说,基于RAM的可用性TOE可能会有些许限制,使其扩展性受损,同时由于硬件出现问题导致的错误以及质量问题都很难保证。

1.2Intel加速技术(intel acceleration technology, IOAT/IOAT2)

从TOE的思想出发,使用硬件来减少CPU的占有率是一个可行的方法,从多个角度去降低整个系统花费对网络性能提升必然更加有优势,IOAT就是为此提出的。

IOAT(intel acceleration technology)也是Intel为了应对网络I/O瓶颈,IOAT是第一代intel I/O加速技术,是一种平台化策略,因特尔I/O加速技术表达了“以应用为中心的服务器观点”,即I/OAT是将整个平台的整体优化作为解决I/O开销的方案。

Intel I/OAT分析了现有操作系统带来的问题,提出了从三个方面进行优化:

· 降低系统开销(System overhead)

· 实现流线型内存访问(Memory access)

· 优化TCP/IP协议计算(TCP/IP processing)

IOAT采用增强型的DMA技术,在主机端加入了TOE的方式,使得在数据复制时的时间更少以提升CPU的利用率,同时也对TCP协议进行了改进,优化数据包的分离,使得数据得到更快的处理。IOAT的优化是整个系统可能在某一方面优化的力度不够,但是多个方位同步实现,确实提供了更加高效的网络数据传输。I/OAT作为一项开源技术对硬件的支持需求很高,还需要操作系统和特殊的驱动这些都是亟待考虑的问题。

IOAT2在IOAT的基础上增加了多端口,虚拟化,网络存储,应用快速响应,增加了附加协议,附加平台级加速,增加了高级缓存访问(DCA),MSI-X终端快速响应等机制进一步优化整个平台的性能。

Intel公司[11]给出了在不使用优化的状态下CPU的利用率,文中可以看出I/O大小在8KB左右就出现了I/O瓶颈,系统开销、内存访问和TCP处理对CPU利用率从60%下降到30%,在使用IOAT技术后,对比了IOAT和普通以太网下CPU的利用率,明显可以看出CPU的占有率下降,而吞吐率上升。Intel公司[12]从性能上对IOAT技术与TOE技术进行了论证与分析,在吞吐率和延迟上的性能IOAT都远胜于TOE,这两种基于硬件优化网络性能的方式针对有特殊需求的网络使很有意义的,但是对于目前传统的以太网而言想要大规模部署代价过于高昂,研究者期望寻找一种在以太网架构下获得高质量网络的方式。

2 面向数据中心的TCP协议优化

硬件带来的网络性能优化是毋庸置疑的,但是部署起来过于麻烦,研究者们更希望在已有的软件基础上进行优化来获得性能提升,为此首先要了解数据中心的流量结构特征。

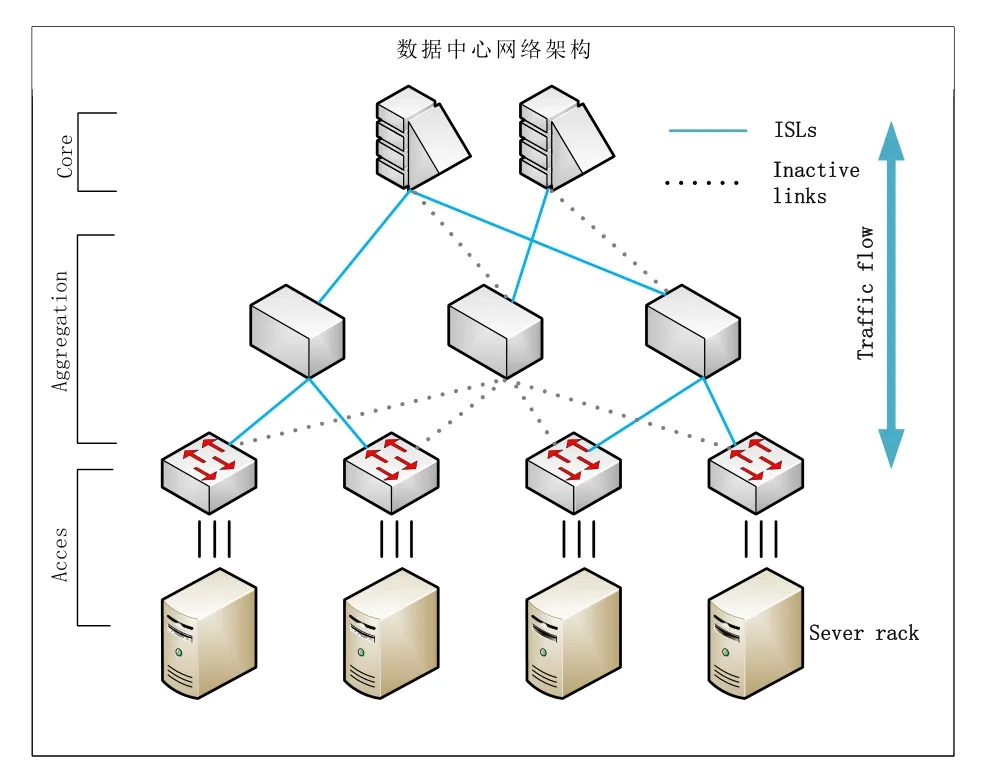

数据中心内部常用的网络拓扑如图1所示,应用数据在节点处来进行频繁交互,而数据中心的庞大流量会给节点带来巨大的负载,从而引起丢包,吞吐量降低的问题,进而可能会造成连接中断,延迟上升,同时数据中心大量采用Partition/ Aggregate的工作模式,高层将自己的deadline分为若干片向下传递,由下层完成,而无法完成时则会放弃任务,这带来的时延代价和响应问题是用户无法接受的。

尤其是在数据中心网络中的短流的比例占90%,TCP Incast现象在高带宽、低延迟,短流多的情况下更易发生,造成性能浪费严重。

但是传统的TCP/IP协议是无法保证数据中心的性能的,由于TCP的“贪婪性”,TCP在发送流量是以尽最大可能交付,所以很有可能在传输过程中引发拥塞,TCP产生拥塞丢包后会进行重发,M.Allman[1]指出TCP在重传初期会经历慢开始的阶段,所以数据在传输时发生拥塞导致重传,会使性能大幅下降,表现在交换机的队列长度产生震荡。同时因为目前的交换机出于商业考虑大部分是浅缓存交换机,而且其缓存是在端口间共享,因此某一个端口的短流很容易因为缺少缓存受到其他端口的大流的影响,这都会大大增加数据传输在网络的延迟。

图1 数据中心网络架构图

而且针对TCP的突发流量其效果也并不好,所以对TCP协议的改进就显得很重要,本章详细描述了DCTCP、D2TCP、L2DCT并进行了总结。

2.1DCTCP

DCTCP使用了一个非常简单的活动管理队列的机制,仅仅使用了标记门限K这一个参数,当队列的长度超过门限K就用CE标记这个数据包,否则就不打标记,这样发送端就可以根据标记的数据包的比例调整窗口的大小,当标记的值越多则下一次发送窗口就降低更多。

M. Alizadeh[4]在文中得出的实验结果可以看出,在1Gbps的带宽下TCP和DCTCP的吞吐量都在0.95Gps左右,链路利用率都接近100%,但是DCTCP的队列长度基本保持在20个包左右,而TCP的队列长度比DCTCP的十倍还要大,在带宽为10Gbps下TCP算法的队列长度抖动的情况非常严重远远超于DCTCP,综上DCTCP能实低延迟和和一定突发流量的容忍能力,在吞吐量上比TCP维持更高且稳定的吞吐量。

DCTCP依赖于ECN标记进行多位反馈,需要依赖于支持这个功能的商业交换机,在早期搭建的数据中心中采用的交换机有可能缺乏对ECN功能的支持,从而影响到DCTCP的部署。

2.2D2TCP

D2TCP在设计时就明确了两个目标,不需要调整交换机硬件和支持传统的TCP协议,D2TCP算法通过ECN的标记数量和数据流的截止时间提供的信息通过伽马函数来调节拥塞窗口的大小。D2TCP可以根据截至时间的不同让数据流获得不同优先级,截止时间比较远的流放弃带宽让截止时间快到的流保证流可以在截止时间内完成传输,这对有时延要求的流来说效果是显著的。

B. Vamanan[5]得出的实验结果可以看出,DCTCP中的流在传输过程被授予相同带宽,而D2TCP中的其他流带宽全部下降这样使得第一个流的完成时间缩短,整个传输过程大约减少了400ms的时延,对突发数据流的容忍能力和带宽都有一定程度提升,比DCTCP错过截止时间的比率降低了75%。

2.3L2DCT

L2DCT也是通过ECN显示拥塞反馈来进行发送窗口的调控同时兼容现有TCP协议。L2DCT通过数据流的大小定义优先级,通过数据流的拥塞程度和权重来调整发送窗口,权重取决于以及发送的数目,这些权重隐式定义了流的优先级,当流的数据量变大时算法就会将他的优先级调低。由于短流的数量庞大,L2DCT更加关注短流的完成时间,当长流和短流并存的时候,长流会放弃自己部分带宽给短流,通过这种方式来减少数据流的完成时间。

A. Munir[29]中得出的实验结果来看,L2DCT相比于DCTCP数据流传输平均完成时间提高了50%,相比于TCP协议提高了95%,错过截至时间的百分率约为TCP的30%,在突发流量的情况和高负载下长流的性能下长流的吞吐量会下降。

L2DCT和D2TCP都是为了尽量少的deadline miss,所以牺牲了一部分长流的性能,对于时延敏感的应用有效,而不同的应用可能采取别的权重分配方式,也有人可以将长流分割为短流作为进一步研究方向。

3 基于RDMA的新型协议

3.1RDMA的技术来源

为了更高效的提高网络性能,研究者们认为TCP的网络僵化、协议创新困难、配置复杂、流量管理繁琐、安全问题凸显,服务尽力而为无法保证服务质量。根据摆脱TCP协议、从新的网络架构下获得高质量网络服务的想法,研究者提出了不基于TCP/IP和以太网的专有网络技术。现在的主流的高速互联网络互联技术有Fiber Channel和Infiniband,一般专用与存储集群。

Infiniband又称为无限带宽技术,是一种异于传统网络架构的新体系,Buyya[15]在文中对Infiniband的体系结构做了详细的介绍,IB基于链路层的流控机制和先进的拥塞控制机制可以防止拥塞,完全的CPU卸载功能,基于硬件的传输协议,内核旁路技术都保证了可靠传输,在IB体系架构里,网络总线DMA技术以RDMA的形式体现,服务器之间通过RDMA来实现数据高效的传输,TCA(通道适配器)结合RDMA技术也在主机端优化了网络性能,可以使得CPU直接移动其他服务器上的数据,这可以带来更高的效率和灵活性。

Fibre Channel是一种灵活的、扩展性强的高速数据传输接口,光纤通道具有很高的传输带宽,无论是在铜线或者是光纤上数据率大约是现在的通信接口的250倍,它的目的就是使用最低的延迟最快的速度进行传输,但是和IB一样安装复杂需要特殊的IB交换机,可扩展的成本较高,传输和普适性方面显得很笨拙,于是研究者们将FC技术和RDMA协议结合起来,将FC搬迁至以太网实现。

3.2RDMA技术特征

针对RDMA给IB和FC带来的网络性能提升,但是却需要特殊的硬件支持,为了使网络更加具有普适性,在结合的RDMA技术所带来的优越的特性进行了调研。

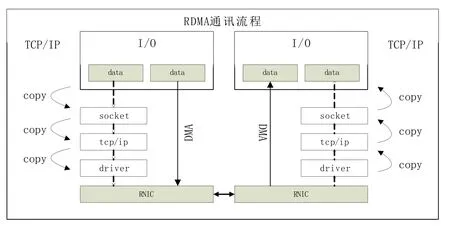

RDMA(Remote Direct Memory Access, RDMA)远程数据存储存取起源于DMA,DMA可以使设备不经过CPU直接和系统内存交换数据,为了使这种性能能在整个网络中使用,又将可靠传输协议固化到网卡(称为RNIC),通过这两种途径数据在传输时不经过内核和部分TCP协议直接从源主机的存储区发送到目的主机的存储区,避免了主机内部之间的重复拷贝,这也形成了RDMA的两大主要特点,零拷贝技术(Zero-copy)和内核旁路技术(Bypass)。零拷贝技术,使数据在接收发送时直接进入缓存而不需要网络层之间的拷贝。内核旁路技术,从用户空间直接访问和控制设备内存,避免了数据从设备拷贝到内核,又再一次从内核拷贝至用户空间。RDMA的数据拷贝计传输实现流程如图2所示

有CPU的参与,就减少了CPU的占有率。同时在RDMA中数据处理事离散的消息而不是以一个流的方式,消除了应用程序区分不同流的信息的需要,这些特点都使得RDMA成为一种数据移动处理的高效方式,在低延迟,高带宽,低CPU占有率的场景下RDMA的应用非常常见,比如HPC, Cloud Computing, Storage and Backup system等等由于解放了CPU网络性能得到巨幅提升。

图2 RDMA通讯协议栈

没这些新型的计算机网络模型在网络性能上确实也得到了显著的增加,但是由于新型体系结构网络模型的更改,RDMA协议在传统的TCP/IP体系下是不支持的,原有在TCP上的服务因为Socket适合协议端口绑定的原因,就无法继续在新的体系架构下,如果想要新的网络模型支持这种应用,势必需要提供新的Socket,这样代价也随之而来。但是由于传统TCP体系结构的落后,导致现在网络的性能很差,应用数据在网络体系上传输的速度没有达到理想中的需求,这也逐渐成为网络性能的瓶颈。新引入的RDMA技术虽然能够达到数据传输的需求,但是由于Socket的不同,所以可能需要针对这项技术提供专门的RDMA应用,考虑到应用大规模部署在以太网中,所以直接革新式的制作新的应用显然代价过于高昂。

从上述的论述中可以得出我们在考虑网络性能的同时也要考虑到现实的应用场景,随着以太网速度提升至40Gbps以上,相比于IB和FC的速度也毫不逊色,所以如果将RDMA协议布置到传统以太网中,那么无论是网络的性能还是从实用上来说都会得到质的飞跃。

3.3iWARP(internet Wide Area RDMA Protocol)技术

传统以太网的从应用处理到操作系统的开销,网络处理,I/O处理,线路延迟等一系列流程导致延迟快速积累,但是随着以太网的提速延迟大大下降,直逼毫秒级延迟,完全可以满足现有的网络架构,如果将RDMA技术布置在以太网上必然能带来性能的大幅提升。

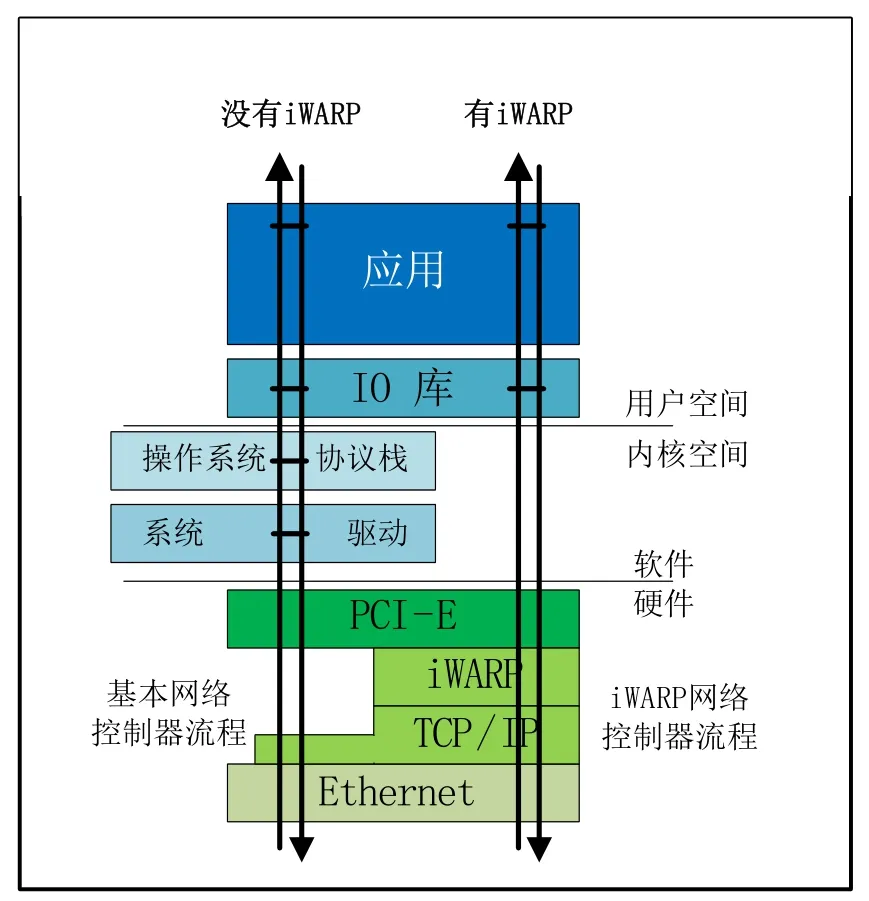

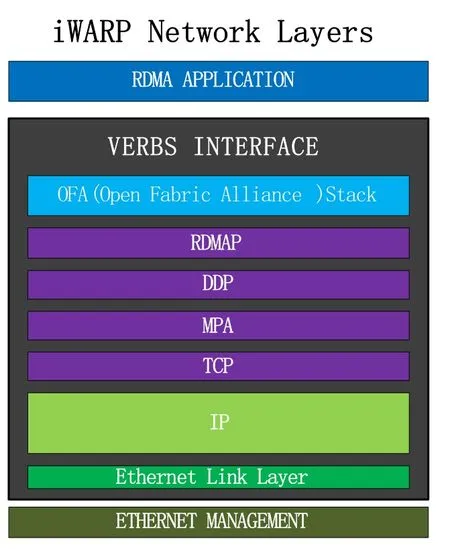

iWARP是一个计算机网络中的协议,能够通过以太网实现远程数据直接访问。iWARP在设计上就是为了适用于现有的TCP传输,利用传统TCP协议达到可靠传输,由于RDMA提供了应用程序到应用程序之间直接通信的能力,跳过了操作系统,实现远程内存应用程序的访问,使得IWARP低延迟变得可能,同时由于IWARP使用普通交换机就可以完成RDMA,所以对比Ether fabric这种私有技术和IB特殊的体系结构,显然更加具有普适性,但是带来的代价就是,IWARP协议族使用了一个复杂的混合层。

在2007年,IETF发布了五个RFC标准定义iWARP,如图4所示,在RFC标准中[22-26]中详细解释了iWARP的协议分工,在DDP(Data Placement Protocol)层上定义了远程数据直接存取协议,这个协议告诉RDMA如何读写数据,MPA层上的DDP定义了如何将数据不通过间接缓存区直接放入上层协议的接收缓存区等。从图3可以清楚的看出有无iWARP协议对整个数据处理的影响。数据直接在硬件部分通过iWARP协议寻址定位到用户空间,避免了内存拷贝。

图3 iWARP和传统架构下数据处理方式

图4 iWARP网络协议栈

iWARP协议主要组件包括了DDP(direct data placement,实现数据传输零拷贝),RDMA(RDMA读和RDMA写),MPA(Maker PDU Aligned framing,数据单元组帧以确保和TCP的消息边界),这种架构使得RDMA在现有的网络中传输变的可能,由于iWARP是通过TCP/IP的RDMA,也享受了TCP/IP提供了可靠的通信路径,支持多地子网寻址功能,以及TCP/IP带来的可扩展性。iWARP由硬件执行TCP/IP的处理,从应用里完全提取出网络协议占的处理,同时由于传统网络对TCP的支持我们在传统网络中部署的应用可以直接使用,这种方式大大减少了我们在硬件,资源等方面的消耗。

Rashti[17]在10Gbps以太网下对比了iWARP和Infiniband的性能,实验显示消息字节在1byte到1Kbyte的情况下iWARP在时延和带宽的性能都是比Infiniband高的。这也说明在高速的网络下即使不适用新的体系结构我们仍旧可以通过RDMA技术来实现性能的提升。而将RDMA应用到以太网上无论从网络性能的角度还是经济适用上都是一个不错的选择。

3.4RoCE(RDMA over Converged Ethernet)技术

随着IEEE提出的数据中心桥接技术(Data Center Bridging, DCB),使得数据链路层性能急剧提升。

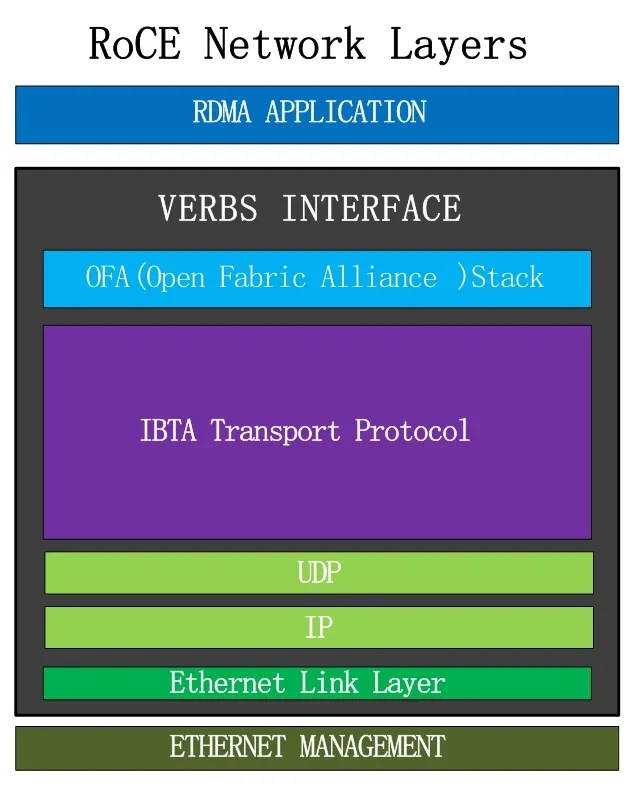

由于DCB提供了拥塞控制,在iWARP的TCP,SCTP和RDDP中提供的拥塞控制功能就变得冗余起来,在DCB中,TCP慢启动行为能够被减弱或者移除,因此在DCB中布置一个最合适的协议来减少iWARP的复杂性和布置问题,RoCE就是在这种情况下提出来的。

IEEE数据中心桥接技术主要包括基于优先级的流量控制(Priority-based Flow Control, PFC),量化拥塞通知(Quantized Congestion Notification, QCN)在DCB技术支撑下实现了无损以太网,以及对RDMA的支持。

RoCE基于融合以太网的RDMA是一种可以极低延迟在无损以太网络上提供高效数据传输的机制,由于RoCE以及RoCEv2的提出使RDMA更加高效的运行在以太网上,RoCEV2是对IB协议栈的一种改进和增强,保留了IB的传输层,使用IP和UDP封装代替了IB的网络层,同时使用以太网代替了IB的链路层,在UDP报头中加入了ECMP,为了有效的运转RoCE同时提供了无损的第二层。图5为RoCE的网络协议栈,相比于iWARP复杂的网络层,RoCE的模型显得更加简单。

图5 RoCE网络协议栈

相比于iWARP,一个包仅仅观察他的UDP目的地端口的值和IANA分配的端口值是否匹配,就可以知道他是否为ROCE包,这种方式在很大程度简化了流量分析和管理。

iWARP使用传统TCP协议栈共享端口,所以会限制了它的高消费和布置的难度。ROCE包头封装了IP和UDP,意味着RoCE可以在L2和L3层运行,可以在L3层路由可以使RDMA带来构造多子网的功能,同时由于Soft-RoCE的布置,RoCE可以通过软件布置而不需要本地硬件,这使得ROCE可以在数据中心获得更加灵活的性能。

在文献[18]中Mellanox对RoCE和iWARP进行了性能的比较,在消息字节大小为100B的情况下,平均延迟相差20微秒,99%的情况下RoCE的延迟比iWARP低40微秒,同时RoCE具有更低的CPU占用率。

4 总结

本文从TCP协议和主机端的数据传输方式分析了传统的网络结构的弊端,总结了几种高效的网络性能提升的方式.

第一类方法考虑到硬件的处理效率,直接将部分协议搬迁至硬件实现提高网络性能,这种方式比较直接,但是需要特殊的硬件支持,不适用于大规模布置,而且硬件更新换代的速度非常快,接口常常难以兼容,接口设置复杂。第二类方法考虑在以太网下对协议优化,在不改变整个架构的基础上做出的性能提升,可扩展性强,而且由于以太网的普遍使用,适用性很强,但是这样做仍旧出于传统的TCP体系下,TCP本身就是一个笨拙的体系结构,在TCP的改进虽然有效,但是随着以太网的提速也慢慢显出不适。第三种方法是将RDMA的想法应用在以太网上,RDMA的思想源于IB,但是由于应用不兼容,体系不同,将RDMA部署在以太网上是一种趋势,而且从数据分析来看,RDMA确实提高了网络带宽,降低了延迟,减少了CPU的占有率,对于网络性能的提升是很可观的,基于以太网的结构又可以让它轻易扩展,是当下提升网络性能的一种较优的方式。

[1] M.Allman, V.Paxson,E Blanton.TCP congestion control. RFC 5681.

[2] Y.Zhu, H.Eran, D.Firestone, C.Guo. Congestion Control for Large-Scale RDMA Deployments. In SIGCOMM Computer Communication Review, New York, USA, 2015:Volume 45 Issue 4

[3] S.Floyd.TCP and Explicit Congestion Notification. In ACM SIGCOMM Computer Communication Review, New York, USA, 1994: Volume 24 Issue 5.

[4] M.Alizadeh, A Greenberg, DA Maltz, J Padhye. Data Center Tcp. In ACM SIGCOMM Computer Communication Review, New York, USA, 2010: Volume 40 Issue 4.

[5] B. Vamanan, J.Hasan, TN Vijaykumar. Deadline-aware Datacenter Tcp. In ACM SIGCOMM Computer Communication Review, New York, USA, 2012: Volume 42 Issue 4.

[6] S.Joy, A Nayak. Improving Flow Completion Time for Short Flows In Datacenter Networks. In IFIP/IEEE International Symposium on Integrated Network Management (IM), Ottawa. ON.

[7] K. Kant. TCP Offload Performance for Front-end Servers. In Global Telecommunications Conference, USA, 2003: volume 6

[8] W. Feng, P. Balaji, L.N Bhuyan, D.K. Panda. Performance characterization of a 10-Gigabit Ethernet TOE. In Symposium on High Performance Interconnects, 2005.

[9] J.C Mogul, P. Alto. TCP offload is a dumb idea whose time has come, 9th Workshop on Hot Topics in Operating Systems, senix Assoc, 2003.

[10] P. Sarker, K. Voruganti. Storage over IP: Does hardware support help? In Proc. 2nd USENIX Conf. on File and Storage Technologies, San Francisco, CA, 2003.

[11] Intel. White Paper. Accelerating High-Speed Networking with Intel®I/O Acceleration Technology. http://www.intel.com/content/www/xr/en/io/i-o-accelerationtechnology-paper.html

[12] Intel. Competitive Guide. Competitive Comparison Intel®I/O Acceleration Technology vs. TCP Offload Engine. http://www.intel.com/content/www/us/en/wireless-network/a ccel-technology.html

[13] J. Shu, B. Li, Weimin Zheng. Design and Implementation of an SAN System Based on the Fiber Channel Protocol. In IEEE Transaction on Computers, 2005: volume 54.

[14] K. Malavalli, High-speed Fiber Channel Switching Fabric services, In Proceedings of the SPIE,USA,1992:Volume 1577

[15] R. Buyya, T.Cortes, H. Jin, An Introduction to the InfiniBand Architecture(http://www.infinibandta.org), In IEEE Press, 2001.

[16] A. Vishnu, A.R Mamidala, W Jin, D.K Panda, Performance modeling of subnet management on fat tree InfiniBand networks using OpenSM, 19th IEEE International Parallel and Distributed Processing Symposium, 2005.

[17] M.J. Rashti, A. Afsahi, 10-Gigabit iWARP Ethernet: Comparative Performance Analysis with InfiniBand and Myrinet-10G, In 2007 IEEE International Parallel and Distributed Processing Symposium, Long Beach, CA, 2007.

[18] Mellanox. White Paper. RoCE vs. iWARP Competitive Analysis Brief. http://www.techrepublic.com/resource-library/whitepapers/ro ce-vs-iwarp-competitive-analysis-brief/.

[19] J. MO, R. La, V. Anantharam, J. Walrand, Analysis and comparison of TCP Reno and Vegas,In IEEE INFOCOM, 1999.

[20] T. Hamann, J. Walrand, A new fair window algorithm for ECN capable TCP (new-ECN), In INFOCOM, Tel Aviv, 2000.

[21] D. Tang, Y. Bao, W.Hu, M. Chen, DMA cache: Using onchip storage to architecturally separate I/O data from CPU data for improving I/O performance, In 16th International Symposium on High-Performance Computer Architecture, Bangalore, 2010.

[22] R. Recio, B. Metzler P. Culley, J. Hilland, D. Garcia. A Remote Direct Memory Access Protocol Specification. RFC 5040, 2007.

[23] H. Shah J. Pinkerton R. Recio P. Culley, Direct Data Placement over Reliable Transports, RFC 5041,2007.

[24] J. Pinkerton E. Deleganes, Direct Data Placement Protocol (DDP)/Remote Direct Memory Access Protocol (RDMAP) Security, RFC 5042,2007.

[25] C. Bestler, R. Stewart, Stream Control Transmission Protocol (SCTP)/Direct Data Placement (DDP) Adaptation, RFC 5043, 2007.

[26] P. Culley, U. Elzur, R. Recio, S. Bailey, J. Carrier, Marker PDU Aligned Framing for TCP Specification, RFC 5044, 2007.

[27] K. Ramakrishnan, S. Floyd, and D. Black. The addition of explicit congestion notification (ECN). RFC 3168.

[28] Riesbeck, C.K. & Martin, C.E, Direct Memory Access Parsing. In J. Kolodner & C. Riesbeck (Eds) Experience, Memory and Reasoning, 1986.

[29] A. Munir, I. A Qzai, Z.A Uzmi, A. Mushtaq, S. N Ismail, M. S Iqbal, B. Khan, Minimizing flow completion times in data centers, In INFOCOM, Turin, 2013

[30] 王晓艳. 基于云计算的数据中心建设探讨[J]. 软件, 2014, 35(2): 129-130

[31] 钱育蓉, 于炯, 英昌甜, 等. 云计算环境下新疆遥感应用数据中心的挑战与机遇[J]. 软件, 2015, 36(4): 58-61

[32] 信怀义, 安卫杰. 金融数据中心数据备份必要性及其机制研究[J]. 软件, 2015, 36(12): 72-75

[33] 张宇翔. 面向质量评估的高校教学数据中心数据模块的设计与实践[J]. 软件, 2016, 37(4): 51-53

High Speed Data Transport Technology for Datacenter Network

QIN Xuan-long1, LI Da-gang1, DU Zheng2, CHEN Yuan-lei2

(1. School of Electronic and Computer Engineering, Peking University Shenzhen Graduate School, Shenzhen 518055, China; 2. Department of High Performance Computing, National Supercomputing Center in Shenzhen, Shenzhen 518055, China)

Data center is the common infrastructure for cloud computing as well as big data application. At present almost all data center network use TCP/IP protocol running on Ethernet technology. With the increase in speed of Ethernet, the TCP/IP protocol and its way of implementation has been unable to meet the requirements of high speed data transmission and is even becoming the bottleneck of the network performance. After analyzing the characteristics of the existing data center network and the real-life performance of the network implementation, this paper will compare and summarize a variety of network performance optimization technologies, and then analyze the future research directions.

TCP; Datacenter Network; Ethernet; RDMA

TP393.03

A

10.3969/j.issn.1003-6970.2016.09.001

国家重点研发计划“资源准入和分级标准体系建设”(2016YFB0201401);深圳市公共技术服务平台项目“深圳市工业设计云服务平台”(GGJS20150429172906635);深圳市技术攻关项目“重20150075:面向智能城市管理的大数据智能分析关键技术研究”(JSGG2015051214574248)

秦宣龙(1993-),男,研究生,主要研究方向:数据中心网络;都政(1981-),男,高级工程师,主要研究方向:高性能计算、云计算与大数据分析;陈远磊(1988-),男,工程师,主要研究方向:大数据分析处理技术。

通讯联系人: 李大刚(1975-),男,助理教授,主要研究方向:高性能网络及分布式存储技术。