基于多重特征信息的图像显著性检测方法

孟莎莎 饶兰香

(江西省计算技术研究所 江西 南昌 330003)

基于多重特征信息的图像显著性检测方法

孟莎莎饶兰香

(江西省计算技术研究所江西 南昌 330003)

针对海量视觉数据处理中的图像显著性检测问题,提出一种基于多重特征信息的新型方法。该方法首先根据像素的CIE Lab颜色空间和空间位置信息选用k-means算法对图像像素聚类,在初始化中心时根据蜂窝原理使用正六边形进行选种。然后用全局对比和局部对比方法分析选取的多重图像特征,并计算得到八种特征图。最后对八种特征图融合得到初始显著性图,再用阈值法得到最终的显著性图。该方法通过改进k-means算法实现良好的图像聚类以进一步分析、处理图像特征,并依据对比度、关键区域聚焦等重要原理将图像底层特征和中层特征合理融合,兼顾全局对比和局部对比,处理问题全面而高效。实验结果表明,从主观和客观两方面进行整体评估,该方法都达到了优越的性能。

显著性检测k-means全局对比局部对比特征图显著性图

0 引 言

随着信息技术的发展以及数字设备的普及,图像和视频等视觉信息作为主要信息载体,其数据规模呈现几何级增长,使得数据的存储、传输、分析、应用遇到巨大困难。因此,如何减少错误或者冗余数据,实现低数据处理量和高分析准确性成为海量视觉信息处理中的重要问题。对于图像而言,以视觉注意机制为代表的显著性检测技术[1]成为提高图像分析处理的效率和精度、降低计算复杂度的重要途径。作为大规模数据选取、分析和处理的重要途径,图像显著性检测技术有着广泛的应用,例如图像分割[2,3]、图像自动裁剪与适配显示[4,5]、目标检测[1]、物体识别[6]、图像检索[7]、图像与视频压缩[8]等。

显著性图获取的基本步骤为:特征提取、特征显著性计算和特征显著性图合成。文献[1]提出了被广泛应用的图像显著性计算的基本模型,成为许多图像显著性检测研究的基础。另外还存在一些其他模型。基于视觉关注机制的图像显著性检测方法有两类,分别是自下向上和自上向下的方法[9]。前一种方法是纯数据驱动和独立于任务的,是对图像显著性自动区域检测的感知处理。后一种方法是先验知识引发的认知处理,例如要执行的任务、目标对象的特征分布、可视场景的上下文等[10]。自下而上的基于底层特征的显著性检测方法一般基于Koch和Ullman提出的框架[11],在这类工作中,需要处理诸如颜色、位置、边缘以及运动等底层特征,Itti等[1]的研究是该模型的一个典型应用。另外还有一些代表性的研究,如文献[12]。这些方法主要关注了局部特征,没有全局性地寻找视觉关注区域[13]。Jiao等[14]的研究考虑了全局特征,并以简单的方式使用了多尺度特征提取,但该计算模型获得的显著性区域缺少明显边缘,且容易忽略掉较小的显著性区域。基于计算域的不同,图像显著性检测算法还可以分为空域法[1]和频域法[15,16]两类。空域法一般存在参数选择敏感、计算复杂度高的问题。为了增强实时性的频率法应运而生,如文献[16]采用一幅图像Fourier变换后的幅度和相位谱来决定显著性。这类方法只关注Fourier变换域内的某些频率,结果中得到的显著性图更好地保护了图像的高级结构,而不是整个区域[1]。由于分块与多尺度显著性图的分辨率不同,会出现不期望的模糊[17]。

到目前为止,由于制约因素过于复杂,所以自上向下类的方法的研究不是很多。虽然图像的显著性检测得到了广泛研究,但其应用还不能令人满意,主要体现在显著性图自身质量不佳、计算复杂度高、应用方式不成熟等,因此需要设计更好的方法。本文的主要工作是通过图像的像素点聚类之后,结合显著性先验理论,通过分析类之间和类内部的颜色特征、空间距离特征和图像纹理特征的对比度和差异性得到不同的特征图,再通过特征图融合获得最终的显著图。

本文首先是设计一种新的聚类方法,为显著性检测方法的设计提供良好的前提条件;第二是利用算法充分分析图像的多重特征并做适当处理,使其应用具有强鲁棒性;第三是体现了自上向下和自下向上两种方法的融合。

1 算法设计

本文算法首先对图像的像素聚类;然后分别根据不同特征信息以一定的方式计算色差之和SCD特征图、局部差之和SLD特征图、颜色方差CV特征图、区域大小RS特征图、每个像素到图像中心位置距离的均值MDI特征图、 每个像素到其所属类的中心位置的距离均值MDC特征图、每个像素到其所属类的中心位置的距离方差VDC特征图、中频能量EMF特征图;最后将8种特征图融合并得出最终显著图。聚类及特征图等都是依据一定的原理并基于多重特征计算得出的。

1.1算法主要依据的原理

(1) 对比度原理:对比度是引起视觉关注的最大因素[19],使用方式可以分为局部对比和全局对比。从效果和计算量角度出发,对比度的使用是算法的关键。

(2) Gestalt原理[18]:图中一般关注的区域由一个或者几个中心组成,而其他区域关注度较小。通常人眼捕获到一个物体或者一个区域,并对这个区域进行搜索。这样的搜索结果是场景中显著性最高的目标区域。

(3) 高频抑制原理:视觉系统对于频繁出现事件不敏感,而最先发现小范围的不寻常部分。使用频域信息时可以滤掉无用的高频,重点计算图像中的中低频信息。

(4) 关键区域聚焦原理:当存在多个显著区域时,某一区域的某一对象最容易被关注。此对象叫做关键对象,其所在区域叫做关键区域,包含图像中的重要信息。

(5) 中心圆周原理:此原理可以检测出中心区域和局部周围区域中相对比较突出的位置和信息[20],能够很好地应用到视觉显著性检测中。

1.2图像特征选取

颜色、空间距离等是图像的底层特征,自下向上的方法主要是基于这些特征。边界信息、频域信息和显著性先验知识等则属于中层特征,中层特征结合底层特征预测显著目标的可能位置能够提高显著性检测模型的鲁棒性。本文基于多重特征的显著性检测方法主要是依据图像的底层特征并结合频域信息以及被验证的显著性理论建立显著性计算模型。其中,关于频域信息的使用,有以下几点:

(1) 考虑原图的低频信号以点亮整个显著性区域;

(2) 低频信号使用要有助于得到一致性的显著图;

(3) 为了获取很好的边界,需要考虑高频信号;

(4) 由于高频信号往往会带来图像的纹理、噪声和块效应,所以超高频信息需要被忽略。

2 算法的实现

2.1图像聚类

聚类选用k-means方法,但与传统的随机选取种子的方式不同,本文使用正六边形排列的方式,最大程度上克服结果的不确定性以此实现强鲁棒性。另外,种子数量太少会使得图像聚类效果出现很大误差,太多则计算量激增且效果没有显著提高,此处种子数选为20。

本文将同时使用颜色和空间距离特征做显著性聚类,一个像素点的值是一个{l,a,b,x,y}向量。其中l、a、b表示CIE Lab颜色空间中的三个分量,x、y表示的是像素点的坐标。图像的左上角为坐标原点,对每个像素点求得种子的距离是:

(1)

其中pi表示第i个像素点,δ是一个可以自由设定取值的距离因子,其大小和图像的横坐标像素点的个数n有关。由式(1)可以看出,δ的值越大,空间距离在聚类中作用越大,像素更容易被匹配到相近的类中,而不是被划分到颜色更相近的类中,本文的取值是10/n。聚类之后将得到向量{c1,c2,…,ck},其中k表示类数。 图1(b)展示的是2个例图的聚类结果。

图1 聚类示例

2.2计算特征图

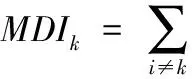

根据选取的图像特征计算所有特征图,并以上面两个例图展示各个特征图的效果。

(1) SCD特征图

根据颜色全局对比计算每一个类的显著值:

(2)

其中ci为聚类后的颜色特征向量,最后将该值赋给聚类之后的编号相同的像素点得到SCD特征图。

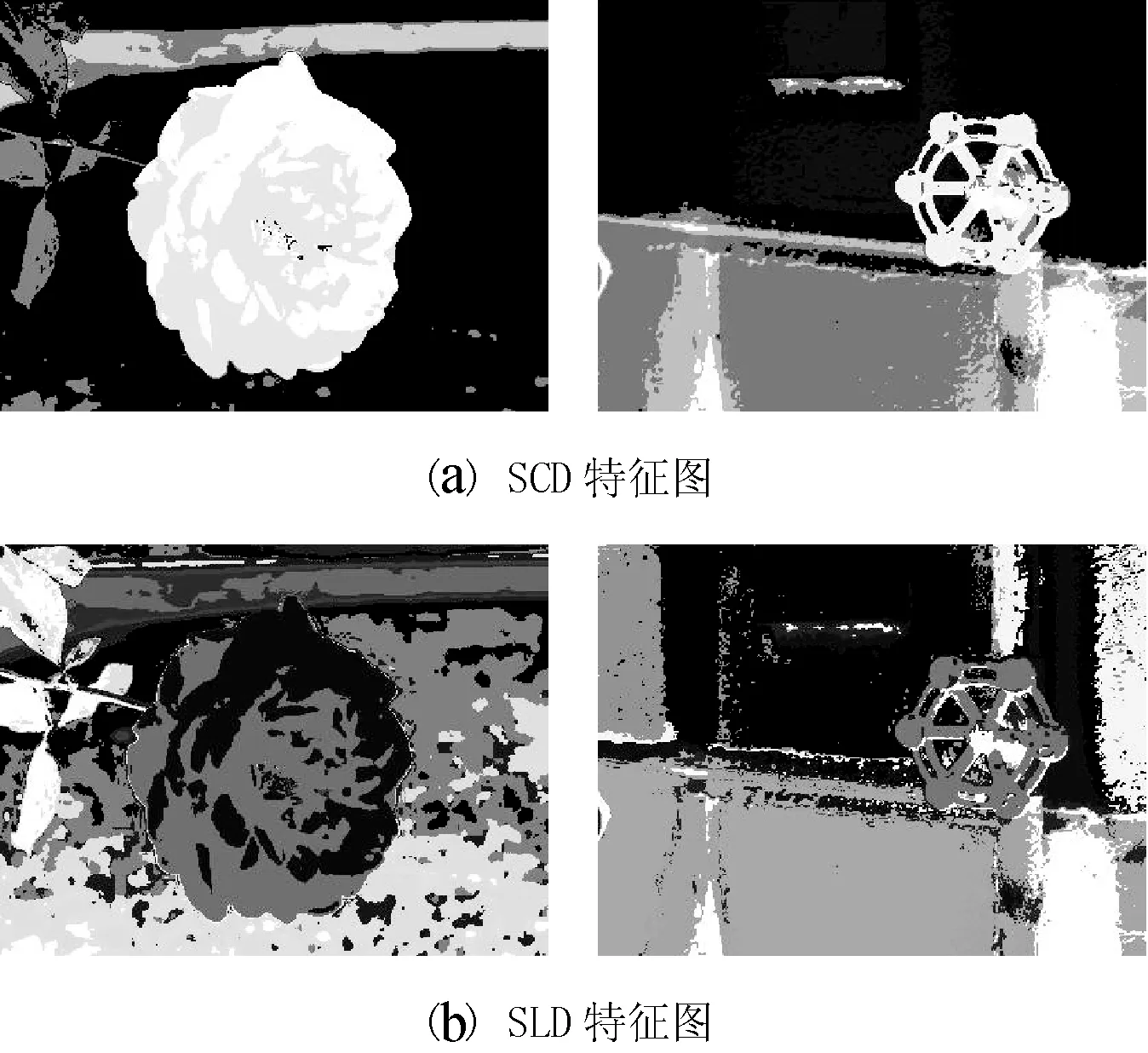

(2) SLD特征图

根据空间距离全局对比,计算每个聚类的中心坐标与其他聚类的距离总和:

(3)

其中p代表了每一个聚类之后的中心坐标。

(3) RS特征图

RS表征图像中某类在整个图像中所占的比例。基于聚类结果,使用局部对比方法根据颜色均值的差异进行优化处理,如果差值较小便认为是连通的,使背景区域有效融合。最后对像素点个数所占比例归一化处理。

(4) CV特征图

使用全局方法计算颜色方差得到CV特征图:

(4)

其中CVk表示类k的方差值,Ci是原图像素的颜色分量。CMk是类k的颜色欧式距离的均值:

(5)

(5) MDI特征图

利用空间信息计算一个类中所有像素到图像中心位置距离的均值:

(6)

其中Ic是图像的中心点位置,pi是某类中像素的坐标。

(6) MDC特征图

同样利用空间信息,MDC的计算如下:

(7)

其中pi是像素点i的坐标,pk是类k的中心坐标。

(7) VDC特征图

利用MDC的结果,计算VDC特征图:

(8)

(8) EMF特征图

图像中的大部分高频信号是背景信号,高频信息一般都不是目标显著区域,所以忽略高频信息和低频信息。计算中频信息,得到EMF特征图:

(9)

图2表示的是两个例图相应的8种特征图。

图2 两个例图的8种特征图

2.3计算显著性图

将所有特征值归一化到[0, 1]区间,最后通过将8个特征值叠加得到初始显著图:

(10)

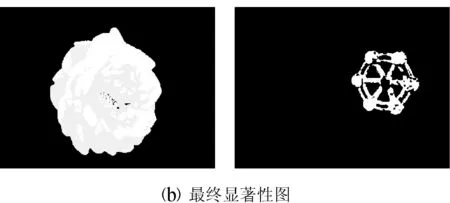

图3 显著性图示例

3 实验与分析

选用具有代表性的Achanta提供的1000幅图像库来检验本文的方法。从主观和客观两方面对于算法性能进行评估。主观上指用户的视觉体验效果,一般采用可视化对比的方式。而客观标准则采用一定指标衡量。

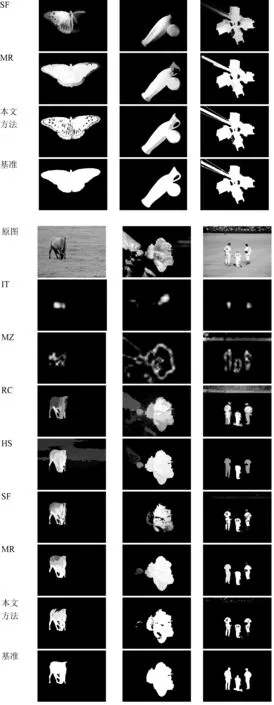

3.1主观评估

选用IT[1]、MZ[21]、RC[19]、HS[22]、SF[17]和MR[23]方法对比。IT方法提出较早,是许多显著性检测方法研究的基础,该方法基于特征集成理论和Center-surround原理设计, 将在多种图特征和多种尺度下得到的显著性度量结果合成一幅显著性图。MZ方法使用模糊生长,使用了显著点、显著区域和显著视图三种层次描述显著性,基于局部或全局对比度的方法得到每个像素的显著性,从而得到显著性图。RC方法基于分割,首先将图像快速分成小块,然后以块为单元计算全局对比度,在计算显著性性时同时考虑颜色对比度、空间距离和块的大小。HS方法基于贝叶斯框架,利用颜色特征,通过超像素和显著性先验理论计算图像的中级特征以得到显著性。SF方法提出了显著性滤波,首先简化图像分布使同质区域成为独立区域,然后计算这些区域在全局中所占比例和空间分布,最后建立模型综合区域的比例信息和空间分布信息来得到全局的显著性表示。MR方法提出流行排序,专注于将背景与显著对象分割开,然后通过图多位排序计算超像素与背景、前景的相似性,最后基于这些相似性得到超像素的显著性。图4表明:本文算法能点亮整个目标区域而且很好地保留区域的边界;IT方法不是全分辨率的,且只能点亮一些点;MZ方法只能得到目标的边缘,不能够点亮整体目标区域;RC和SF方法能够得到完整的目标区域,但出现了块效应;MR方法将图像表示成闭环图,超像素作为节点,虽然该方法与本文方法接近且比较符合基准要求,但在显著性区域内部出现了部分区域间的较大区分度。通过对比,可以看出本文方法效果最好。

图4 本文方法与典型方法的主观可视化对比

3.2客观评估

客观标准采用PR曲线和F-measure进行评估。以图像库的图像均值为参数,精度P(Precision)为纵轴,召回率R(Recall)为横轴绘制PR曲线。F-measure是关于精度和召回率的一个调和平均数,通过一个实数参数α指定精度和召回率的相对重要性。

图5为PR曲线,由于MZ方法主观效果不佳,所以在此忽略。可以看出,IT、RC及SF方法明显比本文所提方法差。在召回率小于0.6时本文方法的精度高于所有方法,在0.6~0.8之间时本文方法只略低于MR,当精度大于0.8时RC、SF、MR、HS和本文算法都趋向一致。因此,本文方法达到预期的效果,能够得到较好的PR曲线。由于本文方法中多特征叠加使得一些目标像素点被隐藏,使其在高召回率的情况下精度比MR模型的精度低。

图5 PR曲线

F-measure可以公式化为:

(11)

在实验中取α=0.3,图6表示的是F-measure曲线图。

图6 F-measure图

由于MZ在主观评价中效果不佳,所以在此也被忽略。图6表明,本文方法的阈值是128,所以阈值范围在110到150之间,该值和MR和HS值都接近0.9,表明具有很好的实验结果。

在主观评估方面,本文方法效果最好;在客观评估方面,本文方法与MR方法相当,优于其他方法。综合主观、客观整体评价,本文方法达到了预期效果。

4 结 语

本文依据对比度、关键区域聚焦等原理,选取多重底层和中层图像特征信息,经过分析处理设计出一种新型图像显著性检测方法。首先对图像根据颜色空间和位置空间信息改进,用k-means算法实现良好的聚类,在初始化中心时根据蜂窝原理使用正六边形的选种方法。然后在聚类的结果基础上,利用局部对比或全局对比方法对图像特征计算得到八个特征图,这些特征图之间相互关联、相互制约,是计算显著性的重要因素。最后通过所有特征图的有效融合并阈值化处理得到最终的显著图。本文方法能够很好地利用到聚类之后类内部像素点之间的关系,通过类之间的像素点的对比关系能够分离得到图像的前景和背景区域,考虑到类内部的颜色距离之后能够得到更加准确的前景区域并将背景分离出来。在典型的图像数据集上选用具有代表性的已有方法对新型方法进行验证对比,实验结果表明,在主观和客观评估两方面所提方法都达到了预期效果,整体性能优越。将来的研究工作将集中在保证性能的前提下降低计算的复杂度,进一步提升鲁棒性,并将之引入到联合显著性(Co-saliency)的研究领域。

[1] Itti L,Koch C,Niebur E.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on pattern analysis and machine intelligence,1998,20(11):1254-1259.

[2] Ko B C,Nam J Y.Object-of-interest image segmentation based on human attention and semantic region clustering[J].Journal of the Optical Society of America A,2006,23(10):2462-2470.

[3] Zhu Junyan,Wu Jiajun,Wei Yichen,et al.Unsupervised object class discovery via saliency-guided multiple class learning[C]//IEEE Conference on Computer Vision And Pattern Recognition,2012:3218-3225.

[4] Hua Shungang,Chen Guopeng,Shi Shusheng.Image resizing algorithm based on similarity criterion[J].Computer Engineering,2012,38(5):191-193.

[5] Kim W,Kim C.A novel importance model for content-aware image resizing[C]//Proceedings of the 18th IEEE International Conference on Image. Brussels,Belginum:IEEE,2011:2469-2472.

[6] Rutishauser U,Walther D,Koch C,et al.Is bottom-up attention useful for object recognition?[C]//IEEE Computer Society Conference on Computer Vision And Pattern Recognition,2004:37-44.

[7] Chen T,Cheng M,Tan P,et al.Sketch2Photo:internet image montage[J].ACM Transactions on Graphics (TOG),2009,28(5):124.

[8] Christopoulos C,Skodras A,Ebrahimi T.The JPEG2000 still image coding system:an overview[J].IEEE Transactions on Consumer Electronics,2000,46(4):1103-1127.

[9] Itti L.Models of bottom-up and top-down visual attention[D].Pasadena:California Institute of Technology,2000.

[10] Fang Y,Lin W,Lee B,et al.Bottom-up saliency detection model based on human visual sensitivity and amplitude spectrum[J].IEEE Transactions on Multimedia,2012,14(1):187-198.

[11] Koch C,Ullman S.Shifts in selective visual attention: towards the underlying neural circuitry[C]//Matters of Intelligence.Springer,1987:115-141.

[12] Harel J,Koch C,Perona P.Graph-based visual saliency[C]//Advances in Neural Information Processing Systems,2006:545-552.

[13] Goferman S,ZelnikManor L,Tal A.Context-aware saliency detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(10):1915-1926.

[14] Jiao W,Peng Q M,Lv W X,et al.Multiscale detection of salient regions[C]//Prodeedings of the 4th IEEE conference on Industrial Electronics and Application Xi’an,China:IEEE,2009:2408-2411.

[15] Hou X,Zhang L.Saliency detection:A spectral residual approach[C]//IEEE Conference on Computer Vision And Pattern Recognition,2007:1-8.

[16] Guo C,Ma Q,Zhang L.Spatio-temporal saliency detection using phase spectrum of quaternion fourier transform[C]//IEEE Conference on Computer Vision And Pattern Recognition,2008:1-8.

[17] Perazzi F,Krähenbühl P,Pritch Y,et al.Saliency filters:Contrast based filtering for salient region detection[C]//IEEE Conference on Computer Vision And Pattern Recognition,2012:733-740.

[18] Hartmann G W.Gestalt psychology:A survey of facts and principles[C]//Montana: Kessinger Publishing,2006:45-72.[19] Cheng M,Zhang G,Mitra N J,et al.Global contrast based salient region detection[C]//IEEE Conference on Computer Vision And Pattern Recognition,2011:409-416.

[20] Klein D A,Frintrop S.Center-surround divergence of feature statistics for salient object detection[C]//IEEE International Conference on Computer Vision,2011:2214-2219.

[21] Ma Y F,Zhang H J.Contrast-based image attention analysis by using fuzzy growing[C]//Proceedings of the eleventh ACM international conference on Multimedia,2003:374-381.

[22] Xie Y,Lu H,Yang M.Bayesian Saliency via Low and Mid Level Cues[J].IEEE Transactions on Image Processing,2013,22(5):1689-1698.

[23] Yang C,Zhang L,Lu H.Saliency detection via graph-based manifold ranking[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,2013:3166-3173.

IMAGE SALIENCY DETECTION METHOD BASED ON MULTIPLE-FEATURE INFORMATION

Meng ShashaRao Lanxiang

(Jiangxi Institute of Computer Technology,Nanchang 330003,Jiangxi,China)

For the image saliency detection in mass visual data processing, we propose a novel multiple-feature information-based method. First, on the basis of CIE Lab colour space and spatial position information of pixels, the method selects k-means algorithm to cluster image pixels. In initialising the centre it employs the regular hexagon for seed selection according to honeycomb conjecture. Then it analyses the selected multiple image features with global contrast and local contrast methods, and derives eight feature maps through computation. At last, it integrates these eight feature maps to obtain the initial saliency map, and then gets the final saliency map using threshold method. By improving k-means algorithm the proposed method realises excellent image clustering results to further analyse and process multiple image features. Taking into account the global and local contrasts, the proposed method reasonably integrates the low-level and middle-level features of image according to some vital principles, e.g., the contrast and the key regional focus, etc., and deals with the problems comprehensively and efficiently. Experimental results show that the proposed method achieves superior performances according to the overall assessments from both the subjective and objective aspects.

Saliency detectionk-meansGlobal contrastLocal contrastFeature mapSaliency map

2015-02-15。国家“十二五”科技支撑计划项目(2014 BAD10B05)。孟莎莎,工程师,主研领域:智能控制,图像处理。饶兰香,高工。

TP3

A

10.3969/j.issn.1000-386x.2016.09.045