多信息动态融合的运动目标检测方法

何伟 齐琦 张国云 吴健辉

摘要:针对基于视觉显著性的运动目标检测算法存在时空信息简单融合及忽略运动信息的问题,提出一种动态融合视觉显著性信息和运动信息的运动目标检测方法。该方法首先计算每个像素的局部显著度和全局显著度,并通过贝叶斯准则生成空间显著图;然后,利用结构随机森林算法预测运动边界,生成运动边界图;其次,根据空间显著图和运动边界图属性的变化,动态确定最佳融合权值;最后,根据动态融合权值计算并标记运动目标。该方法既发挥了显著性算法和运动边界算法的优势,又克服了各自的不足,与传统背景差分法和三帧差分法相比,检出率和误检率的最大优化幅度超过40%。实验结果表明,该方法能够准确、完整地检测出运动目标,提升了对场景的适应性。

关键词:运动目标检测;视觉显著性;结构随机森林;运动边界;动态融合

中图分类号:TP391.41

文献标志码:A

0引言

运动目标检测是视频分析的基础,在智能监控、自动导航、高级人机交互、军事侦察等领域有着广泛的应用前景,国内外学者对其进行了深入研究,提出了许多算法[1-4]。目前,常用的运动目标检测算法主要有背景差分法[5]、帧间差分法[6]和光流法[7]。背景差分法定位准确,可以提取相对完整的运动目标,算法复杂度较低,但很难快速准确地获得合理的背景模型,导致该类方法检测效果并不理想;帧间差分法实时性强,对于动态环境具有较好的适应性,但该类方法抗干扰能力差,其前景内部易出现空洞;光流法能够在不需要背景知识的情况下检测出运动目标,检测精度高,但该类方法计算复杂,实时性较差。因此,如何快速、准确、完整地检测出运动目标,仍然是一个具有挑战性的研究课题。近年来,视觉显著性检测受到关注[8-10],并被广泛地学习和应用到运动目标检测系统中。文献 [11] 提出四元数傅里叶变换相位谱 (Phase spectrum of Quaternion Fourier Transform, PQFT)的空时显著性模型,利用傅氏变换将图像的亮度、颜色、运动等融合特征进行变换;此方法计算简单,但当受到背景纹理干扰时,检测效果不理想。文献 [12] 提出红外图像小运动目标检测的空时显著性模型,利用三维差分高斯滤波器检测红外小运动目标;此方法具有较好的检测精确度和鲁棒性,但仅限于检测红外图像的单个小运动目标,适用范围受到很大的限制。文献[13] 利用最大熵法自适应计算帧差法的阈值,获得显著性图,得到运动目标的候选区域和生长种子,然后通过模糊生长法检测出运动目标;此方法实时性和鲁棒性较好,但没有考虑运动信息,检测出的运动目标位置不准确。文献 [14] 利用超复数傅氏变换和改进的三帧差分法分别获取静态显著区域和动态显著区域,然后利用动态融合算法将两个区域进行融合;此方法易受光照和干扰的影响。

根据上述情况可以看出,如何充分利用运动信息并将其和显著性信息进行有效融合是运动目标检测方法的重要研究内容。本文将显著信息和运动信息进行动态融合,提出一种新的空时显著性的运动目标检测方法。该方法通过改进的显著性检测算法获得图像的视觉显著性图,又通过结构随机森林算法获取图像的运动边界图[15];然后将视觉显著性图和运动边界图进行动态融合,从而有效地检测出完整的运动目标。

1视觉显著性图

视觉显著性通过模拟人类视觉注意机制对图像信息进行处理,显著性检测结果是一幅灰度图,图中每个像素的灰度值代表该像素在原图像中的显著度。文献 [16] 利用图像的颜色、方向信息,通过主成分分析法建立低维多尺度融合特征,计算每个像素的局部和全局显著性,并通过贝叶斯准则将其结合,得到显著图。本文在此基础上进行如下改进:增加图像的纹理特征,以反映图像的区域结构信息,提高算法克服背景纹理的影响及抗干扰能力;由于在运动信息计算中充分利用了图像的方向信息,故不再计算方向特征,以提高计算效率。

1.1特征提取与融合

由于人类视觉系统具有多尺度特征,算法为输入图像构建了具有Q个尺度的尺度空间。在每个尺度中均提取颜色和纹理特征,并利用主成分分析法(Principal Component Analysis, PCA)对提取的特征向量降维。

1.3显著性检测

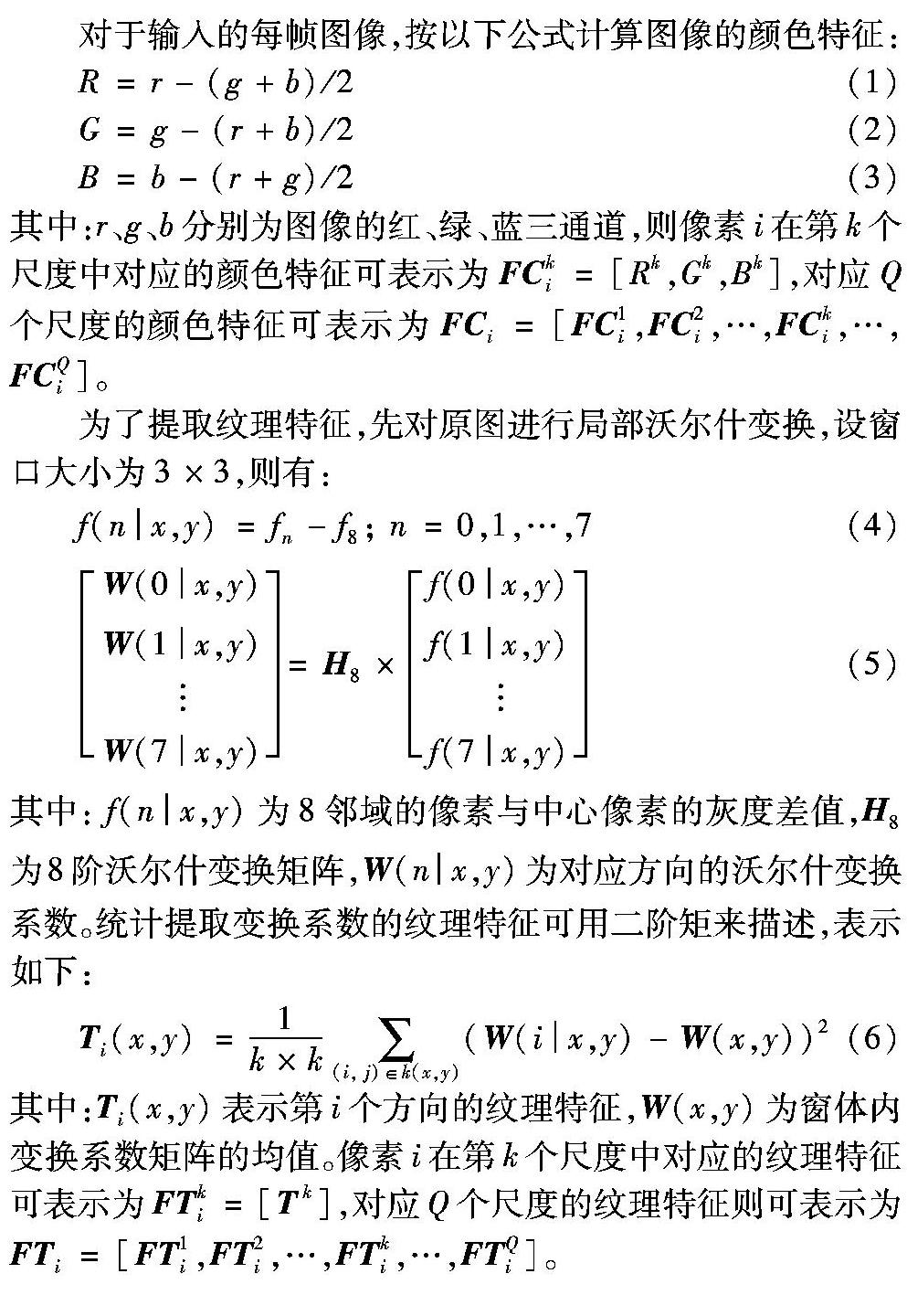

在计算显著性时,取Q=3,即在三个尺度上分别提取像素i的颜色和纹理特征,对联合特征利用PCA降维,计算每个像素的局部显著性和全局显著性,通过贝叶斯准则对其进行结合,其显著图效果如图1所示。由图1可以看出,算法在摒弃大量冗余信息干扰的同时,较好地保持了显著目标的整体特征。

2运动边界图

运动边界对运动目标的颜色、纹理和形状等特征变化较为鲁棒。本文运动边界检测算法主要是在文献 [15] 工作的基础上,对其模型进行了改进,综合考虑了运动目标的颜色、梯度、边缘和光流等信息,以更准确地定位运动目标区域。

2.2运动边界检测

随机森林具有快速的训练能力和很强的多分类能力,而结构学习的输入和输出空间可以是任意复杂的表示。本文利用结构随机森林对标准数据集Bootstrap视频序列的第451、453、455及457帧图像的运动边界进行检测,其结果如图2所示。从图2中可以看出,运动边界可以较好地定位出运动目标,但由于受到目标相互遮挡及光照等因素的影响,其结果并不能清晰完整地将运动目标分离,还需进一步处理。

3多信息动态融合算法

人类视觉系统对运动信息的感知要比其他信息更敏感,然而,当运动信息具有相对一致性时,视觉系统则更容易被颜色、纹理等其他主要视觉特征所吸引。因此,本文利用动态融合方法[18]对视觉显著性图和运动边界图进行融合:

当图像的运动信息增强时,λM迅速增大, λS则相应减小;但当运动达到一定强度后,λM的增加速度会变得较为缓慢。多信息动态融合的运动目标检测方法具体步骤描述如下:

步骤1输入第k帧图像,分别提取颜色特征和纹理特征,并利用主成分分析法对其进行降维,对低维多尺度颜色特征和纹理特征进行融合;

步骤2分别计算每个像素低维多尺度融合特征的局部和全局显著性,通过式 (12) 得到每个像素的显著性,获得视觉显著性图SSi;

步骤3利用训练集生成决策树,并构造随机森林,对每一个输入向量x∈RkN2,计算每个节点相关联的二元分割函数h(x,θi)∈{0,1},以决定x转向左孩子或右孩子,直到叶子节点;

步骤4在随机森林中的每一棵决策树上进行分类,并将所有树的分类结果通过投票选举的方式,输出对应的二值运动边界图MSi;

步骤5根据式(14)对视觉显著图SSi 和运动边界图MSi进行动态融合,获得并标记出运动目标。

4实验结果与分析

为验证本文方法的有效性,实验采用changedetection.net视频库中的标准数据集pedestrians和highway两组图像序列进行测试:视频pedestrains是一组室外均匀光照下背景单一的行人图像序列;视频highway是一组室外含有快速运动车辆的高速公路交通视频,其背景较为复杂。实验采用的计算机配置为Intel Xeon E5-1607 V3 3.1GHz CPU,8GB内存,采用Matlab 2015a编程实现相关算法。

实验1

从测试视频中选取第318帧、第328帧,第360帧和第392帧图像进行测试。从图3中可以明显看出,背景差分法和三帧差分法检测到的前景目标破碎较为严重,目标完整性较差,无法准确地表征运动目标的几何外形,且三帧差分法的检测前景中含有较多的非目标噪声。文献[14] 方法和本文方法均充分利用了图像的显著性信息和运动信息,且进行了有效的融合,使得其检测效果要明显优于以上两种方法。由于本文方法在计算显著性时综合考虑了每个像素的局部显著度和全局显著度,且运动边界能准确定位运动目标区域,使得其检测结果在精确性方面要优于文献[14]的方法。

实验2

从测试视频中提取第66帧、第111帧,第126帧和第156帧图像进行测试。由图4可以看出,背景差分法和三帧差分法对于环境适应性较差,由于视频中有树枝及其阴影的干扰,导致近景的运动目标检测结果中含有较多的非目标噪声,目标缺失严重;远景中的运动目标基本检测不出,说明这两类方法对于复杂背景下多运动目标检测效果较差。文献[14]方法虽然对于近景目标检测效果较好,但由于该方法是利用三帧差分法获取运动区域,抗干扰能力差,加上远景中有部分目标被遮挡,导致远景中的运动目标漏检严重。虽然本文方法提取的运动边界图中能检测出远景中的运动目标,但其轮廓并不清晰,而对显著性图和运动边界图按不同的权值进行动态融合使得本文算法最终能准确完整地检测出所有的运动目标,其检测效果要明显优于文献[14]的方法。

实验从数据库中随机抽取60帧图像进行计算,求其平均值,结果如表1所示。从表1中可以看出,背景差分法和三帧差分法的平均检出率在70%左右;文献[14]的方法平均检出率在90%左右,明显要高于前两种方法,但其误检率也要高出前两种方法;本文方法在保证低误检率的同时,提高了检出率,其平均检出率约为94%,算法总体性能要优于其他三种方法。

5结语

本文提出一种融合视觉显著性图和运动边界图的运动目标检测方法。该方法在提取显著性特征时利用图像的点特征和局部结构特征构成低维多尺度融合特征,并通过贝叶斯准则对每个像素的局部显著性和全局显著性进行有效结合;在提取运动边界图时,充分利用结构随机森林快速、准确分析数据的能力实现对运动目标的准确定位,减少图像中的冗余信息;最后通过动态融合策略将显著性图和运动边界图按动态权值进行融合,从而检测出运动目标。在公开测试集上的多次实验结果表明,本文方法在检测的准确性和完整性方面具有较好的效果,能够实现较复杂场景下的运动目标检测。但是,本文方法对于一些遮挡很严重、动态背景变化剧烈的运动目标检测仍存在着一定程度的漏检现象。未来的工作中将继续研究如何从特征选择上进行改进,寻找更加有效的运动特征,提高算法的有效性。

参考文献:

[1]李伟生,汪钊.基于时空背景模型的自适应运动目标检测方法[J].计算机应用,2014,34(12):3515-3520. (LI W S, WANG Z. Adaptive moving object detection method based on spatial-temporal background model [J]. Journal of Computer Applications, 2014, 34(12): 3515-3520.)

[2]HAN H, ZHU J, LIAO S, et al. Moving object detection revisited: speed and robustness [J]. IEEE Transactions on Circuits and Systems for Video Technology, 2015, 25(6): 910-921.

[3]YUAN G-W, GONG J, DENG M-N, et al. A moving objects detection algorithm based on three-frame difference and sparse optical flow [J]. Information Technology Journal, 2014, 13(11): 1863-1867.

[4]LEE G, MALLIPEDDI R, JANG G-J, et al. A genetic algorithm-based moving object detection for real-time traffic surveillance [J]. IEEE Signal Processing Letters, 2015, 22(10): 1619-1622.

[5]LIU W, YU H, YUAN H,et al. Effective background modelling and subtraction approach for moving object detection [J]. IET Computer Vision, 2015, 9(1): 13-24.

[6]WANG Z H, LIAO K, XIONG J L, et al. Moving object detection based on temporal information [J]. IEEE Signal Processing Letters, 2014, 21(11): 1403-1407.

[7]LIANG C-W, JUANG C-F. Moving object classification using a combination of static appearance features and spatial and temporal entropy values of optical flows [J]. IEEE Transactions on Intelligent Transportation Systems, 2015, 16(6): 3453-3464.

[8]WANG Q, YUAN Y, YAN P. Visual saliency by selective contrast [J]. IEEE Transactions on Circuits and Systems for Video Technology, 2013, 23(7): 1150-1155.

[9]GU K, ZHAI G, LIN W, et al. Visual saliency detection with free energy theory [J]. IEEE Signal Processing Letters, 2015, 22(10): 1552-1555.

[10]SOULY N, SHAH M. Visual saliency detection using group lasso regularization in videos of natural scenes [J]. International Journal of Computer Vision, 2016, 117(1): 93-110.

[11]GUO C L, ZHANG L M. A novel multiresolution spatio-temporal saliency detection model and its applications in image and video compression [J]. IEEE Transaction on Image Processing, 2010, 19(1): 185-198.

[12]WANG X, NING C, XU L. Spatiotemporal saliency model for small moving object detection in infrared videos [J]. Infrared Physics & Technology, 2015, 69: 111-117.

[13]WANG Z, LIAO K, XIONG J, et al. Moving object detection based on temporal information [J]. IEEE Signal Processing Letters, 2014, 21(11): 1403-1407.

[14]LI H, WANG Y, LIU W. Moving Object detection based on HFT and dynamic fusion [C]// ICSP 2014: Proceedings of the 12th International Conference on Signal Processing. Piscataway, NJ: IEEE, 2014: 895-899.

[15]WEINZAEPFEL P, REVAUD J, HARCHAOUI Z, et al. Learning to detection motion boundaries [C]// CVPR 2015: Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2015: 2578-2586.

[16]景慧昀.视觉显著性检测关键技术研究[D].哈尔滨:哈尔滨工业大学,2014:33-37. (JING H Y. Research on key techniques of visual saliency detection [D]. Harbin: Harbin Institute of Technology, 2014: 33-37.)

[17]雷琴,施朝健,陈婷婷.可见光海面目标检测的结构随机森林方法[J].光电工程,2015,42(7):31-35. (LEI Q, SHI C J, CHEN T T. Structured random forests for target detection in sea images [J]. Opto-Electronic Engineering, 2015, 42(7): 31-35.)

[18]ZHAI Y, SHAH M. Visual attention detection in video sequences using spatiotemporal cues [C]// MM 06: Proceedings of the 14th Annual ACM International Conference on Multimedia. New York: ACM, 2006: 815-824.

[19]FAKHARIAN A, HOSSEINI S, GUSTAFSSON T. Hybrid object detection using improved Gaussian mixture model [C]// ICCAS 2011: Proceedings of the 11th International Conference on Control, Automation and Systems. Piscataway, NJ: IEEE, 2011: 1475-1479.