基于尺度自适应局部时空特征的足球比赛视频中的多运动员行为表示

王智文 蒋联源 王宇航 王日凤 张灿龙 黄镇谨 王鹏涛

摘要:为提高足球比赛视频中的多运动员行为识别的准确率,提出一种基于尺度自适应局部时空特征的足球比赛视频中的多运动员行为表示方法,利用时空兴趣点来表示足球比赛视频中的多运动员行为。首先将足球比赛视频序列中的多运动员行为看作是三维空间中的时空兴趣点的集合,然后采用直方图量化技术将时空兴趣点集合量化为维数固定的直方图(即时空单词),最后采用K-means聚类算法生成时空码本。在聚类生成码本之前,对每个时空兴趣点都进行了归一化,以保证其缩放和平移不变性。实验结果表明,该方法能够大大减少足球比赛视频中的多运动员行为识别算法的计算量,显著提高识别的准确率。

关键词:时空兴趣点;多运动员行为表示;行为识别;K-means聚类算法;时空特征检测操作数

中图分类号:TP311; TP391

文献标志码:A

0引言

足球比赛视频中多运动员行为表示的好坏会直接影响行为识别的准确率。在足球比赛中的多运动员行为分析和识别过程中,选取的特征越多,对行为的描述也就越充分;但是选取过多的特征会导致数据间的冗余过大,特征向量的维数过高,数据分布的本质规律不容易被发现,训练行为识别模型所需的数据量过大,算法的计算量大,不利于行为识别的实时性处理。因此,足球比赛视频中的多运动员行为识别研究的关键问题是如何有效地描述提取的特征才能够很好地表征行为。

1相关研究

过去研究者对行为表示进行了广泛的研究,其中比较典型的研究有:Bobick等[1]利用减背景法推导出时间模板的表示,该行为表示方法简单,但容易受噪声影响。Wang等[2]采用自适应多阈值选择光流特征作为行为的表示来识别足球比赛视频中的团队行为,但研究局限于处理三类团队行为,且易受噪声干扰。文献[3]采用时间序列的因果关系来描述成对行为,并利用空间行为轨迹匹配来识别人类行为,但难以被推广到多运动员的行为识别中来。文献[4]用一个完整的四维对象实时交互张量来描述团队行为模式,通过学习并优化张量积来减少内核,使它凝聚到一个可区别的时空互动矩阵中。在视觉变化的情况下,用来简洁描述团队行为模式的时间互动矩阵被证实是稳定的。更重要的是,给定一个黎曼度量,所有时空互动矩阵集形成一个黎曼流形,可用来建立概率框架,特征化团队行为模式每个类,但实现起来比较困难。文献[5]提出目标之间结构化的相互作用模型,使用基于目标的原语和低阶时空关系集成的概率框架从含噪声的感知数据中识别出结构严密、高度结构化的多人行为。基于模型的目标识别和概率计划识别的表示基于下面四个主要假设:1)在智能体之间从事团队活动时,单个智能体目标是指定时空关系的天然的原子表示单位;2)在高度结构化的多智能体的行为识别过程中,行为的时间结构的高层次描述使用较少的低阶时空关系集和逻辑限制就足以表达智能体之间的关系;3)贝叶斯网络为不确定的视觉感知特征的多种来源提供了一种适当的融合机制;4)可以用自动生成的贝叶斯网络来融合不确定时态信息和对象轨迹数据集,识别一个特定的多智能体的行为。假设的限制容易引起标记的偏置问题,且难以实现。文献[6]引入了一个能明确对动态团队成员进行编码和适应计划识别形式的多智能体计划表示法。从多智能体计划表示法中提取的局部时间依赖性能够有效地修剪潜在的团队计划的假设集,但修剪过程比较费时,不能满足实时足球比赛行为识别的要求。文献[7]在无监督的时间分割过程中提出了一种基于动态时间序列的高斯混合模型匹配行为的行为识别方法。该方法假定行为数据是一个能够充分描述的多单向标签,利用了时空特征,通过假设行为的优先级顺序来识别多人行为;但是在团队行为识别的特征子集中会出现多个同时事件,而且在特殊情况下,事先设定的优先级高的行为可能是不重要的行为,这样会影响多运动员行为识别的准确性。文献[8]提出利用浓密轨迹和运动边界进行行为识别。首先,用轨迹来捕获视频的局部运动信息;然后,密集轨迹的表示保证良好地覆盖前景运动以及周围的背景;最后,利用一种最先进的光流算法确保提取密集轨迹的鲁棒性和有效性。文献[9]为人的属性和行为识别提出扩展的部分模型。该模型依赖于收集的部分模板,通过学习区别地解释图像中特定的尺度空间位置(人类为中心的坐标)。它避免了高度结构化的模型限制,提出了用一个自动挖掘算法来学习相应的区分性模板来识别人类行为。Laptev[10]为视频数据的简洁表示提出了时空兴趣点,并探讨了利用时空兴趣点来描述人的行为的优势。借鉴Laptev[10]的思想,本文提出基于尺度自适应局部时空特征来表示足球比赛视频中的多运动员行为。通过提取不随视频图像的缩放和平移而变化的稀疏时空特征来表示多运动员行为,减少多运动员行为识别算法的计算量,提高多运动员行为识别的准确率和实时性。

2尺度自适应局部时空特征检测操作数

本文借鉴Lindeberg[11]关于空间中局部尺度特征自适应选择的方法,将Harris检测操作数推广到足球比赛视频时空域中,提出了尺度自适应局部时空特征检测算法(见算法1)。算法的主要思想是在局部时空域中定义一个能同时在时间和空间维上取得极大值的差分操作数。采用归一化的Laplace操作数来估计局部尺度。利用式(1)将Harris时空兴趣点检测操作数和Laplace操作数相结合推导出Harris-Laplace时空兴趣点检测操作数。

2.1局部时空特征描述子

足球比赛视频中局部区域的表示是一个开放性的问题。本文利用方向梯度直方图(Histogram oriented Gradient,HoG)描述子将足球比赛视频视为“时空”长方体,并将HoG描述子推广到三维足球比赛视频图像中。

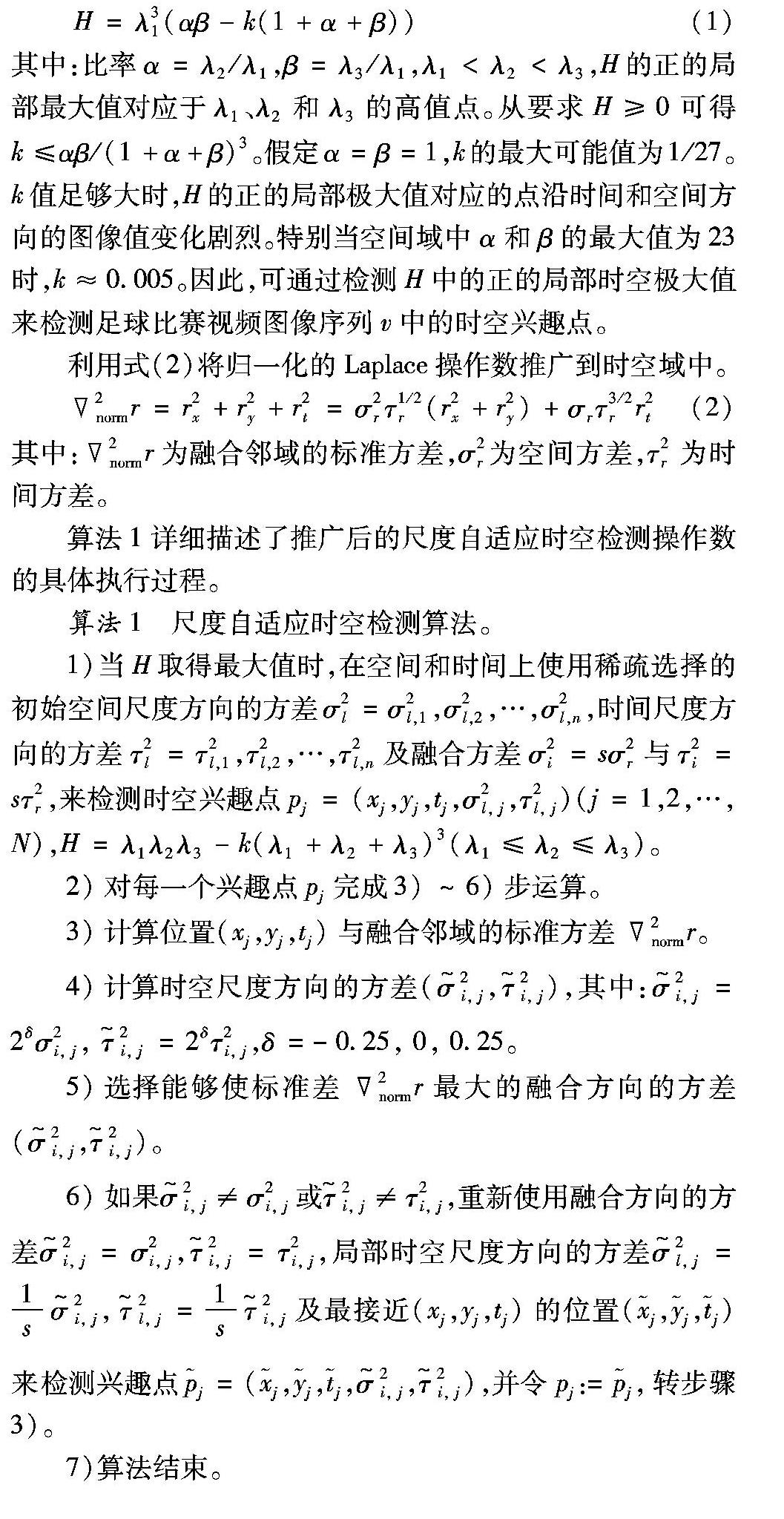

对于一个局部时空感兴趣区域,局部描述子用一个特征向量来表示该区域。图像或者整个足球比赛视频序列可表示为一组在不同的尺度和位置下的特征向量集。为了能有效地利用局部特征向量来进行足球比赛视频中的多运动员行为的识别,客观上要求这些特征描述子具有比较强的区分能力,同时又不受光照、轻微形变等干扰因素的影响。将HoG描述子推广到3D的计算流程如图1所示,其中涉及到的关键计算有:平均梯度计算、方向梯度量化的计算和直方图计算。

2.2直方图计算

方向梯度的直方图需要在一个梯度向量的集合中进行计算。具体计算方法如下:对于一个给定的立方体c=(xc,yc,tc,lc,wc,hc),将其分为S×S×S个子块bi。对于每个子块,利用式(8)来计算其平均梯度,然后将bi量化为qbi。对于每个区域c,通过求和量化后的均值梯度向量来计算其直方图hc。

4实验结果分析

本文使用2010年南非世界杯64场比赛、2009—2010年亚洲杯预选赛32场比赛及2010年意甲比赛部分比赛视频作为数据集。为了在不同光线条件和球员穿着不同衣服的情况下测试系统,从不同的天气条件(晴天、阴天、雨天)和不同光照条件(自然或人工照明)下的不同球队之间的比赛中挑选出12个测试序列。序列时长为3min,每个视角大约5000帧。手动标记图像序列来叠加每个球员和球,限位框被用作真实值来评价算法的性能。在视频图像预处理过程中,利用笔者提出的基于多元统计模型的分形小波自适应图像去噪算法[13]进行去噪,以便得到具有更好特征结构的图像。通过检测H中的正的局部时空极大值来检测足球比赛视频图像序列v中的时空兴趣点。检测结果如图2所示,可以看出,本文使用尺度自适应局部时空兴趣点来表示多运动员行为时, 能够大大减少识别多运动员行为算法的计算量。

本文利用以下方法进行行为识别:

文献[1]提出的减背景法推导出时间模板的行为表示,

文献[2]提出的行为特征的光流表示,

文献[4]提出的四维对象实时交互张量行为表示方法,

文献[8]提出利用浓密轨迹和运动边界法,

文献[9]提出的扩展的部分模型以及本文提出的基于尺度自适应局部时空特征的行为表示方法。

为了分析这六种算法在足球比赛视频

行为识别中表现出的性能,分别在开放性数据集ucf sports中选取Kicking-Side视频和上述自采集的视频进行实验,并从平均每帧提取的特征向量维数、算法处理每帧图像运行的平均时间以及行为识别的准确率三个方面进行比较,结果如表1所示。

由表1可以看出, 对Kicking-Side视频中行为进行识别时,每种算法需要提取的特征向量维数及计算机处理时间明显要小于自采集的足球比赛视频,行为识别的准确率明显高于自采集的足球比赛视频,其原因是由于该视频中行为的复杂度相对低,行为发生过程中不存在着运动员之间的相互遮挡及自遮挡。文献[1]提出的减背景法行为表示方法简单,但提取的特征维数最多且容易受噪声影响;文献[2]提出的光流表示法局限于只能处理3类多运动员行为,且易受噪声干扰;文献[4]提出的四维对象实时交互张量行为表示方法在建立概率框架特征化多运动员行为模式每个类的过程中实现非常困难,处理每帧图像需要的时间最多。文献[8-9]使用了低层特征进行行为识别,行为识别准确率较低,而本文提出方法在性能上明显优于对比方法。

5结语

本文借鉴Lindeberg空间中局部尺度特征自适应选择方法,提出基于尺度自适应局部时空特征的足球比赛视频中的多运动员行为表示。该方法能有效地提取用于识别多运动员行为的时空特征,减少提取特征向量的维数及处理每帧视频图像的平均运行时间,提高多运动员行为识别的准确率。

参考文献:

[1]BOBICK A F, DAVIS J W. The recognition of human movement using temporal templates [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(3):257-267.

[2]WANG L, YUNG N H C. Extraction of moving objects from their background based on multiple adaptive thresholds and boundary evaluation [J]. IEEE Transactions on Intelligent Transportation Systems, 2010, 11(1): 40-51.

[3]SHAO Z, LI Y. Integral invariants for space motion trajectory matching and recognition [J]. Pattern Recognition, 2015, 48(8): 2418-2432.

[4]PEHLIVAN S, FORSYTH D A. Recognizing activities in multiple views with fusion of frame judgments [J]. Image and Vision Computing, 2014, 32(4): 237-249.

[5]CHO S, KWAK S, BYUN H. Recognizing human-human interaction activities using visual and textual information [J]. Pattern Recognition Letters, 2013, 34(15): 1840-1848.

[6]ALTUN K, MACLEANB K E. Recognizing affect in human touch of a robot [J].Pattern Recognition Letters, 2015, 66(15): 31-40.

[7]FIELDA M, STIRLINGA D, PAN Z, et al. Recognizing human motions through mixture modeling of inertial data [J]. Pattern Recognition, 2015, 48(8): 2394-2406.

[8]WANG H, KLSER A, SCHMID C, et al. Dense trajectories and motion boundary descriptors for action recognition [J]. International Journal of Computer Vision, 2013, 103(1):60-79.

[9]SHARMA G, JURIE F, SCHMID C. Expanded parts model for human attribute and action recognition in still images [C]// CVPR 13: Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013: 652-659.

[10]LAPTEV I. On space-time interest points [J]. International Journal of Computer Vision, 2005, 64(2): 107-123.

[11]LINDEBERG T. Feature detection with automatic scale selection [J]. International Journal of Computer Vision, 1998, 30(2): 77-116.

[12]VIOLA P, JONES M. Rapid object detection using a boosted cascade of simple features [C]// CVPR 01: Proceedings of the 2001 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2010: 511-518.

[13]王智文,李绍滋.基于多元统计模型的分形小波自适应图像去噪[J].计算机学报,2014,37(6):1380-1389. (WANG Z W, LI S Z. Adaptive fractal-wavelet image denoising base on multivariate statistical model [J]. Chinese Journal of Computers, 2014, 37(6): 1380-1389.