AER时域视觉传感器总线仲裁建模与仿真分析

杨 帅,胡燕翔,徐江涛

(1.天津工业大学计算机科学与软件学院,天津 300387;2.天津师范大学计算机与信息工程学院,天津 300387;3.天津大学电子信息工程学院,天津 300072)

AER时域视觉传感器总线仲裁建模与仿真分析

杨 帅1,胡燕翔2,徐江涛3

(1.天津工业大学计算机科学与软件学院,天津 300387;2.天津师范大学计算机与信息工程学院,天津 300387;3.天津大学电子信息工程学院,天津 300072)

以视觉传感器设计为背景,对AER时域视觉传感器的总线仲裁进行建模,并对事件取样、AER仲裁和目标跟踪进行仿真分析.实验结果表明:AE事件数量仅占全部像素数目的5%~10%,事件集中优先仲裁方式比特定区域优先仲裁方式和轮权仲裁方式在高速目标跟踪应用上准确率高10%~20%.因此可知:基于AE数据的目标跟踪更加高效,并且事件集中优先仲裁方式更适合于高速目标跟踪应用.

地址-事件表示(AER);视觉传感器;模拟器;仲裁;目标跟踪

图像是人类获取信息的最主要来源,机器视觉技术已在各类智能分析、识别和控制系统获得广泛应用[1].随着图像空间与时间分辨率的提高,目前“帧采样”成像和处理方式不但对图像传输、存储带来巨大压力,也给高实时性视觉应用带来巨大的处理速度要求[2].

根据神经形态工程学的研究成果,生物视觉系统的感知和传导具有大规模并行、超稀疏表示、事件驱动、异步传输的特点[3-4].基于地址-事件表示的时域视觉传感器(address-event representation vision sensor,AER VS)[5]模仿生物视觉系统原理,每个像素自主监测所感知的光强变化,光强变化达到设定阈值的像素主动产生事件输出[6-7].这些异步变化事件通过具有仲裁功能的AER控制器串行输出.变化采样与输出相对于传统“帧采样”图像传感器的全部采样与输出,从源头上消除了冗余数据,同时具有实时动态响应等特点,适合于高速目标跟踪、工业自动化和机器人视觉等应用[8-10].

1992年Mahowald[11]首次提出仿生视觉传感器的概念.2005年以后AER VS成为研究热点,在电路与芯片设计、信号处理方面取得了诸多成果.美国约翰霍普金斯大学Mallik等[12]提出帧差探测电路结构,首次使用CMOS有源像素来检测入射光强度的绝对变化.第一个AER VS由Kramer[13]提出,组合了Delbuck等[14]的自适应光电探测器和校正/阈值保持差分单元.Lichsteiner等[15]实现了128×128像素阵列的异步AER VS,动态范围达到120 dB,延迟响应15 μs.Posch等[16]采用时间自适应ON/OFF电路,像素采集和复位自动完成. Juan等[17]在像素中加入前置放大器,使延时减小到3.6μs.Olsson等[18]和Berner等[19]提出在像素不同结深处集成感知红光和蓝光的双结,通过2个PFM读出电路实现双色AER VS.在AER视觉信息处理方面,Litzenberger等[8-9]研究了AER实时多车道车辆跟踪技术,Drazen等[10]研究了AER粒子跟踪速度计,Kogler等[20]开展了AER立体视觉研究.

虽然近年来AER VS研究在国际上获得了大量的关注,但国内尚处于起步阶段[21],同时国际上关于AER VS的系统建模和仿真研究尚未见发表.本文以设计AER VS芯片为目标,通过AER VS行为建模为电路和AER事件处理算法设计提供理论分析和测试基础.

1 AER传输方式原理

AER传输方式以仿生神经工程学为理论原型,将生物由刺激产生神经激励并通过神经突触并行输出的传导方式,模拟为通过电子系统的串行总线输出变化事件的位置、时间及属性[22].在AER VS中,感知到光强变化的像素主动向仲裁器发出申请,经仲裁许可后以串行脉冲方式输出,内容包括事件地址、时间以及属性.AER原理如图1所示,一维单一事件以脉冲形式异步串行输出,触发其所在行的地址编码器实时输出行地址.接收电路根据接收到的行地址和接收编码的时间还原事件的属性和行地址信息.

图1 一维事件AER方式原理Fig.1 One-dimensional event AER theory

AER VS中所有像素共用AER串行总线,同时发生的传输请求将产生冲突,因此需要进行仲裁.在事件量较小的情况下,AER可以实现实时输出;但在像素阵列较大、运动目标或噪声较多的情况下,同时发生的事件会存在较大的输出时差,会对后端的目标形状识别准确率造成较大影响.因此片上仲裁电路设计对于AER VS的性能具有关键作用.

2 AER视觉传感器模拟器

2.1 AER视觉传感器系统总体结构

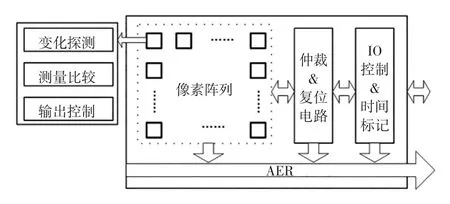

AER视觉传感器的总体结构如图2所示.像素电路包括光强变化检测、测量比较以及传输控制电路三部分:光强变化探测电路连续监测该位置光电流的变化,在光电流发生变化的情况下,启动测量比较电路;测量比较电路将设定时间内的变化光电压ΔV与设定阈值电压VH、VL进行比较,当ΔV大于VH或小于VL时则启动输出控制电路;输出控制电路向仲裁模块提出输出请求,获得许可后将地址及事件属性写入AER总线;I/O控制电路同时将当前时间戳添加入该事件,并发出事件输出信号.

图2 AER视觉传感器总体结构图Fig.2 AER vision sensor overall structure

仲裁模块分为行仲裁和片上仲裁两级,各行中的申请信号进行“或”运算后送往片上仲裁;片上仲裁按照优先规则确定获得AER使用权的行;获得允许的行仲裁器按照优先规则确定行内像素的输出顺序;此外行仲裁器向被允许输出像素发出复位信号,使其开始下一轮探测与采样.

控制与时间标记单元负责芯片内部时序与控制、接受外部控制参数写入相应寄存器等;当有事件输出时,负责将当前时间戳写入事件,因此事件携带的时间戳与其事件发生时间之间存在误差.

2.2 行为级模拟器结构

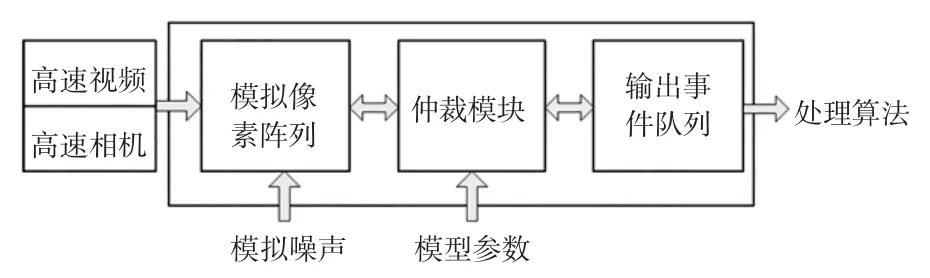

本文实现的行为级模拟器结构如图3所示.使用高速相机或高速视频作为数据源,将每个像素的光强变化拟合为一维连续时间函数,在添加模拟噪声后异步产生指定时间精度的AER事件.当前时间所有发生事件的像素向仲裁模块提出输出申请,获得输出许可的像素向输出事件队列的当前时刻添加本事件,然后该像素复位开始下一次的变化检测.

图3 AER VS模拟器结构图Fig.3 AER VS simulator structure

仲裁器接受来自像素阵列的输出申请,根据仲裁规则对同一时刻产生的多个变化事件进行判断选择.仲裁器性能对于后端跟踪识别算法的实时性和准确率具有很大影响.本文实现轮权仲裁、特定区域优先、事件集中优先3种仲裁方式.

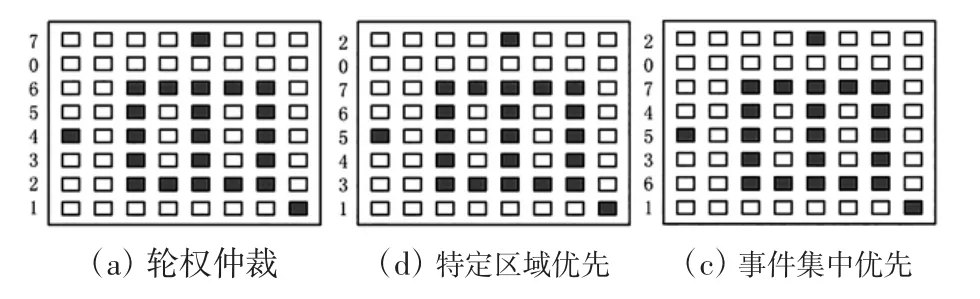

图4给出3种仲裁模式的比较性示意图,图中深色单元表示同一时刻发生变化事件并发出AER输出申请的像素.图4(a)、(b)、(c)分别给出轮权仲裁、特定区域优先及事件集中优先3种仲裁方式的示意图,左侧所标数字为该行的优先级.行内按中间最高、两边最低的优先级仲裁.

图4 3种仲裁方式的比较Fig.4 Comparison of three arbitration modes

(1)进轮权仲裁:按照行序轮转分配优先权(无AE产生的行优先级最低),如图4(a)所示.这种仲裁方式使每行的优先权相对平均,整体上各行的AER输出优先级相同.该方式轮流输出全部变化信息,但当电路存在较多噪声或干扰事件时,主要目标的事件输出时间间隔会较长,不利于主要目标的跟踪识别.

(2)特定区域优先:将优先输出指定的N行,其他行按照由内及外的次序设定.该区域通过SPI总线写入控制寄存器设定.优先输出指定区域的事件,会使得主要目标的所有事件输出间隔缩短.但由于外围系统接收、统计事件的集中区域可能需要较长时间,因此实时性差.如图4(b)指定3~7行具有较高优先级,能够更快输出.但如果关注目标较快移动到4~8行而特定区域坐标未被重写,则关键事件输出被延后.该方式的优点是电路设计较为简单.

(3)事件集中优先:由片上控制电路周期统计并确定事件高发区域的优先权,如图4(c)所示.根据上一周期的统计,事件较多的行将具有较高的优先权.此方式能够自适应提高获取场景关键信息的速度,当关注目标在视场中的位置发生移动时,能够快速改变优先输出区域的位置,实时输出主要关注目标的AE数据.缺点是电路实现代价较高,增加芯片面积.

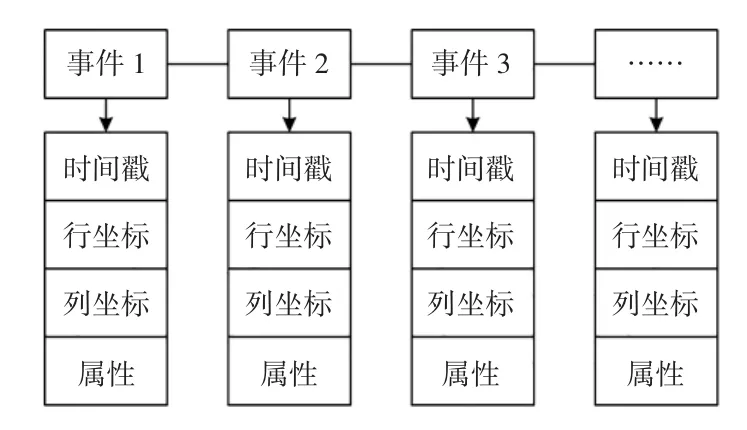

经仲裁处理后的AE事件按照时间顺序将形成如图5所示的事件队列,此事件流由后端处理系统接收处理.

事件所含时间戳并非事件发生的准确时间,而是该事件的AER输出时间.因此事件集中优先仲裁可使主要目标的识别更为准确.

图5 AER模拟器输出事件队列Fig.5 Event queue for AER simulator output

3 实验结果及分析

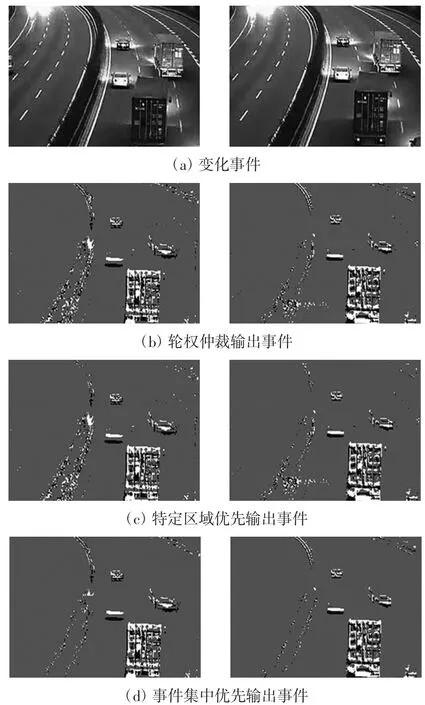

为比较不同仲裁方式对于目标跟踪算法的影响,使用一段高速公路监控视频作为输入进行测试,该视频来自于www.youku.com,视频分辨率为320×240,帧频30帧/s,帧数1 329,其间共72辆车驶过.该视频中目标运动的速度较快(约100km/h),且视频中有明显的光照变化和干扰信息,比较适合作为测试数据.该视频中车辆是主要的运动目标,因此选择其作为跟踪目标进行实验.3种仲裁方式下的输出事件如图6所示.

图6 3种仲裁模式下的输出事件Fig.6 Output events in three arbitration modes

图6(a)为截取的相邻两帧,图6(b)—图6(d)为3种仲裁方式下(a)与其前一帧和(b)与(a)间的变化事件,背景设为灰度值128,白色表示“光强增加”事件,黑色表色表示“光强减小”事件.图中变化事件主要由右侧运动车辆尾部产生,在中部和右上存在灯光干扰.

3.1 输出事件量比较

图6(b)为在轮权仲裁方式下获得的“事件图像”,完整包含了全部变化,输出的事件量分别是4 854和4 645,占到全部像素数目的6.32%和6.05%.

图6(c)为特定区域优先方式下获得的“事件图像”,优先输出上200行的事件.同时为了减少干扰事件,忽略优先级最低的10行事件,实际输出事件量为4 013和3 902,占到全部像素数目的4.65%和4.52%.

图6(d)为事件集中优先方式获得的“事件图像”,忽略优先级最低的10行事件,优先输出以大型卡车为中心的事件(优先下200行),实际输出事件量为4 087和3 965,占到全部像素数目的4.73%和4.59%.表1为上述AE数据量的对比.

表1 不同仲裁方式下AE事件量比较Tab.1 Comparison of events number under different arbitrations

由表1可见,该例中变化事件量不足全部像素的7%,说明图像中存在很大冗余,背景重复采样并不必要.按照‘帧采样’模式估计,等效帧频可以提升至600帧以上(不考虑光强限制).此外由于丢弃了10行最低优先级事件,因此不同仲裁模式输出事件量略有差异.

3.2 使用全部事件的跟踪准确率比较

为评价不同仲裁方式对基于事件的目标跟踪算法的影响,使用文献[23]提出的目标跟踪算法对上述3种输出事件流进行处理.算法原理是将AE事件按位置分簇后形成簇列表,根据AE事件动态更新簇中心、半径等属性,根据中心位移估算速度、方向等信息.

将3种事件流的全部事件作为事件源进行跟踪准确率测试,结果如表2所示(1 329帧,72个经过目标;双核2.2 G CPU,3.6 G内存).

分析表2中不同仲裁方式对跟踪准确率的影响可见:由于包括全部存在干扰事件,轮权仲裁方式的跟踪时间最长,跟踪准确率最低;由于滤除部分干扰事件,特定区域优先方式的跟踪时间小于轮权仲裁,与事件集中优先近似;由于特定区域未包含主要目标,因此跟踪准确率较低;事件集中优先方式耗时与特定区域优先近似,准确率最高.

表2 不同仲裁方式下跟踪准确率比较Tab.2 Comparison of tracking accuracy under different arbitrations

3.3 使用部分事件的跟踪准确率比较

由于变化事件中包含了噪声以及光照等影响因素,并且这些噪声事件以随机顺序输出,而且跟踪算法使用“事件簇”的方式来记录分析目标的运动属性,因此在多目标、高速的情况下并不需要使用全部事件来进行处理.表3给出3种仲裁方式下使用部分事件的跟踪准确率.

表3 不同仲裁方式下部分事件跟踪准确率比较Tab.3 Comparison of tracking accuracy using partial events under different arbitrations %

由表3可见:3种仲裁方式跟踪准确率随事件量的变化关系一致,跟踪准确率随使用事件量增加而上升,约在70%时达到最大,然后逐渐下降,原因是随事件量增加,位于主要‘事件区’之外的干扰事件被输出,导致跟踪准确率下降;与表2的结论相同,3种仲裁方式中事件集中优先在相同事件量下具有最高的跟踪准确率;基于‘事件簇’的跟踪算法通过事件聚集的特点进行目标跟踪,并不考虑事件的位置分布,因此可以使用较少的事件量提高准确率.

4 结束语

本文以仿生AER VS设计研究为基础,进行了AER VS总线仲裁建模和仿真.通过对高速运动场景进行测试,为芯片及后端处理系统设计提供了理论数据和指导.大量实验表明,通常情况下变化事件数量仅占全部像素数目的5%~10%,因此AER VS从源头上消除冗余信息,显著提高采样以及跟踪处理速度.在使用的3种总线仲裁方式中,事件集中优先较其他方式具有更高的跟踪准确率,并且跟踪效率更高.因此事件集中优先的仲裁方式更适宜于目标跟踪应用.本文进一步的工作包括有效的时间戳误差标定方法以及高性能AER事件跟踪算法.

[1]SUZUKI T.Challenges of image-sensor development[C]//Solid-State Circuits Conference Digest of Technical Papers.2010:27-30.

[2]YANG H X,SHAO L,ZHENG F.Recent advances and trends invisualtracking:Areview[J].Neurocomputing,2011,74(6):3823-383.

[3]VOGELSTEIN R J,MALLIK U,CAUWENBERGHS G.Beyond address-event communication:Dynamically reconfigurable spiking neural systems[J].The Neuromorphic Engineering,2004,1(1):1-12.

[4]LIU S D,DELBRUCK T.Neuromorphic sensory systems[J]. Current Opinion in Neurobiology,2010,20(3):288-295.

[5]DELBRUCK T,LINARES-BARRANCO B,CULURCIELLO E,et al.Activity-driven,event-based vision sensors[C]//Proceedings-IEEE International Symposium on Circuits and Systems.2010:2426-2429.

[6]POSCH C,MATOLIN D.Sensitivity and uniformity of a 0.18 m CMOStemporalcontrastpixelarray[C]//IEEEInternationalSymposium on Circuits&Systems.2011:1572-1575.

[7]LENERO-BARDALLO J A,SERRANO-GOTARREDONA T,LINARES-BARRANCO B.A 3.6 μs latency asynchronous frame-free event-driven dynamic-vision-sensor[J].IEEE Journal of Solid-State Circuits,2011,46(6):1443-1455.

[8]LITZENBERGER M,BELBACHIR A N,DONATH N,et al. Estimation of vehicle speed based on asynchronous data from a silicon retina optical sensor[C]//Intelligent Transportation Systems Conference.2006:653-658.

[9]LITZENBERGER M,KOHN B,GRITSCH G,et al.Vehicle counting with an embedded traffic data system using an optical transient sensor[C]//Intelligent Transportation Systems Conference.2007:36-40.

[10]DRAZEN D,LICHTSTEINER P,FLIGER P,et al.Toward real-time particle tracking using an event-based dynamic vision sensor[J].Experiments in Fluids,2011,51(5):1465-1469.

[11]MAHOWALD M.VLSI snalogs of neuronal visual processing:A synthesis of form and function[D].California:California Institute of Technology,1992.

[12]YU C M,MALLIK U,CLAPP M A,et al.CMOS camera with in-pixel temporal change detection and ADC[J].IEEE Journal of Solid-State Circuits,2007,42(10):2187-2196.

[13]KRAMER J.An integrated optical transient sensor[J].IEEE Transactions on Circuits and Systems II,2002,49(9):612-628.

[14]DELBRUCK T,MEAD C A.Adaptive photoreceptor with wide dynamic range[C]//IEEE International Symposium on Circuits and Systems.1994:339-342.

[15]LICHTSTEINER P,POSCH C,DELBRUCK T.A 128×128 120 dB 30 mW asynchronous vision sensor that responds to relativeintensitychange[C]//Solid-StateCircuitsConference.2006:2060-2069.

[16]POSCH C,MATOLIN D,WOHLGENANNT R.An asynchronous time-based image sensor[C]//IEEE International Symposium on Circuits and Systems.2008:2130-2133.

[17]JUAN Antonic L B,TERASA S G,BERNABE L B.A 3.6 μs latency asynchronous frame-free event-driven dynamic-vision-senser[J].IEEE Journal of Solid-State Circuits,2011,46(6):1443-1445.

[18]OLSSON J A M,HAFLIGER P.Two color asynchronous event photo pixel[C]//IEEE International Symposium on Circuits and Systems.2008:2146-2149.

[19]BERNER R,DELBRUCK T.Event-based color change pixel in standard CMOS[C]//IEEE International Symposium on Circuits and Systems.IEEE,2010:349-352.

[20]KOGLER J,SULZBACHNER C.Bio-inspired stereo vision system with silicon retina imagers[C]//International Conference on Computer Vision System.2009:174-183.

[21]于璐,姚素英,徐江涛.一种基于地址-事件表达的实时视觉传感器实现方法[J].光学学报,2013,33(1):251-257. YU L,YAO S Y,XU J T.An implementation method of realtime vision sensor based on address event representation[J]. Acta Optica Sinica,2013,33(1):251-257(in Chinese).

[22]BOAHEN K A.Point-Point connectivity between neuromorphic chips using address events[J].IEEE Transactions on Circuits and Systems,2000,47(5):416-434.

[23]LITZENBERGER M,POSCH C,BAUER D,et al.Embedded vision system for real-time object tracking using an asynchronous transient vision sensor[C]//Digital Signal Processing Workshop.2006:173-178.

Modeling and emulation of address-event representation vision sensor bus arbitration

YANG Shuai1,HU Yan-xiang2,XU Jiang-tao3

(1.School of Computer Science&Software Engineering,Tianjin Polytechnic University,Tianjin 300387,China;2.College of Computer and Information Engineering,Tianjin Normal University,Tianjin 300387,China;3.School of Electronic Information Engineering,Tianjin University,Tianjin 300072,China)

An emulator of AER vision sensor bus arbitration is implemented and is used to emulate the process of event sampling,AER artribution and object tracking.Experimental result indicates that the visual information generated by AER vision sensor is only 5%-10%of the total number of image sensor pixels,and the object tracking accuracy of event-aggregation arbitration is higher than that of specific region arbitration and round-robin arbitration in high-speed object tracking applications by 10%-20%.So object tracking based on AE data is more efficient,and event-aggregation artribution has more efficiency for the applications of high speed object tracking.

address-event representation(AER);vision sensor;emulator;arbitration;object tracking

TP212

A

1671-024X(2016)06-0084-05

10.3969/j.issn.1671-024x.2016.06.015

2016-03-14

国家自然科学基金资助项目(61274021);天津市科技重大专项与工程计划资助项目(15ZXHLGX00300)

杨 帅(1988—),男,硕士,助教,主要研究方向为数字信息处理,E-mail:yangshuaimail@139.com