寒冷地区微模块数据中心能耗分析

王春红

(内蒙古财经大学 计算机系,内蒙古 呼和浩特 010051)

寒冷地区微模块数据中心能耗分析

王春红

(内蒙古财经大学 计算机系,内蒙古 呼和浩特 010051)

从降低数据中心的能耗出发,对工作在自然冷源场景下的冷水机组能耗进行分析,并计算出全年的PUE值。提出了在寒冷地区新建数据中心,采用以微模块为核心,配合具有Free Cooling冷却技术的冷水机组为数据中心进行制冷的技术架构,根据系统仿真测试,结果表明,提高末端空调的供水温度,每当提高1℃的出水温度,冷水机组的制冷量将提高3%~4%,而功耗约增加1%。有效地降低了PUE值,从而节约了电能,降低了碳排量及成本。

能耗分析;微模块;PUE;冷热通道;FreeCooling

根据工信部《电信互联网数据中心的能耗测评方法》、《互联网数据中心资源占用、能效及排放技术要求和评测方法》等标准的推出,明确提出新建的数据中心的PUE值为1.5,对数据中心的建设规模要根据地区能源、气候和地质条件情况不同而分别进行规划。

目前,国际上通行的数据中心电能的衡量指标是PUE(Power Usage Effectiveness)电源使用效率。PUE=数据中心总能耗(Total Facility Power)/IT设备能耗(IT Equipment Power)[1]。数据中心总能耗包括IT设备能耗、网络设备能耗、制冷能耗、照明能耗、电源系统能耗、物理安全能耗和其他相关能耗;IT设备能耗包括服务器、存储设备、数据备份等IT设备能耗。PUE值越低,表示绿色节能度越高。

1 技术分析

1.1 数据中心微模块

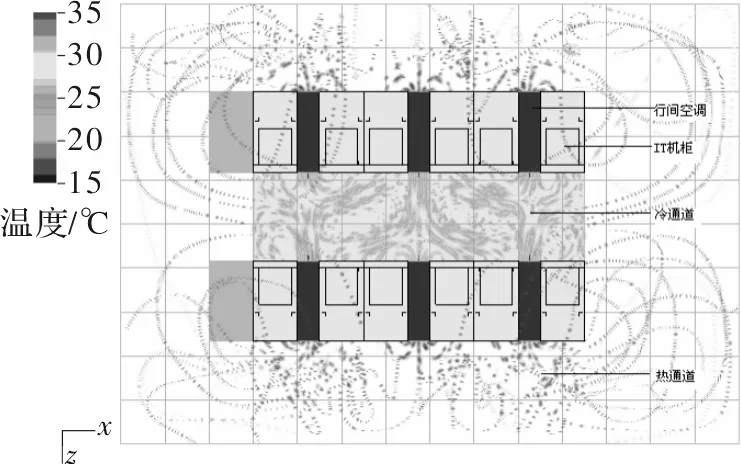

数据中心微模块[2]是指每个模块具有独立的功能、统一的输入输出接口,不同区域的模块可以互相备份,通过相关模块的排列组合形成一个完整的数据中心。通过精细化的机柜布局,减少占地空间,提高制冷效率。机柜放置采用面对面方式,机柜正面形成冷通道,背侧为热通道,前进风后出风,冷热通道隔离,避免冷热空气混合,增强散热,提高制冷效率,降低PUE。隔离冷热通道示意图,如图1所示。Air-side economization(空气流动经济性)是提升散热效率的关键。提高空气流动经济性的关键是让冷空气流入服务器,气流组织优化模型图如图2所示。

图1 微模块机房冷热通道隔离

图2 气流优化模型

1.2 自然冷却(Free Cooling)技术

Free Cooling(免费冷却)是一种在室外空气温度低于机房温度时,通过相应的技术手段将室外冷源引入建筑内将热量带走,以达到降温的目的,降低能耗。目前免费制冷主要有两种方式:空气侧和水侧免费制冷[3]。

空气侧免费制冷是指室外空气直接通过滤网或间接通过换热器将冷量带入到建筑内。水侧免费制冷是指一种制冷剂,直接通过冷却塔循环带走热量,而不是通过制冷机或者压缩机循环来散热。Free Cooling风冷式冷水机组带有独特的自然冷却干冷换热器,其运行原理是优先利用天然环境的低温空气冷却循环冷冻水,实现无压缩机运行制冷,环境温度越低,自然冷却的比例越大,机组的功耗越低,显著节省压缩机的能耗。

2 系统设计分析

2.1 测试背景

内蒙古自治区地跨中国东北、西北地区,北起北纬53°20′,南至北纬37°20′,属典型的中温、寒温带季风气候,显著特点是寒暑变化剧烈,昼夜温差较大。冬季漫长而寒冷,多数地区冬季长达5个月到半年,夏季温热而短暂。以呼和浩特市为例,冬季平均气温在0 ℃以下达5个月,室外气温最低可达-23 ℃。年平均气温在1.5~12.5 ℃,全年约有7~8个月的时间可以利用自然冷源为数据中心降温。

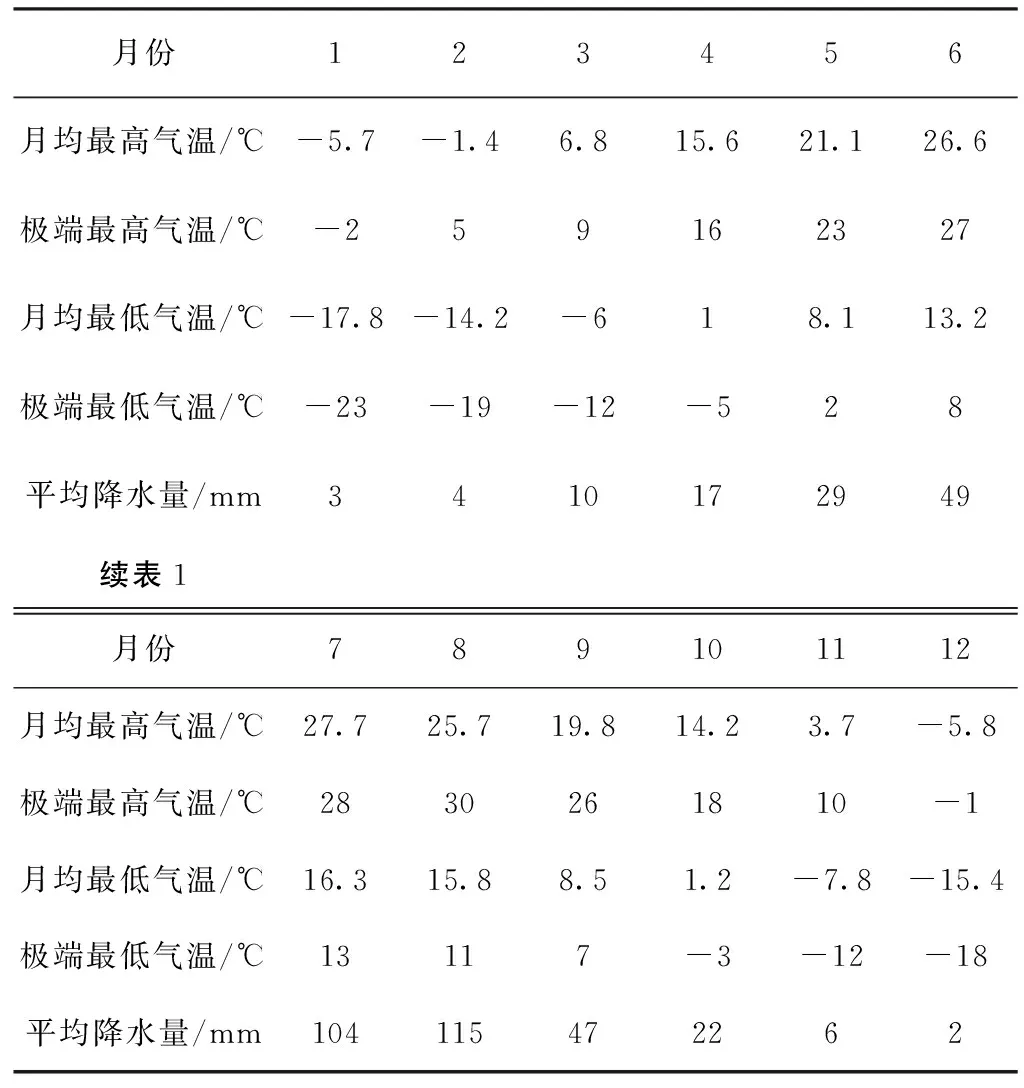

表1 2013年呼和浩特月均气温统计表

图3 全年月均温度曲线图

从图3可以看出,全年月平均气温处于0 ℃以下的为1、2、3、11、12月,全年月平均气温处于7~15 ℃的月份为4和10月,而5~9月,气温升高,月平均气温处于15 ℃以上。

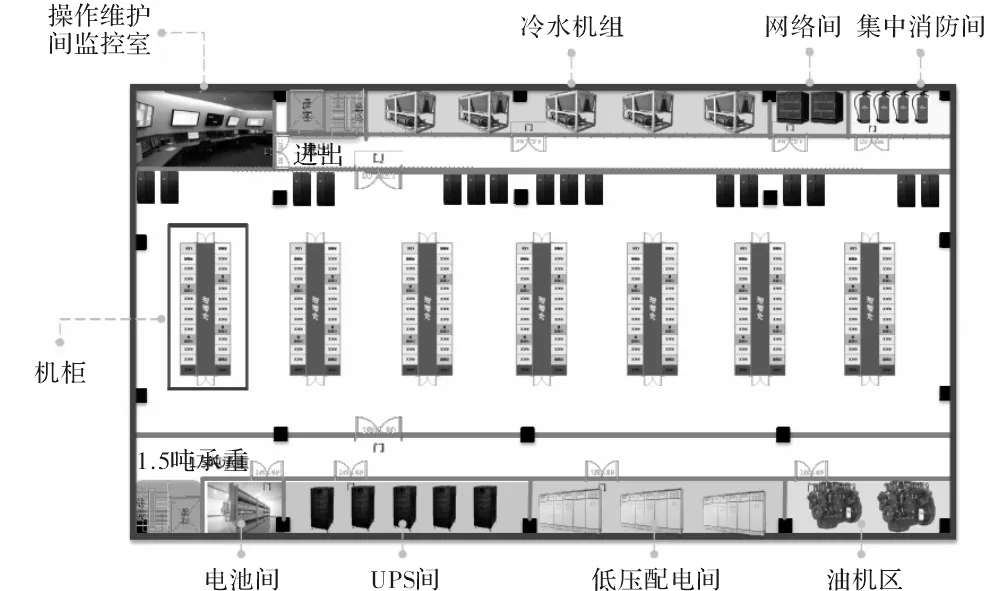

2.2 数据中心组成全景

图4 数据中心全景图

数据中心可分为服务器区(微模块)、网络间、消防间、监控间、配电间(低压配电间、UPS间、电池间)以及供电系统(柴油发电机)、制冷系统等区域。

2.3 设备需求与空调模式

微模块布局采用冷通道封闭设计,通过冷池的宽度大小来区分为高密度区与中密度区。其中,40%为中密度区,单机柜容量为5 kW/Rack;60%为高密度区,单机柜容量为10 kW/Rack。微模块机柜间选用水冷行间空调、配电间采用水冷机房精密空调、网络间采用直膨式风冷精密空调进行冷却。室外冷却部分,采用Free Cooling技术的风冷冷水机组并结合自然干冷器给行间空调和配电间精密空调提供冷冻水。干式冷却塔的热水在散热翅管内流动,靠与管外空气的温差,形成接触传热而冷却,水与空气不直接接触。北方地区气候干燥,适合采用干式冷却,没有水的蒸发损失。制冷模型如图5所示。

图5 制冷模型图

设备规模:7套微模块,每模块16 Rack;工况:回风温度28 ℃,进、回水温度10/15 ℃;室内侧:行间空调35台,单台制冷量28 kW,功率1.5 kW;室外侧:主机为带自然冷却的风冷冷水机组,采用冷冻水为冷媒,设计供水温度为6~20 ℃,理想供水温度为15 ℃,名义制冷量600 kW,功率150 kW;冷却塔:干式冷却塔6台,功率为7.5 kW。

通过控制系统,设定温度范围,当室外温度达到比冷冻水回水温度低10 ℃或以上时,压缩机制冷系统完全停止运行,完全由干冷器工作,采用自然冷源来制冷,自然冷却达到100%,机组无压缩机功耗,仅有少量的风机风扇运转功率。当室外温度达到比冷冻水回水温度低2 ℃或以上时,可以采用压缩机和自然冷源同时工作的模式。开启Free Cooling功能自然冷却预冷冷冻水,无压缩机功耗;自然冷却温度不够的部分,再由压缩机制冷来达到需求冷量。

3 能耗分析计算

3.1 冷量计算

由于机柜密度并不均衡,中密度区每套微模块内服务器功耗为5 kW/Rack,高密度区为10 kW/Rack,核心区机柜的平均功耗8 kW/Rack。每模块内:照明功耗0.2 kW,网络柜功耗1.8 kW,监控功耗0.05 kW。根据各部分功耗,由此可以计算出7套16 Rack的功耗QT。

QT=7×(16×8+1.8+0.2+0.05)=910.35 kW

(1)

中密度区采用每隔3机柜一台行间空调用于制冷,高密度区采用每隔2机柜一台空调,需要4台空调。根据国家标准GB50174-2008《电子信息机房设计规范》的数据中心空调配置建议,为了确保由于单行间空调故障,通常建议数据中心采用N+M(M=1,2,…)配置形式,提供工作可靠性与安全性。此案例采用N+1配置,所以共需5台空调。单台行间空调的制冷量为28 kW,按照空调的配置,可以计算出行间空调总制冷量为Q1。

Q1=7×(28×5)=980 kW

(2)

根据精确估算方法,配电间发热量=空载损耗+运行损耗=总体IT负载功率×0.05。因此水冷空调所需制冷量为Q’。

Q’=QT×0.05=910.35×0.05=45.5 kW

(3)

此案例选用2台50 kW制冷量的空调进行冷却(一主一备),总制冷量需求为Q2。

Q2=50×2=100 kW

(4)

一般机房规划时按照每个机柜4平米来计算机房总面积S。

S=7×4×16=448 m2

(5)

取整为450 m2,这里并不考虑配电间、设备间、操作间、动力组等占地面积,只计算核心机柜部分。

根据环境热负荷计算公式,采用“功率及面积法”,环境热负荷为Q3。

Q3=0.12~0.18 kW/m2×机房面积

(6)

南方地区可选0.18,北方地区选择0.12,所以计算出Q3=0.12×450=54 kW。

通过以上计算,可以计算出总制冷量需求为Q,即室外冷水机组需要提供的制冷量

Q=Q1+Q2+Q3=980+100+54=1 134 kW

(7)

此案例配置3台制冷量为600 kW的冷水机组为空调提供冷冻水,2台运行,1台备用,对应冷冻水循环水泵2台,水泵功率为10 kW;7.5 kW的干式冷却塔6台。

3.2 PUE计算

根据UPS容量计算公式

UPS 容量S=IT负载功率÷0.8(UPS输出功率因数)÷0.6(UPS主机理想负载为输出功率的60%)

(8)

其中,IT负载功率=QT+40=910.35+40=950.35 kW。

S=950.35÷0.8÷0.6=1 980 kVA

(9)

可选用2 000 kVA的UPS进行供电,不考虑预留扩容需求。计算出压缩机完全工作时的PUE值,PUE1=总功耗÷IT设备功耗

PUE1=1 504.68÷908.6=1.656

(10)

完全自然冷源场景时的PUE值为PUE2

PUE2=1 151.28÷908.6=1.309

(11)

根据全年的气温曲线,有5个月时间完全开启自然冷源;有3个月时间处于混合工作时间,混合工作时间可以折算成1个月自然冷却时间;有4个月时间处于压缩机完全工作状态,可以计算出全年的PUE值为1.447 8,达到要求建设标准。

表2 中心机房功耗表

根据系统仿真模拟测试,提高冷水机组的出水温度即提高末端空调的供水温度,每提高1 ℃的出水温度,冷水机组的制冷量将提高3%~4%,而功耗约增加1%左右。

通过模块内先进气流优化组织技术与室外机组Free Cooling技术的应用,有效降低了PUE值,北方寒冷地区最低可达到1.3,每年可为客户节省大笔电费,降低碳排量,为节能减排做出贡献。

4 结束语

为降低数据中心的PUE,提升能源使用效率,通过各种先进技术可以大幅降低PUE。如采用模块化数据中心架构;数据中心选址在寒冷的高纬度地区;采用自然冷源技术减少压缩机工作时间,降低制冷能耗,从而节约电能;采用直流供电技术,提高供电效率;采用刀片服务器、虚拟化技术,减少服务器数量,来降低IT设备能耗等。结合微模块和Free Cooling技术,寒冷地区,数据中心PUE值可达到1.3,可降低PUE值0.3以上,节约电能,降低成本。

[1] 王洪锁,张锐锋,贾春香.基于PUE评价指标的数据中心的绿色IT技术[J].中国管理信息化,2014(1):111-113.

[2] 朱利伟.浅谈微模块技术及实现[J].智能建筑与城市信息,2013(11):33-34.

[3] 郭亮.浅析微模块数据中心的关键技术[J].信息通讯技术,2013(1):33-37.

[4] 仝爱军.自然冷源技术在模块化数据中心的应用[J].电信技术,2013(8):41-44.

[5] 陈育伟.寒冷地区程控机房利用自然冷源空调节能的探讨[J].邮电设计技术,2003(1):47-48.

[6] 陈杰.利用自然冷源制冷对通信基站节能降耗的研究[D].北京:北京工业大学,2012.

[7] 陈婷.数据机房精确送风方式的应用研究[D].南京:南京师范大学,2014.

[8] Cho J,Lim T,Kim B S.Measurements and predictions of the air distribution systems in high compute density (Internet) data centers[J].Energy and Buildings,2009(41):1107-1115.

Analysis of Energy Consumption by Micro Module Data Center in Cold Regions

WANG Chunhong

(Department of Computer Science,Inner Mongolia University of Finance and Economics,Hohhot 010051,China)

Starting from the target of reducing energy consumption in the data center,this paper analyzes energy consumption of the water chiller unit working in the natural cold scenario and calculates the PUE value throughout the year.Researchers suggest selecting the micro module as the core technical framework,and using the water chiller unit with the Free Cooling technology for refrigeration for the data center constructed in cold areas.Simulation shows that an increase of the output water by 1℃ will increase the refrigerating output of the chiller unit by 3%~4% and power consumption by 1%,thus saving electric energy,decreasing carbon emission and reducing cost.

Micro data center;PUE;Cold and hot channel spacing;Free Cooling

2014- 11- 24

内蒙古财经大学校级科研基金资助项目(KY1302)

王春红(1979—),女,硕士,讲师。研究方向:计算机网络规划与设计,计算机教育应用。E-mail:wangchunhong99@163.com

10.16180/j.cnki.issn1007-7820.2015.04.022

TP311.5

A

1007-7820(2015)04-080-04