基于事件分析的多摄像机鲁棒跟踪算法

蔡晓东,吴 迪,华 娜,梁奔香,朱利伟

(桂林电子科技大学 信息与通信学院,广西 桂林 541004)

基于事件分析的多摄像机鲁棒跟踪算法

蔡晓东,吴 迪,华 娜,梁奔香,朱利伟

(桂林电子科技大学 信息与通信学院,广西 桂林 541004)

提出了一种新的基于事件分析的目标跟踪算法来解决多个目标分离或遮挡时的可靠跟踪问题。首先提出使用仿射变换来获得多个摄像机之间重叠画面的映射关系,实现目标交接,为后面的目标识别奠定基础。然后当单摄像机目标跟踪过程中发生候选目标多于一个或者多个目标对应一个候选目标的情况时,提出一种判别目标出现遮挡事件或分离事件的新方法,并且通过多摄像机的目标交接准确识别出发生遮挡或分离事件的目标标号,解决目标发生遮挡或分离后跟踪失败的问题。实验结果证明:所提出的方法突破了一般跟踪算法受目标底层特征约束的难点,具有更高的鲁棒性。

目标交接;多摄像机跟踪;分离事件;遮挡事件

1 目标跟踪

多摄像机目标跟踪在智能监控[1]、视频内容理解[2]等方面有着广泛的应用。目标在一个摄像机中发生遮挡时,在另一摄像机视角观察可能不发生遮挡,因此,使用多摄像机可以很好地解决单摄像机因目标遮挡产生跟踪丢失的问题。但是从不同的摄像机中观察到的目标信息很容易受环境因素(如视角、光线等)的影响,导致观察到的目标信息存在着较大差异,因此多摄像机鲁棒性目标跟踪具有巨大的挑战性。

常见的多摄像机目标跟踪的方法有3类:1)基于特征匹配[3]。如文献[4]采用Mean-shit跟踪法,其通常采用颜色特征对目标进行匹配,计算简单;但是目标颜色受光线影响很大,从不同的角度观察目标时,颜色特征会发生变化,此时容易产生跟踪错误。由于不同摄像机中观察到的目标特征受环境因子影响较大,因此使用特征匹配的鲁棒性较差。 2)使用3D几何约束的方法[5-6]。这些算法将目标的特征点映射到同一三维空间中,通过比较这些特征点在世界坐标系中的位置来建立目标的匹配关系。但是这种方法要先对摄像机进行标定,获取摄像机的内外参数,操作较繁琐,并且在实际应用的复杂环境中,难以通过标定获取精确的摄像机内外参数,导致目标匹配的正确率下降。 3)SIFT特征点匹配法[7-9]。SIFT具有旋转、尺度缩放、亮度变化保持不变性的特征,但是使用SIFT变换时,计算量较大,难以实现实时的目标跟踪。当两个摄像机的观察角度的差异性较大时,各个摄像机观察到的同一目标的特征会存在较大差异,SITF匹配法的准确度也会降低。

综上所述,多摄像机中使用目标底层特征(颜色、特征点等)很容易受到环境的约束,从而引起目标跟踪丢失。因此本文提出了一种新的多摄像机目标跟踪算法,算法模块的框架如图1所示,设摄像机A1,A2,…,An为相邻的摄像机群。

图1 算法框架图

如图1所示,首先获取多个摄像机的视频流,然后使用目标交接获取多摄像机之间目标的对应关系,使得不同摄像机中的同一个目标具有相同的标号。然后提出使用新的多摄像机跟踪算法,当一个摄像机画面的目标发生遮挡事件或分离事件时,与相邻不发生遮挡事件或分离事件的摄像机画面进行目标交接,从而解决目标被遮挡或分离时产生的误匹配问题,实现稳定的目标跟踪。

2 目标交接

首先获取多摄像机画面之间的仿射变换关系,从而计算出多摄像机画面的对应坐标;接着本文提出提取图像中的运动目标坐标,根据目标坐标和仿射变换矩阵计算出与相邻摄像机画面的对应目标,识别出目标标号,从而实现目标交接。

2.1 仿射变换

仿射变换[10]可以实现二维平面到二维平面的线性变换,因此使用仿射变换矩阵可以获取图像平面坐标之间的映射关系。设I1,I2分别为不同视觉观察同一场景ζ的摄像机,目标a和目标b在I1,I2画面中的投影位置如图2所示。

图2 目标在不同视觉的摄像机中的成像图

设I1画面到I2画面的仿射变换矩阵记为H[10]

(1)

其中,h11~h32是仿射变换矩阵的系数,代表水平、垂直方向上的位移量、旋转因子、缩放因子。

设χ是场景ζ中的任意一点,在I1,I2画面中的投影坐标分别设为(x1,y1)和(x2,y2),则其坐标之间的映射关系满足式(2)。从而根据式(2)可以计算出一个平面中的任一坐标点对应到另一平面的坐标位置。

(2)

式(2)展开可得到

(3)

通过式(3)可以实现两个平面之间的坐标对应,为目标标号识别打下基础。

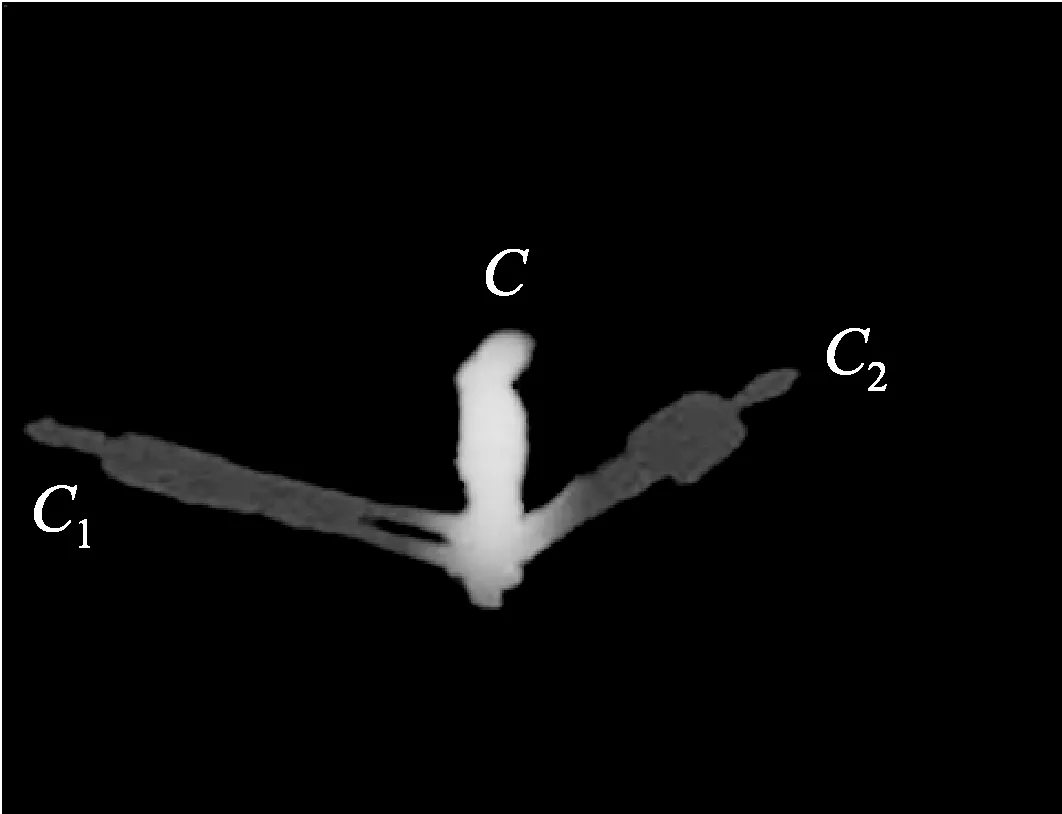

2.2 目标标号识别

如图3所示,设水平地面为参考平面,不同视角的摄像机观察到目标c在地面的投影分别设为c1、c2。当目标的世界坐标与参考平面的深度信息不一致时,其投影在参考平面的位置是不一样的,如图3中c1、c2除了脚部部位,其他部位都不重合。因此,本文首先采用高斯背景重建算法[11]对运动目标进行检测,然后使用文献[12-13]的blob算法提取运动目标。由于目标最低点与地面接触,其深度信息相同(都为0),因此本文提出使用运动物体的最低点代表目标坐标的方法,有效地减少了由于特征点的深度信息不一致而引起的变换误差。

图3 不同视角的摄像机中目标在地面的投影图

设目标ρ在摄像机I1画面中的最低点坐标为(x1ρ,y1ρ),代入式(2)和式(3),计算出其在摄像机I2画面中坐标为(x2ρ,y2ρ);设I2中目标x的像素点坐标集为Area(x),其中,目标x的任一坐标点设为(x2k,y2k),其中k=0,1,…,n,则Area(x)的定义如式(4)所示;如果(x2ρ,y2ρ)满足式(5),则表示目标ρ与目标x为同一目标,从而识别出目标x的标号,实现目标标号交接。

Area(x)={(x20,y20),(x21,y21),…,(x2n,y2n)},n∈R

(4)

(x2ρ,y2ρ)∈Area(x)

(5)

3 多摄像机跟踪

目标不发生遮挡时,一般使用卡尔曼滤波[14]的方法可得到良好的跟踪效果。当目标之间发生遮挡事件时,多个目标重叠在一起,部分目标的特征信息被遮挡丢失;多目标发生分离事件时,由于目标被遮挡期间目标的特征信息丢失,根据目标的先验知识难以将遮挡后重新出现的目标进行准确地识别,此时稳定的目标跟踪存在着巨大挑战。

因此,当目标之间在某一个摄像机中发生遮挡、分离事件,而在另一摄像机视角观察不发生遮挡、分离事件时,本文提出一种新的目标遮挡事件和分离事件的判别算法,准确地判断事件的发生,并提出使用多摄像机之间的目标交接,获得遮挡或分离目标的标号,实现持续的目标跟踪。

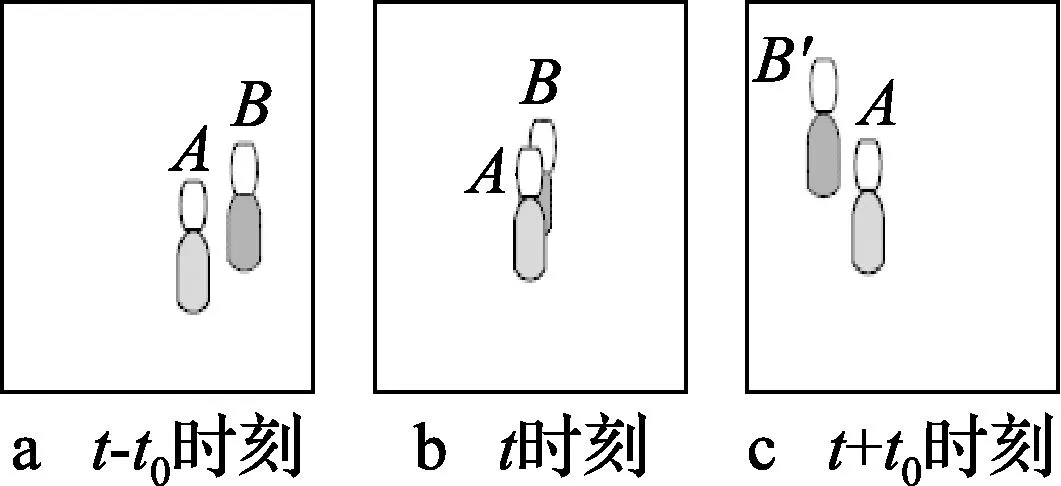

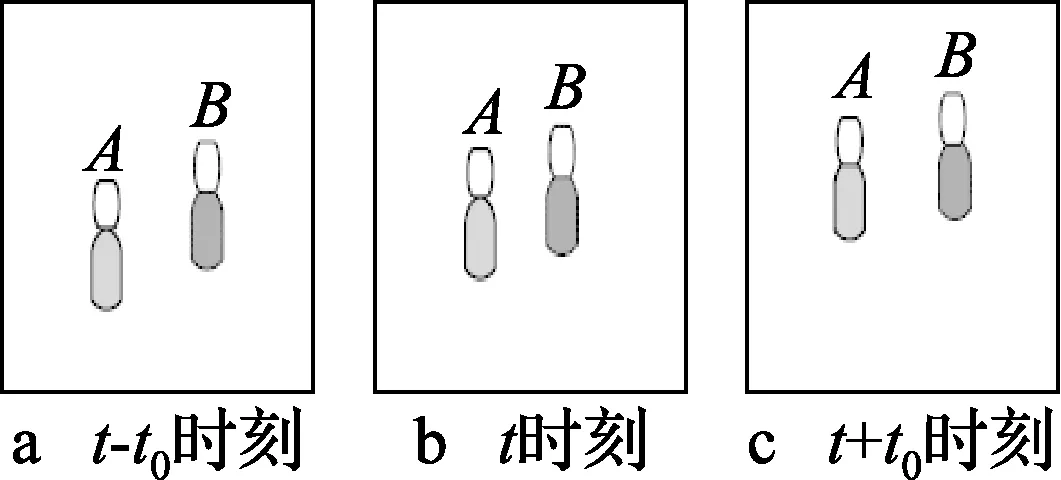

设camA和camB是相邻的摄像机,当多个目标发生遮挡或分离事件时,可使用相同的方法进行分析。目标A和B是camA在t-t0时刻到t+t0时刻观察到的运动物体,如图4a~图4c所示;在camB中观察到的状态如图5a~图5c所示。

图4 camA在t-t0时刻到t+t0时刻观察到的运动物体状态图

图5 camB在t-t0时刻到t+t0时刻观察到的运动物体状态图

图4a~图4c中,目标在t时刻发生遮挡事件,目标在t+t0时刻发生分离事件;图5a~图5c中,目标A和B没有发生遮挡和分离事件。

设在任一时刻,当一个摄像机中发生遮挡或分离事件(如图4的camA),相邻的一个摄像机不发生该事件时(如图5的camB),本文提出使用目标交接从相邻摄像机画面中获取目标的信息,实现目标识别。图6展示了两个摄像机进行目标跟踪算法的流程图,该方法适用于多摄像机中两两摄像机进行多目标跟踪的情况。

图6 两摄像机进行目标跟踪算法流程图

图6中,设X={x1,x2,…,xn},n∈N为camA中发生遮挡或分离事件的目标集合,当camA中的目标发生遮挡或分离事件时,将其目标信息发送给camB,然后通过式(3)~式(5)识别出目标的标号,并发送给camA,从而实现目标X在camA的目标跟踪。

3.1 OE判断及目标识别算法

当多目标发生遮挡事件时,如图4a~图4c所示,观察到的目标个数由多个变为一个。由于camB中目标无遮挡事件发生,使用卡尔曼滤波的方法可实现准确的跟踪结果。

(6)

设Area(x)为目标所占地区域范围,式(7)的定义为

(7)

3.2 SE判断及目标识别算法

当目标发生分离事件时,如图4b~图4c所示,重叠目标体在图4c中分离成多个目标。此时使用单摄像机跟踪的方法将会把分离出来的目标认为是新出现的目标,造成目标跟踪失败。

(8)

设εH为允许的投影误差,式(9)的定义为

(9)

若目标B′的坐标符合式(9),则表示目标与B′的标号与camB中目标B的标号相同,其为同一目标。通过上述方法即可识别出重叠后产生分离的目标标号,解决了重叠目标分离后产生跟踪丢失的问题。

4 实验结果分析

使用本文算法对两组实验的结果分析如下:

1)与SIFT特征跟踪算法的比较实验

使用本文提出的多摄像跟踪机制和文献[9]的方法使用sift特征点进行目标跟踪的实验效果进行对比。实验一场景选择一个小区的门口,门口的行人较多,很容易引起目标遮挡。本文方法可适用到多个摄像机,但是多摄像机中两两摄像机通信的方法是相同的,因此本次实验展示了使用两个摄像机对目标进行跟踪的效果。两相邻摄像机分别设为camA和camB,camA的焦距大小为camB的1/4,因此camB比camA具有更宽广的视角,并且camA与camB对场景观察角度的夹角为75°,此时,camA与camB的观察到的目标特征信息具有较大的差异。

camB的场景如图7所示,camA的场景如图8~图9所示。camA与camB同时对场景进行监控,监控视频中第201帧到568帧有两个行人经过监控区域。其跟踪效果如图7所示。

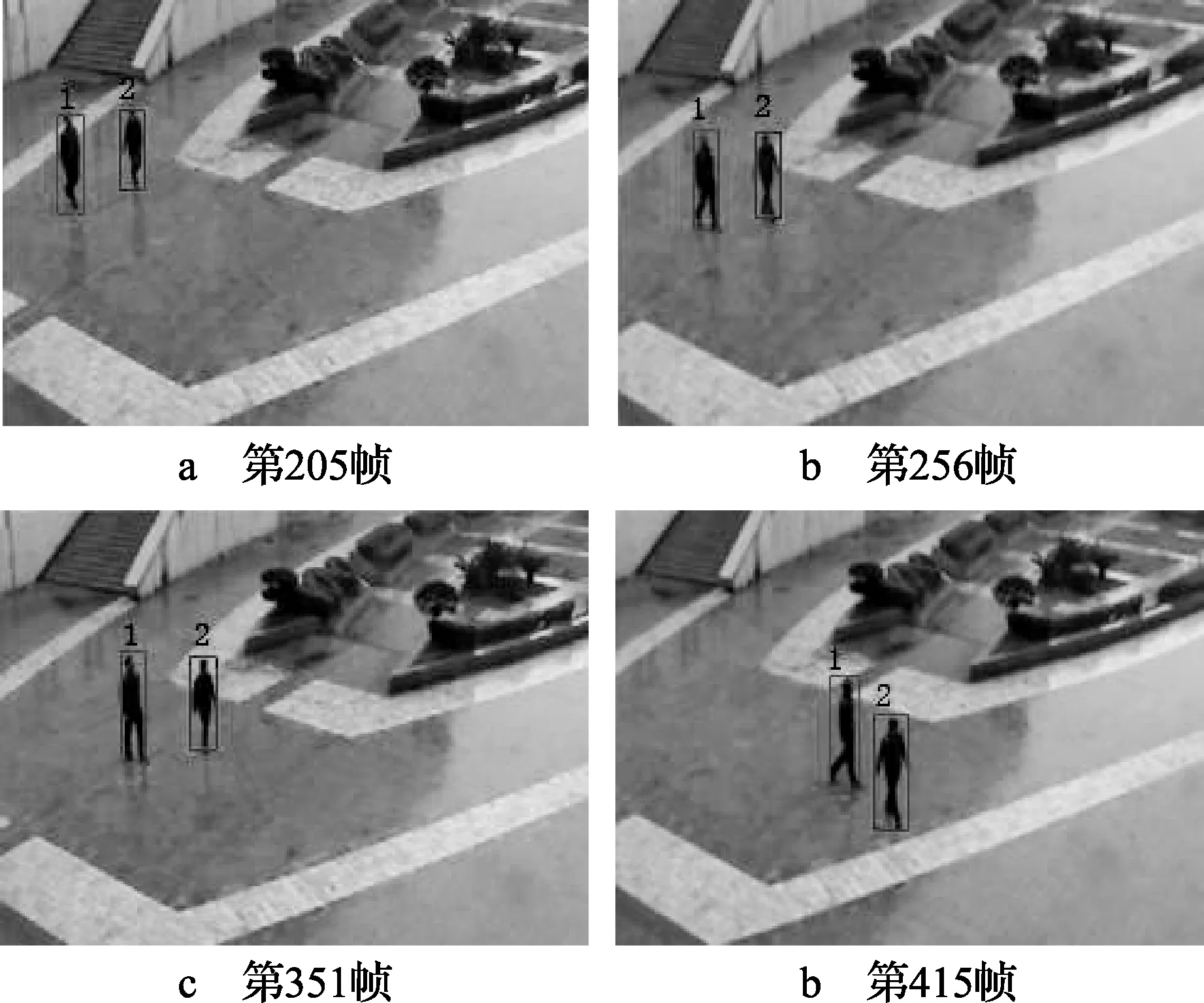

图7 camB的第205帧、256帧、351帧、415帧,用单摄像机跟踪算法对目标进行跟踪的效果图

图8 camA的第205帧、256帧、351帧、415帧,使用本文提出多摄像机通信机制对目标进行跟踪的效果图

目标跟踪的效果用矩形框和标号标识,被认为是相同的目标用同一颜色的矩形框框出,并且标号相同。由图7可以看出,在camB的视野中两个目标的运动过程没有发生遮挡,使用卡尔曼滤波的方法在单摄像机中成功进行跟踪。因此,在目标不发生遮挡的情况下,使用单摄像机跟踪算法可获得良好的效果。

在camA中,第250帧到402帧两个运动目标发生遮挡,用本文提出的根据事件判断机制对camA的目标进行跟踪的效果图如图8所示。可以看到,同一目标的标号、外接矩形框的颜色都相同。由图8c可看到本文算法可以准确地对遮挡目标进行识别,由图8d可看到当目标发生分离事件后可以继续对目标进行跟踪。

文献[9]的方法使用sift特征点进行目标匹配得到的效果图如图9所示。从图9b和图9c中看到,当目标之间发生遮挡时,2号目标特征点跟踪丢失,导致2号目标被认为消失了,跟踪失败。由图9d看到重叠目标分离时,由于历史信息的丢失,2号目标被认为是一个新的目标,外接矩形框的颜色改变并且其标号变成3,不能对目标进行持续跟踪。

图9 camA的第205帧、256帧、351帧、415帧,使用sift特征点方法对目标进行跟踪的效果图

因此,由图8和图9可以看出,使用本文的方法能成功地对发生遮挡事件和分离事件的目标进行持续跟踪。

2)遮挡情况下多目标持续跟踪实验

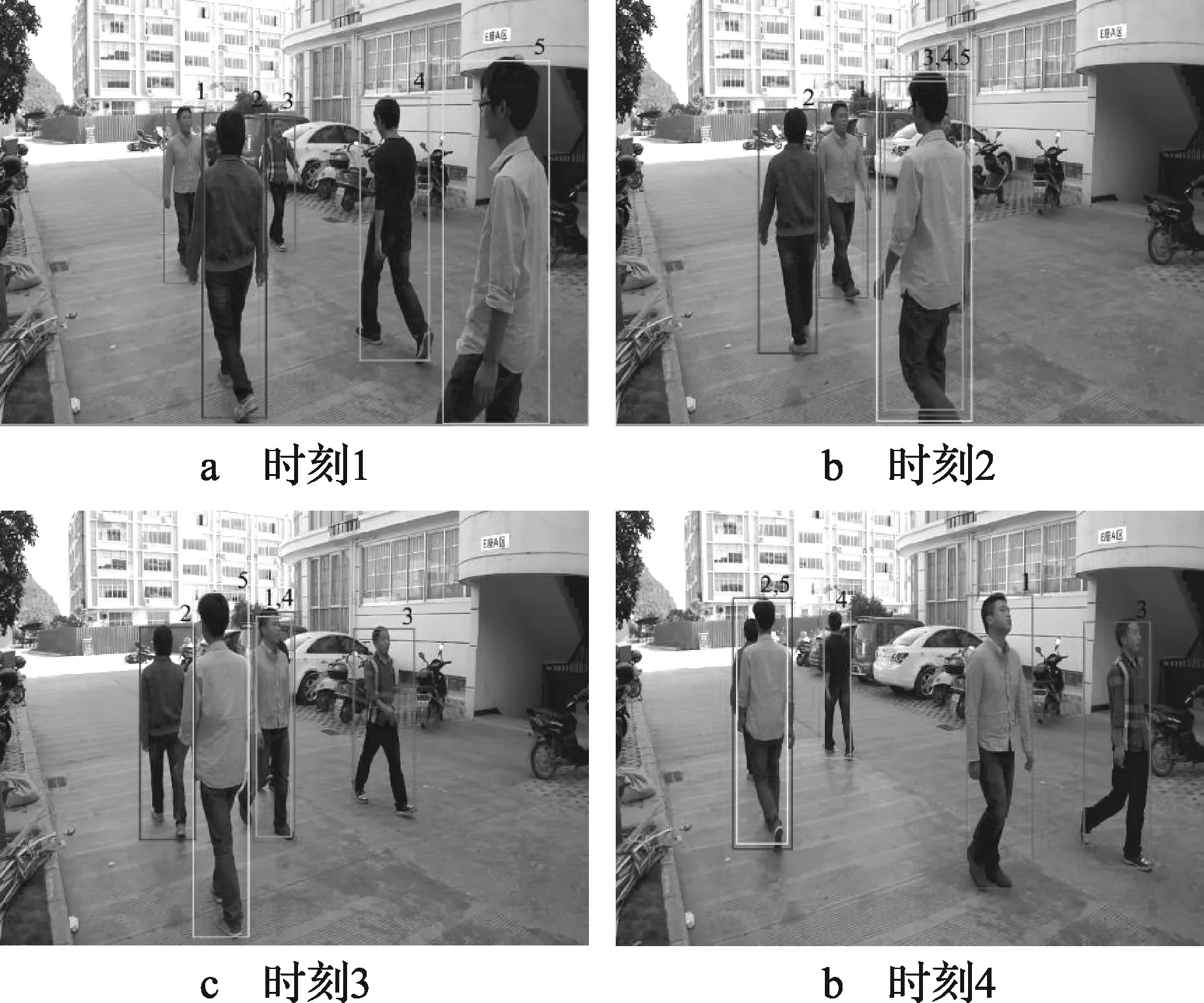

设图10~图11分别为摄像机camC、camD在同一时间段拍摄的画面,其场景比较复杂,存在着较多的运动目标,且运动目标多次发生遮挡、分离事件。使用本文算法的跟踪效果图如图10~图11所示。

图10 摄像机camC在连续的时间内拍摄的画面

图11 摄像机camD在连续的时间内拍摄的画面,分别对应图10a~图10d

图11b~图11d的时间段内,4号目标发生了两次遮挡事件,1次分离事件后,仍能准确进行跟踪;5号目标多次和不同的目标发生遮挡、分离事件后,跟踪标号不发生改变,具有较好的稳定性。因此本文在场景中具有较多运动目标,且发生多次遮挡、分离事件后,仍能准确地实现目标跟踪。

5 结论

本文算法实现对多摄像机观察到的目标信息进行交接,从而识别出对应目标,解决了目标之间发生遮挡、分离事件后跟踪丢失的难题。本文设计的实验无需考虑外观的特征,对光照变化有较强的适应性,且在多摄像机景深不一致的情况下,也能实现良好的跟踪。并且当摄像机画面中目标发生遮挡分离事件时,可以从任何没有发生遮挡、分离事件的相邻摄像机画面中获取当前摄像机发生遮挡、分离事件的目标标号,因此本文方法能从多个摄像机中获取正确的跟踪结果,具有较高的鲁棒性。在场景较复杂时,在多个摄像机可能同时发生遮挡、分离事件的情况,从相邻摄像机中获得所有目标的标号具有一定的挑战性,解决该问题可以通过实际应用场景的分析,对算法加以优化改进来解决。

[1] BRUCKNER D, PICUS C, VELIK R, et al. Hierarchical semantic processing architecture for smart sensors in surveillance networks[J]. IEEE Trans. Industrial Informatics,2012,8(2): 291-301.

[2] TAHAYNA B. Combining content and context information fusion for video classification and retrieval[C]//Proc. the 2010 2nd International Conference on Signal Processing Systems (ICSPS 2010).Seoul:IEEE Press,2010: 81-86.

[3] KIM C I. Fast stereo matching of feature links[C]// Proc. 3D Imaging, Modeling, Processing, Visualization and Transmission (3DIMPVT).Hangzhou:[s.n.],2011: 268- 274.

[4] YONEMOTO S. Multitarget tracking using mean-shift with particle filter based Initialization[C]//Proc. the 12th International Information Visualisation. London: IEEE Press,2008:521-526.

[5] MIR-NASIRI N. Camera-based 3D object tracking and following mobile robot[C]// Proc. Robotics, Automation and Mechatronics. Bangkok, Thailand: IEEE Press,2006:1-6.

[6] CHOI C. Real-time 3D model-based tracking using edge and keypoint features for robotic manipulation[C]//Proc. Robotics and Automation (ICRA). Anchorage,AK:IEEE Press,2010: 4048-4055.

[7] LI H P,FLIERL M. Sift-based improvement of depth imagery[C]//Proc. Multimedia and Expo (ICME). SPAIN:IEEE Press,2011: 1-6.

[8] ZHAO S. Sttk-based video object recognition[C]// Proc. IEEE International Conference on Image Processing ICIP. HongKong: IEEE Press,2010: 3873-3876.

[9] LIU Y H,ZHOU C S.Target matching based on multi-view tracking[C]// Proc. SPIE. San Francisco:SPIE-INT SOC Optical Engineering, 2011:24-25.

[10] HE K,YUAN Z W,MU C C. A new affine transformation parameters estimation method[C]//Proc. 2011 Seventh International Conference on Natural Computation (ICNC). Tianjin:[s.n.],2011:28-32.

[11] YAN R. Moving object detection based on an improved gaussian mixture background model[C]//Proc. ISECS International Colloquium on Computing, Communication, Control, and Management. Sanya:[s.n.], 2009:12-15.

[12] WEI B Z. Automatic color blob segmen tation and fast arbitrary shape tracking[C]//Proc. Visual Information Engineering. Xi’an:[s.n.],2008:408-413.

[13] NGUYEN T B. An Improved real-time blob detection for visual surveillance[C]// Proc. the 2009 2nd International Congress on Image and Signal Processing. Tianjin:[s.n.],2009:1-5.

[14] GUTMAN P O. Tracking targets using adaptive Kalman filtering[J]. Aerospace and Electronic Systems,1990,26(5):691-699.

蔡晓东(1971— ),硕士生导师,主研智能视频处理、云计算、无线传感网络;

吴 迪(1989— ),女,硕士生,主研智能视频处理、云计算;

华 娜(1988— ),女,硕士生,主研云计算、智能视频处理;

梁奔香(1987— ),硕士生,主研视频图像处理、模式识别;

朱利伟(1989— ),硕士生,主研视频图像处理、人工智能、机器学习。

责任编辑:闫雯雯

Robust Video Tracking Based on Event Analysis

CAI Xiaodong,WU Di, HUA Na, LIANG Benxiang, ZHU Liwei

(SchoolofInformationandCommunicationEngineering,GuilinUniversityofElectronicTechnology,GuangxiGuilin541004,China)

Reliable video tracking under occlusion is a challenging task. A novel tracking method based on event analysis and multi-camera communication is proposed. Firstly, the relationship between the overlay parts of two cameras is computed for object handoff using affine transform. Then, a new algorithm for indentifying Occlusion Event (OE) and Separation Event (SE) is designed. When multiple targets are tracked, or there are more than one tracked candidates in the case of single camera tracking, the proposed algorithm recognizes the IDs of tracked candidates by target handoff among multiple cameras, resulting successful tracking. The experimental results show the robustness of the proposed method without using any low-level features of the tracked objects during the tracking process.

target handoff; multi-camera tracking; occlusion event; separation even

【本文献信息】蔡晓东,吴 迪,华娜,等.基于事件分析的多摄像机鲁棒跟踪算法[J].电视技术,2015,39(13).

国家科技支撑计划课题(2014BAK11B02);广西自然科学基金项目(面上项目)(2013GXNSFAA019326);桂林电子科技大学研究生科研创新项目(GDYCSZ201410)

TP392.4

A

10.16280/j.videoe.2015.13.012

2014-10-22