基于多面Rasch模型的大学教师课堂教学能力评价量表优化研究

盛艳燕+喻秋山

摘要:文章利用多面Rasch模型从量表使用者角度研究了大学教师课堂教学能力评价量表的优化问题。实证研究发现,量表具有单维性,但2个题项存在性别上的不公平、7个题项存在分数能力“倒挂”现象。访谈和扎根编码分析后发现,量表内容、尺度和形式是产生分数能力“倒挂”的原因。因此,基于多面Rasch模型的假设和功能,量表优化应以多面Rasch模型检验结果为依据,采取简化题项内容、分离尺度与权重并细化评分等级的措施。

关键词:多面Rasch模型;课堂教学能力评价量表;优化

大学教师课堂教学能力评价是提高教学质量的重要手段,其活动的开展离不开课堂教学能力评价量表这个载体。①目前,大学教师课堂教学能力评价量表在教学管理中得到了广泛应用,却没有表现出管理方所期待的价值:分数能够区分教师的课堂教学能力,兼顾课程难度和评委差异。产生这种现象的原因不能仅仅归结于评委误差,课堂教学能力评价量表的设计也是其中一个重要的影响因素。如何优化量表、提高量表的应用价值成为管理方迫切需要解决的问题。

已有研究者试图通过评价指标的优化来解决大学教师课堂教学能力评价量表优化问题,其研究包括三个方面。第一,引入平衡计分卡、产出分解法确定初始指标。[1][2]第二,通过克隆巴赫系数检验量表的信度、因子分析法检验指标的构建效度,改进权重设计等方法来优化量表。[3][4][5]第三,通过评价结果的反馈、数据标准化处理和选择教学和管理经验丰富、公平、公正的评教专家等方式提高量表的应用价值。[6][7][8]

上述研究成果大多数从指标本身出发研究大学教师课堂教学能力评价量表优化问题,忽视了量表的使用者。面试理论认为,面对相同的评分标准,评委对评分标准的理解和使用往往是不一致的 [9],评委并未完全按照评分标准评分[10],不同形式的评分标准影响评分的一致性[11]。语言学研究发现,评分标准的内容、尺度和形式在一定程度上能解释评委评分差异。[12][13]在大学教师课堂教学能力评价中,Wang 和Cheng利用多面Rasch模型分析了中山大学293名学生对30名任课教师表现的评分,发现学生严苛程度、难度和教师效能之间存在线性关系,评价者对评价结果的影响是显著的。[14]因此,从量表使用者角度分析大学教师课堂教学能力评价量表的设计内容、尺度和形式对评价结果的影响,进而优化量表是非常有必要的。

多面Rasch模型为量表优化提供了可行的方法,在大学教师课堂教学能力评价中应用非常少。本文将多面Rasch模型引入大学教师课堂教学能力评价量表的优化,在已有研究成果基础上作出了三点创新:第一,研究角度创新。研究角度从量表本身转向量表的使用者,拓展了研究的角度。第二,研究对象创新。利用访谈和扎根编码技术探讨了评委评分的心理过程,分析量表内容、尺度和形式对评分的影响。第三,研究结论创新。本文基于多面Rasch模型的假设和功能提出了量表优化的方法,具有普遍适用性。

一、理论模型与研究假设

能力测评理论可以分为经典测量理论和潜在特质理论。经典测量理论假设评委评分的行为像“打分机器”一样完全相同[15],测量误差相互独立,被测心理特质可以用原始分数来表示[16]。潜在特质理论认为能力是制约人们完成某一任务的若干潜在特质,正确做答的概率是个人潜在特质水平的函数[17],评委评分是考生能力和评委特点的函数[18]。因此,做答概率、个人能力和题目难度被定义在同一尺度上,评委具有各自独特的评分行为,测量的结果使得能力独立于特定的题目和评委。

潜在特质理论更适合用来评价大学教师的课堂教学能力。在大学教师课堂教学能力评价中,评委往往依据评分标准独立评分,有的评委评分明显宽松,有的评委正好相反。如果教师担任的课程难度比较大,又遇到了评分严格的评委,分数就会明显偏低;相反,如果教师担任的课程难度比较小,评委评分比较宽松,分数就会明显偏高。因此,原始分数不足以代表教师的课堂教学能力,矫正任务难度和评委差异后的结果能更加准确地表示教师的课堂教学能力。

多面Rasch模型是一种潜在特质理论模型,可以用来实现量表的优化。首先,多面Rasch模型可以用来识别量表的构念。多面Rasch模型的假设前提是单维性,意思是指所有题项测量了同一种潜在特质。如果量表是单维的,说明所有题项从不同的方面测量了同一个构念,分数能够加总并可以相互比较。[19]如果量表不是单维的,说明至少有部分题项测量的构念与其他题项不同,需要将部分题项排除或设计量表单独测量。[20]其次,多面Rasch模型可以用来检验量表的公平性。如果相同能力的群体由于不同的群体特征导致在同一题目上具有不同的正确作答概率[21],测验就产生了不公平。多面Rasch模型提供了项目功能差异检验的方法,可以针对不同题项检验是否存在不公平。最后,多面Rasch模型可以识别评分异常的题项。多面Rasch模型将原始分数分解为能力估计值、评委宽严度、题项难度和等级难度,能够分析每个题项对应的能力估计值、每个分值对应的能力估计值,识别评分产生异常的题项,为量表优化提供依据。

基于以上分析,本文提出如下假设:多面Rasch模型适合用于大学教师课堂教学能力评价量表的优化。

二、课堂教学能力评价量表存在问题的多面Rasch分析

(一)样本与数据来源

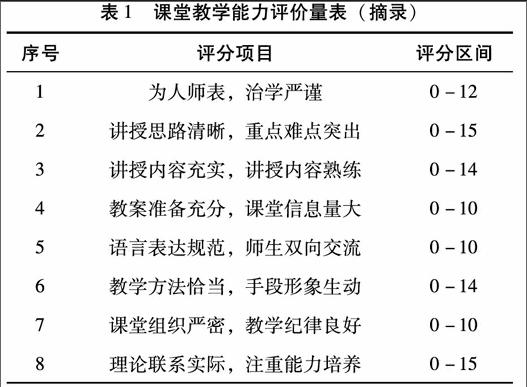

本次研究从某高校的一个学院抽取了2014年11月至12月的107份课堂教学评价表,量表内容见表1。评委共有6位,被听课的教师有23位。其中,有2位评委分别只对两位不同的教师进行了评分,因评分次数太少而被剔除,其余4位评委的评分数据被保留。在被剔除的2位评委的评分数据中,1位教师只被评分一次,而没有被其他评委评分。因此,该教师的评分表也被剔除。

按照教师编号对22位教师的课堂教学评价数据进行分类整理。评委的编号为A、B、C、D,教师的编号为1、2、3…22。18位教师分别被4位相同的评委评分,其他4位教师被若干不同的评委评分。若同一位评委对某位教师多次评分,该教师的得分用这个评委评分的均值表示。例如,编号为1的教师被编号为A的评委评分两次,编号为A的评委对该教师的评分按照两次评分的平均值计算,教师最后的分数等于多位评委评分的均值。经过整理,我们得到了4位评委对22位教师的评分数据共77个,形成本次研究的样本。

(二)研究方法与工具

本次研究采用的工具是Winsteps3.72.3软件和Facets3.71.4软件。Winsteps软件和Facets软件都是多面Rasch模型分析工具,其原理是一致的。[22]Winsteps软件能实现单维性检验和项目功能差异性检验,Facets软件则不能实现这两项功能。Facets软件能将评委、课程和被评价人作为三个单独的面进行分析,体现课程差异和评委差异,Winsteps软件则将评委、课程和被评价人作为一个面来分析。因此,多面Rasch模型分析可以同时使用Winsteps软件和Facets软件来实现多种功能。

在运用多面Rasch模型之前,首先要对数据的整体拟合程度进行检验。运用Winsteps软件进行单维性检验,运用Facets软件计算样本误差均值和标准误。如果数据满足单维性假设,并且样本误差均值接近于0、标准误接近于1,说明数据的整体拟合程度比较高,可以运用多面Rasch模型对数据进行分析。[23]其次,证明数据拟合多面Rasch模型后,我们可以利用Winsteps软件进行项目功能差异检验。本文针对性别进行项目功能差异检验,用于识别产生项目功能差异的题项。最后,利用Facets软件分析能力与分数之间的关系,用于识别产生评分异常的题项。

(三)多面Rasch模型适用性检验

单维性检验用于检验问卷题项是否测量了相同的潜在特质,这是多面Rasch模型能够应用的前提。大学教师课堂教学能力评价量表一共有8个题项,总分按照8个题项得分加总计算。如果这8个题项可以归属于同一个潜在特质,可以认为这8个题项测量从不同角度测量了同一种教师课堂教学能力,总分可以用来表示教师课堂教学能力的高低。反之,则说明至少有部分题项与其它题项测量的并不是同一种能力,需要将部分题项排除或设计量表单独测量。[24]

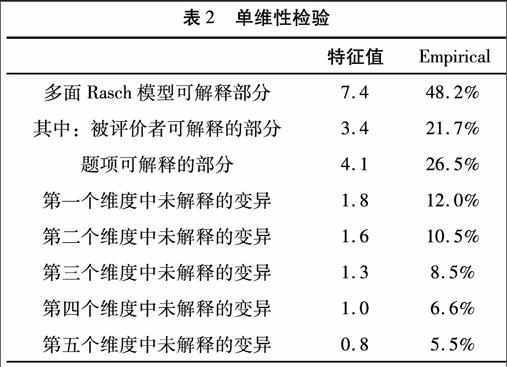

Winsteps软件提供了残差主成分分析法来检验量表的单维性,检验结果见表2。如果剔除多面Rasch模型可解释部分后,残差仍有若干共同的潜在特质并且特征值(未解释的变异)大于2,说明存在第二个维度,量表不具有单维性。五个维度中未解释变异的特征值分别为1.8、1.6、1.3、1和0.8,都没有超过2,说明量表具有单维性。[22]因此,8个题项从不同的角度测量了教师的课堂教学能力。

Facets软件检验结果显示数据对Rasch模型的拟合程度比较高,结果见表3。样本观察值21.83,模型期望值为20.14,误差均值为0。样本标准差为3.96,模型拟合值的标准差为3.64,全样本标准误为1。因此,从样本误差均值和全样本标准误来判断,采用多面Rasch模型来分析数据是适合的。

(四)课堂教学能力评价量表存在的问题

1.2个题项存在性别上的不公平

测验的公平性可以用项目功能差异检验的结果来表示。如果教师课堂教学能力评价量表在性别上存在项目功能差异,可能会对处于劣势的群体不公平,影响他们提高教学质量的积极性。因此,测验开发和使用者需要进行项目功能差异检验,识别可能产生项目功能差异的题项,以便对量表进行优化。

Winsteps软件可以实现项目功能差异检验,检验结果见表4。DIF 表示项目功能差异检验,DIF MEASURE表示某个群组答对特定题项的难度,DIF S.E表示标准误。DIF MEASURE越大,说明该群组答对该题的难度越大。DIF CONTRAST是两个群组答对特定题目的难度差异,Welch T和Prob表示难度差异的显著程度。男性组中第1个题项最难,第6个题项最容易。女性组中第5个题项最难,第8个题项最容易。第1题的DIF CONTRAST=-0.81Logits(t=-2.48,Prob=0.0155<0.05)、第4题的DIF CONTRAST=0.47Logits(t=2.12,Prob=0.0378<0.05),说明男性和女性在第1题上和第4题上难度有显著差异,可能存在因性别导致的不公平。

2.7个题项出现分数能力“倒挂”

测量学原理认为,分数代表能力,分数越高代表能力越强。多面Rasch模型假设随分数增加,能力呈“S”型曲线。[25]如果某个题项出现了较低分数代表的能力值高于较高分数代表的能力值,说明该题项出现了分数能力“倒挂”的现象。

Facets软件可以用来检验能力是否随分数增加而提高,并用*标记出现“倒挂”的题项。结果显示,除了题项1,其余的题项都出现了分数能力“倒挂”现象。题项2和8出现了3次“倒挂”,题项4、6和7出现了2次“倒挂”,题项3和5出现了1次“倒挂”。

以题项2为例进行分析,见表5。26分使用的次数最多,其次是24分和28分,28分使用了8次,22分使用了4次,25分使用了2次,20分、29分和30分只使用了2次,21分和23分没有被使用过。22分对应的能力值低于20分所对应的能力值,25分的能力均值低于24分的能力均值,30分的能力均值低于29分的能力均值。从等级间距来看,每增加一分所需能力值并不相等。通常原始分数直接比较时,我们认为一分代表相同的能力。但实际情况是,从25分增加到26分所需能力值最小,从28分增加到29分所需能力值最大。说明在不同的评分等级,一分代表了不同的能力,同时评委过多地使用了24、26和28分,对分数所代表的能力差异理解和把握不够准确。

三、课堂教学评价量表存在问题的原因分析

项目功能差异检验和识别评分异常的题项为量表优化提供了依据,但不能分析产生项目功能差异和评分异常的原因。因此,本文对评委进行了访谈,利用扎根编码技术分析产生评分异常的原因,提出了量表优化的方法。

(一)访谈提纲的设计

1.访谈提纲设计的依据

影响评委评分的因素是多方面的,评分量表对评委评分影响的研究非常少见,未发现有关大学教师课堂教学能力评价量表对评委评分影响的文献。在教学能力评价中,评委依据评分量表收集信息,并对信息进行解释、归纳、演绎并给出分数,与之接近的研究是有关面试的研究和英语作文评分的研究。因此,本文以面试和英语作文评分的研究成果为依据来设计访谈提纲。

评分量表对评委评分影响的研究主要分为三类。第一类是评分量表内容对评委评分影响的研究。有关面试的研究表明,测评要素越多,每个测评要素内部包含的属性越多,量表的使用效果越差。[26][27]第二类是评分量表尺度对评委评分的影响。英语作文评分的研究发现,小尺度评分量表的评分一致性要高于大尺度评分量表的一致性。[28]第三类是评分量表形式对评委评分影响的研究。面试研究发现,为每个评分等级提供典型行为描述,尽量通过媒介促使行为可视化能够提高评委评分的一致性程度和评价的准确性。[29][30]由此可以假设,教学能力评价量表题项太多、每个题项包括了不同的测量内容,每个题项分值过大、评分等级描述不够清晰会影响评委对量表的理解和把握程度。

2.访谈对象与访谈提纲内容

访谈提纲的内容围绕量表的内容、尺度和形式展开,要求评委讲述他们在评分过程中是如何使用量表的。评委以一门课程为例,先对照评分表记录表的课堂内容对该教师的教学能力作出整体评价,再对量表合理与不合理的地方进行评价,最后对每个题项给出评分的理由。

研究者需要了解三个方面的问题。在评分量表内容方面,包括您觉得8个题项多不多?您觉得这8个题项意思表达是否明确,是否会干扰您的评分?有什么可以改进的地方?在评分尺度方面,访谈的问题有:您觉得哪些题项分值设置是合理的,哪些是不合理的,原因是什么?在评分量表形式方面,访谈的问题有:您在这个题项给了××分,为什么不多给几分,或少给几分呢?您觉得将该题项划分成几个分数段,您是否会使用这些分数段去区分不同教师的能力?

访谈的对象是4位曾经担任过课堂教学评价的老师,包括前面提供评分数据的4位评委中的2位。如果能对4位评委进行访谈,研究结果更为可靠。由于条件的限制,无法对4位评委进行访谈,只能选择具有多年教学评价经验的教师进行类比,这也是在缺乏数据的情况下不得不采取的办法。

(二)访谈内容整理与编码

本次研究采取开放式访谈和研究者提问相结合的方式。评委先围绕量表的合理性作出评价,然后对每个题项给出评分理由,对于评分量表内容、尺度和形式方面没有涉及的问题由研究者提问作为补充。

编码采用扎根编码技术。评分量表内容编码为a1,a2…,其影响编码为a1-1,a2-2…,依次类推。量表尺度编码为b1,b2…,其影响编码为b1-1,b2-2等。量表形式编码为c1,c2…,其影响编码为c1-1,c2-2等。

经过整理后,部分访谈内容和编码摘录如下。

我在听别人上课时,先在量表上记录板书提纲。课程快结束时,我会在心理形成一个整体判断。我给分一般在82分到92分之间。(c1)我觉得分给太少了不好意思,都是同事。分也不能太高,92分已经很高了,再高的话有点不切实际。我一般分为三个档次,最好的90-92分,其次是85-89分,最后是82-84分。(c1)我在心理给他定位后,再分题项给分,保证他所得的分数在我给他划定的档次之内。(c2)我觉得表现好的就在该档次内给一个高点的分数。(c1-1,c2-2)每个题项的给分也基本按照这个思路。没有人告诉我每个题项什么样子可以给15分,什么样子可以给12分,我只能根据我的经验判断。(c3)如果我对该课程很熟悉,我觉得判断还比较准确。如果我对该课程不熟悉,我只能看学生的表现和老师讲课的熟练程度、逻辑性,也是外行看热闹吧。(c3-3)我觉得题项2“思路清晰,重难点突出”是最重要的,也是最不好把握的。(a1)如果这方面表现比较好,我认为其他方面也不会太差。(c3)这个题项只有15分,和其他题项分数差异不大,没有突出其重要地位,这显然是不合适的。(b1)他在这一项上得分不高,但考虑到很重要,就多给了几分。(b1-1)很多题项表达都不是太合理,例如治学严谨,究竟是指“思路清晰”、“教案准备充分”还是“课堂纪律良好”、“课堂教学充实”和“信息量大”,实际上是同一个问题,却分属题项3和4。(a2)题项3中还有“讲授内容熟练”,那我就不知道题项3和题项4究竟按照哪个标准评分了。(a2-2)同样的问题也出现在题项5和题项7,题项5究竟是要对老师的语言表达能力进行评价,还是对教学方法进行评价(a3),我只能选择我认为重要的那个。(a1-1,a3-3)8个题项并不多,关键是题项之间的关系不明确,量表不方便评委使用。

访谈编码结束后,对访谈编码进行汇总。将访谈者提到的内容按量表内容、量表尺度和量表形式归类,找出原因和结果的对应关系,见表6。

(三)量表对评分的影响分析

1.量表内容对评委评分的影响

题项的测量内容和性质影响评委评分。如果一个题项同时包含两个测量内容,评委既可能选择他

认为重要的测量内容(a2-2),也可能随意选择一个测量内容(a1-1),导致多个评委评价的对象是不一致的,甚至同一个评委对不同的教师选择了不同的测量内容进行评价。如果测量的内容本身不好把握(a1),评委对课程不熟悉、缺乏可参考的依据(c3),可能评委就选择他认为重要的测量内容对教师的整体表现进行评分,而不会按题项的测量内容给分。题项2和题项8出现分数能力“倒挂”现象的次数最多,题项3和5出现 “倒挂”次数最少,可能与该题项测量内容容易观察有关。

2.量表尺度对评委评分的影响

评委给出的评分不仅仅体现了教师的能力,还受到题项重要性程度的影响。一般情况下,题项越重要,题项分值越高。如果评委认为某教师在一个题项上的表现非常好,足够给最高分,而该题项只有10分,那么评委也只能给10分。如果某教师在另外一个题项上表现一般,该题项最高分是15分,评委可能给出了12分,这个分数不仅仅是教师的能力,还包括了评委对该题项重要性程度的认可,结果是评委附加了新的评分标准(b1-1)。特别是评委认为重要的题项,分值比较低时,评委可能给表现不够好的教师高于评委心理预期的分数(b1),而非常好的教师分数也得不到较高的分数,分数区分度不够。题项6和8的分值为15分,是所有题项中分值最高的,也是分数能力“倒挂”次数最多的。

3.量表形式对评委评分的影响

量表只给出了各个题项的内容和尺度,未设置评分等级导致评委评分缺乏依据。评委有一个“心理量尺”(c1),评委用“心理量尺”给题项评分(c2),具体给出什么分数可能受到其他因素的影响(c1-1,c2-2),例如“人情”、“出场顺序”等。由于记忆容量有限和背景差异,评委可能根据他认为重要的题项来确定心理量尺(a1-1,a3-3),评委的“心理量尺”可能存在差异,评委之间缺乏统一的评分依据。加上外界因素的影响,同一个评委对不同的教师可能使用了不同的“心理量尺”,每个分数应对的能力实际上是不同的,就可能出现分数能力“倒挂”现象。

四、课堂教学能力评价量表优化的建议

(一)利用多面Rasch模型对量表进行检验

1.构念效度检验

根据单维性来判断量表的构念效度。如果检验结果显示量表具有单维性,说明量表的题项可以用于教学能力评价。如果检验结果显示量表不具有单维,说明量表中有部分题项不能用于教学能力评价,需要把部分题项剔除或将这些题项单独测量。本次研究的量表具有单维性,现有题项可以保留。

2.性别功能差异检验

性别功能差异检验用于检验量表的公平性。如果量表具有性别功能差异,我们需要分析产生性别功能差异的原因。如果是男性和女性本身能力差异造成的,我们需要设置不同的评分标准。如果是群体特征差异造成的,我们需要剔除产生性别功能差异的题项或设置不同的题项。在本次研究的量表中,题项1和4具有性别功能差异,需要进一步分析产生性别功能差异的原因,本次研究没有涉及到这个内容。

3.评分异常检验

评分异常的表现形式之一是分数能力“倒挂”。本次研究显示,部分题项出现了分数能力“倒挂”,需要从量表的内容、尺度和形式三个方面分析产生这种现象的原因。

(二)课堂教学能力评价量表优化的具体措施

1.简化每个题项的测量内容

研究结果显示,每个题项包括多个测量内容,题项之间测量内容交叉可能导致分数能力“倒挂”现象出现。因此,简化每个题项的测量内容,尽量保证一个题项只有一个测量内容,按测量内容的属性归类排列,便于评委明确评价对象,提高量表的使用效果。

2.分离尺度与权重

当题项的尺度包括权重在内时,评委的评分同时考虑了权重和能力。研究结果显示,如果评委不认同量表的尺度时,评委就会各自在内心重新设置尺度,评分时综合考虑“内心重新设置的尺度”与能力,分数与能力的偏离会更大。因此,分离尺度和权重是必要的。可以仿照体育评分的办法,每个题项的尺度都是相同的,但权重另外设置。例如所有题项都设置为10分,评委只在0-10范围内评分,每个题目的分值按照权重和尺度加权计算。

3.细化评分等级

研究结果显示,评委评分有自己的“心理量尺”,并未严格按照量表进行评分。由于评委之间的“心理量尺”存在差异和外界因素的影响,评委的“心理量尺”失去了可比性。因此,细化评分等级,为评委评分提供相互比较的依据,有利于减少分数能力“倒挂”现象。对于容易观察的测量内容,可以对每个评分等级进行关键行为描述。对于不容易观察的测量内容,可以对每个评分等级进行总体描述。在此基础上,管理方可以分类选择一些课程建立可视化的模拟培训库[26],加强对评委的培训和反馈。

注释:

①本文的量表均指大学教师课堂教学能力评价量表,教师均指大学教师。

参考文献:

[1]李长青.构建平衡计分卡理论的高校教学质量评价指标体系[J].高教探索,2014(6):137-141.

[2]吕少柳,刘晓.基于行动导向教学观的课堂教学质量[J].学理论,2010(31):242-243.

[3]钱存阳,李丹青,潘 岚.课堂教学质量评价中的效度和信度分析[J].中国计量学院学报,2004(2):164-167.

[4]丁家玲,叶金华.层次分析法和模糊综合评判在教师课堂教学质量评价中的应用[J].武汉大学学报(社会科学版),2003(3):241-245.

[5]刘伟,孙林.基于支持向量机的课堂教学质量评价[J].合肥工业大学学报(自然科学版),2010(7):968-971.

[6]纪红.课堂教学质量评价的误区与对策[J].中州大学学报,2004(7):87-89.

[7]张克非.课堂教学质量评价数据客观性处理及反馈机制探究[J].教学与管理,2014(3):44-47.

[8]毕菁华.建立课堂教学质量评价体系的实践性探索[J].北京大学学报(哲学社会科学版),2007(5):295-297.

[9]Posthuma R A,Morgeson Frederick P,Campion M A.Beyond Employment Interview Validity:A Comprehensive Narrative Review of Recent Research and Trends [J].Personnel Psychology,2002(55):1-82.

[10][30]Uggerslev K L,Sulsky L M.Using Frame of Reference Training to Understand the Implications Rater Idiosyncrasy for Rating Accuracy [J].Journal of Applied Psychology,2008,93(3):711-719.

[11]Melchiers K G,Lienhardt N. Is More Structure Reality Better? A Comparison of Frame of Reference Training and Descriptively Anchored Rating Scales to Improve Interviewers Rating Quality [J].Personnel Psychology,2011(64):53-87.

[12][28]关丹丹.两种评分量表的评分效应比较研究[J].教育研究与实验,2011(4):92-96.

[13]李航.评分员与评分量表间的交互作用对EFL作文评分结果与过程的影响[D].杭州:浙江大学,2012.

[14]Wang WC,Cheng Y Y.Measurement Issues in Screening Outstanding Teachers [J].Journal of Applied Measurement,2001(2):171-186.

[15] [23][25]Linacre J M.A Users Guide to Facets Rasch-Model Computer Programs[M].Chicago,2014:279,185,204.

[16]漆书青,张厚粲.现代教育与心理测量学原理[M].北京:高等教育出版社,1998:33.

[17]L·赫林,F·德雷斯哥,K·帕森斯.项目反应理论在心理测量中的应用[M].东北师范大学教育咨询中心,译.武汉:湖北教育出版社,1990:15.

[18]Cason G J,Cason C L.A Deterministic Theory of Clinical Performance Rating[J].Evaluation and the Health Professions,1984(7):221-247.

[19]Wu M,Adams R.Applying the Rasch Model to Psycho-social Measurement:A Practical Approach[M].Melbourne,2007:21-23.

[20][24]王文中.Rasch测量理论与其在教育和心理之应用[J].教育与心理研究,2004(4):637-694.

[21]Holland P,Thayer D.Differential Item Performance and the Mantel-Haenszel procedure[C]//Paper Presented at the American Educational Research Association Annual Meeting.Francisco,1986.

[22]Linacre J M.A Users Guide to Winsteps Rasch-Model Computer Programs[M].Chicago,2011: 601-602.

[26]Sanchez J I,DeLa T P.A Second Look at the Relationship Between Rating and Behavioral Accuracy in Performance Appraisal [J]. Journal of Applied Psychology,1996,81(1):3-10.

[27]陈社育.国家公务员录用面试的效度研究[J].甘肃社会科学,2002(2):40-44.

[29]Powell D M,Goffin R D.Assessing Personality in the Employment Interview:the Impact of Training on Rater Accuracy[J].Human Performance,2009(22):450-465.