三维面部表情识别技术的研究进展

三维面部表情识别技术的研究进展

魏永超1,,庄夏2**,傅强2,杜冬1

(1.中国民用航空飞行学院 飞行技术与飞行安全科研基地,四川 广汉 618307;

2.中国民用航空飞行学院 科研处,四川 广汉 618307)

摘要:三维采集设备的快速发展,极大推动了三维数据技术的研究。其中,以三维人脸数据为载体的三维面部表情识别研究成果不断涌现。三维面部表情识别可以极大克服二维识别中的姿态和光照变化等方面问题。对三维表情识别技术进行了系统概括,尤其针对三维表情的关键技术,即对表情特征提取、表情编码分类及表情数据库进行了总结分析,并提出了三维表情识别的研究建议。三维面部表情识别技术在识别率上基本满足要求,但实时性上需要进一步优化。相关内容对该领域的研究具有指导意义。

关键词:表情识别;三维人脸;表情特征;表情编码;表情数据库;研究进展

1引言

目前,人脸表情识别基本上以二维图像为主,识别率容易受到光照、姿态等环境因素的影响。人脸是一个三维几何体,二维图像丢失了一些重要的信息,因而无法精确地反映出面部表情特征。三维面部表情识别以人脸表情的三维数据为载体,最大程度地利用面部几何特征,因此具有更好的鲁棒性和更高的识别率。尤其是近年来,三维成像技术的发展极大地促进了三维人脸表情识别技术的发展。

三维表情识别的过程和二维表情识别类似,分为人脸的预处理、表情特征提取和表情分类三大部分[1-3]。人脸的预处理是人脸区域分割与点云数据的曲面化处理;表情特征提取通过特征点的几何特性表示人脸表情;表情分类通过分类方法,对表情特征进行分类、判决,给出表情结果。

三维表情识别是前沿性研究领域,目前国内还没有关于三维表情识别的综述性文章,国外只有一篇相关的文献[4],且只是对三维表情识别的系统介绍,没有进行深入全面分析。本文综合分析了三维表情识别研究的发展现状。表情特征提取是表情识别的重要核心步骤,而表情编码和表情数据库是表情识别的重要基础,因此,本文重点对人脸表情的特征提取算法,尤其针对近几年研究的热点——动态三维表情特征提取进行了详细总结,同时对表情编码和表情数据库进行较为全面总结,最后,对三维表情识别研究存在问题和发展趋势进行了分析。

2人脸预处理

在实时三维表情识别中,获取的是三维人脸的点云数据,通常数据是不规则的,数据间存在不一致性等问题,需要对人脸点云数据进行预处理,从而为后续的表情建模提供基础。人脸点云数据的处理分为噪声去除、视角对齐、数据精简、数据滤波、数据分割、姿态矫正、曲面重建等步骤,经过处理后,就可以得到实时较为完整的三维人脸数据。三维人脸点云数据的处理和通用的点云处理算法一致,有不少描述点云处理的文献,由于本文重点关注三维表情识别中的差异性,因此这里不再赘述。

3三维表情特征提取

根据三维表情识别的是基于单个三维人脸还是三维人脸数据序列,分为静态三维识别和动态三维识别。

3.1静态三维表情特征提取

3.1.1基于几何的特征

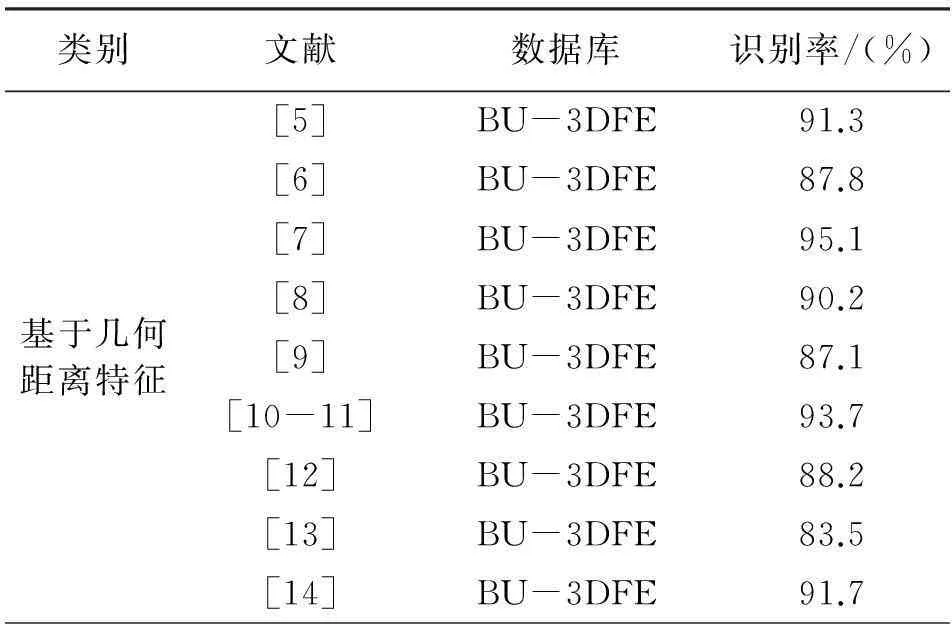

距离是常用的静态三维人脸几何特征,它可以反映脸部标记点间形变。在BU-3DFE人脸表情数据库中,每个人脸网格数据有83个特征点,这些特征点及距离常用来进行静态脸部表情分析。文献[5]利用数据库给定的其中11个特征点,计算出6个特征距离。文献[6]中的多个距离分别对应眼睛张开方式、眉毛高度以及嘴部位置的特征描述。文献[7]通过脸部动画参数单元、特征点之间的距离进行归一化,并用折线连接特征点,通过法线分割产生单元矢量作为额外特征集。文献[8]采用脸部特殊移动位置的6个距离,加上眼睛和嘴巴形状相关的坡线角度作为特征。文献[9]计算出特征点的多种距离为特征。文献[10-12]利用所有特征点对之间的距离为特征。文献[13]以所有特征点的距离为特征,并对每个点的表面曲率进行分类,人脸被分割成不同特征点三角形子集,并进一步生成直方图。文献[14]运用残余量,计算每个点的位移大小和方向为特征,通过组合3个空间方向的矩阵,形成一个二维特征矩阵。

块特征是另外一种几何特征,常用于获取脸部每个点、标志点或者特征点周围小块区域的信息[15]。文献[16]通过一组多项式函数对每个点进行局部曲面拟合,并利用函数参数计算出曲率来表征块特征。文献[17-18]通过标志点周围曲线定义块特征,曲线表示块的层次,并通过均方根速度函数(Square-Root Velocity Function,SRVF)的值来描述曲线形状,函数值用来计算曲线变形,从而得到几何距离,对每个块的曲线几何距离求和就可以得到块之间的距离。文献[19]通过形状、强度和深度值3个变量的线性组合来构建统计面部特征模型(Statistical Facial Feature Model,SFAM),从而拟合面部标记点局部块特征,通过尝试ICP(Iterative Closest Point)对齐,比较6个典型的面部表情等效区域,计算得到块距离后用作特征之间的分类。

基于几何的特征提取方法以特征点的距离为主要的特征,通过直接以距离或者距离的变换进行三维表情描述,因此算法对特征点的依赖程度较高,特征点的提取结果会一定程度影响识别率。该方法总体来说是从微观角度描述人脸表情信息,可以反应表情的一些细节,但无法宏观描述人脸面部表情。

3.1.2基于模型的特征

形变模型是特征提取的方法之一,可以对身份、表情或两种变量同时建模。文献[20]中,通过减少点之间的能量函数值,确认表情人脸之间的匹配点。通过提取表情的平均人脸主成分以及特征表情加权求和重建新人脸,建立MEM(Morphable Expression Model)模型。SFAM属于形变模型的一种[21],通过模型拟合参数,提取网格特征。运用强度和深度值,同时从向量中减去形状参数的均值得到位移特征集,通过以上参数计算形状指数,并通过多尺度局部二进制模式(Local Binary Patterns,LBPs)进行编码。文献[22]同样采用SFAM提取特征,从SFAM中自动或者人工提取标记点和特征,特征包括标记点坐标以及标记点周围网格的形态、纹理和深度参数,LBP对纹理和深度参数进行编码。文献[23]采用弹性变形双线性3D模型提取特征,该模型对模型和点云中标记点都进行拟合,通过最小化能量函数优化,创建点之间的细分曲面。文献[24-25]通过区分能量函数,设置为零,然后再执行奇异值分解求解获取的线性方程组,得到最优参数。

模型特征提取方法是人脸表情的宏观描述,从整体角度对面部表情进行特征提取,因此算法会损伤表情的细节特征,无法识别细微表情变化。算法对特征点的依赖程度较低。

3.1.3基于二维映射的特征

另外一种三维图像序列的特征提取方法是通过映射三维数据到二维空间表征。在三维特征提取之前,该表征可以同样用于配准和网格区域分割。文献[27]用三维网格的深度图和点z值做二维表征,用尺度不变特征变换(Scale-Invariant Feature Transform,SIFT)算法进行特征提取。同样,在文献[28]中,深度图经过进一步处理,实现图像直方图的均衡化。文献[29]进一步采用Zernike矩实现特征分类。文献[30]用微分几何特征转化三维人脸到二维空间表征,然后通过传统的二维运动单元检测算法对二维表征进行分析。文献[31]采用类似的方法,通过分析如几何、法线和局部曲率等特征,获取表情图,用于特征分类。通过文献[32]中的方法,LSCM(Least Squares Conformal Mapping)可以变换三维数据特征到二维图像[32-33]。该方法通过等角参数化方法实现三维形状的二维图像描述,之后通过二维弹性形变估计图像和参考图像间的差异,并利用自适应网格技术完成轮廓平滑及人脸点密度均衡,而这些自适应网格可以最终估计非刚性配准造成的形变误差。文献[34]利用共形映射转换三维网格到二维平面网格,并找到对应关系,根据十二基元,对映射网格上的面部表面特征进行标记,形成面部表情标签图(Facial Expression Label Map,FELM),并通过拟合局部表面和使用Hessian矩阵特征,估计表面主曲率和方向。

基于二维映射的特征提取方法通过降维的方式,投影三维特征到二维区域,利用成熟的二维识别算法完成识别。算法的效率较高,可以用于实时识别。但算法对于特征投影方式较为敏感,如何挑选出反映面部表情的特征并进行投影,是算法需要解决的根本。

3.1.4多信息融合特征

二维信息和三维信息融合的特征提取方法是目前研究的热点之一,它充分利用两者的优势,是自动化实时识别的一个解决方案。

文献[3]提出三维局部曲率和二维局部角点双模态识别方法。文献[35]结合二维纹理、三维表面和三维曲率进行特征提取,上述特征通过曲面拟合的三次函数系数以及计算矩不变量的标志点周围的Gabor小波系数构建。文献[36]通过二维和三维小波变换,提取三维人脸数据的多尺度特征,并用于分类。文献[37] 评估了三维、二维以及三维结合二维的方式对运动单元识别方法。文献[38] 使用纹理图像和三维数据结合的方式自动提取特征点,纹理图像被分割为6个区域,并在分割的纹理图像的6个区域中轮廓线,通过补偿点云位置得到一个矩阵,之后用特定表情的矩阵减去无表情矩阵形成动态矩阵,再使用PCA(Principal Component Analysis)的投影系数得到表情模板。文献[1]提出了利用多源图像数据(包括三维深度图像和二维彩色图像)进行表情识别的算法,首先将人脸三维图像转化为用灰度表示的深度图像,通过对人脸深度图像的分析,提取出进行表情识别所需要的特征点,最后通过对特征点的综合分析,对待识别人脸的表情作出判断。

多信息融合方式识别是目前表情识别研究的一个热点,多信息融合特征提取识别可以很大程度提高算法的识别率,但目前研究只进行了简单的线性叠加,因此,识别率较低。如何快速提取多信息并进行融合是算法的核心问题。

3.2动态三维表情特征提取

相比利用单个或者多个静态图像的三维表情识别,基于三维图像序列的面部表情动态分析还处于起始阶段。

3.2.1基于常规三维表情数据库

文献[39]通过跟踪特征点,捕捉表情的三维网格变形,尽管创建了一个三维表情识别数据集,但没有相关测试结果的报道。最早采用三维运动特征进行人脸表情分析工作之一是文献[40],可变形模型用于跟踪帧与帧之间的变化,并计算运动矢量,通过为每一个表情提取的三维人脸表情标签图,对所获得的运动矢量进行分类。文献[41-43]中的ASM(Active Shape Model)跟踪技术可以跟踪人脸标志点的运动,在考虑标志点代表的不同多边形形状的测量变化情况下,提取的信息用于确定对应特定运动单元的不同脸部变形。文献[44]基于运动的方法中,通过在减去主体对应中性状态的矩阵之前,把三维人脸网格映射到一个统一的三维矩阵中,生成一个流量矩阵,显示时间演变带来的表情运动。采用傅里叶变换对该矩阵进行变换,所得到的谱矩阵行连接起来以形成一个表示表情的特征向量。

3.2.2基于动态三维表情数据库

文献[45]是最早利用BU-4DFE数据库进行面部表情动力学分析的报道之一,它采用文献[40]中的形变模型,对每一帧图像建模,并跟踪模型变化以提取几何特征。文献[46]中,在配准和裁剪后,通过提取每一帧不同层次人脸特定高度点得到面部水平曲线,通过比较帧间曲线的chamfer距离,进一步提取特征,利用弧形参数化函数分区后,chamfer距离进一步对曲线进行分割,相邻3帧图像的特征用于提取时间信息。文献[47-48]中FFDs(free-form deformations)方法通过控制点的一个变形晶格的B样条插值,对帧间运动进行建模,在每个表情的开始和结束段,对包含最高运动集中的图像序列,通过向量投影法建立空间和时间区域,轴分割图像成不同大小区域,使最小区域包含最多运动,同样向量投影法对轴进行四叉树分解。对上述区域进行特征提取,包括运动量测量、向量场的散度和旋度以及运动方向。

文献[49]提出了4D表情识别方法,利用时间维度上3D网格数据的融合和配准,从而提取脸部特征。首先计算Harris角点的旋转图像、MeshDOG检测的关键点位置的MeshHOG描述符,通过RANSAC(Random sample consensus)轮廓压缩,建立数据序列描述符见的匹配;再通过三维形变脸部模型拟合数据序列,最后利用局部二进制模式(LBP)计算模型的3个正交平面。文献[50]对算法进行了扩展,使其适用于静态和动态三维表情识别。然而,由于需要对三维数据序列进行融合和配准,因此算法不适用于在线识别。同时,算法是半自动识别,需要人工标注12个标记点。

文献[51]提出的运动面部特征提取方法可以用于三维动态表情识别。算法原理是基于黎曼面部形状分析技术,以第一帧为参考帧,通过比对鼻尖径向曲线,建立随后5帧与参考帧间的变形矢量场,并进一步取其平均值作为特征矢量,通过LDA(Linear Discriminant Analysis)和多级随机森林算法对表情特征矢量进行分类识别。该算法需要帧间数据精确比对,计算量较大,且中性表情的平均特征矢量会影响表情的准确分类。

文献[52]提出了自动实时动态三维表情识别算法。算法首先自动选择特征点,并通过计算特征点间距离和特征点的三维形状纹理局部信息,对脸部进行描述,最后通过HMM(Hidden Markov Models)对特征进行分类。

文献[53]提出自动4D表情识别算法。采用自动标注特征点,提取了人脸面部各个运动单元在深度信息和法方向信息在各个阈值范围内当表情发生变化时的变化特征,在表情判定过程中,建立6种基本表情的表情动态编码特征向量,并使用近邻法对输入表情进行表情判定。

从上面分析看出,现有的动态三维表情识别算法是半自动或者自动的,且一些算法采用2D数据。半自动算法依赖人工标注的标记点,进行帧间配准和脸部关键区域提取。自动算法采用较少的特征点进行配准和融合,或者应用弹性形变进行配准和计算矢量场。然而,无论自动或者半自动算法,计算量都很大,对于实时和在线处理都是不适合的。

表1为相关算法在各自文献中的实验结果。

表1 三维表情识别算法一览表

续表1

4表情特征分类

三维面部表情分析的特征分类和二维的类似。在三维面部表情识别系统中有许多分类技术,这些方法包括LDA和线性分类器、最近邻分类、聚类算法和最大似然分类。基于规则的分类器广泛用于二维情况,也已经被用于三维人脸表情分析。通过蚁群和粒子粒子群优化(Ant Colony and Particle Swarm Optimizations,ACO和PCO),可以进行规则分类。支持向量机(Support Vector Machines,SVM)包括多类支持向量机也是主要的分类方法之一。选择不同的弱分类器是另一种已被广泛应用的技术,如线性回归和LDA、基于Adaboost的分类方法。GentleBoost分类、贝叶斯分类器也是广泛使用的方法。神经网络分类器构成另一流行的方法。概率神经网络和流形学习也可以应用于三维特征分类的问题。

5面部表情分类与编码

5.1常规表情分类

许多研究者曾对情绪进行过分类,汤姆金列出了8种基本情绪:兴趣、快乐、惊奇、痛苦、恐惧、愤怒、羞怯、轻蔑。伊扎德在此基础上又增加了厌恶和内疚两种情绪。许多研究者都在实验中使用了7种表情,就是应用了这6种基本的特定情感表情加上平静共7种表情作为待识别的表情类别。根据心理学的定义[54],表情被分为6个基本的大类:高兴、悲伤、愤怒、惊讶、厌恶和恐惧。六大表情时脸部的主要表现如下:

(1)“愤怒”时主要表现为两眼眉皱起,嘴抿紧,眼睛瞪着或鼓起,鼻孔可能张大;

(2)“厌恶”的主要表现是上嘴唇上抬,导致鼻子皱起、脸颊上抬、下眼睑上扬,此外眼眉可能会出现形变;

(3)“恐惧”最显著特征为嘴角向后拉伸,眉毛抬起并皱在一起,上眼皮抬起,下眼皮被拉上来;

(4)“高兴”表情出现时,脸部形变主要集中于下半脸,最显著的特征是两个嘴角向上运动,此外由于嘴部的运动可能导致脸颊形变和下眼睑形变;

(5)“悲伤”主要表现在眼眉和嘴部:眼眉内侧会向上抬起,眼眉中部也会向上抬起,但是运动幅度明显小于眼眉内侧,两眼眉构成八字形,而两个嘴角向下拉伸,此外上眼睑由于眼眉的运动可能会产生形变;

(6)“惊讶”的显著特征最多分散最广,表现在眼眉整体显著上移,眼睛张大,上眼睑上移和下眼睑下移,下颌下移嘴张大。

5.2面部运动编码系统

自20世纪20年代早期开始,研究者们都试图测量面部表情和开发一个参数化的系统,但没有达成任何共识。为了解决这些问题,Ekman和Friesen开发了全面FACS系统[55],并已成为事实上的标准。

FACS(Facial Action Coding System)面部动作编码是一种基于肌肉的方法,它包括确定各类的面部肌肉,它们单独或成组引起面部行为的改变。这些在脸上变化和底层肌肉(一个或多个)引起的变化被称为行动单位(Action Unit,AU),FACS由许多这类行动单位组成,这些单元与使面部表情改变的肌肉结构紧密相连,每一个 AU 对应一个特定的动作。

面部表情用44个AU来描述,然而不同的 AU 组合的数目却是巨大的,超过了7000 种,许多很难用2D图像识别进行检测。FACS 详细分析了这些 AU 的运动特征及其所控制的主要区域以及与之相关的表情,并给出了大量的照片说明。

目前,FACS 几乎已经成为描述人面部行为的基础,它不包含任何与情感相关的描述,只是对人面部的各种可视的动作和特征进行编码,已经被自动化表情识别领域的研究人员广泛接纳。根据六大表情的表现,6种基本表情和 AU 组合之间的联系如下:

(1)“愤怒”时AU组合为4+7+17+23+24;

(2)“厌恶”的AU组合为9+10+17;

(3)“恐惧”的AU组合为1+2+4+5+20+25;

(4)“高兴”的AU组合为6+12;

(5)“悲伤”的AU组合为1+4+15+17;

(6)“惊讶”的AU组合为1+2+5+26+27。

其他编码方案有面部动作评分技术(Facial Action Scoring Technique,FAST)、 情绪面部动作编码系统(Emotional Facial Action Coding System,EMFACS)、 最大限度地判别面部动作编码系统(Maximally Discriminative Facial Movement Coding System,MAX)、面肌肌电图(Facial Electromyography,EMG)、整体判断的影响表情(Affect Expressions by Holistic Judgment,AFFEX)、一元阶段(Mondic Phases)和婴儿/婴儿FACS,详细介绍可以参考文献[56-57]。

6三维表情数据库

目前国际上已有多个大规模的二维人脸表情数据库,这些数据库为二维人脸表情识别算法提供了评测和性能比较的公共平台。2004 年之前,很少有公开的三维人脸表情数据库。近年来,越来越多的研究组织开始建立自己的三维人脸数据库。公开的三维人脸数据库为三维人脸识别领域提供了实验的依据。下面列出部分有代表性的三维数据库。

6.1BU-3DFE和BU-4DFE

BU-3DFE数据库是首次收集用于表情识别的三维面部数据的系统尝试[58],由美国宾汉姆顿大学(Binghamton University)提供,包括100人,每个人被采集 4种程度的6类表情模型,系统通过3DMD设备采集。三维人脸模型由20 000~35 000个多边形组成,同时,每个人脸模型包含83个特征点。

BU-4DFE数据库是BU-3DFE的延伸[59],用于动态三维表情识别,由四维人脸(三维人脸图像序列)组成。该数据包括101人,用DI3D采集设备采集动态人脸图像。它由6种基本表情的面部表情序列组成,每个表情时间段大概持续4 s。时间和空间分辨率分别为25 frame/s和35 000个顶点。但是数据库不提供AU识别。

6.2The Bosphorus Database

Bosphorus数据库[60]是公开的用于静态三维表情分析的数据库,该数据库通过商业结构光三维采集设备Mega Capturor获取人脸数据。数据库包含105人(60名男性,45名女性,且大部分为白种人),其中27人为专业演员,包含丰富的姿态、表情和遮挡。每人表达6种表情以及24 AU单元。纹理图像分辨率为1600×1200,三维人脸包含35 000个顶点。数据库同时包含24个人工标注的标志点。

6.3ICT-3DRFE[61]

该数据库是新近建立的,采集了23人(17名男性,7名女性)的多光照条件下的15种表情单元数据。这15种表情单元分别是:6种典型表情,2种中性表情(闭眼与睁眼),2种眉毛表情,1种皱眉表情以及4种眼睛表情。数据集中每个模型包含多达1 200 000个顶点的1296×1944反射贴图像素,分辨率对应于亚毫米级皮肤毛孔的详细程度。数据库还包括光度信息,允许真实感渲染。该数据库是完全注释AU。根据肌肉活动度,AU分在0和1之间。

6.4D3DFACS

第一个包含动态三维Aus编码的数据库是D3DFACS[62],它包含10人(4名FACS专家),包含多达38种组合姿态变化例子,总共519个AU序列,帧率为60 frame/s,平均90帧每个AU。每个图像序列经过FACS专家编码。系统通过3DMD人脸动态系统获取数据,是第一个用于动态三维AU识别和分析的数据库。

6.5FRGC Ver2.0

FRGC V2.0包含了465人的4007幅2.5维图像,图像尺寸为 320×240,采集设备为Minolta Vivid 900/910 series scanner,采集时间从 2003 年秋至 2004 年春。除了中性表情外,还包括一些带表情的图像,如微笑、惊讶等。

6.6GavabDB

GavabDB库[63]包含了61人的 549 幅三维图像,其中 45 名为男性,16 名为女性。所有的被采集者都是高加索人种,年龄18~40岁。每个采集设备分别采集 9 幅图像,其中2 幅中性正面,2 幅左右全侧面,1 幅仰头,1 幅低头,1 幅微笑表情,1 幅大笑表情,1 幅随意表情姿态图像。

6.7CASIA 3D Face Database[64]

该数据库由中图科学院自动化所生物识别与安全技术研究中心提供,于2004年8月,采用Minolta Vivid 910采集设备,采集了123人的4624幅三维数据,数据包含姿态、光照以及表情变化数据,同时采集戴眼镜与不戴眼镜情况下数据,每人采集37幅或者38幅数据,其中包括二维图像和三维脸部网格数据。

6.8Hi4D-ADSIP

该数据库是一个三维动态数据库,由高分辨率的全面部数据组成。数据库不但可以促进面部表情识别技术的研究,还可以用于面部神经功能障碍的临床诊断研究。该数据库采集了80名各种年龄、性别及种族的共3360个人脸数据序列,被认为是到目前为止最全面的一个人脸面部三维动态表情数据库。而且,针对面部功能障碍的脑卒、贝尔氏麻痹症及帕金森症的研究,该数据库正在进一步扩充数据。

6.9其他数据库

第一个三维人脸表情数据库包含六大表情[39],它通过视频采集图像以及一个摄像机和投影机组成的被动结构光技术得到三维数据,目前该数据并未公开。

另外一个公开但未被广泛关注的表情数据库[42],同步采集3D、灰度图像和不可见近红外光谱数据。包含52人(12女,40男)的832个序列,每个序列中,采集每人的简单AU(总共11个)或者模仿一个脸部表情2~4次(高兴、悲伤、厌恶、惊奇和中性),持续5~10 s。

另外一个用于面部行为分析的数据库[65],通过3DMD人脸动态系统采集,由94人说同一词语组成。采集50人的微笑。然而,作者在采集各种AU数据时存在问题,因为被采集者无法多次表达正确的AU,况且对于那些没有任何经验用户更加困难。

最早公开的三维人脸数据库[66-67],通过CyberwareTM激光技术采集三维数据,包含100男性和100女性,年龄18~45岁,所有的都是白种人,在配准后可以用于形变模型构建。文献[68]是最近公开的同样用于静态形变模型的数据库,数据主要用于三维表情分析和合成。

还有其他的包含表情人脸的三维人脸数据库,如ND-2006数据库[69]、York三维数据库[70]、Texas数据库[71]等。 ND-2006数据库包含888个人的多个图像,每个人有高兴、厌恶、悲伤和惊奇表情,通过Minota Vivid采集三维数据,分辨率达到112 000个顶点。York三维数据库由350个人脸组成,包含微笑、生气、闭眼和扬眉表情,通过结构光技术采集数据。Texas数据库包含105人,或微笑或交谈,以及25个标记点。

7总结与讨论

7.1现有技术总结

现有的3D面部表情领域工作基于的数据库都是对6种基本情绪,表演和夸张的表情很少发生在我们的日常生活。此外,越来越多的证据表明,深思熟虑或表演的行为在表现和时间上都和自发的不同。例如,表演的微笑比自然发生的微笑幅度较大,持续时间较短,起止速度更快。反过来,实验室环境培训的表演行为自动方法无法概括现实世界中表情行为的复杂性。

此外,目前三维表情识别技术研究更多关注的是算法对识别率的影响,速度不是主要的研究方向。因此,实时识别还有一定差距。

目前三维表情识别无论采用哪种表情特征提取方式,都过多依赖特征点或者标记点,特征点或者标记点的提取结果直接影响最后的识别率,而目前的特征点或标记点提取算法在稳定性方面还需要进一步改善,因此自动表情识别技术还需要进一步研究。

三维比二维具有更多的人脸信息,特征提取是对信息的有效压缩,而如何从三维信息中提取比二维表情图像更有效的特征,现有的特征提取方法无法证明比二维图像更简单有效。

7.2存在问题及展望

目前为止,三维表情识别技术还处于算法的研究阶段,在性能和应用方面与二维表情识别相比还存在差距。

在三维表情识别研究领域,国外研究无论从数据库建设还是核心算法研究方面都取得了一定的研究成果。同时,国内开展该方面的研究较晚,鲜有该方面研究文献报道,且国内研究以模仿国外研究、算法以借鉴三维人脸识别为主,还存在着一定的差距。

尽管三维数据采集设备发展迅速,但相比二维图像采集,在普适性方面还存在差距。目前的三维采集设备只能够采集几米内的物体,且速度较慢。而人脸面部有微表情,持续时间低于0.04 s,强度非常低,帧速率至少50~60 frame/s,因此需要捕捉这些微表情至少2~3帧。记录的帧的分辨率要求很高,从而需要捕获脸部非常细微运动部分。目前,很少有方法能够记录上述数据。有两个商业产品可以记录上面数据,但需要严格的记录场景,且不支持实时三维面部重建。另一个挑战是记录4D面部数据库。该数据库包含自发行为,且在具有高空间和时间分辨率的上下文中实时捕获。为了获取3D数据所需的设备和装置,必须开发新的策略,以摆脱环境限制,同时引入通用表情和其他的情感状态。最后,需要捕获脸部360°视图。由于当前成像系统的局限性,4D捕获仍然局限于正面人脸,这是由于无法处理非常大的姿态变化问题。因此,要处理任意姿势或动作的运动,具有多个全方位捕捉相机是必要的,这样才可以捕捉任何情况下超过60°或90°的头部转动。因此,部分人脸捕获的空洞问题是可以解决的。

三维数据的人脸表情识别算法复杂,尤其是随着分辨率的提高以及数据规模的扩大,计算的时间成本将无法估量,如何提取简单有效的表情特征是亟待解决的问题。

综上所述,三维表情识别技术在识别率、实时性、自动化及鲁棒性等方面都还需要进一步研究。现有的技术一定程度体现了三维表情识别未来发展潜力,通过结合二维表情识别技术和三维表情识别技术两者优势,取长补短,将会推动表情识别技术的实际应用。

参考文献:

[1]文沁,汪增福.基于三维数据的人脸表情识别[J].计算机仿真,2005,7(22):99-103.

WEN Qin,WANG Zengfu. Recognition of Human Facial Expression Based on 3D Data[J]. Computer Simulation,2005,7(22):99-103.(in Chinese)

[2]胡平,曹伟国,李华.一类等距不变量及其在三维表情人脸识别中的应用[J]. 计算机辅助设计与图形学学报,2010,22(12):2089-2094.

HU Ping,CAO Weiguo,LI Hua. A Novel Isometric Invariant and its Applications in 3D Face Recognition[J]. Journal of Computer-Aided Design & Computer Graphics,2010,22(12):2089-2094.(in Chinese)

[3]胡步发,王金伟. 双模态及语义知识的三维人脸表情识别方法[J].仪器仪表学报,2013,34(4):873-880.

HU Bufa,WANG Jinwei. 3D facial expression recognition method based on bimodal and semantic knowledge[J].Chinese Journal of Science Instrument,2013,34(4):873-880.(in Chinese)

[4]Sandbach G,Zafeiriou S,Pantic M,et al. Static and dynamic 3D facial expression recognition: A comprehensive survey[J]. Image and Vision Computing,2012,30(10):683-697.

[5]Soyel H,Demirel H. Facial expression recognition using 3D facial feature distances[C] //Proceedings of 2007 4th International Conference on Image Analysis and Recognition.Montreal, Canada:Springer Berlin Heidelberg,2007:831-838.

[6]Soyel H,Demirel H. 3D facial expression recognition with geometrically localized facial features[C] //Proceedings of 23rd International Symposium on Computer and Information Sciences.Istanbul:IEEE,2008: 1-4.

[7]Tang H,Huang T. 3D facial expression recognition based on properties of line segments connecting facial feature points[C] //Proceedings of 8th IEEE International Conference on Automatic Face & Gesture Recognition.Amsterdam:IEEE,2008: 1-6.

[8]Li X,Ruan Q,Ming Y. 3D facial expression recognition based on basic geometric features[C] //Proceedings of 10th International Conference on Signal Processing.Beijing:IEEE,2010: 1366-1369.

[9]Tang H,Huang T. 3D facial expression recognition based on automatically selected features[C] //Proceedings of 2008 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Anchorage,AK:IEEE,2008: 1-8.

[10]Soyel H,Demirel H. Optimal feature selection for 3D facial expression recognition with geometrically localized facial features[C] //Proceedings of 5th International Conference on Soft Computing,Computing with Words and Perceptions in System Analysis,Decision and Control.Famagusta:IEEE,2009: 1-4.

[11]Soyel H,Demirel H. Optimal feature selection for 3D facial expression recognition using coarse-to-fine classification[J]. Turkish Journal of Electrical Engineering and Computer Sciences,2010,18(6):1031-1040.

[12]Tekguc U,Soyel H,Demirel H. Feature selection for person-independent 3D facial expression recognition using NSGA[C]//Proceedings of 24th International Symposium on Computer and Information Sciences.Guzelyurt:IEEE,2009: 35-38.

[13]Sha T,Song M,Bu J,et al. Feature level analysis for 3D facial expression recognition[J]. Neuro Computing,2011,74(12-13): 2135-2141.

[14]Srivastava R,Roy S. 3D facial expression recognition using residues[C] //Proceedings of 2009 IEEE Region 10 Conference(TENCON 2009).Singapore:IEEE,2009:1-5.

[15]Gunes H,Pantic M.Automatic,dimensional and continuous emotion recognition[J]. International Journal of Synthetic Emot,2010,1(1): 68-99.

[16]Wang J,Yin L,Wei L,et al.3D facial expression recognition based on primitive surface feature distribution[C]//Proceedings of 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington DC:IEEE,2006: 1399-1406.

[17]Maalej A,Amor B,Daoudi M,et al. Shape analysis of local facial patches for 3D facial expression recognition[J]. Pattern Recognition,2011,44(8):1581-1589.

[18]Maalej A,Amor B,Daoudi M,et al. Local 3D shape analysis for facial expression recognition[C] //Proceedings of 2010 20th International Conference on Pattern Recognition.Istanbul:IEEE,2010: 4129-4132.

[19]Lemaire P,Amor B P,Ardabilian M,et al. Fully automatic 3D facial expression recognition using a region-based approach[C] //Proceedings of the 2011 Joint ACM Workshop on Human Gesture and Behavior Understanding.Shanghai:IEEE,2011: 53-58.

[20]Ramanathan S,Kassim A,Venkatesh Y,et al. Human facial expression recognition using a 3D morphable model[C] //Proceedings of 2007 IEEE International Conference on Image Processing.Atlanta,GA:IEEE,2007: 661-664.

[21]Gong B,Wang Y,Liu J,et al. Automatic facial expression recognition on a single 3D face by exploring shape deformation[C] //Proceedings of the Seventeen ACM International Conference on Multimedia.New York,USA:IEEE,2009: 569-572.

[22]Zhao X,Dellandrea E,Chen L,et al. Au recognition on 3D faces based on an extended statistical facial feature model[C] //Proceedings of Fourth IEEE International Conference on Biometrics: Theory Applications and Systems(BTAS).Washington DC:IEEE,2010: 1-6.

[23]Mpiperis I,Malassiotis S,Strintzis M. Bilinear models for 3-D face and facial expression recognition[J].IEEE Transactions on Information Forensics Secure,2008,3(3):498-511.

[24]Mpiperis I,Malassiotis S,Petridis V,et al. 3D facial expression recognition using swarm intelligence[C] //Proceedings of 2005 IEEE International Conference on Acoustics,Speech and Signal Processing.Las Vegas,NV:IEEE,2008: 2133-2136.

[25]Mpiperis I,Malassiotis S,Strintzis M. Bilinear elastically deformable models with application to 3D face and facial expression recognition[C]//Proceedings of 8th IEEE International Conference on Automatic Face & Gesture Recognition.Amsterdam:IEEE,2008:1-8.

[26]Mpiperis S,Malassiotis S,Strintzis M G. Bilinear decomposition of 3D face images: an application to facial expression recognition[C] //Proceedings of 10th International Workshop on Image Analysis for Multimedia Interactive Services.London:IEEE,2009:1-4.

[27]Berretti S,Amor B,Daoudi M,et al. 3D facial expression recognition using sift descriptors of automatically detected keypoints[J]. Visual Computer,2011,27(11):1021-1036.

[28]Vretos N,Nikolaidis N,Pitas I. 3D facial expression recognition using Zernike moments on depth images[C] //Proceedings of 18th IEEE International Conference on Image Processing.Brussels:IEEE,2011: 773-776.

[29]Zernike F. Beugungstheorie des schneidenver-fahrens und seiner verbesserten form,der phasenkontrast methode[J]. Physica,1934,1(7):689-704.

[30]Savran A,Sankur B,Bilge T. Comparative evaluation of 3D versus 2D modality for automatic detection of facial action units[J].Pattern Recognition,2012,45(2):767-782.

[31]Ocegueda O,Fang T H,Shah S K,et al. Expressive maps for 3D facial expression recognition[C] //Proceedings of 2011 IEEE International Conference on Computer Vision Workshops.Barcelona:IEEE,2011:1270-1275.

[32]Savran A,Sankur B. Non-rigid registration of 3D surfaces by deformable 2D triangular meshes[C] //Proceedings of 2008 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Anchorage,AK:IEEE,2008: 1-6.

[33]Savran A,Sankur B. Automatic detection of facial actions from 3D data[C] //Proceedings of 12th International Conference on Computer Vision Workshops.Kyoto:IEEE,2009:1993-2000.

[34]Rosato M,Chen X,Yin L. Automatic registration of vertex correspondences for 3D facial expression analysis[C] //Proceedings of 2nd IEEE International Conference on Biometrics: Theory,Applications and Systems.Arlington,VA:IEEE,2008:1-7.

[35]Wang P,Kohler C,Barrett F,et al. Quantifying facial expression abnormality in schizophrenia by combining 2D and 3D features[C]//Proceedings of 2007 IEEE Conference on Computer Vision and Pattern Recognition.Minneapolis,MN:IEEE,2007: 1-8.

[36]Pinto S,Mena-Chalco J,Lopes F,et al. 3D facial expression analysis by using 2D and 3D wavelet transforms[C]//Proceedings of 18th IEEE International Conference on Image Processing.Brussels:IEEE,2011:1281-1284.

[37]Savran A,Sankur B,Bilge M. Facial action unit detection: 3D versus 2D modality[C] //Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.San Francisco,CA:IEEE,2010:71-78.

[38]Venkatesh Y,Kassim A,Murthy O. A novel approach to classification of facial expressions from 3D-mesh datasets using modifie PCA[J]. Pattern Recognition Letters,2009,30(12): 1128-1137.

[39]Chang Y,Vieira M,Turk M,et al. Automatic 3D facial expression analysis in videos[C] //Proceedings of Second International Workshop on Analysis and Modeling of Faces and Gestures. Beijing:Springer Berlin Heidelberg,2005:293-307.

[40]Yin L,Wei X,Longo P,et al. Analyzing facial expressions using intensity variant 3D data for human computer interaction[C] //Proceedings of 18th International Conference on Pattern Recognition.Hong Kong:IEEE,2006: 1248-1251.

[41]Tsalakanidou F,Malassiotis S. Real-time facial feature tracking from 2D+3D video streams[C] //Proceedings of 3DTV Conference.Tampere:IEEE,2010:1-4.

[42]Tsalakanidou F,Malassiotis S. Real-time 2D+3D facial action and expression recognition[J].Pattern Recognition,2010,43(5): 1763-1775.

[43]Tsalakanidou F,Malassiotis S. Robust facial action recognition from realtime 3D streams[C] //Proceedings of 2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops.Miami,FL:IEEE,2009: 4-11.

[44]Venkatesh Y,Kassim A,Murthy O. Resampling approach to facial expression recognition using 3D meshes[C] //Proceedings of 2010 International Conference on Pattern Recognition.Istanbul:IEEE,2010:3772-3775.

[45]Sun Y,Yin L. Facial expression recognition based on 3D dynamic range model sequences[C] //Proceedings of 10th European Conference on Computer Vision.Marseille,France:IEEE,2008:58-71.

[46]Le V,Tang H,Huang T. Expression recognition from 3D dynamic faces using robust spatio-temporal shape features[C]// Proceedings of 2011 IEEE International Conference on Automatic Face and Gesture Recognition.Santa Barbara,CA:IEEE,2011: 414-421.

[47]Sandbach G,Zafeiriou S,Pantic M,et al. A dynamic approach to the recognition of 3D facial expressions and their temporal models[C] //Proceedings of 2011 IEEE International Conference on Automatic Face Gesture Recognition and Workshops.Santa Barbara,CA:IEEE,2011:406-413.

[48]Sandbach G,Zafeiriou S,Pantic M,et al. Recognition of 3D facial expression dynamics[J]. Image Vision Computer,2012,30(10): 762-773.

[49]Fang T,ZhaoX,Shah S,et al. 4D facial expression recognition[C] //Proceedings of 2011 IEEE International Conference on Computer Vision Workshop.Barcelona:IEEE,2011:1594-1601.

[50]Fang T,Zhao X,Ocegueda O,et al. 3D/4D facial expression analysis: an advanced annotated face model approach[J]. Image Vision Computer,2012,30(10):738-749.

[51]Drira H,Ben Amor B,Daoudi,et al. 3D dynamic expression recognition based on a novel deformation vector field and random forest[C] //Proceedings of 2012 21st International Conference on Pattern Recognition.Tsukuba:IEEE,2012:1104-1107.

[52]Berretti S,del Bimbo A,Pala P. Automatic facial expression recognition in real-time from dynamic sequences of 3D face scans[J].Vision Computer,2013,29(12):1333-1350.

[53]马晓磊. 四维人脸表情识别[D].北京:北方工业大学,2012.

MA Xiaolei. 4D Facial Expression Recognition[D].Beijing:North China University of Technology,2012.(in Chinese)

[54]Ekman P. Facial Expression and Emotion [J].American Psychologist,1993,48(4):384-392.

[55]Ekman P,Friesen W V. Facial Action Coding System: A Technique for the measurement of Facial Movement[M]. Palo Alto: Consulting Psychologists Press,1978.

[56]Sayette M A,Cohn J F,Wertz J M,et al. A psychometric evaluation of the facial action coding system for assessing spontaneous expression[J]. Journal of Nonverbal Behavior,2001,25(3):167-185.

[57]Ekman P,Rosenberg E L. What the face reveals: basic and applied studies of spontaneous expression using the facial action coding system(FACS)[M].2nd ed. New York:Oxford University Press,2005.

[58]Yin L,Wei X,Sun Y,et al. A 3D facial expression database for facial behavior research[C]//Proceedings of 7th International Conference on Automatic Face and Gesture Recognition.Southampton:IEEE,2006:211-216.

[59]Yin L,Chen X,Sun Y,et al. A high-resolution 3D dynamic facial expression database[C] //Proceedings of 8th International Conference on Automatic Face and Gesture Recognition.Amsterdam:IEEE,2008: 1-6.

[60]Savran A,Alyuz N,Dibeklioglu H,et al. Bosphorus database for 3D face analysis[C] //Proceedings of First COST 2101 Workshop on Biometrics and Identity Management.Denmark:IEEE,2008: 47-56.

[61]Stratou G,Ghosh A,Debevec P,et al. Effect of illumination on automatic expression recognition: a novel 3D relightable facial database[C] //Proceedings of 9th International Conference on Automatic Face and Gesture Recognition.Santa Barbara,CA:IEEE,2011:611-618.

[62]Cosker D,Krumhuber E,Hilton A. A FACS valid 3D dynamic action unit database with applications to 3D dynamic morphable facial modeling[C] //Proceedings of 2011 IEEE International Conference on Computer Vision.Barcelona:IEEE,2011:2296-2303.

[63]Moreno A,Sanchez A. Gavabdb: a 3D face database[C]//Proceedings 2nd COST Workshop on Biometrics on the Internet:Fundamentals, Advances and Applications.Vigo:IEEE,2004:77-82.

[64]Zhong C,Sun Z,Tan T. Robust 3D face recognition using learned visual codebook[C] //Proceedings of 2007 IEEE Conference on Computer Vision and Pattern Recognition.Vigo:IEEE,2007:1-6.

[65]Benedikt L,Cosker D,Rosin P,et al. Assessing the uniqueness and permanence of facial actions for use in biometric applications[J].IEEE Transactions on System,Man,and Cybernetics—Part A:System Human,2010,40(3): 449-460.

[66]Beumier C,Acheroy M. Face verification from 3D and grey level clues[J]. Pattern Recognition Letters,2001,22(12): 1321-1329.

[67]Beumier C,Acheroy M. SIC DB: multi-modal database for person authentication[C] //Proceedings of 1999 International Conference on Image Analysis and Processing.Venice:IEEE,1999:704-708.

[68]Pascal Paysan, Reinhard Knothe, Brian Amberg, er al. A 3D Face Model for Pose and Illumination Invariant Face Recognition[C]//Proceedings of the Sixth IEEE International Conference on Advanced Video and Signal Based Surveillance.Genova, Italy: IEEE,2009:296-301.

[69]Faltemier T,Bowyer K,Flynn P. Using a multi-instance enrollment representation to improve 3D face recognition[C] //Proceedings of 2007 First IEEE International Conference on Biometrics: Theory,Applications,and Systems.Crystal City,VA:IEEE,2007:1-6.

[70]York 3D databaseURL[EB/OL].[2014-12-20].http://www-users.cs.york.ac.uk/nep/research/3Dface/tomh/ 3DFaceRecognition. html.

[71]Texas 3D Face Recognition DatabaseURL[EB/OL].[2014-12-20].http://live.ece.utexas.edu/research/ texas3dfr.

魏永超(1981—),男,河南许昌人, 2009年于四川大学获博士学位,现为副教授,主研研究方向为光电信息处理;

WEI Yongchao was born in Xuchang,Henan Province,in 1981.He received the Ph.D. degree from Sichuan University in 2009.He is now an associate professor.His research concerns photoelectric information processing.

Email:mylife001@126.com

庄夏(1980—),男,四川广汉人,2006年于西南大学获硕士学位,现为副教授,主要研究方向为计算机应用技术;

ZHUANG Xia was born in Guanghan,Sichuan Province,in 1980. He received the M.S. degree from Southwest University in 2006.He is now an associate professor. His research concerns computer application.

傅强(1969—),男,四川西昌人,2002年于四川大学获硕士学位,现为研究员,主要研究方向为计算机及空管自动化;

FU Qiang was born in Xichang,Sichuan Province,in 1969. He received the M.S. degree from Sichuan University in 2002.He is now a research fellow. His research concerns computer and air traffic control automation.

杜冬(1975—),男,四川广汉人,2010年于电子科技大学获硕士学位,现为副研究员,主要研究方向为图形图像处理。

DU Dong was born in Guanghan,Sichuan Province,in 1975. He received the M.S. degree from University of Electronic Science and Technology of China in 2010.He is now an associate research fellow. His research concerns graphics image processing.

引用格式:魏永超,庄夏,傅强,等.三维面部表情识别技术的研究进展[J].电讯技术,2015,55(6):693-703.[WEI Yongchao,ZHUANG Xia,FU Qiang,et al.Research Progress of 3D Facial Expression Recognition Technology[J].Telecommunication Engineering,2015,55(6):693-703.]

Research Progress of 3D Facial Expression Recognition Technology

WEI Yongchao1,ZHUANG Xia2,FU Qiang2,DU Dong1

(1.Academy of Flight Technology and Safety,Civil Aviation Flight University of China,Guanghan 618307,China;

2.Department of Research,Civil Aviation Flight University of China,Guanghan 618307,China)

Abstract:The rapid development of three-dimensional(3D) acquisition devices has greatly promoted the researches based on dimensional data and the achievements in 3D facial expression recognition research is constantly emerging. 3D facial recognition can greatly overcome the gesture and illumination changes and other issues of two-dimensional(2D) recognition. This paper summarizes 3D facial expression recognition technologies with emphasis on analysis of the key technologies of 3D expression,including expression feature extraction,coding and database.It also gives some research suggestions about 3D facial expression recognition. 3D facial expression recognition technology can basically meet the requirements in recognition rate,but its real-time performance needs to be further optimized. The research in this paper has reference value for researchers in the field.

Key words:facial expression recognition;3D face;facial expression feature;facial expression coding;facial expression database;research progress

作者简介:

中图分类号:TN29;TP391.4

文献标志码:A

文章编号:1001-893X(2015)06-0693-11

通讯作者:**mylife001@126.comCorresponding author:mylife001@126.com

收稿日期:*2014-12-17;修回日期:2015-04-07Received date:2014-12-17;Revised date:2015-04-07基金项目:国家自然科学基金资助项目(61079022);四川省科技基金项目(2015JY0188);中国民航飞行学院科研基金项目(Q2013-050,J2012-43)Foundation Item:The National Natural Science Foundation of China(No.61079022);The Science & Technology Fund of Sichuan Province(2015JY0188);The Research Fund of Civil Aviation Flight University of China(Q2013-050,J2012-43)

doi:10.3969/j.issn.1001-893x.2015.06.019