一种基于仿射变换的SURF图像配准算法*

刘欣,李校林,,谢灿,何鹏

(1.重庆邮电大学通信与信息工程学院,重庆400065;2.重庆信科设计有限公司,重庆400065)

图像匹配技术是机器视觉和模式识别领域的一个重要分支,其应用领域广泛,如医学、目标识别跟踪、图像拼接等。目前,图像配准的方法大致分为两类:基于特征的图像配准方法和基于灰度的图像配准方法。其中,基于特征的匹配方法由于对不同特性的图像特征容易提取,且提取的特征点不易受到光照、旋转变化的影响,具有较强的稳定性和鲁棒性,因而得到广泛应用。

1999年,LOWE D在总结现有特征算法的基础上提出了尺度不变特征变换SIFT(Scale Invariant Feature Transform)算法[1],并于2004年总结完善[2]。该算法提取的稳定特征点对旋转、亮度变化、尺度变化保持不变性,对视角变换、仿射变换也有一定程度的稳定性,因此在图像配准中得到了应用,如参考文献[3-4]将SIFT用于图像配准领域,除此以外也衍生了一系列改进算法,如利用主成分分析的PCA-SIFT[5]。但是SIFT本身始终存在抗仿射性弱以及计算效率低的缺点。针对以上缺点,BAY H等人于2008年提出了一种加速的鲁棒性特征SURF(Speeded Up Robust Feature)算法,该算法是对SIFT的一种改进方法,其性能在各方面接近或超越了SIFT算法,在保持性能的同时,计算速度是SIFT的3倍,参考文献[6]对此进行了比较详细的阐述。参考文献[7]提出了一种基于SURF和CamShift的物体跟踪方法,利用SURF算法找到跟踪窗口与初始窗口的色彩相似度,最终实现对物体的跟踪。

尽管上述算法在特征描述和特征匹配方面取得了较好的效果,但是,这些算法并没有在仿射变换上得到更好的改进。针对这个问题,Random ferns[8]算法通过对以特征点为中心的子块进行仿射变换,利用像素比对信息构造快速分类器,在加快匹配速度的同时提高了对视角变化的鲁棒性。2009年,Jean-Michel Morel等人提出了ASIFT算法[9],该算法具有完全仿射不变性,能够解决SIFT和SURF在仿射性方面的缺陷,但ASIFT算法计算量复杂,难以在实时系统中使用。

本文通过对以上算法的深入研究和总结,提出了一种基于仿射变换的SURF描述符。该算法利用透视投影模型来模拟成像过程,然后将仿射变换后的图像利用SURF算法进行匹配。通过3组不同类型图像的实验证明,本文算法比SIFT、SURF、MSER(Maximally stable extremal regions)[10]算法要好。

1 SURF描述符

SURF描述符的建立主要包括特征点检测与特征点描述两个主要步骤。

1.1 特征点检测

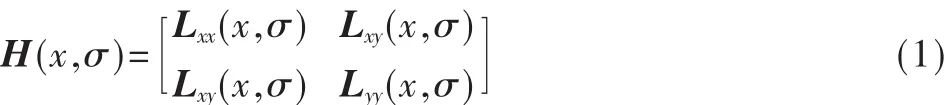

假如给定图像I中的一个点x(x,y),则在x处,基于尺度空间Hessian矩阵H(x,y)定义为:

SURF采用盒子滤波(Box Filter)的方法来近似代替高斯滤波。假设盒子滤波器估计值分别为Dxx、Dyy和Dxy,这样可以得到Fast-Hessian行列式的定义:

在求得Fast-Hessian矩阵行列式的响应图像后,对空间3×3×3邻域内所有点进行非最大值抑制,将最值作为候选的特征点,然后采用线性插值法得到特征点的准确位置。

1.2 SURF特征点描述

为了保证得到的特征矢量具有旋转不变性,需要为每一个特征点分配一个主方向。统计以特征点为中心,以6s(s为特征点尺度)为半径圆形区域内,利用Haar小波滤波器在x,y方向进行响应,并使用σ=2s的高斯加权函数对Haar小波进行高斯加权,离特征点越近响应贡献越大。然后,在60°的扇形区域内求出x和y方向上的系数之和,并构建一个新的向量,接着遍历整个圆形区域,选择最长向量方向为主方向。

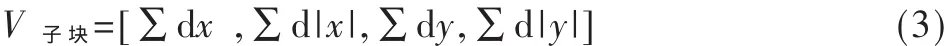

选定方向后,以特征点为中心,构建一个20σ×20σ的正方形窗,并沿主方向将方形窗分成4×4个子块,计算每个子块的dx、dy,并用高斯函数进行加权,得到每个子块的矢量V子块:

最后再对特征矢量进行归一化处理。

2 基于仿射变换的SURF描述符

本文为了解决SURF仿射性能上的不足,在其基础上模拟了经度角和纬度角两个参数。

2.1 仿射模拟

摄像机投影模型可以用描述为:

式中,u0表示平面数字图像;T和R表示由相机引起的平移和旋转变换;A表示仿射投影;G表示高斯视觉模型;S表示网格采样。u为最终获取的平面图像。

为了简化该模型,结合相机的运动方式与仿射变换形式,可以得到如下定理。

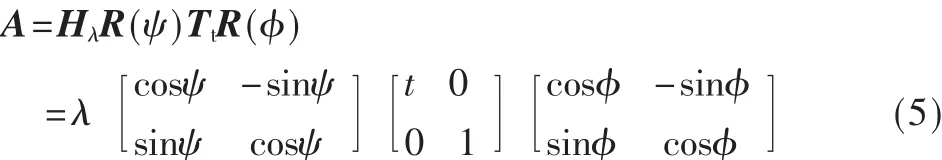

定理:对于任意的仿射矩阵A可以分解为:

其中,λ为缩放尺度参数,λ>0;φ∈[0,π);Tt为倾斜矩阵,该矩阵第一个特征值t>1,第二个特征值t=1;R(φ)为旋转变换矩阵。

2.2 Affine-SURF描述符

Affine-SURF描述符的建立过程如下:

(1)仿射采样获取参数φ和θ

获取参数的过程就是对待匹配图像进行经度角与纬度角采样的过程。首先,对纬度角采用等比数列采样:以达到平衡,本文n=5;然后,对经度角进行等差采样:0,b/t,...kb/t,其中b取72°,t=|1/cosθ|,k为满足条件kb/t<180°的最后一个整数。

(2)获取仿射变换后的图像

将步骤(1)得到的序列参数带入下式:

其中,I为输入图像,I′为仿射模拟图。

(3)对输出的仿射图像进行特征点检测

①首先计算仿射图像的积分图像。积分图像I在X=(x,y)处的定义为:

②然后利用式(2),获得Fast-Hessian矩阵行列式,并得到响应图像。

③接着采用最大值抑制搜索技术,在位置和尺度上对响应图像进行特征点搜索。

④对得到的特征点分配方向。

(4)构造Affine-SURF描述符

通过计算图像的Haar小波响应,然后统计∑dx,∑d|x|,∑dy,∑d|y|来形成特征矢量。

经过以上步骤就得到了具有较强仿射性能的Affine-SURF描述符。

3 基于仿射变换的SURF图像配准

得到Affine-SURF描述符后,用其进行特征匹配。本文中,首先采用比值提纯法进行特征点粗匹配,接着采用鲁棒性较强、可靠性好的RANSAC算法[11]进一步提纯,得到最终的匹配对。

4 实验与结果分析

本文在VS2010平台上验证该算法的性能。实验的评价指标为图像在不同仿射情况下获取的正确匹配对数目。

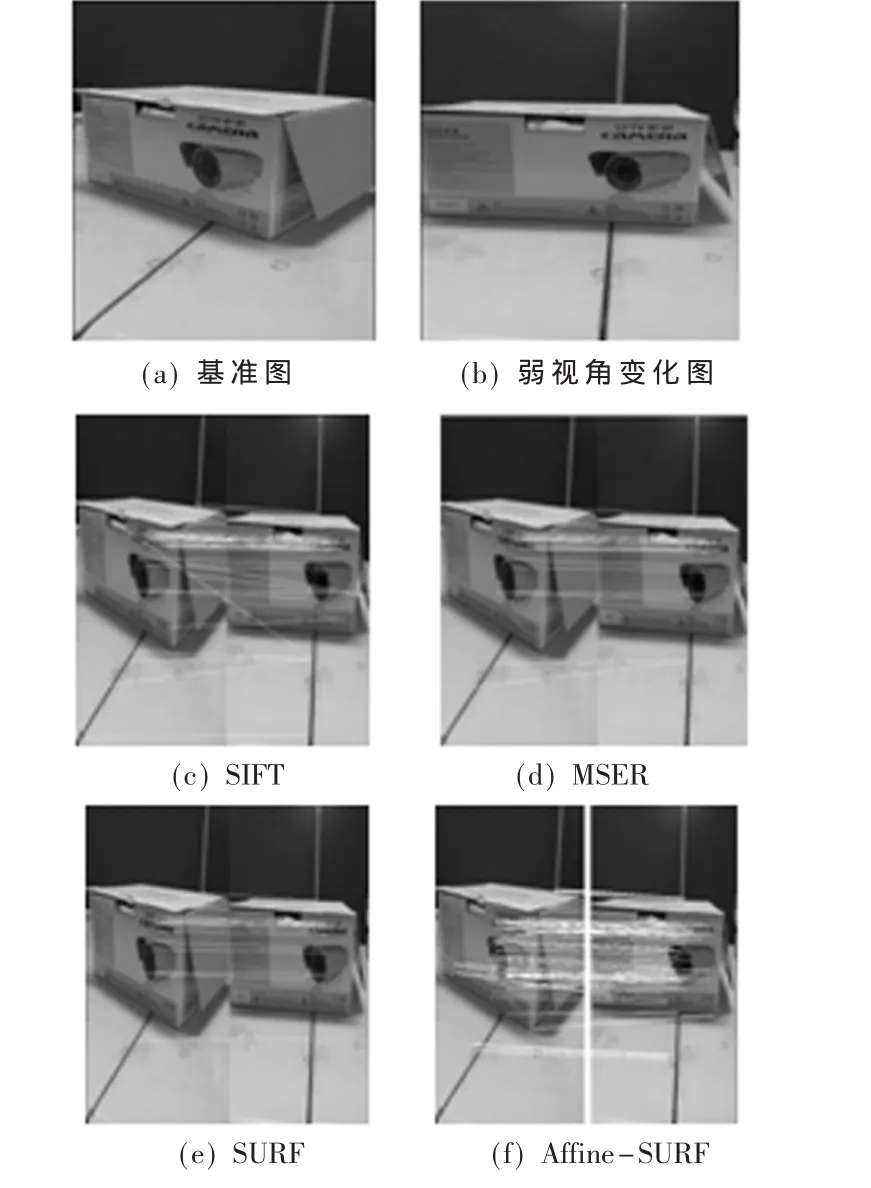

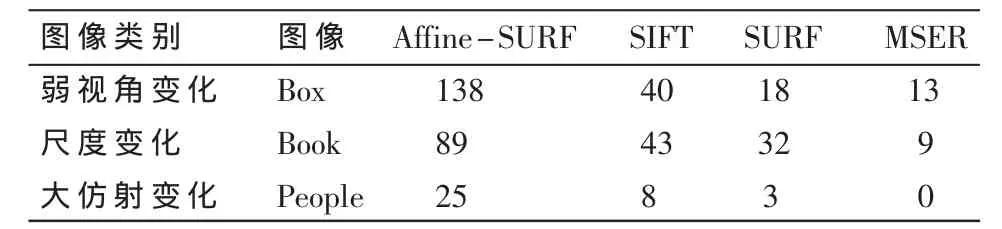

第一组实验主要分析弱视角变化对算法的影响。以图1为例,图像Box由于相机的视角变化,存在着旋转、弱透视形变等现象,图1(c)~图1(f)分别为SIFT、MSER、SURF和Affine-SURF算法的匹配结果,它们的匹配结果如表1所示。通过对比正确匹配对的数目可以看出,Affine-SURF有效地克服了视角变化对特征提取与描述的影响。

图1 弱视角变化匹配鲁棒性比较

表1 4种图像匹配方法在不同类型图像的匹配结果

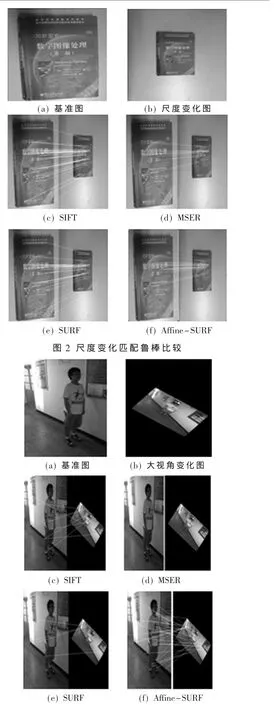

第二组实验主要用来评价不同算法在尺度变化方面的鲁棒性。以图2为例,图像Book由于拍摄高度不同,导致出现尺度变化。从图2(c)~图2(f)以及表1可以看出,Affine-SURF算法有较好的匹配效果,而且比其他3种算法能够获取更多特征点。这说明Affine-SURF能够在尺度变化明显的情况下获得更多正确的匹配点。

第三组实验主要用来验证算法在仿射形变较大情况下的性能。以图3为例,图像People由于旋转、视角变化过大,导致仿射形变明显。图3(c)~图3(f)分别为SIFT、MSER、SURF和Affine-SURF算法的匹配结果,结合表1可以看出,采用本文提出的Affine-SURF算法找到的正确匹配特征点最多,证明了该算法对大视角变化的仿射图像匹配鲁棒性最好。

图3 大仿射变化匹配鲁棒性比较

SIFT、SURF图像配准算法已经被验证对于尺度变化、旋转、亮度变化具有较好的不变性,但是它们不具有很好的仿射性。因此,本文提出一种基于仿射变换的SURF图像配准算法。通过3组不同图像类型的实验结果表明,采用本文算法比SIFT、SURF、MSER算法能够得到更多的正确匹配点,更好地提高算法的仿射鲁棒性。

[1]LOWE D.Object recognition from local scale-invariant features[C].In:Proceedings of the 7th IEEE International Conference on Computer Vision,Corfu,US:IEEE,1999:1150-1157.

[2]LOWE D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[3]Zhao Wanglei,NGO C W.Flip-invariant SIFT for copy and object detection[J].Image Processing,IEEE,2013,22(3):980-991.

[4]张瑞年.联合时空SIFT特征的同源视频检测[J].电子技术应用,2012,38(3):130-133.

[5]JUAN L,GWUN O.A comparison of SIFT,PCA-SIFT and SURF[J].International Journal of Image Processing(IJIP),2009,3(4):143-152.

[6]BAY H,ESS A,TUYTELAARS T,et al.Speeded up robust features(SURF)[J].Computer Vision and Image Understanding(CVIU),2008,110(3):346-359.

[7]路宁.基于SURF和CamShift的物体跟踪方法[J].微型机与应用,2012,31(27):40-43.

[8]OZUYSAL M,CALONDER M,LEPETIT V,et al.Fast keypoint recognition using random ferns[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(3):448-461.

[9]MOREL J M,YU G S.ASIFT:a new framework for fully affine invariant image comparison[J].SIAM Journal on Image Sciences,2009,2(2):438-469.

[10]MATAS J,CHUM O,URBAN M,et al.Robust widebaseline stereo from maximally stable extremal regions[J].Image and Vision Computing,2004,22(10):761-767.

[11]FISCHLER M A,BOLLES R C.Random sample consensus:A paradigm for model fitting with applications to image analysis and automated cartography[J].Communications of the ACM,1981,24(6):381-395.