基于嘴巴特征点曲线拟合的哈欠检测*

谢国波,陈云华,张 灵,丁伍洋

(广东工业大学计算机学院,广东 广州 510006)

基于嘴巴特征点曲线拟合的哈欠检测*

谢国波,陈云华,张 灵,丁伍洋

(广东工业大学计算机学院,广东 广州 510006)

针对疲劳分析中哈欠检测具有嘴角点定位困难、嘴巴张开大小及持续时间因人而异的特点,提出一种基于嘴巴内轮廓角点检测与曲线拟合的哈欠检测方法。首先利用角点检测获取嘴巴内轮廓上的若干点,对这些点进行曲线拟合建立嘴唇内轮廓数学模型;然后再对张口度曲线进行时间维度的分析,对哈欠进行二次判决。实验结果表明,该方法不仅能够更精确地获取开口度的大小,而且还能够降低哈欠的误检率。

角点检测;轮廓提取;曲线拟合;哈欠检测

1 引言

哈欠是反映疲劳的重要特征,基于哈欠与眨眼检测的疲劳分析在智能交通领域拥有广阔的应用前景。目前,国内外进行哈欠检测的方法主要依据的是嘴巴的形态特征。Lu Yu-feng等[1]对两帧图像进行差分来定位人脸,通过检测鼻孔与下巴的距离来判断是否有哈欠产生。该方法在头部发生偏转的情况下,下巴难以准确定位,并且当摄像头与人的距离发生改变时,从图像上检测到的鼻孔与下巴的距离也会发生相应的变化,因而会产生误判。文献[2,3]先从单幅图像中分割出嘴巴,根据嘴巴张开区域的大小来检测哈欠。该方法仅考虑单幅静态图像中嘴巴的状态,没有考虑哈欠的时间特性,而且提取的张口形状是不规则图形,当头部发生倾斜时,不能有效地判断。Wang Tie sheng等[4]先定位两边嘴角,然后检测嘴唇的上下边界获取嘴巴的高宽比,并通过对张口度的分析判断哈欠的产生。该方法依赖于嘴角点定位的准确性,其中任何一个嘴角点定位不准确都会影响到检测结果;而且不同的嘴形和嘴唇厚度也会对结果产生一定的影响。此外,上述方法在判别哈欠时均未对张口的持续时间进行分析,导致短时间内或者瞬时的嘴巴张大(如惊讶时张大嘴)会被误判为哈欠。

针对上述方法中的不足,本文提出一种基于嘴巴特征点曲线拟合的哈欠检测方法。先对图像进行人脸检测和嘴巴粗定位;然后对嘴巴区域进行Harris角点检测,利用检测到的角点坐标拟合出嘴巴内轮廓曲线,计算张口度,得到张口度曲线和哈欠张口度阈值。对张口度曲线进行时间维度的分析,将结果分为哈欠、非哈欠和疑似哈欠,对于疑似哈欠的情况,根据哈欠、惊讶、大声喊话时张嘴的不同特点进行二次判决。实验结果表明,采用角点检测和曲线拟合方法提取嘴巴内轮廓能够获取到更加精确的张口度大小,对张口度曲线进行时间维度分析的哈欠二次判决方法能够提高哈欠检测的准确率,减少误判。

2 嘴巴内轮廓提取

2.1 人脸检测与嘴巴定位

在彩色视频图像中,肤色是区分人脸与非人脸的显著特征,因而也是人脸检测的最常用的特征之一。相对于RGB颜色空间,肤色在YCrCb色彩空间具有更好的聚类特性。采用文献[5]中的方法检测人脸,并获取嘴巴的粗略位置,然后利用文献[6]中给出的唇色模型,得到嘴巴区域的位置,嘴巴检测结果如图1所示。

Figure 1 Diagram of face detection and mouth location results图1 人脸检测与嘴巴定位结果

2.2 嘴巴角点检测

角点作为图像上的特征点,包含有重要的信息,对图像图形的理解和分析具有重要价值。由于角点特征具有旋转不变性和不随光照条件变化而变化的特点,利用角点检测嘴巴的内轮廓点,不仅准确而且结果稳定。

采用Harris角点检测算法[7]对嘴巴区域进行检测,主要步骤如下:

(1)设置高斯窗口函数:

其中,Ix、Iy分别为原始图像像素点在水平和垂直方向上的梯度。

(3)计算每个像素点的Harris角点响应函数:

其中,k为Harris算子的参数,一般取值为0.04~0.06,计算出的响应函数CRF所对应的极大值点就是图像的角点。嘴巴角点检测的结果见图2。

Figure 2 Diagram of mouth inner contour corner detection results图2 嘴巴内轮廓角点检测结果图

2.3 嘴巴内轮廓模型

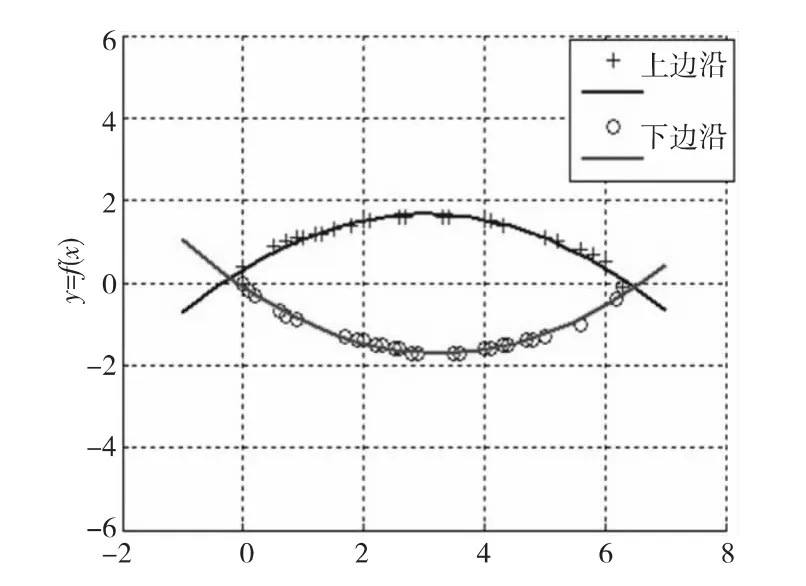

采用Harris角点检测可获取嘴巴内轮廓上角点的坐标,通过对这些坐标点进行曲线拟合可获取嘴唇的内轮廓曲线,从而更准确地计算张口度的值。嘴唇区域的Harris角点检测结果如图2所示。

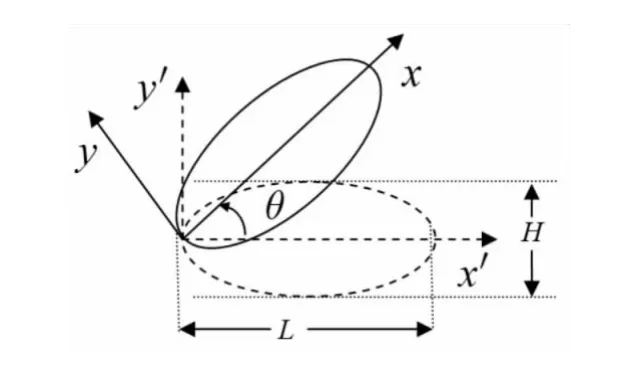

嘴唇的内轮廓形似抛物线,因而本文选取分段抛物线作为拟合曲线,采用最小二乘法获取嘴唇内轮廓线,建立相应的数学模型。由于Harris角点提供的坐标是基于图像像素点的坐标,因而角点坐标值受到图像尺寸的影响,在进行拟合前要对坐标进行相应的变换。本文以检测到的最左侧角点(x0,y0)为坐标原点,其它点的坐标均转化为该点的相对坐标,并以最左侧和最右角点坐标 (x0,y0)、(xn,yn)的连线为水平坐标轴创建坐标系,如图3所示。

设任意一点 (xi,yi)变换后的坐标为,),则有:

Figure 3 Mouth inner contour curves coordinate transformation diagram图3 嘴巴内轮廓曲线坐标转换示意图

其中,θ为嘴角连线相对水平位置的夹角,且:

当检测到两个嘴角的纵坐标相差很大时,表明头部产生了倾斜,此时需要根据公式(9)对检测到的嘴唇轮廓点进行坐标转换。

利用公式(7)完成坐标转换后,进行分段二次函数最小二乘曲线拟合得到嘴巴张开时的内轮廓曲线,如图4所示。其对应的数学模型如下:

其中,a1<0,a2>0,f1(x)对应上嘴唇内轮廓曲线,f2(x)对应下嘴唇内轮廓曲线。

Figure 4 Mouth inner contour curve fitting diagram图4 嘴巴内轮廓曲线拟合结果

3 哈欠检测

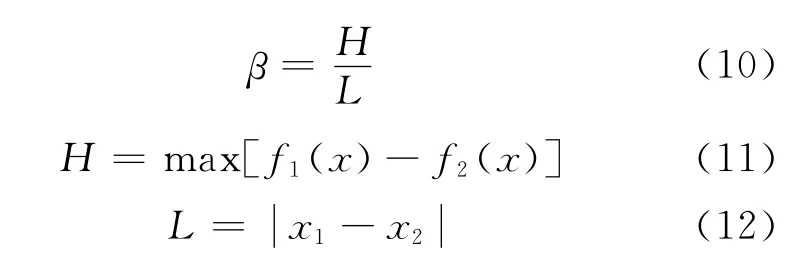

3.1 张口度曲线

人在打哈欠时,嘴巴最明显的特征就是张开的程度会变大,并且较大的张口度会维持一段时间。由于嘴唇内轮廓区域高宽比相对于嘴唇外轮廓高宽比更能够反映张口度的大小,因此本文依据嘴唇的内轮廓,给出张口度的定义为:嘴巴张开时,嘴唇内轮廓曲线所围区域的高度与宽度的比值为:

其中,H表示嘴巴张开的高度;L表示两个嘴角间的距离,如图3所示;x1和x2为上下嘴唇内轮廓曲线的交点的横坐标。对每一帧视频实时求取张口度即可生成张口度曲线。为了描述方便,将张口度随时间变化的曲线称为M曲线。

3.2 哈欠初次判决

已有的哈欠检测方法由于未考虑张口度持续时间,容易将瞬时张大嘴巴如惊讶等误判为哈欠,为此,本文在张口度阈值的基础上增加张口持续帧数的检测;同时,为了满足哈欠检测的实时性,本文的哈欠检测分两步进行:

第1步 根据张口度阈值进行哈欠初判;

第2步 对条件区域的哈欠进行二次判决。

现有哈欠检测的文献中并没有给出一个准确的哈欠阈值,本文张口度的阈值根据多次实验的经验值确定。张口度超过βT的持续帧数记为t。如果是由惊讶或者大声讲话所导致的瞬时嘴巴张大,张口度超过阈值的持续时间必然会很小,因此,可按照张口度超过阈值βT的持续帧数t进行哈欠初判。判决规则如下:

(1)当t∈ (0,T1)时,为非哈欠区。在此区域内的点表示嘴巴张大维持的时间短,可能是惊讶等表情引起的嘴巴瞬间张大。

(2)当t∈ [T1,T2)时,为条件哈欠区。在此区域不能直接判别是否产生了哈欠,需进行二次判决。

(3)当t∈ [T2,150)时,为绝对哈欠区。在此区域内嘴巴张大的持续时间长,因此可以判定为产生了哈欠。

其中,T1和T2的值根据多次实验的经验值确定,时间维度的哈欠判别区域划分如图5所示。其中,整个检测时间范围内张口度均未达到判决门限βT的被认为是嘴巴正常活动状态,如讲话等。

3.3 哈欠二次判决

对条件哈欠区的情况,需要进行二次判别。二次判别的依据是哈欠的过程比大声说话或瞬间张大嘴的过程要长,因此稍低于初次判决门限βT的张口度会持续更长的时间(对应于嘴小的人);而瞬时的张大嘴或大声说话时稍低于判决门限βT的张口度持续时间仍然很短。为此,取二次判决阈值为张口度,持续时间为T′,即已处于条件区域且满足张口度超过β′T的持续帧数在T′以上时,才被判定为产生了哈欠,否则未产生哈欠。

Figure 5 Yawning discrimination zoning in time dimension图5 时间维度的哈欠判别区域划分

4 实验结果与分析

选择不同性别、不同年龄的192名测试者,在实验室和驾驶室分别进行视频采集。测试者的年龄和性别的分布如表1所示。测试者在录制视频时,可以打哈欠、讲话、面露惊讶的表情,头部可以倾斜、扭转,靠近或者远离摄像头,每人至少打一次哈欠,有一次惊讶张嘴,讲话若干。选取180段视频进行哈欠检测:至少包含了一次哈欠的视频共60段,至少包含了一次惊讶张大嘴的视频共60段,无哈欠也无惊讶张嘴的视频共60段。经过多次反复实验得出:典型的哈欠是张口度超过0.65,且持续帧数大于或等于25帧;对少数嘴较小的测试者的哈欠是张口度超过0.5,且持续帧数大于或等于125帧;由于惊讶等导致的瞬时张大嘴,开口度大于0.65的持续时间不超过25帧;由于惊讶等导致的瞬时张大嘴,开口度大于0.5的持续时间不超过125帧。因而,取哈欠初次判决的开口度阈值βT=0.65,持续时间阈值为T1=25帧,T2=75帧,二次判决的开口度阈值β′T=0.5,条件哈欠区开口度超过β′T的张口持续时间阈值为T′=125帧。

Table 1 Age distribution of the testers表1 测试者年龄分布

(1)内轮廓角点拟合与嘴唇边界获取张口度的对比实验。

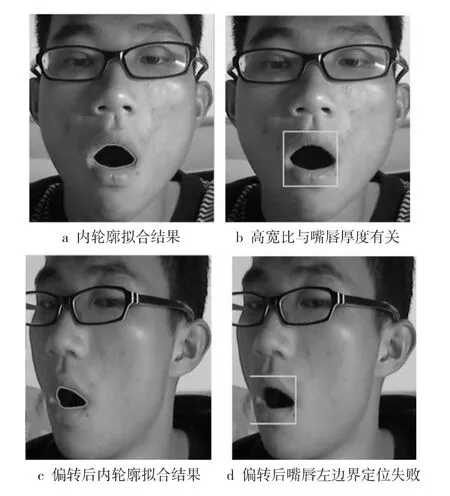

为了说明采用内轮廓角点拟合方法计算嘴唇内轮廓获取张口度的优越性,给出本文方法与文献[4]中的方法对比实验,如图6所示。文献[4]中计算张口度的方法是现有张口度计算方法的代表,该类方法在利用人脸比例关系粗定位嘴唇的检测范围后,采用梯度积分投影和唇色模型结合的方法定位嘴唇的上下左右边界,从而获取张口高宽比。该类方法存在的不足是:(1)张口度的计算会受到嘴唇厚度的影响,如图6b所示;(2)当被测者头部存在较大角度偏转时,嘴唇的左右边界容易检测失败,如图6d所示。

Figure 6 Comparison of mouth open degree obtained by inner contour curve fitting and mouth border detection图6 嘴唇内轮廓拟合与边界获取张口度的对比

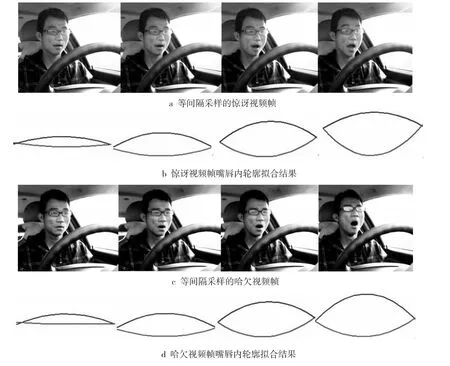

(2)瞬时张大嘴与哈欠的对比实验。

图7是包含了一次由惊讶导致的瞬时嘴巴张大和一次张口度较小的哈欠,其中A段对应一次惊讶时的突然张嘴,B段对应一次张口度较小的哈欠。由图7可看出,若仅用张口度阈值βT进行判别,则A段被误判为哈欠;若用张口度βT加上超过βT的持续时间t进行判别,A段不会被误判,同时,B段则被判为条件哈欠区的哈欠,需要进行二次判决。二次判决时,采用的张口度阈值为β′T,持续时间阈值为T′,经过二次判决后,B段被判定为哈欠。

对应的视频帧及嘴唇内轮廓曲线拟合结果如图8所示。由图8可知,惊讶时张嘴与哈欠时张嘴的大小区别不大,仅用张口度阈值是很难将二者区别开的。但是,惊讶时张大嘴的持续时间明显要短于哈欠,因而可利用该特点将如惊讶等的瞬时张大嘴的情况与哈欠区别开来。

对图8所示的惊讶时张大嘴的视频,利用本文

Figure 7 Mouth open degree curve containing a yawning and an instant mouth opening图7 包含了一次瞬时张嘴和哈欠的张口度曲线

方法与其他文献中的方法进行哈欠检测,检测结果如表2所示。

Table 2 Experimental results of mouth open caused by surprising misjudged as by yawning表2 惊讶张口被误判为哈欠的实验结果

从表2可看出,本文结合张口度与持续时间根据张口度曲线对哈欠进行二次判决,能区分出瞬时的嘴巴张大的情况,从而降低哈欠的误检率。

(3)总的检测结果对比。

各种方法检测率如表3所示。从表3可看出,本文对哈欠的误判和漏判率均低于其他文献中的方法。

Figure 8 Video frames and their inner contour curve fitting result of surprising and yawning图8 惊讶和哈欠对应的视频帧及其内轮廓拟合结果

Table 3 Yawning detection rate of different methods表3 不同方法的哈欠检测率 %

5 结束语

本文根据打哈欠时嘴巴具有张口度大和持续时间较长的特点,针对现有哈欠检测方法的不足,提出一种基于嘴巴内轮廓角点拟合的哈欠检测方法。由于角点拟合综合考虑了多个嘴唇轮廓点的信息,利用角点坐标拟合嘴唇的内轮廓曲线,相对于仅仅依赖少数几个点进行嘴角和上下嘴唇边界定位来计算张口度的方法,结果更加可靠和准确;对于存在大角度头部扭转的张口度,依靠嘴唇边界计算张口度的方法会失效,但本文方法则仍然可以得到与真实张口度足够近似的值;利用张口度和张口持续时间进行二次哈欠判决,先区分最易判别的状态,对其它不易判别的情况进行二次判决,可有效地将哈欠与其它各种瞬时张大嘴的情况区别开。该方法也存在着一定的不足,拟合与二次判决在提高判决准确性的同时,也影响检测的速度,每秒处理帧数约25帧,但仍能满足实时检测的需要。

[1] Lu Yu-feng,Wang Zeng-cai.Detecting driver yawning in successive images[C]∥Proc of the 1st International Conference on Bioinformatics and Biomedical Engineering,2007:581-583.

[2] Abtahi S,Hariri B,Shirmohammadi S.Driver drowsiness monitoring based on yawning detection[C]∥Proc of IEEE Instrumentation and Measurement Technology Conference,2011:1-4.

[3] Omidyeganeh M,Javadtalab A,Shirmohammadi S.Intelligent driver drowsiness detection through fusion of yawning and eye closure[C]∥Proc of IEEE International Conference on Virtual Environments Human-Computer Interfaces and Measurement Systems,2011:1-6.

[4] Wang Tie-sheng,Shi Peng-fei.Yawning detection for determining driver drowsiness[C]∥Proc of the IEEE International Workshop on VLSI Design & Video Technology,2005:373-376.

[5] Zhao Ming-hua,You Zhi-sheng,Mu Wan-jun,et al.Face detection based on skin color segmentation,mathematical morphology and geometry[J].Journal of Sichuan University(Natural Science Edition),2005:42(3):617-620.(in Chinese)

[6] Liew A W C,Leung S H,Lan W H.Segmentation of color lip image by spatial fuzzy clustering[J].IEEE Transactions on Fuzzy System,2003,11(4):542-549.

[7] Rabi G,Si Wei-lu.Energy minimization for extracting mouth curves in facial image[C]∥IEEE International Conference on Intelligent Information Systems,1997:381-385.

附中文参考文献:

[5] 赵明华,游志胜,穆万军,等.基于肤色分割、数学形态学和几何方法的人脸检测[J].四川大学学报(自然科学版),2005,42(3):617-620.

Yawning detection based on mouth feature point curve fitting

XIE Guo-bo,CHEN Yun-hua,ZHANG Ling,DING Wu-yang

(College of Computer,Guangdong University of Technology,Guangzhou 510006,China)

In yawning detection for fatigue analysis,it is difficult to get the exact location of the two mouth corners,the open size and open duration varies for different individuals.For this problem,it proposes a yawning detection method based on mouth inner contour corner detection and curve fitting of those corner points.Firstly,several points are located on the contour of the mouth by corner detection.Secondly,the mathematical model of the mouth inner contour is established by curve fitting to those points.Thirdly,the mouth openness curve is analyzed in the time sequence to identify the yawning twice.Experimental results show that this method can obtain more precise mouth openness,and reduce false detection rate of yawning.

corner detection;contour extraction;curve fitting;yawning detection

TP317.4

A

10.3969/j.issn.1007-130X.2014.04.027

2012-08-27;

2012-12-30

广东省教育部产学研项目(2012B091000058);广东省重点实验室建设专项项目(2011A091000046)

通讯地址:510006广东省广州市广州大学城广东工业大学计算机学院计算机工程系

Address:Department of Computer Engineering,College of Computer,Guangdong University of Technology,Guangzhou 510006,Guangdong,P.R.China

1007-130X(2014)04-0731-06

谢国波(1977-),男,广东五华人,博士,副教授,CCF会员(E200031488M),研究方向为计算机视觉和精神疲劳监测。E-mail:guoboxie@163.com

XIE Guo-bo,born in 1977,PhD,associate professor,CCF member(E200031488M),his research interests include computer vision,and mental fatigue monitoring.

陈云华(1977-),女,湖北仙桃人,博士生,讲师,研究方向为计算机视觉、精神疲劳监测和可拓检测。E-mail:chenyh_winy@163.com

CHEN Yun-hua,born in 1977,PhD candidate,lecturer,her research interests include computer vision,mental fatigue monitoring,and extension detection.

张灵(1968-),女,广西合浦人,博士,教授,研究方向为智能控制技术、数字信号处理和自动化装备。E-mail:june4567@21cn.com

ZHANG Ling,born in 1968,PhD,professor,her research interests include intelligent control technology,digital signal processing,and automation equipment.

丁伍洋(1988-),男,湖北咸宁人,硕士生,研究方向为嵌入式系统开发和图像处理。E-mail:dingwuyang0902@sina.com

DING Wu-yang,born in 1988,MS candidate,his research interests include embedded system development,and image processing.