一种基于DWT 通道分离和函数提取的运动目标检测新方法

张秋艳,何明一,毕凯凯

(西北工业大学 电子信息学院,陕西 西安710072)

近来,智能视频监控[1]成为人们关注的热点之一,它涉及图像处理、模式识别、计算机视觉等诸多技术。而运动目标检测[2]作为智能视频监控中的重要环节也得到学者的持续研究。

智能视频监控中的运动目标检测主要分为3类[3]:光流法、帧间差分法和背景差分法。光流法检测效果较好,但计算耗时难以满足视频监控实时性的要求,且收敛速度依赖于场景、运动形态和噪声。帧间差分法不易受光线变化影响,检测稳定有效,但易出现虚假和空洞目标。背景差分法适合于摄像机静止的情形,需要建立准确的背景模型,优点是检测速度快,但真实场景复杂多变,建立的背景难以自适应的更新。

利用DWT(Discrete Wavelet Transform,离散小波变换)显著降低图像噪声[4]和分层次提取图像信息以及YCbCr空间具有把颜色亮度和色调分量分离的优势[5],本文在图像小波变换后分别在YCbCr三通道检测目标,再和函数提取法检测[6]的结果融合,实现运动目标检测。

1 原理与方法

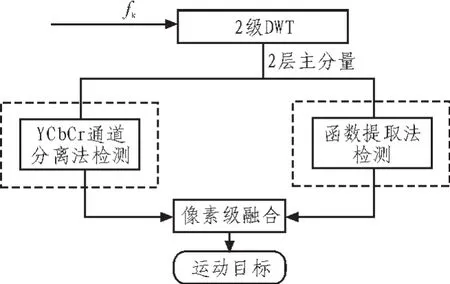

本文的运动目标检测方法主要包括视频序列的预处理、背景建立、差值决策、通道分离结果的融合和图像后处理以及DWT通道分离结果和函数提取法结果的融合,其中图像预处理和通道分离为本算法的重点。算法流程图如1所示。

图1 本文算法流程图Fig.1 Frame chart of moving target detection

其检测步骤是:

1)对视频帧进行去噪处理包括直方图均衡和中值滤波;

2)对视频帧进行2级小波变换,提取2层主分量LL2[k];

3)对每帧均进行RGB到YCbCr色彩空间转换,并用自适应更新的均值法[7]建立背景;

4)采用背景帧差法求取每通道的差值图像,对差值图像Otsu[8]二值化即三通道运动目标的初始轮廓。

5)采用投票决策法对每帧相应的像素点进行3选1,融合得到通道分离的最终目标轮廓。

6)DWT通道分离结果和函数提取法结果融合,得到本文最终的检测目标结果。

1.1 图像预处理

随着计算机网络的发展,传输彩色高清图像和视频的需求日益突出。彩色图像比黑白图像包含了更多视觉信息,如色调,饱和度,同时大大增加了网络传输的压力。本文在预处理中采用DWT和通道分离法,利用YCbCr空间优势,减少数据冗余,降低计算和存储成本。

1.1.1 小波变换

小波分析的应用和成熟的小波理论紧密联系在一起的,它是泛函数、傅里叶分析、调和分析和数值分析的完美结晶。小波变换是时域和频域的局部变换,具有多分辨率分析(Multi-resolution Analysis)的特点。由于小波变换子带的某一位置和其相应的不同频率的子带具有相似的空间信息,使其在图像处理领域得到广泛的应用,如图像压缩,去噪。

如图2所示,二维DWT能够把一幅图像分解为4个不同子带图像,即LL1、LH1、HL1以及HH1,不同子带图像反映了图像不同频率的信息。二维DWT的二级分解如图3所示,一级分解的低频部分(LL1)被再次分解成LL2、LH2、HL2以及HH2,二级低频部分LL2包含了图像的基本信息。类似地,LL2还可进行三级分解。本文利用二级小波变换减少计算量和降低噪声,并采用二级主分量(LL2)进一步建立背景,检测目标。

图2 二维DWT分解结构Fig.2 The structure of a forward 2-D DWT

图3 2级DWT子带Fig.3 Sub-band of DWT

1.1.2 颜色模型

颜色模型是用来精确度量和生成其它各种颜色的一套规则和定义。颜色模型通常用多维坐标系统来表示空间中的单个像素点,整个空间可以表示颜色域的所有色彩,以此来方便的指定需要的颜色。颜色模型主要有 RGB、HSI、YCbCr、CMY等。通常,颜色模型可以划分为两大类,面向彩色图形显示设备的如RGB模型;和人的直观色彩感知相一致的如HIS、YCbCr模型,本文采用YCbCr颜色模型。

1)RGB颜色模型

RGB模型是电子显示领域的标准颜色,用R(红)、G(绿)、B(蓝)三种颜色的值来表示颜色分量,三原色相加实现颜色的合成,即混色。RGB颜色模型对应的三维坐标系统如图4所示的颜色立方体,所有的色彩均已归一化到[0,1]范围内。黑色坐标为[0,0,0],白色坐标为[1,1,1]。

图4 RGB颜色模型的坐标系统Fig.4 The coordinate system of RGB color model

2)YCbCr颜色模型

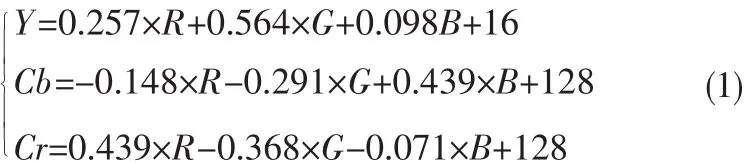

YCbCr颜色模型具有与人类视觉感知相类似的构成原理,是YUV压缩和偏移的一种相对颜色空间,能够将图像的亮度信息分离出来,是JPEG、MPEG、摄像机和数字电视普遍采用的颜色格式,和RGB空间相比,YCbCr更符合人眼视觉特性,三通道关联性小,表示形式相比HIS简单。硬件支持的RGB空间到YCbCr 空间的转换为线性变换如下:

1.2 DWT通道分离法检测

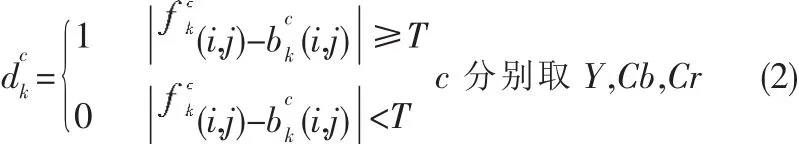

对视频序列中第帧进行2级DWT,然后对其2级主分量包含信息的图像进行RGB到YCbCr空间转换,得到三通道图像,并分别与背景帧相减如公式(2)所示。

1.3 DWT通道分离法和函数提取法结果的融合

通道分离法像素级融合后得到的初始轮廓存在噪声和不完整的边缘,通过图像数学形态学的恢复和噪声消除等图像后处理,能得到较完整的目标轮廓。但是有时行人运动的不规则性,导致整体录像不清晰,提高快门速度,减少曝光,使得视频序列灰度降低。提取函数法能够在灰度值较低的场景中取得满意的目标检测效果。为了进一步提升目标检测的精度,我们进一步结合提取函数法和通道分离法的像素级融合来获取精确的目标。

图5 DWT通道分离法流程图Fig.5 Flow chart of DWT channel separation

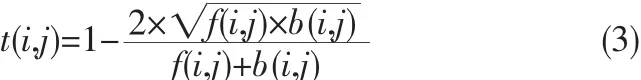

设坐标为(i,j)的待检测图像帧为f(i,j),当前背景灰度为b(i,j),其取值范围均为[0,255]。则坐标点(i,j)的提取函数计算方法为公式(3)。

由定义可知其取值范围为[0 1]。对提取函数二值化,如公式(4)所示。

式中,t1为设定的阈值。由t(i,j)的变化趋势,t1=0.03分割目标错误率最小。当背景灰度和当前帧灰度相同时,t(i,j)为0。当f(i,j)和b(i,j)差值增大时,t(i,j)随之增大,即检测为运动目标。当b(i,j)=5时,t(i,j)变化较快,可知在低灰度区间,该方法也能很好的区分背景和前景,从而忽略中高灰度区间的变化。提取函数法可以依据灰度背景自适应的调整图像灰度的差值,精确地提取低灰度的目标,弥补了帧差法的不足。进一步分析表明,提取函数法能够根据图像的灰度状况自适应的提取运动目标,以此来解决低灰度区漏检的现象。

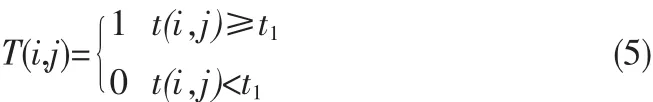

通道分离法充分利用了图像的三通道信息提取物体的轮廓,提取函数法在低灰度区间具有良好的检测特性。通过实验验证,DWT通道检测的结果和提取函数法检测的结果具有互补的特点,本文采用二者像素级的融合,即二者结果的对应像素点只要有一个为1,则该点判定为1,否为判定为0,可获取较好的目标轮廓。对视频流中的第k帧图像,其融合规则为式(5)。

其中Dk(i,j)为第k帧DWT通道分离法的检测结果,Tk(i,j)为第k帧提取函数法检测的结果,Ok(i,j)为融合后的结果。

2 实验结果与分析

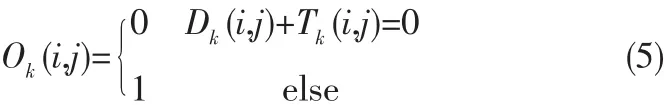

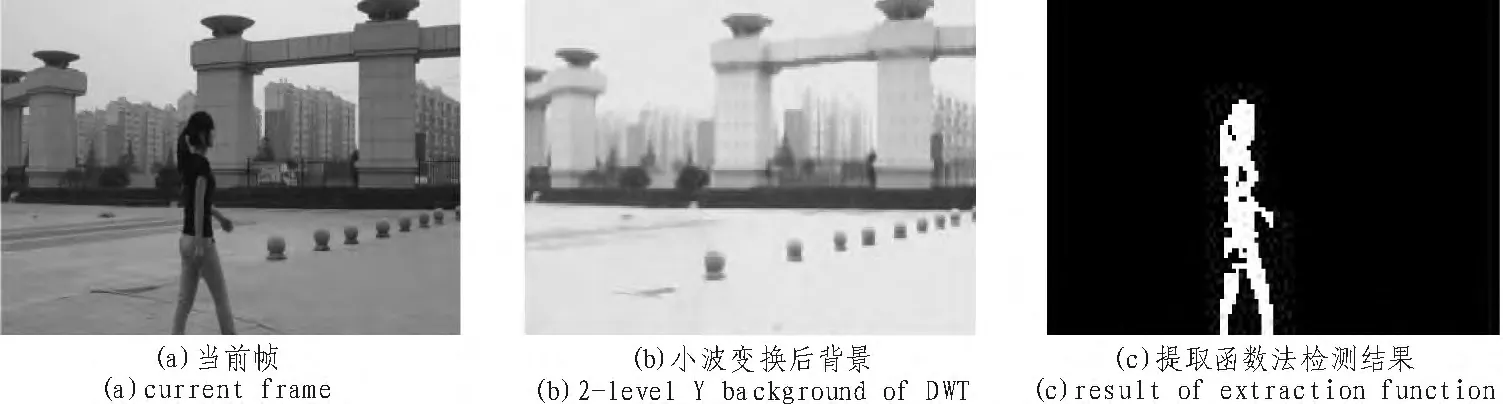

本文实验环境为Intel(R)Core(TM)i5-2400 CPU,主频为3.10 GHz,实验软件为Matlab 2010a。实验视频为实验室利用三角架固定相机拍摄的西北工业大学校园,视频格式为.avi,分辨率为 720*576,时长 13 s,帧率 25 fps。 图 6、图 7和图 8为实验结果图。

图6 DWT通道分离检测法Fig.6 Detection of DWT channel separation

图7 提取函数检测图Fig.7 Detection of extraction function

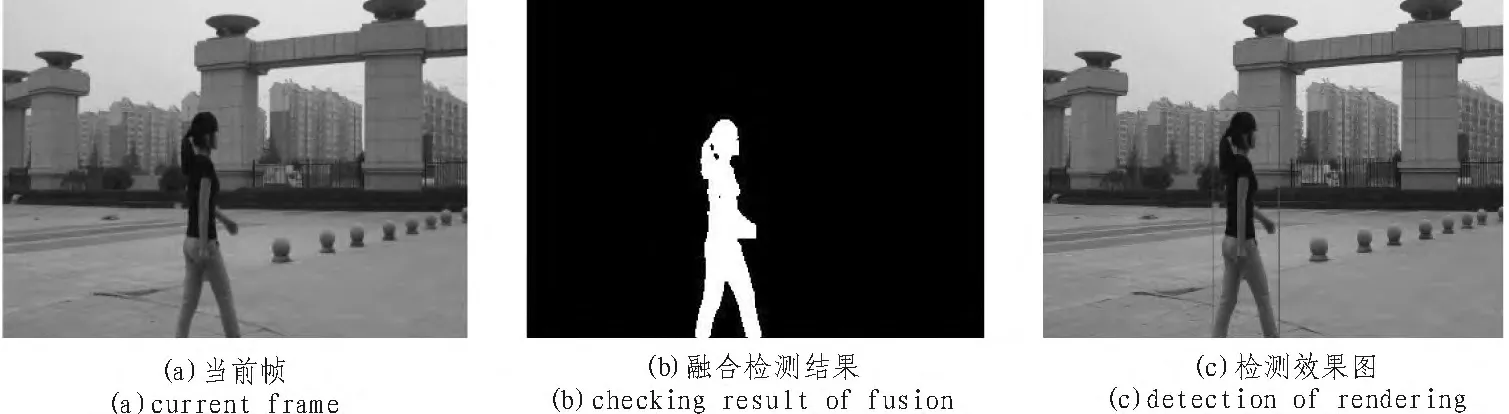

图8 通道分离法和提取函数法融合效果图Fig.8 Fusion effect of channel separation and extraction function

由图6可知,三通道分离法能够较好的检测到运动目标,同时抑制小的背景干扰,如背景中运动的小狗和通过的汽车,二值图像经过处理包括图像恢复,行列的扫描填充和形态学滤波后,轮廓较清晰。函数提取法在低的对比度下能够取得较好的检测结果,和三通道提取法像素级融合后的目标如图8所示。本文提出的方法能够快速准确的检测出运动目标,受噪声影响较小。

为了定量分析本文算法的时间复杂度,与在预处理中没有利用DWT的原始检测方法做了对比。两种方法的每帧检测所需时间如表1所示。

表1 本文算法与没有利用DWT的原始检测算法计算时间对比Tab.1 Computing time comparison of proposed algorithm with the original algorithm

由表1知,本文的算法计算量较少,速度较快,检测精确度较高,基本能满足智能视频监控中目标检测的要求。

3 结束语

本文提出将DWT算法应用到智能视频监控的目标检测算法中,使得图像高频噪声得到消除,同时大大的减少了计算量,二层主分量包含有图像的主要信息,对以后的目标检测提供足够的信息。同时充分利用YCbCr的亮度和色差信息,采用背景差分法较好的检测目标轮廓。结合提取函数法低对比度下的检测特性,使通道检测结果和提取函数法检测的效果图像素级融合,融合图像较好的显示目标轮廓。由实验结果得知,该方法计算量较少、速度较快,检测的目标轮廓较完整。

[1] Held C, Krumm J, Markel P, et al. Intelligent videosurveillance[J].Computer,2012,45(3):83-84.

[2]Corbetta M,Kincade J M,Ollinger J M,et al.Voluntary orienting is dissociated from target detection in human posterior parietal cortex[J].Nature Neuroscience,2000,3(3):292-297.

[3]汤宁,何明一.视频监视中运动物体检测的一种新算法[J].电子测量技术,2007,30(10):45-48.TANG Ning,HE Ming-yi.New algorithm of moving objects detection for video surveillan [J].Electronic Measurement Technology,2007,30(10):45-48.

[4]Youssef S M,Hamza M A,Fayed A F.Detection and tracking of multiple moving objects with occlusion in smart video surveillance systems[C]//.5th IEEE International Conference on Intelligent Systems,2010:120-125.

[5]Shajeena J,Ramar K.A novel way of tracking moving objects in video scenes[C]//.Proc.of 2011 International Conference on Emerging Trends in Electrical and Computer Technology(ICETECT).IEEE,2011:805-810.

[6]刘晓东,苏光大,周全,等.一种可视化智能户外监控系统[J].中国图像图形学报,2000,5(12):1024-1029.LIU Xiao-dong,SU Guang-da,ZHOU Quan,et al.A visual intelligent outdoor surveillance system[J].Chinese Journal of Image and Graphics.2000,5(12):1024-1029.

[7]杨茂清.车辆检测技术研究[D].北京:北京交通大学,2012.

[8]Ronggui H M L M W.Application of an improved Otsu algorithm in image segmentation [J].Journal of Electronic Measurement and Instrument,2010,24(5)443:449.