深度信息辅助的均值漂移目标跟踪算法

宋康康,陈 恳,郭运艳

宁波大学 信息科学与工程学院,浙江 宁波 315211

深度信息辅助的均值漂移目标跟踪算法

宋康康,陈 恳,郭运艳

宁波大学 信息科学与工程学院,浙江 宁波 315211

1 引言

Mean Shift算法是一个自适应步长的迭代算法,已经成功地应用于图像分割,无参数密度估计,视频跟踪等诸多领域[1-5]。自从该算法引入视频目标跟踪以来,在算法复杂度和时间开销上,都要优于Kalman滤波算法和粒子滤波算法,因此受到了广泛的关注。经典Mean Shift算法利用空间核加权颜色直方图作为模板,通过搜索局部巴氏系数最大值,最终实现目标跟踪定位。颜色直方图是对图像在颜色空间中分布的一种简单的非参数估计,描述了图像的全局统计特征,具有旋转和平移不变性,而且特征提取方便,因此常常作为特征模型广泛应用于图像检索和目标跟踪之中。但是由于颜色信息容易受到外界光照条件变化或者目标视角改变而发生变化,导致其不稳定。而基于核函数的Mean Shift跟踪算法受颜色特征不稳定性的影响,效果就会大打折扣,实际应用范围就被限制了。

针对此问题,许多学者提出了许多改进方法,例如边缘特征辅助颜色特征[6],提升颜色直方图抗噪声能力,但是在发生部分遮挡时,算法就会失效。通过削弱目标颜色直方图中的背景噪声,减小了Mean Shift算法对目标定位的影响[7],但是未解决带宽固定的问题[8]。修正了背景直方图加权算法(Corrected Background-Weighted Histogram,CBWH),通过降低参考模板的背景颜色特征信息,从而突出目标的特征信息,提高算法的稳定性和鲁棒性[9]。对候选目标区域进行直方图插值,加强了目标在直方图中影响,较好解决了小尺寸目标的跟踪问题[10]。利用模糊颜色直方图克服光照变化下颜色特征不稳定的弱点。

近些年,用深度信息辅助目标提取、跟踪已经越来越受到学者的关注[11-13],本文从目标的深度信息特征出发,根据目标与周围背景处于不同的深度平面,利用深度信息对目标参考模板进行加权(Depth assisted Background-Weighted Histogram,DBWH),对核窗口内距离目标较远的颜色特征赋予较小的权值,并采用背景直方图加权算法[8],在刻画目标的颜色特征信息的同时,也降低了背景中的干扰信息。这样目标的特征信息就不会淹没在嘈杂的背景信息中,即使目标尺寸相对于核窗口较小时,同样能够放大其特征信息,实现跟踪算法的鲁棒性和稳定性。

2 Mean Shift算法

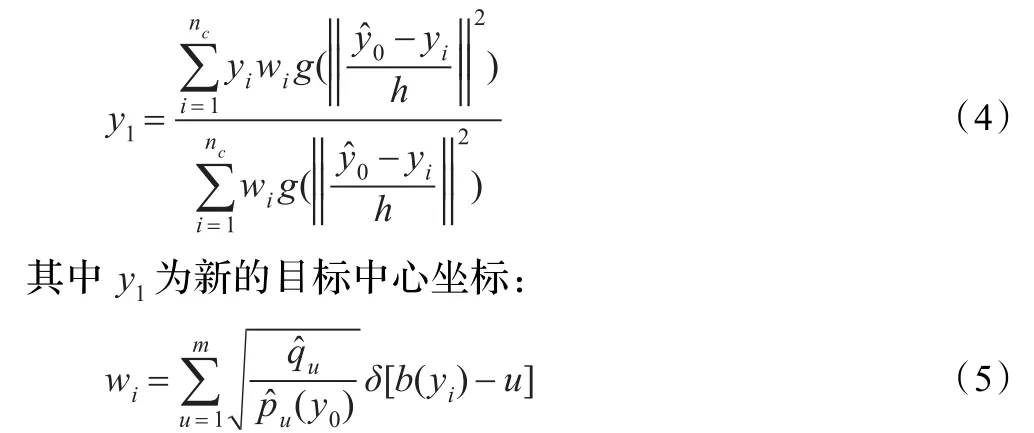

Mean Shift是一个高效的目标定位算法。下面简单介绍下Mean Shift算法。算法开始将目标模型初始化为加权直方图的形式其中:

Ch是归一化系数,h是核带宽,x0是中心像素坐标,xi是跟踪窗口中第i个像素,共有n个像素,k(x)是非增、连续的核函数,b(xi)将颜色特征映射到对应的直方图空间。当以 y为中心时,候选目标模型可以按如下的式子建立,其中:

度量候选模型与参考模型之间的相似性,使得巴氏系数最大时的y可通过Mean Shift算法迭代获得:

y0是当前候选目标区域的中心位置,则基于Mean Shift算法的目标跟踪通过反复地迭代式(4),使目标从当前 y0不断地移到新位置 y1,直至Bhattacharyya系数最大或者达到规定的迭代次数为止,得到的y1即Mean Shift偏移得到的跟踪窗口的新的中心坐标。

3 深度信息简介

1976年,Marr[14]建立了模拟人类立体视觉机制的匹配算法,为双目视觉奠定了基础。双目立体视觉技术是指通过对同一物体从不同角度获得的两幅图像来恢复物体的三维信息的过程。双目立体视觉技术主要包括图像获取、摄像机标定、特征图像匹配以及三维信息恢复等方面。获取场景中各点相对于摄像机的距离是立体视觉的重要任务。场景中各点相对于摄像机的距离可以用深度图来表示,即深度图中的每一个像素值表示场景中某一点与摄像机之间的距离。

图1[15]假设C1和C2两个摄像机的焦距相等,各内部参数也相等,两个摄像机光轴互相平行,x轴互相重合。设C1坐标系为O1x1y1z1,C2坐标系为O2x2y2z2,空间点P(x1,y1,z1)的坐标在C1坐标系下为(x1,y1,z1),C2坐标系为(x1-b,y1,z1)。则空间点映射到图像平面上的关系为:

其中 u0,v0,αx,αy为摄像机内部参数[16],b为基线长度,u1-u2为视差。 (u1,v1)1,(u2,v2)分别是 p1与 p2图像的坐标。P点到基线中心的距离即为深度,可以通过三角测量计算。在平行双目相机各个参数确定后,再校正摄像机,将双目相机拍摄的左右通道的图像,通过图像匹配获得视差数据,最后经三角测量将视差数据转换为距离,并量化为0~255之间的数值,形成明暗效果的深度图。

图1 平行双目相机配置

4 基于深度信息的颜色直方图加权

4.1 参考模板的颜色直方图加权

在传统Mean Shift算法中,通常用的核函数是高斯核函数或Epanechnikov等一类剖面函数,这些函数都是单峰的、有限局部支撑的,这些性质决定了在参考模板建立时,会给予核窗口中心的像素比较大的权值,这样做的优点是目标被部分遮挡时,通常核窗口中心的像素会比较可靠,边缘遮挡部分也可以抑制住。核函数的这些特点使得算法能够处理局部遮挡的情况。然而在目标未被遮挡时,由于目标外部尺寸不规则,核窗口通常为规则的椭圆或矩形,因此或多或少地会引入背景信息,所以核窗口中心加权不够精细。核窗口内的所有信息都会被统计到目标的直方图中,若核窗口过大,目标的信息就会被严重冲淡,使得目标与周围背景的区分度下降,直接导致跟踪性能大幅度下降。因此必须抑制核窗口内的干扰信息,突出目标本身信息特征。

基于背景直方图加权是一种有效地将核窗口干扰信息降低的方法,其借助统计目标周围的背景信息来抑制背景干扰信息对颜色直方图中的影响,突出目标中不同于背景中特征信息,抑制目标信息中与背景相似的成分。本文将利用此方法结合深度信息对目标参考模板的颜色直方图进行加权。

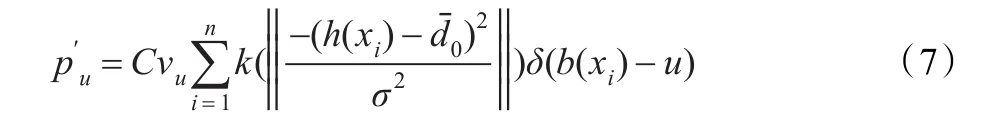

假设核窗口中,有n个像素,分布用{xi}i=1,2,…,n表示,δ(x)是Delta函数,特征值bin值有m个,目标特征值u= 1,2,…,m的概率密度为:

其中C是归一化常数,h(xi)是xi像素处的深度值是当前第0帧中目标的深度平均值,σ是目标深度的方差值,vu=min(/,1),u=1,2,…,m,其中为目标周围两倍核带宽大小范围内的背景颜色直方图,可由式(1)计算得到的非零最小值。候选目标模型仍按式(2)计算。深度信息的引入使得核窗口内的数据采样依据深度的不同而支配不同的权值,背景中与目标深度相差较大的,其信息将被极大地抑制住,即使目标周围的干扰信息也被不同程度地抑制,原因是充分考虑目标与背景处于不同深度层面的特性,并用此特性来强化目标的颜色特征信息。再通过背景直方图加权算法,降低目标特征中的背景特征成分,使得颜色特征更加具有更高的区分度。

4.2 核带宽自适应更新

核带宽问题是影响Mean Shift算法跟踪精度的重要原因,由于在目标尺寸变化剧烈时,固定不变的核带宽会导致候选目标模型的不准确,目标尺寸变小时,会引入较多背景干扰信息;较大时,采样不够充分,都会导致定位偏差。常用到的带宽更新方法为试探法[17],变换法[18],但是时间代价较高,本文提出了基于深度信息的带宽自适应更新法。首先定义背景交叠系数:

Cn是第n帧中核带宽中总的像素数目,是对应像素灰度值在[-δ,+δ]的像素总数,δ是目标整体深度信息的方差值,可以在第一帧选目标时确定,是目标的平均深度信息。若0.8<ρn<0.9说明目标尺寸占据核带宽的绝大部分,带宽大小合适,故无需更新,反之则按下面的公式更新:

当 ρn<0.8时,说明核带宽尺寸过大,因此要适当减小核带宽尺寸;而当 ρn>0.9时,此时核带宽尺寸过小,要适量增大其尺寸。对不规则变化的目标尺寸能够自适应调节带宽,使得核窗口带宽自适应更新。

5 实验结果

为验证本文算法的有效性,首先构造了一个大小为40×40绿色虚拟目标,目标中心坐标为(150,150),同时构造了背景区域灰度值为180,目标内部区域为从130到170连续变化的灰度深度图,设定跟踪起始位置为(125,125),核带宽大小为44,核函数为高斯函数,颜色直方图的bin数量为16×16×16。用Matlab7.0进行编程测试,分别比较了CBWH算法,传统Mean Shift算法和本文算法的跟踪结果。

5.1 虚拟目标实验对比

目标颜色特征组成为绿色成分,其pdf量化后会集中在特征空间值为125左右。从建立的参考模板的概率直方图中可以看到,本文算法的特征空间主要集中于125左右,由于核带宽略大于目标尺寸,因此传统Mean Shift算法的参考模板中混入了白色的背景信息,其特征值在4 000后,而本文算法利用深度信息加权抑制了白色的背景干扰信息。

从表1中的跟踪结果比较可以看出,本文算法不仅迭代次数相对较少,而且定位结果相当准确。巴氏系数比较小是因为候选目标模型中未使用背景直方图加权,原因已经在文献[8]中证明。

图2 虚拟目标

图3 虚拟模板颜色直方图比较

表1 跟踪性能比较

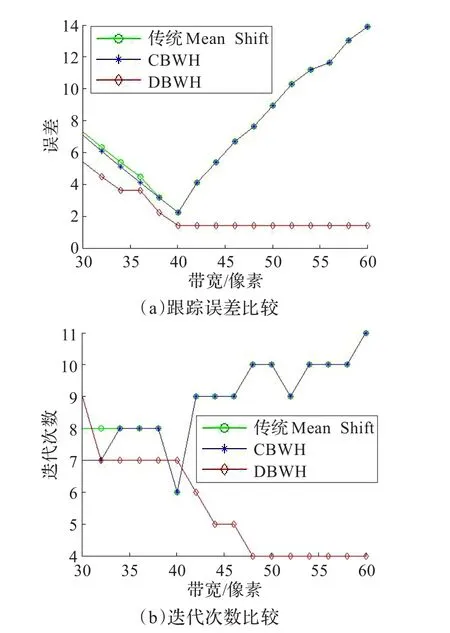

5.2 虚拟目标在不同带宽下跟踪结果比较

图4将传统Mean Shift算法与CBWH,DBWH在不同带宽情况下,分别比较跟踪定位准确性和迭代次数。可以从图中看出,DBWH在相同带宽情况下,不仅定位误差小而且迭代次数少,而CBWH在简单场景中退化为传统Mean Shift算法。综上可以推知,核带宽的合适与否很大程度上影响了目标跟踪定位精准性。在带宽逐渐变大时,同时本文算法考虑了目标与背景处于不同的深度平面,并用深度信息对目标颜色特征加权,抑制了背景中的干扰信息,从而保持了跟踪定位的准确性。

图4 不同带宽下跟踪性能比较

5.3 真实场景对比实验

利用Kinect深度相机拍摄视频进行实验,选取了一段小球尺寸由大变小的视频,共计80帧,分彩色图像和对应的深度图像两组可以观察到传统Mean Shift算法在目标逐渐变小时,算法性能在下降,最终跟踪窗口偏离了中心。而CBWH算法消除了背景信息的一些影响,使得跟踪算法在一定程度上受背景信息影响比较小,跟踪效果稍好;但是由于CBWH在初始化模型时对周围背景信息抑制不够充分,会残留许多目标周围背景信息,因而在跟踪框内出现同目标颜色信息特征相似的物体时,会受到比较大的影响,导致跟踪框偏向干扰物体。而本文算法在经深度加权后,极大保留目标特征,同时能够自适应更新核带宽,取得了良好的跟踪定位效果。

图5 跟踪定位比较(第1、52、78帧)

6 总结

本文利用目标和背景处于不同的深度平面的特点,用深度信息和背景信息对颜色直方图加权后,前者增强了颜色特征信息在背景中的区分度,后者降低了背景信息的干扰,同时也自适应地更新了核带宽,空间定位更加准确,迭代次数更少。

本文算法应用了深度信息,导致了一些局限性。由于现在的深度相机所取的深度范围有限,如果目标景深太大,深度信息可能无法得到。受现有技术的限制,本文算法现在适合做近距离视频交互时的目标跟踪。

[1]Georgescu B,Shimshoni I,Meer P.Mean shift based clustering in high dimensions:a texture classification example[C]// IEEE International Conference on Computer Vision,2003,2:456-463.

[2]Comaniciu D,Meer P.Mean shift:a robust approach toward feature space analysis[J].IEEE Trans on Pattern Anal Mach Intell,2002,24(5):603-619.

[3]Collins R.Mean shift blob tracking through scale space[C]// IEEE Conference on Computer Vision and Pattern Recognition,2003,2:234-240.

[4]Comaniciu D,Ramesh V,Meer P.Kernel-based object tracking[J]. IEEE Trans on Pattern Anal Mach Intell,2003,25(5):564-577.

[5]Cheng Y.Mean shift,mode seeking,and clustering[J].IEEE Trans on Pattern Anal Mach Intell,1995,17(8):790-799.

[6]郑玉凤,马秀荣,赵晓琳,等.基于颜色和边缘特征的均值迁移目标跟踪算法[J].光电子激光,2011,22(8):1231-1235.

[7]李小和,张太镒,沈晓东,等.基于加权空间直方图的均值漂移目标跟踪[J].光电子·激光,2010,21(5):767-771.

[8]Ning Jifeng,Zhang Lei,Zhang D,et al.Robust mean shift tracking with corrected background-weighted histogram[J]. IET Computer Vision,2010.

[9]陈建军,安国成,张索非,等.基于直方图插值的均值移动小尺寸目标跟踪算法[J].电子与信息学报,2009,32(9):2119-2125.

[10]Han Ju,Ma Kaikuang.Fuzzy color histogram and its use in colorimageretrieval[J].IEEE Transactionson Image Processing,2002,11(8):944-952.

[11]Ma Y,Worrall S,Kondoz A M.Depth assisted visual tracking[C]//10th Workshop on Image Analysis for Multimedia Interactive Services,2009:157-160.

[12]Ma Y,Worrall S,Kondoz A M.Depth assisted occlusion handling in video object tracking[C]//Proc 10th IEEE International Workshop on Image Analysis for Multimedia Interactive Services,London,2009.

[13]Shotton J,Fitzgibbon A,Cook M,et al.Real-time human pose recognition in parts from a single depth image[C]// CVPR,2011.

[14]Marr D,Poggio T.Cooperative computation of stereo disparity[J].Science,1976,194:283-287.

[15]马颂德,张正友.计算机视觉-计算理论和算法基础[M].北京:科学出版社,1998:73-75.

[16]Forsyth D A,Ponce J.Computer vision:a modern approach[M]. New Jersey:Prentice Hall,2002:18-25.

[17]左军毅,梁彦,赵春晖,等.Mean Shift跟踪算法中尺度自适应策略的研究[J].中国图象图形学报,2008,13(9):1750-1757.

[18]康文静,丁雪梅,刘功亮,等.带宽自适应Mean Shift跟踪算法[J].光电子·激光,2008,19(1):135-138.

SONG Kangkang,CHEN Ken,GUO Yunyan

College of Information Science and Engineering,Ningbo University,Ningbo,Zhejiang 315211,China

The background noise in the candidate object model diminishes the object color characteristic,and induces localization error.To reduce the error,according to the discriminative depth level between the object’s and the background’s,a Mean Shift algorithm based on depth cues assisted and corrected background-weighted histogram is proposed.The proposed algorithm can sufficiently weaken the background noisy interference in the kernel window,enhance the object’s color feature information, and update the kernel size adaptively in due course to reduce the distractive information in the background as the object size becomes small.Experimental result shows the proposed algorithm has fewer iteration number and good localization precision of tracking. Key words:depth cues;Mean Shift;adaptive kernel bandwidth;color histogram

参考目标模型中混入的背景噪声会弱化目标特征的描述,导致目标跟踪定位误差。为减少误差,依据目标与背景处于不同深度平面的特点,提出了基于深度信息辅助的和改进的背景加权直方图的Mean Shift跟踪算法,能够有效削弱核窗口中的背景干扰信息,突出目标的颜色特征信息,并适时自适应更新核带宽,减少因目标尺寸变小时引入较多的背景干扰信息。实验结果表明该算法迭代次数更少,具有良好的跟踪定精度。

深度信息;均值漂移;带宽自适应;颜色直方图

A

TP39

10.3778/j.issn.1002-8331.1202-0245

SONG Kangkang,CHEN Ken,GUO Yunyan.Mean Shift object tracking algorithm assisted by depth cues.Computer Engineering and Applications,2013,49(23):177-180.

宁波市科技局自然科学基金(No.2010A610109)。

宋康康(1986—),男,硕士,主要研究领域为视频目标跟踪、图像处理;陈恳(1962—),男,博士,副教授,主要研究领域为图像与视频处理、智能控制;郭运艳(1987—),女,硕士,主要研究领域为视频目标跟踪、图像处理。E-mail:boyadme@163.com

2012-02-14

2012-04-06

1002-8331(2013)23-0177-04

CNKI出版日期:2012-06-15 http://www.cnki.net/kcms/detail/11.2127.TP.20120615.1726.035.html