拥挤场景中对多个人的检测和跟踪技术研究

徐 曼

(1.上海电力学院计算机科学与技术学院,上海 200090;2.复旦大学 计算机科学技术学院,上海 200433)

人的检测和跟踪技术在视频监控、人机交互、辅助驾驶系统等方面有着广泛的应用,该技术主要由两部分组成:一是对人的检测,即在视频帧中用目标检测技术检测出人;二是将在多个连续帧间跟踪检测到的人做标记.对于人的检测,早期采用的是基于移动的目标检测方法,假设摄像机是静止不动的,此时背景不变,变化的区域(motion blobs)就是检测的对象.这种方法适用于对单个移动的人的检测,要求照明不变或场景变化很慢,而且人是场景中唯一移动的对象.

在实际应用中,场景复杂,监测到的移动区域不再是一个人,有可能是物体,也有可能是多个互相遮挡的人,人的出现可能会伴随着人与人的遮挡及景物的遮挡,因此基于移动的方法不再适用.在人群拥挤的复杂场景中如何实现鲁棒的多个人的检测和跟踪,已成为研究的热点.

1 人的检测和跟踪系统

1.1 系统结构

人的检测和跟踪系统基本结构如图1所示.该系统由检测器和跟踪器两部分组成.输入视频流后,首先由检测器对每一帧进行监测,检测出每一帧图像中包含的多个人,以一个检测子的形式R={ri}(ri为多元组,代表一个人,通常由检测人的位置、大小、特征、所在帧编号等组成)表示该集合.跟踪器以这些检测结果为基础,对检测到的人进行跟踪,并计算不同帧中检测对象间的联系.最后,给出不同检测对象在视频流中的轨迹T={Tk},其中 Tk为第 k 个人的轨迹,Tk={rk1,rk2,,…,rkl},kl为检测子的个数.

图1 检测和跟踪系统的基本结构

根据具体的检测和跟踪方法,可以将系统框架进一步细化,主要包括3个方面:检测器的组成;跟踪器的组成;系统整体结构的调整.比如,在文献[1]中检测器由部分检测器和联合检测器两部分组成;而跟踪器由前向跟踪和后向跟踪组成.文献[2]提出了基于数据联系的3层的层级式跟踪方法,可以实现在拥挤环境中单个摄像机对多个对象的鲁棒跟踪.

基于文献[2]的分层联系框架,文献[3]对多个检测对象的亲密度量进行了改进,提出了一种基于学习亲密度模型的跟踪方法,在系统中引入了机器学习模块.文献[4]构建了小轨迹图,通过求图的最大权重独立集,在小轨迹之间建立联系并进行多目标跟踪.

1.2 技术概述

关于用于静止图像和视频跟踪的人的检测方法有大量的研究,其中大部分都是基于滑窗的方法,DALAL在博士论文[5]中进行了较为全面的综述.现阶段人的检测技术主要包括两个方面:一是具有高区分能力的特征;二是分类器.

1.2.1 特征

检测对象人的特征表示可以分为全局特征和基于局部的特征两种.其中,基于局部的特征由于不容易受遮挡的影响,因而应用得比较多.常用的局部特征有:SIFT特征;小波特征;HOG(梯度直方图)特征;小边缘特征[1].文献[5]将这些局部特征用于行人检测,实验结果显示HOG特征用于行人检测的性能优于其他3种.

其中HOG特征是目前最好的一种描述边缘和形状特征的局部特征.很多研究者对HOG特征进行了改进,提出了一些类HOG的特征.文献[6]针对杂乱背景中的噪音边缘,结合HOG特征和另外一种描述子LBP,提出了将HOG-LBP特征用于行人检测.

LBP是一种纹理描述子,它通过均匀模型过滤掉图像中的噪音,弥补了HOG特征的不足.文献[7]针对HOG特征的高位率存储和传输问题,提出了CHOG(压缩的HOG)特征,将梯度直方图表示成树结构进行高效压缩,在压缩的HOG特征间比较相似度,提供了一种低位率的特征描述子.文献[8]将图像的分割信息集成到HOG特征中,提高了行人检测的准确度.

1.2.2 分类器

用于行人检测的分类器主要有SVM分类器和决策树两种.一些研究工作针对分类器展开,主要目的是提高分类器的区分能力和分类速度.SVM分类器的训练速度快,但是非线性SVM分类器的运行复杂度较高;而决策树的分类速度较快,但同时训练速度较慢,而且训练的复杂度随类别的增加而呈指数级增长.因此,在实时应用中大多使用线性的SVM核分类器,其训练速度和分类速度都比较快,而且比非线性方法耗费的内存少.文献[9]提出了SVM直方图相交核方法,加速了直方图比较函数的处理速度,同时还提出了一种基于多级方向边缘能量直方图的特征,实验表明该方法优于 DALAL[5]的方法.

1.2.3 检测方法

从人的表示方法的角度,可以将人的检测技术分为两种:一是基于整体表示的方法,将人表示成一个整体;二是基于部分的方法,将人表示成不同部位的组合.基于整体表示的方法比较简单,但对于部分被遮挡的情况效果不好;基于部分的表示方法对遮挡有一定的鲁棒性.

1.2.4 关键问题

在人多的拥挤环境中,人的出现常常表现为不同程度的遮挡,其中包括人的遮挡和景物的遮挡,如何检测出有部分遮挡的人,是对人的检测技术必须解决的关键问题.一个较好的解决方法是将部位检测和整体检测结合起来,组成联合检测器.

文献[1]和文献[2]实现了联合检测的技术,将人表示为不同部位的组合,以方便处理遮挡问题.使用了部分检测器和联合检测器,其中部分检测器是基于部分特征的,联合检测器是由部分特征与贝叶斯推论组合而成的.检测时,首先用人整体和头肩部分检测器对图像进行扫描,得到一幅图像中存在多个人的推测,然后再逐个用躯干和腿的部位检测器进行验证.

2 跟踪多个人的技术

基于检测的跟踪方法[1,2,10-19]应用较为普遍,即用检测器检测视频中的每一帧,然后基于检测结果建立多个检测对象之间的联系.针对复杂场景中多个对象的跟踪,研究者提出了基于数据联系的跟踪方法(DAT方法)[20],在多个对象联系假设间进行匹配,通过计算多个对象的连接映像似然值处理遮挡问题.由于连接假设空间通常是高维的,因此采用了很多有效的优化算法,包括基于粒子滤波器的方法、马尔可夫链蒙特卡洛方法(MCMC)、EM 方法、Hungarian 算法等[1-3].

DAT方法的两个主要组成部分:一是用来测量两个小轨迹是否属于同一个对象的亲密度模型[3,12-14,21,22];二是联系优化结构,用来决定基于亲密度模型,链接哪些小轨迹.

2.1 亲密度模型

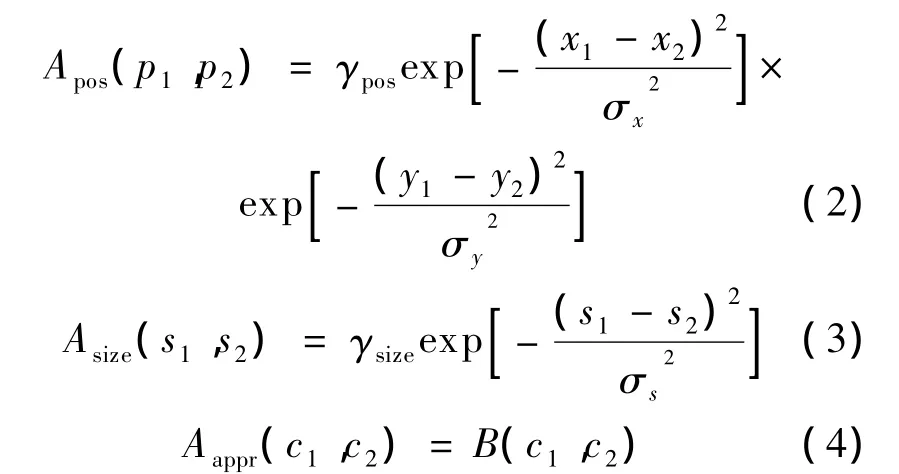

亲密度模型主要使用对象的颜色特征(如颜色直方图)、移动特征(如速度)和小轨迹之间的帧数,采用欧氏距离、简单高斯分布等度量其密度.假设,rp1,rp2是两个检测结果,rp1=(p1,s1,c1),rp2=(p2,s2,c2),表示两个检测子的位置、大小和颜色直方图,它们之间的亲密度公式为[1]:

式中:Apos,Asize,Aappr——位置、大小及外貌的相似度;

γpos,γsize——正则化参数.

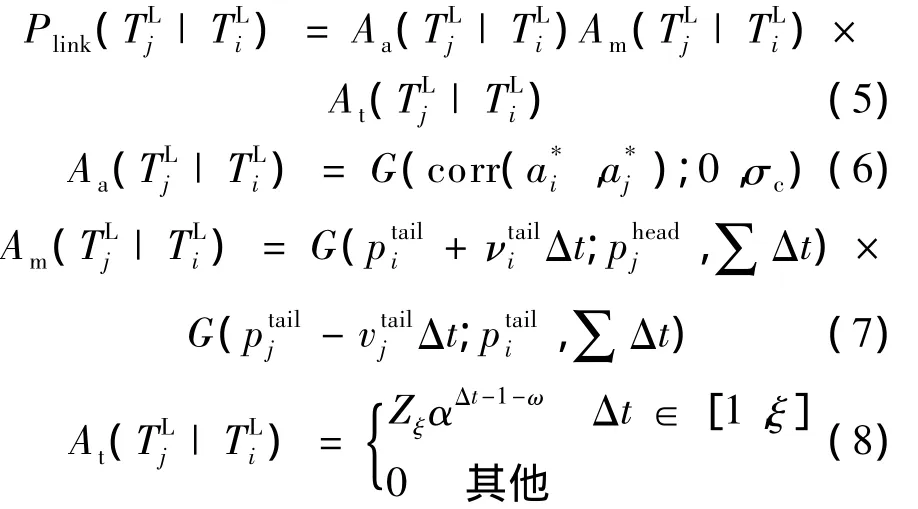

文献[2]提出的3层的层级式联系方法,在每一阶段采用不同的亲密度量模型,第一层联系中采用式(1)至式(4)定义的亲密度模型,得到小轨迹集;在中级阶段,对这些小轨迹基于更复杂的亲密量度模型作进一步计算联系,以形成更长的小轨迹.中级阶段中使用的亲密度量模型综合考虑了颜色、移动信息及两个小轨迹间的帧数等.两条小轨迹的亲密度模型定义为:

Aa,Am,At——颜色相似度,移动信息亲密度,时间亲密度.

文献[1]对文献[2]的中级联系亲密度量模型进行了改进,不再使用经验的固定参数和权值,而由学习得到,是一种基于学习亲密度模型的跟踪方法.另外,结合AdaBoost算法和Rank-Boost算法的优点,提出了一种 boosting算法,即HybridBoost算法,可用于训练亲密度量的参数.

2.2 联系优化方法

文献[2]中基于Hungarian算法对优化结构进行了改进,采用一种分层的联系框架,每一层采用不同的亲密度模型,同时利用上一层跟踪的结果,采用贝叶斯方法对其逐层优化,考虑到了检测器的误警、漏检,以及不准确的检测子和场景遮挡等噪音问题,是一种鲁棒的跟踪方法.该方法在中级阶段对检测结果进行了卡尔曼滤波,得到移动模型;将检测结果进行精炼,减小错误的检测结果对跟踪的影响.中级阶段的数据联系是一个迭代的过程.在高级阶段,由中级阶段已经计算得到的小轨迹,通过贝叶斯推论得到进入、退出及场景遮挡的统计估计,用于对最终轨迹的精炼.

另外,还有一些基于联系优化的研究,比如基于线性规划的方法、最小流的方法都是比较有代表性的.文献[23]和文献[24]采用马尔可夫蒙特卡罗方法和粒子滤波建立了数据联系.

3 实验数据集及性能度量

3.1 实验数据集

常用的实验数据集有CAVIAR视频库[25]、i-LIDS AVSS AB视频集[26]和 TRECVID08 数据集[27].

CAVIAR视频库提供了不同的情景,包括:人单独行走;遇到其他人;进入商店;走出商店;打架;经过;经过并在公共场所留下包裹等.提供了两个场景的视频库:第一个视频库是用一个广角摄像机在INRIA实验室的走廊入口处拍摄的视频,半分辨PAL标准(分辨率为384×288像素,帧率为25帧/s),MPEG2压缩,文件大小为6~12 MB,有些文件达到21 MB;第二个视频库也是使用广角镜头拍摄的,在Lisbon的一个商场的门厅外分别沿着门厅方向和跨门庭两个方向同步拍摄,视频文件执行的标准、压缩标准和文件大小与第一个视频库相同.

i-LIDS AVSS AB视频集是从一个地铁站拍摄得到的,包含 3个视频,135个真实轨迹.TRECVID08数据集较有挑战性,其中的视频是从机场拍摄得到的,场景拥挤(每一帧10~30人),互相遮挡较为严重,并有频繁的互动.

3.2 性能度量

Recall,查全率,定义为正确匹配的对象/所有的真实对象.Precision,查准率,定义为正确匹配的对象/所有查出的对象.这两个评价标准都是基于帧的.

跟踪性能通常有以下度量标准:

(1)GT(No.of groundtruth trajectories),跟踪到的真实轨迹的数量;

(2)T%(Mostly tracked),跟踪出长度大于真实轨迹80%的轨迹的比例;

(3)ML%(Mostly lost),跟踪出长度小于真实轨迹20%的轨迹的比例;

(4)PT%,部分跟踪率,定义为1-MT-ML;

(5)Frag(Fragments),真实轨迹被中断的次数,越小越好;

(6)IDS(ID switches),发生身份交换的次数,越小越好.

这些综合标准基本上也是基于上述检测和跟踪的度量标准来确定的,主要有:

(1)多对象跟踪准确度,计算误警数量、漏检数量和身份交换数量等,越大越好;

(2)真实实例漏检比例,越小越好;

(3)每帧误检率,越小越好.

4 结语

对拥挤场景中人的检测和跟踪的困难主要体现在:拥挤环境中存在较多的人和人之间的遮挡以及场景遮挡,而且人和人之间体貌相似的较多,很容易产生对象的交叉,当两个人的轨迹发生交叉时,标识会发生交换.如何解决遮挡和部分遮挡问题,提供具有高度区分能力的特征是解决拥挤环境下多个人的检测和跟踪的关键问题.将来的工作主要要围绕4个方面展开:一是提供高区分度的特征用于人的检测;二是发明适用于人的检测的聚类技术;三是建立更好的自适应亲密度量模型;四是研制用于跟踪过程中高维假设空间的高效优化算法.

[1] WU Bo,NEVATIA R.Detection and tracking of multiple,partially occluded humans by bayesian combination of edgelet based part detectors[J].International Journal of Computer Vision,2007,75(2):247-266.

[2] HUANG Chang,WU Bo,NEVATIA R.Robust object tracking by hierarchical association of detection responses[C]//Computer Vision-ECCV,2008:788-801.

[3] LI Yuan,HUANG Chang,NEVATIA R.Learning to associate:hybridBoosted multi-target tracker for crowded scene[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2009:2 953-2 960.

[4] BRENDEL William,AMER Mohamed,TODOROVIC Sinisa.Multiobject tracking as maximum weight independent set[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),2011:1 273-1 280.

[5] DALAL N.Finding people inimages andvideo[D].Grenoble:INRIA Rhne-Alpes,2006.

[6] WANG Xiaoyu,HAN Tony X,YAN Shuicheng.An HOG-LBP human detectorwith partialocclusion handling[C]//Proceeding of the 12th IEEE International Conference on Computer Vision,2009:32-39.

[7] CHANDRASEKHAR Vijay,TAKAC Gabriel,CHEN David,et al.CHOG:compressed histogram of gradients:a low bit-rate feature descriptor[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2009:2 504-2 511.

[8] OTT Patrick, EVERINGHAM Mark. Implicit color segmentation features for pedestrian detection[C]//Proceeding of the 12th IEEE International Conference on Computer Vision,2009:723-730.

[9] MAJI Subhransu,BERG AlexanderC,MALIK Jitendra.Classification using intersection kernel support vector machines is efficient[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2008:1-8.

[10] OKUMA Kenji,TALEHANI Ali,FREITAS Nando D,et al.A boosted particle filter:multitarget detection and tracking[C]//Proceeding of European Conf.Computer Vision(ECCV),2004:28-39.

[11] GRABNER H,BISCHOF H.On-line boosting and vision[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),2006:260-267.

[12] LEIBE B,SCHINDLER K,GOOL L V.Coupled detection and trajectory estimation for multi-object tracking[C]//Proceeding of IEEE Int'l Conf.Computer Vision(ICCV),2007:1-8.

[13] ANDRILUKA M,ROTHS,SCHIELEB.People-trackingbydetection and people-detection-by-tracking [C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),2008:1-8.

[14] XING J,AI H,LAO S.Multi-object tracking through occlusions by local tracklets filtering and global tracklets association with detection responses[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),2009:1 200-1 207.

[15] CHOI W,SAVARESE S.Multiple target tracking in world coordinate with single,minimally calibrated camera[C]//Proceeding of European Conf.Computer Vision(ECCV),2010:553-567.

[16] YUL Jie,FARIN Dirk,SCHIELE Bernt.Multi-target tracking in crowded scenes[C]//DAGM'11 Proceedings of the 33rd InternationalConference on Pattern Recognition,2011:406-415.

[17] STALDER S,GRANDER H,VAN GoolL.Cascaded confidence filtering for improved tracking-by-detection[C]//Proceeding of European Conf.Computer Vision(ECCV),2010:369-382.

[18] BREITENSTEIN M D,REICHLIN F,LEIBE B,et al.Online multi-person tracking-by-detection from a single,uncalibrated camera[J].IEEE Trans.on Pattern Analysis and Machine Intelligence,2011:1 820-1 833.

[19] BREITENSTEIN M,REICHLIN F,LEIBE B,et al.Robust tracking-by-detection using a detector confidence particle filter[C]//Proceeding of IEEE International Conference on Computer Vision(ICCV),2009:1 515-1 522.

[20] QIN Zhen,SHELTON Christian R.Improvingmulti-target tracking via social grouping[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),2012:1 972-1 978.

[21] LI Y,NEVATIA R.Key object driven multi-category object recognition,localization and tracking using spatio-temporal context[C]//Proceeding of European Conf.Computer Vision(ECCV),2008:409-422.

[22] GRABNER H,MATAS J,COOL L Van,et al.Tracking the invisible:learning where the object might be[C]//Proceeding of IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR),2010:1 285-1 292.

[23] DOUKWORTH Daniel.Monte carlo methods for multiple target tracking and parameter estimation.technical report No.UCB/EECS-2012-68[R].http://www.eecs.berkeley.edu/Pubs/TechRpts/2012/EECS-2012-68.html.

[24] VU Anh Tuyet,VO Ba Ngu,Evans,et al.Markov chain monte carlo for bayesian multi-targettracking[C]//2011 Proceedings of the 14th International Conference on Information Fusion(FUSION),2011:1-8.

[25] SMEATON A F,OVER P,KRAAJI W.Evaluation campaigns and trecvid[C]//MIR ’06:Proceedings of the 8th ACM International Workshop on Multimedia Information Retrieval,2006:321-330..