数据中心被动式散热解决方案——通向绿色数据中心之路

文|上海速越电子工程有限公司

1 前言

随着计算机设备的计算能力和功率能耗的大幅提高,传统数据中心如何提高每个机柜的功率密度也变得越来越重要。Intel的研究表明,同样的计算能力在2002年时需要25个机柜和128kW的能耗(5.1kW/每机柜),但在2008年时只需一个机柜和21kW的能耗(21kW/每机柜)。对比之下,我们节省了107kW的能耗,并且也大大节省了数据中心的物理大小和结构。

这种大幅度的计算能力的提升主要是得益于虚拟计算、内存系统、多核CPU系统以及CPU速度和GPGPU技术的飞速发展。虚拟计算大大提高了服务器的使用效率,从而直接增加单个机柜的发热密度。随着内存容量和速度的飞速发展,最新的DRAM技术使内存的发热量也大大提升。工程和科学研究等大量使用图形浮点运算,GPGPU使得显卡的发热量从25W 提高到 300W 以上。虽然服务器的功耗持续不断的提高,但是性能和功耗比在不断的下降。从以上的例子可以看出,如果数据中心空调系统能够高效的对机柜进行冷却,我们将会大大减少数据中心的总能耗,从而在本质上可以真正拥有一个绿色数据中心。

提高空调的制冷效率并节约能源只是数据中心管理的重要一部分,然而每机柜的热密度不停的增加则带给我们更多的挑战。目前全球数据中心的每机柜的平均热密度大概为6.5kW,但是ASHRAE2预测在2014年数据中心平均每机柜所需的制冷量为37kW。这种5倍的热密度的飞跃需要我们对数据中心不断的革新来解决。本文将对被动式散热解决方案进行介绍,以及在数据中心中如何利用该技术实现绿色节能数据中心。

2 数据中心散热基础

首先,我们将对数据中心散热做一个基本的研究。IT设备散热所需要的风量可用下列等式来表明:

m3/h = 2.9W÷ΔT

其中m3/h为机柜中的设备散热所需的风量(立方米冷风/每小时);W=瓦特数(IT设备的功耗);△T=IT设备的温差(设备回风温度减去设备的进风温度)。

该等式也表明了机柜的散热能力直接和高架送风地板的送风能力有着密不可分的关系。由于高架送风地板所送的冷风风量的不够,在机柜上部的IT设备进风风扇所造成的负压,会将机柜后部热通道中的热空气抽入IT设备中,从而造成服务器过热的问题。

研究表明在一个设计不合理的数据中心中,60%的空调机冷送风由于气流组织的不合理而被浪费。目前,传统的开放式热通道结构数据中心面临着两大气流管理难题:冷热空气相混合现象和空调冷送风的浪费现象,这两种现象大大降低了空调制冷的效率。其中,冷热空气相混合现象指的是由设备产生的热空气和空调机的冷送风相混合,从而提高了设备的进风温度;空调冷送风的浪费现象则指的是从空调机的冷送风并未进入设备,并对设备冷却而直接回流到空调机的现象。冷热空气混合现象也是导致数据中心温度不一致的主要原因,并且这种现象也大大降低了数据中心空调的制冷效率和制冷能力。如何解决这两种现象,其实最简单有效的方法就是将冷热空气物理隔离开。

Intel三多年的研究和实验表明,良好的气流组织管理能够大大减少冷热空气相混合现象和空调冷送风的浪费现象。Intel现在的数据中心的热密度也从单个机柜310WPSF增加到781WPSF(每机柜从15kW 增加到40kW 以上),另外,Dell4和HP5的数据中心也正在使用冷池或热池技术。本文将以被动型(通过物理手段,无任何有源设备)对数据中心的散热做出研究,并对可行的方案做出比较,从而找出最佳的数据中心散热解决方案。

目前,主动性数据中心散热(机柜内空调制冷)也在行业内普遍使用。但是其高昂的投资成本、复杂的安装过程和维护等问题,我们将不在本文中讨论。

3 数据中心散热解决方案

方案一:冷池和热池

热通道封闭或热池(HAC)是将热通道密闭起来,并通过回风管将热回风传回数据中心空调系统,如图1所示。对比热池,冷池(CAC)是将冷通道密闭起来。这两种技术都将空调的冷送风和热回风隔离开来,并使空调机回风温度提高,以此来提高空调的制冷效率。这两种方式的区别主要是可扩展性、散热管理和工作环境的适宜性。

冷池的可扩展性主要是受地板下送风和如何将地板下冷风送入多个冷池的制约。目前业界对该技术有着很多的误解,很多人认为只要当空调机的出风量能满足设备的散热风量即可。但是他们忽略了高架地板下冷送风对于多个冷池的压力和空间的限制。相反的热池则是使用整个数据中心作为冷通道来解决这个问题,这样热池相比于冷池也有着更多空调冗余性能,多出的热通道空间将会在空调系统出现故障时能提供足够的维修时间。最后,随着服务器设备散热能力的提高,服务器所需的散热风量将会大大的减少。现在很多服务器的热出风温度可达到55℃,冷池的未被隔离部分空间的温度将会比传统数据中心大大的提高,这将增加数据中心工作人员的舒适度和减少数据中心其他设备的使用寿命。综上所述,虽然这两种方法都可以提高机柜的热密度,但是当合理使用热池时,热池的效率比冷池更为有效可靠。

图1 标准热池方案

通过以上的对比,我们可以发现热池比冷池有着更多的优点,另外在数据中心断电的情况下,冷池数据中心的冷空气只存在于高架地板下和密闭冷通道中,相反于热池数据中心中冷空气存在于高架地板下和房间内的绝大多数地方,所以冷池数据中心的冷空气体积远远小于热空气的体积。当数据中心断电或空调出现问题时,冷池数据中心在几秒钟内可以丧失所有的IT设备,所以在有可能的情况下,我们应该尽量采用热池而不是冷池。使用部分密闭热池或冷池的数据中心,数据中心的热点现象可能还会存在,消防设施的位置也需要额外注意,但是,要到达2014年每机柜37kW的热密度,这些是远远不够的。

方案二:垂直排风管机柜

除此之外,另一种方案是机柜级的冷热风隔离系统,这种系统通常是机柜的一个延伸部分。最常见的系统为机柜垂直排风管系统,或称作烟囱机柜系统。垂直排风管系统将密闭机柜内的热回风导入到天花板的上方,对比冷池或热池,烟囱机柜系统有着巨大的优点。首先,对于机柜而言,烟囱机柜的隔离冷热空气系统比冷池或热池系统隔离整排机柜的热冷空气来的更为简单有效,并且烟囱机柜在所有解决方案中是最简单的全密闭系统。其次,烟囱机柜系统不和空调系统相连,这样我们可以随着需求的增加来任意增加机柜。最后,垂直排风系统和空调系统的独立性,确保了数据中心可使用大型的空调系统来提高制冷效率和节能。使用垂直排风管系统,冷空气可使用高架地板(常用送风方法)送风或直接将冷风吹入数据中心内部,并且结合使用空气节能器来起到更佳的节能效果。

垂直排风管机柜的第一个挑战是我们必须使用天花吊顶或使用回风管,如图2所示,这样,数据中心则需要额外的高度。第二个挑战则是风压差,我们必须确保机柜前后的风压以使得冷风可以进入机柜来对机柜散热,这种挑战主要体现在机柜前部的送风风压压力、机柜后部热回风的风压、机柜后部的理线等功能区对风压的影响以及机柜顶部垂直排风管的大小和长度。因此,我们必须在设计时,确保垂直排风管系统不会造成错误的压差。

图 2 垂直排风管系统或称为烟囱机柜

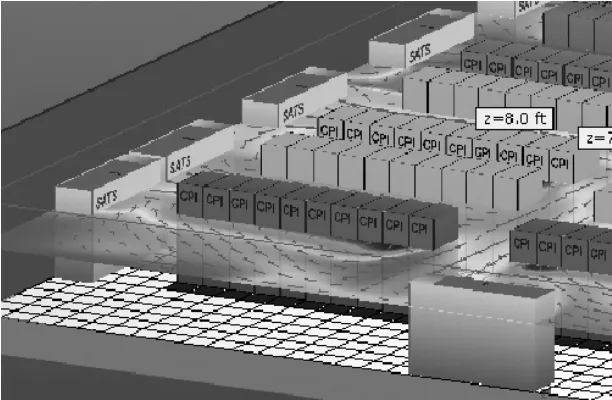

我们可以通过控制机柜内部的空气流速来控制机柜内部的空气压力,即使在没有使用任何有源设备的情况下,利用这种自然压力差将更多的冷送风吸入机柜,并将热回风排放至天花板上部,如图3所示。

图 3 垂直排风管系统在数据中心内的应用

4 通向绿色数据中心之路——垂直排风管机柜

(1)防止无效的冷送风浪费现象

Uptime曾对美国的大型数据中心做过一次研究,美国平均每个数据中心冷送风风量是实际需求的2.7倍。但是这么多的冷量仍无法对大多数的数据中心进行冷却,很多数据中心存在着局部过热问题。实际上这么多的冷量并没有进入机柜对IT设备进行降温,而是完全的浪费掉。比如,我们通常所见的高架地板上的过线孔,如图4所示,在下走线的数据中心内,很多过线孔是开在热通道或机柜底部,这些开口在过线的同时也将空调的冷送风送入了热通道或机柜底部,从而绕开了设备的进风风扇。我们甚至不止一次的见到,由于水平走线的原因,有些数据中心在地板墙壁上开了很大的孔,该孔造成了大量空调冷送风向数据中心外部泄露。这些被浪费的冷送风带来高架地板静压箱的压力下降,从而使得冷送风往往不能送达关键的位置。

图4 高架地板缆线开口造成冷空气的浪费

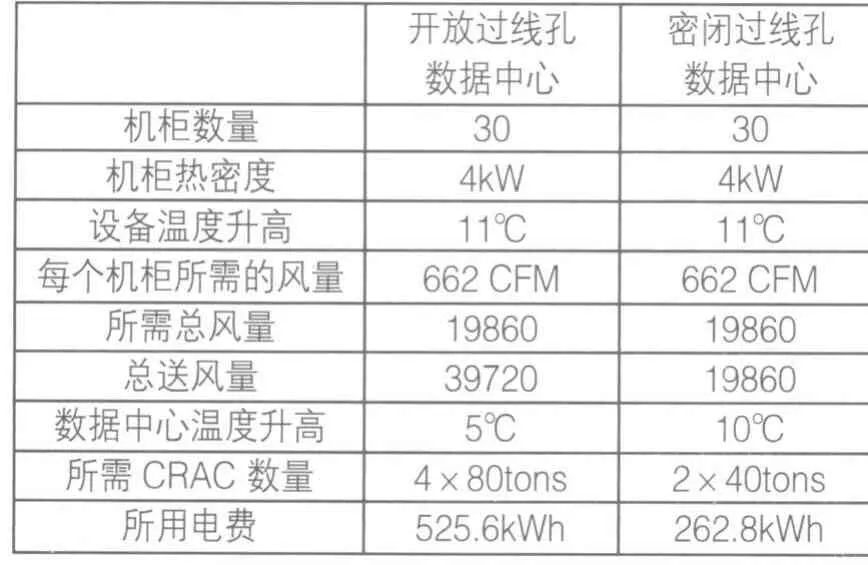

Uptime通过实际测量很多数据中心,发现大多数的数据中心存在开孔导致浪费现象严重。如果将这些不正确的开孔密闭起来的话,我们可以大大提高数据中心空调制冷效果。如果我们能把这些浪费的冷量节省下来,数据中心的节能效果将有很大的改变。通过表1对同一数据中心做一个比较,在一个30个机柜的低热密度的机房内,如果我们将地板过线孔都密封起来,该数据中心空调运行每小时能节省262度电。

表1

(2)提高空调机热回风温度来提高空调制冷性能

众所周知,空调的制冷效率和性能与空调机热回风和冷送风的温差有关,如表2所示。

表2

但是对绝大多数的数据中心而言,它们给空调机的回风温度不高,这些可能是因为数据中心的布局不好或者是热回风在回流空调机时被旁路(浪费的)冷送风降温,从而使大多数数据中心的空调制冷效果未能达到空调机的性能值。我们拿Libert FH600C 30吨的空调机来看,大多冷热通道布局的数据中心温差为5.5℃,如果我们将回风温度从21℃提高到40.5℃度时,我们可以将空调额定制冷量翻倍,30吨冷量的空调机实际制冷效率为61.3吨。提高回风温度,不仅可以节省设备投资费用,同时在数据中心实际运行中也节省了很多电费。

那么我们如何提高回风温度?答案很简单:使用烟囱机柜。这样我们几乎忽略设备热回风的路径,所有热空气在天花板上方,冷热空气不在混合,所以也没有热空气在向空调机回流时被冷却的现象。

(3)提高空调机冷送风温度

采用冷热通道布局的数据中心,房间内部的温度不一。由于冷热空气的相混合和避免机柜过热的问题,空调机通常的冷送风温度在11℃~13℃之间,如5所示。

但是在烟囱机柜的数据中心中,机柜顶部的垂直排风管将机柜内部的热回风导流至天花板上方,从而使机房内部再无冷热空气混合的现象,这样,机房内部空气温度几乎一致。IT设备过热的定义为设备进风温度不能超过25℃,对于空调机而言,24℃的冷送风完全能够冷却数据中心。通过提高空调机的冷送风温度,我们也可提高冷冻水管的水温和冷水机组的制冷效率。

图5 冷热通道布局数据中心气流图

5 结束语

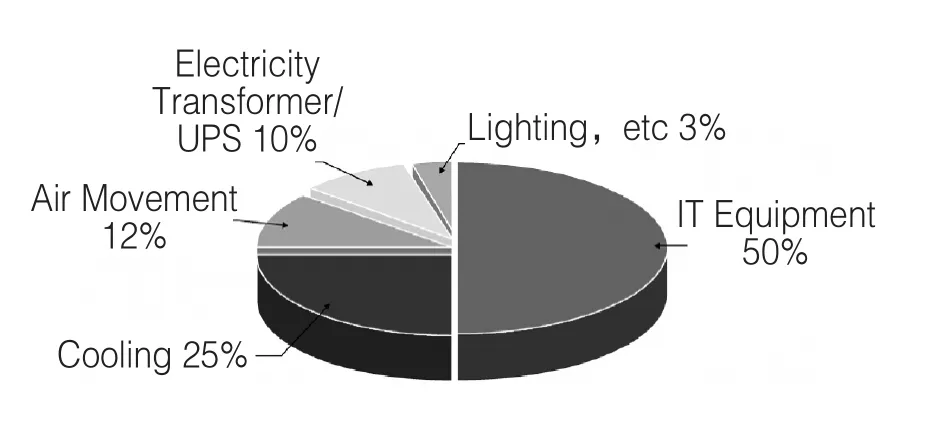

PUE(Power Utilization Effectiveness,数据中心用电使用效率)是全球用来衡量数据中心是否绿色节能的一个重要技术指标。

美国高性能数据中心的PUE值大概为2.0左右,这代表了数据中心每用2度电,只有1度电是被IT设备用掉,另外1度电是用在管理该数据中心。通过对数据中心管理用电使用情况分析,我们知道空调和气流管理大概占到40%左右,如图6所示。

图6 PUE2.0时,数据中心各设备用电情况

国内数据中心的PUE值对比欧美发达国家要更大,这也意味着同样的数据中心,我们使用了更多的能源,其中主要问题是管理人员对数据中心散热的不熟悉。主要问题体现在如下几个方面:一味购买更多的、更大的空调机来对数据中心制冷;空调冷送风温度过低;热回风回流空调机时,遇冷却回风的从而降低了空调的制冷效率;机房布局不合理,机柜冷热空气相混合现象严重;错误地板开孔导致大量冷送风被浪费。

机柜的传统概念正在被垂直排风管系统慢慢改变,机柜不再是传统意义上只是用来安装设备的柜子,而使用垂直排风管机柜可将冷热空气彻底隔离,从而成为数据中心空调系统密不可分的重要组成部分。

目前垂直排风管机柜在国际数据中心散热方案中逐步应用。其中Intel在全球30个高热密度数据中心都有广泛使用,在实际应用中,每机柜热密度高达32kW,在机房中无任何机柜局部过热现象。在高效的对IT设备进行散热之外,该机柜还通过提高空调回风温度和提高空调机冷送风温度来节约数据中心能源,如图7所示。

图7 高密度刀片机柜中垂直排风管系统机柜的应用

使用垂直排风管系统机柜,我们不仅可以做到机柜的高密度应用,更可以做到:数据中心关键制冷量下降74%;冷冻水峰值用水量下降35%;要求的水箱24小时储水量下降44%;发电机重启所需的散热箱容量下降74%;发电机、设施分配方面的HVAC负荷下降65%;三相部件连接要求下降78%;室内HVAC设备的空间要求下降89%;HVAC用水成本下降63%;维护成本下降49%。从而建设成一个绿色节能的数据中心。