一种基于YOLOv5的农业害虫检测方法

摘要

虫害是影响农作物产量的重要因素之一,害虫种类的精确识别已成为农业领域目标检测的重要研究课题。但由于害虫样本存在类间相似,标注的害虫样本尺度多样、背景复杂和类别分布不均匀等问题,使害虫的精准识别面临严峻挑战。为此,本文提出一种基于YOLOv5改进模型的农业害虫检测新方法。首先,引入了一种新型特征金字塔(feature pyramid attention, FPA)模块,用于替换基准YOLOv5主干网络的空间金字塔池化(spatial pyramid pooling, SPP)模块。该模块能够进行不同尺度的特征提取,并将提取的特征拼接作为注意力机制指导网络进行细粒度特征提取。然后,在YOLOv5主干网络输出层的特征提取过程中插入全局注意力上采样(global attention upsampling, GAU)模块,用高级特征的全局信息来指导模型从复杂背景中提取特征,使得模型能够从低级特征中更精准地提取类别定位细节特征,进而提高模型的识别精度。本文在IP102害虫数据集上进行算法验证,结果表明,与现有的多尺度注意学习网络(multiscale attention learning network, MS-ALN)相比准确率提升了3.21百分点。

关键词

害虫识别;" YOLOv5;" 数据增强;" 注意力机制;" 多尺度特征提取

中图分类号:

TP 391. 41

文献标识码:" A

DOI:" 10.16688/j.zwbh.2024089

收稿日期:" 20240221""" 修订日期:" 20240320

基金项目:

国家自然科学基金(31760342)

致" 谢:nbsp; 参加本试验部分工作的还有江代礼、谭翰杰、张能和纪烨斌等同学,特此一并致谢。

* 通信作者

E-mail:

ssjlb@gxu.edu.cn

#

为并列第一作者

A YOLOv5-based method for agricultural pest detection

LI Zongzhu," SONG Shaojian*," LI Xiuhua

(School of Electrical Engineering, Guangxi University, Nanning" 530004, China)

Abstract

Pest attack is a critical factor that affects agricultural crop yields, and the accurate identification of pest species

has become an important research topic in the field of target detection in agriculture

. However, the accurate identification of pests still face critical challenges due to the issues, such as complex backgrounds, interclass similarities, multiple scales of annotated samples, and uneven distributions among different category samples. Therefore, this paper proposed a new method for detecting crop pests based on an improved YOLOv5 model. First, we introduced a feature pyramid attention (FPA) module to replace the spatial pyramid pooling (SPP) module in the backbone of YOLOv5, which enhances the network performance in extracting features of different scales and

concatenates the extracted features as an attention mechanism to

guide the network to extract fine-grained features. Then, a global attention upsampling (GAU) module was inserted into the output layers of the backbone to guide the model to extract features from complex backgrounds. Experiments conducted on the IP102 dataset showed that the accuracy was improved by 3.21 percent point compared to the multiscale attention learning network (MS-ALN), which achieved state-of-the-art performance on the IP102 dataset.

Key words

pest identification;" YOLOv5 (You Only Look Once version 5);" data augmentation;" attention mechanism;" multi-scale feature extraction

虫害是造成农作物减产、农业重大经济损失的主要因素之一。全球因害虫造成的作物损失占总产量的50%~80%[1]。虫情监测在病虫害防治和农业管理中发挥着至关重要的作用。及时采取病虫害预警和防治措施, 可以显著减少农作物的经济损失。然而农业害虫种类繁多, 部分害虫在外观上高度相似, 导致只有少数农业专家能够正确识别和区分它们。因此, 农作物害虫的识别很大程度上依赖于专业知识, 这既昂贵又低效[2]。随着机器学习和害虫数据集的发展, 基于机器学习的害虫识别在智慧农业领域越来越受到关注[37]。Wen等[8]使用不变的局部特征模型、全局特征模型和层次组合模型设计了1种基于图像的昆虫自动识别和分类方法。Larios等[9]改进了基于尺度不变特征变换的特征提取策略。Csurka等[10]使用特征袋方法提取果蝇幼虫的区域特征, 并将这些区域表示为尺度不变特征变换向量, 然后使用集成分类算法对其进行分类。Yao等[11]提出了1种利用害虫和非害虫图像之间的颜色差异去除背景的方法。他们提取了156个特征,包括每种害虫的颜色、形状和纹理等, 并使用径向基核函数和支持向量机进行建模。这些算法的性能在很大程度上取决于手动设计的特征提取算法, 既麻烦又耗时。

近年来, 卷积神经网络(convolutional neural networks, CNN)在模式识别和机器学习领域取得了快速发展[1213], 研究人员尝试将CNN应用于害虫识别。Dimililer等[14]提出了1种基于两阶段神经网络的方法。在第一阶段, 使用各种图像处理技术来处理害虫图像以检测其几何形状。在下一阶段, 在处理后的图像上训练和测试反向传播神经网络。Ayan等[15]提出了1种包含多个分支的CNN结构以提高识别精度。通过遗传算法对不同分支的预测概率进行加权,根据加权结果在决策时选择模型。Tang等[16]提出了基于改善CNN和YOLOv4的实时农业害虫检测方法Pest-YOLO。Pest-YOLO将SE注意机制模块引入YOLOv4, 并设计了跨阶段的多次融合方法, 通过改善特征金字塔网络的结构和路径聚合网络来增强害虫和其他小物体的特征表达能力。Wang等[17]提出了1个具有注意力机制的三尺度CNN模型(three-scale CNN with attention, TSCNNA), TSCNNA通过将通道注意力和空间注意力机制引入CNN来构建用于作物有害生物的检测。TSCNNA可以在复杂背景下提取不同尺寸的害虫特征, 并丰富CNN的感受野。上述方法采用了CNN的端到端训练, 避免了手动特征提取的繁琐过程, 但上述模型仅能识别特定的害虫类别, 因此所使用的害虫数据集包含类别很少。为了缓解现有害虫数据集样本量有限和缺乏多样性的问题, Wu等[18]构建了用于害虫识别的大规模数据集IP102, 目前基于IP102的网络设计可大致分为两类: 设计基于显著性的策略网络;设计特定任务的识别网络。Nanni等[19]提出了一种基于显著性方法和卷积神经网络融合的自动分类器,使用3种不同的显著性方法创建不同的图像以训练不同的卷积神经网络。Luo等[20]提出了一种显著性引导的鉴别学习网络, 设计了2个共享参数的分支:原始分支用于提取粗粒度特征, 而细粒度分支通过细粒度特征挖掘模块挖掘细粒度特征, 作为在原始分支中约束特征学习的一种方式。Feng等[21]提出了一个多尺度注意学习网络(multiscale attention learning network, MS-ALN), 该网络通过递归方式定位鉴别区域, 并在4个分支中学习各区域的特征。

尽管近年来对大规模害虫数据集的研究不断取得进展, 但最新提出的模型识别精度仍然较低, 目前基于大规模数据集的害虫识别面临着一些挑战: 1)数据集中取样的多尺度导致样本的特征提取困难;2)同类别中存在类内变异以及不同类别之间特征相似导致模型难以提取到有效特征;3)自然环境中对害虫的取样存在复杂背景干扰特征提取;4)样本分布极不均衡, 部分类别样本数量极少, 使模型难以学习到类别特征。为了解决上述难点, 并提高在大规模数据集上的害虫识别精度, 本文提出了一种改进的YOLOv5模型并将之应用到害虫的分类检测。

1" 材料与方法

1.1" 数据集和数据处理

1.1.1" IP102农业害虫数据集

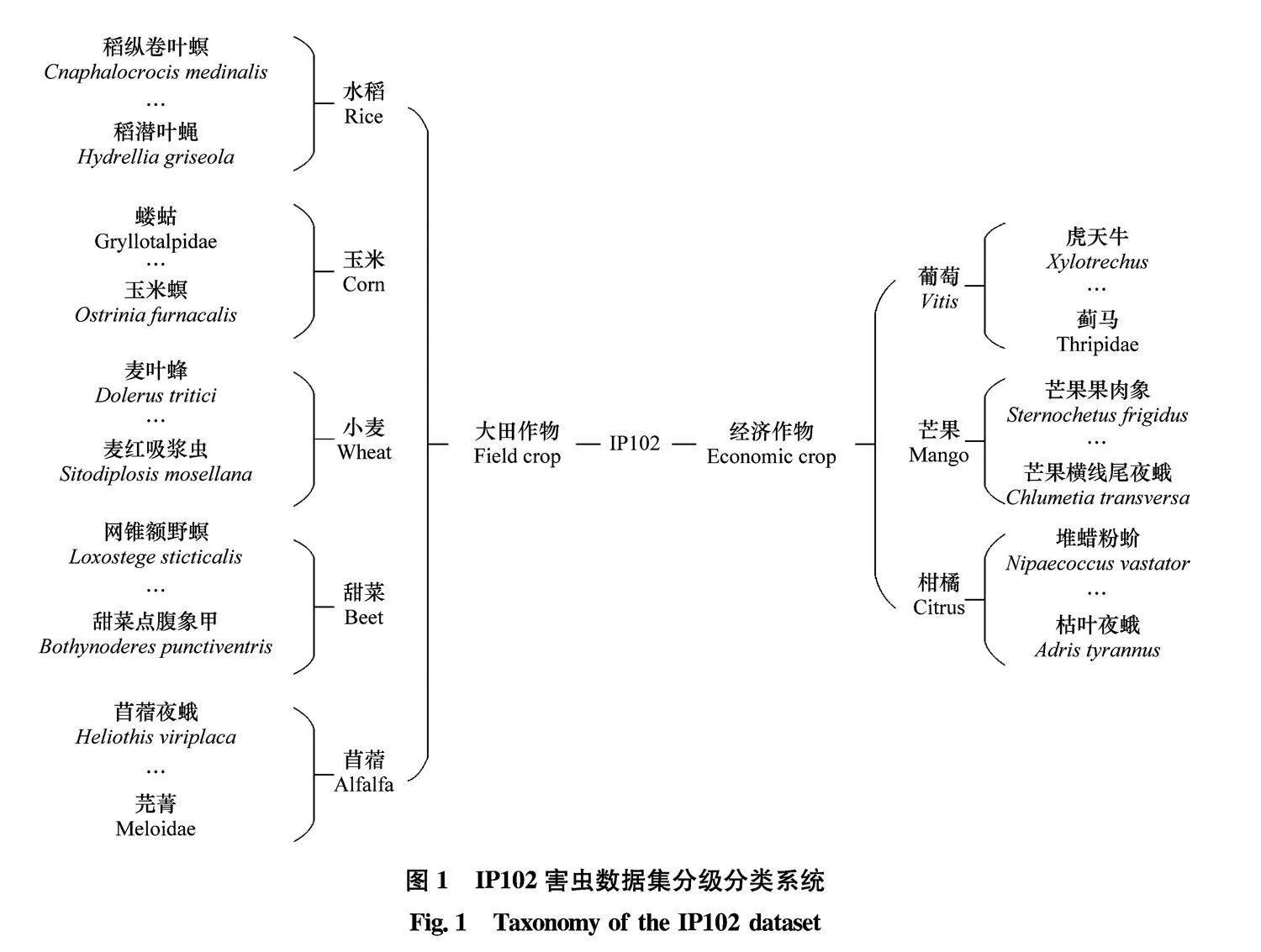

IP102害虫数据集在虫害识别领域广泛使用, 数据集涵盖了102类害虫。IP102按害虫损害的作物进行划分, 其中包括57类大田作物害虫和45类经济作物害虫, 大田作物害虫涵括了14类水稻害虫、13类玉米害虫、9类小麦害虫、8类甜菜害虫和13类苜蓿害虫, 经济作物害虫涵盖了16类葡萄害虫、19类柑橘害虫和10类芒果害虫。

IP102数据集有一个层次分类系统(图1), 每个害虫类别有对应的作物上级分类, 而作物也有大田作物或者经济作物2个上级分类。以芒果横线尾夜蛾Chlumetia transversa为例, 上级分类为芒果作物害虫, 芒果作物害虫的上级分类是经济作物害虫。

1.1.2" 数据处理

IP102数据集收集了102个类别的75 222张图像, 其中约18 983幅图像标注了用于目标检测的锚框, 并将标注的类别名称简化为数字0~101,对应102个害虫类别名。本文对数据集中各类别的样本数进行统计, 最多的样本数为2 975, 最少的样本数为13。最多样本类别和最少样本类别的样本比率接近229∶1。通常数据呈长尾分布能够训练出鲁棒性较高的模型, 但是如果单个类别的样本数过少极易导致由于训练样本不足而发生的欠拟合现象, 最终降低整体模型的检测精度。为提升模型精度,可通过数据增强方法创建与训练样本相似的样本来提高模型的泛化能力。

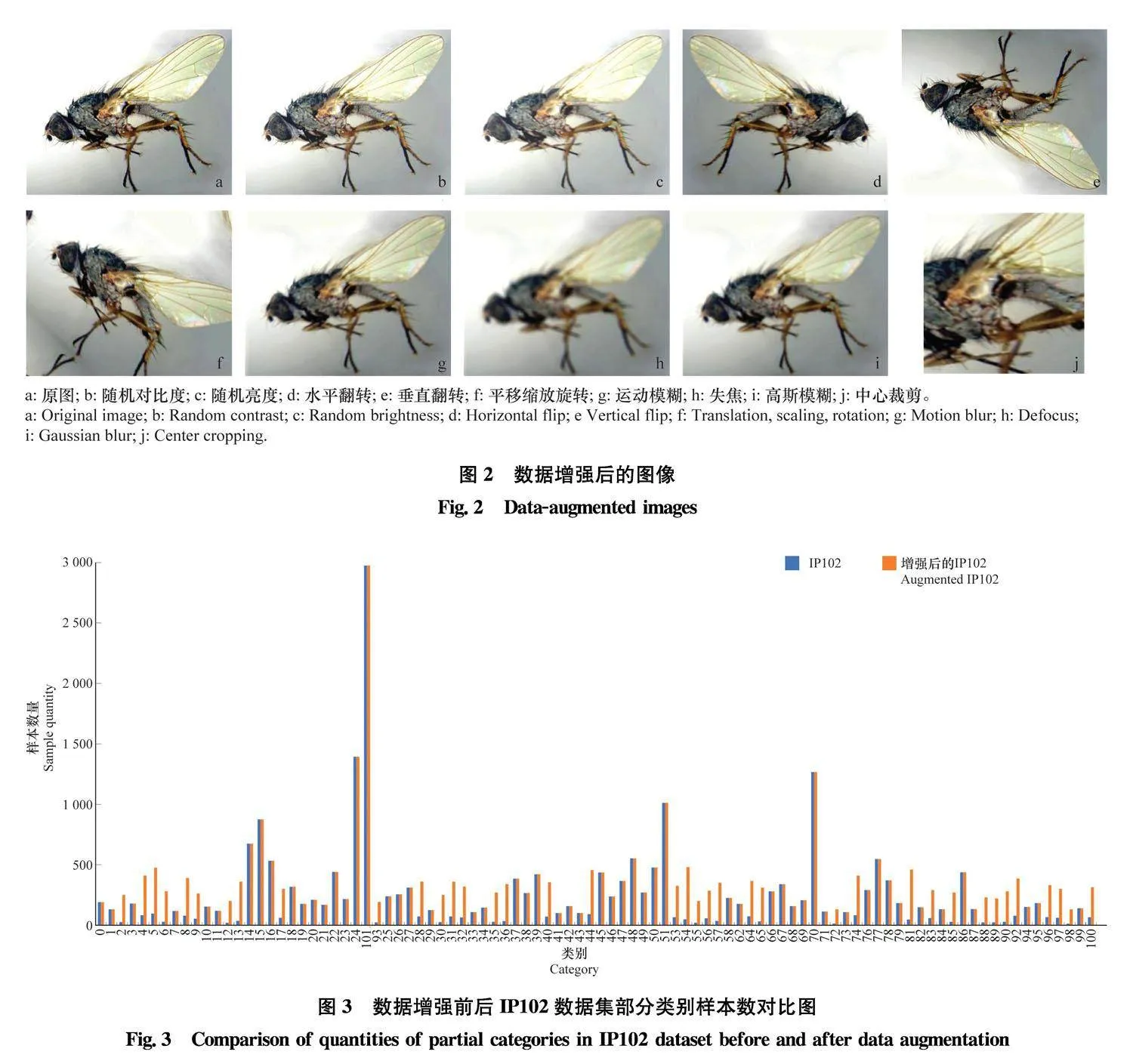

本文通过图像增强方法对IP102害虫数据集中的样本数量不足的类别进行增强。常见的数据增强方法包括: 垂直翻转、水平翻转、旋转、平移缩放旋转、随机裁剪、随机对比度、随机亮度、运动模糊和高斯模糊等, 其中垂直翻转、水平翻转、旋转、平移缩放旋转是对图像进行几何增强, 增加不同角度的样本来增强模型对样本特征的学习。随机对比度、随机亮度是对图像进行色彩增强, 增加图像RGB的多样性使模型能够学习不同场景下的样本特征。运动模糊、高斯模糊是对图像进行模糊处理来降低图像的噪声和减少图像的细节。高斯模糊是用正态分布来分配每个点求取周围像素平均值的权重;运动模糊是使静态的影像向某一方向运动, 并将运动的图像重叠, 将像素信息缩小后相加。模糊处理后的图能够让模型对不同品质的图像都能进行高效的学习, 增加模型在低分辨率数据库、恶劣天气等场景的应用。数据增强后的图片效果如图2所示。具体方法是将IP102害虫数据集中样本数少于50的类别划为稀缺样本类别, 将样本数大于50少于100的类别划为少量样本类别。图像增强方法选取垂直翻转、平移缩放旋转、中心裁剪、随机裁剪、运动模糊、随机对比度、随机亮度、水平和垂直翻转、水平翻转、缩放、旋转和高斯模糊等11种增强方法, 对稀缺样本类别随机选取10种增强方式进行增强, 对少量样本类别随机选取5种增强方式进行增强, 最终将初始数据集从18 983张图片拓展到28 055张, 增强前后的部分类别样本数量分布如图3所示。

1.2" YOLOv5检测算法及改进方法

在目标检测领域, YOLO系列算法具有精度高、检测速度快、参数量少等特点。随着YOLO算法版本的改变, YOLOv5的检测速度在提高精度的基础上有了很大提高, 而且模型也更小。YOLOv5网络模型的高级特征映射具有更广泛的接受域, 并侧重于表示抽象语义信息。但农业害虫检测识别任务往往存在背景复杂、尺度多样、类别相似性等难题, 使得YOLOv5难以取得较好的识别结果, 因此本节将介绍基于YOLOv5基准模型进行的改进策略, 使改进后的YOLOv5模型在农业害虫检测识别领域取得更好效果。

1.2.1" YOLOv5检测算法

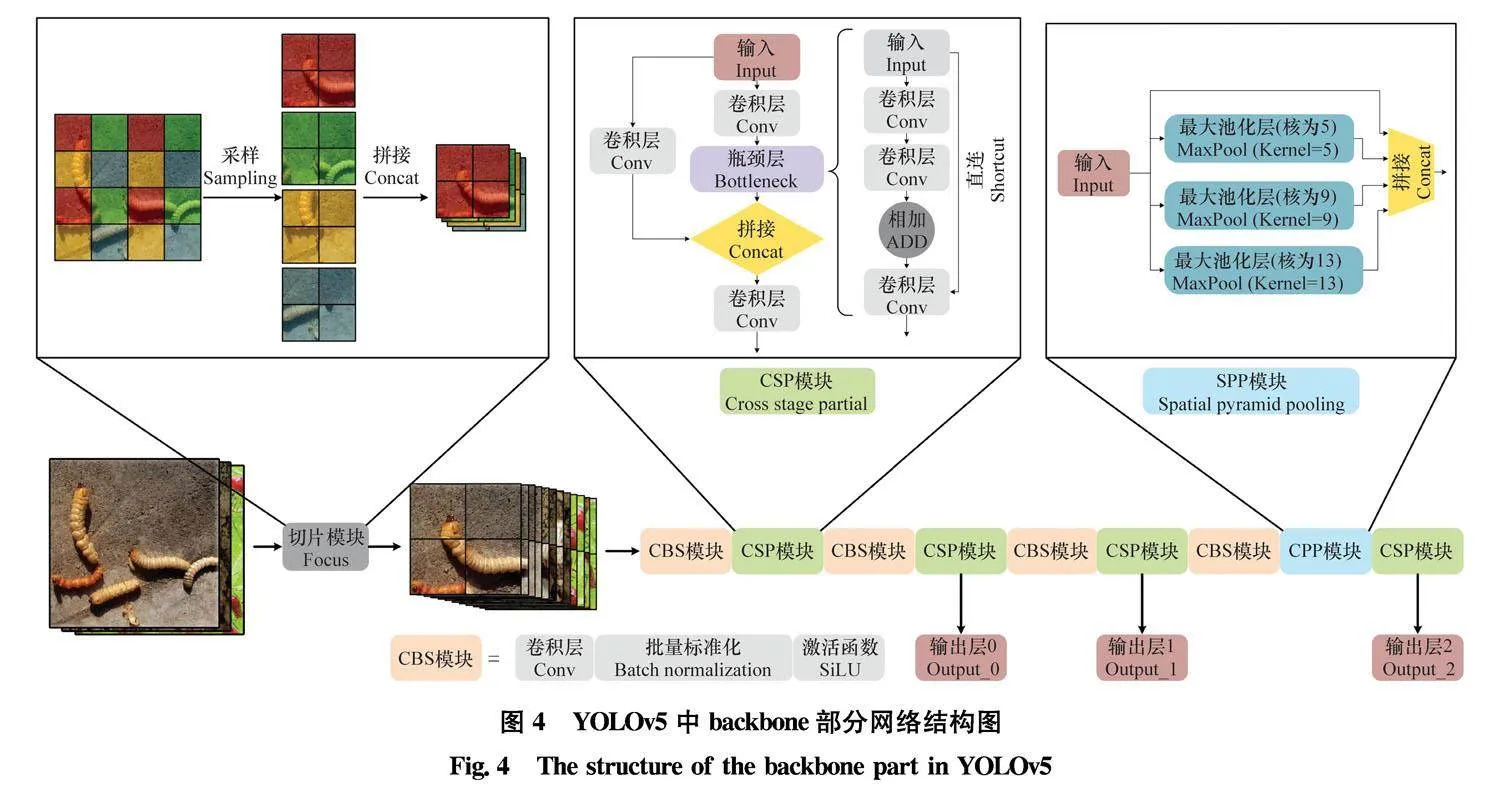

YOLOv5模型主要由Backbone、Neck、Head 3个部分组成。Backbone可以被称作YOLOv5的主干特征提取网络, 输入的图片首先会在主干网络中进行特征提取, 主干网络最终输出的特征可以被称作特征层。在主干部分最终获取3个特征层进行Neck部分网络的构建, 这3个特征层被称为有效特征层。3个有效特征层会在Neck部分进行特征融合, 以获得不同尺度的特征信息。Head是YOLOv5的分类器与回归器, YOLO系列的解耦头是一样的, 也就是分类和回归在一个1×1卷积里实现。

Backbone主要由Focus结构、跨阶段部分(cross stage partial, CSP)结构和空间金字塔池化(spatial pyramid pooling, SPP)结构组成。如图4所示, Focus结构主要用于切片操作, 通过降低计算复杂度和网络层数来提高速度。CSP网络通过将一个网络阶段从开始到结束的梯度变化融入特征层中, 解决了其他大型卷积神经网络框架中梯度信息冗余的问题, 减少了模型的参数和浮点运算量, 保证了推理速度和准确性, 并减小模型尺寸。SPP网络通过融合局部和全局特征丰富了特征层的表达能力, 这有利于待检测图像中目标尺寸差异较大的情况, 并兼容多种尺度的特征。

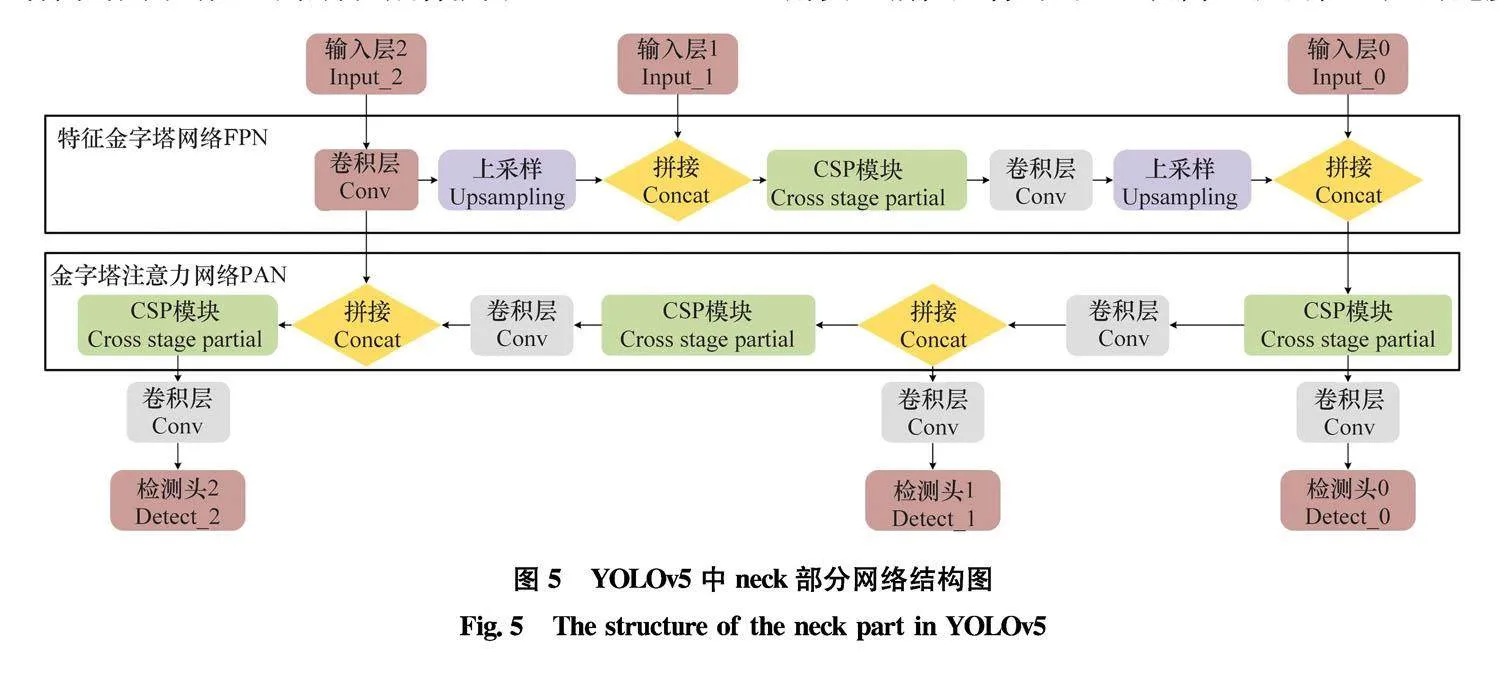

Neck使用特征金字塔网络(feature pyramid network, FPN)和金字塔注意力网络(pyramid attention network, PAN)结构来聚合特征。如图5所示, FPN通过向上采样从上到下传输和集成高级特征信息, 以传递强大的语义特征。PAN是一个自下而上的特征金字塔, 传达了强大的定位特征。两者同时用于增强网络特征融合能力。Head主要用于最终检测部分。它在特征层上生成锚框, 并生成带有类概率、目标得分和锚框的最终输出向量, 其包括锚框的损失函数和非极大抑制(non maximum suppression, NMS)。将锚框的损失函数从CIoU (complete intersection of unit)损失改进为GIoU (generalized intersection of unit)损失, 有效地解决了锚框重合的问题, 提高了预测框回归的速度

和精度。在目标检测的处理过程中, YOLOv5使用加权NMS操作过滤同目标的多个锚框, 增强了对多个目标和遮挡目标的识别能力, 获得了最优目标检测框。

1.2.2" YOLOv5检测算法的改进

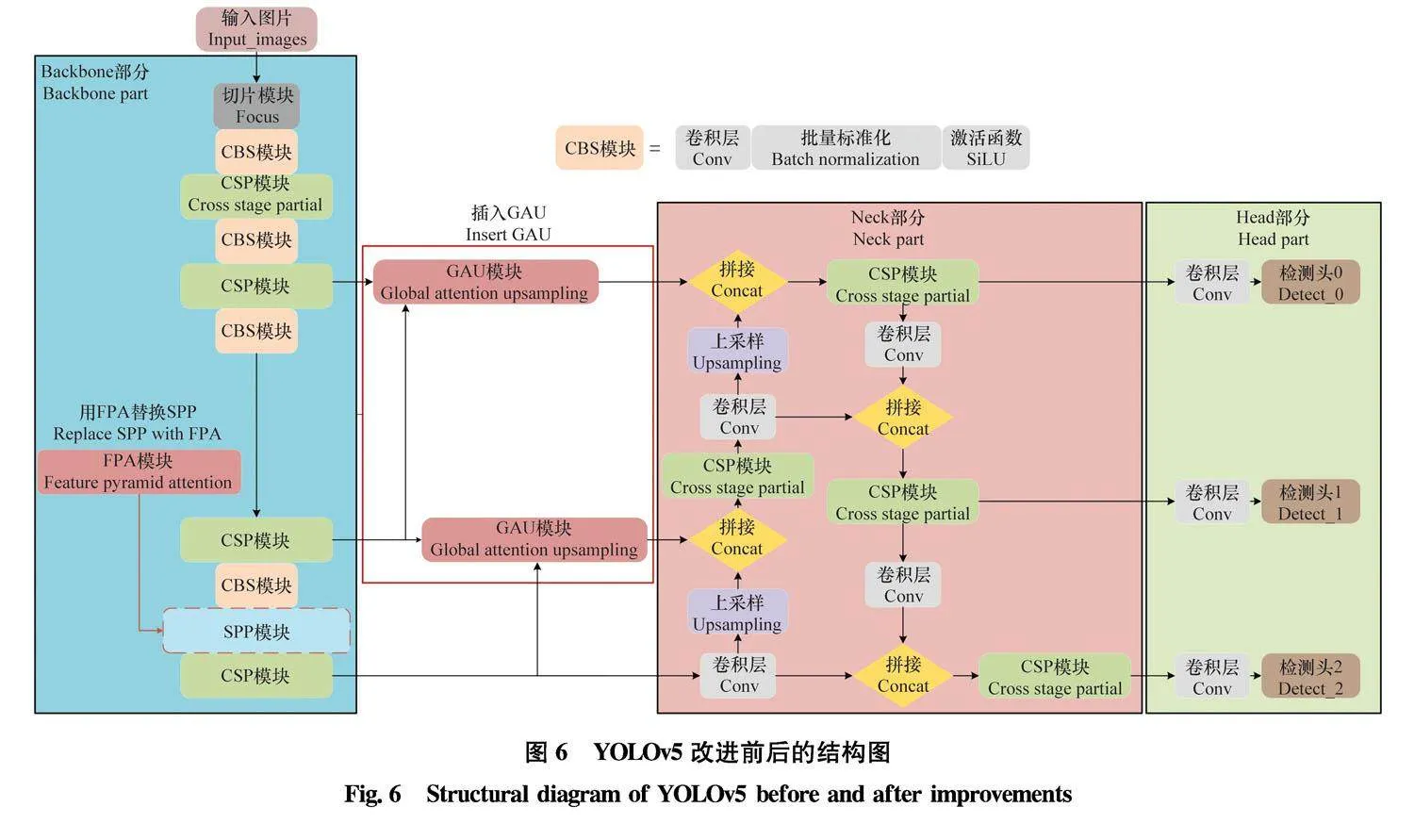

YOLOv5目标检测网络的改进主要分为两部分: 首先, 引入FPA (feature pyramid attention)模块替换Backbone中的SPP模块, 以提取多尺度特征, 进而解决图片中样本尺度各异导致的漏检问题。其次, 在Backbone的3个特征提取层间插入了GAU (global attention upsampling)模块, 用高级特征的全局信息指导低级特征在复杂背景中提取细粒度特征, 以解决害虫复杂背景中的漏检问题、害虫类别相似或种类间变异导致的误判问题。改进后的YOLOv5结构如图6所示。

1.2.2.1" FPA模块

YOLOv5基准模型的主干网络中SPP模块主要是为了解决图像区域裁剪、缩放操作导致的图像失真, 以及卷积神经网络对图像相关重复特征提取的问题, 大大提高了产生候选框的速度, 且节省了计算成本。在YOLO系列网络中SPP模块仅仅是实现了对局部特征和全局特征的提取, 特征层经过局部特征与全局特征相融合后, 丰富了特征层的表达能力, 有利于待检测图像中目标尺寸差异较大的情况。但是, 由于IP102害虫数据集中的害虫样本存在复杂背景、取样多尺度导致的分类困难问题, 仅靠SPP通过空间并行池化难以充分地提取到有效的多尺度特征, 所以本节引入了FPA模块尝试从网络中提取高级特征, 以提取精确的像素级注意力, 能够提取高级特征并有效地对小型目标进行分类。

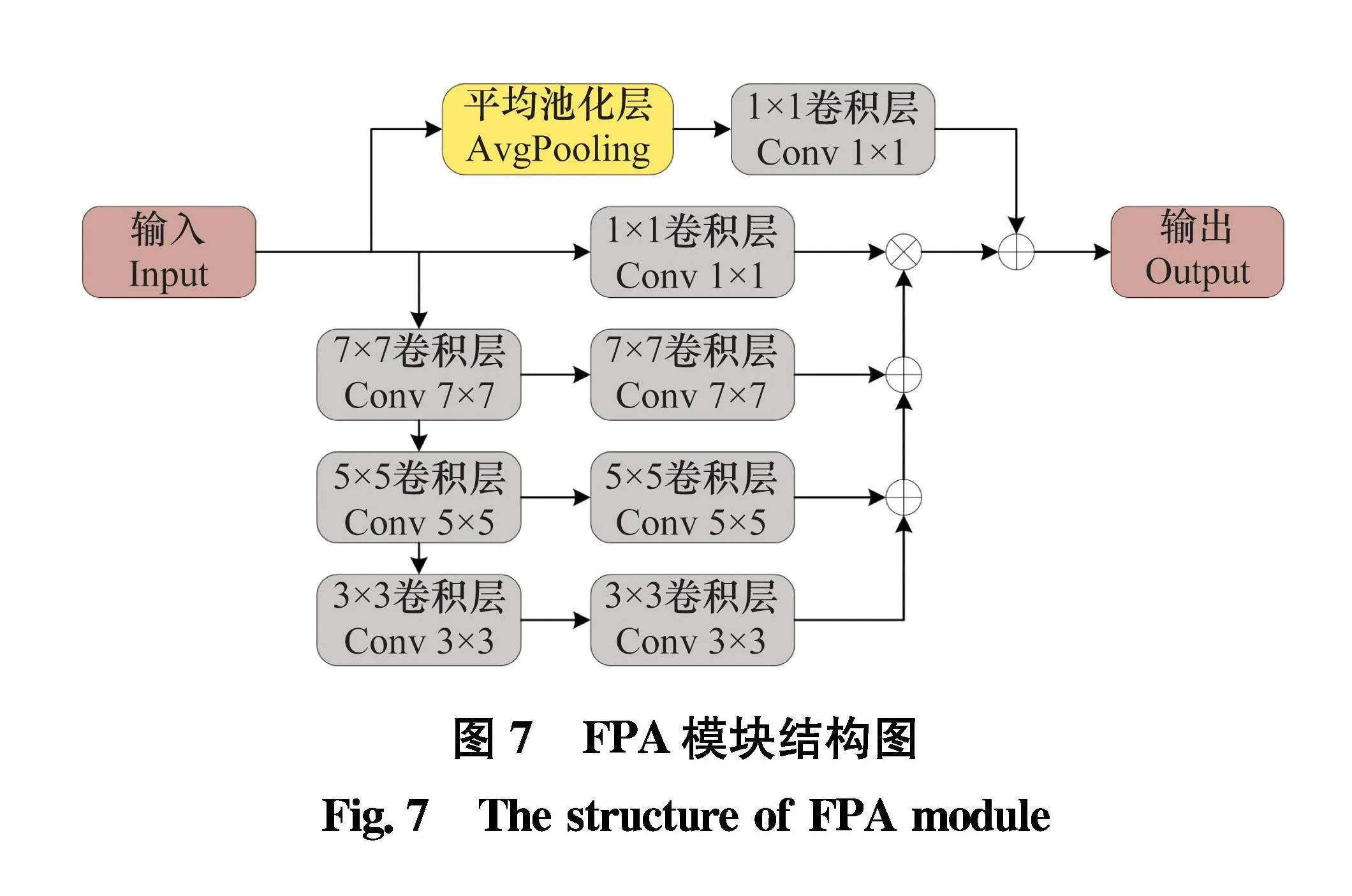

FPA模块通过实现一个类似于U形结构的特征金字塔网络(图7), 融合了3个不同金字塔尺度下的特征。为了更好地从不同的金字塔尺度中提取上下文信息, 本节在金字塔结构中分别使用3×3、5×5、7×7卷积。由于高级特征映射的分辨率很小, 因此使用较大的内核不会带来太多计算负担。金字塔结构逐步整合不同尺度的信息,可以更精确地整合上下文特征的相邻尺度。在经过1×1卷积后, 将来自CNN的原始特征与金字塔注意力特征相乘。

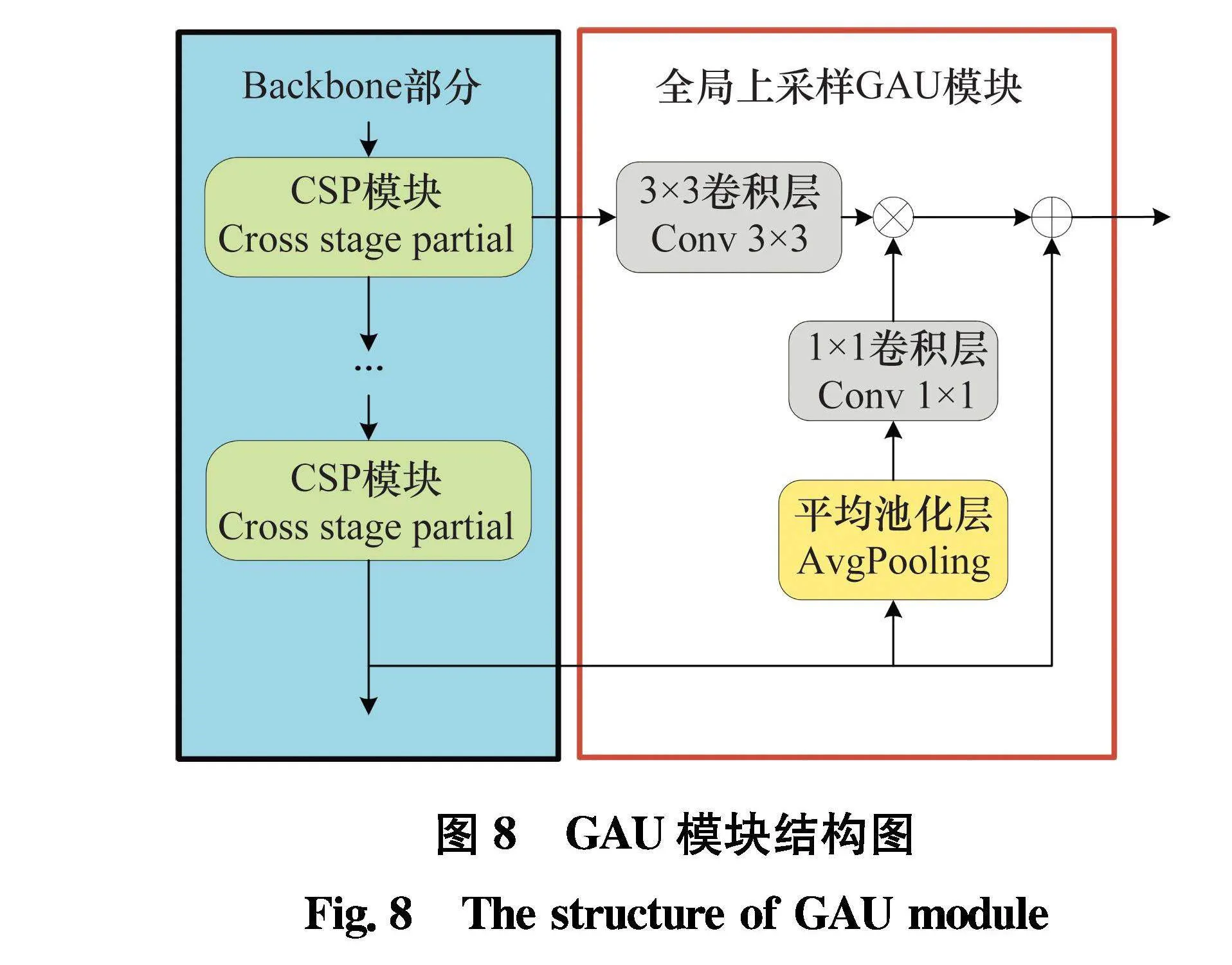

1.2.2.2" GAU模块

在目标检测领域中,将主干网络与特征金字塔模块相结合可以显著提升模型的性能,同时增强模型对多尺度目标特征的表达能力和

类别信息的提取能力。YOLOv5中主干网络有3个特征层输出到金字塔模块,我们希望主干网络输出的特征层能够滤除复杂背景的干扰并更具细粒度特征,进而使得特征层在金字塔模块中更有效地获取类别信息。因此,本研究引入了一种有效的解码器模块,GAU模块,它可以提取高级特征层的全局上下文信息

,指导低级特征的信息加权,且不会增加太多计算负担。

GAU模块执行全局平均池化,以提供全局上下文信息,指导低级特征层选择类别细节。如图8所示, 我们对低级特征进行3×3卷积, 以减少来自CNN的特征映射通道。从高级特征层生成的全局上下文信息是通过1×1卷积和批量归一化和ReLU非线性, 然后乘以低级特征层。最后, 用加权的低级特征直连高级特征, 并逐渐上采样。该模块让高级特征层以简单的方式向低级特征层提供指导信息。

1.3" 试验环境

本试验在个人PC机和python 3.8的软件环境上进行。采用了第十二代Intel (R) CoreTM i5-12600KF 3.69 GHz CPU、12 GB运行内存和NVidia GeForce RTX 3 060 GPU (12 GB内存)。随机选取了IP102增强后数据集共28 055张图片中的90%图像进行模型训练,余下的10%用于模型测试。

训练模型使用预训练权重进行冻结训练,冻结训练阶段批量大小设置为8,冻结训练100个时期,解冻训练阶段批量大小为4,解冻训练100个时期。所有训练过程的最大学习率为0.01,最小学习率为0.000 1,模型优化器选择随机梯度下降优化器。

1.4" 评价指标

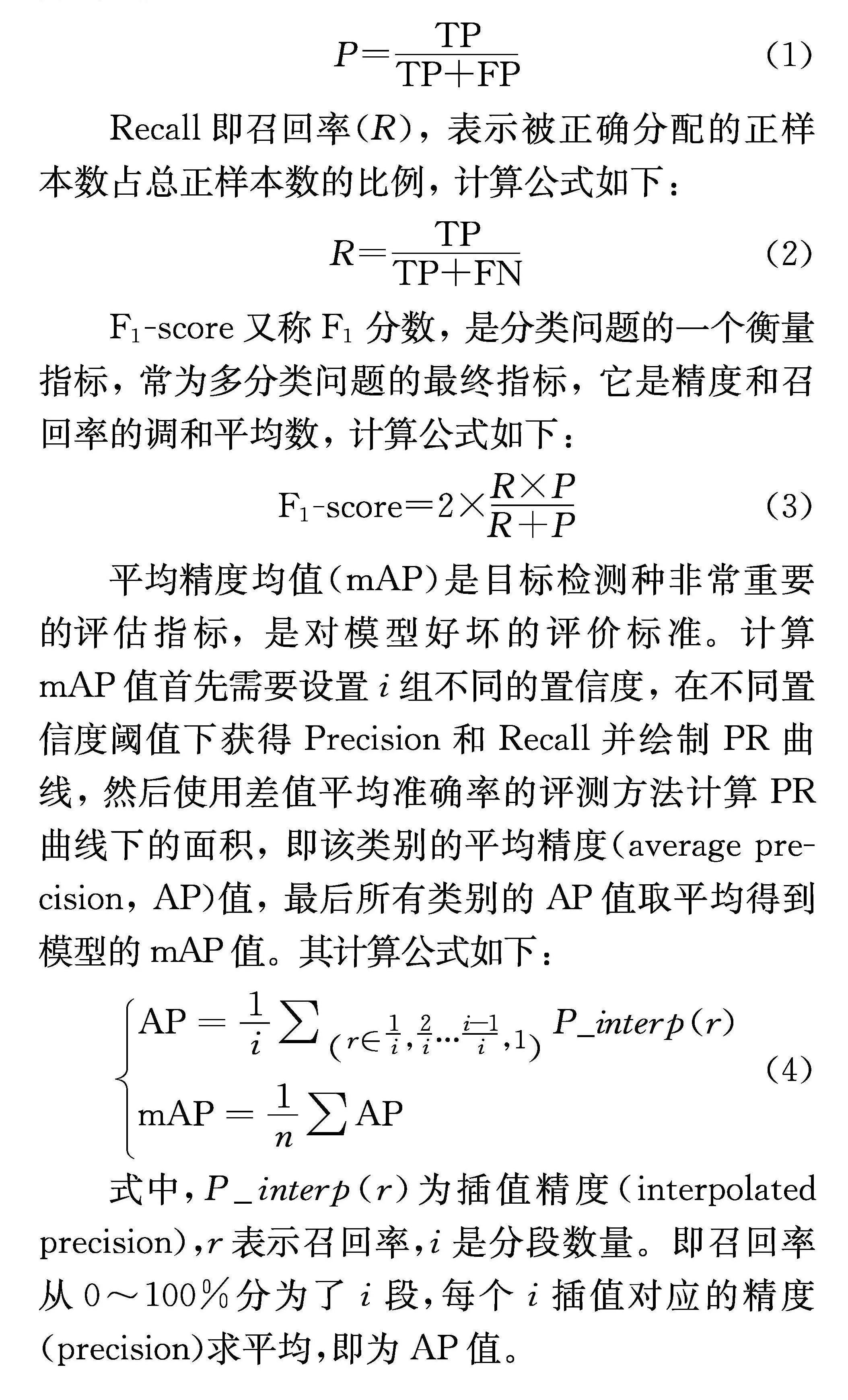

样本被分为正样本且分配正确表示为TP,样本被分为负样本且分配正确表示为TN,样本被分为正样本但分配错误表示为FP,样本被分为负样本但分配错误表示为FN。Precision即精度(P),表示被正确分配的正样本数占总分配的正样本数比例,计算公式如下:

P=TPTP+FP(1)

Recall即召回率(R), 表示被正确分配的正样本数占总正样本数的比例, 计算公式如下:

R=TPTP+FN(2)

F1-score又称F1分数, 是分类问题的一个衡量指标, 常为多分类问题的最终指标, 它是精度和召回率的调和平均数, 计算公式如下:

F1-score=2×R×PR+P(3)

平均精度均值(mAP)是目标检测种非常重要的评估指标, 是对模型好坏的评价标准。计算mAP值首先需要设置i组不同的置信度, 在不同置信度阈值下获得Precision和Recall并绘制PR曲线, 然后使用差值平均准确率的评测方法计算PR曲线下的面积, 即该类别的平均精度(average precision, AP)值, 最后所有类别的AP值取平均得到模型的mAP值。其计算公式如下:

AP=1i∑r∈1i,2i…i-1i,1P_interp(r)

mAP=1n∑AP (4)

式中,P_interp(r)为插值精度(interpolated precision),r表示召回率,i是分段数量。即召回率从0~100%分为了i段,每个i插值对应的精度(precision)求平均,即为AP值。

2" 结果与分析

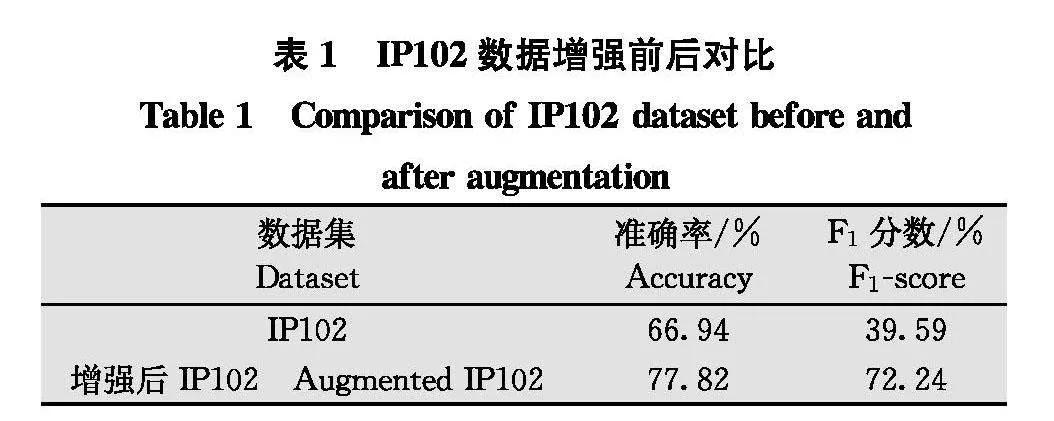

2.1" 数据增强对比试验

为了验证使用增强数据集对模型性能的改进, 在原始数据集和增强数据集上对增强模型进行了训练。训练后模型的性能如表1所示。

结果表明, 在增强数据集上进行训练时, 模型性能有所提高。准确率提升10.88百分点, F1分数提升32.65百分点。这证实了增强后的数据集在保持长尾分布的同时类别样本比例合适, 使模型能够学习更多类别特定的特征, 从而提高其分类性能。

为了验证数据增强能有效提升稀缺类别、少量类别的样本识别效果, 我们将稀缺类别、少量类别的验证结果单独划分呈现, 对比增强前后的试验结果

(表2)表明, 对于稀缺类别进行数据增强, 准确率提升7百分点, F1分数提升47.68百分点;对于少量类别进行数据增强, 准确率提升11.27百分点, F1分数提升18.74百分点。数据增强对于稀缺类别、少量类别的准确率提升较小, 因为样本数量的限制, 稀缺类别、少量类别的特征没有被模型充分学习, 其他类别的样本也不会被误识别为稀缺类别、少量类别。所以增强前的稀缺类别、少量类别精确度会较高, 数据增强对精确度的提升较小。而数据增强对稀缺类别、少量类别的F1分数提升较大, 稀缺类别的F1分数提升更为突出。这证实了数据增强能够很好地解决稀缺类别、少量类别的样本被误分类的问题, 样本数量越少的类别提升更多。

2.2" 消融试验

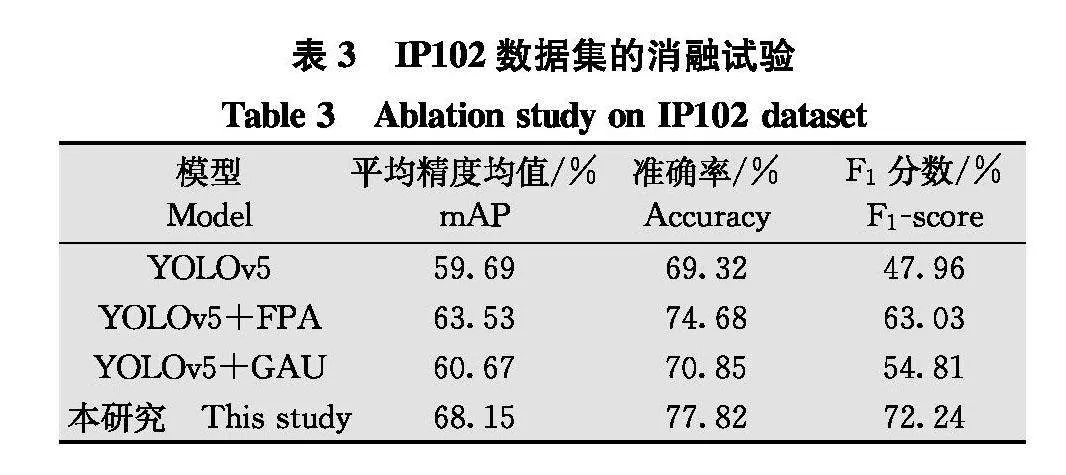

为了证明本文引入的FPA、GAU的有效性, 在IP102数据集上进行消融试验。识别结果如表3所示。

在YOLOv5模型的基础上单独

引入FPA模块进行不同尺度的特征提取, 能够将提取的特征拼接作为注意力机制指导网络进行细粒度特征提取, 与YOLOv5基准模型相比,mAP值提高了3.84百分点, 准确率提升了5.36百分点, F1分数提高了15.07百分点。在YOLOv5模型的基础上单独引入GAU模块,用高级特征的全局信息来指导模型从复杂背景中提取特征, 使得模型在低级特征中能够更精准地提取类别定位细节特征, 进而提高模型识别精度,与YOLOv5基准模型相比,mAP值提高了0.98百分点, 准确度提升了1.53百分点, F1分数提高了6.85百分点。同时引入FPA模块与GAU模块后,与YOLOv5基准模型相比,模型整体mAP值提高了8.46百分点, 准确率提升了8.5百分点, F1分数提高了24.28百分点。模型的识别性能有显著提升。

2.3" 性能比较

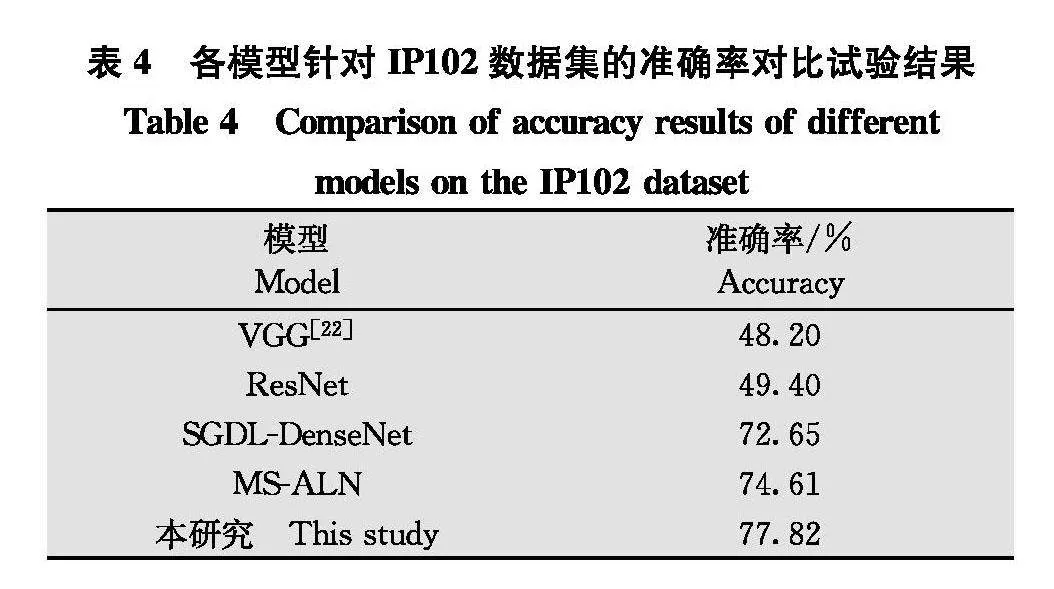

为了验证本文所提出的改进模型在害虫分类中的有效性,将其与经典分类模型以及近年来提出的典型害虫分类算法进行了横向的比较。比较结果如表4所示。

传统分类模型VGG和ResNet在IP102数据集上的分类准确率低于50%, 很难对害虫识别任务进行精确分类。SGDL-DenseNet方法与MS-ALN都是基于IP102害虫数据集进行设计的特定任务网络, 其中MS-ALN在IP102数据集上取得了最好的成绩。本研究基于YOLOv5模型进行改进, 并在IP102上实现了最先进的性能, 准确率为77.82%, 比MS-ALN高3.21百分点。

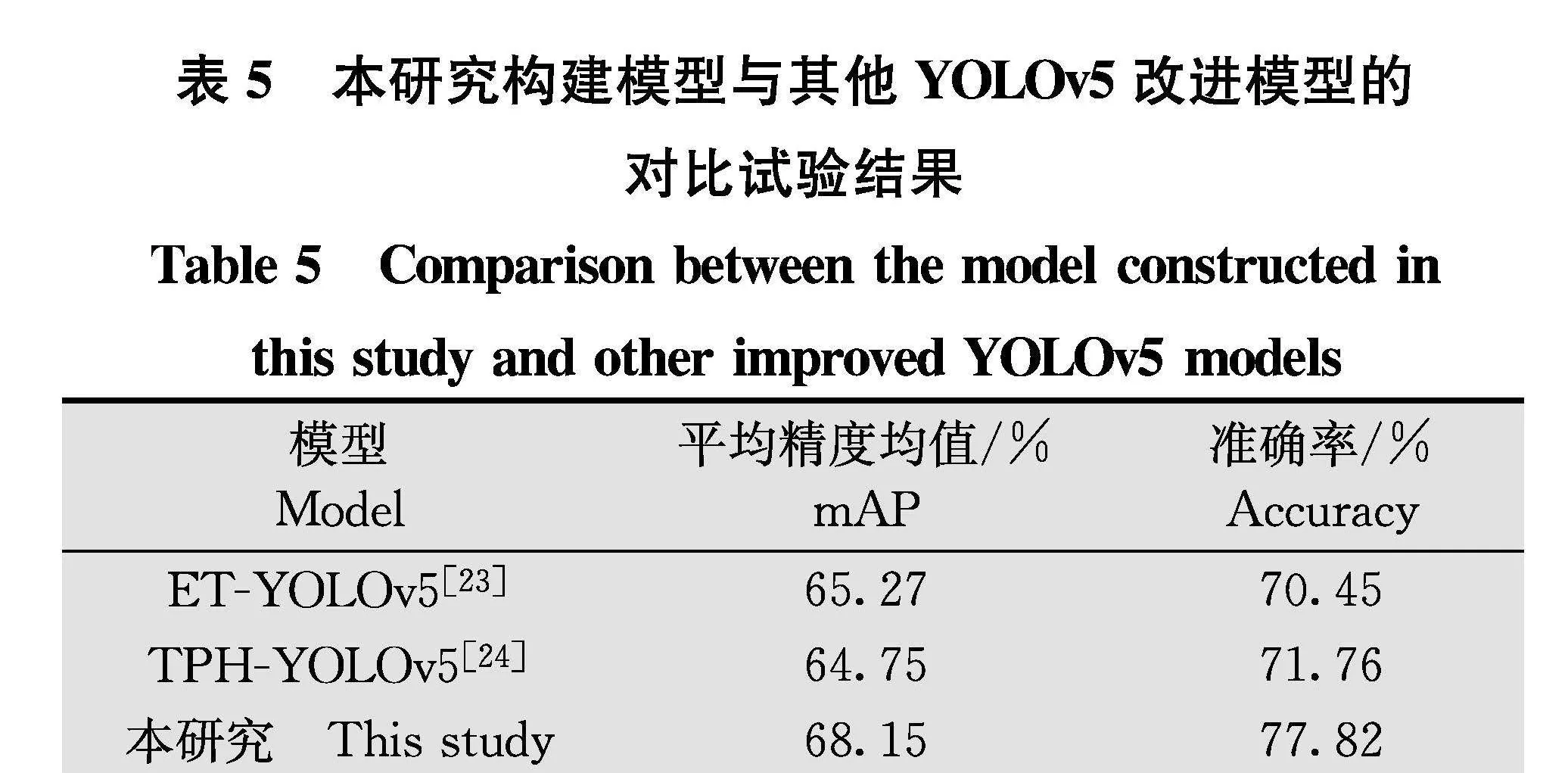

为了验证引进FPA模块与GAU模块的YOLOv5模型能克服害虫识别领域的难题, 将改进后的YOLOv5模型与替他场景应用的改进YOLOv5模型在IP102数据集上进行训练并比较性能。比较结果如表5所示。

ET-YOLOv5在Focus模块后加入了CBAM注意力模块, 并在Neck部分多输出一个160×160大小的检测层, 希望获得更多尺度的特征信息。TPH-YOLOv5在Neck部分中的特征融合模块后都添加了一个CBAM注意力模块, 并在下采样过程中添加Transformer解码模块来获得更多语义信息。将改进后模型与上述2个基于YOLOv5改进的模型进行对比, 在IP102上取得了出色的识别效果, 验证了本研究对YOLOv5模型的改进更适用于害虫自动识别。

2.4" 视觉分析

对于一些具有挑战性的样本图像, 例如复杂背景和多尺度样本引起的漏检以及类内变异或种类间相似引起的误分类, 我们比较了YOLOv5和改进后模型对这些样本的检测和分类结果, 以说明所提出的方法能有效解决害虫自动识别中遇到的问题。

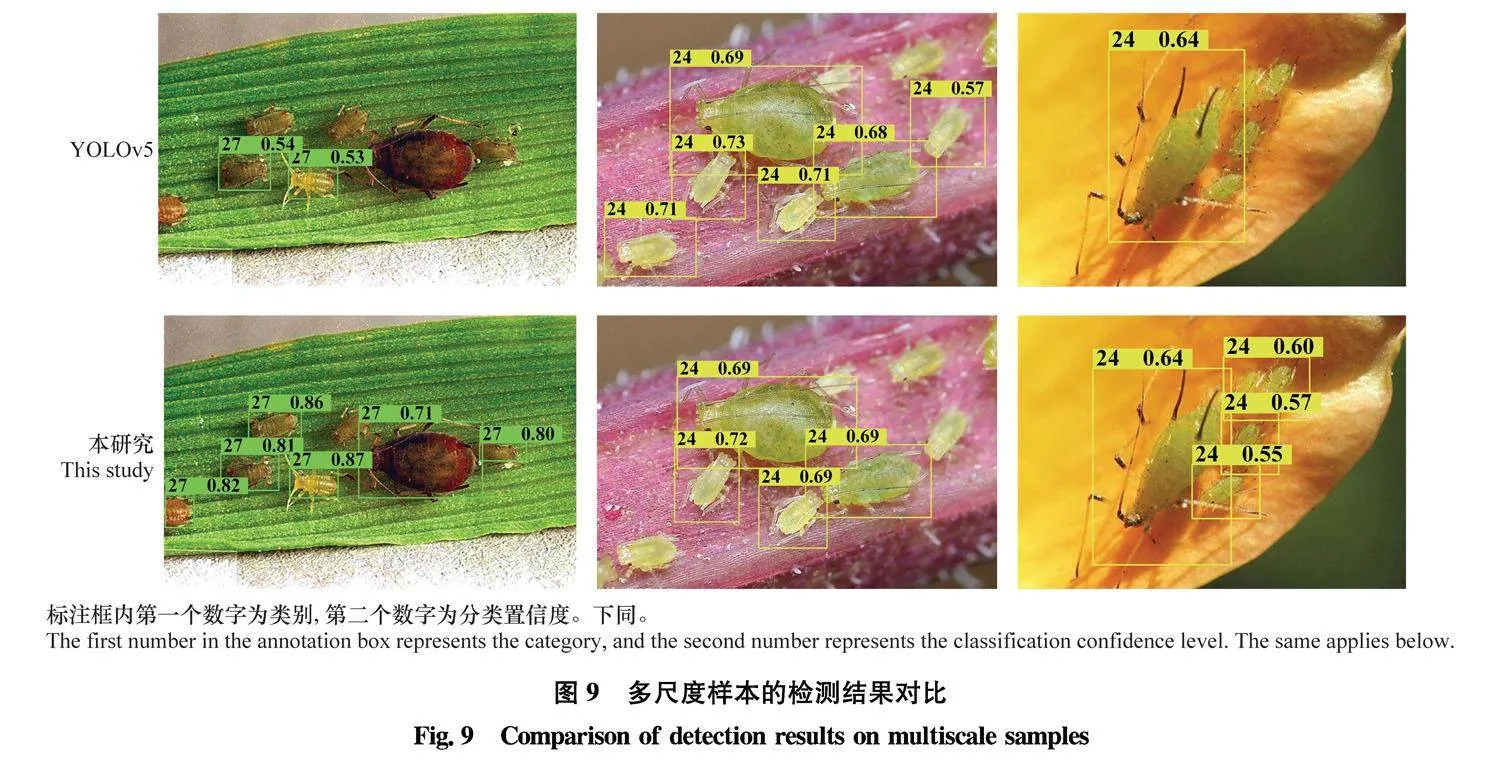

FPA使用不同大小的卷积核提取不同尺度的图像特征,并将其整合为注意力特征乘以原始特征, 使网络能够关注不同尺度的特征。如图9所示,由于某些图像中害虫的尺度变化很大, 基准YOLOv5只关注某些尺度,导致漏检。与基准YOLOv5相比, 改进后模型即使在尺寸差异很大的情况下也能很好地识别和检测害虫。这验证了FPA能够使网络提取多个尺度的特征, 提高不同尺度样本的检测精度。

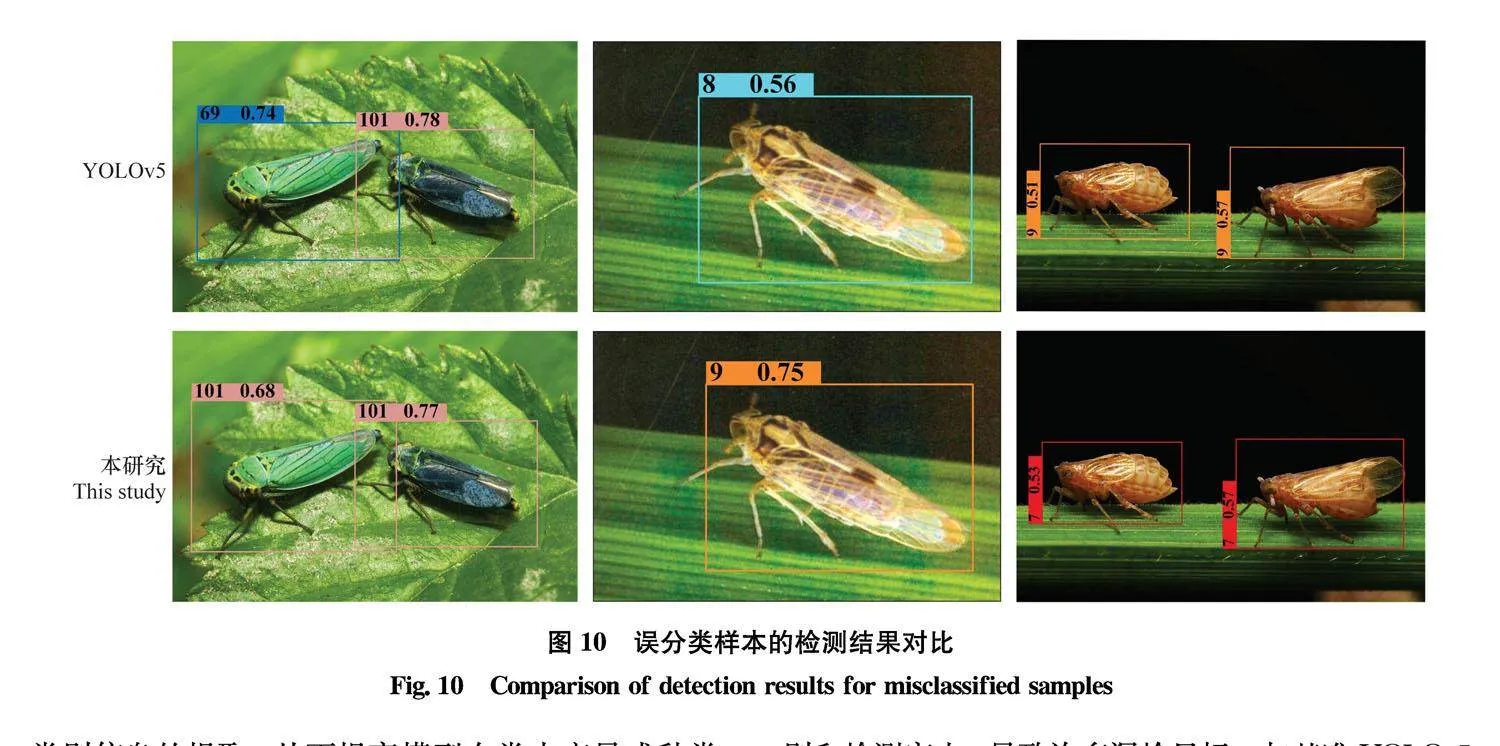

GAU利用来自高级特征的全局信息来指导较低级别特征层中的特征提取。高级特征中细粒度的类别特定信息可以方便低级特征层在特征提取时获取类别信息, 从而提高模型对相似类别进行分类的准确性。如图10所示, 由于类内变异或种类间相似性, 基准YOLOv5在检测和分类过程中会出现类别误判。改进后的模型可以更有效、更准确地提取

类别详细信息来识别害虫种类。GAU高级特征中的细粒度类别信息可以指导低级特征层中更丰富的

类别信息的提取, 从而提高模型在类内变异或种类间相似场景中识别的准确性。

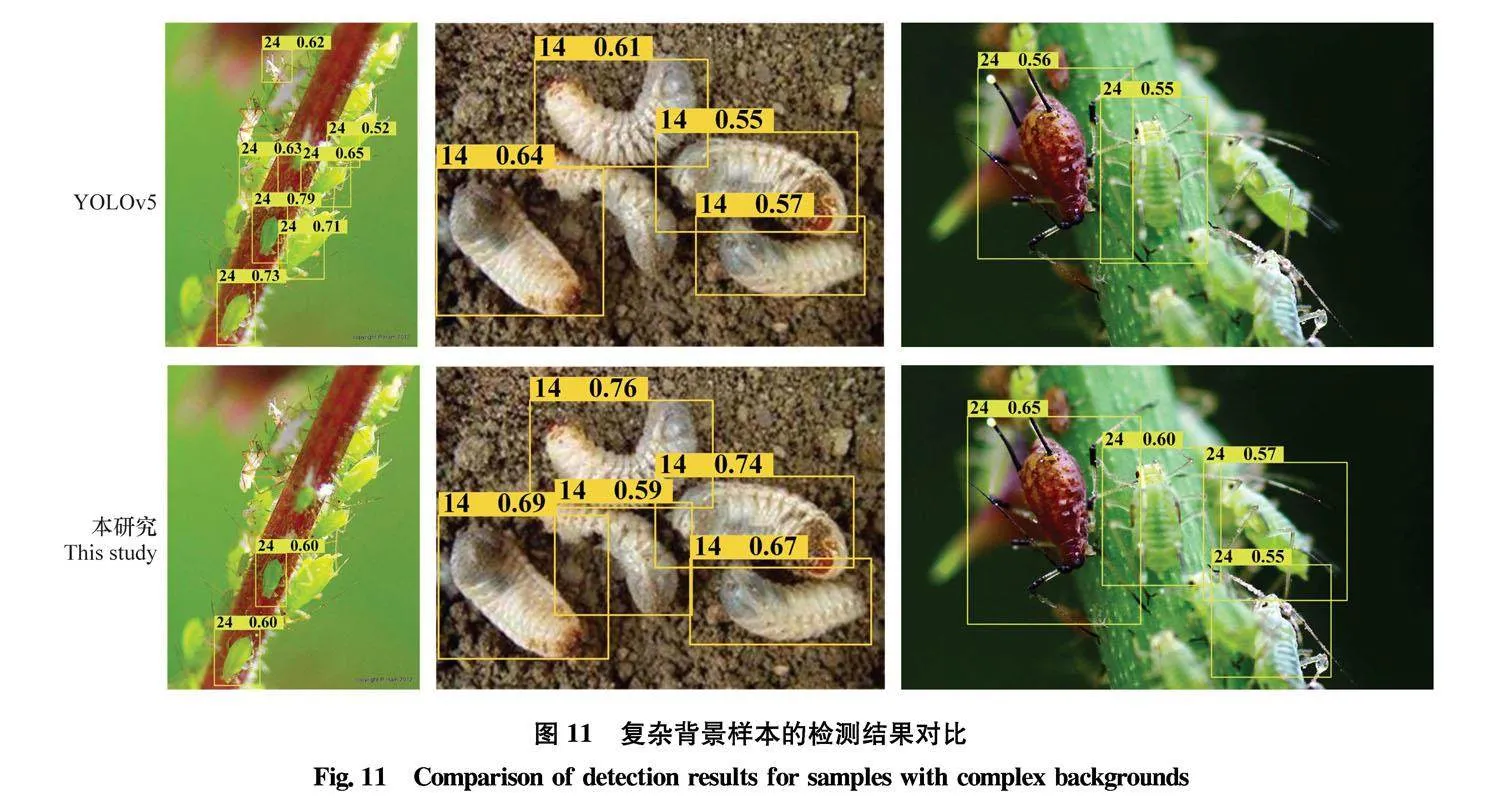

此外, GAU可以使用低分辨率的高级特征来指导低级特征层的特征提取, 使它们能够更多地关注复杂背景中的样本特征信息, 有效地过滤复杂背景。如图11所示, 在一些图像中, 背景和害虫非常相似, 导致基准YOLOv5因害虫融入环境而难以识别和检测害虫, 导致许多漏检目标。与基准YOLOv5相比, 即使害虫与背景的相似度很高, 例如混入泥土的幼虫和融入绿植的蚜虫, 我们的模型仍然可以很好地定位害虫。GAU的引入使得来自高级特征层的低分辨率图像信息能够引导网络在较低级特征层中有效地提取样本特征, 从而使模型克服由于拟态或复杂背景导致的漏检问题。

3" 结论与讨论

本文在基准YOLOv5模型上引入了一种新型特征金字塔(FPA)模块和全局注意力上采样(GAU)模块,提出一种害虫识别检测模型。与现有成果相比, 主要贡献如下: 1)在YOLOv5主干网络中引入了FPA模块, 使网络融合了3个不同金字塔尺度下的特征, 可以更好地从不同的金字塔尺度中提取特征, 有效地增加感受野并对小对象进行分类;2)在YOLOv5特征提取层中引入了全局注意力上采样GAU模块。可以提取高级特征的全局信息, 为选择类别定位细节的低级特征提供指导信息, 进而在精确的分辨率细粒度特征中学习类别信息。能够让模型更有效地从复杂背景中提取目标害虫的特征, 提高识别精度;3)将IP102数据集中的102类害虫根据样本数量进行划分, 进行不同程度的数据增强, 在确保模型鲁棒性的条件下, 仍能保证模型对小样本种类的检测精度。

本文通过数据增强对IP102数据集中的部分类别进行样本扩充, 最终在IP102数据集上进行试验验证, 结果表明: 1)引入的FPA模块可以更好地进行不同尺度的特征提取, 并将提取到的特征作为注意力机制以指导网络进行细粒度特征提取, 有利于提高模型对多尺度样本的检测能力;2)插入的GAU模块用高级特征的全局信息指导模型从复杂背景中提取样本特征, 使模型能够检测到复杂背景中的目标样本;同时, GAU模块在低级特征中能够更精准地提取类别细粒度特征, 有效缓解了类内变异和种类间相似性带来的误判问题;3)对样本数量过少的类别进行数据增强后, 模型对各类别的学习能力更加均衡, 缓解了数据集的长尾分布带来的模型检测低精度问题。此外, 本文还发现,在害虫识别的应用中仍存在着一些问题: 害虫通常包括幼虫、成虫等发育阶段, 不同阶段的形态相差甚远, 这干扰了模型的特征学习并降低了模型识别的准确性, 有待于深入研究。

参考文献

[1]" OERKE E C. Crop losses to pests [J]. The Journal of Agricultural Science, 2006, 144(1): 3143.

[2]" BOLLIS E, PEDRINI H, AVILA S. Weakly supervised learning guided by activation mapping applied to a novel citrus pest benchmark [C]∥Proceedings of the IEEE/CVF conference on computer vision and pattern recognition workshops, 2020: 7071.

[3]" DALAL N, TRIGGS B. Histograms of oriented gradients for human detection [C]∥IEEE computer society conference on computer vision and pattern recognition (CVPR′05), 2005: 886893.

[4]" EBRAHIMI M, KHOSHTAGHAZA M H, MINAEI S, et al. Vision-based pest detection based on SVM classification method [J]. Computers and Electronics in Agriculture, 2017, 137: 5258.

[5]" FAITHPRAISE F, BIRCH P, YOUNG R, et al. Automatic plant pest detection and recognition using k-means clustering algorithm and correspondence filters [J]. International Journal of Advanced Biotechnology and Research, 2013, 4(2): 189199.

[6]" LOWE D G. Distinctive image features from scale-invariant keypoints [J]. International Journal of Computer Vision, 2004, 60(2): 91110.

[7]" NANNI L, MANF A, MAGUOLO G, et al. High performing ensemble of convolutional neural networks for insect pest image detection [J/OL]. Ecological Informatics, 2022, 67: 101515. DOI: 10.1016/j.ecoinf.2021.101515.

[8]" WEN Chenglu, GUYER D. Image-based orchard insect automated identification and classification method [J]. Computers and Electronics in Agriculture, 2012, 89: 110115.

[9]" LARIOS N, DENG Hongli, ZHANG Wei, et al. Automated insect identification through concatenated histograms of local appearance features: Feature vector generation and region detection for deformable objects [J]. Machine Vision and Applications, 2007, 19(2): 105123.

[10]CSURKA G, DANCE C, FAN L X, et al. Visual categorization with bags of keypoints [C]∥Workshop on statistical learning in computer vision, ECCV, 2004: 12.

[11]YAO Qing, L Jun, LIU Qingjie, et al. An insect imaging system to automate rice light-trap pest identification [J]. Journal of Integrative Agriculture, 2012, 11(6): 978985.

[12]HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition [C]∥Proceedings of the IEEE conference on computer vision and pattern recognition, 2016: 770778.

[13]KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks [C]∥Proceedings of the 25th international conference on neural information processing systems, 2012: 10971105.

[14]DIMILILER K, ZARROUK S. ICSPI: intelligent classification system of pest insects based on image processing and neural arbitration [J]. Applied Engineering in Agriculture, 2017, 33(4): 453460.

[15]AYAN E, ERBAY H, VARIN F. Crop pest classification with a genetic algorithm-based weighted ensemble of deep convolutional neural networks [J/OL]. Computers and Electronics in Agriculture, 2020, 179: 105809. DOI: 10.1016/j.compag.2020.105809.

[16]TANG Zhe, CHEN Zhengyun, QI Fang, et al. Pest-YOLO: deep image mining and multi-feature fusion for real-time agriculture pest detection [C]∥2021 IEEE international conference on data mining (ICDM), 2021: 13481353.

[17]WANG Xuqi, ZHANG Shanwen, WANG Xianfeng, et al. Crop pest detection by three-scale convolutional neural network with attention [J/OL]. PLoS ONE, 2023, 18(6): e0276456. DOI: 10.1371/journal.pone.0276456.

[18]WU Xiaoping, ZHAN Chi, LAI Yukun, et al. IP102: A large-scale benchmark dataset for insect pest recognition [C]∥Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, 2019: 87878796.

[19]NANNI L, MAGUOLO G, PANCINO F. Insect pest image detection and recognition based on bio-inspired methods [J/OL]. Ecological Informatics, 2020, 57: 101089. DOI: 10.1016/j.ecoinf.2020.101089.

[20]LUO Qiuhong, WAN Li, TIAN Lichao, et al. Saliency guided discriminative learning for insect pest recognition [C]∥2021 international joint conference on neural networks (IJCNN), 2021: 18.

[21]FENG Fuxiang, DONG Hanlin, ZHANG Youmei, et al. MS-ALN: Multiscale attention learning network for pest recognition [J]. IEEE Access, 2022, 10: 4088840898.

[22]SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [C]∥3rd international conference on learning representations, 2015.

[23]LI Lina, LIU Minghan, SUN Liyan, et al. ET-YOLOv5s: Toward deep identification of students’ in-class behaviors [J]. IEEE Access, 2022, 10: 4420044211.

[24]ZHU Xingkui, LYU Shuchang, WANG Xu, et al. TPH-YOLOv5: Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios [C]∥Proceedings of the IEEE/CVF international conference on computer vision, 2021: 27782788.

(责任编辑:杨明丽)