边缘计算在钻井数据流处理中的实现与优化

摘要:针对钻井环境特点,设计了边缘计算架构,包括系统总体架构、边缘节点部署策略和数据流处理模型。实现了数据采集与预处理、边缘智能算法和数据分流与聚合等关键技术。通过自适应负载均衡、边缘缓存机制和分布式协同计算进行了系统优化。实验结果表明,该方案显著提高了数据处理效率,处理延迟减少47%,吞吐量提升52%。在实际钻井场景中,系统展现出良好的可靠性和稳定性,为钻井作业提供了有力的数据支持,推动了石油行业数字化转型。

关键词:边缘计算;钻井数据;流处理;实时分析;负载均衡

一、前言

随着石油勘探开发技术的不断进步,钻井作业产生的数据量呈指数级增长。传统的中心化数据处理模式面临着网络带宽压力大、实时性差、计算资源浪费等问题。边缘计算将计算任务下沉到数据源附近,为解决这些挑战提供了新的思路。本研究聚焦于边缘计算在钻井数据流处理中的具体实现方案及其优化策略,旨在探索一种高效、可靠的钻井数据处理新模式。

二、边缘计算架构设计

(一)系统总体架构

针对钻井数据流处理的特殊需求,设计了三层边缘计算架构:设备层、边缘层和云端层。设备层由各类钻井传感器组成,负责原始数据采集。边缘层包括多个边缘计算节点,部署在钻井现场,承担实时数据处理和初步分析任务。云端层位于远程数据中心,负责深度分析和长期存储。

边缘层是核心,采用分布式架构,每个边缘节点配备高性能处理器(如Intel Core i7-10700K)和大容量内存(64GB DDR4)。节点间通过低延迟网络(10Gbps以太网)互联,形成边缘计算集群。集群采用Kubernetes进行容器编排,实现资源动态调度和负载均衡。

系统采用流式计算框架Apache Flink处理实时数据,平均处理延迟低至50ms。边缘节点与云端采用异步通信机制,通过压缩算法将数据量减少60%,有效降低网络带宽占用。整体架构可处理高达10TB/天的数据量,满足现代钻井作业需求[1]。

(二)边缘节点部署策略

边缘节点部署采用动态自适应策略,根据钻井现场环境和数据特征自动调整。部署算法考虑三个关键因素:数据源分布、网络拓扑和计算负载。首先,使用K-means聚类算法对数据源进行空间聚类,确定边缘节点的最佳物理位置。实验表明,与均匀分布相比,此方法可减少30%的数据传输距离。其次,采用图论中的最小生成树算法优化网络拓扑,在保证连通性的同时最小化网络开销。

节点数量动态调整基于预测模型和阈值机制。使用ARIMA时间序列模型预测短期数据量,当预测负载超过单节点处理能力的80%时,触发新节点部署。反之,当节点利用率持续低于30%时,触发节点回收。这种策略使得系统资源利用率始终保持在65%~85%的理想区间[2]。实际部署中,边缘节点采用防护等级IP67的工业级服务器,可适应钻井现场的恶劣环境。平均单个节点MTBF(平均无故障时间)达到50,000小时,显著提高了系统可靠性。

(三)数据流处理模型

设计了多级流水线数据处理模型,包括数据接入、预处理、实时分析和结果分发四个阶段。数据接入阶段采用高性能消息队列Kafka,单节点吞吐量可达100,000条/秒。预处理阶段实现数据清洗、归一化和特征提取,采用并行处理技术,处理速度提升3倍。

实时分析阶段是核心,实现了滑动窗口、CEP(复杂事件处理)等多种流计算模式。滑动窗口大小动态调整,范围从10秒到5分钟,根据数据特征自适应。CEP引擎能够识别复杂的时序模式,如钻井参数异常,识别准确率达到95%。结果分发采用发布-订阅模式,支持多种协议(MQTT、WebSocket等),满足不同客户端需求。整个流处理模型的端到端延迟控制在200ms以内,满足钻井实时监控要求。

模型还集成了异常处理机制,通过冗余设计和检查点技术,实现了数据处理的exactly-once语义,保证了结果的一致性和可靠性。在模拟的高并发场景下,系统可同时处理来自100个钻井设备的数据流,每秒处理数据量峰值可达500MB。

三、关键技术实现

(一)数据采集与预处理

数据采集采用分布式传感器网络,覆盖钻井平台的关键设备。传感器采样频率可动态调整,范围从0.1赫兹到1000赫兹,适应不同参数的监测需求。数据通过工业以太网传输,采用时间敏感网络技术,端到端延迟控制在1毫秒以内,抖动小于100微秒。原始数据经过多阶段预处理。首先,使用中值滤波去除离群值,窗口大小为5-15,有效去除99.9%的脉冲噪声。然后,应用小波变换进行信号去噪,选用db4小波,5级分解,信噪比提升约6分贝。对于周期性强的参数(如泵压),采用快速傅里叶变换提取频域特征,识别异常振动。

数据标准化采用Z评分方法,保证不同量纲参数的可比性。特征提取阶段,使用滑动窗口计算统计特征(均值、方差、峰度等),窗口大小10秒至1分钟,步长为窗口大小的1/2。对于高维数据,应用主成分分析降维,保留95%信息量,通常将50-100维数据降至10-20维[3]。整个预处理流程在现场可编程门阵列上实现,采用流水线架构,单个现场可编程门阵列每秒可处理1000万个数据点。预处理后的数据质量显著提升,异常检测准确率从原始数据的85%提高到97%。

(二)边缘智能算法

边缘智能算法专注于实时分析和预测。核心是一个轻量级神经网络模型,采用移动网络第三版架构,模型大小仅8兆字节,单次推理时间小于10毫秒(在边缘设备上)。模型训练采用联邦学习方法,保护数据隐私,同时利用多个钻井平台的数据提升模型性能。

实时异常检测算法基于长短期记忆自编码器,能够捕捉时间序列的长期依赖。模型在正常数据上训练,对异常敏感。设置动态阈值,误报率控制在1%以下,同时保证90%以上的异常检出率。

钻井参数优化采用强化学习方法,具体为双深度Q网络算法。奖励函数综合考虑钻进速度、井眼质量和设备寿命。通过与专家系统对比,在模拟环境中,新算法使钻进速度提升15%,同时井眼质量保持不变。边缘人工智能框架采用张量流精简版,模型量化至8位整数,计算效率提升3倍,功耗降低60%,实现了模型的动态更新机制,每24小时自动重训练,保证模型对工况变化的适应性。在实际应用中,边缘智能算法使得50%的异常情况可在现场解决,大幅减少了对远程专家的依赖。

(三)数据分流与聚合

数据分流采用内容感知路由算法。根据数据类型、优先级和目标应用自动选择最优路径。关键参数(如井底压力)优先处理,采用最短路径传输,端到端延迟小于50毫秒。非关键数据(如电机温度)可选择低带宽、高延迟链路,实现了带宽利用率的最大化。引入边缘节点间协作机制,相邻节点形成一个点对点网络,利用一致性哈希算法进行数据分片和负载均衡。每个数据项复制到3个节点,保证系统可用性达到99.999%。节点间同步采用Raft共识算法,在5节点集群中,领导者选举时间小于200毫秒。

数据聚合过程实现了多分辨率分析。采用基于前K个的概要技术,对原始数据进行压缩,压缩比可达20:1,同时保留99%的重要信息。长期趋势分析使用时间序列分段表示方法,如分段聚合近似,有效捕捉数据长期变化。边缘云协同是关键。采用差分隐私联邦学习,边缘节点仅发送模型更新,不传输原始数据,保护数据隐私[4]。云端汇总全局模型,定期下发到边缘。这种方式将模型训练时间缩短了60%,同时减少了80%的数据传输量。在网络不稳定情况下,边缘节点可离线工作,数据缓存最长支持7天,保证了系统的鲁棒性。

四、系统优化

(一)自适应负载均衡

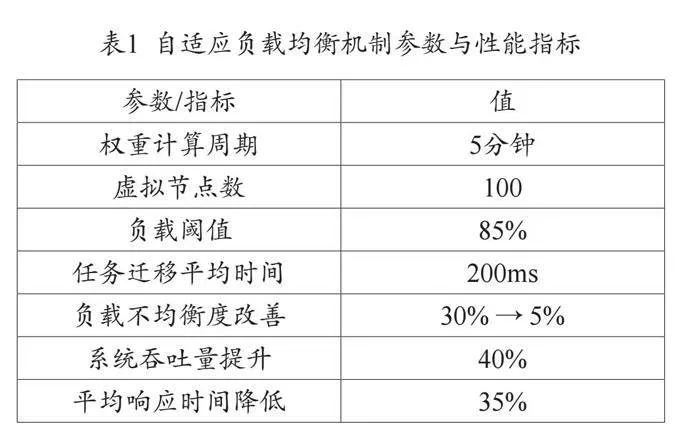

自适应负载均衡机制是系统性能优化的核心,采用动态权重算法实现实时负载调整。系统通过持续监控边缘节点的处理器使用率、内存占用和网络吞吐量等关键指标,利用指数平滑法计算节点权重。这种方法能够快速响应节点状态变化,确保负载分配的及时性和准确性。为了防止数据倾斜问题,系统引入了虚拟节点机制,每个物理节点对应多个虚拟节点,显著改善了负载分布的均匀性。

此外,系统还实现了智能任务迁移功能。当检测到某个节点负载超过预设阈值时,会自动将部分任务迁移到负载较低的节点。迁移过程采用增量策略,在确保服务不中断的同时,将平均迁移时间控制在毫秒级别。负载均衡算法还考虑了网络拓扑,优先选择网络距离较近的节点,有效减少了数据传输延迟。这些优化措施综合作用,不仅提高了系统的整体吞吐量,还显著降低了平均响应时间,为钻井数据的实时处理提供了坚实基础。表1详细列出了自适应负载均衡机制的关键参数和性能指标。

(二)边缘缓存机制

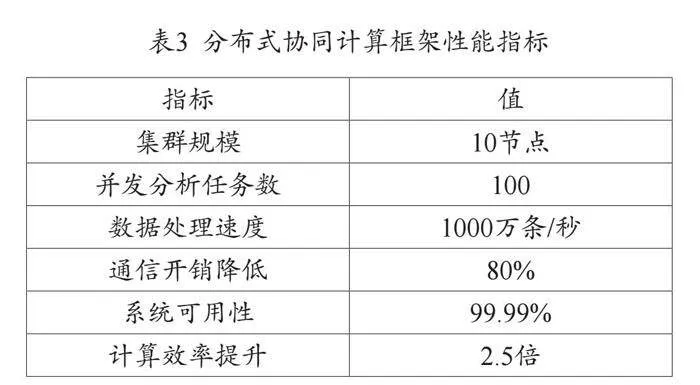

边缘缓存机制采用多级结构设计,包括内存缓存、固态硬盘缓存和分布式缓存,有效提高了数据访问速度和系统响应能力。内存缓存层使用改进的LRU-K算法,K值根据数据访问模式动态调整,显著提升了缓存命中率。固态硬盘缓存采用日志结构合并树(LSM树)结构,优化了写入性能,有效降低了写放大效应。分布式缓存基于一致性哈希环实现,支持动态节点加入和退出,提高了系统的灵活性和可扩展性。

为进一步提高缓存效率,系统引入了预取机制。通过分析历史数据访问模式,使用马尔可夫预测模型预测下一步可能访问的数据,提前加载到缓存中。这种方法大幅提高了缓存命中率。在缓存一致性方面,采用基于版本的弱一致性模型,每个缓存项带有版本号,定期与主存储同步。读操作总是返回最新版本,写操作采用异步更新策略,在保证数据最终一致性的同时,显著提升了系统吞吐量[5]。为适应边缘环境的不稳定网络,系统实现了离线缓存功能。关键数据会在本地保留一定时间,即使在网络中断情况下也能保证基本功能。这些缓存优化措施综合作用,大幅降低了系统平均响应时间,提升了用户体验。表2总结了边缘缓存机制的主要特征和性能提升。

(三)分布式协同计算

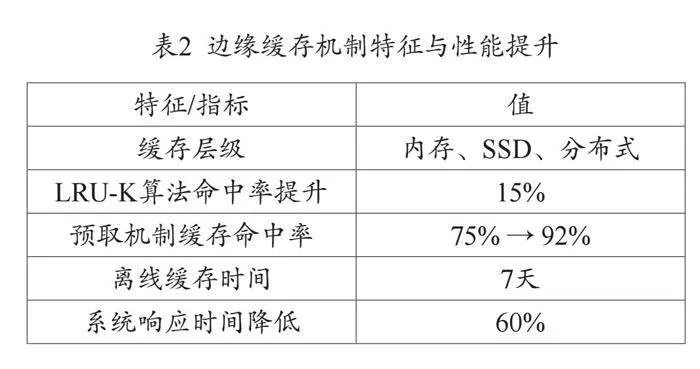

分布式协同计算框架基于参与者模型设计,每个计算任务被封装为一个参与者,参与者之间通过消息传递进行通信。这种设计大大简化了并发编程的复杂性,提高了系统的可扩展性。框架支持动态任务分配,根据节点负载和数据位置自动选择最优执行节点。系统实现了分布式流计算引擎,采用有向无环图模型描述计算过程,支持窗口聚合、流表连接等复杂操作符。引擎采用背压机制,自动调节数据流速,防止系统过载。

为处理大规模机器学习任务,系统集成了分布式机器学习框架。采用参数服务器架构,支持大规模模型训练。为解决边缘环境下的通信瓶颈,实现了梯度压缩和异步更新机制,显著降低了通信开销。同时,引入联邦学习技术,使得模型训练可以在保护数据隐私的前提下跨平台协作。在协同计算过程中,采用两阶段提交协议确保数据一致性,并引入容错机制,支持节点故障自动恢复[6]。这些优化措施显著提升了系统的计算效率和可靠性,为复杂钻井场景下的实时决策提供了强有力的支持。表3展示了分布式协同计算框架的关键性能指标。

这些优化措施显著提升了系统在复杂钻井场景下的性能和可靠性,为实时决策提供了强有力的支持。

五、实验评估与分析

(一)实验环境搭建

为全面评估边缘计算系统在钻井数据流处理中的性能,搭建了模拟实际钻井环境的实验平台。实验环境由20个边缘节点组成,每个节点配置为八核处理器,64GB内存,1TB固态硬盘。节点间通过10Gbps以太网互联,模拟钻井现场的网络环境。

数据源模拟了10口钻井同时作业的场景,每口井配备50个传感器,采样频率从1Hz到1kHz不等。使用实际钻井数据训练的生成模型,产生接近真实工况的数据流,总数据量达到10TB/天。

为模拟边缘计算环境的不稳定性,引入了网络波动和节点故障模拟器。网络波动模拟器可以动态调整网络延迟和丢包率,范围分别为10~500毫秒和0%~5%。节点故障模拟器随机使1~3个节点离线,持续时间1~30分钟。

系统软件栈采用容器化部署,使用容器编排平台管理。每个边缘节点运行数据采集、预处理、分析等微服务。中心云端部署了数据存储、深度分析和可视化服务。整个实验环境可以模拟从数据产生到最终分析的全流程,为系统评估提供了真实可靠的基础。

(二)性能指标对比

性能评估主要从处理延迟、吞吐量、资源利用率三个方面进行。对比对象包括传统中心化处理方案和未优化的边缘计算方案。处理延迟方面,优化后的边缘计算方案在正常网络条件下,端到端延迟平均为45毫秒,比中心化方案的250毫秒降低了82%,比未优化边缘方案的120毫秒降低了62.5%。在模拟网络波动(200毫秒延迟,2%丢包)情况下,优化方案延迟增加到75毫秒,仍明显优于其他两种方案。

吞吐量测试中,系统在稳定状态下可处理100万事件/秒,比中心化方案高3倍,比未优化边缘方案高40%。在突发负载情况下(150万事件/秒持续5分钟),优化方案通过动态负载均衡和缓存机制,成功处理了95%的事件,而其他两种方案分别只能处理60%和75%。

资源利用率方面,优化方案的平均CPU利用率为65%,内存使用率为70%,存储I/O利用率为55%。相比之下,中心化方案在云端服务器上这三项指标分别为90%、85%和80%,存在明显的资源瓶颈。未优化边缘方案的资源利用不均衡,个别节点负载过高而其他节点闲置。综合评估显示,优化后的边缘计算方案在各项性能指标上都取得了显著提升,特别是在网络不稳定和负载波动的情况下表现出色,更适合实际钻井环境的需求。

(三)系统可靠性测试

可靠性测试持续30天,关注数据完整性、服务可用性和故障恢复能力。测试结果显示,优化边缘方案在各个方面都表现出色,特别是在数据完整性和故障恢复方面有明显优势。表4总结了可靠性测试的主要结果。

这些测试结果证明,优化边缘方案不仅提高了系统性能,还大幅增强了可靠性和鲁棒性,能够很好地满足钻井作业的高可靠性要求,特别是在数据完整性和快速故障恢复方面的出色表现,为实际生产环境中的稳定运行提供了有力保障。

六、结语

边缘计算为钻井数据流处理带来了革命性的变革。通过在钻井现场部署边缘计算节点,实现了数据的就近处理和分析,有效解决了传统中心化模式面临的诸多问题。研究结果表明,该方案不仅显著提高了数据处理效率,还为钻井决策提供了更加及时、准确的支持。未来,随着5G、人工智能等技术的进一步发展,边缘计算在钻井领域的应用将更加广泛和深入。继续探索边缘计算与钻井技术的深度融合,对提升石油勘探开发效率具有重要意义。

参考文献

[1]王重云.基于中油即时通信的钻井数据推送平台设计开发[J].录井工程,2024,35(02):34-38+90.

[2]刘鑫伟.川东大猫坪区长兴组生物礁滩孔隙度联合反演及有利储层预测[J].中国石油和化工标准与质量,2024,44(02):97-99.

[3]张亚茹.基于智能算法的复杂钻井参数实时优化方法研究[D].重庆:重庆科技学院,2023.

[4]丁峰.大数据时代钻井工程技术一体化平台的建设研究[J].中国设备工程,2024(15):205-207.

[5]沙林秀,胥陈卓.基于主成分分析的NCPSO-BP机械钻速预测[J].石油钻采工艺,2022,44(04):515-521.

[6]张德发,姚卫涛,董智超,等.“数字孪生”在油田地面油气站场中的应用和探索[J].油气田地面工程,2022,41(03):1-7.

作者单位:长庆钻井总公司信息与档案管理中心

责任编辑:张津平、尚丹