模拟神经反馈机制和工作记忆的图像分类网络模型

摘" 要:该项目在卷积神经网络(CNN)中引入神经反馈机制和工作记忆机制,提出层内深度反馈卷积神经网络模型(IDFNet)。该网络以神经反馈机制构建深度反馈计算模块(DFS),并在模块中引入了工作记忆(WM),通过深度变化控制WM空间内容的更新,从而增强了信息获取能力。最后,利用DFS替代CNN的卷积层构建IDFNet网络。通过在Flower102和CIFAR-10、CIFAR-100数据集上的实验表明,相较于同类网络,在更少参数量和计算量的情况下,IDFNet仍取得显著的性能提升,其识别率分别达到了96.61%和95.87%、79.99%。

关键词:反馈机制;工作记忆;循环计算;图像分类

中图分类号TP391.4" 文献标识码:A" " " " 文章编号:2096-4706(2024)10-0001-06

Image Classification Network Model of Simulated Neural Feedback Mechanism

and Working Memory

TONG Shunyan, LIU Haihua

(School of Biomedical Engineering, South-Central Minzu University, Wuhan" 430074, China)

Abstract: This project introduces neural feedback and working memory mechanisms into Convolutional Neural Networks (CNN) and proposes an Intra-Layer Deep Feedback Convolutional Neural Network Model (IDFNet). The network constructs a Deep Feedback Structure (DFS) using neural feedback mechanisms, and introduces a Working Memory (WM) within this module. It controls the update of WM spatial content by depth variations, so as to enhance information retrieval capabilities. Finally, the IDFNet network is built by replacing CNN's convolutional layers with DFS. Experimental results on the Flower102, CIFAR-10, and CIFAR-100 datasets demonstrate that IDFNet achieves significant performance improvements compared to similar networks, with higher recognition rates of 96.61%, 95.87%, and 79.99%, respectively, while requiring fewer parameters and computations.

Keywords: feedback mechanism; working memory; loop computation; image classification

0" 引" 言

神经网络模型经过几十年不懈研究,取得了显著的突破和进步。从最初的感知器模型到今天的深度神经网络模型,且在语音识别、图像识别、自然语言处理等多应用领域持续演进。在神经网络的发展中,模型的规模和复杂性在不断增加,出现了AlexNet 11 [1]、VGGNet [2]、Googlenet [3]、ResNet [4]、DenseNet [5]、SENet [6]等模型及其变体。然而,在面对多样性和复杂性的图像数据时,更深和更宽的网络模型发展面临瓶颈。为此,人工神经网络模型需要引入生物神经网络的一些属性,以提升模型的能力。

在人脑神经网络中,神经元间除存在前馈连接,还有反馈侧连接。神经生物学研究表明,反馈连接的数量是前馈连接的几倍[7]。而反馈机制使神经系统能处理时间序列数据。基于此,循环神经网络(RNN)[8]被开发,并广泛应用于文本、音频和视频等数据的模式识别。此外,工作记忆(Working Memory, WM)是神经系统的重要功能[9]。WM不仅能实现信息的存储,还能对信息进行处理、转换和整合。研究发现WM的空间是有限的[10],其引入神经网络模型可以有效地控制模型的规模和复杂性。

综合上述分析,本文将神经反馈机制和工作记忆机制与卷积神经网络(CNN)相融合,提出了层内深度反馈卷积神经网络模型(Intra-Layer Deep Feedback Convolutional Neural Network Model, IDFNet),以有效完成图像模式识别任务。与传统的CNN不同,深度反馈结构的每层进行循环计算,同时更新工作记忆区域的信息,并将工作记忆中的信息融合作进行复用,以获取更有效的特征信息,提高模型的识别性能。

1" 相关工作

近年来,应用于图像识别的前向深度神经网络模型主要是通过增加模型的深度或宽度,以增强网络拟合能力,提升模型的性能。在这些模型的基础上,Dropout [11]、残差连接[7]、最小批量归一化[12]、密集连接[8]、注意力机制[6,13]等技术被采用,进一步加强了网络模型内部信息的融合,从而显著提升模型的性能。

反馈神经网络模型也应用于模式识别,但主要应用于序列数据,其典型的模型为循环神经网络模型(RNN)。然而,该模型在处理长时依赖性数据时会导致梯度消失或梯度爆炸问题。为此,学者提出了多种改进的RNN模型,如长短期记忆网络(LSTM)[14]和门控循环单元(GRU)[15]。这些模型主要是通过门控的方式对信息进行判断和筛选,在避免梯度消失和爆炸问题的基础上,有效捕获长序列的关键信息。但是,这些模型只是处理序列数据,而不能处理图像数据。

处理图像数据,运用反馈机制的神经中心环绕相互作用,可以不断筛选和加工视觉信息[16]。最典型的是Cao等人提出的Feedback模型[17],该模型由脉冲神经元激活变量z ∈ {0,1}与每个ReLU层组合构成反馈层,以自下而上和自上而下的方式主动调节神经元的响应。而Wen等人使得相邻层在前馈过程中能够进行局部且循环的交互,提出了PCN模型[18]。另外,Yu等人在递归卷积神经网络的基础上引入了自注意力机制,提出了自注意力循环卷积神经网络(A-RCNN)[19],以完成图像分类任务。

工作记忆机制在残差连接和密集连接的神经网络中有所体现,基于网络的深度[20]和宽度[21]的考量,衍生出了不同的残差(ResNet)和密集网络(DenseNet)模型的变体。例如,Sergey等人通过增加ResNet每层网络的宽度,而减少网络深度提出WRN [22]网络;而Han等人根据深度的增加逐渐调整宽度,提出金字塔残差网络(PyramidNet)[23];Gao等人提出多尺度的残差网络Res2Net [24]。同样地,Huang等人提出了多尺度密集网络(MSDnet)[25],该网络自适应地处理多尺度输入数据;随后,CondenseNet [26]和CondenseNetv2 [27]网络对密集结构进一步改进,从而提升其性能。尽管这些改进是有益的,但仍未解决残差和密集网络存在的一些固有问题[5,28]。

2" 层内深度反馈卷积神经网络

2.1" 深度反馈结构

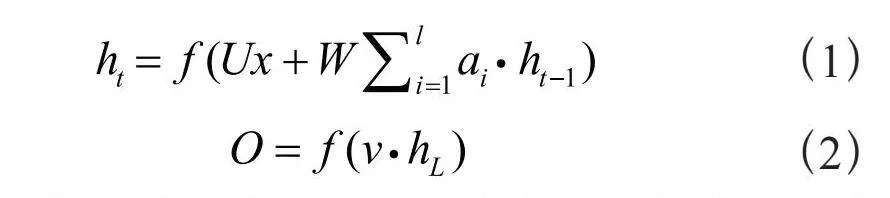

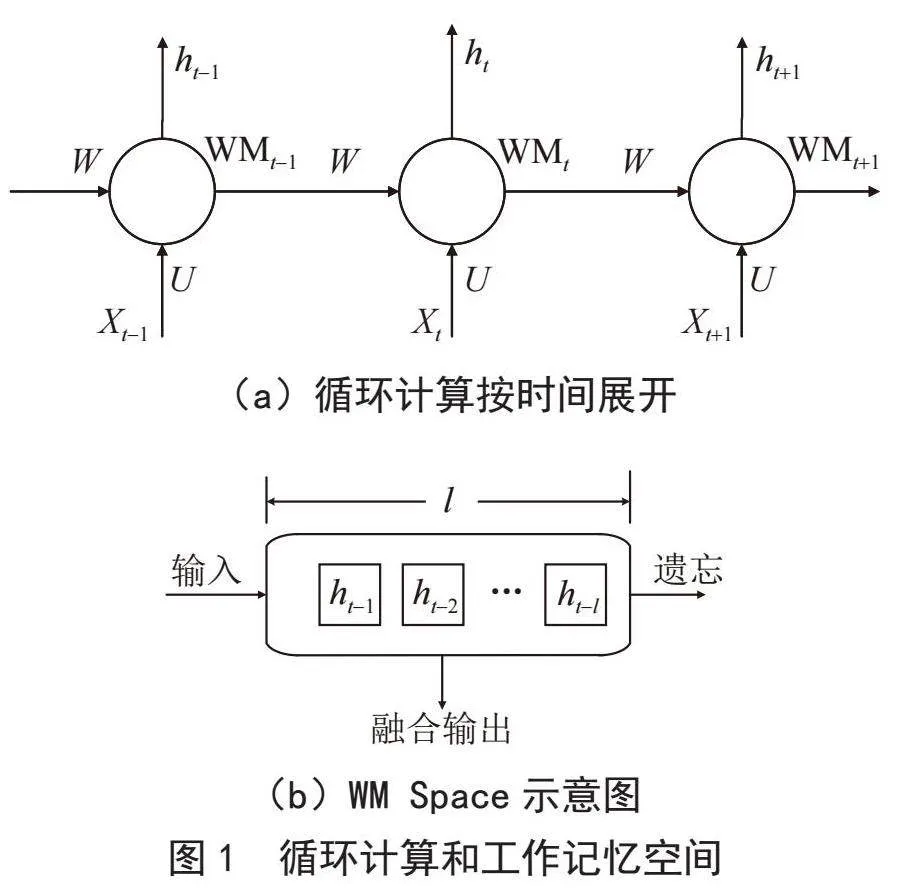

RNN的循环结构赋予其记忆和时间依赖性的特质。然而,RNN也受梯度消失和爆炸问题困扰,难以捕捉长期依赖性。在处理图像数据时,RNN也遇到困境,因为图像特征在空间上呈局部性。因此,本文的构想是将RNN的循环思想嵌入卷积神经网络中,运用循环计算创造感知信息ht,模拟视觉认知对物体的感知。另外,记忆是神经系统宝贵的能力,但不可能无限制长久保留。本文引入一个长度有限的工作记忆空间用来存储感知序(ht-1,ht-2,…,ht-l)列,以FIFO(先进先出)方式更新其中信息。通过重新利用感知信息ht,网络能够捕获长距离依赖,从而有效地提取信息。由此,本文提出深度反馈结构(Deep Feedback Structure, DFS)融合了反馈机制和工作记忆。该结构状态和输出变量定义如下:

其中l为反馈深度,L≥l是总的时间步长,称为模型深度。本文将工作记忆中的感知信息用求和的方式加以复用,并在下一次循环计算时参与信息的传递,用以提取特征中变化缓慢的量,同时也可以缓解梯度消失和梯度爆炸的问题。此外,为了突出每次的感知信息,对感知信息乘以加权系数ai,ai源于神经元的响应信息ht-i,因此将其定义如下:

ai = σ (ht-i)" " " " " " " " " " " " " " "(3)

其中σ使用Sigmoid激活函数,使得0<ai<1,以凸显感知信息ht-i中的感兴趣区域。

循环计算和工作记忆空间如图1所示。在循环计算时将WMt与Xt融合后经过卷积得到输出ht。ht按照FIFO的方式更新WM Space中的内容,WM Space中的信息融合产生WMt+1作为下一次循环计算的输入。

2.2" 网络结构

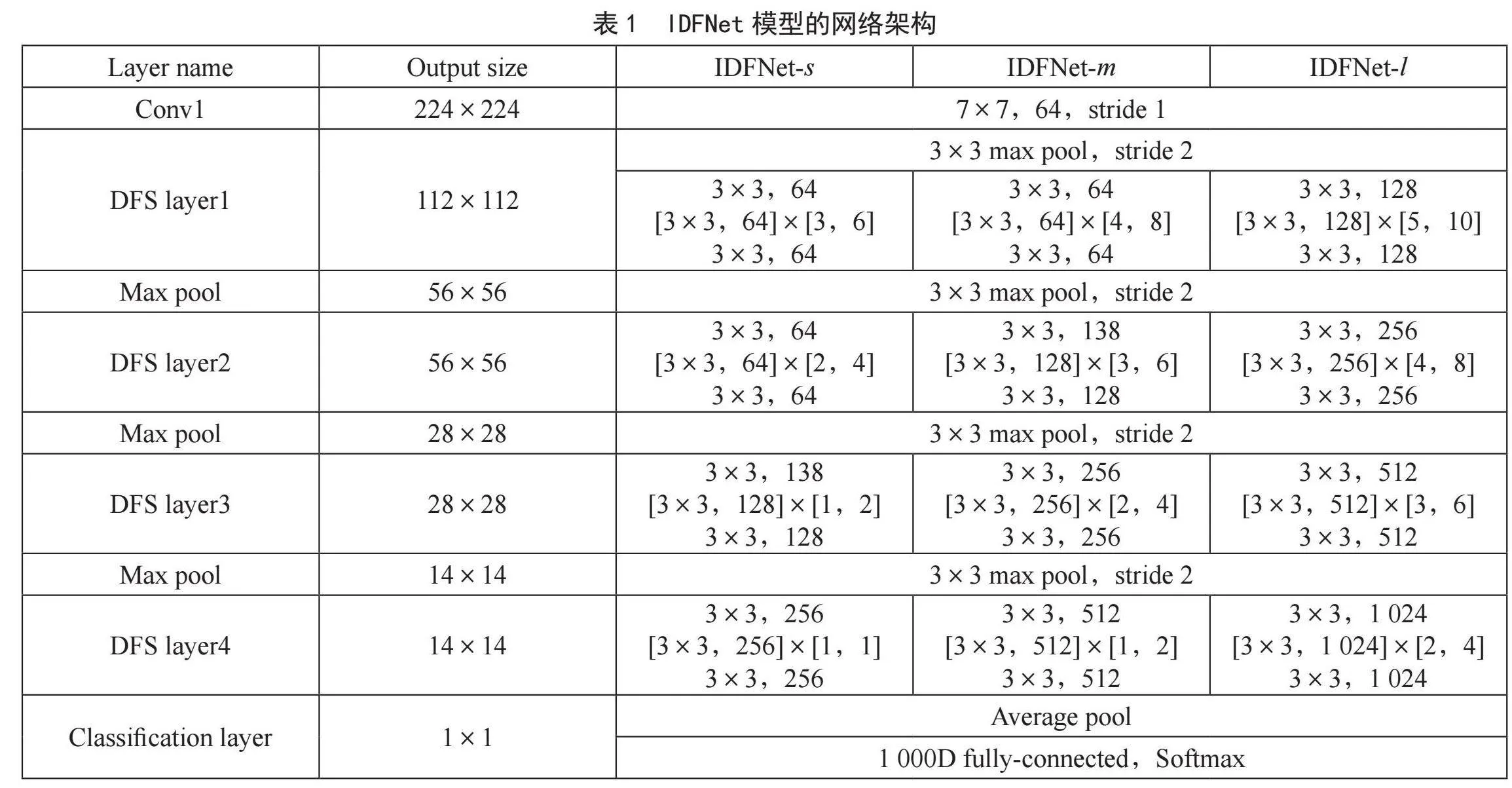

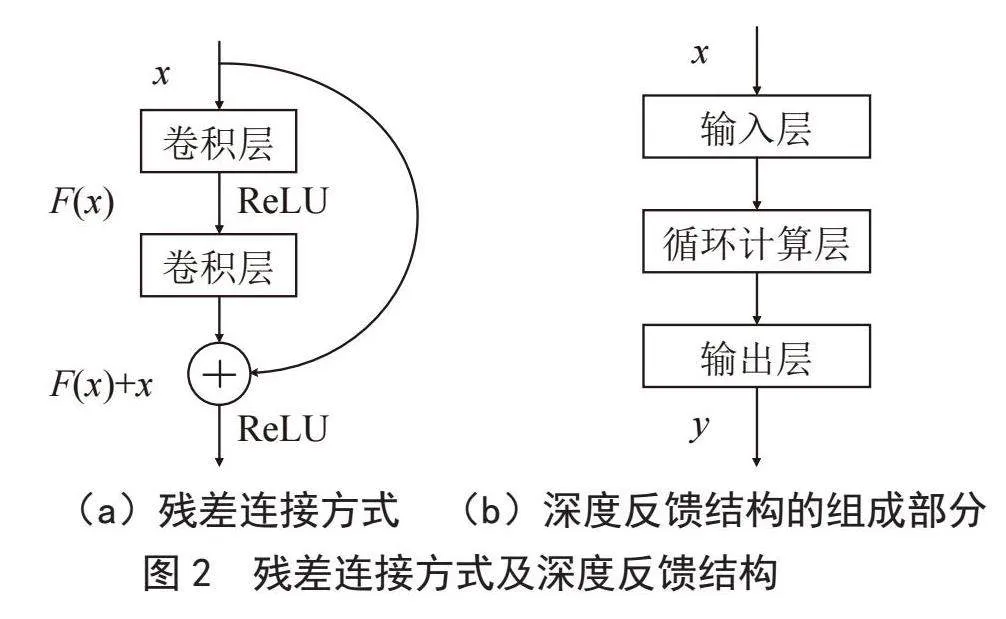

在IDFNet网络中,网络主要由连续的DFS模块构成。DFS模块在实现上由3个层构成:输入层、循环计算层和输出层。其中,输入和输出层分别由1个卷积模块(Conv-BN-ReLU)组成,而循环计算层则由一个残差块组成,如图2所示。循环计算主要通过反馈深度l和模型深度L两个重要参数来控制,将x经过输入层的输出记为h-1,对WM Space初始化为(h-1,h-1,…,h-1),长度为l。在模型深度L次内,每次循环计算会产生1个感知信息ht,用ht更新WM Space产生新的感知序列(ht,ht-1,…,ht-l)。当L = 1时,感知序列为(h0,h-1,…,h-1),L = l时,感知序列为(ht-1,ht-2,…,ht-l)。将新的感知序列信息融合作为下一次循环计算的输入,循环往复,直到完成L次计算,得到hL,将其经过输出层,得到深度反馈结构的输出y。

每2个DFS模块之间,使用最大池化对特征图进行下采样。在网络最后,使用全局平均池化层和Softmax组成分类层,用于最终的分类。

对于CIFAR-10和CIFAR-100数据集,考虑到图像输入只有32×32的大小,本文搭建由3个DFS模块组成的网络(IDFNet for CIFAR)用于该数据集分类。在进入第1个DFS模块之前,经过1个卷积核为3×3、通道数为32的卷积层,网络使用最大池化进行下采样。这3个DFS模块的输出通道分别是32,64,128;输出特征图的大小分别为32,16,8。

对于输入图像大小为224×224的数据集,本文使用4个DFS模块搭建网络。在进入第1个DFS模块之前,经过1个卷积核为7×7,步距为1的卷积层,使用最大池化进行下采样,在最后1个DFS模块之后,使用全局平均池化层和Softmax进行分类。本文基于不同的网络宽度搭建了3个网络结构:IDFNet-l、IDFNet-m和IDFNet-s,每个结构中最后DFS模块的输出通道数分别为1 024,512和256,详细的网络细节和参数如表1所示。表中[l,L]表示该DFS模块中反馈深度和模型深度的取值。

3" 实验结果与分析

本文建议的网络模型在不同的数据集上进行验证评估,并与其他同类型的网络进行比较。验证的实验条件为:Intel(R)Xeon(R)Gold 5118 CPU @

2.30 GHz,Tesla V100-SXM2 GPU服务器;软件为Python 3.8.0,PyTorch 1.10.1框架。

3.1" 数据集

CIFAR数据集涵盖了CIFAR-10和CIFAR-100两个子集[29],图像尺寸为32×32像素的彩色图像。CIFAR-10包含10个不同类别的图像,而CIFAR-100则拥有100个类别。训练集和测试集分别含有50 000张和10 000张图像。从训练集中提取5 000张作为验证集,以测试集的结果为最终报告。类似于其他文献对数据进行预处理[4-6,26,30],并运用各通道均值和标准差进行数据归一化处理。

Flower102数据集包含102类花卉图像[31],每类图像约有40至258张,共计8 189张。由于花卉之间的相似性,数据集在分类任务中存在一定难度。将数据集按8:1:1的比例划分为训练集、验证集和测试集。

对CIFAR数据集进行训练时,采用SGD优化器,将初始学习率设定为0.1,总共进行300次迭代。同时,在迭代次数达到50%和75%时,对学习率进行10倍的衰减。而在训练Flower102数据集时,采用Adam优化器,将初始学习率设置为0.000 1,总共进行500次迭代。同样,在迭代次数达到50%和75%时,对学习率进行10倍的衰减。此外,还对权重进行了初始化[31],设定权重衰减率为10-4。在全连接层之前,添加Dropout层,设置丢弃率为0.2,以增强模型的鲁棒性。

3.2" 实验结果

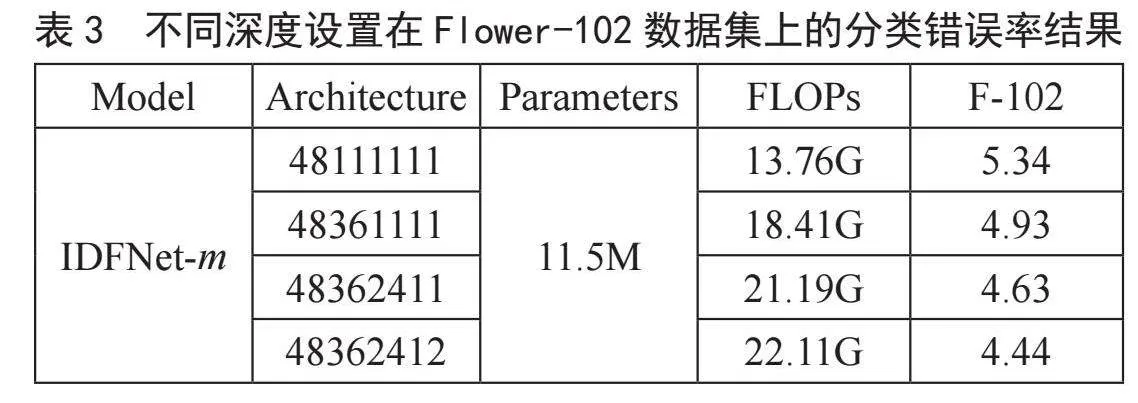

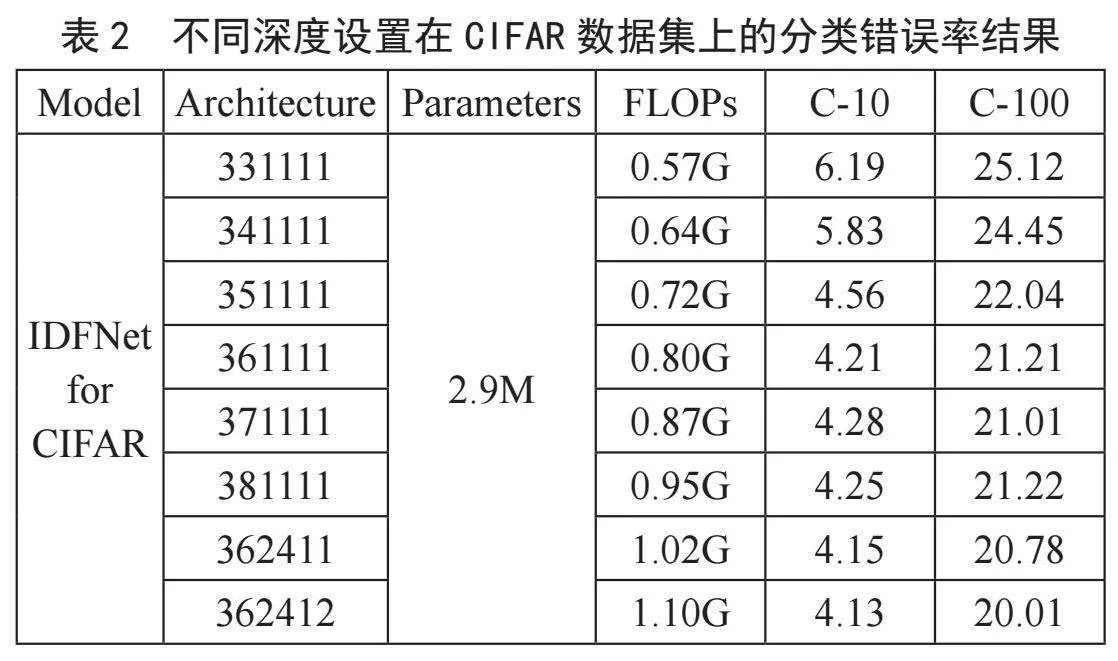

在神经网络中,浅层(shallow layers)主要关注图像的低级特征,深层(deep layers)主要聚焦于图像的抽象和语义特征。为了探究反馈深度l和模型深度L的关系,以及选取的范围,实验时分别对浅层和深层的DFS模块的反馈深度l和模型深度L进行调整,以分类错误率作为评价指标。为确保验证的准确性,实验时逐层调整反馈深度和模型深度。由于l和L具有多种组合方式,且每层的模型深度可以不同,导致组合数增加。基于神经网络特性和计算量的考虑,列出部分不同反馈深度和模型深度组合下的分类结果,如表2和表3所示。模型深度的选择遵循l≤L,并且深层模型深度Ld≤浅层模型深度Ls。在表2和表3的网络结构设置中,利用lL表示每个DFS的设置,所有DFS的设置构成了数字串。如表2中的结构数字串362412,开始的36表示第一个DFS模块反馈深度l和模型深度L;而最后的12表示最后DFS模块的反馈深度反馈深度l和模型深度L。

表2给出了不同反馈深度和模型深度的实验结果,其中前6行的实验结果主要是探索浅层(第1个DFS)反馈深度和模型深度的关系。从实验结果中可以看出,模型深度等于反馈深度的2倍时性能与计算量达到平衡,继续增加模型深度时,网络的计算量会增加,而性能则趋于饱和。表2中第4、7和8行探索逐层使用DFS结构对模型性能的影响,由实验数据可知每层使用DFS结构都对模型性能有所改善。

同样地,表3给出了IDFNet-m网络结构在Flower-102数据集上验证浅层与深层不同反馈深度和模型深度的实验结果。从实验数据可以发现与表2相同的结论。因此,随着网络层次的加深,DFS模型深度随之减少,可使网络模型性能最佳。

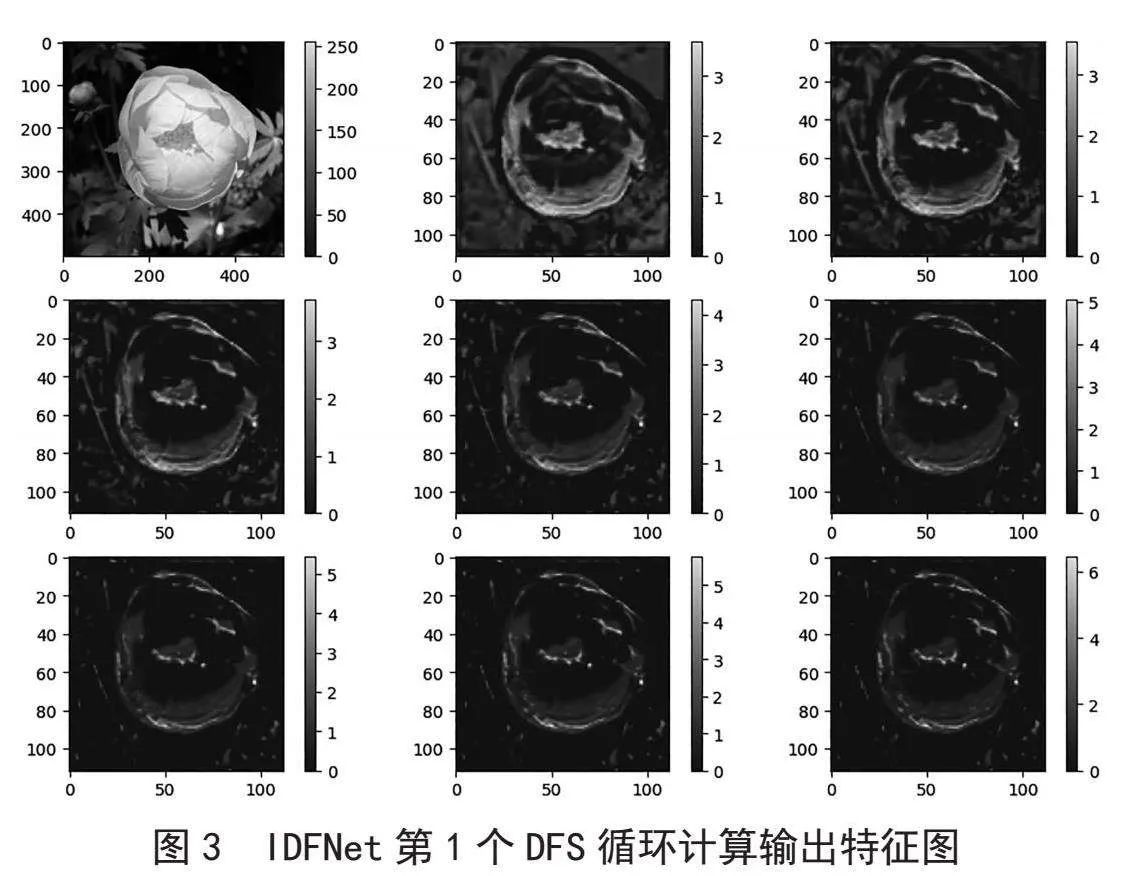

为了更好地理解上述结论,图3给出了DFS在循环计算所输出的特征图。DFS模块通过循环计算对特征进行重复,在网络浅层采用较深的反馈深度和模型深度,有助于突出图像的纹理和边缘等特征,如图3所示,这对后续分类任务很有帮助(第1张为原图,从左至右依次为模型深度L = 1,L = 2,…,L = 8时的结果的特征图,固定反馈深度l = 4。)。在网络的深层,主要包含高级语义特征,每个像素携带大量信息,较浅的反馈深度和模型深度可以对特征图略做调整,以增强模型性能。

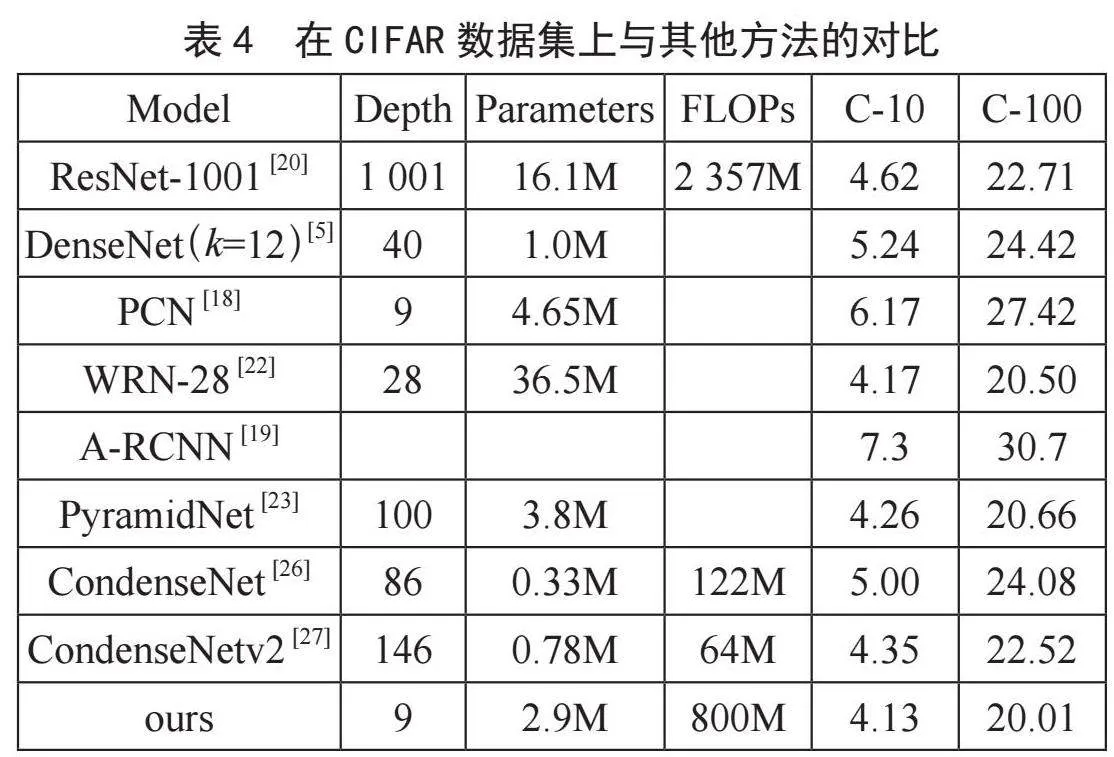

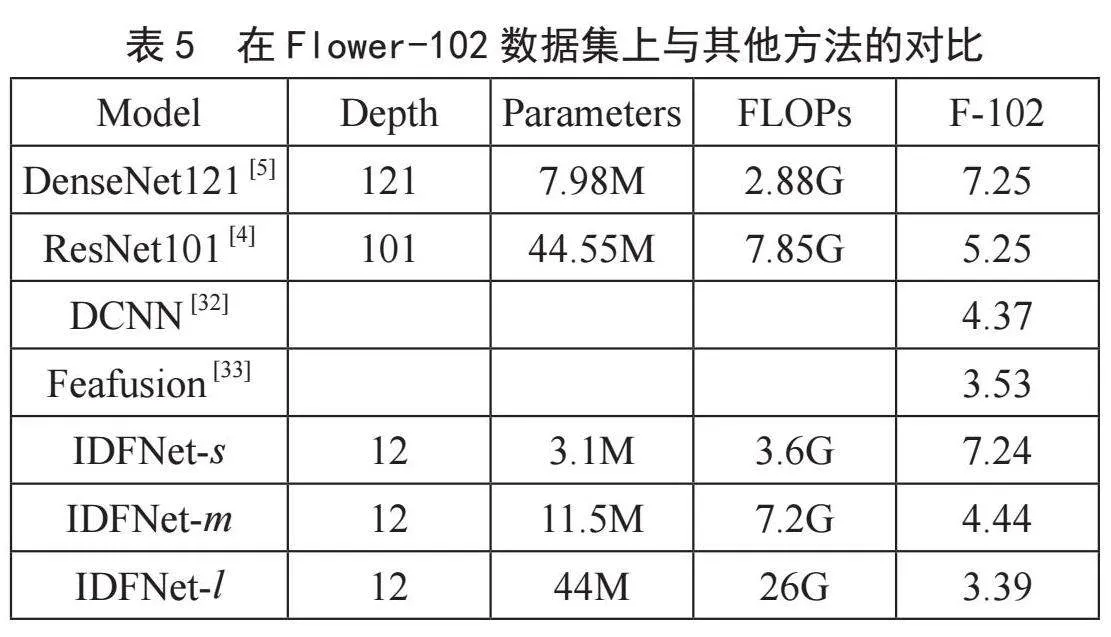

将本文的建议方法与其他方法在模型深度、参数量、计算量和分类准确率等方面进行了对比,结果如表4和表5所示。在表4中,尽管本文建议的模型深度与其他一些模型相比较浅,但在CIFAR-10和CIFAR-100数据集上的性能表现却非常接近甚至超过了其他更深的模型。这表明建议的模型能够更有效地利用网络深度,从而在参数数量和计算复杂性方面取得了更好的平衡。在表5中,从IDFNet-s、IDFNet-m到IDFNet-l模型,分类错误率逐步下降,但计算量和参数量也在逐步上升,IDFNet-m网络在参数量和计算量之间取得平衡,性能与最优结果相比略有下降,而IDFNet-l则取得最优性能。在这3种模型中选择最适合的模型,可以满足不同的使用场景和性能要求。

与其他方法的对比显示,本文提出的方法在减少了网络层数、参数量和计算复杂度的情况下仍能取得出色的性能。相对于其他网络结构,本文的方法更加简单,层数更少,这使得每层网络都能够更充分地发挥性能,而不会受到过多冗余分支和参数的干扰。

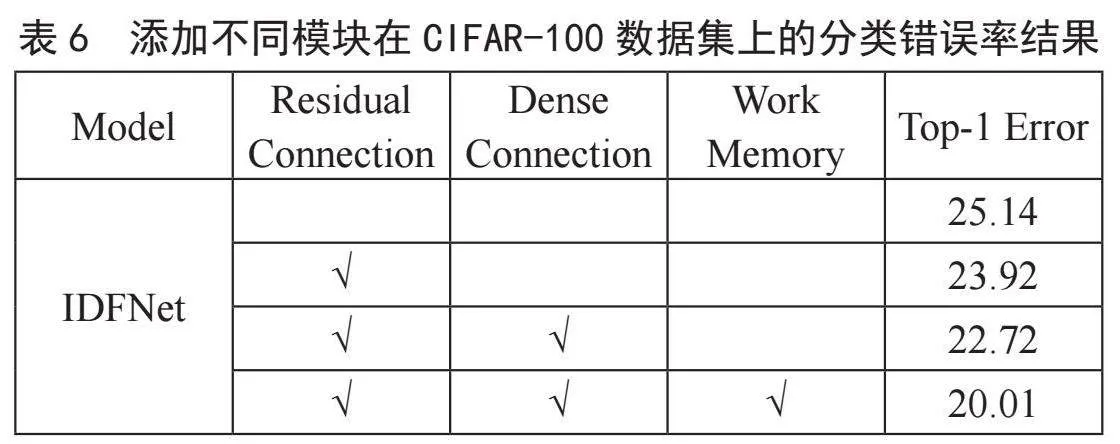

为了更全面地说明建议网络,本文在CIFAR-100数据集上进行消融实验,展示在DFS中每个附加模块对网络性能的增益,其结果如表6所示。以只有卷积模块,且保持反馈深度和模型深度固定,为基础的DFS结构,在此基础上分别添加残差块,密集连接和工作记忆3个模块。从表6中得知,依次在DFS结构中添加建议的模块,对性能都有逐步的提升,说明反馈机制和工作记忆在神经网络应用中的有效性。

4" 结" 论

本文探索了将反馈机制和工作记忆机制与卷积神经网络相融合的层内深度反馈神经网络模型,以提升图像分类任务的性能。通过在网络的浅层和深层应用不同的深度反馈策略,揭示了循环计算在浅层时的潜力,以及在深层时的应用。实验结果表明,在浅层中,循环计算有助于捕捉图像的低级特征,从而提升分类精度;而在深层中,适当的深度反馈策略能够更好地捕捉抽象和高级的语义特征。此外,实验结果验证了反馈深度和模型深度的关系对网络性能的影响,并以此为基础提出了一种适用于浅层和深层的模型选择策略。在后续工作中,我们希望模型能够在推理过程中自动选择合适的模型深度。这种自适应方法允许模型在处理简单图像时使用较浅的深度,在处理复杂图像时使用较深的深度。这种动态深度选择有助于在保持模型性能的同时减少计算负担并加快推理速度。

参考文献:

[1] KRIZHEVSKY A,SUTSKEVER L,HINTON G E. Imagenet classification with deep convolutional neural networks [J].Commun ACM,2017,60(6):84-90.

[2] SIMONYAN K,ZISSERMAN A. Very Deep Convolutional Networks for Large-Scale Image Recognition [J/OL].arXiv:1409.1556 [cs.CV].(2014-08-04).https://arxiv.org/abs/1409.1556.

[3] SZEGEDY C,LIU W ,JIA Y ,et al. Going Deeper with Convolutions [C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Boston:IEEE,2015:1-9.

[4] HE K ,ZHANG X ,REN S ,et al. Deep Residual Learning for Image Recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas:IEEE,2016:770-778.

[5] HUANG G ,LIU Z ,LAURENS V D M ,et al. Densely Connected Convolutional Networks [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:2261-2269.

[6] HU J ,SHEN L ,SUN G .Squeeze-and-Excitation Networks [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2019,42(8):2011-2023.

[7] ANGELUCCI A,BRESSLOFF P C. Contribution of Feedforward, Lateral and Feedback Connections to the Classical" Receptive Field and Extra-Classical Receptive Field Surround of Primate V1 Neurons [J].Progress in brain research,2006,154:93-120.

[8] ZAREMBA W,SUTSKEVER I,VINYALS O. Recurrent neural network regularization [J].arXiv:1409.2329 [cs.NE].(2014-08-08).https://arxiv.org/abs/1409.2329v1.

[9] COWAN N. What are the Differences Between Long-Term Memory, Short-Term Memory, and Working Memory? [J].Progress in Brain Research,2008,169:323-338.

[10] PRATTE M S,PARK Y E,RADEMAKER R L,et al. Accounting for Stimulus-Specific Variation in Precision Reveals a Discrete Capacity Limit in Visual Working Memory [J].Journal of experimental psychology. human perception and performance,2017,43(1):6-17.

[11] SRIVASTAVA N ,HINTON G ,KRIZHEVSKY A ,et al. Dropout: A Simple Way to Prevent Neural Networks from Overfitting [J].Journal of Machine Learning Research,2014,15(1):1929-1958.

[12] IOFFE S,SZEGEDY C. Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift [C]//International conference on machine learning.PMLR,2015:448-456.

[13] LIU T,LUO R,XU L,et al. Spatial channel attention for deep convolutional neural networks [J].Mathematics,2022,10(10):1750.

[14] HOCHREITER S,SCHMIDHUBER J. Long short-term memory [J].Neural computation,1997,9(8):1735-1780.

[15] CHO K,VAN MERRIENBOER B,GULCEHRE C,et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation [J/OL].arXiv:1406.1078 [cs.CL].(2014-06-03).https://arxiv.org/abs/1406.1078.

[16] HOCHSTEIN S,AHISSAR M. View from the Top: Hierarchies and Reverse Hierarchies in the Visual System [J].Neuron,2002,36(5):791-804.

[17] CAO C,LIU X,YANG Y,et al. Look and Think Twice:Capturing Top-Down Visual Attention with Feedback Convolutional Neural Networks [C]//2015 IEEE International Conference on Computer Vision (ICCV).Santiago:IEEE,2015:2956-2964.

[18] WEN H,HAN K,SHI J,et al. Deep Predictive Coding Network for Object Recognition [C]//International conference on machine learning.PMLR,2018:5266-5275.

[19] YU N,QIU T. An Improved Method and Application of Recurrent Convolutional Neural Network With Self-attention Mechanism [C]//2022 China Automation Congress (CAC).Xiamen. IEEE,2022:6312-6316.

[20] HE K,ZHANG X,REN S,et al. Identity Mappings in Deep Residual Networks [C]//In ECCV2016.Amsterdam,Springer,2016:630-645.

[21] ZHANG C,BENGIO S,SINGER Y. Are all layers Created Equa? [J].The Journal of Machine Learning Research,2022,23(1):2930-2957.

[22] ZAGORUYKO S,KOMODAKIS N. Wide residual networks [J].arXiv:1605.07146 [cs.CV].(2016-05-23).https://arxiv.org/abs/1605.07146v1.

[23] HAN D,KIM J,KIM J. Deep Pyramidal Residual Networks [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:6307-6315.

[24] GAO S H,CHENG M M,ZHAO K,et al. Res2Net: A New Multi-Scale Backbone Architecture [J].IEEE transactions on pattern analysis and machine intelligence,2019,43(2):652-662.

[25] HUANG G,CHEN D,LI T,et al. Multi-Scale Dense Convolutional Networks for Efficient Prediction [J].arXiv:1703.09844 [cs.LG].(2017-05-29).https://arxiv.org/abs/1703.09844v2.

[26] HUANG G,LIU S,VAN DER MAATEN L,et al. Condensenet:An Efficient Densenet Using Learned Group Convolutions [C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City:IEEE,2018:2752-2761.

[27] YANG L,JIANG H,CAI R,et al. CondenseNet V2: Sparse Feature Reactivation for Deep Networks [C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Nashville:IEEE,2021:3569-3578.

[28] HUANG G,SUN Y,LIU Z,et al. Deep Networks with Stochastic Depth [C]//Computer Vision – ECCV 2016.Springer International Publishing,2016:641-661.

[29] KRIZHEVSKY A,HINTON G. Learning Multiple Layers of Features from Tiny Images [D].Toronto:University of Toronto,2009.

[30] HE K,ZHANG X,REN S,et al. Delving Deep into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification [C]//2015 IEEE International Conference on Computer Vision (ICCV).Santiago:IEEE,2015:1026-1034.

[31] NILSBACK M E,ZISSERMAN A. Automated Flower Classification over a Large Number of Classes [C]//2008 Sixth Indian conference on computer vision, graphics amp; image processing. Bhubaneswar:IEEE,2008:722-729.

[32] CIBUK M,BUDAK U,GUO Y,et al. Efficient Deep Features Selections and Classification for Flower Species Recognition [J].Measurement,2019,137:7-13.

[33] SADATI F,REZAIE B. An Improved Image Classification Based In Feature Extraction From Convolutional Neural Network: Application To Flower Classification [C]//2021 12th International Conference on Information and Knowledge Technology (IKT).Babol:IEEE,2021:35-40.

作者简介:童顺延(1998—),男,汉族,四川屏山人,硕士在读,研究方向:视觉认知计算与医学图像处理;通讯作者:刘海华(1966—),男,汉族,湖北孝感人,教授,博士,研究方向:视觉认知计算与医学图像处理。