基于机器视觉的穿戴式导盲设备的开发与设计

摘要:据2019年世卫组织发布数据,全世界约有22亿视障人群,近七成盲人有出行需求,但社会上无障碍措施并不完善,现有导盲产品无法真正满足盲人的需求。现有导盲辅具存在较多问题:导盲杖检测距离短、不识别障碍物;导盲腰带、眼镜等探测范围窄、导盲距离远,无法应对嘈杂环境。针对此类问题,研发一款基于机器视觉的穿戴式导盲设备,选用语音模块搭配骨传导耳机,配合百度地图API进行开发,将路径规划进行语音播送;基于行人、车辆等,展开基于YO⁃LOv5的目标检测,进行重复训练,用于检测路况;针对路标、斑马线等传统路标,通过对目标颜色进行阈值二值化处理,通过串口通信将色块的实际位置、大小等信息传回,用于实时定位。该项目在通信技术、障碍物识别、穿戴方式等方面进行突破,解决盲人在嘈杂的环境中无法准确导盲的问题,随身携带,从而保障他们的出行安全。

关键词:导盲;机器视觉;YOLOv5

中图分类号:TN29 文献标识码:A

文章编号:1009-3044(2024)27-0012-03

0 引言

许多研究者一直致力于改善盲人的导盲辅具[1]。早期设备多依赖单一传感器,如超声波或红外线,主要通过声音或震动提示导航。这些设备虽小巧且检测范围广,但功能单一,缺乏路线规划能力,智能化有限。

近年来,出现了导盲眼镜、导盲腰带等可穿戴电子导盲产品[2]。例如,Google Glass外观时尚、轻便,可像普通眼镜一样佩戴,具备通话等功能。仿生眼镜通过摄像头捕捉图像,处理后显示在眼镜内侧,但要求用户有感光能力,不适合全盲者。随着移动设备普及和GPS、图像识别等技术的发展,可穿戴设备的智能化设计迎来了新机遇。

然而,现有导盲设备仍存在诸多挑战,如无法识别所有障碍物、续航短、易丢失以及无法创造“熟悉”的场景和环境等。因此,本项目设计了一款基于机器视觉的穿戴式导盲设备,旨在解决这些问题,满足盲人的行为习惯、使用便利性和安全性等需求。该设备穿在身上,为盲人提供更加智能和贴心的导航体验。

1 系统设计方案

1.1 系统设计综述

STM32F407微控制器作为主控芯片,将主控板、深度学习摄像头、蓄电池、供电电路、超声波模块、红外模块和语音识别模块分别做轻量化处理后,整合至穿戴外衣中,构成整个系统。

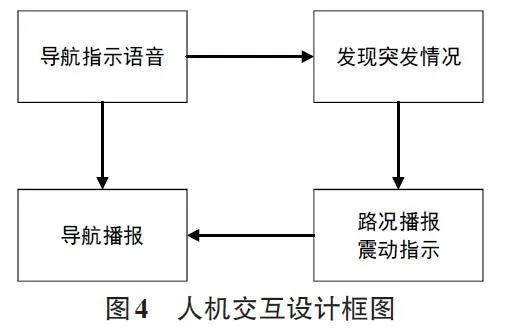

设计采用语音交互模式,微控制器搭载GPS 模块[3]、视频采集模块、图像处理模块等,使用百度地图API进行路径规划,通过深度学习卷积神经网络算法YOLO进行行人、车辆、障碍物等目标识别,结合传统图像处理算法实现盲道、路标、斑马线等目标位置、大小等信息反馈,可以实现盲人的实时定位和准确导航。系统设计框图如图1所示。

1.2 系统设计方案

系统主要通过微型摄像头进行环境信息的采集,利用K210处理器对采集的信息进行识别操作,将识别后的障碍物等信息发送至STM32主控微处理器当中。主控处理器同时需要接收激光测距、GPS等传感器的数据信息,后将整合的数据打包,使用网络通信发送至云端上位机。用户可以通过设备的震动和语音交互模块获取环境信息,以便做出下一步动作。与此同时,预先设置的紧急联系人可以通过上位机实时查看使用者的位置信息和状态信息。

当使用者在使用过程中,发生意外情况,可以通过胸前的SOS报警装置联系紧急联系人,或者进行报警操作。该系统也支持使用者预先设定导航路径,以及根据使用者的习惯记忆常用路线信息。

2 系统硬件设计

2.1 视觉识别设计

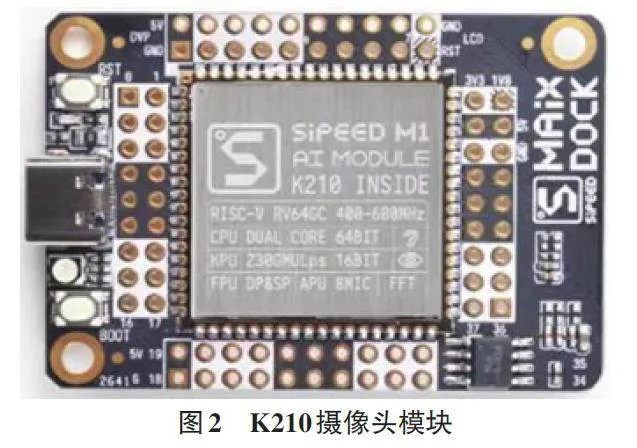

使用K210芯片作为图像处理单元,其上搭载的RISC-V 64位双核处理器,专为机器视觉而设计,通过运算神经网络模型,对微摄像头采集到的环境信息进行识别处理,将处理结果反馈至主控处理器中。K210 摄像头模块,如图2所示。

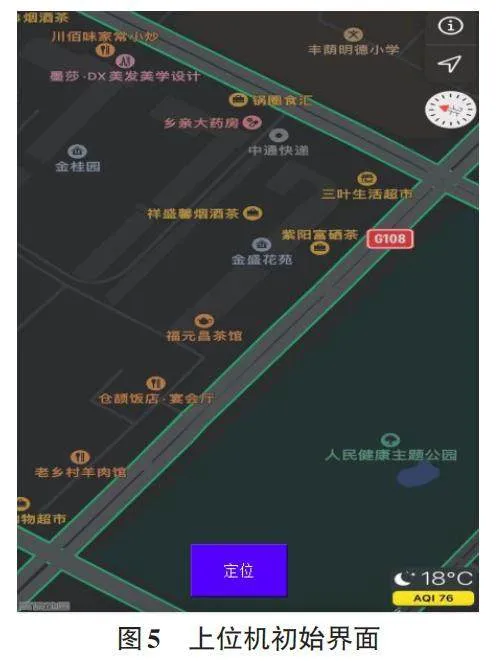

首先利用双肩矫正和标定技术,精确获取摄像头参数矩阵,实现立体匹配,获得高精度立体视差图。然后采用先进的YOLO算法进行物体检测与识别,该算法精确度高且速度快捷,比R-CNN快1000倍。识别障碍物演示(柱子),如图3所示。神经网络模型的主要特征如下。

特征自动提取:卷积神经网络可以通过学习来自动提取图像中的特征,减少了手工特征工程的负担。

鲁棒性:由于卷积神经网络可以自动学习图像特征,使得网络对图像的变形、光照等影响具有一定的鲁棒性。

可扩展性:卷积神经网络的结构可以通过增加卷积层、池化层等可复制的层次来扩展网络结构,从而适应更大规模的数据集。

端到端学习:卷积神经网络可以直接将图像的原始像素作为输入来进行学习,从而实现端到端的自动学习。

层次结构:卷积神经网络是一种多层结构,每一层都通过前一层的输出作为输入。这种结构让它能够探测到不同层次的特征。

局部连接和共享权值:卷积神经网络中的卷积操作是在局部区域内执行的,而不是在整个输入数据上进行操作。这样可以减少计算量,并且更好地捕捉到局部特征。同时,每一个卷积核都可以在输入数据的不同位置上进行卷积操作,从而提高特征提取的效率。

多层卷积:卷积神经网络中包含多个卷积层,每一层提取的特征都比前一层更加抽象。

池化层:卷积神经网络中的池化层用于缩小特征图的大小,减少计算量,并且提高模型的鲁棒性。

Dropout:卷积神经网络中的Dropout层可以减少过拟合现象,并且提高模型的泛化能力。

2.2 主控微处理器

STM32系列微处理器是意法半导体开发的嵌入式处理器,专为要求高性能、低成本、低功耗的嵌入式的应用而设计。

系统中采用了STM32F407微控制器,它具有多达1MB的FLASH、64KB的SRAM、168MHz的主频、12位ADC以及高速USART,完全能够满足本项目的所有开发需要。利用IIC、USART等通信接口实现与各个模块之间的数据交换任务,同时能够快速地完成多种数据信息的整合运算工作,实现路径的规划导航和记忆。

2.3 传感器

2.3.1 定位模块

系统中所使用的GPS 定位功能通过ATKMO1218模块实现。该模块的应用主要通过SkyTraqbinary 协议进行相关参数的配置,然后利用NMEA-0183协议[4]获取实时定位信息。主控微处理器对获取到的原始定位数据进行处理操作后,通过通信模块发送至上位机,并实时记录位置信息。

2.3.2 通信模块

系统使用了4G通信模块ATK-MW510模块来实现通讯功能。ATK-MW510模块作为一款高性能的LTE Cat.4模块,具备丰富的硬件资源。它集成了LTECat.4模组,支持高速数据传输,满足用户对于网络速度的需求。同时,模块还配备了Nano-SIM卡座,方便用户进行SIM卡安装和更换。此外,该模块还具备ADC检测接口、3.5mm音频输入输出接口、SMA主天线接口等多种接口,方便用户进行各种外接设备的连接和通信。复位按键和开机按键的设置,使得用户可以方便地控制模块的启动和复位。

根据以上所描述的信息,ATK-MW510模块是一款功能全面、性能卓越的网络通信模块,因此能够很好地完成系统分配的通讯任务。

2.3.3 激光测距模块

除了通过视觉识别进行环境判断之外,系统还采用了激光测距模块组对行走过程中的障碍物进行辅助避障。ATK-MS53L1M激光测距模块拥有小巧的外形,能够轻易地安装在穿戴设备周围,该测距模块能够实现范围为40mm至4 000mm内的障碍物检测任务,完全符合视障人士行走过程中的检测需要。

2.3.4 交互模块

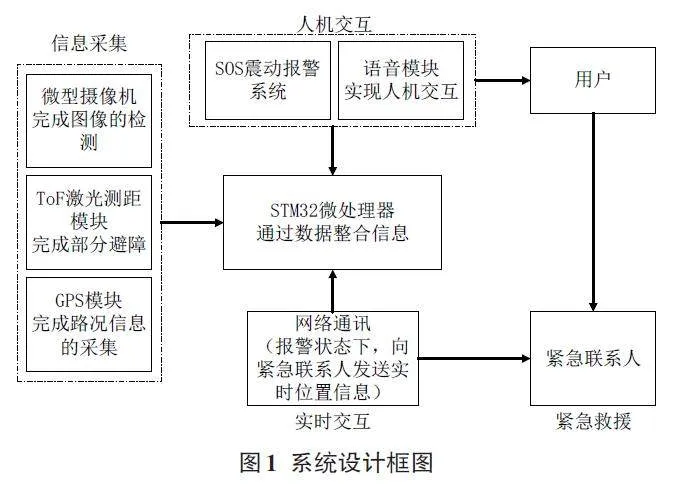

考虑到视障人群的使用方式,设备主要通过震动和语音的方式进行交互操作[5]。在设备中安装了八处振动源,分别位于穿戴者的前方、左前方、左方、左后方、后方、右后方、右方以及右前方八个方位,能够根据每个方位检测到的障碍物信息进行震动提示。同时语音模块也将进行路况的大致内容播报,便于使用者进行下一步规划。人机交互设计框图,如图4所示。

3 系统软件设计

3.1 YOLO(You Only Look Once) 算法

系统在通过K210 模块进行物体识别时使用的YOLO算法是一种在AI领域目标检测方向非常流行的算法[6-7]。它以其速度、精度和效果上的优势而著称。YOLO算法的核心思想是将目标检测任务转换为一个单次前向传播的回归问题,从而实现了快速的目标检测和定位。与传统的目标检测方法相比,YOLO 算法不需要进行复杂的区域提议和分类器训练,而是直接在整个图像上进行预测,从而大大提高了处理速度。在物体识别方面,YOLO算法能够检测出各种大小、形状和旋转角度的目标,并且在复杂背景下也具有较好的检测效果。它采用全局损失函数,能够在不同尺度的特征图上进行检测,从而提高了检测的精度。

当使用过程中,K210模块对道路上的障碍物体进行识别时,YOLO算法可以与该模块的机器视觉能力相结合。K210模块具备的卷积人工神经网络硬件加速器KPU,可高性能进行卷积人工神经网络运算,支持基于卷积神经网络的目标检测和图像分类任务。通过结合YOLO算法和K210模块的机器视觉能力,可以实现快速、准确的障碍物检测识别,完成道路环境的采集和处理任务。

此外,该算法还采用交叉损失函数,能够同时预测目标的类别和位置,进一步提升了检测的精度。

3.2 系统上位机设计

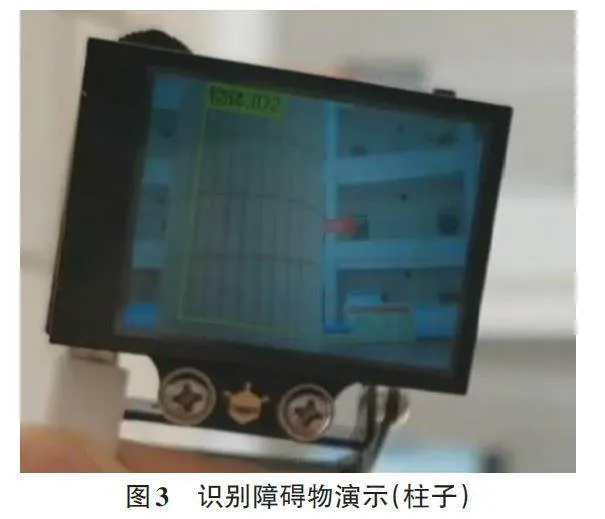

系统使用了4G通信模块进行网络通信,将实时定位数据信息上传至云端。设计了一个带有地图定位功能的上位机软件,选定百度地图的SDK并集成到开发环境当中[8]。随后,通过网络获取用户使用设备过程中提供的定位数据,利用SDK将位置信息实时展示在地图上。

此外,为了提升用户体验,还增加了地图的缩放、定位以及标记点添加等交互功能。最后,通过实际的测试与调试,完善了软件的稳定性和可用性,并将提供相应的文档和用户指南,以便用户轻松上手。上位机初始界面,如图5所示。

4 系统的性能测试与分析

本设计的系统为穿戴式的导盲设备,旨在为视障人士提供一种更加便捷高效的行走辅助方式。在使用过程中,主要以设备的单独运行为主,上位机在此过程中仅作为信息接收端,主要负责接收设备运行过程中的定位与报警信息,从而方便设备使用者的监护人或紧急联系人能够随时随地观察该使用者的动态,以保证使用者的安全。

团队按照上文设计要求与设计方案,并结合了对于视障人群的调研报告,完善了整套穿戴式导盲系统以及上位机的设计。根据数名视障人士提供的信息,团队在不同地点、不同环境下分别对设备进行了多方位多角度的实际测试实验。最终测试获得的数据如表1所示。

整体系统最终测试数据均处于预测范围内,符合初期的精准度要求,在大部分情况下均能够完成基础的行走辅助任务。上位机在使用过程当中也能够很好地获取实时定位信息,并且能够及时准确地得到使用者发出的报警信息。

5 结束语

基于机器视觉的穿戴式导盲设备旨在实现盲人的便捷出行,通过高度智能化的设计,为视觉障碍人士的安全出行提供额外的保障和便利。该设备采用先进的神经卷积网络算法,能够通过双肩矫正和标定技术获取摄像头参数矩阵,实现立体匹配,获得高精度立体视差图。同时,采用YOLO算法,可以精确识别与定位目标物体,确保盲人在行走过程中能够避开障碍物。

该设备仍然需要大量的数据进行模型训练,并且需要高性能的计算资源。总体来说,基于机器视觉的穿戴式导盲设备为视觉障碍人士的安全出行提供了强有力的支持和保障。

参考文献:

[1] 余娜娜.面向视障人群的导盲辅具设计研究[D].广州:广东工业大学,2022.

[2] 徐浩.室外导盲机器人研究与设计[D].沈阳:东北大学,2020.

[3] 金文祥,王绍伟,时继潮,等.一种低成本的GPS定位信息采集显示系统[J].单片机与嵌入式系统应用,2018,18(8):46-48.

[4] 周兰兰,曾水平.基于NMEA-0183协议的导盲仪定位信息采集与解析系统[J].工业控制计算机,2021,34(2):41-42,55.

[5] 徐进波,陈晨.基于语音交互的盲人出行辅具设计[J].艺术与设计(理论),2018(5):100-102.

[6] 张炳力,王焱辉,潘泽昊,等.基于障碍物和车位检测的单阶段多任务YOLO-Parking 算法研究[J]. 合肥工业大学学报(自然科学版),2024,47(1):1-6,61.

[7] 张四平.基于YOLO目标检测算法的人群多目标识别跟踪方法[J].智能计算机与应用,2024,14(1):152-155.

[8] 涂晋升,李鹏,王延霞,等.基于百度地图开放平台的导航电子地图课程实践教学研究[J].导航定位学报,2022,10(2):191-194.

【通联编辑:朱宝贵】

基金项目:省级大学生创新创业训练计划项目-基于机器视觉的穿戴式导盲设备的开发与设计(项目编号:S202110723035)