人工智能背景下科技期刊论文出版中的伦理风险与应对策略*

摘 要:人工智能(Artificial Intelligence,AI)技术在科技期刊论文,特别是医学论文编辑出版领域的应用优势突出,但同时也带来了多重伦理挑战。在当前AI技术快速迭代的发展趋势下,医学论文编辑出版面临伦理问题风险,包括数据质量和透明度不足、公平性和偏见问题、利益冲突及论文撰写问题等,可加强法律责任、风险管理、监管审查,以及提高科研人员和编辑出版人员在AI使用中的边界意识,强化职业操守,确保AI服务于学术交流的同时,满足学术出版伦理道德的要求。

关键词:人工智能;科技期刊;医学研究;学术出版;伦理风险;应对策略

DOI: 10.3969/j.issn.2097-1869.2024.04.011 文献标识码:A

著录格式:许媛媛,张群,崔云裳.人工智能背景下科技期刊论文出版中的伦理风险与应对策略:以医学论文为例[J].数字出版研究,2024,3(4):94-100.

1 研究缘起

人工智能(Artificial Intelligence,AI)是基于涉及多层人工神经网络(即深度学习)的先进机器学习技术,为未来科学研究和学术出版带来了广阔的前景和机遇。AI为科技期刊学术论文出版的发展和创新提供了多种便利,在学术论文的审稿、润色和翻译,以及增强出版、语义出版等方面具备广阔的应用场景。其强大的数据分析能力和模拟自然语言的优势,在医学研究领域的辅助效果更加突出。在《“健康中国2030”规划纲要》的统筹推进下,医疗行业由传统医疗转变为数字医疗、信息医疗,再由数字医疗转变为智慧医疗。《中国人工智能医疗白皮书》明确了AI在医疗领域的应用,利用AI技术助力医疗发展成为社会的研究热点[1]。随着计算机技术的快速迭代,AI利用大数据可能会较大程度地改善医学科研的众多方面[2]。在当前的学术生态中,学者以论文的形式展示新的知识生产结果并向学术期刊投稿,以学术期刊编辑、审稿人为代表的学术共同体成员就这一知识生产成果进行创新性和可靠性质量评价,通过评价的论文被学术期刊发表,由此形成了知识生产的一般uMfL4yq7xaOHsKMEc60CuQ==性全流程[3]。然而,由于医学学科具有研究内容专业性强、研究对象涉及个人和群体生命健康、研究数据更关乎隐私与安全等特点,随着新技术的发展,在医学研究论文出版的全流程中,AI的应用也带来了多重伦理挑战。美国生命伦理学家汤姆·比彻姆(Tom L. Beauchamp)和詹姆士·丘卓斯(James F. Childress)在《生物医学伦理学原则》(Principles of Biomedical Ethics)一书中首先提出了4项主要原则:尊重自主原则、不伤害原则、有利原则和公正原则,这4项原则已成为世界公认的生物伦理决策原则[4]。然而在AI介入医学科研编辑出版的实践中,目前还没有统一的质量标准、准入制度、评价制度和保障制度。许多国际出版机构,如国际出版伦理道德委员会(Committee on Publication Ethics,COPE)和国际医学期刊编辑委员会(International Committee of Medical Journal Editors,ICMJE)及一些医疗领域的权威机构,都在试图制定关于使用AI的伦理准则[5-6],旨在解决从科研到出版过程中各个利益相关方应如何在确保诚信和透明原则下运用这项技术的问题。我国也对AI在学术研究和编辑出版领域的使用场景进行了规范。2023年9月,中国科学技术信息研究所与出版商爱思唯尔(Elsevier)、施普林格·自然(Springer Nature)、约翰威立(Wiley)联合编ZdiAWEBqK3GGIstQNsMFeA==写了《学术出版中AIGC使用边界指南》[7];2024年1月,中华医学会发布了《中华医学会杂志社关于论文写作和评审过程中使用生成式人工智能技术的有关规定》[8]。既往研究多以AI对科技期刊编辑出版的影响及对策为切入点,但对各个环节的讨论相对割裂和分散[9-10],对于从医学研究到论文出版的全流程中,AI所带来的伦理风险研究涉及较少。本文就AI在医学研究全流程中可能出现的重大伦理风险问题进行了梳理,并提出应对措施,旨在为AI更好地服务学术交流提供借鉴。

2 AI介入的医学研究特征带来的伦理挑战

医学研究成果广泛体现在生命本质、人与人之间关系、人与自然之间关系等方面,可能会引发价值事实冲突与价值观念冲突,不仅可能影响人与社会的关系,还可能影响未来的人类健康和生存,甚至是整个生态环境的平衡[11]。

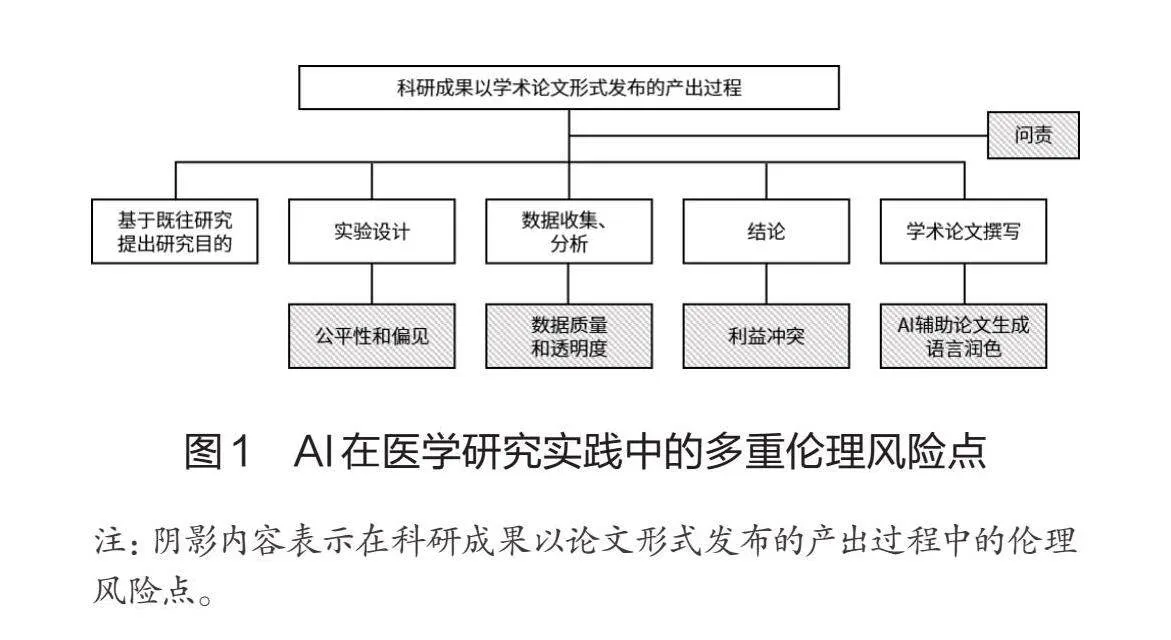

AI介入的医学研究,除对医学出版物、标准库和开放共享医学知识数据库中已经公开的数据或文献进行分析的综述、评价、解读外,一些原始数据的采集基本来自真实世界,研究对象往往涉及个人和群体生命健康,研究数据关乎隐私与安全。数据的收集、储存和使用需要充分的信息防护措施,特别是对于个人敏感信息、身份识别信息、与数据分析结果相关的个人信息来源等数据的处理与保密方法尤为关键。目前大多AI介入的医学研究依据国际医学科学组织理事会(Council for International Organizations of Medical Sciences, CIOMS)和世界卫生组织(World Health Organization,WHO)联合制定的《涉及人的健康相关研究国际伦理准则》,2016年经国家卫生计生委委主任会议讨论通过的《涉及人的生物医学研究伦理审查办法》及健康大数据相关规范进行管理,但在实践过程中,在科研项目的实验设计、资料采集、结论推导、论文撰写和问责机制等环节容易出现伦理风险(见图1)。

2.1 AI在医学论文实验设计中的公平性和偏见

AI的开发与使用全过程均涉及人为的选择与决策,其算法规则逻辑和所产生的社会影响并非完全客观、公正,在辅助临床决策或辅助医学科研时,会产生与人类相似的偏见行为,即算法偏见。表现为AI可能会因劣势群体的种族、性别、宗教和经济等因素而生成差异结果,并对该群体产生不良影响[12]。AI是一个典型的不透明“黑盒子”,这使得在许多情况下,一些复杂和无意偏见难以被检测或预测[13]。

2.1.1 风险点

如果数据对特定(如不同种族、性别和经济状况)患者群体的代表性不足,那么由此产生的AI算法就可能会对这些群体产生偏见,从而在科研试验的设计和科研成果的出版过程中产生伦理风险。比如主要涉及西方人的训练数据对亚洲人的诊断可能不够准确;同样地,基于大量中国样本的大数据智能中医AI开具的中医方剂可能并不完全适用于西方人。此外,AI一定程度的偏见,可能致使其性能在不同机构之间产生不同的表现,报告不同的结果。在医学科研的实践中,诊断队列的代表性更好,因为其具有更自然的疾病流行率、人口统计学特征和疾病表现谱;而病例对照设计由于研究人群相互独立,容易因不同的年龄、民族和地域特征而产生系统性偏见,进而因研究对象的不同而产生夸大的研究结论[14]。

2.1.2 应对策略

由于医药卫生领域的研究不仅只有相关科研工作者关注,公众也对这一领域的话题颇感兴趣,因此发布涉及AI报告的研究成果时可以将公众视为潜在读者,保证研究结果可进行明确的解释而不带任何偏见,防止误导公众或非专业媒体。医学编辑应对此保持高度的认知力和敏感性,如要求作者提供相应临床试验报告注册表,并附带关键的研究计划;建议作者使用多个机构的测试数据集,并报告所有机构的结果,以准确评估AI算法的互操作性和研究结果的可推广性;同时强烈建议作者公开或共享相应的原始数据资料等。AI介入的医学研究须具有普遍性和可转移性,适用于不同种族、地域、性别和护理水平的患者。如果为单中心的研究成果,应在论文中声明其数据可能带来偏倚等局限性。

2.2 AI在医学论文数据收集与分析中的数据质量和透明度问题

对于AI相关科研成果的学术评价首先基于其数据质量和透明度。经历了早期基于规则的算法到机器学习再到深度学习,现代AI算法利用大数据和多层人工神经网络实现了更高的准确性。

2.2.1 风险点

当前的AI算法在很大程度上依赖其训练数据和测试数据,数据的质量直接决定医学研究的质量。医学研究的相关数据多元且异构,包括文献数据、临床试验数据、真实世界数据和健康数据等,这些来自各级别医院和医学科研机构的数据虽然庞大,但大多数为非结构化和非标准化数据,由于在患者构成、医生偏好、设备设施及卫生政策等方面存在差异,医学研究数据在不同机构和实践环境中通常是异质的[15]。此外,缺失数据的现象也比较常见。再者,不同级别医院所使用的AI工具或设备,以及不同医生的设置和操作,也会导致结果出现偏差,影响数据质量。

2.2.2 应对策略

在科学研究中澄清训练数据和基于这些训练数据的AI算法中的偏差和错误至关重要。对于AI生成数据的质量和算法的透明度,医学科技期刊编辑在遇到AI相关研究时应要求作者说明测试数据是本机构内的还是来自不同机构,是前瞻性还是回顾性收集,另需要提供基线人口统计学特征、临床特征(如目标病症严重程度的分布、其他诊断和合并症的分布情况)、技术特征(如图像采集技术)等;区分数据集是由部分阳性病例和部分阴性病例组成的方便样本还是临床队列;如果使用了多个机构的数据集,应全面公布每个机构的结果和数据使用的细节(如使用日期和实施的医疗机构)。科技期刊编辑除要求作者完整、公开地公布算法透明度外,还应该建议作者对AI算法中可能存在的错误进行释义,并提出改进措施,进而帮助读者了解数据中的偏差和错误[16]。

2.3 AI在医学论文结论推导中的相关利益冲突

在医学研究领域,科研人员发表论文的部分结论可能成为商业资助方的营销工具,影响其IHWHbUzp7kC0QJyrnOpF966zB8QES2yLB5RWgLh/WpI=研究结果的公正性和科学性,带来利益冲突。此外,AI工具本身多由商业公司开发,在使用中可能也会存在利益偏倚问题。

2.3.1 风险点

AI技术目前已应用于各医疗领域,如医学图像分析、疾病筛查和预测、临床决策支持、手术机器人、健康管理、虚拟医疗助理和辅助筛选药物靶点等[2]。如果在此过程中使用的AI算法工具是由某个公司或组织开发的,那么该组织可能会在设计该算法工具时为符合自身商业利益而产生偏斜,从而导致学术论文的结论受到影响。从2020至2026年,医疗健康领域AI市场商业价值或将增长10倍,达到452亿美元[17],这吸引了原本与健康行业无关的科技巨头,如谷歌(Google)、国际商业机器公司(IBM)和微软(Microsoft)加入并开始主导市场。如何保证这些企业在AI工具的开发和使用过程中保持中立?如何避免这些企业利用信息和技术优势对AI工具进行操控?这些均是AI相关的医学科研成果在出版时需要关注的利益冲突问题。

2.3.2 应对措施

AI时代,对于利益冲突的破局,有关部门需要引入更多负责任的利益相关者,比如医疗AI工具的开发者、算法的设计者、数据训练服务提供者、AI工具监管者等;同时在政策方面鼓励更多主体参与监管,如医疗机构、保险公司、社会保障机构等,弥补监管的缺失。对于AI介入的医学研究中可能存在的利益冲突,学术期刊在出版论文时,一是要坚持披露原则,包括公开研究资助的来源、AI开发设计公司等;二是要坚持回避原则,对于论文评议等学术质量评价环节,要避免利益相关方的参与。

2.4 AI在医学论文撰写过程中的辅助性内容生成

2022年12月,以ChatGPT为代表的基于自然语言大模型的生成式AI(Generative AI,GAI)横空出世。这种工具以人工神经网络为基础,基于数据库和其他来源的大量数据,根据每条信息的重要性进行加权,并以此对输入的问题作出类似于人的回答。出版界对于GAI是否可以作为主体、拥有著作权和负法律责任展开热烈讨论,提出GAI不可作为论文出版的主体,不能作为独立的作者,但是可以对科学研究有辅助作用[18]。前文提到的《学术出版中AIGC使用边界指南》及《中华医学会杂志社关于论文写作和评审过程中使用生成式人工智能技术的有关规定》,均对AI在学术研究和编辑出版领域的使用场景进行了规范指引。

2.4.1 风险点

GAI可以根据作者的提问及提示生成论文内容,还能帮助编辑根据审稿人背景及其既往审稿质量和速度等,为指定论文筛选匹配的审稿人,甚至可以对审稿人的建议进行综合分析,辅助论文学术质量综合评价。但是在GAI辅助论文出版过程中,这种优势也伴随着信息错误、学术不端、数据安全等伦理风险,如:(1)可能会欺骗性地将AI生成的文本当作AI使用者自己的学术产出;(2)生成结果不可靠,含有歧视和偏见;(3)生成内容虚构,产生错误和误导性的信息,影响科研生态环境;(4)利用软件学术造假,篡改数据和图表等重要结果,通过暗中修改数据,恶意操纵AI生成内容;(5)有复制和放大偏差的风险;(6)在使用AI工具进行数据收集和辅助论文写作时,如果把尚未发表的学术内容上传,可能存在被系统学习后并展示给其他用户的风险;(7)AI工具的迭代升级增加了学术不端检测难度,学术不端检测工具与AI科研辅助工具之间形成一种博弈关系[19]。

2.4.2 应对策略

首先,学术期刊编辑要积极鼓励和引导作者对AI工具的使用情况进行客观、公开的披露,披露声明应包括且不限于以下内容:使用者;AI技术或系统(版本号)及使用的时间和日期 ,格式如Reference Open AI (2023). ChatGPT (Mar 14 version) [Large language model]. https://chat.openai.com/chat;用于生成文本的提示和问题;论文中有AI工具编写或共同编写的部分;论文中因使用AI工具而产生的想法;对于AI工具撰写的稿件的任何部分,须在方法或致谢部分公开、透明、详细地进行描述。其次,对于学术造假,尤其是图像和数据的造假,科技期刊编辑要不断提升判断能力和鉴别力。再次,科技期刊要积极响应国务院办公厅印发的《科学数据管理办法》[20],增强向“科学数据银行”等公益性数据中心上传数据的意识,为作者公开原始数据(包括原始数据,处理后的数据、软件、算法、协议、方法、材料等)创造技术条件。最后,随着AI技术快速迭代带来的日新月异的学术环境变化,学术编辑要通过不断学习,拥抱新技术,尽快重构认知,在学术论文的创新性和可靠性评价方面,以及在解决学术分歧中充分发挥把关者的作用。

2.5 AI在全球化学术交流中的语言辅助作用

国际主流刊物和高影响力刊物,以及Web of Science和PubMed等数据库均为英文语境,非英语国家的科研工作者往往用母语实施研究,但用另一种语言(大部分为英语)撰写论文和阅读文献,这是一种叠加在科研本身之上的巨大挑战,这种不公平的科研语境可能会造成科研交流上的不公平。AI大语言模型能够根据翻译文本的类型需求进行高效和精准的翻译,有助于破除文化和语言上的不公平现象,让科研活动聚焦于学术研究的意义与价值本身[21]。

2.5.1 风险点

医学界普遍接受的观点是,在写作过程中,AI辅助工具仍无法完全取代人。首先,在内容前沿性方面,由于AI对自然语言的模拟在很大程度上依托其不断升级的语料库,因而其获取的专业性语言具有一定滞后性,而学术论文却往往需要最新的数据和资料;其次,对于要求知识结构化程度高、训练集质量高、专业性程度高的医学专业领域,AI工具输出的信息可能存在大量冗余[22],还可能会自动生成错误的信息或错误的图像,造成虚假信息和虚假内容的传播[23]。在语言翻译的过程中,则可能会因文化差异带来语义和语境理解上的偏差,出现导向性错误。此外,医学专业性较强,专业词汇繁多,AI工具往往只提供常用词汇,缺乏技术或学科专用术语,在正确选词及准确语境的恰当使用方面仍有一些缺陷。

2.5.2 应对策略

首先,对于AI语言润色服务,医学学术编辑要注意审核医学论文可能涉及的种族、性别、临床试验注册和动物实验福利等内容,医学学术编辑尤其要提高政治敏锐性,对跨语言出版中的中西方文化和相关规定的差异保持高度关注。另外,在简明英语之外,医学论文还涉及大量的专业词汇,且词义和词根变化复杂,医学学术编辑在日常工作实践中应保持AI学习的持续性,通过在AI语料库中不断纳入学科领域内专业词汇来训练AI,以此帮助清除学术编辑与国外学者就专业问题讨论困难的障碍。

2.6 对AI在医学研究中应用的问责机制

医学研究的问责制度指编辑出版全流程中相关部门应各自承担相应责任,相关责任主体包括研究人员、资金提供者、政策制定者、出版单位、出版商、数据库平台等。在使用AI工具的情况下,责任方又叠加了AI工具的设计开发者和用户。AI工具在本质上不具备自由意志,也不具备道德的客观性[24],因此无法作为负责任的主体,不能将道德特征归因于AI工具,且无人对使用AI工具导致的不良事件负责[16,25]。

2.6.1 风险点

AI技术在医学科研中的应用及相关的政策和监管体系尚未完全建立,相关决策是由软件设计开发者、硬件或算法及使用者共同构成的复杂系统,很难明确责任主体,即很难确定是哪个组件或哪个参与者导致了特定的问题或错误。这可能导致责任归属模糊,存在争议,如责任应归属做出最终决定的医生、决定使用AI工具的医疗机构、AI工具的制造者、科技论文最后发布的出版单位、同行评议专家还是算法本身?这值得深入探讨。

2.6.2 应对措施

科技无法取代人类的天赋和创造力。在医学科研编辑出版的整个流程中,虽然有AI的辅助,但是从责任归属角度,首先要认定AI作为工具的属性,再厘清责任的承担者。对于问责制度,一是在政策方面要尽快完善。2023年4月11日,国家互联网信息办公室就《生成式人工智能服务管理办法(征求意见稿)》向社会公开征求意见,次日,美国也就AI系统的潜在问责措施征求公众意见。有关AI对数据安全和个人信息保护方面的问题正在引起全球监管部门的关注,其中涉及医学研究与编辑出版的各行业、组织或协会也应尽快对AI应用中不断出现的新情况、新问题制订指南和标准;二是在用户使用方面要对其进行伦理道德教育和培训;三是在监管层面要充分发挥各专业和各级伦理委员会的积极性,对有可能出现的AI伦理问题,不仅做到事前监管,也要做到事后监督调查,明确具体的责任方,督促整改。

3 结语

AI背景下医学研究论文出版流程中的伦理风险点,包括公平性和偏见、数据质量和透明度偏差、相关利益冲突、论文生成和语言辅助问题及责任归属困难等。对此,本文一一提出应对举措,并提出编辑出版人员在处理AI介入的医学学术论文的研究到出版全过程中要有明确的边界意识,遵守规范,提高道德价值观、遵守伦理道德规范来指导实践。同时对AI保持适当的开放态度,接受并适应新事物,保持学术质量评价和学术话题组织方面的核心竞争力,充分发挥学术期刊编辑人员“智”和智能机器“算”的优势,在符合伦理道德要求的前提下,促进知识传播和学术交流。

作者简介

许媛媛,女,硕士,中国疾病预防控制中心副编审。研究方向:公共卫生和学术编辑出版。

张群,男,博士,中国疾病预防控制中心研究员。研究方向:医学信息学。

崔云裳,本文通信作者,女,硕士,中国疾病预防控制中心副编审。研究方向:公共卫生和学术编辑出版。E-mail:bes_editor1@vip.163.com。

参考文献

周罗晶,邵旸,张瑞,等.智慧医疗场景下人工智能应用伦理问题与治理路径探讨[J].中国医院,2024,28(2):38-41.

TOPOL E J.High-performance medicine: The convergence of human and artificial intelligence[J]. Nature Medicine,2019,25(1):44-56.

纪小乐,魏建.生成式AI与学术期刊出版:冲击及应对[J].沈阳师范大学学报(社会科学版),2024,48(4):82-90.

BEAUCHAMP T, CHILDRESS J. Principles of biomedical ethics[M]. New York: Oxford University Press, 2013:20-80.

European Commission’s High-Level Expert Group on Artificial Intelligence. Ethics guidelines for trustworthy AI[EB/OL].(2019-05-09)[2023-12-01].https://www.europarl.europa.eu/cmsdata/196377/AI%20HLEG_Ethics%20Guidelines%20for%20Trustworthy%20AI.pdf.

IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems. Ethically aligned design[EB/OL].(2019-05-09)[2023-12-01]. https://ethicsinaction.ieee.org.

中国科学技术信息研究所.学术出版中AIGC使用边界指南[EB/OL].(2024-02-24)[2024-06-17]. https://www.fxbaogao.com/detail/4150135.

中华医学杂志社.中华医学会杂志社关于在论文写作和评审过程中使用生成式人工智能技术的有关规定[EB/OL].(2024-01-09)[2024-06-17].https://mp.weixin.qq.com/s/_IRUqAtyEM_2n53GrRlQgA.

李春丽,俞琦.ChatGPT人工智能对科技期刊编辑出版的影响及对策[J].学报编辑论丛,2023(3):56-61.

任宇,罗剑萍,甘甜.ChatGPT对学术出版实践的影响及其应对[J].武汉理工大学学报(社会科学版),2023,36(4):113-119.

谢小萍,何晓波.新科技时代医学研究的伦理挑战及治理对策[J].杭州科技,2022,53(1):36-40.

陈龙,曾凯,李莎,等.人工智能算法偏见与健康不公平的成因与对策分析[J].中国全科医学,2023,26(19):2423-2427.

CHAR D S, SHAH N H, MAGNUS D. Implementing machine learning in health care: Addressing ethical challenges[J]. The New England Journal of Medicine,2018,378(11):981-983.

KLUGE E-H W. Artificial intelligence in healthcare: Ethical considerations[J]. Healthcare Management Forum,2020,33(1):47-49.

马婷,陈清财.基于开放医疗大数据的人工智能研究[J].医学与哲学,2022,43(1):1-4.

PARK S H, KRESSEL H Y. Connecting technological innovation in artificial intelligence to real-world medical practice through rigorous clinical validation: What peer-reviewed medical journals could do[J].Journal of Korean Medical Science,2018,33(22):e152.

HAWKINS V A, LONGSTAFF H. Ethical considerations in biobanks: How a public health ethics perspective sheds new light on old controversies[J]. Journal of Genetic Counseling, 2015,24(3):428-432.

COPE.Position Statement(2023)[EB/OL].(2023-05-01)[2024-01-15]. https://publicationethics.org/cope-positionstatements/ai-author.

张济明,吴领叶,丁译.机遇与挑战并存:ChatGPT对期刊出版的影响的几点思考[J].传播与版权,2023(24):12-15.

国务院办公厅. 国务院办公厅关于印发科学数据管理办法的通知[EB/OL].(2018-03-17)[2024-06-17]. https://www.gov.cn/gongbao/content/2018/content_5283177.htm.

HAMAMAH H, IVE E, YULIA H, et al. Using nominal group technique to explore publication challenges and the usefulness of AI-based writing technologies: Insights from Indonesian scholars[J]. Theory and Practical in Language Studies, 2023,13(8): 2038-2047.

郑满宁.人工智能技术下的新闻业:嬗变、转向与应对:基于ChatGPT带来的新思考[J]. 中国编辑,2023(4):35-40.

陈昌凤,张梦.由数据决定?AIGC的价值观和伦理问题[J].新闻与写作,2023(4):15-23.

GAN S P. How can robots have rights[J]. Ethics Research,2017(3):126-130.

杨亚红,孙岩,余党会.学术出版行业生成式人工智能作品相关责任与风险分析研究综述[J].中国科技期刊研究,2023,34(12):1601-1607.

Ethical Risks and Countermeasures in Sci-Tech Journal Paper Publishing in the Context of Artificial Intelligence—An Example of Medical Research Papers

XU Yuanyuan, ZHANG Qun, CUI Yunshang

Chinese Center for Disease Control and Prevention, 102206, Beijing, China

Abstract: Application of artificial intelligence (AI) technology in medical research paper editing and publishing has outstanding advantages, but it also brings multiple ethical challenges. Under the current AI trend, medical research paper editing and publishing face ethical issues, including insufficient data quality and transparency, fairness and bias issues, conflict of interest, and paper writing issues, etc. In this regard, legal responsibility, risk management and regulatory review can be strengthened, as well as raising the awareness of boundaries and professional ethics among researchers and editorial staff in the use of AI. These countermeasures help to ensure that AI services academic communication while meeting ethical and moral requirements.

Keywords: Artificial intelligence; Sci-tech journals; Medical research; Academic publishing; Ethical risks; Countermeasures