改进YOLOv8的遥感图像检测算法

摘 要:针对目前遥感图像目标检测算法中存在的误检、漏检和检测精度低等问题,提出了一种改进YOLOv8 的遥感图像检测算法。在主干网络中引入注意力机制EMA 到C2f 模块,以提高模型对多尺度目标的特征提取能力;在颈部网络中提出Slim-PAN 结构,以减少模型计算量;使用WIOU 损失函数代替CIOU 损失函数,以提升模型的检测精度。通过在DIOR 和RSOD 遥感数据集上的实验结果表明,改进后的算法与原YOLOv8 算法相比,mAP 分别提升了1. 5% 和2. 3% ,计算量降低了0. 3 GFLOPs,改进算法在不增加计算量的同时能提高检测精度,证明了改进算法的有效性和先进性。

关键词:遥感图像;目标检测;YOLOv8;注意力机制

中图分类号:TP391. 9 文献标志码:A 开放科学(资源服务)标识码(OSID):

文章编号:1003-3106(2024)05-1155-07

0 引言

遥感图像是指通过卫星、飞机或其他传感器从遥远地面获取的图像数据。伴随着科技的不断进步和应用需求的不断增加,遥感图像在精准农业、地质灾害检测、城市规划和军事国防等多个领域都起到了重要作用[1]。对于遥感图像而言,这些图像中的目标通常分布密集、尺度差异显著,而且还会受光照、天气和其他建筑的影响,检测背景十分复杂,从而给检测过程带来一定的影响[2]。因此,降低误检率和漏检率是此领域亟需解决的问题[3]。

目前,基于深度学习的目标检测算法根据有无候选区域分为2 类:一类是以R-CNN 系列(R-CNN[4]、Faster R-CNN[5]和Cascade R-CNN[6])为代表的双阶段目标检测算法;另一类是以YOLO[7]系列(YOLOv3[8]、YOLOv5 和YOLOv6[9])、SSD[10]、Cascade retinanet[11]和CenterNet[12]等为代表的单阶段目标检测算法。单阶段目标检测算法得到了更广泛的应用是由于它具有更快的识别速度。国内外已有很多学者使用单阶段目标检测算法在遥感图像检测领域取得了显著的成绩,Hou 等[13]将MS Trans-former 模块与CBAM 注意力机制引入YOLOv5 中,形成新的R-YOLO 网络,提高了对遥感目标的检测精度。张上等[14]设计了一种能重构特征提取与特征融合的LUSS-YOLO 网络结构,使其能够提高检测精度。Wan 等[15]将多层特征金字塔、多检测头策略和混合注意力模块放入到YOLOv5 中,形成新的YOLOHR 网络,提高了对光学遥感目标的检测精度。

虽然上述研究已经找到了有效的方法来提高遥感图像检测的准确性,但由于遥感图像中目标尺度变化范围大且分布密集,容易出现漏检、误检等情况,并且对于目标的特征提取能力不足,导致检测精度不高[16]。针对上述问题,本文以YOLOv8n 作为基线网络,进行了一系列改进和优化。首先,在主干特征提取网络中将注意力机制EMA[17]引入到C2f模块中,构成C2f_EMA 模块,以提升网络对遥感目标的注意力;其次,在特征融合网络中提出了SlimPAN 结构,在保证准确性的前提下,降低了计算量;使用WIOU[18]损失函数替换原网络中的CIOU[19]损失函数,以提高检测框的定位能力;最后,在DIOR[20]和RSOD[21]公开数据集上进行实验,结果表明改进后的算法对分布密集且尺寸差异明显的遥感目标具有良好的检测效果。

1 YOLOv8 算法

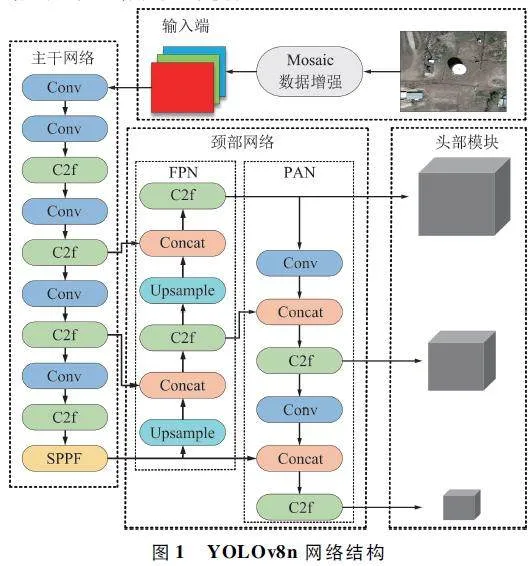

YOLOv8 模型是由Ultralytics 团队在2023 年1 月提出,本文选择以YOLOv8n 网络模型为基本框架,其模型结构如图1 所示,主要包括输入端、主干网络、颈部网络和头部模块。

输入端:通过Mosaic 数据增强对图片进行随机选择、拼接和旋转等操作,使模型能够更好地适应真实世界的复杂场景,具有更好的鲁棒性和泛化能力,进而提高模型在复杂背景下对目标的检测能力。

主干网络:主要由Conv 模块、C2f 模块、SPPF模块组成。通过Conv 模块可以改变图像的分辨率和通道数,实现更好的特征提取;C2f 模块的核心思想是通过结合全局语义信息和局部目标信息来更好地理解图像,并使目标检测器更关注有意义的区域;SPPF 模块能在同尺度上对特征进行池化,以允许网络在不同大小的输入图像上执行目标检测,从而提高模型的感受野和鲁棒性。

颈部网络:用于将来自不同层次或不同尺度的特征图进行融合,以提高模型在多尺度场景下的性能,这种融合机制可以提高模型的感受野,使得模型更适应于处理多尺度的输入图像,从而增强了模型的鲁棒性和泛化能力。

头部模块:采用解耦头结构,将分类和检测头分离,同时将锚框换成了无锚框,减少了设计复杂性,提高了位置精度和模型的泛化能力,使其变得更加灵活。

2 改进YOLOv8n 算法

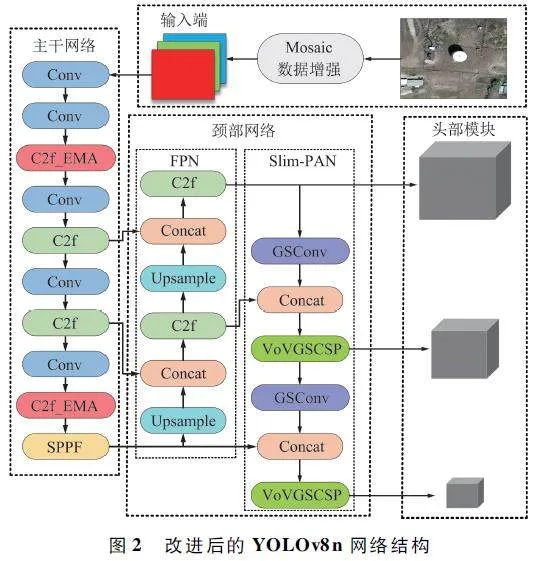

本文以YOLOv8n 为基线模型,使用C2f_EMA模块替换原始主干网络中的部分C2f 模块,提出Slim-PAN 结构替换原始颈部网络中的PAN 结构,最后采用WIOU 作为边界框损失函数。改进后的网络结构如图2 所示。

2. 1 EMA 模块

EMA 模块是一种新的跨空间学习的高效多尺度注意力模块,它能够在保留每个通道上信息的同时将注意力放在感兴趣的位置,其结构如图3 所示。

具体流程如下:首先,对于任何给定的输入特征映射X,将跨通道维度方向X 划分为G 个子特征,接下来利用2 条1×1 分支和一条3 ×3 分支来提取分组特征图的注意力权重描述符。在1×1 分支中,通过2 个一维全局平均池化操作对通道进行编码,再连接2 个编码特征之后采用1×1 卷积生成2 个并行的一维特征编码向量并分别送入Sigmoid 函数中。然后通过简单的乘法将每个组内的通道注意力图合并,以实现不同通道之间的交互特征。在3×3 分支中,采用3×3 的卷积操作旨在捕获局部不同通道的互动特征,从而扩大特征空间。其次,引入了2 个张量。在1×1 分支中,用二维全局平均池化进行全局空间信息编码,注意在通道特征联合激活机制前,将最小支路的输出直接转化为对应的维度形状。随后用自然非线性函数Softmax 来拟合以上的线性变换。通过将并行处理后的输出与矩阵点积相乘,来获得一个空间注意力图。在3×3 分支中,原理与1×1 分支相同。最后,将每组内的输出特征映射相加,从而生成2 个空间注意力权重值的集合,随后使用Sigmoid 函数和简单的乘法操作,使得EMA 的最终输出与X 的大小相同。

通过将EMA 模块引入到C2f 中,使模型更加关注于目标区域位置信息,以提高对目标区域的检测精度,其结构如图4 所示。Sigmoid 函数和简单的乘法操作,使得EMA 的最终输出与X 的大小相同。

通过将EMA 模块引入到C2f 中,使模型更加关注于目标区域位置信息,以提高对目标区域的检测精度,其结构如图4 所示。

2. 2 SlimPAN 结构

遥感图像通常从无人机、飞机等轻量化设备中获取,参数量和计算量较大的网络模型在这些边缘设备中难以应用,因此本文提出了一种由GSConv[22]和VoVGSCSP[22]构成的轻量化SlimPAN结构。

为了使深度可分离卷积的结果尽可能地近似标准卷积,标准卷积和深度可分离卷积可以联合使用,将普通卷积、深度可分离卷积混合起来,得到GSConv,其结构如图5 所示。

具体操作如下:首先,将输入的图片进行标准卷积操作,得到通道数为c2 / 2 的特征图A,接着对特征图A 进行深度可分离卷积操作,得到通道数为c2 / 2 的特征图B。然后将特征图A、B 进行连接,形成特征图C。最后,将特征图C 进行混洗操作,得到最后的输出特征图。从图5 可以看出,GSConv 的计算成本约为Conv 的一半,但对模型的贡献与标准卷积相当。基于GSConv 设计了GSbottleneck 模块,并在此基础上使用单阶段聚合方法设计了跨阶段局部网络模块VoVGSCSP,在降低了计算量和复杂度的同时保持了足够的精度。其中,GS bottleneck 的结构如图6 所示,VoVGSCSP 的结构如图7 所示。

2. 3 损失函数

在原YOLOv8n 网络中,计算预测框的坐标损失所采用的是CIOU 损失函数,其计算公式如下:

式中:wgt、hgt 表示真实框的宽和高,w、h 表示预测框的宽和高,ρ2(b,bgt )表示预测框与真实框中心点之间的欧式距离,IoU 表示真实框与预测框交并比,C表示预测框与真值框的最小外接矩阵的对角线长度,α 表示权重,v 表示衡量长宽比一致性的参数。

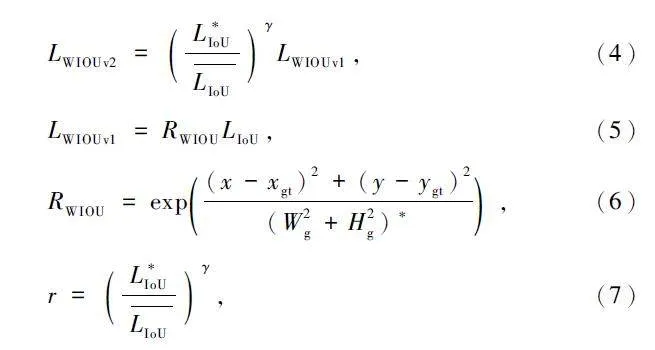

虽然CIOU 在DIOU 的惩罚项基础上添加了一个影响因子αν,但是,当影响因子中的v = 0 时,此时长宽比的惩罚项为0,于是提出单调静态聚焦机制,引入WIOU 损失函数。其计算公式如下:

式中:Wg、Hg 表示最小包围框的宽和高,r 表示梯度增益。

3 实验

3. 1 实验环境及参数设置

实验环境为64 位Windows 11 操作系统下搭建的Pytorch 2. 0. 1 深度学习框架,Python3. 8 以及CU-DA 11. 7 编程软件。计算机CPU 为AMD Ryzen 97945HX,GPU 为NVIDIA GeForce RTX 4060,显存为8 GB,内存为16 GB,训练选用的batch-size 为8,epochs 为200。

3. 2 数据集

为验证算法的可行性,本文在DIOR 遥感数据集和RSOD 遥感数据集进行实验。其中,DIOR 数据集是一个用于光学遥感图像目标检测的大规模基准数据集。该数据集包含23 463 张图像和192 472 个实例,涵盖20 个对象类。RSOD 数据集是一个开放的、用于遥感图像目标检测的公开数据集,该数据集包含946 张图像和6 950 个实例,包括4 个对象类。这4 个对象类是飞机、操场、立交桥和油箱,其中由于操场图像中包含40 张无标注图像,本文只使用149 张标注过的操场图像。在实验中,按照7 ∶ 2 ∶ 1的比例随机的将数据分成训练集、验证集和测试集,以进行实验。

3. 3 性能评价指标

实验评价指标采用精密度(Precision,P)、回收率(Recall,R)、平均测量精度(mAP)、浮点运算次数(Giga Floating-point Operations Per Second,GFLOPs)对改进后的网络进行评估。P、R、mAP 计算如下:

式中:TP 表示模型预测为正向的正样本,FP 表示模型预测为正向的负样本,FN 表示模型预测为负向的正样本,即漏检数;APi 表示对数据集中的某一种类别求平均精度,k 表示数据集中所有类别的数目。

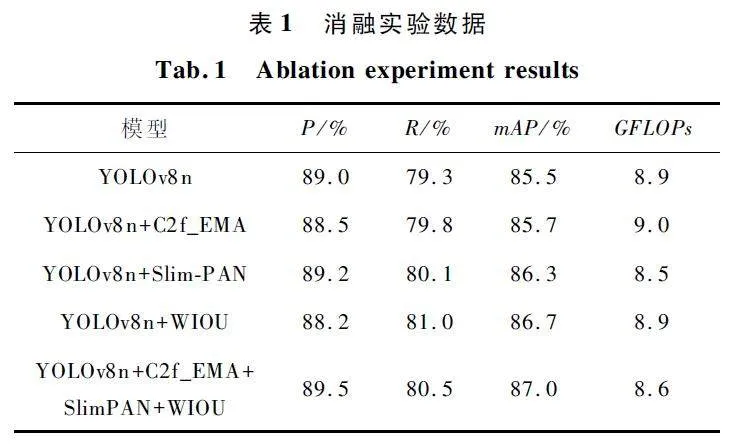

3. 4 消融实验

为了分析每个模块对原网络的作用和有效性,通过设计4 组消融实验来分别评估使用C2f_EMA模块、Slim-PAN 结构、WIOU 损失函数对YOLOv8n的改进效果,结果如表1 所示。分析表1 实验数据可知,原YOLOv8n 的P、R、mAP、GFLOPs 分别为89% 、79. 3% 、85. 5% 、8. 9。加入C2f_EMA 模块后,R 和mAP 均有不同程度的提升,说明C2f_EMA 模块有助于更好地聚焦于网络关注的地方,从而克制对无关的背景信息的关注。用SlimPAN 结构改进PAN结构,减少了计算量的同时使得P 提高了0. 2% ,R 提高了0. 8% ,mAP 提高了0. 8% ,说明SlimPAN 结构能在实现轻量化的同时提高准确率、召回率和平均精度均值;用WIOU 损失函数替换CIOU 损失函数,P 下降了0. 8% ,R 提高了1. 7% ,mAP 提高了1. 2% ,说明WIOU 损失函数以降低准确率为代价大大提升了召回率和平均精度均值;同时添加C2f_EMA 模块、Slim-PAN 结构以及WIOU 损失函数后,P 提高了0. 5% ,R 提高了1. 2% ,mAP 提高了1. 5% ,GFLOPs减少了0. 3,取得了最优改进。

3. 5 对比实验

为了证明所提模型的优势,在其余所有条件都不变的前提下,利用DIOR 公开遥感数据集在YOLOv3、YOLOv5、YOLOv6、YOLOv8n 以及改进的YOLOv8n 网络进行了对比试验,结果如表2 所示。

从表2 可以看出,YOLOv8n 网络的P、R、mAP指标要明显优于其他经典YOLO 模型,而改进的YOLOv8n 网络在计算量低于原YOLOv8n 网络的前提下,其P、R、mAP 均有不同程度的提升,既实现了网络的轻量化又提升了对遥感图像中目标的检测精度,证明了本文改进方法的有效性。

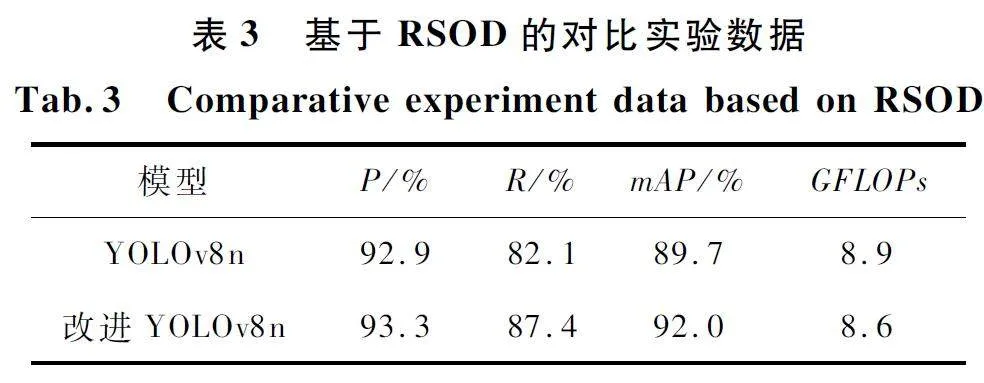

为了充分反映本文方法的适用性,设置相同的训练参数,将改进后的YOLOv8n 网络在RSOD 数据集上进行实验,结果如表3 所示。

分析表3 实验数据可知,改进YOLOv8n 网络的P 提高了0. 4% ,R 提高了5. 3% ,mAP 提高了2. 3% ,计算量GFLOPs 减少了0. 3,证明了本文改进方法的适用性。

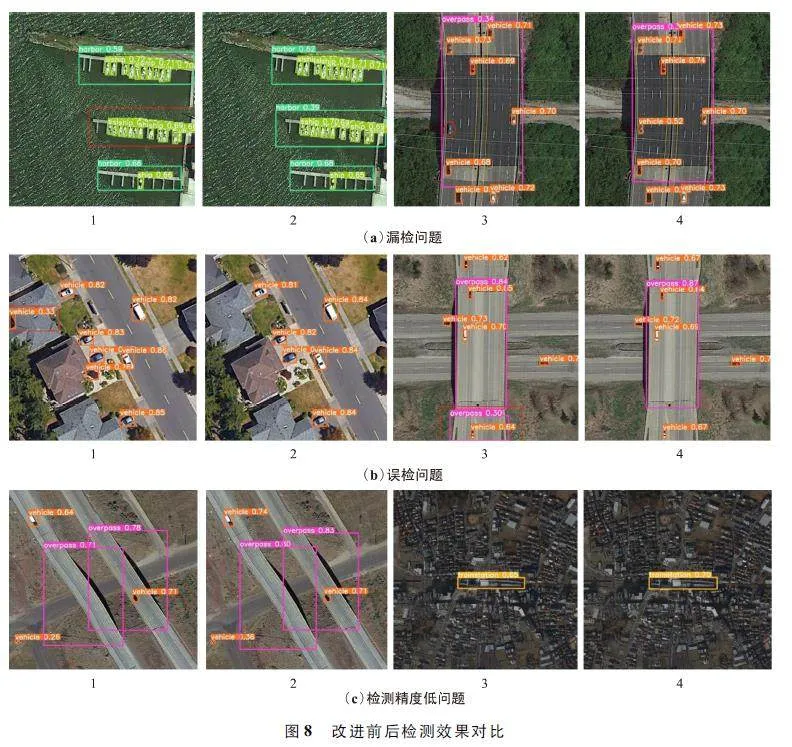

本文对DIOR 数据集中检测效果具有代表性的几类场景进行改进前后检测效果的可视化效果进行了展示,如图8 所示。其中,图8 (a)1、图8 (a)3、图8(b)1、图8 (b)3、图8 (c)1、图8 (c)3 为原YOLOv8n 算法检测效果图,图8 (a)2、图8 (a)4、图8(b)2、图8(b)4、图8(c)2、图8(c)4 为改进后的YOLOv8n 算法检测效果图。由图8(a)1、图8(a)2 的检测效果可知,在待检测目标分布密集且尺度变化范围大的情况下,改进后的算法有效地解决了对于红框处海港的漏检问题并且提升了对海港这种大目标的检测精度。由图8(a)3、图8(a)4 的检测效果可知,在背景复杂且待检测目标尺度变化范围大的情况下,改进后的算法有效地解决了对于红圈处车辆的漏检。由图8(b)1、图8(b)2 的检测效果对比可知,在待检测目标分布密集的情况下,原始YOLOv8n 算法错误地将房屋阴影处识别为车辆,而改进后的YOLOv8n 算法有效地解决了误检问题。由图8(b)3、图8(b)4 的检测效果对比可知,在待检测目标分布密集且尺度变化范围大的情况下,改进后的算法完美地解决了对于天桥这种大目标的误检。图8(c)1、图8(c)2、图8(c)3、图8(c)4 的检测结果表明,在背景复杂且目标尺度变化范围大的情况下,改进后的算法相比原始YOLOv8n 算法检测精度更高,检测效果更好。总体上来说,改进后的算法既解决了目标被漏检或误检的问题又提升了检测精度,体现了该算法的有效性。

4 结束语

针对复杂背景下遥感图像目标分布密集、尺度变化范围较大的检测难题,将注意力机制EMA 引入到主干网络部分C2f 模块中,从而加强网络在复杂背景下对目标的注意力;提出了Slim-PAN 的结构,使不同尺度之间的特征相互融合,既实现了网络的轻量化又提升了对遥感目标的检测精度;使用WIOU 损失函数来替换原网络中的CIOU 损失函数,解决了当预测框与真实框重合时惩罚项失灵的问题,提高了定位框的准确度。在DIOR 数据集和RSOD 数据集上进行实验,改进后的YOLOv8n 网络比原YOLOv8n 网络的准确率、召回率、平均精度均值分别提高了0. 5% 和0. 4% 、1. 2% 和5. 3% 、1. 5%和2. 3% ,且计算量GFLOPs 降低了0. 3,证明了改进算法既具有适用性又具有有效性。鉴于DIOR 数据集和RSOD 数据集主要包含白天或晴天的遥感图像,晚上、雾天和雨天等恶劣天气环境下的图像很少,因此未来将在恶劣天气下收集相关遥感图像并加入DIOR 和RSOD 数据集中,以增强网络在恶劣环境下的鲁棒性和泛化性。

参考文献

[1] 李阿标,郭浩,戚畅,等. 复杂背景下遥感图像密集目标检测[J]. 计算机工程与应用,2023,59(8):247-253.

[2] 余俊宇,刘孙俊,许桃. 融合注意力机制的YOLOv7 遥感小目标检测算法研究[J]. 计算机工程与应用,2023,59(20):167-175.

[3] 付涵,范湘涛,严珍珍,等. 基于深度学习的遥感图像目标检测技术研究进展[J]. 遥感技术与应用,2022,37(2):290-305.

[4] GIRSHICK R,DONAHUE J,DARRELL T,et al. Rich Feature Hierarchies for Accurate Object Detection and Se-mantic Segmentation[C]∥Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:580-587.

[5] GIRSHICK R. Fast RCNN [C ]∥ Proceedings of theIEEE International Conference on Computer Vision. Santiago:IEEE,2015:1440-1448.

[6] CAI Z W,VASCONCELOS N. Cascade RCNN:Delvinginto High Quality Object Detection[C]∥ Proceedings ofthe IEEE Conference on Computer Vision and PatternRecognition. Salt Lake City:IEEE,2018:6154-6162.

[7] REDMON J,DIVVALA S,GIRSHICK R,et al. You OnlyLook Once:Unified,Realtime Object Detection [C]∥Proceedings of the IEEE Conference on Computer Visionand Pattern Recognition (CVPR ). Las Vegas:IEEE,2016:779-788.

[8] REDMON J,FARHADI A. YOLOv3:An Incremental Improvement[EB / OL]. (2018 - 04 - 08)[2023 - 09 - 04].https:∥arxiv. org / abs / 1804. 02767.

[9] LI C Y,LI L L,JIANG H L,et al. YOLOv6:A Singlestage Object Detection Framework for Industrial Applications[J]. (2022 - 09 - 07 )[2023 - 12 - 04 ]. https:∥arxiv. org / abs / 2209. 02976.

[10] LIU W,ANGUELOV D,ERHAN D,et al. SSD:Single ShotMultibox Detector[C]∥Computer VisionECCV 2016:14thEuropean Conference. Amsterdam:ECCV,2016:21-37.

[11] ZHANG H K,CHANG H,MA B P,et al. Cascade Retinanet:Maintaining Consistency for Singlestage ObjectDetection[J]. (2019-07-16)[2023 -09 -04]. https:∥arxiv. org / abs / 1907. 06881.

[12] DUAN K W,BAI S,XIE L X,et al. Centernet:KeypointTriplets for Object Detection [C]∥ Proceedings of theIEEE / CVF International Conference on Computer Vision.Seoul:IEEE,2019:6568-6577.

[13] HOU Y J,SHI G,ZHAO Y X,et al. RYOLO:A YOLObased Method for Arbitraryoriented Target Detection inHighresolution Remote Sensing Images [J ]. Sensors,2022,22(15):5716.

[14] 张上,张岳,王恒涛,等. 轻量化无人机遥感图像小目标检测算法[J]. 无线电工程,2023,53(10):2329-2336.

[15] WAN D H,LU R S,WANG S L,et al. YOLOHR:Improved YOLOv5 for Object Detection in HighresolutionOptical Remote Sensing Images [J ]. Remote Sensing,2023,15(3):614.

[16] 梁秀满,贾梓涵,于海峰,等. 基于改进YOLOv7 的无人机图像目标检测算法[J / OL]. (2023 -10 -17)[2023 -12 - 04 ]. http:∥ kns. cnki. net / kcms / detail / 13. 1097.TN. 20231013. 1804. 010. html.

[17] OUYANG D L,HE S,ZHANG G Z,et al. Efficient Multiscale Attention Module with Crossspatial Learning[C]∥ICASSP 2023 - 2023 IEEE International Conference onAcoustics,Speech and Signal Processing (ICASSP ).Rhodes Island:IEEE,2023:1-5.

[18] TONG Z J,CHEN Y H,XU Z W,et al. WiseIoU:Bounding Box Regression Loss with Dynamic FocusingMechanism[EB / OL]. (2023 -01 -24)[2023 -12 -04].https:∥arxiv. org / abs / 2301. 10051.

[19] ZHENG Z H,WANG P,REN D W,et al. Enhancing Geometric Factors in Model Learning and Inference for ObjectDetection and Instance Segmentation [J ]. IEEETransactions on Cybernetics,2021,52(8):8574-8586.

[20] LI K,WAN G,CHENG G,et al. Object Detection inOptical Remote Sensing Images:A Survey and a NewBenchmark[J]. ISPRS Journal of Photogrammetry andRemote Sensing,2020,159:296-307.[21] LONG Y,GONG Y P,XIAO Z F,et al. 。Accurate ObjectLocalization in Remote Sensing Images Based on Convolutional Neural Networks[J]. IEEE Transactions on Geoscience and Remote Sensing,2017,55(5):2486-2498.

[22] LI H L,LI J,WEI H B,et al. Slimneck by GSConv:ABetter Design Paradigm of Detector Architectures for Autonomous Vehicles[EB / OLJ]. (2022 - 08 - 17)[2023 -12-04]. https:∥arxiv. org / abs / 2206. 02424.

作者简介

程换新 男,(1966—),博士,教授,硕士生导师。主要研究方向:人工智能、先进控制、机器视觉。

矫立浩 男,(1999—),硕士研究生。主要研究方向:人工智能、深度学习、目标检测。

(*通信作者)骆晓玲 女,(1966—),博士,教授,硕士生导师。主要研究方向:过程装备自动化的优化设计。

于沙家 女,(1986—),硕士,讲师。主要研究方向:人工智能、先进控制技术。

基金项目:国家自然科学基金(62273192)