增强特征融合并细化检测的轻量化SAR图像船舶检测算法

摘 要:针对SAR 图像船舶检测任务在船舶组合和船舶融合场景下低检测精度的问题,提出了一种轻量化船舶检测算法———RGDET-Ship,有效提高了SAR 图像在复杂场景下的船舶检测精度。该算法的创新点包括:① 构建基于改进ResNet的基础主干网络,增强深浅网络早特征融合,保留更丰富的有效特征图,并利用RegNet 进行模型搜索得到一簇最优结构子网络RegNet and Early-Add (RGEA),实现模型的轻量化;② 在FPN Neck 基础上,结合EA-fusion 策略设计出FPN and EarlyAdd Fusion (FEAF)Neck 网络,进一步加强深浅特征晚融合,提高中大船舶目标特征的提取;③ 通过细粒度分析改进RPN网络得到Two-RPN (TRPN) 网络,提高模型的检测粒度和预测框准确性;④ 引入多任务损失函数———Cross Entropy Lossand Smooth L1 Loss (CE_S),包括分类任务和回归任务,进一步提升检测性能。通过在标准基准数据集SSDD 上进行大量实验,验证了RGDET-Ship 模型的有效性和健壮性。实验结果表明,相较于Faster RCNN 和Cascade RCNN,RGDET-Ship 在mAP_ 0. 5:0. 95 上分别提升了5. 6% 和3. 3% ,在AR 上分别提升了9. 8% 和7. 6% 。

关键词:船舶检测;深浅特征融合;细粒度设计;RGDET-Ship

中图分类号:TP391. 41 文献标志码:A 开放科学(资源服务)标识码(OSID):

文章编号:1003-3106(2024)05-1123-13

0 引言

SAR 图像船舶检测是海上目标检测中一项重要且具有挑战性的工作。船舶检测可以提高许多海上任务的效率,有助于在海上救灾抢险和海洋安全监测领域中快速有效地锁定可疑目标并采取相应措施[1-2]。

受益于深度学习中卷积神经网络的有效特征表示,许多基于卷积神经网络的目标检测算法实现了较好的效果[3-4]。然而准确的船舶检测仍然存在一些挑战。例如,SAR 图像中船舶与非船舶物体具有不同的语义,但具有相似的特征(例如白色光点)。如果没有高级语义和全局上下文,很难区分它们。另一方面,由于SAR 图像中小尺寸船舶通常是小目标,特征单一,大尺寸船舶又具有较多的局部特征,若图像中存在多尺寸的船舶信息,高级语义则很难准确检测所有船舶。因此,低级和高级特征信息对于准确的船舶检测是互补的。现有的SAR 船舶要么仅对小船舶目标进行了快速检测[4-6],要么构建更深层网络对中大尺寸船舶进行精确的检测[3,7-8]。多数研究并没有结合这2 个特性,从而导致在不同场景下会有检测不准确的问题。船舶检测中的其他常见问题是多船舶组合行驶和码头干扰。码头干扰是由于船舶与码头高度融合导致船舶很难被识别。多船舶组合行驶是由于多只船舶组合在一起导致整体结构失去了船舶的典型特征。

为克服这些缺点,本文提出了RGDET-Ship 模型,一种增强特征融合并细化检测粒度的轻量化SAR图像船舶检测算法。具体来说,将包含一只或多只船舶的图像作为输入,首先构建RegNet and Early-Add(RGEA)主干网络从SAR 船舶图像中提取不同深度的图像特征;然后,构建FPN and Early Add Fusion(FEAF)网络结合各个特征层关系生成新的全局记忆特征图;其次,设计Two-RPN(TRPN)区间建议生成网络,生成可预测的特征图;最终,构建多任务损失函数,分类损失和回归损失。实验结果表明,RGDET-Ship 船舶检测模型很大程度上优于现有的方法,在SSDD[9]数据集上mAP =0. 650,在HRSID[10]数据集上mAP =0. 690,FPS =14。

1 相关算法介绍

与小目标检测和网络深度扩建不同[5,8],RGDET-Ship检测是通过扩大感受野和细化检测粒度来精准检测定位SAR 图像中较为复杂情形下的所有船舶。以下是实现本文算法的前期积累。

Zhang 等[11]使用深度卷积和逐点卷积相结合替换原普通卷积,有效减少了检测网络中的参数量;文献[8]在FPN 网络结构中通过巧妙组合感受野模块(RFB)和卷积块注意力模块(CBAM)有效增强了特征融合操作;文献[12]通过设计一种新型双向特征融合模块(bi-DFM)有效地聚合了多尺度特征,从而增强了深浅特征层的融合;Vu 等[13]对RPN 网络进行了细粒度分析后设计了一种用于提高区域建议框质量的网络Cascade RPN。此外,SSDD 数据集由Zhang 等[9]首次提出,并提供了相应的船舶真实框和标签信息,Wei 等[10]提出了名为HRSID 的新SAR 图像船舶数据集,该数据集包含了更多场景下的船舶图像信息。

在传统目标检测过程中随着网络的加深,出现了训练集准确率下降的现象。出现此类现象的原因是在传统的卷积操作全连接过程中信息的传递会存在信息丢失和消耗等问题,同时还会导致梯度爆炸或消失,从而阻碍了网络收敛,无法训练。ResidualNeural Network(ResNet)由He 等[14]提出,通过使用ResNet Unit 成功训练出了152 层的神经网络。加入了直连通道(Highway Network)思想的ResNet 结构可以极快地加速神经网络训练且模型准确率也有较大提升。

在目标检测网络中,识别不同大小的物体是网络实现检测的基本需求。Lin 等[15]提出了FPN 金字塔特征提取网络结构,它是一种自顶向下的特征融合方法。首先通过将更小的目标放在更高分辨率的卷积特征图上预测,将大目标分配到分辨率较低的预测层进行预测;其次进行连续上采样和跨层融合机制;最终使得输出的特征兼具底层视觉信息和高层语义信息。

2 算法改进

2 算法改进

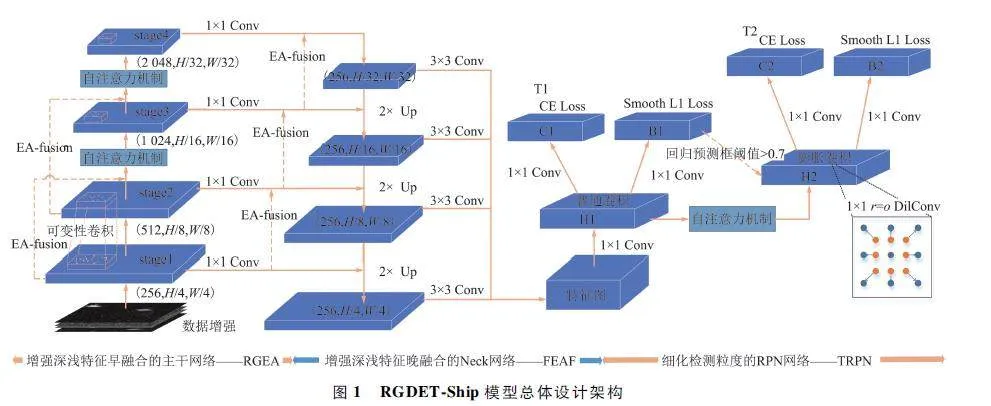

本文提出一种新的细化检测粒度并增强深浅特征融合的SAR 图像船舶轻量化检测模型———RGDET-Ship。RGDET-Ship 由4 个主要部分组成:① 扩大感受野增强深浅特征早融合的RGEA 主干网络;② 用于增强深浅特征晚融合的FEAF Neck 网络;③ 具有更高细粒度的候选区生成器TRPN 网络;④ 用于计算分类和回归误差的Cross EntropyLoss and Smooth L1 Loss(CE_S)损失函数。本文提出的RGDET-Ship 模型总体设计架构如图1 所示。

2. 1 RGEA 主干网络

在主干网络特征信息传递过程中,底层特征分辨率更高,包含更多位置和细节信息但相对卷积更少,噪声更多,而高层特征具有更强语义信息但分辨率低,对细节的感知能力较差。融合不同尺度的特征是提高检测性能的一个重要手段。本文提出了Early Add-fusion(EA-fusion)早融合策略,通过add并行连接方式将2 个特征向量组合成复合向量,对于输入特征x 和y,输出特征如下:

z = αx + βy, (1)

式中:α 和β 为权重值,x 和y 为输入特征,z 为输出特征。

本文以ResNet[14]为关键组件,首先使用可变性卷积代替原有的普通卷积来扩大特征图的感受野获得更多特征信息。

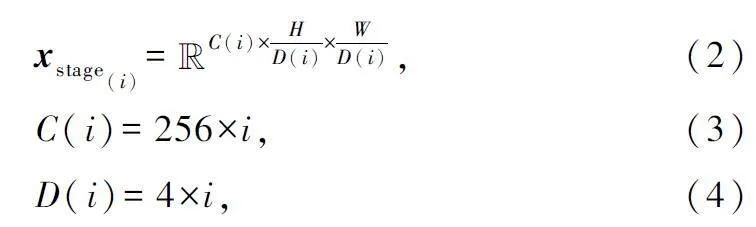

其次使用EA-fusion 结合自注意力机制Attention 对stage1 特征层和stage3 特征层以及stage2 特征层和stage4 特征层进行融合从而增强深浅特征早融合,给定输入图像x∈R3×H×W ,通过RGEA的4 层特征层后依次输出特征图形状满足:

式中:i 表示当前阶段数,i∈{1,2,3,4};C(i)表示当前特征图的通道数,D(i)表示当前特征图的长宽比原输入图片的长宽减少多少倍。

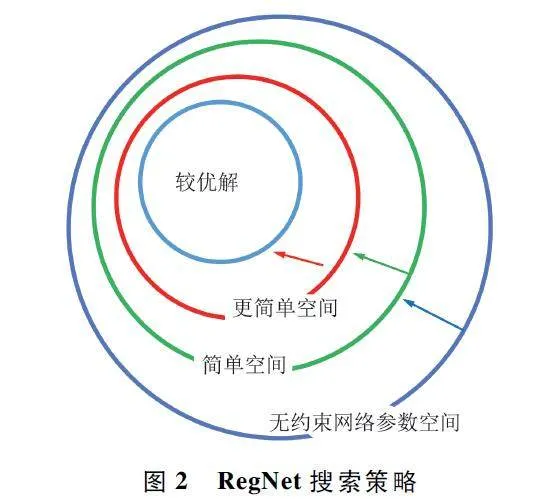

最后使用RegNet 搜索策略[16]在上述模型中进行搜索最优的网络设计空间,从而得到一簇性能较好的简单网络子模型RGEA。使用RegNet 搜索策略生成较好的网络子模型的过程如图2 所示。

2. 2 FEAF Neck 网络

在主干网络架构设计之后本文构建了以FPN为基础改进的FEAF 特征融合网络层。FPN 是典型的深浅特征晚融合策略[15]。将从主干网络中提取到的多尺度特征信息进行融合,进而提高目标检测的精度。为尽可能多地提取到有效特征信息,本文在晚融合操作前依次对stage2、stage3 和stage4 的输出特征层再进行了EAfusion 融合,实现了增强深浅特征晚融合的FEAF 网络。

如图1 所示,FEAF 首先把RGEA 输出的4 层特征图都归为一个stage,特征图形状表现为x∈R256×H/D×W/D(D∈{4,8,16,32})并结合EA-fusion 策略进行特征深浅早融合保留更多的特征信息。

其次进行2 倍的双线性插值上采样操作,对应特征图的高和宽满足下式:

Hout = [Hin × scale_factor], (5)

Wout = [Win × scale_factor], (6)

式中:Hin 表示输入特征图的高,Hout 表示输出特征图的高,Win 表示输入特征图的宽,Wout 表示输出特征图的宽,scale_factor 表示指定输出为输入的多少倍数。

最后结合EA-fusion 策略进行横向连接将处理好的RGEA 输出结果与相同上采样得到的特征层进行融合,并使用3×3 标准卷积消除混叠效应生成可预测的特征图。

2. 3 TRPN 区间建议生成网络

RPN[17]用于筛选出可能会存在目标的框。它依靠在共享特征图上的一个滑动窗口,为每个位置生成9 种anchor,并通过卷积回归当前anchor 和真实框之间的差值来进行精调,但因为真实框与anchor 是非对齐的,所以会出现大量回归误差。为了缓解对齐问题,本文设计了TRPN 网络,框架如图2所示。

将回归序列f t,分类器g,以及特征图x 作为输入参数,并在特征图图像上均匀初始化锚点集1 ={a1 }。在进行生成区间建议框过程中,首先T1 部分对特征图x 进行了标准RPN 操作得到了初始化锚点a,在特征图上进行精调后的anchor 定义为a并进行了回归预测;其次T2 部分通过式(7)可计算得出特征与anchor 的偏移1 = {o1 },并对特征图x进行了膨胀卷积,膨胀系数r 由o 的大小来决定。最终进行使用特征图x 和偏移o 来计算得分s =g(x,o)并使用NMS 操作从= {a}和= {s}中导出区间建议框,该建议框会映射到EAFPN 输出的特征图中得到模型的预测结果。

o = octr + oshp , (7)

式中:octr = (ax -px,ay -py)为中心点偏移,oshp 为形状偏移量,由anchor 的形状和卷积核大小决定。

2. 4 CE_S Loss 损失函数

目标检测任务中的损失计算大多由两部分组成:船舶目标预测与真实目标之间的分类损失Lcls以及船舶目标检测框的回归损失Lbox。本文的CE_S多任务损失函数由交叉熵分类损失和Smooth L1 回归损失组合而成:

CE_S = LCE + LSmooth_L1 , (8)

式中:LCE 表示交叉熵分类损失,LSmooth_L1 表示Smooth L1 回归损失。

分类交叉熵损失函数如下:

LCE = CELoss(Xi,Yi) = - Σcj = 1yij × lb(pij), (9)

LCE = CELoss(Xi,Yi) = - Σcj = 1yij × lb(pij), (9)式中:c 表示类别数,yij 表示第i 个样本是否属于类别j,如果属于则yij = 1,否则yij = 0;pij 表示第i 个样本属于类别j 的概率。本文采用SoftMax 函数得到样本属于每种类别的概率pij。

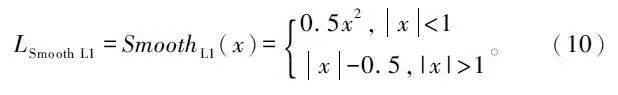

对于预测框的回归损失,本文采用Smooth L1损失函数。本文的船舶检测属于单样本,定义x 为预测值和真实值的差值,则对应的Smooth L1 损失函数可表示为:

3 实验与分析

3. 1 数据集

本文在SSDD 数据集[9]和HRSID 数据集[10]上训练和测试船舶检测模型。模型训练过程中使用的SSDD 数据集共1 160 张SAR 船舶图像,本文按7 ∶2 ∶ 1 的比例划分出了训练集、验证集和测试集。HRSID 作为模型定量分析的实验数据集。为满足SSDD 与HRSID 数据集格式相同,本文统一将图像标签设置为COCO 数据格式。

通过对SSDD 数据集中的每张船舶图像进行统计分析得出以下3 点船舶特点:① 如图3(a)所示,数据集中大多数船舶均为小尺寸目标,也存在有少量的大尺寸船舶目标,即船舶尺寸分布不均衡,检测大尺寸的船舶目标模型会出现欠拟合现象;② 如图3(b)所示,只存在一只船舶的图像数量最多,其余图像中平均存在2 ~ 3 只船舶,也存在少数图像包含大量船舶元素,可以看出船舶空间分布不均衡,在检测含有大量船舶目标的图像时会出现漏检现象;③ 如图3(c)和图3(d)所示,船舶目标框多为小方型和扁长型且anchor 框的宽高比率集中在2 上,由此可设置船舶检测模型中anchor 比例初始值为[0. 5,1. 0,2. 0]。

为避免模型出现大目标船舶样本欠拟合现象,以及由于图像中船舶空间分布不均衡而出现漏检现象,本文采用缩放、翻转、旋转以及添加各类噪声的方式对SSDD 数据集进行了数据增强,从而平衡数据样本。数据集的各类增强效果如图4 所示。

3. 2 评价指标与实验环境详细信息

为评估RGDET-Ship 算法在SAR 图像船舶检测任务中的性能,本文采用了准确率(P )、召回率(R)、平均精度(mAP)以及平均召回率(AR)作为评估指标。构成目标检测评价指标的基本参数是真阳性(TP)、假阳性(FP)和假阴性(FN)。TP 表示预测阳性目标和实际是阳性目标的数量,即当且仅当RGDET-Ship 准确地检测并定位船舶目标时,结果才被视为真阳性;FP 表示预测阳性目标但实际是阴性目标的数量;FN 表示预测的阴性目标但实际是阳性目标的数量。

实验首先使用coco 格式数据集训练初始化网络,其次使用batch_size 为16 的SGD 优化器对模型进行了30 轮的训练。其中,主干网络的初始学习率设为0. 02,动能为0. 9,数据集图像归一化后的均值为[0. 155 909 70,0. 155 913 68,0. 155 889 38],方差为[0. 108 753 29,0. 108 760 05,0. 108 695 34]。本文所有实验均在NVIDIA GeForce RTX 3060 GPU上进行。

3. 3 与最新技术的比较

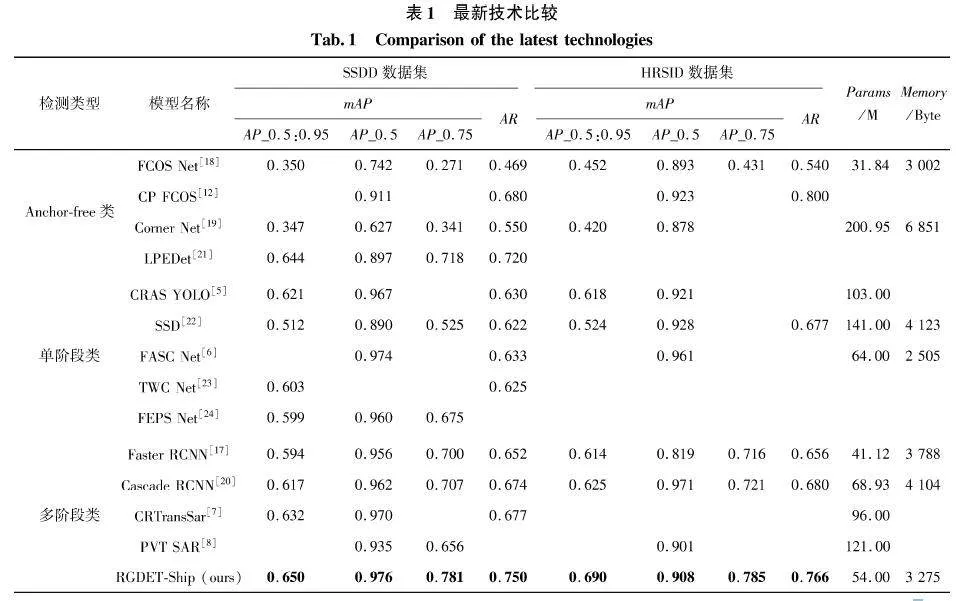

RGDET-Ship 与各检测类型中SAR 图像船舶检测方法的主要定量比较如表1 所示。具体来说,由于各大类目标检测算法的检测机制有所不同,因此本文进行了分类比较。

在Anchor-free 类型中使用FCOS[18]和Corner-Net[19]模型作为基准模型的SAR 船舶检测算法较多,其中CP-FCOS[12]以FCOS 框架为基础,重构建了网络层并加入类别位置(CP)模块层用于优化网络中回归分支的特征,有效提升了模型性能但同时也增加了模型层数。在单阶段检测类型中,多数学者受YOLO 系列算法的启发开始自主实现相关的检测模型,CRAS-YOLO[5]和FASC-Net[6]基于一阶段算法思想构建的网络模型,在小目标检测任务上都有着出色的表现,但在整体精度AP_0. 5:0. 95 上并无明显增长。在多阶段检测类型中,多数研究使用Faster RCNN[17]和Cascade RCNN[20]为基准模型进行改进,CRTransSar[7]以Swin Transfromer 为基本框架提出了一种基于上下文联合表示学习的主干网络,但模型体积和参数量过于庞大。PVTSAR[8]的突出优势在于使用二阶段算法有效地提高了小目标检测的精度。与目前存在的多种目标检测方法相比,本文的RGDET-Ship 作为二阶段SAR 图像船舶检测模型仍然具有较好的性能,能够在保持小目标检测效率的同时提高大目标检测模型。

3. 4 消融研究

本节进行了大量实验,以证明RGDET-Ship 船舶检测模型的有效性。消融实验使用的基础数据集是SSDD 数据集。

3. 4. 1 RGEA 主干网络

为提高模型对SAR 图像船舶的特征提取能力,本文在ResNet50 基础上提出了RGEA 主干网络。该主干网络主要包含了3 处改进:① 使用膨胀卷积并结合EA-fusion 策略实现深浅特征早融合,从而保留更多有效信息;② 添加自注意力机制,使得模型具有捕捉远距离上下文信息的能力,从而有效检测图像占比较大的船舶目标;③ 使用RegNet 网络搜索策略在模型中进行搜索最优的网络设计空间,从而得到一簇性能较好的网络子模型。以下是对3 处改进的消融实验分析。

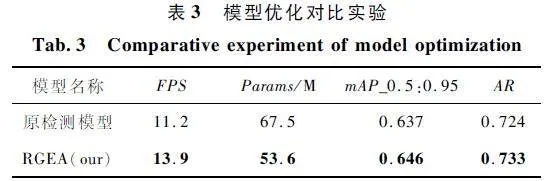

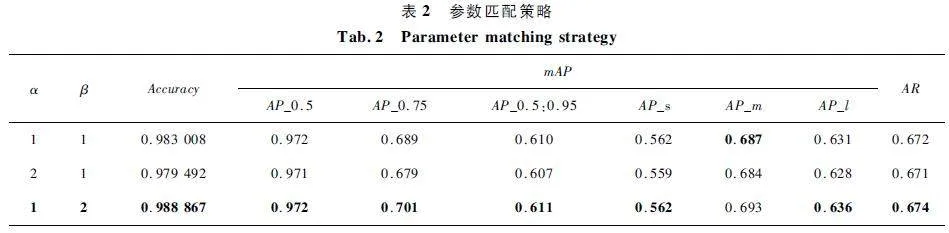

① EA-fusion 策略参数匹配。本文提出的EA-fusion 融合策略由2 个主要特征向量组成:浅层特征向量和当前层的特征向量。具体地,将包含了更丰富信息的浅层特征向量与相较浅层特征具有更高的语义解释性的深层特征向量(当前层的特征向量)进行融合操作。在这种情况下,本文进行消融实验以进一步得到相对较好的结合方式:浅层特征向量占比大还是深层特征向量占比大?如表2 所示,在α = 1,β = 2 的情况下获得最佳结果,这表明在融合过程中,当前层的特征向量相较于浅层特征向量依然占主导作用。

② 自注意力机制。自注意力机制作为RGEA主干网络中与EA-fusion 融合策略相结合的重要组成部分,具有捕捉远距离上下文信息的能力。对于自注意力机制,使用热力图进行比较,以验证引入自注意力的有效性。如图5 所示,使用典型的大型船舶和停靠的船舶作为验证图像,可以看出有自注意力机制的模型比没有自注意力机制的模型能提取更有效的特征信息,在典型大船舶的热力图中,添加了自注意力机制的模型可以更好地将船舶轮廓展示出来,在多船舶的热力图中,添加了自注意力机制的模型可以更好地区分船舶与非船舶物体部分。

③ RegNet 网络搜索策略。RegNet 网络搜索策略通过对模型进行搜索最优的网络设计空间,并从中得到一簇性能较好的网络子模型。在相同的训练设计和FLOPs 条件下,将结合了RegNet[16]网络搜索策略的检测模型与原检测模型进行模型性能分析,如表3 所示。

由表3 可以看出,RegNet 网络搜索策略在SAR图像船舶检测任务中表现很出色。

3. 4. 2 FEAF Neck 网络

特征金字塔FPN 网络[15],主要用于提取不同尺度特征图并提供给后面的网络执行预测任务。为验证FEAF 模块在SAR 船舶检测模型中的有效贡献,本文将FEAF 与现有的各类主流Neck 网络进行了对比实验,如表4 所示,展示了不同Neck 网络在SSDD 数据集上的表现。

由表4 可知,本文设计的FEAF 网络在SAR 图像船舶检测任务中有较好的优势。使用主流改进的CARFPN 和PAFPN 都有明显的精度下降,导致此结果的原因是此类数据集属于单色简单目标类型,在进行特征晚融合过程中若进行过多卷积操作反而会丢失更多的有效特征信息。相反,FEAF 中通过结合EA-fusion 策略丰富了输入特征信息,从而FEAF可提取到更多的有效特征信息。

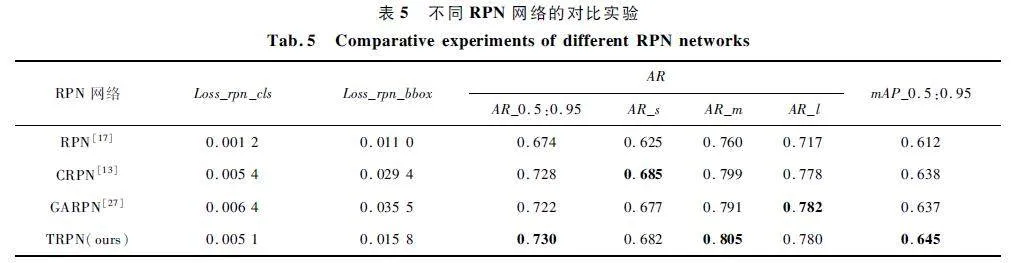

3. 4. 3 TRPN 区间建议生成网络

为细化RGDET-Ship 模型的检测粒度,本文提出的TRPN 建议区间生成网络,主要通过设计2 个主从关系的RPN 来生成较高质量的建议框。本文将TRPN 与现有各类主流RPN 网络进行对比实验。不同RPN 网络在SSDD 数据集上的表现如表5 所示。

区域生成网络RPN 主要用于筛选出可能会有目标的框。由表5 可得,基于RPN 改进的2 类主流网络CRPN 和GARPN 在本实验中均有较好的表现。CRPN 专注于强调anchor 的对齐规则,使用自适应卷积来精调每个阶段的anchor。GARPN 专注于判断目标点概率是否超出阈值进而调整anchor,GARPN 相较于CRPN 大尺寸船舶定位框更准确。本文通过结合二者优点而设计的TRPN 拥有2 个主从关系的RPN,使用anchor 对齐规则对预测框的位置进行精调,并将拥有更高阈值的船舶预测框送入第2 个阶段再次进行细调。最终TRPN 在SAR 图像船舶检测任务中拥有更突出的表现。

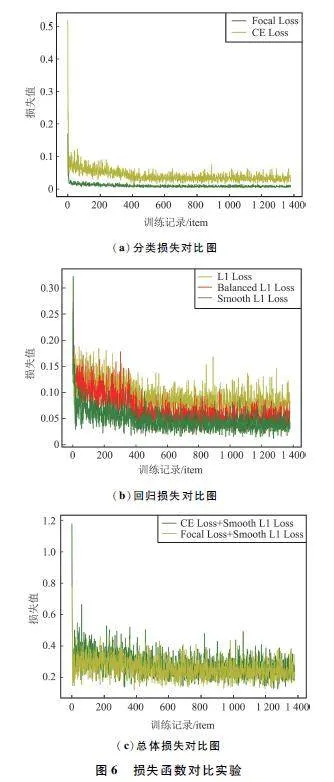

3. 4. 4 CE_S 损失函数

为验证CE_S 损失函数在RGDET-Ship 模型上的有效性,本文进行了如图6 所示的3 组对比实验。由图6(a)可知,在分类损失中使用Focal Loss 有显著优势,模型收敛速度也快;由图6 (b)可以看出Smooth L1 Loss 在模型训练中充分发挥了其优势;图6(b)将CE Loss 和Focal Loss 分别结合SmoothL1 Loss 进行了总图损失的比较,Focal Loss 和Smooth L1 Loss 相结合的效果与CE Loss 和SmoothL1 Loss 相结合的总体损失相似。

如表6 所示,Focal Loss 虽然在图6(a)样本分类损失计算中有较好的收敛性和表现,但精度相较于用CE Loss 训练模型的结果有明显的下降。在自然图像检测中,Focal Loss 从样本难度分类角度出发,使得Loss 聚焦于难分样本,从而解决了样本非平衡的问题,同时提高了自然图像检测模型的整体性能。然而本文数据集中有一个明显的特点,即船舶目标和非船舶目标物体差异较小并且噪声干扰情况下,船舶形状也会发生变化,在Focal Loss 的训练中就会针对此类船舶样本进行过多解读,进而导致本文的模型精度有所下降。因此本文采用CE_S 作为RGDET-Ship 模型的损失函数。

3. 5 模型推理

通过模型推理过程和推理结果,详细分析模型的健壮性和模型的效率。

3. 5. 1 模型健壮性

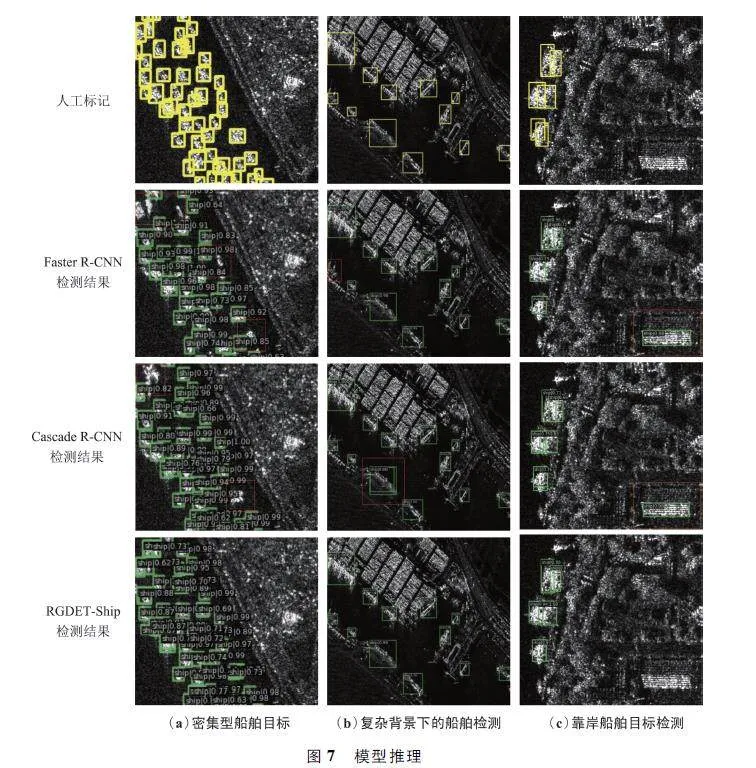

在实际应用中,如拍摄高度、环境噪声和图片亮度是最常见的船舶信息变化,而SSDD 数据集中现有的船舶图像场景有限,因此额外复杂场景下的船舶图像对验证模型鲁棒性来说至关重要,本文在不同雷达卫星拍摄的图像中选取了几类不同场景复杂度的SAR 船舶图像。如图7 所示,使用RGDET-Ship 与Cascade R-CNN 和Faster R-CNN 进行对比实验并分析RGDET-Ship 模型的健壮性。图7 列出3 种不同船舶检测场景。绿色框表示模型预测的船舶定位;红色框表示模型出现错检、漏检以及重检的船舶目标。

由图7 可知,Faster R-CNN 只适用于检测常规船舶,面对各类复杂环境的船舶检测场景容易出现漏检和错检现象。Cascade R-CNN 检测粒度较大且上下文语义联系较弱从而出现错检和重复检测的问题。在与Cascade R-CNN 和Faster R-CNN 对比下,本文提出的RGDET-Ship 船舶检测模型在不同复杂场景下具有更高的鲁棒性,面对不同近岸干扰和不同的尺寸大小情况下的船舶都有较好的检测能力。

3. 5. 2 模型泛化性

为验证RGDET-Ship 模型的泛化性,本文通过绘制相关的Precision-Recall(P-R)曲线进行全面分析。P-R 曲线上的某一个点代表着在某一阈值下模型将大于该阈值的结果判定为正样本,否则为负样本,并返回结果对应的召回率和准确率。所以,P-R曲线是检测模型泛化能力的重要指标。

如图8 所示,将Cascade R-CNN 和Faster R-CNN分别与RGDET-Ship 进行对比,其中分别选取了IoU = [0. 5,0. 6,0. 7]下的P-R 曲线进行对比分析,结果表明本文提出的RGDET-Ship 模型与经典算法Faster R-CNN 和Cascade R-CNN 有着较高的重合度。其中图8(b)和图8(c)在IoU 为0. 6 和0. 7 的情况下,RGDET-Ship 的性能略胜于Faster R-CNN。总而言之,RGDET-Ship 有着较好的泛化性。

3. 5. 3 模型大小与效率

目前常用于评价模型大小以及效率的指标有:访存量(Memory)、参数量(Params)以及推理速度(Frame Per Second,FPS)等,这些指标从不同的纬度评价了模型的大小和效率。Memory 是模型计算所需访问的单元字节大小,反映模型对存储单元带宽的需求;Params 是模型中参数的总和,用于评价模型体积的大小;FPS 指模型每秒内推理的图片数量,用于评估模型的整体效率。

本小节使用不同模型效率评价指标对RGDET-Ship 检测模型进行了详细的分析,如表7 所示。CRTransSar[7]和PVT-SAR[8]作为改进的二阶段检测算法在整体检测精度上有所提升(见表1),但其模型Params 明显增大并且模型FPS 也大幅降低。作为一阶段算法拥有快速检测的显著优点,FASC-Net[6]在小目标检测上有突出表现但大目标检测精度较低(见表1)。在各目标检测模型性能对比下,由FPS 指标可看出模型的FPS 控制较好,由Params可知模型的大小略高,Memory 体现出模型对存储单元的带宽需求正常。

综上所述,RGDET-Ship 与其他检测算法相比各项指标均在可行范围之内,在保持小目标检测效率的同时增大了中大目标的检测准确率,并且模型的推理性能和模型大小并未存在较大消耗。

3. 6 定量分析

为了评估RGDET-Ship 模型在实际应用中的表现,本文使用HRSID 数据集进行定量分析。该数据集包含了在真实云雾、阴雨、建筑干扰以及SAR 拍摄尺度不同等多场景下的船舶特征。所有检测模型均使用SSDD 数据集的预训练权重对HRSID 数据集进行训练。定量结果如表8 所示,可以看出本文的RGDET-Ship 模型以显著的优势胜于其余方法。

4 结束语

本文所提出的方法用于对海上船舶进行检测和定位。作为一项以船只为中心的检测任务,研究成果可用于海上民生安全以及禁航区域的船舶监测等领域。同时认为使用RGDET-Ship 模型进行SAR 图像海上船舶检测任务是更合理的,因为在实际应用中会由于SAR 拍摄的距离和环境不同而导致船舶尺寸和噪声等因素变化较大,使用RGDET-Ship 不仅增强了船舶的特征提取,同时细化了检测粒度,即保证了有较高小目标检测准确率、增大了大目标检测的准确率。在基准数据集上的实验验证了模型具有强大的性能,证明了RGDET-Ship 模型在海洋观测和救灾中可以发挥有效作用。下一步工作将针对多尺度复杂环境中的船舶航行进行视频多帧分析检测。

参考文献

[1] 方小宇,黄丽佳. 基于全局位置信息和残差特征融合的SAR 船舶检测算法[J / OL]. 系统工程与电子技术:1-13[2023-08-26]. http:∥kns. cnki. net / kcms / detail /11. 2422. TN. 20230411. 1715. 004. html.

[2] 徐志京,谢安东. 基于细节增强的级联多分类光电船舶检测[J]. 光电子·激光,2023,34(3):241-249.

[3] 张阳,刘小芳,周鹏成. 改进Faster RCNN 的SAR 图像船舶检测技术[J]. 无线电工程,2022,52 (12 ):2280-2287.

[4] 李佳东,张丹普,范亚琼,等. 基于改进YOLOv5 的轻量级船舶目标检测算法[J]. 计算机应用,2023,43(3):923-929.

[5] ZHAO W X,SYAFRUDIN M,FITRIYANI N L. CRASYOLO:A Novel Multicategory Vessel Detection and Classification Model Based on YOLOv5s Algorithm [J ].IEEE Access,2023,11:11463-11478.

[6] YU J M,ZHOU G Y,ZHOU S B,et al. A Fast and Lightweight Detection Network for Multiscale SAR Ship Detection Under Complex Backgrounds [J]. Remote Sensing,2022,14(1):31.

[7] XIA R F,CHEN J,HUANG Z X,et al. CRTransSar:AVisual Transformer Based on Contextual Joint Representation Learning for SAR Ship Detection [J]. Remote Sensing,2022,14(6):1488.

[8] ZHOU Y,JIANG X,XU G Z,et al. PVTSAR:An Arbitrarily Oriented SAR Ship Detector with Pyramid VisionTransformer [J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing,2023,16:291-305.

[9] ZHANG T W,ZHANG X L,LI J W,et al. SAR Ship DetectionDataset (SSDD):Official Release and Comprehensive DataAnalysis [J]. Remote Sensing,2021,13(18):3690.

[10]WEI S J,ZENG X F,QU Q Z,et al. HRSID:A HighresolutionSAR Images Dataset for Ship Detection and Instance Segmentation [J]. IEEE Access,2020,8:120234-120254.

[11] ZHANG T W,ZHANG X L,SHI J,et al. Depthwise Separable Convolution Neural Network for Highspeed SARShip Detection [J]. Remote Sensing,2019,11(21):2483.

[12] SUN Z Z,DAI M C,LENG X G,et al. An AnchorfreeDetection Method for Ship Targets in Highresolution SARImages [J]. IEEE Journal of Selected Topics in AppliedEarth Observations and Remote Sensing,2021,14:7799-7816.

[13] VU T,JANG H,PHAM T X,et al. Cascade RPN:Delvinginto Highquality Region Proposal Network with AdaptiveConvolution[C]∥ Proceedings of the 33rd InternationalConference on Neural Information Processing Systems.Vancouver:Curran Associates Inc. ,2019:1432-1442.

[14] HE K,ZHANG X Y,REN S Q,et al. Deep ResidualLearning for Image Recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. LasVegas:IEEE,2016:770-778.

[15] LIN T Y,DOLL?R P,GIRSHICK R,et al. Feature Pyramid Networks for Object Detection[C]∥ Proceedings ofthe IEEE Conference on Computer Vision and PatternRecognition. Honolulu:IEEE,2017:936-944.

[16] RADOSAVOVIC I,KOSARAJU R P,GIRSHICK R,et al.Designing Network Design Spaces [C]∥ Proceedings ofthe IEEE / CVF Conference on Computer Vision andPattern Recognition. Seattle:IEEE,2020:10425-10433

[17] REN S Q,HE K,GIRSHICK R,et al. Faster RCNN:Towards Realtime Object Detection with Region ProposalNetworks[J]. IEEE Transactions on Pattern Analysis andMachine Intelligence,2017,39(6):1137-1149.

[18] TIAN Z,SHEN C H,CHEN H,et al. FCOS:Fully Convolutional Onestage Object Detection[C]∥2019 IEEE / CVFInternational Conference on Computer Vision. Seoul:IEEE,2019:9626-9635.

[19] LAW H,DENG J. CornerNet:Detecting Objects as PairedKeypoints[C]∥Proceedings of the European Conference onComputer Vision (ECCV). Munich:Springer,2018:765-781.

[20] CAI Z W,VASCONCELOS N. Cascade RCNN:HighQuality Object Detection and Instance Segmentation [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2021,43(5):1483-1498.

[21] FENG Y,CHEN J,HUANG Z X,et al. A Lightweight Positionenhanced Anchorfree Algorithm for SAR Ship Detection [J]. Remote Sensing,2022,14(8):1908.

[22] LIU W,ANGUELOV D,ERHAN D,et al. SSD:SingleShot Multibox Detector [C ]∥ Computer VisionECCV2016:14th European Conference. Amsterdam:Springer,2016:21-37.

[23]YU L,WU H Y,ZHONG Z,et al. TWCNet:A SAR Ship Detection Using Twoway Convolution and Multiscale FeatureMapping [J]. Remote Sensing,2021,13(13):2558.

[24] BAI L,YAO C,YE Z,et al. Feature EnhancementPyramid and Shallow Feature Reconstruction Network forSAR Ship Detection [J ]. IEEE Journal of SelectedTopics in Applied Earth Observations and RemoteSensing,2023,16:1042-1056.

[25] WANG J Q,CHEN K,XU R,et al. CARAFE:Contentaware Reassembly of Features[C]∥2019 IEEE / CVF International Conference on Computer Vision. Seoul:IEEE,2019:3007-3016.

[26] GE Z,LIU S T,WANG F,et al. Yolox:Exceeding YOLOSeries in 2021[EB / OL]. (2021-07-18)[2023-09-01]https:∥arxiv. org / abs / 2107. 08430.

[27] WANG J Q,CHEN K,YANG S,et al. Region Proposal byGuided Anchoring[C]∥2019 IEEE / CVF Conference onComputer Vision and Pattern Recognition. Long Beach:IEEE,2019:2960-2969.

作者简介

郑莉萍 女,(1998—),硕士研究生。主要研究方向:目标检测和深度学习。

(*通信作者)赵良军 男,(1980—),博士,副教授,高级工程师,硕士生导师。主要研究方向:卫星遥感、深度学习和图像处理。

宁 峰 男,(2000—),硕士研究生。主要研究方向:目标检测和深度学习。

谭 亮 男,(1996—),硕士研究生。主要研究方向:计算机视觉和图像分割。

肖 波 男,(1997—),硕士研究生。主要研究方向:遥感技术和目标检测。

胡月明 男,(1964—),博士,教授。主要研究方向:耕地质量监测评价与土地大数据融合应用。

何中良 男,(1995—),硕士研究生。主要研究方向:遥感技术和深度学习。

席裕斌 男,(1999—),硕士研究生。主要研究方向:目标检测和遥感技术。

梁 刚 男,(1999—),硕士研究生。主要研究方向:计算机视觉和图像处理。

基金项目:四川省科技计划项目(2023YFS0371);四川省智慧旅游研究基地项目(ZHZJ22-03)