基于人物交互的学生课堂行为识别研究

周珍玉 秦学 蔡芳 邓霞

摘要:深度学习技术促进了学生课堂行为识别研究的发展,为精准刻画学生的课堂学习行为提供了有效途径。然而,该方法面临真实课堂场景下目标多、行为特征复杂等困难,导致行为识别准确率不高。基于此,文章提出了一种基于人物交互的学生课堂行为识别网络,将交互对象作为重要特征引入课堂行为识别,首先将原网络中的检测模块替换为YOLOv5s,然后引入欧氏距离减少冗余人-物节点关系,并设计新特征提取算法优化听课这类无交互物品的学生行为识别,最后通过实验验证了此网络有效性和准确性。文章通过研究,旨在为规模化课堂行为识别研究提供理论参考和实践借鉴,进一步优化课堂教学效果的过程化评价,促进教学质量提升。

关键词:目标检测;学生行为识别;人物交互;图卷积

【中图分类号】G40-057 【文献标识码】A 【论文编号】1009—8097(2024)02—0053—09 【DOI】10.3969/j.issn.1009-8097.2024.02.006

课堂教学一直是教育研究的重点,对学生在课堂上的行为进行观察识别及分析,能够帮助教师精准掌握其整体学习状态,从而提供有效干预和指导,改善学习效果,推动教学高质量发展。在课堂教学中,学生作为学习活动的主体,其课堂行为不仅与自身的学习成效密切相关,也是反映教师教学质量的重要参照。传统的课堂行为识别主要通过人工方式开展,耗时且效率低[1],而随着计算机视觉技术的发展,深度学习网络凭借其能够有效提取课堂视频中的复杂特征,以及自动识别学生行为动作的优势,为课堂行为识别提供了一种高效的方案。目前,基于深度学习的学生课堂行为识别处于前期研究阶段,主要研究方法是通过面部表情、人体骨架及头部和姿态估计来识别学生的课堂行为,这种方法虽然能识别学生行为,但缺点是对学生与周围物品的交互关注不够。而在真实的教室环境下,很多课堂行为还包含学生和周围物品的交互,如看书、书写、玩手机等,分析学生与周围物品的交互关系,能够为课堂行为识别提供更多有用的信息,有助于提升课堂行为识别的准确性。人物交互(Human-Object Interaction,HOI)检测作为视觉关系中的子任务,旨在将场景中的对象与各种语义角色相关联,从而更精细地了解当前的活动状态[2],利用HOI技术分析人-物间的交互关系,能为行为识别提供更多有效信息。由此,本研究参考当前基于深度学习的课堂行为识别方法,引入人物交互技术,以看书、玩手机、听课、书写四种典型行为为例,分析学生与其周围物品之间的交互关系,以期提升课堂行为识别的准确性,更好地帮助教师掌握学生的学习状态,并进行精准的学习指导或干预,同时为智慧课堂的实施提供参考。

一 文献综述

当前,采用深度学习技术对教室监控视频进行分析,以识别学生的课堂学习行为已成为新的研究热点,并取得了一定的研究成果。例如,Li等[3]基于ESRGAN检测网络对课堂监控视频进行处理,采用YOLOv5s识别出课堂监控图像中学生玩手机、上课、睡觉等行为;Cao等[4]提出了基于MobileNetV2的改进轻量级网络,采用C-反相残差块代替传统模块,提高了网络的识别精度,同时识别出学生睡觉、书写等课堂行为;Liu等[5]通过对YOLOv5s网络中的BN层进行校正,增强了网络的特征提取能力,有效识别出学生书写、吃东西、听课等行为;王泽杰等[6]则结合学生的人体骨架信息特征,识别学生玩手机、起立等典型的课堂行为。这些基于深度学习的学生行为研究方法,通常是直接提取图像中学生的特征信息来进行行为分类,对特定实验环境下典型课堂行为的识别效果较为理想,但实际教室场景普遍会受一些客观因素的影响,包括学生远近不一、动作较相似、存在遮挡等,这些客观因素是通用教室监控视频场景下进行行为识别的难点和挑战。

大量研究表明,识别一个人的动作行为,不仅要检测单个目标对象,还需要识别其与周围物品的交互活动[7]。近年,部分研究人员致力于视觉关系检测的研究,并取得了重大进展[8],发现相比于目标检测、图像分割、动作识别等传统机器视觉任务,视觉关系检测更关注对象对之间的语义关系。2015年,Chao等[9]提出用于人物交互的大型数据集HICO,使HOI检测这一技术取得了重大发展。HOI检测主要分为单阶段和双阶段两条技术路线:①单阶段的HOI检测直接检测图片中的交互行为,但其针对多目标识别时准确率较低。②双阶段的HOI检测主要分为基于多流分支和基于图卷积神经网络两大研究方向,其中基于多流分支的检测方法将特征提取、空间关系等分支网络结合构成多流分支。例如,Kolesnikov等[10]提出BAR-CNN网络,借助链式规则分解概率网络,对人与物的空间位置关系进行编码;Wang等[11]提出的IPNet网络用于预测人-物的交互点,并进行交互关系定位和分类。上述研究方法主要通过提取人与物的外观特征和空间关系来推理交互关系,但对上下文特征缺乏重视,识别精度还有较大的提升潜力。鉴于此,Wang等[12]提出DCANet网络,将全局上下文特征整合到人物交互检测中,使网络检测的准确性得到了提升。基于图卷积神经网络的检测方法为人物交互检测提供了新的思路,该方法将图神经网络应用于HOI检测,将人物间的交互关系构建成解析图,并利用图神经网络捕获更多上下文特征。借鉴该思想,Gao等[13]提出DRG网络,利用抽象的空间语义来描述每一组人与物,并通过双重关系图聚合场景中的上下文信息。Ulutan等[14]提出的可视空间图网络(Visual-Spatial-Graph Network,VSGNet)通过构建人-物之间的交互关系图,较好地表征了空间关系特征,对人-物交互识别精度有显著提升。考虑到双阶段VSGNet网络在识别精度及表征人-物空间关系等方面的优势,本研究以VSGNet为基础,提出基于人物交互的学生课堂行为识别网络,优化和改进目标检测模块、人物交互關系构建等环节,从而实现课堂行为识别。

二 基于人物交互的学生课堂行为识别网络设计与优化

VSGNet网络由检测和识别两阶段构成,检测网络采用Faster R-CNN检测图像中的目标,识别网络则通过提取人-物对的视觉特征及空间配置信息,利用图卷积来分析配对之间的结构连接,进而分析、识别人-物交互关系。本研究以VSGNet网络作为基线,设计了基于人物交互的学生课堂行为识别网络。同时,考虑到人物交互检测方法在课堂行为识别中存在一些典型问题,如对笔、手机等小目标和多目标的漏检和误检,对不存在交互物品行为的识别误差等,本研究将原VSGNet的Faster R-CNN检测模块替换为YOLOv5s,并重新设计距离计算方法以减少无效的候选人-物交互关系,然后针对无交互物品行为识别需要改进视觉特征提取算法。

1 目标检测网络优化

YOLOv5s是由Ultralytics团队提出的一种单阶段网络,与双阶段的Faster R-CNN网络相比,其检测速度更快[15]。此外,在检测小目标时,YOLOv5s的检测精度也超越了Faster R-CNN[16]。在本研究中,第一阶段检测网络的输出作为第二阶段输入,检测阶段网络的准确性是正确识别学生行为的基础和关键所在。因此,本研究尝试将YOLOv5s网络应用到教室场景,替换原VSGNet中的Faster R-CNN。

2 基于欧氏距离的交互关系筛选

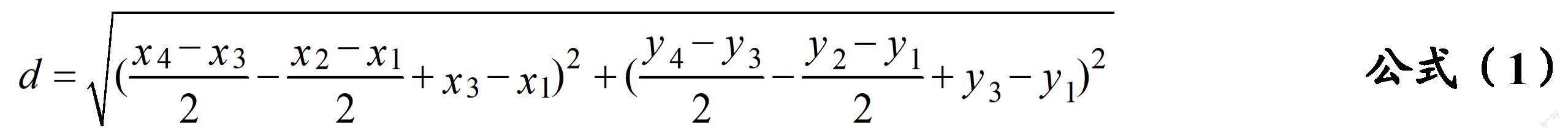

教室场景下识别的学生课堂行为通常只与学生周围的物品有关。如果以学生节点为中心,连接图片中的所有物品节点,会导致节点间连接数量急剧上升,节点数增多,削弱与学生节点真正有关系的物品节点的重要程度,进而影响交互关系的判断,不利于学生行为的识别。鉴于此,本研究利用欧氏距离对学生节点与物品节点之间的距离进行筛选和优化:取学生检测框和物品检测框的中心点作为端点,通过计算两个端点之间的欧氏距离,缩小物品节点的选择范围。计算过程如下:假设学生检测框坐标为(x1, y1, x2, y2),物品检测框坐标为(x3, y3, x4, y4),那么学生与物品间的欧氏距离计算如公式(1)所示。

通过对视频的统计和分析,输入图片中学生与桌面物品的欧氏距离与输入图片的高(H)的比值小于0.15。因此,将两个检测框中心点距离与H比值的阈值设定为0.15,舍弃比值超过0.15的物品节点。图卷积分支可视化如图1所示,图中最大长方形表示整张图片,中等长方形表示人的检测框,小长方形表示物的检测框,人与物检测框间的直线表示交互关系。其中,图1(a)表示原图卷积分支,图1(b)表示改进后的图卷积分支。通过对比图1(a)和图1(b)可以发现,图1(b)删除了大量无效边,能显著提升人与真实存在交互关系物品的重要程度,从而提升行为识别准确率。

3 无交互物品行为特征融合算法设计

原VSGNet网络使用图卷积网络来学习学生与周围物品之间的交互关系,但视频中“听课”这一动作类别不存在交互物品,这导致网络对该动作的识别不够稳定。针对这一不足,本研究在原网络中增加了一个无交互物品的行为识别模块,通过视觉分支获取学生检测框中的特征向量和整张图片中的上下文特征向量。但是原VSGNet视觉分支在提取无交互物的学生特征时存在两个问题:因池化操作会造成部分特征信息丢失;采用的小卷积核对尺度较大的人物目标识别效果欠佳。鉴于此,本研究提出一个基于上下文的残差模块(记为CM_Resnet),由一个可分离大核卷积和一个残差模块串联而成,在不显著增加网络复杂度的前提下捕获更丰富的特征。

基于以上分析,本研究得到无交互物品的学生行为特征提取网络,其结构如图 2 所示。该 结构使用 YOLOv5s 网络检测出“学生”这一目标,并将对应的检测框及相关信息输入该网络, 经过 ROI+Residual 操作后引入基于上下文的 CM_Resnet 模块,接下来经过 GAP 处理,得到框 中强化后的学生目标的特征向量 以及整张图片的特征向量,即上下文特征向量 。最后,将 、 相乘可得到该动作类别概率 。

综上所述,基于人物交互的学生课堂行为识别网络结构如图3所示。首先,对教室监控视频进行数据预处理,采用YOLOv5s网络检测出教室内学生、手机、书本、笔四种目标;然后将检测结果以形如<学生,动作,物品>的三元组形式输入识别网络。识别网络主要包括视觉、空间注意和图卷积三个分支。视觉分支使用区域池化ROI提取特征,再经残差块Residual、全局平均池化GAP处理,输出人、物的视觉特征向量。将上述特征向量连接并通过全连接层进行投影,最后得到人-物对的视觉特征向量![]() ,其计算如公式(2)所示。其中,Wvis表示投影矩阵,fh、fo、fc分别表示人、物、上下文背景的视觉特征向量。

,其计算如公式(2)所示。其中,Wvis表示投影矩阵,fh、fo、fc分别表示人、物、上下文背景的视觉特征向量。

空间注意分支利用人和物检测框的位置信息,生成人-物对的空间关系特征向量aho。将aho与视觉特征向量拼接得到![]() ,其計算如公式(3)所示。

,其計算如公式(3)所示。![]() 经投影矩阵变换再由Sigmoid函数作用得到人-物对的交互得分iho以及动作类别概率

经投影矩阵变换再由Sigmoid函数作用得到人-物对的交互得分iho以及动作类别概率![]() 。由于aho编码了空间配置,因此aho也可用于辅助HOI分类,aho经投影矩阵变换得到动作类别概率

。由于aho编码了空间配置,因此aho也可用于辅助HOI分类,aho经投影矩阵变换得到动作类别概率![]() 。

。

图卷积分支利用图卷积神经网络将人与物关系表征为图结构,通过遍历和更新图中的节点,提取节点间交互关系的特征,可得图卷积分支分类预测概率![]() 。最后,将三个分支的概率相乘,计算出最终预测的动作类别概率Ρho,其计算如公式(4)所示。

。最后,将三个分支的概率相乘,计算出最终预测的动作类别概率Ρho,其计算如公式(4)所示。

三 教室监控视频场景下学生课堂行为识别的实验与分析

1 实验对象与环境

由于目前还没有公开的真实教室场景下的学生行为数据集,因此本研究基于真实教室场景下的监控视频进行数据集制作。课堂监控视频来自研究团队承担课程的5个教室场景,分别是贵州省A大学的大数据专业2019级和2020级共两个年级的4个教学班级、信管专业2021级的1个教学班级。实验硬件环境为:CPU采用Intel(R)Core(TM)i7-10700KF,GPU采用NVIDIA GeForce RTX 2060。软件环境为:操作系统采用Win10,Python版本为3.8.13,深度学习框架采用PyTorch 1.8.0。

2 数据集构建

该数据集来源于真实教学场景下的课堂监控视频,本研究通过分析监控视频,发现学生上课时的行为在连续时间内变化幅度较小,故以50帧一张的间隔抽取图片,图片的分辨率为1920×1080。本研究选取了5个不同教室的监控视频进行图片抽取,每张图片包含10~15位学生,共计1963张图片,学生实例16685个。本研究将得到的数据集分为训练集和测试集两部分,同时按照4:1的比例划分,即训练集1571张,测试集392张。通过分析目前现有的数据集,发现学生课堂行为主要集中在Look(看书)、Play(玩手机)、Listen(听课)、Write(书写),因此本研究主要这四种学生课堂行为进行研究。

3 实验流程

本研究的实验分为三个步骤:①分析课堂监控视频抽取图像帧,确定典型课堂行为,并完成行为标注。②将实验数据集分为训练集和测试集两部分,同时按照4:1的比例划分。③基于构建的数据集,对本研究提出的基于人物交互的学生课堂行为识别网络(记为Our_method)进行训练,依次验证其整体性能及各优化改进模块的有效性。

4 实验结果与分析

为验证基于人物交互的学生课堂行为识别网络及其优化方案的可行性和有效性,本研究根据实验流程展开多项验证、消融和对比实验。评价依据采用深度学习领域常用的关键性能指标:平均精度(mean Average Precisio,mAP)、精确率(Precision,P)、召回率(Recall,R)。

(1)基于人物交互的学生课堂行为识别网络整体性能分析

基于构建的真实课堂场景学生行为数据集,各动作类别的平均准确率实验结果如表1所示。从表1可以看出,Look、Play、Write三种课堂行为的精度均有提升(分别提升了2.56%、3.49%、2.55%),验证了本研究对原网络中图卷积分支的物节点设置阈值进行筛选可提高网络识别性能的结论。此外,改进后的网络能识别出学生“听课”这一课堂行为,证明了本研究对不存在交互物品的“听课”动作进行重新规划并计算其动作类别概率具有理论可行性。从实验结果可得出,本研究改进方案是可行的,且达到了预期识别效果。

图4则更为直观地展示了该网络的识别结果,可以看出,改进后的网络能较准确地识别学生Look、Write、Play三种课堂行为。最后一幅图片显示,网络也能成功识别“Listen”行为。

(2)改进目标检测网络的验证结果分析

依据本研究的设计,将原网络中的Faster R-CNN替换为YOLOv5s后,实验结果如表2所示。表中的mAP、P、R分别提升了3.54%、2.6%、4.9%,平均检测速度更是快了近2.93倍。可见,针对实际教室场景中的多目标检测更宜采用YOLOv5s网络,其检测效果如图5所示。

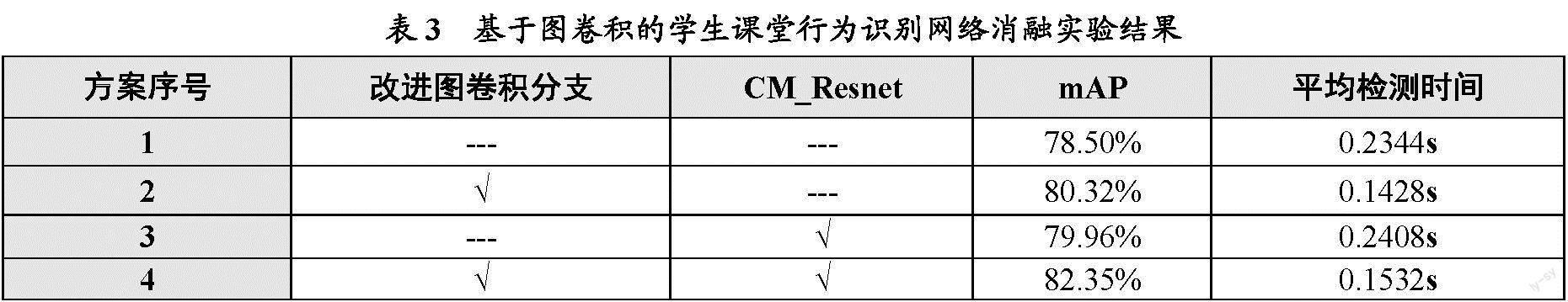

(3)图卷积改进模块消融实验分析

为进一步分析识别阶段的两处优化对行为识别网络的性能提升,本研究设计了相应的消融实验,其结果如表3所示。实验数据表明,本研究提出的课堂行为识别网络的识别精度明显提升,其中mAP提升了3.85%,平均检测时间下降了34.6%。在方案2中,缩短了物节点遍历范围后,平均检测时间明显缩短,提升了约1.53倍。从方案3的实验结果可以看出,引入CM_Resnet模块后,平均检测时间增加了0.0064s,仅增加了2.73%,而精度提升了1.46%,进一步说明了CM_Resnet模块能提取到更加丰富的特征,验证了引入该模块的理论可行性。

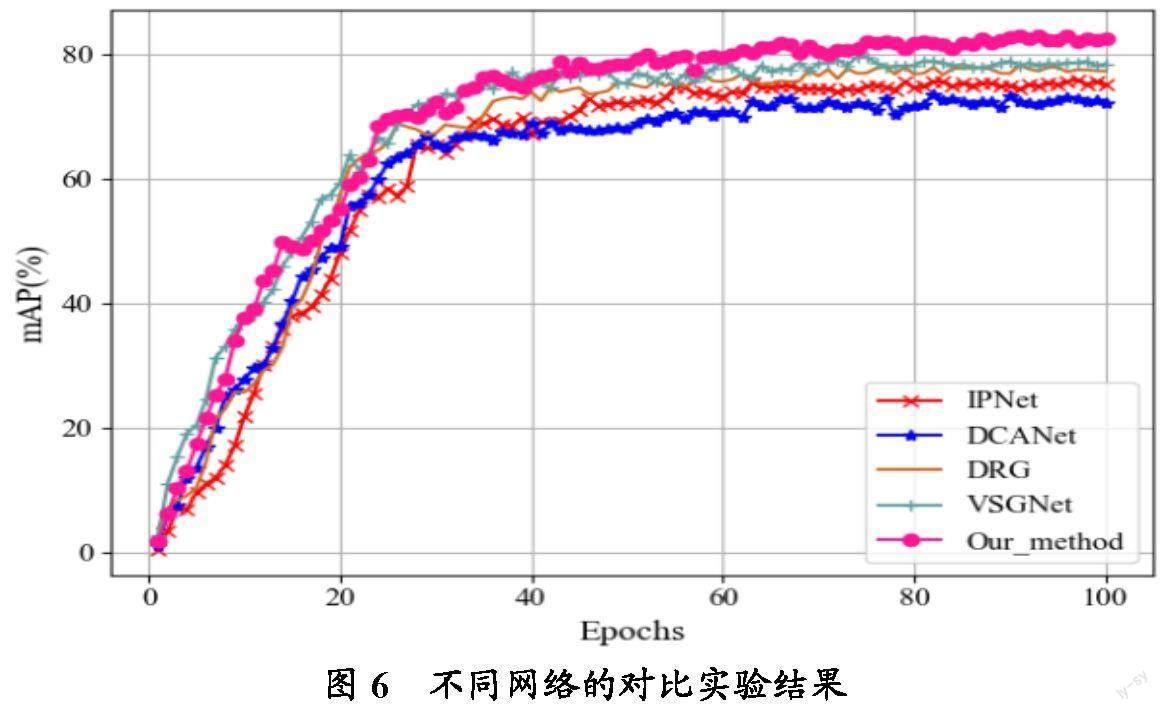

(4)不同网络性能的对比实验

为验证本研究提出的整體改进网络的可行性和通用性,本研究将整体改进后网络与主流的DCANet、DRG、IPNet等人物交互识别网络在教室监控视频数据集上进行对比实验,实验结果如图6所示。从图6可知,DCANet网络的识别表现较差,这是由于其对图片中的目标特征提取不充分导致的;IPNet网络主要通过计算人与物的检测框之间的交互向量对行为进行分类,但将其应用于教室场景时,由于教室内目标与目标之间的间距较小,容易误判;DRG网络识别结果仅次于基线网络VSGNet,与VSGNet不同的是,DRG只利用图网络,将人与物关系表示为对偶关系图,导致图中关系很密集,并且没有考虑到人与物之间的空间关系。

此外,在本研究提出的网络训练前期即前40次迭代中,mAP没有其他网络高,这是因为网络训练前期学习到的特征还不充分,而经过40次迭代后,Our_method学习到足够多的特征,mAP开始逐步提升并优于其他网络。可见,Our_method更适合用于教室场景下的学生课堂行为识别任务。

四 结语

本研究通过分析学生与周围物品的交互关系,提出了一种基于人物交互的学生课堂行为识别网络,利用学生与周围物品的交互关系,重点对学生的四种典型课堂行为进行了识别,并经实验验证了本研究的有效性和可行性。但与此同时,本研究也还存在一些不足:①在学生课堂行为识别网络的检测阶段,仍存在目标对象漏检问题;②由于摄像头位于教室前侧方位,所拍摄的监控视频存在较小的角度偏移,不利于特征提取,因此影响了目标检测精度和人物关系筛选。后续研究将继续改进检测网络,减少小目标物品的漏检误检;扩充数据集,增加课堂场景及行为的多样性,进一步提升网络识别行为的准确率和实用性,以更好地推动规模化课堂行为分析,促进课堂教学改革与优化。

参考文献

[1]徐家臻,邓伟,魏艳涛.基于人体骨架信息提取的学生课堂行为自动识别[J].现代教育技术,2020,(5):108-113.

[2]Gao C, Zou Y, Huang J B. iCAN: Instance-centric attention network for human-object interaction detection[OL].

[3]Li L, Liu M, Sun L, et al. ET-YOLOv5s: Toward deep identification of students in-class behaviors[J]. IEEE ACCESS, 2022,10:44200-44211.

[4]Cao D, Liu J, Hao L, et al. Recognition of studentss behavior states in classroom based on improved mobile netV2 algorithm[J]. International Journal of Electrical Engineering & Education, 2023,60:2379-2396.

[5]Liu S, Zhang J, Su W. An improved method of identifying learners behaviors based on deep learning[J]. The Journal of Supercomputing, 2022,(10):12861-12872.

[6]王澤杰,沈超敏,赵春,等.融合人体姿态估计和目标检测的学生课堂行为识别[J].华东师范大学学报(自然科学版),2022,(2):55-66.

[7]Siadari T S, Han M, Yoon H. Three-stream network with context convolution module for human-object interaction detection[J]. ETRI Journal, 2020,(2):230-238.

[8]Yu D, Xu Z, Fujita H. Bibliometric analysis on the evolution of applied intelligence[J]. Applied Intelligence, 2019,(2):449-462.

[9]Chao Y W, Wang Z, He Y, et al. HICO: A benchmark for recognizing human-object interactions in images[A]. 2015 IEEE International Conference on Computer Vision (ICCV)[C]. Santiago, Chile: IEEE, 2015:1017-1025.

[10]Kolesnikov A, Kuznetsova A, Lampert C, et al. Detecting visual relationships using box attention[A]. 2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW)[C]. Seoul, Korea (South): IEEE, 2019:1749-1753.

[11]Wang T, Yang T, Danelljan M, et al. Learning human-object interaction detection using interaction points[A]. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)[C]. Seattle, WA, USA: IEEE, 2020:4115-4124.

[12]Wang T C, Anwer R M, Khan M H, et al. Deep contextual attention for human-object interaction detection[A]. 2019 IEEE/CVF International Conference on Computer Vision (ICCV)[C]. Seoul, Korea (South): IEEE, 2019:5693-5701.

[13]Gao C, Xu J, Zou Y, et al. DRG: Dual relation graph for human-object interaction detection[A]. ECCV 2020: Computer Vision - ECCV 2020[C]. Cham: Springer, 2020:696-712.

[14]Ulutan O, Iftekhar A, Manjunath B S. VSGNet: Spatial attention network for detecting human object interactions using graph convolutions[A]. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)[C]. Seattle, WA, USA: IEEE, 2020:13614-13623.

[15]Li M L, Sun G B, Yu J X. A pedestrian detection network model based on improved YOLOv5[J]. Entropy, 2023,(2):381.

[16]楊睿宁,惠飞,金鑫,等.改进YOLOv5s的复杂交通场景路侧目标检测算法[J].计算机工程与应用,2023,(16):159-169.

Research on Classroom Behavior Recognition of Students Based on Human-object Interaction

Abstract: Deep learning technology promotes the development of research on students classroom behavior recognition, which provides an effective approach to accurately depict students classroom learning behaviors. However, the method faces many difficulties in real classroom scenarios, such as multiple targets and complex behavior characteristics, resulting in low accuracy of behavior recognition. Based on this, this paper proposed a classroom behavior recognition network for students based on human-object interaction, which incorporated interactive objects as key features into classroom behavior recognition. Firstly, the detection module in the original network was substituted with YOLOv5s. Secondly, the Euclidean distance was employed to reduce redundant human-object node relationships. Meanwhile, a new feature extraction algorithm was designed to optimize such behavior recognition of students listening without interactive objects. Finally, the effectiveness and accuracy of this model were verified through experiments. Through research, this paper was expected to provide theoretical reference and practical experience for the research on large-scale classroom behavior recognition, and further optimize the procedural evaluation of classroom teaching effects, therefore promoting the improvement of teaching quality.

Keywords: object detection; students behavior recognition; human-object interaction; graph convolutional