车载激光雷达与摄像头数据融合的智能车辆环境感知技术

吴学舟 李岳松

摘要:近年来人工智能技术快速发展,其中以深度学习为代表的技术极大提升了图像识别精确度,降低了目标识别成本,同时带动了智能车辆普及。使用传统单一的激光雷达、车载摄像头等传感器采集车辆周围环境数据时会出现因传感器自身劣势特性,导致车辆在复杂天气、道路等环境中容易出现数据采集不全、不准,从而影响车辆最终的决策判断和出现车辆行驶安全隐患。本文研究了使用单一激光雷达、车载摄像头传感器的识别系统工作原理与存在的识别问题,提出激光雷达与摄像头数据融合的智能车辆环境感知模式,提升智能车辆环境识别的精确度。

关键词:车辆环境感知;传感器融合技术;人工智能;数据层;特征层;决策层

中图分类号: TP274 文献标识码:A

0 引言

2020 年11 月,国务院办公厅印发《新能源汽车产业发展规划(2021―2035 年)》,提出了智能汽车的发展方针,对提升汽车智能化水平,推动汽车与交通、信息通信等融合发展作了相关部署[1]。因此,智能化汽车、智能交通是汽车行业未来发展的重要方向。智能汽车就是通过搭载各类传感器等装置,运用人工智能、通信网络等技术,从而使汽车具有环境感知、决策判断和车辆控制三项主要技术功能[2]。

车辆环境感知技术可以准确收集道路车辆、行人和交通标志等车辆周围信息,充当着智能汽车的眼睛,能用数字化的方式观察汽车周围道路情况。目前主流的汽车环境感知方式采用各类传感器提取道路信息,如车载摄像头、激光雷达和毫米波雷达等。智能汽车还要对各类传感器采集到的数据进行多次加工处理,如完成图像处理、目标识别、距离判断和路径规划等,让智能汽车自动、实时地计算车辆路径,降低驾驶员疲劳度,减少车辆安全隐患。车辆控制技术主要是按照决策判断的指令操作车辆起停、转向等,最终实现车辆自动驾驶、环境避障功能。

车辆环境感知技术作为智能汽车重要的组成部分,通过采集实时且精准的道路环境信息,为车辆决策判断提供支撑。车辆周围环境信息采集后,需要对传感器原始数据去噪、校正和融合,最后运用基于GPU 架构的深度学习技术[3],完成对周围目标的检测。本文通过对单一的车载传感器识别方式进行研究,提出了基于激光雷达与摄像头数据融合的技术模式,最后对基于车载激光雷达与摄像头融合技术进行总结。

1 基于激光雷达三维环境感知技术

车载激光雷达是扫描车辆周围环境主要传感器设备之一,主要由發射器、接收器和信息处理器组成。激光雷达工作时,通过激光器发射出脉冲激光,接收器接收车辆周围的地面、树木和行人等散射信号,最后信息处理器处理接收到的数据,最终得到周围环境三维立体图像(图1)。但是激光雷达受环境影响较大,如大雨、浓烟等环境都会影响获取数据。基于激光雷达环境感知技术是通过激光雷达传感器获取车辆周围物体点云三维形状,从而进行目标检测。激光雷达主要目标检测算法包括基于传统的目标检测和基于深度学习的目标检测。

1.1 基于传统激光雷达目标检测

传统激光雷达系统的目标检测是由数据预处理、提取特征和目标分类三个部分组成。首先,激光雷达传感器采集环境点云数据,但在采集中会存在如浮尘等噪声,因此需要通过数据预处理技术降低噪声干扰,减少干扰数据。其次,使用提取特征技术对点云特征进行提取。最后将具有相同特征点云聚类一起,完成目标检测。

1.2 基于深度学习的激光雷达目标检测

近年来,深度学习技术在目标检测领域中大受青睐,尤其以卷积神经网络为代表的技术,在交通检测[4]、医院检测等领域具有重要应用价值。基于深度学习的激光雷达目标检测主要包括二维投影点云检测、点云体素化检测和点的目标检测。二维投影点云检测主要把激光雷达采集到的三维数据信息投影为二维平面,然后再使用卷积神经网络完成环境检测。该方法需要把三维数据转化为二维数据,因此缺少环境深度等数据。点云体素化是通过将点云网格进行素华,然后使用3D 卷积神经网络进行目标检测。点的目标检测是直接对点云进行3D 卷积神经网络目标检测,提取出目标特征信息。

基于激光雷达的环境感知技术能扫描车辆周围环境信息并转化为三维空间点云数据,但激光雷达无法获取环境纹理等特征信息,对交通信号灯也无法有效检测。因此,该技术目前还无法单独应用于车辆环境感知中。

2 基于摄像头二维图像环境感知技术

车载摄像头由若干个凸透镜组合而成,采用小孔成像原理把环境物体经透镜投影到相机的感光平面上,得到车辆环境RGB 二维图片。常见车载摄像头包括针孔模型、透视模型和鱼眼模型等。

2.1 基于摄像头的传统机器视觉的目标检测

传统的目标检测由获取目标、特征提取和目标分类三部分组成。获取目标主要使用滑动窗口法和纹理特征法选取目标区域。特征提取是通过对获取到的目标进行分割、灰度变化等操作,提取图像特征信息,最终完成目标检测。传统机器视觉目标检测方法要求特征提取员具有较高的专业领域知识,同时特征提取要进行大量的手工操作,否则缺乏泛化能力。

2.2 基于深度学习的摄像头目标检测

卷积神经网络模型是深度学习技术重要的应用,能自动提取特征信息,提高目标检测精度。Krizhevsky 等人提出的AlexNet网络模型完全超越传统机器视觉的目标检测[5],促使智能汽车从传统的环境识别转变为基于深度学习技术的识别方式。基于深度学习的摄像头目标检测主要分为单阶段检测和两阶段检测。

单阶段检测取消生成目标候选区过程,直接对图像进行处理,从而提升检测速度。两阶段检测是先获取目标候选区域,再对候选区域进行分类的图像处理。基于摄像头二维图像环境检测能使用较低硬件成本快速获取车辆环境二维平面,但摄像头采集到的数据无法反映环境空间位置信息,同时摄像头采集数据时容易受到环境影响出现识别精度不高等情况。

3 多传感器数据融合模式

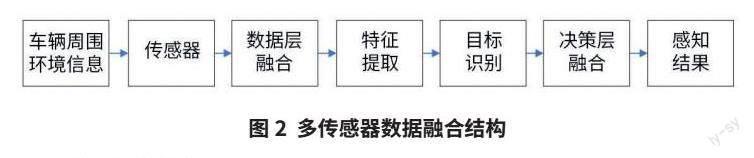

智能汽车环境感知方式如果采用单一的传感器采集数据,容易出现数据准确度不高、受环境干扰大等情况,导致智能汽车在行驶过程中出现决策误判、环境目标信息检测不全等问题,从而降低智能汽车自动驾驶安全性。多传感器融合技术则是将多个不同种类传感器进行协同工作,把多种类传感器实时数据进行融合(图2),提升智能汽车对环境的感知能力和智能化决策能力,有效弥补汽车单一传感器的限制问题,从而增加智能汽车安全、可靠性,降低驾驶人员和道路行人的安全隐患。多传感器融合模式包括数据层融合、特征层融合和决策层融合三个部分。

3.1 数据层融合

车载摄像头能获取到可见光环境数据信息,摄像头相对于激光雷达相比成本较低,是目前应用最广的传感器设备之一。摄像头能应用在智能汽车上实现采集环境信息,如障碍物、道路和交通标志等。摄像头传感器主要获取到环境的二维图像信息,但二维图像无法体现环境的深度和尺寸等信息,因此在要求安全性较高的自动驾驶中还需配合其他传感器共同实现环境监测。车载激光雷达能扫描环境信息并转化为三维点云数据,如障碍物三维信息、道路三维信息等。

数据层融合是把车载激光雷达和摄像头所采集到的原始数据进行融合。数据融合也属于底层融合,需要把不同传感器输出的数据封装为统一数据源,并为后续特征提取作好铺垫。激光雷达和摄像头数据融合需要进行联合标定,通常联合标定包含激光雷达、摄像头、像素和车辆周围环境4 种坐标系。要实现激光雷达与摄像头坐标系融合就需要添加转化参数,从而找到不同种类传感器源数据共有的点、线和面等特征信息。

标定摄像头采用旋转和平移变化方法。假设摄像头图像像素坐标为(x1,y1),激光雷达数据坐标为(x2,y2,z2),k 代表摄像机参数,(r,t)是旋转和平移矩阵,由此可以根据下列公式标定摄像头和激光雷达的数据。

把激光雷达采集到三维数据与摄像头采集的二维数据融合,目前常用的技术有基于标靶、基于无靶、基于运动标定和基于深度学习标定。基于深度学习标定能通过多次训练实现特征提取与特征匹配,其自动化程度高、稳定性好。通过提取摄像头和激光雷达原始数据进行回归计算,就能自动估计变换范围,最终完成数据标定。

3.2 特征层融合

目标检测是近年来人工智能技术领域热门研究方向,对车辆环境目标检测要做到实时、精准,也是智能化汽车环境感知的一个挑战。通常对汽车车载摄像头采集到的道路信息进行检测为二维目标检测,主要包括单阶段检测算法和两阶段检测算法两种。由于要满足智能汽车检测和部署速度,一般采用简短检测算法完成车辆环境目标检测。

车载激光雷达采集的数据进行目标检测属于三维目标检测,三维目标检测能对目标空间、姿态和深度进行检测,从而提升目标检测精准度。激光雷达传感器收集的三维数据主要用于图像的检测和点云与图像融合的检测。三维目标检测技术运用在目标检测、目标跟踪和语义分割等智慧车辆环境感知中。基于点云的目标检测目前主流算法有K-Means 算法、DBSCAN 算法等,能對激光雷达采集到的点云数据进行处理。

特征层融合是对多传感器数据融合后,进行数据特征法的提取,该操作也通常称为中间层融合。特征层数据融合以一个单位特征量的形式输出,相比数据层的数据,特征层把数据融合后还要进行关键特征提取工作。目前特征层融合只对多传感器采集的重点感知数据进行特征提取。

特征层融合内容主要有目标状态数据融合和目标特特征数据融合两大类。其中,目标状态数据融合是把多种类传感器采集到的数据进行数据匹配,找出具有相同或不同特性的数据信息,最后再修改数据关联参数以及数据状态信息,从而实现目标跟踪。目标特征融合是完成数据特征矢量分类的操作,最终实现目标检测。因此特征层的主要功能是对数据层结合后的数据进行加工与提取,为车辆环境目标识别、轨迹计算等提供支撑数据。

3.3 决策层融合

决策层融合是对已完成特征提取的各类传感器数据结果进行融合。通过前2 个步骤,已对各类传感器数据的融合和特征提取,决策层融合与数据层和特征层融合相比,在抗干扰性方面有一定优势,在恶劣环境下的车辆检测周围信息有较强的鲁棒性,提高车辆环境感知能力和精确度。决策层融合会把多个传感器特征结果进行统一融合分析,从而弥补单一传感器的劣势问题(表1)。

决策层能融合多传感器数据并完成目标识别,从而提升智能化汽车在动态环境中的安全能力。而基于深度学习的目标检测可以高效检测汽车环境信息、道路信息和交通标准信息,提升检测的精准度。目标常用的深度学习技术有生成式模式、图神经网络模型等,能自动、快速地做出决策。因此决策层可以弥补部分传感器采集数据时因环境、天气等情况出现的数据不完整等情况,分析多个传感器数据信息并自动找出最优数据。

4 结束语

本文基于对单一激光雷达传感器与单一摄像头传感器识别技术的研究,提出激光雷达与摄像头多种类传感器数据层融合、特征层融合和决策层融合模式,对激光雷达和摄像头转化参数标定,多传感器数据融合层次进行分析。目前在智能汽车领域环境感知中,使用深度学习技术促进多传感器融合的研究越来越多,能有效改进智能车辆因使用单一传感器而受到天气、环境等干扰所导致的识别精度不高问题,可以增强智慧汽车环境感知的鲁棒性。基于激光雷达与摄像头融合环境感知技术,能有效提升智能汽车环境感知能力。但决策层融合技术目前对多传感检测时还存在检测结果匹配度不高、有效性不足等问题,需要多方协同完善数据整合、优先级判断和决策选择等情况。

【参考文献】

[1] 新华网. 国务院办公厅印发《新能源汽车产业发展规划(2021 - 2035年)》[EB/OL].( 2020-11-02) [2023-10-12]. https://baijiahao.baidu.com/s?id=1682239764162107391&wfr=spider&for=pc.

[2] 崔明阳, 黄荷叶, 许庆, 等. 智能网联汽车架构、功能与应用关键技术[J]. 清华大学学报( 自然科学版), 2022, 62(3): 493-508.

[3] 彭湃, 耿可可, 王子威等. 智能汽车环境感知方法综述[J/OL]. 机械工程学报:1-23[2023-10-26].http://kns.cnki.net/kcms/detail/11.2187.TH.20230927.1635.038.html.

[4] 张文炽, 陈黎辉, 吴炜等. 基于卷积神经网络特征融合的交通标志识别[J].计算机应用,2019,39(S1):21-25.

[5] Krizhevsky A,Sutskever I,Hinton E G. ImageNet classification withdeep convolutional neural networks[J]. Communications of theACM,2017,60(6) : 84-90.

作者简介:

吴学舟,本科,工程师,研究方向为智能网联汽车、车载智能感知测试。李岳松,专科,助理工程师,研究方向为新能源汽车电子测试。

——股权结构的调节效应检验