基于DeepLabV3+的稻田苗期杂草语义分割方法研究

邓向武 梁松 齐龙 余淑婷

摘要:稻田杂草位置获取是靶向喷施除草剂和机械智能除草的基础,为实现自然光照环境和水田复杂背景下稻田苗期杂草的信息获取。以稻田恶性杂草野慈姑为研究对象,提出一种基于全卷积神经网络的稻田苗期杂草语义分割方法,利用DeepLabV3+对秧苗和杂草进行语义分割进而获取的杂草位置信息。首先人工田间采集稻田苗期杂草野慈姑的RGB图像,通过图像标注工具LabelMe人工标注图像中秧苗、杂草和背景的各个像素点,70%数据集用于DeepLabV3+网络模型参数的训练,30%数据集用于测试DeepLabV3+性能。然后与FCN和U-Net两种语义分割方法进行比较,所提出的DeepLabV3+语义分割方法准确率、均正比、频权交并比和F值等性能指标都最优,试验得出:DeepLabV3+模型像素准确率最高达到92.2%,高于U-Net和FCN方法的准确率92.1%和84.7%。所提出的方法能对稻田苗期杂草、秧苗和背景像素进行准确分割,满足智能除草和除草剂靶向喷施的实际应用需求。

关键词:稻田杂草;野慈姑;语义分割;DeepLabV3+

中图分类号:S511

文献标识码:A

文章编号:2095-5553 (2023) 04-0174-07

Abstract: Paddy weed position acquisition is the basis of targeting spraying herbicide and mechanical intelligence weeding. In order to acquire information acquisition of weeds in seedling stage under natural light environment and complex paddy field background, in this paper, a new semantic segmentation method for weeds at seedling stage was proposed based on the full convolutional neural network and DeepLabV3+ was used for semantic segmentation of seedlings and weeds to obtain the weed location information by sagittaria trifolia as the research object. Firstly, the weeds RGB image of sagittaria trifolia in the paddy field were captured, and each pixel of the seedlings, weeds and background in the images were manually labeled by the image labeling tool LabelMe. 70% data set was used for the parameter training of the DeepLabV3+ network model, and 30% data set was used to test the performance of DeepLabV3+. By comparing with FCN and U-Net semantic segmentation methods, the proposed DeepLabV3+ semantic segmentation method had the best performance indicators, such as accuracy, proportional ratio, frequency weight intersection ratio and F value, and the experiment results showed that the pixel accuracy of DeepLabV3+ model was up to 92.2%. The accuracy rates of U-Net and FCN methods were 92.1% and 84.7% respectively. The method proposed in this paper could accurately segment weeds, seedlings and background pixels at seedling stage of paddy field, and also meet the practical application requirements of intelligent weeding and targeted herbicide spraying.

Keywords: paddy weed; sagittaria trifolia; semantic segmentation; DeepLabV3+

0 引言

水稻秧苗封行前杂草与秧苗在有限的生长空间内竞争光、水、肥等生长元素,并为病虫害传播提供中间载体,如不对杂草进行及时的田间管理,会导致水稻产量下降,据统计每年因杂草导致的水稻产量损失率约在15%以上[1]。随着精准农业和智慧农业的快速发展,根据杂草位置进行精准喷施已经成为可能[2]。因此,各类作物的杂草位置检测成为研究热点[3-4]。目前杂草位置智能检测分为基于杂草目标框的检测和基于像素的语义分割。近年来随着卷积神经网络(Convolutional Neural Networks,CNN)在图像目标检测领域的研究深入,并取得了很好的效果。基于R-CNN目标检测算法首先被提出。Fast R-CNN[5]在R-CNN的基础上做出了一些改进,解决了R-CNN需要对同一张图片重复进行多次卷积计算的问题,提高了速度和准确率。为避免Fast R-CNN中selective search[6]方法定位所需大量时间消耗,Faster R-CNN[7]提出了建议区域提取网络(RPN)网络,在生成候选框时比之前生成更少的候选框,但是生成的质量更高,不僅加快了速度,同时也提高了精度。除以上基于分类的目标检测方法,国内外学者还从回归的角度对目标检测方法进行了探索。樊湘鹏等[8]针对棉花幼苗和杂草提出了基于优化Faster R-CNN识别与定位方法,平均识别精度达到94.21%。Redmon等[9]提出了一种被称为POLO的检测方法,其基本思路是直接在卷积特征图上对多个区域的类别和边界框进行回归,实现对输入图像端到端的训练和测试。Liu等[10]也采用基于回归的设计思路,提出了一种被称为SSD(Single Shot MultiBox Detector)的检测方法。该方法通过在基础网络VGGNet上添加多个卷积层,并从多个卷积特征图上对多个区域的类别和边界框进行回归,较好地平衡了目标检测的精度和效率。

由于稻田行株距小,稻株行列间的杂草很容易与稻苗之间遮挡;同时由于杂草形态各异且自身非刚体容易形变等问题,同时杂草很难有清晰的边界信息,这对基于目标框的目标检测造成很大挑战。所以基于矩形框图像块特征学习的目标检测方法,不适用于稻田苗期杂草的目标检测。Long等[11]提出了全卷积网络(Fully Convolutional Networks,FCN)的语义分割算法,将传统的图像块特征转变为像素点特征学习[12-13]。该方法也在农业方面得到应用,如王璨等[14]基于双注意力语义分割网络对玉米田间苗期杂草进行识别与分割。

由于稻田杂草种类多且大部分杂草随着生长阶段的变化其形态也会发生很大变化,而由于杂草萌发的不一致导致稻田苗期会存在不同生长期的杂草形态。针对形状发散且形态随生长阶段变化的杂草,不适用基于矩形框的目标检测方法。Huang等[15]基于无人机采集稻田杂草图像,并基于FCN对杂草区域进行语义分割,取得了很好的效果,将卷积神经网络与条件随机场结合进行语义分割,获得了更好的性能。刘庆飞等[16]基于U-Net对甜菜田间杂草开展语义分割的方法,U-Net方法逐像素平均准确率为92.06%。由于DeepLabV3+[17]模型在Pascal VOC 2012通用图像数据集测试中表现优异,其在水田图像语义分割[18]、小麦病害识别[19]、淡水鱼体语义分割[20]和水产养殖水体信息获取[21]等方面得到大量的应用。

本文针对稻田秧苗封行前行列间生长形态不一致的杂草区域,提出DeepLabV3+的稻田苗期杂草语义分割方法,为智能除草和除草剂靶向喷施等应用提供技术支持。

1 材料与方法

1.1 稻田苗期杂草图像数据集

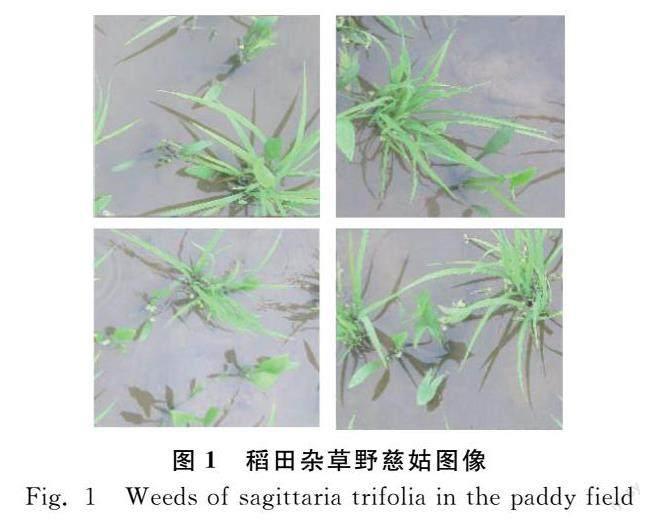

本文以早稻秧苗移栽后20 d后稻田内处于幼苗生长期的恶性杂草野慈姑为研究对象,在广东江门农科所农业实验基地稻田自然环境下采集图像,图像中杂草野慈姑由于种子萌发时间的区别,同一块区域杂草野慈姑形态差异大,叶龄长的显现剑形,叶龄短的显现扇形。将采集得到的图像进行行列分割成1 024像素×912像素,共得到华南稻区常规恶性杂草野慈姑图像224张图像,如图1所示。

1.2 图像标注

首先自然条件下水稻秧苗及苗期杂草的RGB图像,标注图像水稻秧苗、杂草和背景对应的像素类别,生成对应标签图像,连同水稻秧苗及苗期杂草的RGB图像及其对应的标签图像分成训练样本和测试样本。本文通过手工像素标注实现数据GroundTruth的构建,如图2所示。

1.3 稻田苗期杂草野慈姑图像语义分割流程

基于DeepLabV3+的稻田苗期杂草野慈姑语义分割方法研究流程如图3所示。

1) 首先获取自然水田环境稻田苗期杂草野慈姑的RGB样本图像。

2) 对杂草野慈姑图像进行人工标注形成对应的GroundTruth标签样本图像;随机选取70%的杂草野慈姑RGB样本图像及其对应的GroundTruth标签样本图像作为训练样本,其余30%的样本图像为测试样本。

3) 构建基于DeepLabV3+网络的稻田苗期杂草野慈姑图像语义分割模型。

4) 数据增强。数据增强可通过在训练期间随机变换原始数据来提高网络准确度。数据增强通过对杂草野慈姑图像和像素标签数据应用相同的随机变换,可为草野慈姑训练数据添加更多变化,而不必增加带标签的训练样本的数量。Matlab中使用数据存储transform应用在支持函数augmentImageAndLabel中定义的所需数据增强,使用随机左/右翻转和随机X/Y平移+/-10个像素来进行数据增强。

5) 通过杂草野慈姑RGB样本图像和人工标注形成对应的标签样本图像对模型进行训练;利用水稻秧苗和杂草野慈姑图像语义分割模型待分割水稻秧苗和杂草野慈姑的RGB图像的像素进行分类,输出水稻秧苗和杂草野慈姑分割图像,实现水稻秧苗及苗期杂草图像的语义分割;然后基于测试集对DeepLabV3+语义分割模型进行测试。

1.4 语义分割模型及评价指标

1.4.1 基于DeepLabV3+的语义分割模型

DeepLabV3+是由DeeeplabV1和DeeeplabV2发展而来,DeeeplabV2在DeeeplabV1基础上增加了空洞卷积和空间金字塔池化相结合的ASPP(Atrous Spatial Pyramid Pooling,ASPP)結构。DeepLabV3+相比于DeeeplabV1和DeeeplabV2减少了全连接条件随机场的使用,级联多个空洞卷积模块并改进了ASPP。

本文采用DeepLabV3+语义分割模型对田间自然场景下的秧苗和杂草野慈姑进行语义分割,语义分割模型DeepLabV3+能够从样本中学习并提取浅层特征和深层特征经常融合进而得到鲁棒性强的特征,实现水稻秧苗和杂草野慈姑图像的语义分割。DeepLabV3+网络结构如图4所示。DeepLabV3+网络是由编码和解码两部分组成,期中编码部分比解码部分相对复杂。编码部分包括特征提取网络ResNet-18[22]用于提取特征,其通过引入残差结构解决模型训练中梯度消失的难题。DeepLabV3+编码部分还包括ASPP,其用于进一步优化深度卷积特征。ASPP应用不同采用率(如图4中的rate 6、rate 12、rate 18)的空洞卷积多尺度信息提取ResNet-18输出的特征图,不同膨胀率卷积核结构如图5所示。

2 试验结果与分析

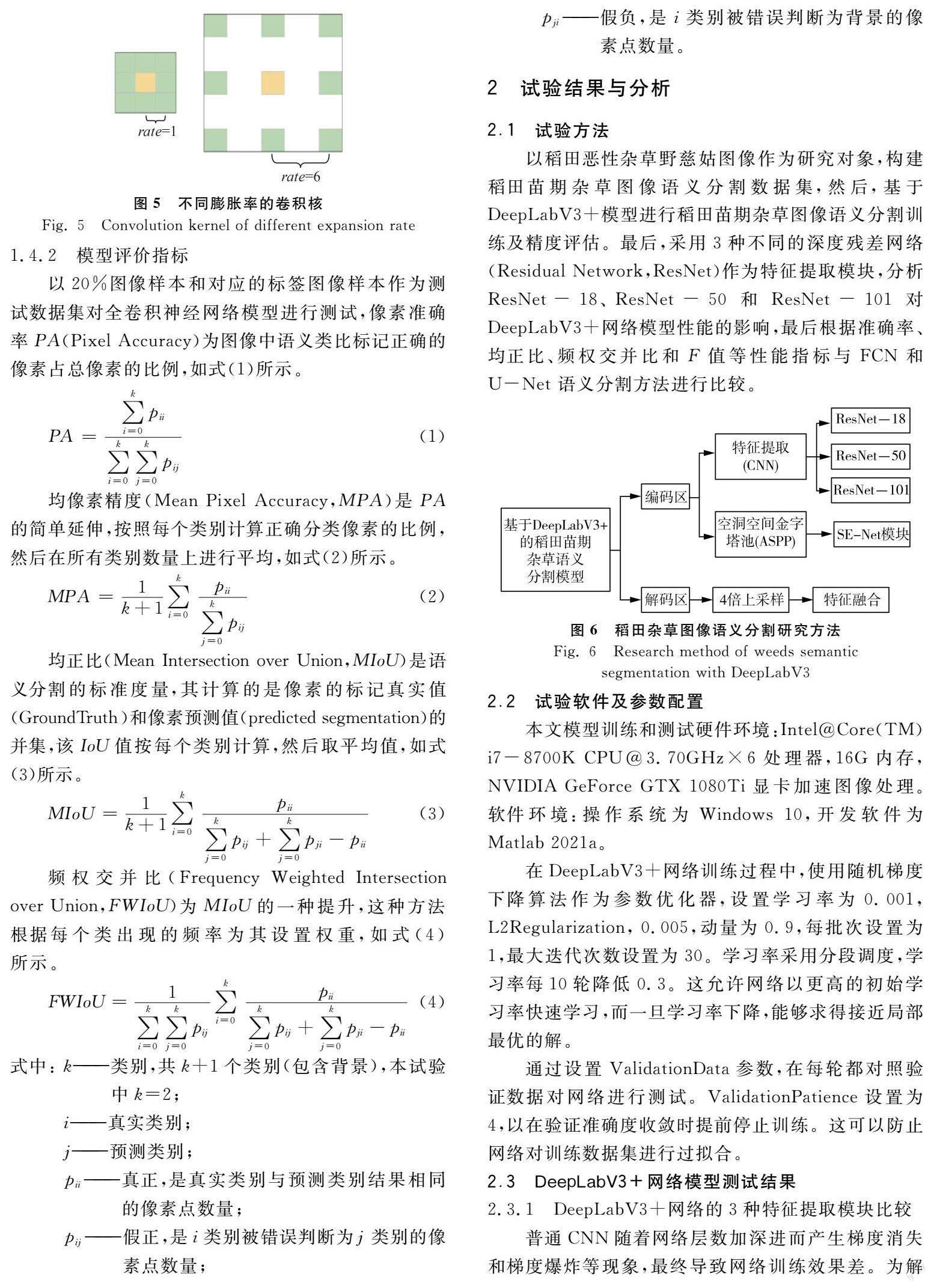

2.1 试验方法

以稻田恶性杂草野慈姑图像作为研究对象,构建稻田苗期杂草图像语义分割数据集,然后,基于DeepLabV3+模型进行稻田苗期杂草图像语义分割训练及精度评估。最后,采用3种不同的深度残差网络(Residual Network,ResNet)作为特征提取模块,分析ResNet-18、ResNet-50和ResNet-101对DeepLabV3+网络模型性能的影响,最后根据准确率、均正比、频权交并比和F值等性能指标与FCN和U-Net 语义分割方法进行比较。

2.2 试验软件及参数配置

本文模型训练和测试硬件环境:Intel@Core(TM) i7-8700K CPU@3.70GHz×6处理器,16G内存,NVIDIA GeForce GTX 1080Ti显卡加速图像处理。软件环境:操作系统为Windows 10,开发软件为Matlab 2021a。

在DeepLabV3+网络训练过程中,使用随机梯度下降算法作为参数优化器,设置学习率为0.001,L2Regularization, 0.005,動量为0.9,每批次设置为1,最大迭代次数设置为30。学习率采用分段调度,学习率每10轮降低0.3。这允许网络以更高的初始学习率快速学习,而一旦学习率下降,能够求得接近局部最优的解。

通过设置ValidationData参数,在每轮都对照验证数据对网络进行测试。ValidationPatience设置为4,以在验证准确度收敛时提前停止训练。这可以防止网络对训练数据集进行过拟合。

2.3 DeepLabV3+网络模型测试结果

2.3.1 DeepLabV3+网络的3种特征提取模块比较

普通CNN随着网络层数加深进而产生梯度消失和梯度爆炸等现象,最终导致网络训练效果差。为解决CNN网络模型网络深度增加导致的上述问题,ResNet引入BasicBlock和Bottleneck旁路连接结构,如图7所示。梯度可以通过旁路跨越CNN中的网络层数进行反向传播。

ResNet-18、ResNet-50和ResNet-101网络结构如表1所示,ResNet-18采用BasicBlock旁路结构,ResNet-50和ResNet-101采用Bottleneck旁路结构。由于ResNet-50和ResNet-101网络层数较深,采用BottleNeck结构不仅在参数上更加节约,同时还能保持特征提取性能。

采用3种不同的ResNet特征提取模块对稻田苗期杂草DeepLabV3+语义分割模型进行性能比较。表1给出了采用ResNet-18、ResNet-50和ResNet-101共3种不同特征提取模块在DeepLabV3+模型上的性能。

试验结果如表2和表3所示,图8为采用3种不同特征提取模块的DeepLabV3+语义模型输出结果。

如表2所示,虽然采用ResNet-101虽然总的准确率最高,达到94.7%;但从表3和图8(d)可以看出,采用ResNet-101的DeepLabV3+模型针对杂草野慈姑的准确率仅为77.2%。

如表3所示,采用ResNet-50的DeepLabV3+模型针对杂草野慈姑和稻苗的准确率都好于ResNet-18,但总准确率还是低于ResNet-18(表3)。试验结果表明针对本文小样本杂草数据集,采用ResNet-18的DeepLabV3+模型方法综合性能最优。

2.3.2 3种不同语义分割模型比较

为了便于与其他全卷积语义分割网络对比,在相同环境下实现了SegNet、FCN和U-Net语义分割网络,并使用相同的训练集和测试集对模型进行训练和测试。

图9为DeepLabV3+语义模型输出结果,结果表明DeepLabV3+方法能预测复杂条件下,不同生长期的杂草野慈姑不同形态像素位置信息,其形态边缘清晰。

表4中给出了SegNet、FCN和U-Net方法以及本文DeepLabV3+方法在测试数据上的各项评估指标。针对测试集试验结果表明,使用本文提出的DeepLabV3+方法对杂草、水稻秧苗和背景的逐像素分类平均准确率、均正比和F值都高于FCN和U-Net的方法。

表5中结果表明采用本文DeepLabV3+针对杂草野慈姑、背景和稻苗的逐像素分类准确率都超过了90%,分别为93.6%、92.1%和90.5%,尤其对稻苗像素识别能力高于U-Net和FCN。U-Net方法对背景像素类别的分割能力达到97.7%,高于DeepLabV3+和FCN,而针对稻苗和杂草野慈姑像素的识别准确率较低。FCN方法对杂草野慈姑像素类别的分割能力达到92.9%,高于DeepLabV3+和U-Net。试验结果出现表明本文所提出的DeepLabV3+模型能够对自然条件下水稻秧苗及苗期杂草野慈姑中的各像素能进行有效语义分割。

3 结论

1) 本文提出了一种DeepLabV3+的稻田苗期杂草语义分割方法,该语义分割模型能对稻田苗期杂草野慈姑、秧苗和背景像素进行准确分割,为稻田智能除草和除草剂靶向喷施等应用提供技术支持。

2) 通过与FCN和U-Net两种语义分割方法进行比较,本文所提出的DeepLabV3+语义分割方法准确率、均正比、频权交并比和F值等性能指标都最佳。试验得出DeepLabV3+模型像素平均准确率最高达到92.2%,高于U-Net和FCN方法的平均准确率为92.1%和84.7%。

3) 本文所提出的基于DeepLabV3+全卷积神经网络的水稻秧苗和杂草野慈姑逐像素分类方法,能对稻田图像中的水稻秧苗、杂草野慈姑和背景实施有效逐像素分类,能对同一幅图像中不同生长形态的杂草野慈姑进行有效语义分割,满足智能除草和除草剂靶向喷施的实际应用需求。

参 考 文 献

[1] 于改莲. 稻田除草剂的正确施用方法[J]. 农药, 2001, 12(40): 43-45.

Yu Gailian. Correct application method of herbicide in the paddy field [J]. Agrochemicals, 2001, 12(40): 43-45.

[2] 刘成良, 林洪振, 李彦明, 等. 农业装备智能控制技术研究现状与发展趋势分析[J]. 农业机械学报, 2020, 51(1): 1-18.

Liu Chengliang, Lin Hongzhen, Li Yanming, et al. Analysis on status and development trend of intelligent control technology for agricultural equipment [J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(1): 1-18.

[3] 范德耀, 姚青, 楊保军, 等. 田间杂草识别与除草技术智能化研究进展[J]. 中国农业科学, 2010, 43(9): 1823-1833.

Fan Deyao, Yao Qing, Yang Baojun, et al. Progress in research on intelligentization of field weed recognition and weed control technology [J]. Scientia Agricultura Sinica, 2010, 43(9): 1823-1833.

[4] 李春明, 逯杉婷, 远松灵, 等. 基于Faster R-CNN的除草机器人杂草识别算法[J]. 中国农机化学报, 2019, 40(12): 171-176.

Li Chunming, Lu Shanting, Yuan Songling, et al. Weed identification algorithm of weeding robot based on Faster R-CNN [J]. Journal of Chinese Agricultural Mechanization, 2019, 40(12): 171-176.

[5] 张小青, 樊江川, 郭新宇, 等. 基于Faster R-CNN的大田玉米雄穗识别及抽穗期判定研究[J]. 安徽农业大学学报, 2021, 48(5): 849-856.

Zhang Xiaoqing, Fan Jiangchuan, Guo Xinyu, et al. Research on male ear detection and tasseling stage identification of field maize based on faster R-CNN [J]. Journal of Anhui Agricultural University, 2021, 48(5): 849-856

[6] Uijlings J R R, Sande K E A, Gevers T, et al. Selective search for object recognition [J]. International Journal of Computer Vision, 2013, 104(2): 154-171.

[7] 董浪, 许建峰, 靳江周, 等. 基于改进Faster R-CNN的梨树花芽识别方法[J]. 河北农业大学学报. 2021, 44(6): 116-121.

Dong Lang, Xu Jianfeng, Jin Jiangzhou, et al. Flower bud recognition of pear tree based on improved faster R-CNN [J]. Journal of Heibei Agricultural University, 2021, 44(6): 116-121.

[8] 樊湘鹏, 周建平, 许燕, 等. 基于优化Faster R-CNN的棉花苗期杂草识别与定位[J]. 农业机械学报, 2021, 52(5): 26-34.

Fan Xiangpeng, Zhou Jiangping, Xu Yan, et al. Identification and localization of weeds based on optimized Faster R-CNN in cotton seedling stage [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5): 26-34.

[9] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2016: 779-788.

[10] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector [C]. Proceedings of European Conference on Computer Vision. Springer International Publishing, 2016: 21-37.

[11] Long J, Shelhamer E, Trevor Darrell. Fully convolutional networks for semantic segmentation [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431-3440.

[12] Dai J, He K, Sun J. Instance-aware semantic segmenta-tion via multi-task network cascades [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3150-3158.

[13] Noh H, Hong S, Han B. Learning deconvolution network for semantic segmentation [C]. IEEE International Conference on Computer Vision. IEEE Computer Society, 2015: 1520-1528.

[14] 王璨, 武新慧, 张燕青, 等. 基于双注意力语义分割网络的田间苗期玉米识别与分割[J]. 农业工程学报, 2021, 37(9): 211-221.

Wang Can, Wu Xinhui, Zhang Yanqing, et al. Recognition and segmentation of maize seedlings in field based on dual attention semantic segmentation network [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(9): 211-221.

[15] Huang, H, Deng, J, Lan, Y, et al. Accurateweed mapping and prescription map generation based on fully convolutional networks using UAV imagery [J]. Sensors, 2018, 18(10): 3299.

[16] 刘庆飞, 张宏立, 王艳玲. 基于深度可分离卷积的实时农业图像逐像素分类研究[J]. 中国农业科学, 2018, 51(19): 3673-3682.

Liu Qingfei, Zhang Hongli, Wang Yanlin. Real-time pixel-wise classification of agricultural images based on depth-wise separable convolution [J]. Scientia Agricultura Sinica, 2018, 51(19): 3673-3682.

[17] Chen L C, Papandreou G, Kokkinos L. Deeplab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs [J]. IEEE transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[18] 鄧泓, 杨滢婷, 刘兆朋, 等. 基于深度学习的无人机水田图像语义分割方法[J]. 中国农机化学报, 2021, 42(10): 165-172.

Deng Hong, Yang Yingting, Liu Zhaopeng, et al. Semantic segmentation of paddy image by UAV based on deep learning [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(10): 165-172.

[19] 戴雨舒, 仲晓春, 孙成明, 等. 基于图像处理和DeepLabv3+模型的小麦赤霉病识别[J]. 中国农机化学报, 2021, 42(9): 209-215.

Dai Yushu, Zhong Xiaochun, Sun Chengming, et al. Identification of fusarium head blight in wheat-based on image processing and DeepLabv3+ model [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(9): 209-215.

[20] 王红君, 季晓宇, 赵辉, 等. SENet优化的DeepLabv3+淡水鱼体语义分割[J]. 中国农机化学报, 2021, 42(3): 158-163.

Wang Hongjun, Ji Xiaoyu, Zhao Hui, et al. SENet optimized DeepLabv3+ freshwater fish body semantic segmentation [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(3): 158-163.

[21] 苟杰松, 蒋怡, 李宗南, 等. 基于DeepLabv3+模型的成都平原水产养殖水体信息提取[J]. 中国农机化学报, 2021, 42(3): 105-112.

Gou Jiesong, Jiang Yi, Li Zongnan, et al. Aquaculture water body information extraction in the Chengdu plain based on DeepLabv3+ model [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(3): 105-112.

[22] He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition [C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CPVR), Las Vegas: IEEE, 2016.