机器学习在不良心血管事件诊断中的应用综述

柯盼盼,陈 胜,李珂然

(上海理工大学 光电信息与计算机工程学院,上海 200093)

0 引言

如今,计算机处理能力和硬件设备算力的大幅提升促进了信息技术在各个领域应用的发展,而这些进步也已渗透到心血管疾病诊断领域。作为人工智能的一个组成部分,机器学习在未来医学数据整合分析中将发挥重要作用[1]。机器学习相关算法可以处理大量临床数据,利用数据驱动为医生诊断提供参考。在电子病历数据或者影像学报告中适当地利用机器学习算法,可以降低成本、提高护理质量,并有助于对不良心血管事件的辅助诊断[2]。本文探讨机器学习相关算法如何提高对不良心血管事件的诊断与预后能力,以及其未来在改善急性冠脉综合征患者护理方面的潜力。传统统计学目前在临床试验与研究中发挥着至关重要的作用,然而如今新数据有多个来源,包括可穿戴设备、智能手机应用程序和电子病历等。随着数据在复杂性、量级和维度上的发展,将超过传统统计分析的阈值,而与之相反的是,由于数据驱动能力,机器算法的诊断性能会随着数据的增加而显著提高。不同于传统统计方法,机器学习模型除可揭示数据中隐藏的关系外,某些机器学习方法还可以独立进行操作,并提供关于数据性质的进一步洞察结果。

1 临床风险预测模型

1.1 风险评估指标

急性冠脉综合征(Acute Coronary Syndrome,ACS)患者属于高风险人群,包括急性心肌梗死和不稳定心绞痛[3],其主要不良心血管事件涉及再梗、心衰、死亡、中风等[4]。临床中常用的风险评估工具是心肌梗死溶栓治疗临床试验(Thrombolysis in Myocardial Infarction,TIMI)评分和全球急性冠状动脉事件注册(Global Registry of Acute Cardiac Events,GRACE)评分[5-6]。TIMI 风险评分主要涉及8 个变量,包括年龄、动脉收缩压、心率、心功能Killip 分级、体重、前壁心肌梗死、发病至治疗时间以及有无糖尿病、高血压或心绞痛病史,理论得分0~14 分,该评分能够较好地预测患者14 天全因死亡和心肌梗死的风险,以及30 天和一年的全因死亡风险;GRACE 风险评分指标包括年龄、心率、动脉收缩压、血肌酐、心电图显示ST 段变化、Killip 分级、入院时心脏骤停和心肌标志物升高,该评分基于研究制定,危险因素来自对住院死亡和出院后6 个月时死亡具有独立预测能力的因素。Anand 等[7]使用GRACE 风险评分对老年心梗患者一年的全因死亡风险进行预测,该评分结合临床衰弱量表,结果AUC 为0.86,并得到外部验证AUC为0.75。

这两种风险评分均可对急性心梗患者进行风险分层,同时也可用于评估并预测不同周期的相关死亡率。Chen等[8]使用两种风险评分对心肌梗死患者进行危险分层和长短期预后预测,其中GRACE 评分在预测非ST 段抬高型心梗患者的3 年死亡率与ST 抬高型心梗患者的1 年和3 年死亡率方面显著优于TIMI 评分。这两个评分在预测亚洲心梗患者的短期和长期主要不良心脏事件方面显示出相当好的判别准确性。与简单TIMI 风险评分相比,GRACE风险评分在预测长期死亡率方面更准确。Kao 等[9]使用GRACE 和TIMI 风险评分对急性心梗患者进行两年死亡率评估,其中GRACE 评分AUC 为0.74,略优于TIMI(0.73)。

1.2 Cox回归模型

Cox 回归模型通常被用来对患者进行风险评估与生存分析,通过患者的身体基线参数以及相关疾病指标因素,可以得到一个风险概率[10]。具体公式如式(1)、式(2)所示:

其中,h0(t)是基线风险函数,t是生存时间,X=(X1,…,Xn)是协变量,表示影响生存时间且不随时间变化的变量。β=(β1,β2…,βn)表示其他给定变量不变时,对应X的系数变量[11]。若危险因素的变量不随时间变化,则h(t,X)/h0(t)不随时间变化,式(1)又被称为比例风险模型。风险概率公式(2)表示存活t时刻后,变量X在t~t+Δt时间段内死亡概率与Δt之比的极限值。

Cox 回归模型在临床中用于危险变量分析,以及对患者进行风险评估。Leng 等[12]通过Cox 回归模型分析左心房应变因素与不良心血管事件之间的关联性,得到梗死面积风险比为1.01,左心房应变风险比为0.81~0.84,其应变因素和心梗面积可作为预后因素,通过左心房障碍和发病率预测心梗患者的死亡率。Tsai等[13]在Cox回归模型中加入新变量,如高血压、支架植入等,通过这些独立因素对冠心病患者的不良心血管事件进行预测,用于识别高危患者。

2 基于机器学习的风险评估模型

传统统计学方法使用选择性变量进行预测,无法汇总大数据,存在丢失重要信息的可能性,且只能对患者进行简单的风险评估,而机器学习模型可以从采集的大数据中提取关键变量进行预测,通过有效结合多数据来源,从数据中挖掘潜在关系,并进一步实现数据智能化,以提高医患管理效率。机器学习算法中包含的多种方法可以通过训练学习数据的有效表示,实现对不良心血管的风险评估[14]。相较于传统统计学方法对样本或总体的参数进行推断,机器学习侧重于实现数据结构算法,并进行回归预测或分类。大部分相关研究进行建模的数据一般是患者的电子病历、住院信息或是国家医疗信息库里的大批量数据,其中的变量涉及人口统计学、社会经济情况、病史、临床症状、生命体征和出院干预等[15]。数据汇总后通过特征工程处理,输入模型进行训练,具体流程如图1所示。

Fig.1 Data processing flow图1 数据处理流程

2.1 模型评价指标

常见的模型评价指标包括准确率、特异度、灵敏度等,具体公式如式(3)-式(5)所示。

其中,TP表示实际与预测均为正,FP表示实际为负而预测为正,FN表示实际为正而预测为负,TN表示实际为负且预测为负。灵敏度表示实际类别为1 的样本中预测正确的比例,特异度表示实际类别为0 的样本中预测错误的比例。

为准确评估模型性能,根据上述灵敏度和特异度绘制ROC 曲线。AUC表示ROC 曲线下的面积,是对模型预测能力的综合评价,AUC值越大表明模型的稳定性和可靠性越强。

2.2 基于决策树的风险评估模型

决策树算法是通过不同属性进行分支,其中每个节点表示一个特征,每个叶子节点描述一个结果,每个分支以信息增益作为原则,并选择使增益最大的属性作为本次分支的属性[16]。Tison 等[17]使用分类回归树开发心衰风险预测模型,与传统风险模型相比,该模型具有更强的识别能力。简单树模型计算简单,可解释性强,适合处理可能有缺失值的样本,同时也可处理非相关特征。Hsieh 等[18]使用基尼不纯度结合决策树模型预测患者经过皮冠状动脉介入术后30 天的死亡率。线性树结合线性模型与决策树可以提升整体预测性能,并改善决策树容易过拟合的缺点。Barrett 等[19]整合简单逻辑回归和线性树模型预测诊断患者一年的死亡率,取得了较高准确率。

2.3 基于支持向量机的风险评估模型

支持向量机是一种典型的基于核的有监督学习算法,其目标是在数据点之间创建一个超平面,使分类区最大化,通常用于解决二分类问题,也可用于其他线性或非线性分类问题。Wallert 等[21]选择支持向量机模型解决预测首次心梗后患者两年存活与非存活的二分类问题,得到AUC 为0.84,敏感度和特异度分别为0.78 与0.75,若减少到10 个变量,实际效果与其他模型效果整体相差不大。数据不平衡是常见问题,容易导致模型过拟合,为缓解不同类别间的数据失衡问题,Zhao 等[20]采用支持向量机结合随机欠采样训练,提升模型预测高危患者的能力,同时模型在简化数据集中仍有较好的结果。与初始模型相比,有效的特征选择可以帮助模型实现更强的判别能力。基于心梗患者长期随访数据中提取的38 个变量,Aziz 等[22]通过支持向量机结合特征顺序向后消除方法构建预测模型,可以识别个别亚洲人口的不同因素特征,预测患者住院、30 天和一年的死亡率,实现风险分层,并帮助改善医患管理。

2.4 基于随机森林的风险评估模型

随机森林是一种有监督学习分类算法,其通过平均多个独立决策树模型的结果实现每个预测结果的一致性。每个独立的决策树拟合一个随机选择的数据子集,并在每个节点上将可用于训练预测器的随机子集作为分裂的候选子集[23]。在急性心梗患者的主要不良心血管事件中,短期死亡率与住院率是重要的关注点,Shouval 等[24]使用随机森林模型结合统计筛选的54 个变量进行30 天死亡率预测,得到AUC 为0.91,优于GRACE(0.87)和TIMI(0.82)临床风险评分;作为集合模型,随机森林极大地缓解了决策树中容易过拟合的问题,可直接应用于高维数据,且无需作特征选择,Li等[25]使用随机森林算法实现患者住院风险预测模型,在不同特征数据集中表现优异,可为临床决策提供支持;通过改变随机森林中树的组合,可进一步强化模型的稳定性,Lee 等[26]评估患者一年全因死亡情况,提出一个由决策树和提升树组成的改进模型,结合特征工程,包括重要度分析提取关键变量以及PCA 降维得到输入变量,最终验证死亡研究队列精准度为0.85,存活队列灵敏度为0.97;为解决数据不平衡问题,吴欢等[27]使用SMOTE(Synthetic Minority Over-Sampling Technique)方法[28]结合随机森林预测模型,通过对数据进行过采样处理,从而提升模型性能。

变量个数变化对随机森林模型的可靠性不造成显著影响,在样本属性较少时,构建的预测模型可保留较好性能。Mansoor 等[29]利用随机森林算法构建女性患者全因住院死亡率预测模型,平均AUC 为0.81,经过多个外部患者队列验证,并在简化变量后仍保留了较好的预测结果;在变量个数相同的情况下,机器学习模型相较于风险评分仍有良好表现,Hadanny 等[30]使用随机森林模型评估患者30天死亡率,基于完整变量训练的随机森林模型与应用少数变量的简单模型验证的AUC 分别为0.80 和0.79,均优于GRACE 风险评分(0.76)。

2.5 基于梯度提升算法的风险评估模型

梯度提升机(Gradient Boosting Machine,GBM)[31]是一种集成算法,是将多个高偏差的弱学习器进行组合以降低整体偏差,形成一个强学习器的方法,在临床风险预测中有较多应用,有比传统风险评分更优的预测性能。Sherazi 等[32]使用梯度提升机构建模型,预测ACS 患者出院一年后临床随访的死亡率,帮助预测并发现ACS 患者早期主要心血管不良事件。XGBoost[33]是从boosting 算法中衍生而来,有效减少了方差与偏差,在临床实践中具有稳健性。Li 等[34]使用XGBoost 算法构建心梗患者随访一年后的死亡预测模型,相较于评估急性冠脉综合征的GRACE 风险评分,该模型具有更高的精度和更好的预测短期死亡率的能力。心衰作为主要不良心血管事件之一,对患者风险评估非常重要。Sax 等[35]对比多个模型预测30 天不良事件发生率,其中XGBoost 表现最优,C 统计量为0.85,在不同风险分层人群中均有较好效果。先验特征可以有效提升模型性能,Schrempf 等[36]利用特征滤波提取电子病历数据中的826 个先验特构建机器学习模型,预测5 年内主要不良心血管事件发生的风险,XGBoost 模型在五折交叉验证中表现最优,体现出模型的长期预后价值。

2.6 基于人工神经网络的风险评估模型

随着硬件技术与大数据的发展,神经网络被应用于大规模数据中,并在不同领域得到广泛验证。人工神经网络衍生的变种很多,通过快速调整可以适用于新问题,在疾病风险预测场景中的应用逐渐得到发展,其辅助诊断能力也得到认可。支持向量机、随机森林等模型应用于大量电子健康记录数据时容易达到瓶颈,而神经网络可以更好地拟合数据。Payrovnaziri 等[37]使用浅层神经网络模型提取电子记录数据的高维特征,实现重症患者一年内的死亡风险预测。除常用的机器学习模型外,新的神经网络也被应用于不良心血事件预测中。Huang 等[38]提出一种多目标子类型不良心血管预测模型,融合了逻辑回归和堆叠去噪自动编码器[39]模型,并引入对抗性学习来缓解子类型中共享和私有潜在特征空间之间的干扰。神经网络模型在非结构数据中可以更好地提取并学习相关文本特征,Kwon等[40]基于多层感知器开发新的深度学习模型DAMI,选择Adagrad 优化器[41]和交叉熵损失函数,在预测心梗患者住院死亡率和12 个月死亡率的准确性上优于其他机器学习模型,可以作为日常事件中精确决策的工具。

2.7 模型应用分析

研究文献中的机器学习预测模型如表1 所示,其中罗列了具体模型与相关改进以及实验结果。

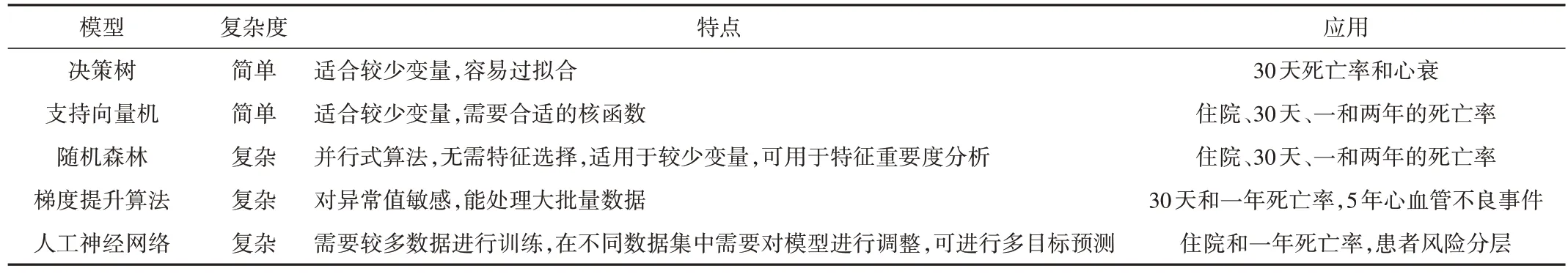

机器学习模型在多个预测场景中得到了广泛应用,如表2 所示。若预先通过特征工程进行变量筛选,提取关键变量,可选择决策树、支持向量机及随机森林模型进行训练,其在短期预后分析中表现较好。在长期预测分析中,应用梯度提升算法有一定效果。而神经网络需要更多数据进行训练,可调整模型实现多目标预测。

目前医生对不良心血管事件的诊断主要依赖患者各项生理健康指标、既往病史、影像报告等数据,而面对统计数据的膨胀式增长,传统风险评分工具无法有效进行多渠道信息整合。通过利用机器学习模型快速学习和深度挖掘语义信息的能力,可以快速筛选高风险患者。其他应用如确定ACS 患者风险等级、预测患者长期存活率和不良心血管事件复发率等,也将对改善心血管疾病的辅助诊断和预后分析产生积极影响。

Table 1 Summary of prediction models表1 预测模型汇总

Table 2 Application of machine learning models表2 机器学习模型应用

3 结语

在目前的长短期预后研究中,机器学习模型在不良心血管事件风险评估中相比传统风险评分具有更强的预测能力,因此在临床应用中有着广阔前景,但也存在一些难点:

(1)样本多样性。由于患者数量很大,样本采集与数据统计不统一会导致数据偏差。另外,一些非结构化数据如心电图、彩超等作为患者在诊断中常用的检查,可以考虑应用深度学习方法提取相关特征与临床数据相结合。

(2)模型不可解释性与泛化能力弱。传统统计学方法在临床中仍是主要的分析与建模工具,机器学习模型中的随机森林、XGBoost 以及神经网络的可解释性较差和泛化能力弱是部分原因。不同的训练集会导致模型产生差别,出现泛化能力弱的问题,分析其变量的重要度以及增加数据多样性较为重要。

(3)长期预后。相较于短期风险的预见性,长期风险评估也尤为重要。通常来说,患者长期风险受到多方面因素影响,常规风险评估指标涉及变量较少,通过机器学习模型对患者进行多方面的综合评估,需要医院体系进行长期随访才可以实现对相关患者进行风险警示。机器学习模型可以适应不同数目的变量,但是通常较少的变量会降低实际预测效果,因此需要解决数据不平衡问题,并筛选长期预测因子。

机器学习的高效性与稳定性使其在医学数据方面有着广泛应用,并且可以辅助医生对病患进行相关救治与护理,通过对高危患者采取分期预防措施或治疗以改变预测风险。如今,基于机器学习算法的不良心血管风险预测仍处于发展阶段,如果在目前的难点上有所突破,将可以应用于更多场景中。