基于5G的数据中心节能技术及部署策略研究

王小稳,林高全,黄宗伟

(广东邮电职业技术学院,广东 广州 510665)

0 引 言

随着5G的大规模建设和各种行业应用的快速发展,催生了海量数据的爆发性增长,造成数据中心耗电量的急剧上升。从全球来看,到2025年数据中心的耗电量将占到全球能耗的33%;从国内看,全国数据中心的耗电量增长速度已经连续8年超过12%。截止2021年底,全国数据中心耗电量已经突破2 372亿kW·h。预计到2030年,耗电量将达到4 000 亿kW·h,将占全国总用电量的4%以上。

当前我国数据中心行业东西地区供给分布极不均衡,受地域经济发展水平的影响,我国数据中心的供给分布呈现东多西少。东部地区行业应用需求大,但数据中心用电成本高、能源消耗指标紧张,大规模发展数据中心的难度和局限性较大。西部地区可再生能源丰富、气候适宜,但存在网络带宽较小、跨区域跨省的数据传输费用高等问题。由于东部地区高价值业务集中,数据中心的预期回报率高于西部地区,尤其以视频、游戏、电商以及支付等为代表的新经济应用比较突出,应用的消费量与地区平均经济水平挂钩,导致东部地区流量与算力需求相对集中。此外,相关的信息基础设施也就近分布,东部地区数据中心整体利用水平、现金流与收益水平均高于西部地区。

1 数据中心现状与发展趋势

1.1 国外数据中心现状与发展趋势

当前,全球数据中心市场平稳增长。市场收入方面,2021年全球数据中心市场规模超过679亿美元,较2020年增加60.6亿美元,同比增长9.89%。预计到2022年底,市场规模将达到746.5亿美元,增速总体保持平稳。随着5G、工业互联网、人工智能等新技术应用落地和传统产业数字化、智能化转型,海量数据将推动数据中心大规模发展。到2025年,全球数据中心市场规模有望突破1 500亿美元,数据中心将迎来新一轮的发展机遇。

1.2 国内数据中心现状与发展趋势

近年来,我国数据中心机架规模稳步增长。截止到2021年底,我国在用数据中心机架规模达到520万架,近5年年均复合增速超过30%。其中,大型以上数据中心机架规模为420万架,占比达到80%。随着国家“东数西算”战略的推出,数据中心成为整个社会的关注重点。作为算力的主要载体,数据中心同样面临着严峻的能耗问题。相关数据显示,2021年全国数据中心共耗电2 372 亿kW·h,占全社会用电量的2.7%。到2035年,我国数据中心和5G总用电量将达6 951~7 820 亿kW·h,将占全社会用电量的5%~7%。

当前我国正处于各行业数字化转型的加速期,以数据中心为代表的数字基础设施应用场景将进一步扩大,数据中心产业将迎来更大机遇,发展前景将更加广阔。

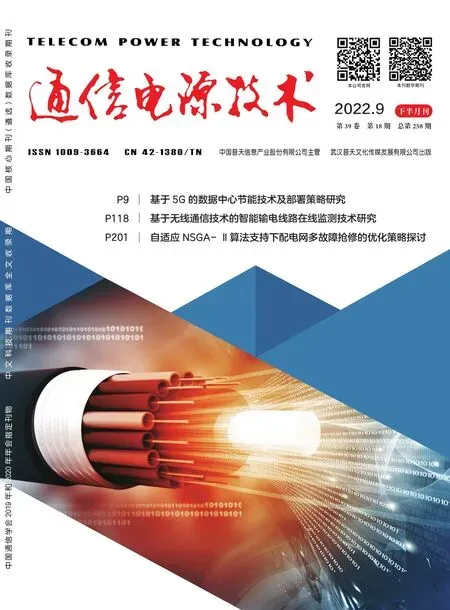

2 数据中心构成与能耗结构

数据中心是一类特殊的建筑,用来集中放置和管理各类IT设备(如服务器、交换机、高性能计算机等)及其配套设施(电源、照明、空调等),以实现对大量数据的存储、运算、传输以及通信等功能,为不同需求的用户提供实时高效的信息处理服务。数据中心具体构成如图1所示。

图1 数据中心构成

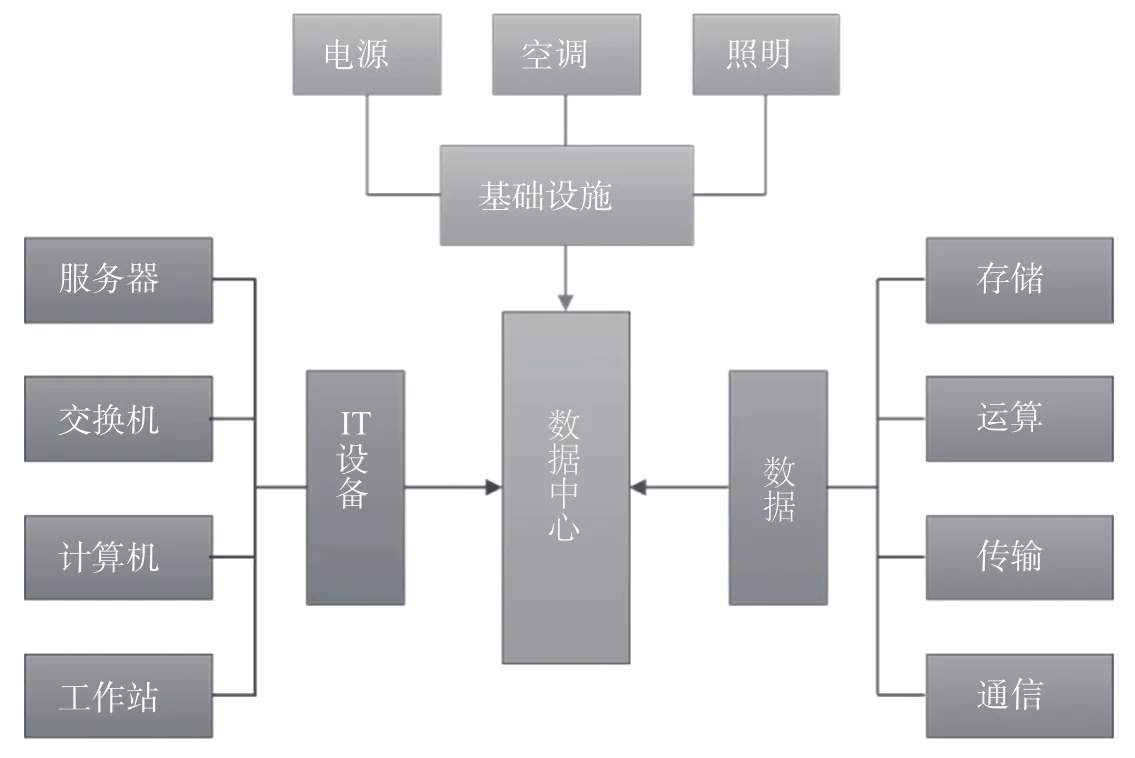

典型数据中心能耗包含IT设备能耗、空调系统能耗、电源系统能耗以及其他能耗,其中能耗比重最大的部分为空调系统(约占47%),其次为IT设备(约占43%)和电源系统(约占8%)[1]。典型数据中心能耗构成如图2所示。

图2 典型数据中心能耗构成

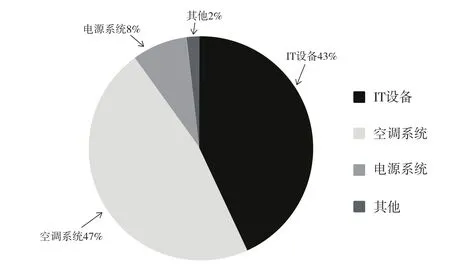

各系统的能耗影响因素如图3所示。其中,气候类型、制冷形式影响数据中心制冷系统能耗,IT负荷率、规模大小以及安全等级影响数据中心整体能耗[2]。

图3 数据中心能耗影响因素

3 数据中心节能降耗解决方案与部署措施

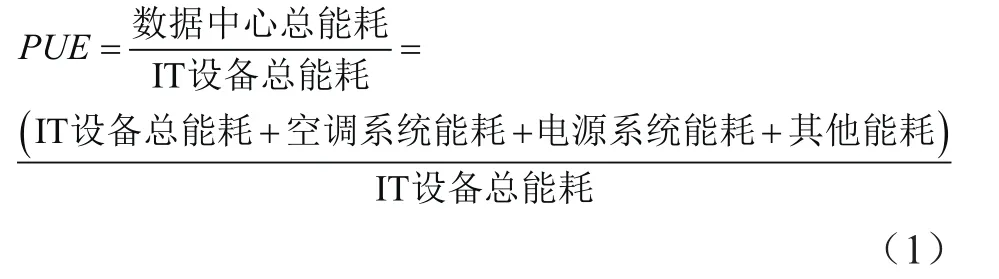

电源使用效率(Power Usage Effectiveness,PUE)是衡量数据中心节能的重要指标,其计算公式为

PUE值越接近1,说明数据中心能效比越好、越节能[3]。数据中心节能措施主要从以下2个方面考虑:一是提高数据中心机房IT设备的能效,即在保持同样计算能力的前提下,尽量降低IT设备的功耗;二是降低数据中心机房配套设施的能耗。

针对5G带来的海量数据中心需求和数据中心的高能耗问题、东西部分布不均衡问题,重点从设备级节能、系统级节能以及战略层级节能3个层级进行研究。

3.1 设备级节能

IT设备是数据中心的核心,机房内其他所有的配套设施均为IT设备服务,提高IT设备的能效是数据中心节能减排的重中之重。

3.1.1 IT设备模块降耗

(1)应用功放新材料。提升功率放大器(Power Amplifier,PA)的效率一般通过创新设计工艺或采用新材料来实现,例如采用氮化镓Doherty放大器、低压等离子材料等,均能大幅降低额外损耗。以氮化镓材料为例,该材料具有更高的电子饱和迁移率和更高的二维电子气浓度,由该材料制成的晶体管输出功率比传统半导体的输出功率低。

(2)优化功放模块的设计。设备功放的平均效率主要取决于驱动器和末级的效率,当功放采用低压晶体管作为驱动器时,可以降低驱动器功耗并消除其与末级之间的级间不匹配问题,提高整体功放的平均效率。传统设计的PA功放对驱动器和未级采用相同的电源电压,需在驱动器和未级之间增加1个匹配网络。例如,驱动器侧设计为低电源电压,在降低驱动器功耗的同时,还可降低其输出阻抗,使整个PA功放不需要匹配网络,从而提高整体效率。

3.1.2 IT设备板卡降耗

采用液冷技术进行板卡降耗,使用装有冷却液的散热管直接冷却电子设备,冷却液吸收热量后液体温度升高,可将其用作供暖等。由于液体的导热性能更均匀,相比风冷系统,能更精准地控制机框内各类板卡的温度。

3.1.3 IT设备机框降耗

(1)机柜风扇智能变速。理论上风机功率与转速成正比,业务闲时板卡耗能减少、散热量下降,可适时通过变压或变频方式调节风扇电机的转速,使轴上功率大大减少,从而实现节电。某厂家风扇功耗最高占光传送网(Optical Transport Network,OTN)设备总功耗的9%,应用智能风扇技术后检测温度并实时调整风扇转速。在设备常温状态下,风扇运行在50%转速时,测试可节省约70%的风扇功耗。

(2)分区温控。基于不同机框模块的耐温性能,选择差异化的温控系统,实现分区温控。相比统一温控,分区温控可降低温控系统总能耗约30%~70%。

3.1.4 设备定制

为了便于IT设备工作时更好地实现散热,也可对IT设备机框和机柜进行定制,通过不断优化IT设备的结构,在IT设备机框和机柜中增加热管背板、节能控制装置、节能散热装置以及节能通风装置等,尽量减少IT设备对配套设施的需求,从而达到降低数据中心整体能耗的目的[4]。

某数据中心机房位于大楼2层,机房面积约为550 m2,IT设备输入功率约为350 kW。机房室内设定温度为23 ℃,机房空调设备为8台上送风精密空调。机房局部热点现象较为突出,尤其是小型机柜附近,局部热点区域的设备散热效果较差。通过对机房内局部热点较严重的机柜加装热管背板后,可实现机柜按需供冷,有效消除了局部热点,机房空调整体能耗降低约20%。

3.2 系统级节能

数据中心机房配套设施是保障IT设备正常运行的重要基础,包括空调制冷系统、电力供应系统、照明系统以及智能管理系统等。

3.2.1 制冷系统

为了更好地设计数据中心空调制冷系统方案,以下将从风冷型空调系统、冷冻水型空调系统、水冷型或乙二醇冷却型空调系统、双冷源型空调系统等方面进行探讨[5]。

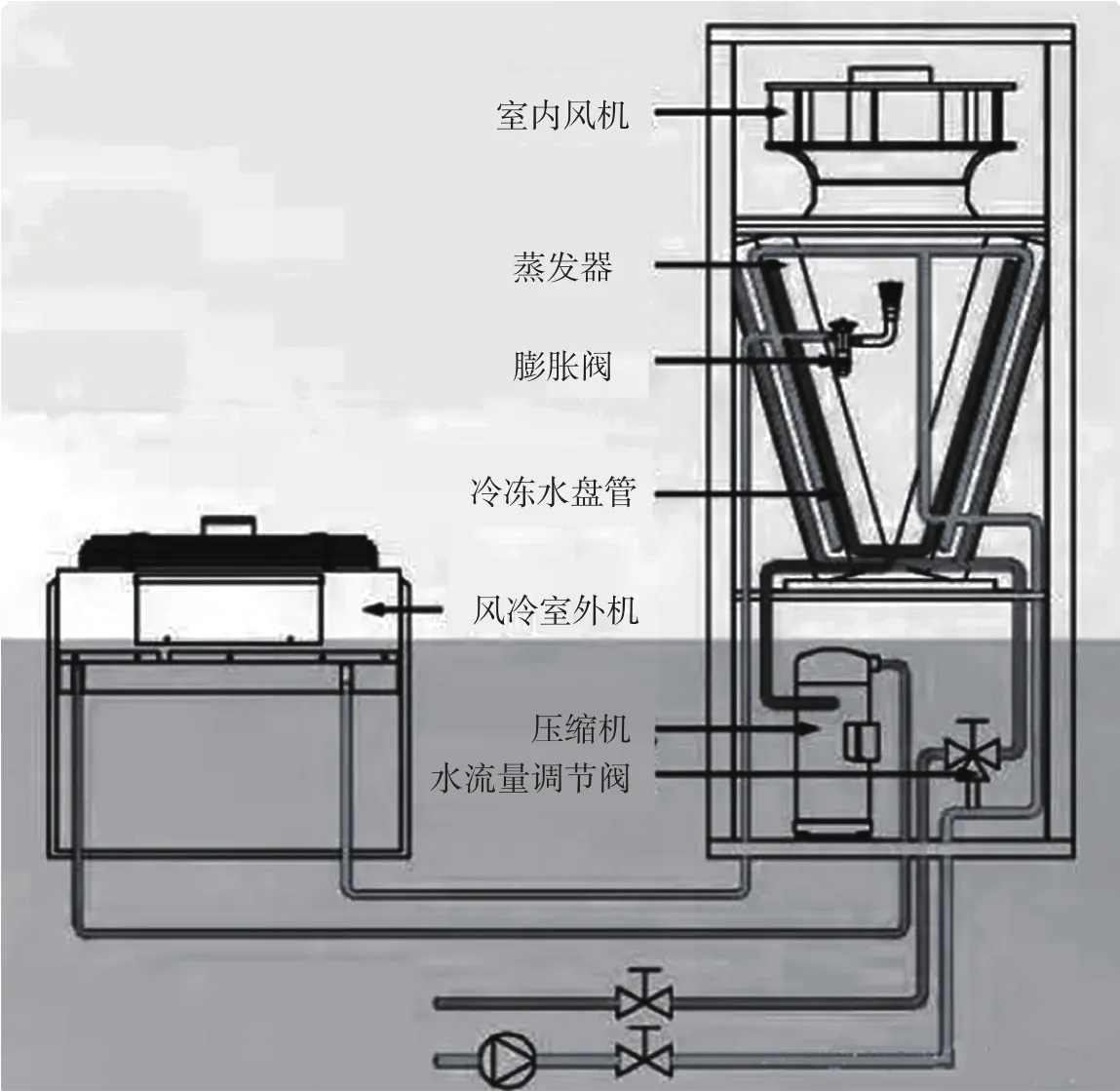

(1)风冷型机房空调系统。风冷型机房空调使用空气作为传热介质,是最常见的数据中心机房空调方案,属于直接膨胀(Direct eXpansion,DX)制冷方式。该空调自带制冷系统,各机组独立运行,室内机包含压缩机、蒸发器和膨胀阀,室外机为冷凝器风冷,室内外机组构成制冷剂闭合回路。室外冷凝器通过室外空气冷却制冷剂,将其变为常温高压液体。经过膨胀阀后,制冷剂变为低温低压气液混合物后进入蒸发器。在蒸发器内,制冷剂与室内空气热交换带走室内空气热量,制冷剂则变为高温低压气体再进入压缩机。压缩机将制冷剂压缩成高温高压气体,送入冷凝器冷却。整个制冷循环在一个封闭系统内,可以将室内的热负荷转移到室外空气。风冷型机房空调系统原理如图4所示。

优点:系统简单、安装和运维方便;机组间具有最大的独立性、没有故障关联;机房内漏水的潜在威胁小;扩容方便,可分期分批建设,节省投资。

缺点:机组噪声对周边影响大;需要足够的室外机安装位置,多台机组密集放置易造成过热;室内外机组之间的管线多,冷媒管长度有限制;室内外高差有限制,室外冷凝器不应低于室内机5 m。

应用场景:中小型机房、室内外安装距离和高差满足要求的机房、希望分批建设的机房以及要求运维简单的机房。

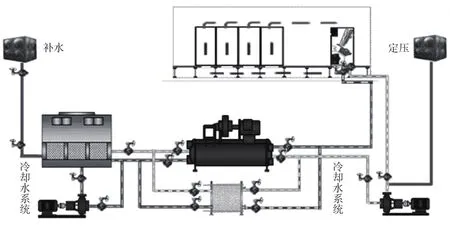

(2)冷冻水型空调系统。冷冻水型空调系统采用冷冻机组+机房空调单元方式制冷,直接引入冷冻水,通过冷冻水盘管将机房热负荷传递到冷冻水系统内,为集中冷冻水供给,自身不带制冷系统。为提高空调机组的安全性和可靠性,通常在空调机组内安装2套独立的冷冻水盘管和控制阀门,连接2套独立的冷冻水系统。冷冻水型空调系统原理如图5所示。

图5 冷冻水型空调系统原理

优点:室内机结构简单、故障少、维护量少;室外占用空间少;室内外机组之间的管线少,长度和高度几乎不受限制;冷水机组效率高、节能减排。

缺点:集中冷冻水供给、系统复杂;机房引入水管路,占用地板下空间较大,存在漏水的潜在威胁;运维管理复杂;依赖集中冷冻水,共用冷冻水管路可能导致系统风险;分期投入负载及设备时,需要提前做好系统的预留设计,扩容不方便。

应用场景:大型机房或有冷冻水集中供给的场合,制冷效率高。

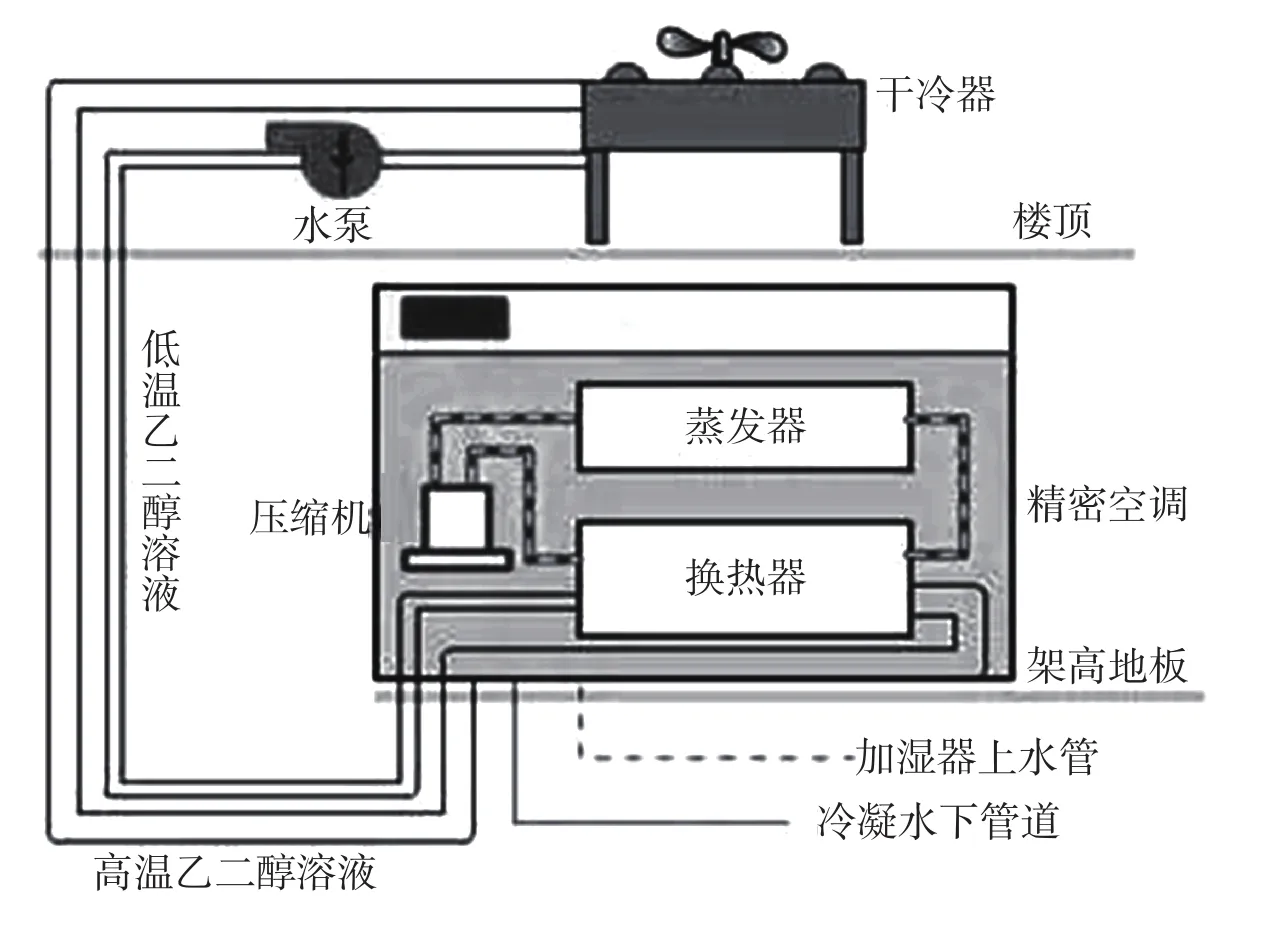

(3)水冷型或乙二醇冷却型空调系统。水冷式空调系统自带制冷系统,室内机内置的板式冷凝器为水冷,室外集中配置冷却塔,采用乙二醇防冻混合液冷却排热。水冷型或乙二醇冷却型空调系统的冷凝器和蒸发器都在室内机中,各个机组可共享冷却水管道、冷却水塔或干冷器,易于实现压缩机、干冷器等关键器件的冗余配置,在大型数据中心应用时工程量较少。乙二醇冷却型空调系统原理如图6所示。

图6 乙二醇冷却型空调系统原理

优点:能够解决管道安装距离和室内外高差问题;效率高于风冷,系统运行更加稳定。

缺点:增加了冷却水系统,系统设计复杂,总投资成本增加;非独立运行,共用冷却水管路可能导致系统风险;分期投入负载及设备时,需要提前做好系统的预留设计,扩容不方便;应用中需要注意水质问题。

应用场景:风冷型实施困难的场合。

(4)双冷源型空调系统。双冷源型空调系统结合了风冷型空调和冷冻水型空调的特点,空调内有2套制冷循环系统。对于具有独立的冷冻水机组和直接膨胀式制冷系统的双重系统,有以下2种组合。一是风冷冷凝+冷冻水,以冷冻水系统为主用,风冷系统为备用;二是水冷冷凝+冷冻水,以冷冻水系统为主用,水冷系统为备用。机组在可提供冷冻水资源但不能保证全年持续供应的场所,会优先使用冷冻水系统制冷;当冷冻水供应中断或者冷冻水水温不足以承担全部负荷要求时,会自动启动直接膨胀式制冷系统。双冷源型空调系统原理如图7所示。

图7 双冷源型空调系统原理

优点:双冷源互为备用、可靠性高;利用集中冷冻水提高能效比,节能减排。

缺点:双冷源系统复杂、初期投资高;管线多、安装和运维复杂。

应用场景:有集中冷冻水供给且可靠性要求极高的大中型机房,如交换机房和移动机房[6,7]。

3.2.2 照明系统

数据中心机房照明系统包含普通正常照明、消防备用照明、非消防备用照明以及疏散照明等,对数据中心机房照明系统可采取以下措施进行降耗[8]。对于主机房,设置普通正常照明、疏散照明和非消防备用照明;对于辅助区,如拆包区、备件库等,设置备用照明;对于柴油发电机机房、消控室等发生火灾时需要有人继续值守的场所,设置消防备用照明和疏散照明;对于不涉及消防供电的变配电房、不间断电源房,只需设置正常照明即可。主机房及辅助区正常照明和备用照明可各带50%的照明电源进行设计,即备用照明按50%设计,系统更简单且不增加建造成本。

3.2.3 智能管理系统

为了满足数据中心运维管理工作的需要,提高数据中心机房维护和管理的安全性,可以考虑建设1套可视化、智能化、远程化的三维数据中心智能监控管理系统,为数据中心机房的安全运营和高效管理提供有力保障。智能运维不仅仅是为了节省人力,更重要的是在很多细致、烦琐的调整方面,智能手段能达到比人工更加敏捷、准确的效果。智能管理系统可以实时感知服务器的运行情况,从而灵活地调整电力、散热等资源供给,有效减少数据中心的能源浪费[9,10]。

3.3 战略层级节能措施

在“新基建”背景下,数据中心应当结合5G业务应用场景特点统筹规划、科学布局。坚持立足当下、着眼未来,既统筹考虑各区域的能源供给、自然环境以及用地保障等配置资源,又注重兼顾各区域的产业环境、人才支撑、市场需求等重要因素,坚持以高规格规划为引领、以因地制宜与科学布局为导向、以按需设计与按标建设为路径,统筹推进各区域的数据中心建设。同时结合各数据中心的算力情况,构建基于云、网、边深度融合的算力网络,满足在云、网、边之间按需分配和灵活调度计算资源、存储资源以及网络资源的需求,实现数据中心能耗最优化。

3.3.1 全局统筹规划数据中心

随着5G网络的大规模部署和建设,带来了大量的数据中心需求。各地建设的数据中心缺乏统一的全局规划,分布极不均衡。国家“新基建”背景下,“东数西算”工程就是实现“一盘棋”统筹规划数据中心的关键举措。通过“东数西算”工程,将大量的数据中心建设在西部,可显著提高对西部光伏、风电、水电等绿色能源的使用,大幅减少电能传输损耗,减少碳排放。除此之外,“东数西算”能够有效激发数据要素创新活力,加快数字产业化和产业数字化进程,催生新产业、新业态、新技术以及新模式等,支撑社会经济高质量发展。

3.3.2 优化资源配置

目前,国家数据中心等算力基础设施大多分布在东部沿海经济发达的地区。中国数据中心大平台数据显示,仅北京、上海、广州3地的数据中心数量就占到全国数据中心的26%。由于数据中心耗电量、占地面积都比较大,在东部沿海地区持续大规模部署已经难以为继。我国西部地区土地资源充裕,水电、风电、光伏等可再生能源丰富,加上适宜的环境温度为数据中心的配置布局提供了得天独厚的基础优势,具备大规模布局数据中心的良好条件。通过“东数西算”工程可以充分发挥西部地区的自然资源优势,将东部地区的互联网、大数据、云计算以及人工智能等大规模算力需求转移至西部,优化东西部地区差异化的资源配置,提升资源的使用效率。

针对各行各业产生的海量数据,对于存储备份、后台加工、离线分析等对网络要求不高的数据处理业务,可考虑优先向西部地区转移,由西部地区的数据中心进行处理;对于远程医疗、工业互联网、视频通话、人工智能、金融证券、灾害预警以及无人驾驶等对网络时延、相关配套要求较高且不适于传输至西部数据中心进行处理计算的业务需求,可在东部枢纽内就近处理。

3.3.3 加强数据中心云网协同和区域协同布局

为了满足在云、网、边之间灵活调度、按需分配资源以及数据存储的需求,构建基于云、网、边深度融合的算力网络,对数据中心网络架构进行扁平化改造。企业上云是数字化转型改造发展的重要途径,尤其是对于资金投入相对有限的中小型企业,云化发展能降低企业数据算力使用的成本。“东数西算”工程能够很好地平衡调度资源,可以将东部地区海量的上云数据存储、算力挖掘需求牵引到西部,缓解东部地区的存算压力。对于东西部均衡布局算力设施、提供算力的企业来说,将有效加快实现云网协同、区域协同,提供多层次算力服务,增强算力服务品质,同时降低网络、电力等成本,提升资源使用效率。

数据中心的建设要求高、专业性强、周期长、投资大,为了更好地规划建设数据中心,应根据国家发展战略和业务需求合理布局。根据IT业务需求合理确定数据中心的建设等级标准、机架数量和功耗、PUE指标等关键因素,并相应确定互联网数据中心(Internet Data Center,IDC)规模和建设方案,实现建设与需求匹配。数据中心选址时应注意周边的电力和供水是否可靠充足、通信网络带宽是否足够且可高速直连、市政交通是否便捷方便,应远离水灾、地震等自然灾害隐患区域。数据中心机楼应在满足政府用地规划指标的原则下,根据IT设备需求和机电各专业工艺需求合理规划。

对于IT设备具体需求尚不明确的数据中心,可采用钢混建设模式,参考目标客户通用需求确定机楼的建筑层高、柱网尺寸、楼板承重等,并预留可灵活满足不同功耗、不同建设标准的机房空间,实现土建通用化、机电定制化。机房应模块化布局,便于灵活按需分期建设,减少传输损耗。对于IT设备和工艺需求已明确的数据中心,可进行更有针对性的设计,例如仓储式钢结构数据中心、堆叠式集装箱数据中心等[11,12]。

4 结 论

随着数据中心规模的扩大,其能耗也在不断增加。从节约能源、保护环境的角度出发,应采取适当的措施对各地区大中型数据中心的建设进行规范,在确保“双碳”目标实现的前提下,完成对用户需求的支撑。相关企业需要继续加大对数据中心节能领域的研发投入,推动数据中心朝着低碳化、智能化方向发展,共建绿色美好未来。