基于深度学习的高速公路免划线事件检测系统

傅宏伟

(广东飞达交通工程有限公司,广东广州510000)

0 引言

高速公路上的交通异常事件导致出现重大交通事故隐患。依靠人工巡检监控视频方式检查交通异常事件难以保证效率以及及时性。近年来,随着图像处理算法以及硬件设备的发展,深度学习算法在视频检测应用方面取得很好的效果。陈波等人利用残差网络模型的图像识别技术实现对隧道内的交通流量、交通拥堵等方面进行监测[1]。高新闻等人利用YOLOv3和改进的SORT算法对检测目标进行异常情况自动判断,帧级检测精度高,达到实际场景的应用要求[2]。李海生等人利用基于深度学习算法开发的事件检测系统应用于珠海机场高速,对违法停车、拥堵、行人等事件进行预警,准确率达到了96%,极大降低了人工成本[3]。

针对事件检测系统当前的问题,即部分高速公路周围存在省道、乡道或者其他公路,以及高速公路场景外存在行人等情况,系统检测整个摄像机画面会导致误报增加。

另外,监控人员需轮询实时视频,频繁转动摄像机或摄像机未停留在预置位等行为都会降低检测的准确率。当前事件检测系统解决此问题方案是:获取摄像机的某个预置位画面后,通过人工方式划分检测区域。

同时,摄像机为球机时,需针对多个预置位画面划分检测区域。当摄像机偏移预置位时,系统停止识别检测。该方案增加了人工维护成本,同时降低了系统的灵活性。

因此,提出一种免划线自适应检测区域的事件检测系统方案,利用EfficientPS全景分割算法识别交通场景的各类目标,根据不同等级的识别粒度提供对应结构化的识别结果,提升高速公路场景的全要素识别能力[4]。另外,结合视频时间维度的信息数据,优化识别结果的稳定性和精准性,实现自动分析高速公路范围内的交通异常事件,减少人力投入。

1 技术路线

1.1 总体框架

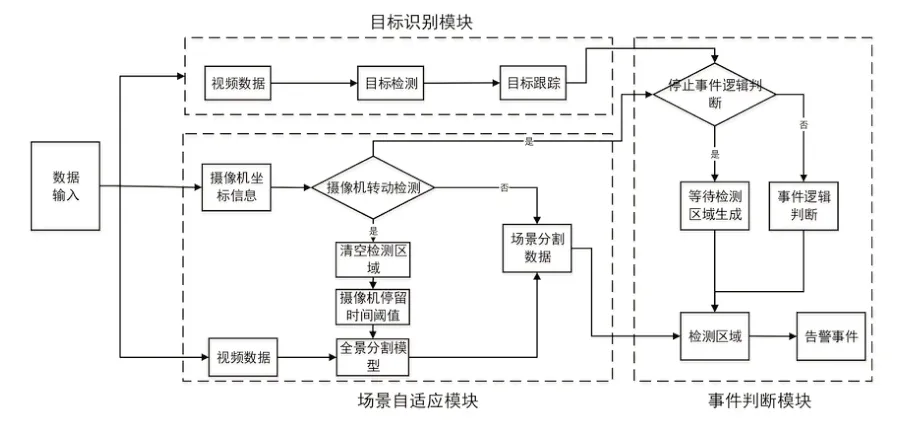

系统采用先进的深度学习、人工智能及计算机视觉等技术,实现实时检测高速公路范围内的交通异常事件。系统是以YOLOv5目标检测算法、DeepSORT目标跟踪算法和EfficientPS全景分割算法为核心,基于DeepStream的深度学习应用框架开发的一套具有快速检测、高精度识别、稳定运行的系统。系统总体框架如图1所示。利用DeepStream组件解码监控网摄像机的录像视频流或实时视频流以获取图像数据;YOLOv5挖掘每帧视频图像数据中感兴趣的目标类别,并获取相关目标的位置信息;DeepSORT目标跟踪算法基于目标检测信息,结合视频的时空特征,精准分析目标轨迹姿态,并通过目标轨迹判定感兴趣的目标是否为异常停车、违规行人、拥堵事件、抛洒物等交通异常事件。

图1 系统总体框架

为了实现免划线自适应检测区域,系统引入全景分割算法,利用基于EfficientPS深度学习网络的像素级图像全景分割技术,分析视频图像的场景数据,完成对高速公路交通场景的像素级全要素理解,识别交通场景中的标识、标线、护栏、绿化带等重要目标,精准定位分析发生在高速公路范围内的事件,实现自动结构化检测区域功能。

1.2 目标检测与跟踪算法

1.2.1 基于YOLOv5目标检测

YOLOv5目标检测算法的特点是在输出层直接回归预测检测目标的位置信息和类别信息,其检测精度高,检测速度快,适合应用于实时检测等场景。YOLOv5的主要框架由输入端、Backbone Network、Neck Network和输出层四部分组成。

(1)输入端

模型输入端采用Mosaic数据增强、自适应锚框计算和自适应图像缩放等图像处理技术,丰富图像样本的多样性,减少信息参数冗余,加快模型收敛速度,增强模型的小目标检测。

(2)Backbone Network

Backbone模块CSPDarknet网络提取目标特征,Focus负责对特征图进行切片操作。该模型网络将梯度信息融合到特征图中,优化网络参数,有效减少梯度信息重复的现象。该方法使模型变小,同时提高模型的推理速度和准确率,可满足工业级实时检测需求。

(3)Neck Network

Neck Network采用FPN和PAN结构,结合两种网络,使浅层特征强定位特征和深层特征强语义特征双向传递,聚合不同层次的特征信息,增强模型的特征融合能力,提高同一物体在图像中展现不同大小和尺寸形态时的识别效果。

(4)输出层

输出层的检测框预测采用回归损失函数CIOU_Loss。该函数可最大化利用检测框间的重叠面积、中心点距离、长宽比等重要的几何因素,很好地识别遮挡重叠物体,有效提高预测框回归的检测速度和精度。

1.2.2 基于DeepSORT多目标跟踪

DeepSORT基于SORT多目标跟踪算法改进,针对SORT跟踪算法目标ID频繁切换和遮挡时间长无法跟踪等问题,设计了一种结合目标行为和特征信息进行跟踪的关联方式,能有效提高目标跟踪的准确率,对高速公路目标行为分析起到关键作用。DeepSORT主要工作流程如下。

(1)特征提取

利用目标检测算法获得目标检测框,根据检测框提取视频帧中的所有检测目标数据,对目标进行外观特征和运动特征提取。

(2)特征匹配

结合目标的外观和运动特征,计算目标的特征相似性,得到目标的前后两帧视频的匹配度。

(3)数据关联

对外观和运动两种度量方式进行线性加权后,作为最终的度量。利用匈牙利算法关联的代价矩阵对数据进行关联,为每个对象分配目标的ID,实现检测目标跟踪。

1.2.3 目标跟踪关联目标检测

DeepSORT目标跟踪的前提是定位到目标物体。YOLOv5目标检测算法的精度高、速度快等特点可为DeepSORT提供准确的目标框信息。因此,系统以YOLOv5作为目标检测算法,结合DeepSORT目标跟踪,实现对正在运行的高速公路交通异常事件的精准分析。

1.3 图像分割算法

场景理解在交通领域被广泛应用,图像分割算法是场景理解的技术之一。对于高速公路事件检测系统,仅分析高速路上的交通异常事件无法满足客户需求。当事件发生在非高速公路区域内时,此事件定义为无效事件,故如何准确判断事件发生于高速区域内尤为重要。当前的解决方案是通过人工指定相关区域,但该方法存在一个缺点:当摄像机转动时,配置区域无法适配转动后的场景,导致产生误报的情况。为了解决该问题,系统引入图像全景分割算法,自动识别高速公路场景内的物体,如路面、车道线、绿化带等,结合交通异常事件发生的位置信息,可判断事件发生在高速路区域内还是非高速路区域,减少摄像机转动后识别事件的误报率。

1.3.1 基于EfficientPS网络的高速公路全景分割算法

全景分割于2018年由Kirillov等人首次提出,意在融合语义分割和实例分割的特性,为每一个像素点划分类别和实例ID,同时提出了一种评价全景分割算法指标的方法,使得全景分割受到广泛关注。EfficientPS全景分割算法由Valada等人提出,该方法包含共享网络、双向FPN以及实例和语义分割头等。EfficientPS网络能够更好地利用目标特征信息,更准确地细化边界,在多种图像分割数据集上取得精准的效果。

1.3.2 自适应场景事件检测实现路线

系统利用全景分割算法对高速公路场景进行自动识别,实现流程如图2所示。启动任务时,系统捕获当前摄像机的视频数据输入目标识别模块和场景自适应模块,同时将获取的摄像机信息传输到场景自适应模块。目标识别模块根据视频数据获取检测目标信息,以进行事件逻辑判断。场景自适应模块将获取的视频数据输入全景分割模型,对视频数据中的高速公路进行场景分割。当检测到摄像机转动状态时,系统下发指令停止事件逻辑判断,同时清空转动前的高速公路场景数据。当摄像机停止转动且停留在某位置超过设置时间阈值时,系统重新生成高速公路场景数据并恢复事件逻辑判断。通过全景分割模型理解高速公路场景布局,分析高速公路区域位置,精准定位交通异常事件是否发生于高速公路范围内,实现场景自适应功能。

图2 自适应场景与检测事件流程图

2 基于深度学习的免划线自适应场景事件检测试点路段

紫惠高速起点位于河源市紫金县南部,终于惠州市平潭镇,于2020年12月28日正式通车运营。系统对该路段的停车事件和行人事件实施检测。其中,两类事件的判定规则如下。

停车事件:车辆停止在高速公路区域内超过20s,则判定为停车事件。

行人事件:在高速公路区域内出现行人,则判定为行人事件。

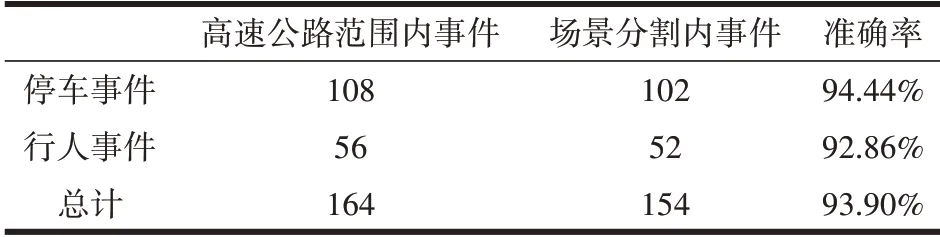

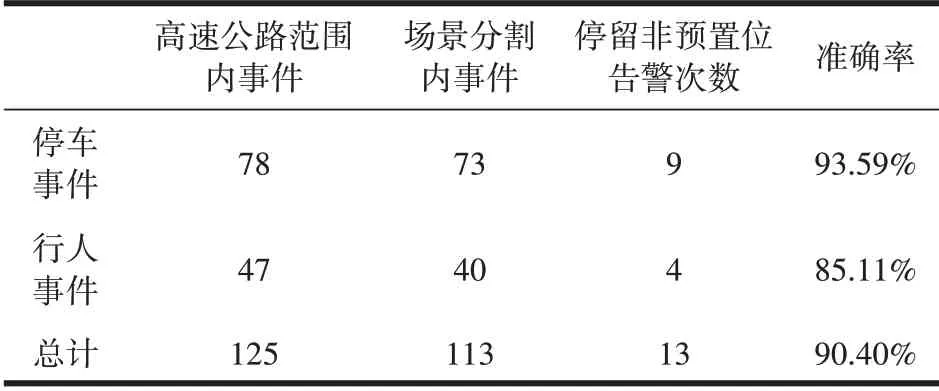

对系统在2022年5月15日—5月20日的检测数据进行统计,总共测试32路摄像机,人工统计该时间段发生在高速公路范围内的所有事件数量和发生在自适应检测区域范围内的事件,统计结果见表1。从表1可知,系统自动判断发生在高速公路范围内事件的准确率达到93.9%。对摄像机转动自适应场景检测,对系统中某一摄像机A识别数据进行统计,时间为2022年5月15日—6月30日,期间摄像机A总共转动141次,未停留在预置位13次,统计结果见表2和表3。

表1 32路摄像机发生于高速公路范围内事件数据统计

表2 A摄像机发生于高速公路范围内事件数据统计

表3 A摄像机停留在非预置位上高速公路范围内事件数据统计

3 结语

针对事件检测系统人工划分检测区域以及适应球机转动检测效果差的问题,提出利用深度学习方法自适应场景的事件检测方案。系统基于YOLOv5目标检测和DeepSORT目标跟踪算法检测目标信息,获得精准的检测准确率。同时,系统引入EfficientPS全景分割算法,在无人工介入的情况下,自动识别高速公路的区域信息,且在摄像机转动时,系统通过AI监测监控,有效提高监管人员的工作效率。在下一步工作中,将继续对全景分割模块进行素材和参数优化,提高准确率。同时在保持检测精度的情况下,减少YOLOv5和DeepSORT模型的参数量规模,以提高检测速度。