深度学习在光学和SAR影像融合研究进展

成飞飞,付志涛,黄亮,2,牛宝胜,陈朋弟,王雷光,季欣然

1.昆明理工大学 国土资源工程学院,昆明650093;

2.云南省高校高原山区空间信息测绘技术应用工程研究中心,昆明650093;

3.西南林业大学 大数据与人工智能研究院,昆明650024

1 引言

随着对地观测卫星多传感器、多时间和多分辨率影像数据的出现,各种影像数据在应用方面展示了优势和特色,而在实际应用中单一传感器场景信息量、分辨率和光谱方面表现出一定的局限性,难以满足日常应用的需求(Ghamisi等,2019)。因此,多源影像融合已成为影像融合领域引人注目的研究方向,它是将从不同传感器获得的不同类型的影像进行信息融合,以提高同一区域数据所包含信息的准确性和技术的丰富性(Goshtasby和Nikolov,2007),不同影像通过信息互补的融合,可以充分发挥多传感器数据优势,更适合人类视觉感知,提高人们对地物判断和解译的能力,从而扩大影像的应用范围。目前影像融合已被广泛应用于遥感影像融合(Ghassemian,2016;Zhong等,2016;Pandit和Bhiwani,2015)、可见光和红外影像融合(Li和Wu,2019;Ma等,2019)、多聚焦影像融合(Yang等,2017;Liu等,2017b)、多曝光影像融合(Prabhakar等,2017;Zhang,2021)、医学影像融合(Liu等,2017a;Song等,2019)等方面。

影像融合研究已有近40年的历史,特别是随着新技术的不断出现和新方法的不断革新,影像融合取得了长足发展。图1显示了过去20多年(1996年—2019年)由科学引文检索(SCIE)在国际期刊上发表的相关文章数量(统计数据来自WOS(Web of Science)核心馆藏数据库)(图1(a))和来自中国知网发表论文的数量(图1(b))。从图1中可见,近年来增长趋势明显,主要得益于机器学习、深度学习等方面的快速兴起,表明了该研究领域的热点在不断增强,未来影像融合将会出现更多的研究成果,图2为影像融合效果图(Shakya等,2020)。

图1 影像融合领域的发表文章数量Fig.1 Number of articles in the field of image fusion

图2 影像融合效果展示(Shakya等,2020)Fig.2 Display of image fusion effect(Shakya et al.,2020)

针对数据源的多样性、融合算法的复杂性、融合效果的差异性(李盛阳等,2017),研究学者提出了多种影像融合方法,一般将其分为两类:基于空间域的融合方法和变换域的融合方法(Stathaki,2008;Liu等,2018),传统的方法需要通过人工构建融合规则或融合知识库(李盛阳等,2017),给影像融合带来了诸多困难和不确定性。

随着深度学习的发展,基于CNN的神经网络被广泛应用于影像融合领域,特别是在遥感大数据时代,深度学习在特征提取和数据表达方面具有良好的特性,已经取得了显著的突破,不断推动影像融合的发展(Sun等,2020)。深度学习已经成为遥感影像融合发展的必然趋势(Schmitt等,2017)。它通过训练多层卷积网络,在损失函数约束下实现自动提取影像特征信息进行融合,克服了传统方法中不能自适应权值和需要通过手工构建融合规则的缺陷,在融合领域取得了显著成效(Liu等,2018)。近年来一些研究人员提出了基于深度学习的影像融合方法(Shakya等,2020;Kim等,2018;Xia等,2019),可以应对复杂的遥感影像场景,特别是作为遥感影像融合领域的一个重要分支,光学和SAR影像融合可以得到互补性很强的影像。因此,光学和SAR影像融合是目前学术研究的热点问题,值得进一步深入研究。

在研究进程中,李树涛等(2021)对全色、多光谱、合成孔径雷达等9种多源遥感影像的进行介绍,阐明了多源遥感影像融合方法的研究现状与面临的挑战性难题。目前,对光学与SAR影像融合的研究相对较少,Kulkarni和Rege(2020)对像素级的光学与SAR影像融合进行详细的阐明,但基于深度学习方面的光学和SAR影像融合相对描述较少。然而基于深度学习的影像融合研究已经成为融合领域的前沿和热点(Li等,2020;Feng等,2019a;Gao等,2019;Grohnfeldt等,2018)。通过研究发现目前还没有专门针对深度学习在光学和SAR影像融合进展的综述性文献,因此,本文主要针对近几年深度学习在光学和SAR影像融合方法及其研究未来方向展开分析和探讨,力图指出光学和SAR影像融合所存在的问题和不足,为研究人员提供更多的研究思路与方法,推动光学和SAR影像融合领域发展。本文的主要贡献包括:

(1)将现有光学和SAR影像融合方法分为两大类:传统融合和深度学习融合方法,重点梳理了基于深度学习在影像融合方面的最新工作,并简要评述和方法对比。

(2)归纳总结了光学和SAR影像融合领域中常用的数据集,并做了简要介绍。

(3)最后指出了当前光学和SAR影像融合方法研究面临的问题和挑战,对未来发展方向进行了展望。

2 融合方法

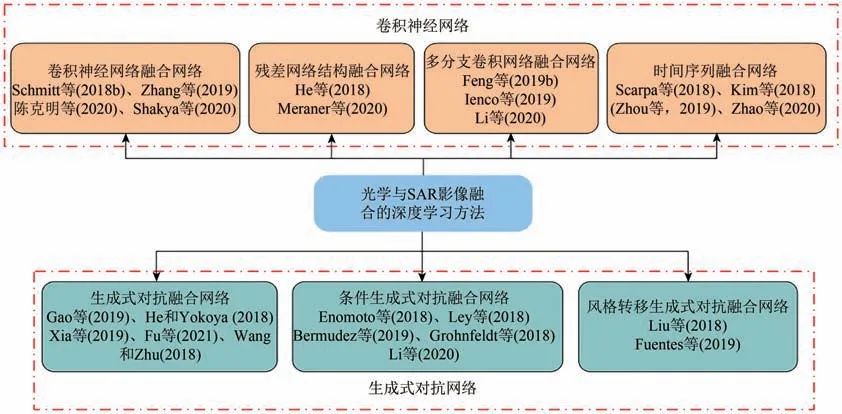

传统影像融合方法一般可分为两类:基于变换域和空间域的融合方法(Ranchin等,2003;Stathaki,2008;Liu等,2018)。随着光学和SAR融合影合的快速发展,深度学习已成为光学和SAR影像融合领域中重要的研究方法。其中,卷积神经网络、生成式对抗网络等深度学习模型已成功应用于影像融合(Kim等,2018;Grohnfeldt等,2018)。基于此,本文将光学和SAR影像融合方法分为两类:传统方法和深度学习方法,其中,深度学习方法分为卷积神经网络和生成式对抗网络方法(图3)。

图3 深度学习融合方法Fig.3 Deep learning fusion method

2.1 传统方法

SAR影像与光学影像之间存在成像差异大、空间分辨率差异大以及光谱失配等诸多挑战,导致融合后的影像存在空间和光谱失真(Kulkarni和Rege,2020)。经过将近40年的发展,许多融合方法都已经成功地应用于光学和SAR影像融合。

基于空间域的融合是一种简单而快速的融合方法,直接对像素进行操作获取融合结果,主要有IHS、Brovey、PCA、GS、加权平均法等方法(贾永红,1998;Chen等,2010;Manaf等2016;万剑华等,2017)。变换域方法作为影像融合领域最流行的算法之一,近些年得到广泛的发展与应用(Ghamisi等,2019)。主要分为多尺度变换(Chou等,1993;李晖晖 等,2009;Xu和Cheng,2015;易维等,2018)和基于模型(Chandrakanth等,2011;El-Taweel和Helmy,2014;Wang和Chen,2016)方法,其中多尺度变换方法包括金字塔变换、小波变换、脊波变换、剪切波变换、曲波变换、NSCT、NSST等,模型方法包括脉冲耦合网络(PCNN)、稀疏表示(Zhang等,2016)等,Kulkarni和Rege(2020)对传统的光学与SAR影像融合像素级方法进行详细的论述。

综上所述,传统的方法包括变换域和空间域融合算法。空间域融合方法简单直观、融合速度快,适合实时处理,但简单的叠加运算的融合规则会大幅度降低影像融合的精度,而且融合结果存在一定的光谱扭曲,导致融合影像中细节信息的对比度和清晰度下降,主要将空间域的方法与其他方法结合使用(Dupas,2000;Huang等,2005;Shao等,2020)。在变换域算法中,特征提取用多尺度变换的分解系数来表示,可以提供了平移不变性和多方向性(Xu等,2015;El-Taweel和Helmy,2014)。然而,由于计算成本的限制和算法实现的困难性,在实际应用中,充分考虑影像融合速度等方面的问题。无论是变换域算法还是空间域算法,特征提取都是通过人工设计的滤波器获得,因此设计一种理想的特征提取方法或融合规则仍然是一项艰巨的任务。深度学习的不断发展为特征提取与融合规则选取困难等方面提供了可行的解决方案。

2.2 深度学习方法

深度学习是影像融合领域中热门的研究方法。目前卷积神经网络、生成式对抗网络等(图3)深度学习模型已成功应用于光学和SAR影像融合(Kim等,2018;Grohnfeldt等,2018)。为了更清楚的展示融合方法,图4表述了3种不同的网络模型框架,表1进行不同方法结果分析。本节主要从以下两方面介绍基于深度学习的光学和SAR影像融合方法。

图4 3种不同网络框架图Fig.4 Three different network frameworks

?

2.2.1卷积神经网络

CNN是当前影像处理领域最流行的一种模型。对CNN的研究始于20世纪80至90年代,LeNet-5(LeCun和Bengio,1995)等网络是较早出现的卷积神经网络。随着深度学习理论的不断提出和计算机强大的运算效率,CNN得到了快速发展,CNN能够从原始影像中通过网络层学习抽象特征,其中提取的特征不仅具有平移、旋转、缩放不变的特性,而且具有很强的泛化性,可广泛应用于影像融合中(Sun等,2020)。由于光学和SAR影像的成像差异性较大,为实现多尺度特征的提取,Li等(2020)、Feng等(2019b)和Ienco等(2019)提出了采用多通道的多分支网络。Li等(2020)首次采用双线性池化层的融合网络对光学和SAR影像提取的特征进行融合,利用通道注意力探索影像各通道间的关系;Feng等(2019b)提出了分支CNN网络,从SAR和多光谱影像中分别提取特征;Ienco等(2019)利用异构孪生网络(TWINNS)融合Sentinel数据,利用Sentinel影像的空间和时间两个层次的互补性对影像的多尺度特征进行提取,获得比单支网络更好的效果。

为解决影像之间的非线性问题,将残差网络引入影像融合领域,He和Yokoya(2018)将单一SAR影像的输入扩展为多时相光学和SAR影像数据集,利用具有非线性的残差网络对光学和SAR融合影像进行光学影像模拟;同样Meraner等(2020)利用残差神经网络,提出SEN12MS-CR去云的数据集,利用光学和SAR影像融合比单纯依靠光学影像转换的结果包含了更多的结构信息,重建了缺失信息。

为了更好利用具有时间序列的影像数据,Scarpa等(2018)、Kim等(2018)、Zhao等(2020)和Shakya等(2020)利用Sentinel-1和Sentinel-2时间序列的影像进行融合。Scarpa等(2018)采用简单的3层体系结构耦合网络,结合随机梯度下降算法,使融合后的效果优于单幅影像;Kim等(2018)提出基于上下文信息序列CNN模型,验证了深度学习模型具有协同光学和SAR影像的潜力;Zhao等(2020)利用循环神经网络建立光学和SAR影像之间的关系,为丢失的光学时间序列提供了可靠的参照;Shakya等(2020)采用结合3种不同金字塔的CNN来融合Sentinel-2与Sentinel-1的VV和VH波段,融合影像的分类性能有所改善。上述方法充分验证时间序列影像融合可以提高应用,还可以进行缺失信息的补全。

为了克服传统方法中手工提取特征困难和SAR影像难以彩色化的问题,陈克明等(2017)利用CNN实现了光学遥感影像和SAR遥感影像自动融合;Zhang等(2019)在AlexNet网络基础上训练了13层的网络融合提取影像的特征,解决了需要手动提取特征的问题,更好地实现影像智能化的融合;Schmitt等(2018a)利用自动编码器以及混合密度网络,从已配准的Sentinel-2影像集中训练样本学习Sentinel-1影像进行彩色化,进而进行影像解译。传统的融合算法还无法解决SAR影像缺少彩色信息的问题,该方法为影像彩色化迈出重要一步。

综上,基于卷积神经网络的深度学习融合算法在过去的几年中已经取得了长足进步,融合算法克服了手工提取特征的困难,得了较为良好的效果,融合后的影像提高了SAR影像的可解释性,更好地挖掘了光学和SAR影像的信息,弥补了光学影像信息缺失的问题,同时也为传统方法融合算法不能实现彩色化迈出了重要的一步。

为了进一步提高影像融合的效率,研究者开始探索利用更加轻量化和无监督深度学习方法进行影像融合(Jung等,2020;Cheng等,2021)。目前大部分卷积网络是有监督的学习,严重依赖具有标签的数据,需要提前把不同的影像数据构建标签,将标签信息输入到神经网络中监督训练的模型获得融合影像(Chen和Bruzzone,2019)。由于SAR影像的复杂性难以构建良好的标签数据,生成式对抗网络的出现为无监督学习提供了更好的策略,克服了监督学习需要大量标签数据的局限性。

2.2.2 生成式对抗网络

Goodfellow等(2014)提出的生成式对抗网络(GAN)是深度学习领域中最受欢迎的网络之一。根据博弈论原理,GAN由生成器和判别器两个网络组成,生成器的目标是学习一个潜在空间,通过它可以与训练数据相同的分布中生成样本,而判别器作用是试图学习区分样本是否是由生成器生成还是来自训练数据。随着生成式对抗网络的发展,出现了许多通用变体,如:CGAN(Mirza和Osindero,2014)、CycleGAN(Zhu等,2017)和Pix2pix(Isola等,2017)等,极大地推动了光学和SAR影像的融合进展,为光学和SAR影像融合提供了新的方法。

Gao等(2019)将SAR影像转换为光学影像,并进行融合以填充光学影像的云区,为异源影像融合提供了一种新的思路,利用GAN来增强影像之间的相关性,使影像转换后更易补全遮挡信息。为了更好利用光学和SAR影像之间的互补信息,通过改进原来的GAN网络,提高融合的效率和视觉效果,He和Yokoya(2018)在判别器中采用patchGAN网络提高多时相数据融合的光学影像仿真效果,但仍有部分存在模糊现象;Xia等(2019)利用X-MTGAN的端到端生成器合成目标光学影像,弥补多时相光学和SAR影像缺失信息;Fu等(2021)提出多级级联残差连接的GAN框架,实现光学和SAR影像之间的相互转换;Wang和Zhu(2018)利用GAN和CNN的级联网络进行影像去斑和彩色化,利用影像翻译方式,使SAR影像生成了高质量的可见光影像。

为了提高SAR影像的可解释性,可将条件生成式对抗网络引入融合领域。例如,Grohnfeldt等(2018)提出一种SAR-OPT-CGAN条件生成对抗网络结构,专门用于处理SAR和多光谱影像融合,该模型利用SAR影像进行信息辅助,比使用单传感器多光谱(MS)影像更好地重建多光谱影像;为了进一步利用条件生成对抗网络进行影像融合研究,Enomoto等(2018)利用条件生成对抗网络在去相干斑噪声方面具有较强的鲁棒性;Bermudez等(2019)采用条件生成对抗网络用于多模态/多时相影像合成丢失或损坏的多光谱光学影像的恢复;Ley等(2018)利用条件生成对抗网络将SAR影像转换成光学影像的来区分不同的陆地表面。但上述方法对影像的信息约束比较弱,为此Li等(2020)提出改进的条件生成对抗网络的SAR到光学影像转换方法,将SSIM和L1范数结合的损失函数增强了影像之间的约束,提取的光学影像具有良好的视觉效果。

为了更好地应用风格转移生成式对抗网络(CycleGAN),Fuentes等(2019)归纳研究了条件生成对抗网络中优化、前景和局限方面的关键问题,提出了自适应的条件生成式对抗网络,用生成基于光学和SAR影像组合的SAR影像进行训练。虽然提高了SAR影像的解译性,但CycleGAN生成的场景有很大差异,即农村/半城市化区域较好,城市区域较差。因此,Liu等(2018)利用CycleGAN生成对抗网络应用于光学和SAR影像之间的转换,使用未配对的高分辨率SAR样本和光学样本进行训练,验证了影像转换的可行性。

综上,生成式对抗网络的出现为光学和SAR影像融合的带来了机遇,大量研究证明了影像翻译进行信息融合的可行性,并展示了深度学习方法在影像融合中的潜力。尽管生成式对抗网络融合模型的性能令人满意,但一些特殊的地物和纹理信息没有得到很好的转换(Liu等,2018),今后仍有很大的发展与改进空间。

3 影像数据集

数据集在深度学习影像融合领域中具有重要作用,针对性强、数据量充足的数据集是训练优良融合模型的关键。训练数据集不同,训练出的模型就会存在差异,直接影响网络训练结果。为了方便研究,过去的几年中学者们陆续发布了光学和SAR影像方面的数据集,如SARptical(Wang和Zhu,2018)、SEN1-2(Schmitt等,2018a)、SEN12MS(Schmitt等,2019)和QXS-SARPOT(Huang等,2021)等。图5为SARptical数据集示例,背景点云是TerraSAR点云和光学点云的融合,点云的颜色代表高度,矩形标记了两个示例的区域;图6为SEN1-2数据集示例,第一行是Sentinel-1 SAR影像,第二行是Sentinel-2 RGB影像;图7为SEN12MS数据集示例,从左到右,Sentinel-1 SAR、Sentinel-2 RGB、Sentinel-2 SWIR、IGBP土地覆盖图和CCS土地覆盖图;图8为QXS-SARPOT数据集示例,第一行是高分3号SAR影像,第二行是谷歌地球多光谱影像。每一个数据集详细的描述见表2所示,表中主要描述了数据集的影像来源、数据的详细信息和下载链接等。

表2 光学和SAR影像数据集介绍Table 2 Introduction of optical and SAR image datasets

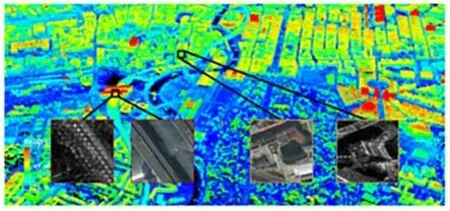

图5 SARptical数据集示例(Wang和Zhu,2018)Fig.5 Example SARptical dataset(Wang and Zhu,2018)

图6 SEN1-2数据集示例(Schmitt等,2018a)Fig.6 Example of SEN1-2 dataset(Schmitt et al.,2018a)

图7 SEN12MS数据集示例(Schmitt等,2019)Fig.7 Example of SEN12MS dataset(Schmitt et al.,2019)

图8 QXS-SARPOT数据集示例(Huang等,2021)Fig.8 Sample QXS-SARPOT dataset(Huang et al.,2021)

4 结语

随着深度学习技术的不断发展,影像融合效果得到显著提升,但光学和SAR影像融合(李树涛等,2021)一直难以获得理想效果,主要原因如下:(1)SAR影像由于其自身成像机理,会受到严重的相干斑噪声干扰;(2)成像存在严重的差异,融合常会出现对比度低、重要信息丢失以及光谱扭曲严重等问题。深度学习被广泛应用于遥感影像的融合,取得了一定的研究成果,在研究中依然存在光学和SAR影像融合数据集少(Schmitt等,2018b)、基于时间序列的光学和SAR影像融合研究少(Zhou等,2019)、缺乏统一的评价指标(Kulkarni和Rege,2020)以及算法复杂等问题。因此,今后的主要研究方向可以归纳为以下几个方面:

(1)数据集。深度学习方法中为了训练和评估深度学习模型,需要大量的训练数据。SAR影像由于其复杂性而很难标注,所以对于光学和SAR影像融合具有很大挑战。虽然在基于深度学习的光学和SAR影像融合中已经公开了SARptical(Wang和Zhu,2018)、SEN1-2(Schmitt等,2018b)、SEN12MS(Schmitt等,2019)和QXS-SARPOT(Huang等,2021)等数据集,但仍需要开发更多的数据集来支撑该领域的发展与应用。

(2)时间序列。遥感影像时间序列是监测地球表面随时间演变的影像(Zhou等,2019),Sentinel-1和Sentinel-2等卫星可以提供密集的时间序列。将时间序列光学影像作为SAR数据的补充信息,提高了遥感影像信息的利用程度,具有更高的精度(Shakya等,2020)。时间序列的研究对光学和SAR影像融合发展具有非常重要的意义,今后需要加强时间序列的融合与应用。

(3)融合评价体系。融合评价指标是影像融合的重要组成部分,目前在影像融合方面没有固定的融合评价体系,通常的做法是选择几种指标衡量结果,导致融合结果没有标准对比,使得目前的很多影像融合算法不具备直接的可比性。为了解决这个问题,Zhang等(2020b)建立了VIFB(Visible and Infrared Image Fusion Benchmark),它是可见光与红外影像融合领域的第一个基准,也是整个影像融合领域的第一个基准,但当给定的影像和内容发生改变时,评价指标对于不同情况的性能不再具有普适性,因此融合评价方法也需要随之改变。融合结果缺乏一个统一的评价指标来评价融合算法的性能,制定适合于光学和SAR影像融合领域的评价指标体系是首要任务。融合评价指标作为一个重要的研究方向,是实际应用中迫切需要解决的问题。

(4)算法轻量化。神经网络中有数以千万计的网络参数需要参与计算,致使网络结构复杂和运算量大等缺点(Cheng等,2021),因此难以植入嵌入式设备。随着网络模型层数越来越深,参数越来越多,减少计算量大小和降低损耗至关重要,特别考虑到遥感影像的特殊性和复杂性,在设计影像融合算法时需要考虑计算速度和内存问题。如何得到实时、可靠和稳健的融合算法并将其植入到嵌入式设备也是未来研究的一个热点。

总之,光学和SAR影像融合是一个非常活跃的领域,本文通过综合分析国内外光学和SAR影像融合方法进行了分析和总结,基于深度学习的影像融合研究已经取得了较大进展,涌现出大批优秀卷积神经网络和生成式对抗网络融合模型,但目前基于深度学习的遥感数据融合的数据集、模型方法相比医学影像、多聚焦影像融合研究较少,今后还有很大的研究和探索空间。最后,指出了光学和SAR影像融合未来可能的几个研究方向,为深度学习中光学和SAR影像融合及相关领域的研究人员提供借鉴和参考。