人工智能将走向哪里:思维机器会出现吗?

孙 会

(南京大学 哲学系,江苏 南京 210023 )

一、引 言

当前,人类社会正在进入一个技术变革时期,其中,以人工智能为代表的新一轮前沿技术在学界掀起了一股讨论热潮。人工智能在很多领域的表现已经达到甚至超越了人类的水平,如计算速度、搜索能力、深度学习等。一方面,在人工智能的推动下,人们正享受技术带来的快捷与便利;另一方面,人工智能也引起了很多学者的批评,代表人物有罗杰·彭罗斯(Roger Penrose)和休伯特·德雷福斯(Hubert Dreyfus)等。其中,作为数学家和物理学家的彭罗斯对于人工智能的观点出自他的《皇帝的新脑》(Emperor’sNewMind)一书,他认为人的意识并非算法,不能用传统的数学计算机建模,他还推测量子效应在人脑中扮演重要角色。而德雷福斯最早撰写的一篇文章是《炼金术与人工智能》(AlchernyandArtificialIntelligence),后来在此基础上修订内容,出版了《计算机做不到的那些事》(WhatComputerCan’tDo)一书,到了1992年,该书的第3版问世,德雷福斯批判中略带嘲讽地把书的名字改成了《计算机仍然做不到的那些事》(WhatComputerStillCan’tDo)。德雷福斯并不否定人工智能取得的成果,他的主要批评点在于建构思维机器的象征性方法。

机器人科学探索iRobot公司把机器人定义为“在现实世界中,为了实现特定目标而感知世界,并且合理行动的物理设备”[1],也就是说,机器人必须与现实世界发生联系,在这一点上,机器人专家罗德尼·布鲁克斯(Rodney Brooks)与德雷福斯的观点似乎不谋而合,均认为思维机器必须植入现实世界,像人类一样去感知世界从而获得外部世界的知识,只有这样,符号才能获得真正的意义。而约翰·塞尔(J.R. Searle)则用一场“中文屋”(Chinese Room)思想实验来解释这一观点的内涵,并以此来反驳艾伦·图灵(Alan Turing)对智能的定义。

毋庸置疑,从计算机产生以来,机器变得越来越聪明。人工智能发展到今天,人们不禁思考:人工智能的未来究竟将走向哪里?机器可以具有智能吗?思维机器会出现吗?奇点会出现吗?带着对这些问题的思考,本文从图灵测试出发,在各种反驳意见中探索智能的定义,并试图分析当前思维机器的局限,以及奇点到来之前面临的各种技术问题和伦理挑战。

二、机器可以具有智能吗?

通常情况下,我们在日常生活中看到的人工智能指的是“弱人工智能”(简称“弱AI”),例如AlphaGo可以下围棋,机器人特奥可以谱曲等。弱AI通常指的是机器在某一领域可以实现像人一样的行为。而在谈到机器是否可以思维这个问题时,我们谈论的则是“强人工智能”(简称“强AI”),强AI的含义是指机器可以像人类一样具有自由意志,可以思维,也就是人们所说的“通用人工智能”。而在现实中,我们已经可以看到很多弱AI的普及和应用,那么,强AI究竟能否实现呢?换言之,机器究竟能否具有像人类一样的智能呢?

谈到智能问题,我们就需要从人工智能历史上著名的“图灵测试”(Turing Test)开始讨论。为了给智能下定义,图灵采用一种功能性定义,即如果一台计算机的行为方式和人类一样,那么就可以说它具有智能。为此,图灵提出了一个思想实验来介绍这种功能性定义,即图灵测试:假设有一套智能程序,评委在一个房间,使用一台计算机终端与另一个房间的一个人或者计算机相连。评委向对方提问,对方回答问题,如果有超过30%的回答使评委无法判断出对方是一个人还是一台机器,那么,这台计算机就通过了图灵测试,即具有智能[2]。

显然,“图灵测试”给出了一个非常大胆的猜想,如果机器具有智能,就意味着机器可以像人类一样思考,正是这一猜想的强大吸引力,让很多专家们跃跃欲试,试图创造出像人类一样自由思考的强AI。当然,图灵的这一观点也引起了很多反对意见,而图灵也预见了这些可能的反驳,并对此进行一一回应。

反对意见之一是“能力缺陷说”。这一论点指出计算机即使可以在很多方面表现出色,但永远无法做到X。这里的X特征很多,如仁慈,有幽默感……这份清单可以一直列下去,都是人类的一些特有特征,但人们无法拿出系统的证据来支撑这些观点,因为这些观点都是建立在归纳原理基础上,是人们从过去见过的机器特征中总结出的经验印象,因此不能用来预测未来的机器。对此,图灵指出:“要获得可靠的结果,必须在相当大的时空范围内进行研究。”[3]75

反对意见之二是“总结创新说”。这一论点认为计算机无法做出像人类一样从经验中学习,也无法做出新东西。早在1950年,图灵就预测机器可以在50年时间里通过图灵测试,实现这些能力。事实上,无需图灵回应,当今社会发生的种种事件已经给出了答案。例如:购物网站从你经常浏览的网页中总结习惯,向你推荐你可能喜欢的产品;AlphaGo通过深度学习学会了下围棋,机器可以做到翻译、写诗、谱曲等。实际上,早在计算机诞生的100年前,发明家约翰·克拉克(John Clark)就发明了一台可以生成拉丁文六步格诗的机器,并于1845年在伦敦皮卡迪利做了首演。

反对意见之三是“意识说”。这一观点也是历史上争议最多的意见。这一观点的代表人物是英国脑外科医生杰弗里·杰弗逊(Geoffrey Jefferson)。他在1951年曼彻斯特大学举办的利斯特演讲大会中明确表达了这一观点:除非机器能够做到出于自己的感情和思想来写诗作曲,而不是通过符号的随机来临,否则我们不能认为机器与大脑是等同的——也就是说,不仅能写诗,还要知道自己写出来的含义。任何机器都不能感受到(不是人为的信号,这在设计上很容易实现)成功时带来的喜悦和电子管烧熔后的悲伤,不会因为听话而开心,不会因自己犯错而懊恼,见到异性而着迷,愿望实现不了时发怒或沮丧[3]72-73。

对此,图灵指出,如果论证机器能否思维的唯一途径就是自己成为机器,体验它是否在思维,并向别人描述这些感受,这是“唯我论”的表现,最终会导致智能的定义没有标准,思想无法交流的结果。基于这个反驳基础,塞尔设计了著名的“中文屋”思想实验,假设自己变成了一台机器,被关进屋子里,在不懂中文的情况下,借助一本英文指南手册完成屋外的人类指令(配对正确的中文问答卡片)的过程,通过塞尔完成任务但不懂中文这一结论来反驳机器可以具有智能这一观点[4]94-95。

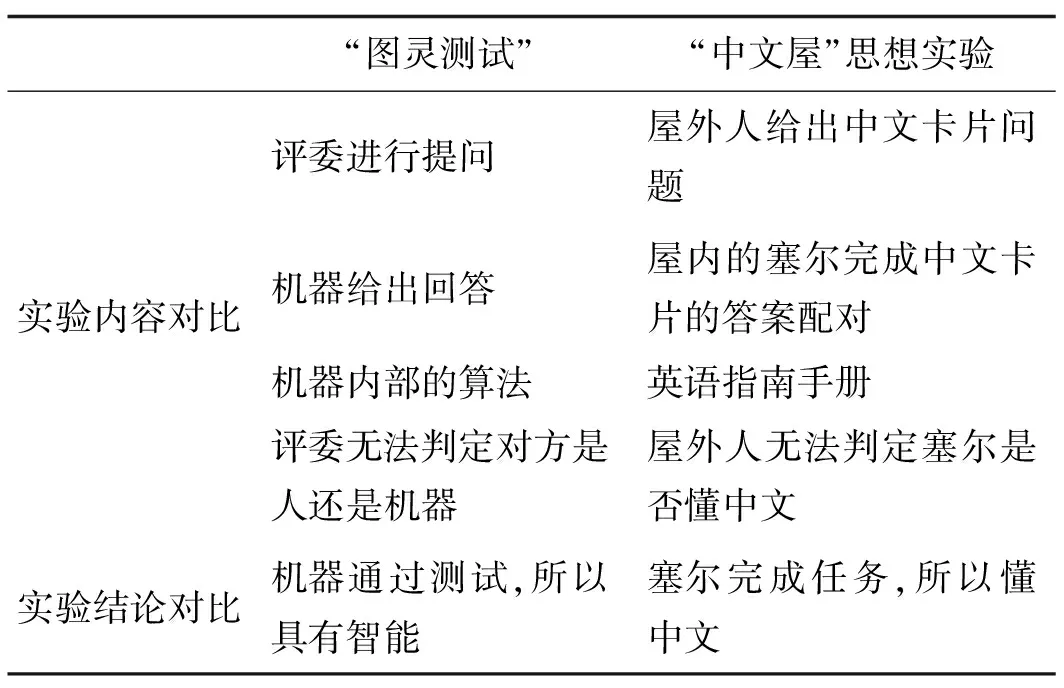

塞尔的意图是通过这一思想实验与图灵测试进行类比论证,从结论出发反驳图灵关于“机器可以具有智能”的观点,因为事实上塞尔并不懂中文,所以图灵的结论也不成立。塞尔的“中文屋”思想实验与图灵测试的对比关系可以通过表1进行具体剖析。

通过这一思想实验,塞尔不仅反驳了图灵对智能的定义,同时指出机器无法具有智能的根本原因在于缺乏意向性,“机器人根本没有意向状态,只是受电路和程序支配的来回运动而已”[4]105。塞尔还指出,理解力是智能必不可少的一部分,显然在“中文屋”实验过程中,塞尔是没有理解行为的,因此,计算机回答问题的行为也是不具有理解力的。实际上,在此之前的10年时间里,人工智能领域正在遭受第一次寒冬,虽然支持图灵的呼声强调“智能增强基因几乎无处不在”[5],机器人的服务领域也在逐渐扩展。然而,关于“机器是否可以具有智能”这一问题依然面临着各种批评和挑战。

表1 “图灵测试”与“中文屋”思想实验对比分析

谈到人工智能,就无法避开一位具有批判精神的哲学家——德雷福斯,他最初把人工智能比喻成中世纪的炼金术,即把各种不同的化合物倒在一起,观察它有什么变化,并指出即使人工智能发展到今天,依然处于不同程度的尝试与观察之中。而对于计算机程序可以做到模拟甚至等同人的智能的观点,德雷福斯主要以人工智能建构的象征性方法来分析,分别从生物学假想、心理学假想、认识论假想和本体论假想几个角度出发,对这种观点提出批评和反驳。

在生物学假想方面,在神经生理学家发现大脑的神经元可以发出具有全有或全无特征的电脉冲后,这与计算机的二进制编码信息似乎一致,于是这种电脉冲信号就被看成是人脑与计算机的基本信息单元,并以此推理出:计算机可以模仿大脑的工作原理。德雷福斯指出,人脑的“信息加工”方式和计算机的信息处理过程是不同原理的,人的大脑是由许多随机相连的神经元连接成的庞大阵列,用某种程序可以模拟这些神经网络,但这种程序并不是启发式的程序,因此,“把人脑看成一个通用符号处理装置,像数字计算机那样工作,这是一种经验论的过时的假说”[6]171。也就是说,大脑中的神经元之间可以发生相互作用,其中一个神经脉冲序列可以反映出其他神经元的活动情况,同样的情况可以发生在其中任何一个神经元中,而这一点是计算机的编码程序无法实现的。

在心理学假想方面,即认为人的大脑存在一种和计算机类似的信息处理空间装置,对外界输入的各类信息进行组合和加工。研究人员认为人在进行智能行为时,是遵循一些类似为使数字计算机产生同一行为所必须遵循的启发规则。德雷福斯指出,心理学出现了从行为主义到心智主义的普遍转移,于是引起了很多心理学家和哲学家沿着这一路径进行计算机的类比推理,把人理解为一个装有启发式程序的数字计算机的信息加工系统。德雷福斯指出,“信息加工”是有歧义的,对于人脑和计算机程序而言,问题的关键在于不能把信息和意义混为一谈,因为一个负荷很重的消息和一个无关痛痒的消息对于一台计算机来说可能是完全相同的。“心理学意义上的运算必须是人类在加工信息时,比如搜索、整理、存储,至少有时有意义地进行那一类的运算,而不是有机体内的生化过程。”[6]177

在认识论假想方面,虽然不能假设人是在一系列无意识运算中遵循启发规则来活动的,但人的智能行为依然可以用这种规则加以形式化,因此可以用机器复制。对此,德雷福斯将认识论假想归纳为两点:(A)所有非随意性行为都可以形式化;(B)形式化系统可以复制。德雷福斯指出,观点A是建立在物理学成果基础上的,而观点B则是建立在语言学成果基础上的。德雷福斯进一步指出问题在于,观点A把物理学上对物体运动的抽象规律(如把行星绕太阳运动抽象为形式化系统——微分方程)和计算机的信息加工(信息的输入、输出)混为相同机制,即微分方程可以描述行星运动,但行星运动不是在解方程,因而辩护不成立,而观点B的前提是人的语言行为都是遵循一定规则的,且要将语言行为形式化的前提条件是将所有人类知识全部囊括在内,这显然是无法实现的。

在本体论假想方面,即认为世界可以分解为离散的、确定的初始元素,按照这个逻辑,所有现实世界的知识都可以被数字化、符号化、形式化,编入计算机程序。德雷福斯从现象学角度指出“事物可计算”观点的局限性在于把人类的现实世界局势与物理的宇宙世界相混淆,“一种物理状态的演变,的确可以形式化为微分方程,并可以用数字计算机复制出来。但是,现实局势却对那些想把它们变成形式系统的人提出了令人头痛的问题”[6]222。这里的问题可以归结为:现实性和具身性是计算机所不具有的。这里,可以通过机器翻译中出现的问题来证实这一点,因为自然语言的内涵十分丰富,而机器自动翻译常常出现语义偏差,由此可以看出,把现实世界完全形式化是不可能的。

其实,德雷福斯并不否定人工智能在技术上取得的成果,他的主要目的是把人工智能从技术领域延伸到哲学领域,试图重新审视建构思维机器的象征性方法,并指出这个方法可以回溯到柏拉图的“理念论”、莱布尼茨的“人类思想字母表”以及休谟的经验主义,而实现机器具有智能的关键问题在于如何把抽象符号与现实世界联结起来。

汉斯·莫拉维克(Hans Moravec)通过观察和对比计算机行为和人类行为发现:“让计算机在一般认为比较难的智力测验和棋类游戏中表现出成人的水平相对容易,而让它在视觉和移动方面达到一岁小孩的水平却很难甚至不可能”[7]。这一现象被称为人工智能历史上著名的“莫拉维克悖论”,也表明了制造思维机器面临的现实挑战与限制。

三、思维机器的限制

关于机器能否思维,前文提到了“意识说”,杰弗逊和塞尔都认为意识产生于人类大脑特有的生物机制,而计算机则是由硅作为主要系统,因而认为这从构成机制上限制了机器具有意识的可能性。然而问题是,这种论证至今依然没有确切的完整证据。因此,当我们在讨论这一论点时,首先要抛开过去传统观念中“唯我论”式的恐惧:只有人的意识确定存在,即笛卡尔的“我思故我在”,那么,是否可能还有其他的可能性;或许意识有可能是一种突现特征,可以在任何复杂的系统里生成、演化、运行,即使该系统是由硅构成的。值得一提的是,在生物系统里,意识一直都是一个难以解释的现象,大卫·查尔默斯(David Chalmers)曾指出:“意识是心智科学里最令人困惑的问题,意识体验我们再熟悉不过了,可要解释它也再困难不过了。近年来,人们已经对各种各样的精神现象进行了科学观察,但意识仍然顽强地抵挡着来自人的努力探索”[8]。因此,由于目前学界对意识的认识不够,还无法说清楚意识是否一定是思维机器产生的限制。那么,我们再来看看制造思维机器还有哪些其他限制。

1.默会限制

有一个现象是,人所做的很多智能行为是无法向其他人解释的,甚至无法向自己解释。例如:一个3岁的孩子可以从一堆照片中迅速找到他父亲的脸,但是有关父亲的脸部知识他却很难描述。还有一个现象是,人类最初在学习语言时并不是靠语法和字典,或许一个人的中文可以讲得很棒,但却对汉语的语法知识考试一头雾水。英国哲学家迈克尔·波兰尼(Michael Polanyi)曾经做过这样一种观察:“我们所知的,超出我们的判断……潜水员的技能,不能用彻底的汽车理论知识代替;我对自己身体的认识,完全有别于相关的生理学知识;韵律和诗体的规则,并不能告诉我一首诗到底在讲什么,而哪怕我对诗歌的规则一无所知,我也知道这首诗在讲什么。”[9]

默会能力是人类特有的现象,由于无法诉说,无法描述,没有系统而准确的知识,而让很简单的事情在机器人那里变得很难实现,这种现象也被称为“波兰尼悖论”。人类的这种能力至今尚未得到科学解释,未来,如何将这种默会知识变为确切的、可以被复制的知识和符号或许是未来人工智能领域努力的一个方向。

2.人为限制

未来,制造思维机器还面临的一个难题在于:人类在制造机器之前总会加以各种限制,历史上著名的人为限制就是1942年艾萨克·阿西莫夫(Isaac Asimov)针对人工智能提出的机器人三大定律:第一,机器人不得伤害人类,或坐视人类受到伤害;第二,除非违背第一定律,机器人必须服从人类的命令;第三,在不违背第一及第二定律的前提下,机器人必须保护自己。

阿西莫夫指出,人类社会发展到了2058年,机器人很可能在人类生活中扮演重要角色,因此必须提前为它们设定限制规则。然而遗憾的是,阿西莫夫的机器人三大定律依然面临挑战:如果机器人必须伤害一个人以拯救其他更多的人(如电车难题),该如何采取行动?如果两个人同时给出相互矛盾的命令,机器人该如何处理?当前3条定律的局限性突显出来后,阿西莫夫又推出了第4条定律:机器人不得伤害人类,也不得因不作为令人类受到伤害。

阿西莫夫把这一定律排在前3条定律之前,称之为“零号定律”。然而,这一定律带来了新的问题:机器人怎样判断什么会伤害人类呢?即便如此,阿西莫夫依然主张应该带着此类定律的思考去开发机器人。

可以看出,阿西莫夫定律的最大挑战在于,有限的计算机系统无法准确而又完整地把人类的所有场景全部涵盖在内。例如,谷歌在开发无人驾驶汽车期间,曾遇到很多出乎意料的情况,这些情况的发生主要源于计算机对人类以及外部世界的形式化语言判断偏差。

3.伦理限制

制造思维机器的设想引出了很多伦理挑战,“电车难题”就是经典的伦理问题之一。试想,如果你坐在一辆行驶在公路上的无人驾驶汽车上,这时候有两个孩子突然冲到路上来,汽车是撞上两个孩子,还是撞到对面车道上的车?或者是撞到路边停着的车?计算机只有几毫秒来决定采取哪一种行动,而所有这些行动都可能会导致人死亡或者受伤。此时,计算机应该采取哪一种行动呢?背后的理论依据又是什么呢?

这个问题曾一度引起了学界关注,但就开发符合伦理道德的自动驾驶汽车而言,这只是其中一小部分,还有很多其他伦理问题,而这些问题可能会在实际中出现得更频繁,例如在特殊紧急情况下,人类驾驶员可能会违反交通规则来摆脱危险状况,那么,自动驾驶汽车能否以这种方式违反法律呢?此外,还有一些引发热议的问题是,是否应该开发一套系统,让人类驾驶员可以在某些特殊情况下临时收回控制权?

目前,大多数政府对自动驾驶采取的立场是把责任交到了相关的技术开发公司,而让自动驾驶汽车上路,在伦理道德上也势在必行。当然,政府的严格监管应该是自动驾驶汽车上路的前提和重要保障,否则交通系统会陷入混乱状态。

此外,思维机器还面临的一个伦理挑战就是算法歧视,即计算机的程序算法有可能会有意无意地歧视社会上某些特定群体。这些算法本身可能没有任何明确的偏见,但不管我们是否意识到,他们提供的数据结果令人产生一种带有偏见的感觉,这一点也是未来人工智能需要克服的一个问题。

这里,需要引起重视的另一个问题是,人类正在进入人工智能、自动程序、基因编辑的技术时代,技术的浪潮将影响人类生活的方方面面,但人们似乎把重心更多地放在了经济和商业前景上,而对人类的价值观和伦理考虑得不够,这一点需要在技术前行的进程中引起重视。“随着我们走向奇点时代,并且当计算机通过巨大的全球网络相互连接,到达或者超过人类大脑能力时,我们迫切需要一个大多数人认同且比较明确的伦理环境。”[10]

四、奇点会到来吗?

制造出思维机器,如果其迅速发展,进入“超级智能”时代,就会有所谓“技术奇点”的出现。这一概念可以追溯到约翰·冯·诺依曼(John Von Neumann),他就是最初设想的人之一,诺依曼把奇点描述为一种可以撕裂人类历史结构的能力。1957年,诺依曼去世后,数学家斯塔尼斯拉夫·乌拉姆(Stanislaw Ulam)回忆和诺依曼生前进行的一番对话,内容是快速发展的技术以及人类生活模式的变化,将使得人类历史上出现某个重要的奇点,在此之后,传统的人类之道将无以为继。在人工智能领域,技术奇点一般指的是一个时间点,届时人类将制造出一台具备足够智能,可以对自己进行重新设计以不断提高智能的机器,而一旦达到这个点,该机器的智能就开始呈指数级增长,在量级上超过人类。

无独有偶,关于技术的未来预测不仅是诺依曼,早在1950年,美国控制论专家诺伯特·维纳(Norbert Wiener)就提出:“人之所以能够进行大量学习和研究工作,乃是生理地装备了这种能力的……机器或有机体的结构就是据之可以看出其演绩的索引。”[11]维纳还设想了技术发展到未来某个时间,就可以实现机器的自主学习。

之后,美国未来学家雷·库兹韦尔(Ray Kurzweil)在其著作中论述并推广了技术奇点的概念。库兹韦尔从生物和技术两个方面将进化历史分为6个纪元:物理和化学纪元、生物与DNA纪元、大脑纪元、技术纪元、人类智能与人类技术结合的纪元、宇宙觉醒纪元[12]。库兹韦尔指出,人类目前已经走过了前4个纪元,即将进入第5纪元,即人类与机器的联合——人机文明。按照库兹韦尔的观点,人类与机器的结合是人类历史发展到一定阶段的必然选择,也是技术发展史的必然阶段。

很多研究人员认为,机器人和人类一样,都是物质世界发展的必然产物,“从彻底的唯物主义观点看,不排除完全复制一个人的可能”[13]。英国控制论教授凯文·渥维克(Kevin Warwick)曾提出要将自己变成一个“半人半机器式的智能复合体”,并分别于1998和2002年把芯片植入自己的左臂和左腕。这样,渥维克左手臂的每一个动作发出的神经信号都可以与计算机相连。这样做的结果是,当渥维克在办公大楼里走动的时候,所有由电脑控制的房间都可以自动识别他,为他自动开门、开灯,打开电脑向他问好。渥维克曾指出:“若是机器有可能达到与人类大致相同的水平,那么由于技术进步的潜力,机器在很短的时间内一定会变得更聪明。”[14]

实际上,随着1996年出现的“深蓝”计算机打败国际象棋大师,2015年DeepMind 人工智能公司开发的程序通过自主学习实现了自玩49款Atari游戏,2016年AlphaGo打败韩国棋王李世石,2017年以全胜成绩打败围棋世界冠军柯洁等一系列惊人的事件发生后,人们越来越相信,奇点可能会在未来的某个时间到来,到那时,计算机将实现自主学习、自我繁衍,并可以不断开发新智能,甚至取代人类。以色列历史学家尤瓦尔·赫拉利(Yuval Harari) 在《未来简史》一书中也指出:“在过去几千年间,人类已经走向专业化,比起狩猎者,出租车司机或心脏病专科医生所做的事更为有限,也就更容易被人工智能取代。”[15]

从技术角度来说,AlphaGo是一个基于卷积神经网络的程序,其核心技术主要有两个方面:第一方面就是计算机系统内部的强化学习(Reinforcement);第二方面则是蒙特卡罗树搜索(Monte Carlo Tree Search)。通常情况下,强化学习是指除了无监督学习和有监督学习之外的第3类机器学习方法,强调智能体和环境之间的互动,通过智能体寻求期望奖励的最大化来习得从状态空间到行动空间的策略函数,在运筹学和最优控制理论中,强化学习也被称作是近似动态规划。而蒙特卡罗树搜索算法从本质上来说其实是一种博弈,即“双人有限零和顺序博弈”,也就是在游戏状态中,双方分别在对立状态下交替进行选择下一步操作以获得最终游戏的胜利。

毋庸置疑,在寻找“最佳下一步”的问题序列中,机器的算法要比人类更强大、更快捷,这是深度学习具有的独特优势,因此,计算机在这个算法程序的控制下战胜人类是必然。但是,这里需要引起注意的是:人类对于深度学习这一算法真的做到理解其工作原理了吗?实际情况并非如此。美国计算机科学家、哲学家朱迪亚·珀尔(Judea Pearl)引出了另一个难题:即使是AlphaGo的程序编写者也不能解释为什么这个程序可以把下围棋这个任务指令执行得这么好,换句话说,这个程序的内部运行机制并不明确,“我们对深度学习的理解完全是经验主义的,没有任何保证”[16]333。

这里珀尔预测到,也许有人会说,我们并不真正需要透明,毕竟我们也不太明白人脑是如何工作的,但它却可以灵活运行,为什么不可以在不了解工作原理的情况下利用深度学习创造出新的智能呢?珀尔将这类人称为“将就派”,而把追求准确性、透明性的一类人(包括他自己)称作是“讲究派”,并通过一个生活场景案例来说明有意义的沟通的重要性:假设珀尔在睡觉,此时他的机器人准备打扫卫生,于是开启了吸尘器,结果把熟睡的珀尔吵醒了,于是珀尔很生气并向机器人发出一条指令:“你不该吵醒我!”[16]334

那么接下来的问题是,通过深度学习的计算机程序真的可以做到完全理解“你不该吵醒我”这句简单的指令里蕴含的丰富内涵吗?机器人能否明白它的主人的意思是此时打开吸尘器是不合适的,而不是让它永远不要打开吸尘器?机器人能否准确地判断什么时间打开吸尘器最合适?珀尔对此表示怀疑。按照珀尔的观点,如果一台机器的内部运行程序无法做到准确性、透明性,就不可能产生新的智能,奇点也就不会出现。

珀尔提出的这个理论可以用柏拉图的“洞穴之喻”来做一个类比的解释。在这个比喻中,深度学习的程序目标是准确预测墙壁上那些不断出现的影像动作、形状以及出现的时间,如果单就这一点来说,或许它可以做到很出色,但珀尔提出的问题则是:这个系统实际上无法理解墙壁上出现的那些影像只是篝火后面的人和物体的投影。换言之,真正的思维机器必须具备这种“理解能力”。

珀尔进一步指出,所谓“理解能力”指的是机器可以在行动之前进行自我思考,通过因果推理和概率计算,然后选择一个最佳行为。例如,机器在行动之前可以这样思考:我的行为A=a1,产生的结果是B=b1;如果换一种行为,如A=a2,那么,产生的结果就是B=b2,而第二种行为产生的结果更好,于是机器最终选择行为a2。也就是说,机器可以通过深度学习得到不同事件发生的概率,并且具有自由意志进行决策执行。然而,这里面临的一个问题是:如果机器人只会按照存储在程序中的指令执行操作,那么,它又该如何拥有自由意志呢?

然而,人工智能领域的乐观主义代表佩德罗·多明戈斯(Pedro Domingos)却认为,计算机可以通过学习一种终极算法而最终实现超越人类。那么,究竟什么才是终极算法呢?他给出的答案是:进化的、连接主义的、符号的、贝叶斯的和类比的算法,并指出真正让算法发挥作用的基础则是对数据的处理,他认为“数据犹如新型石油”[17],可以让系统在智能的道路上越走越远。但是,多明戈斯并没有说明这些算法是如何整合在一起而成为终极算法,于是引来了很多质疑的声音,“在每一个单独领域都有可能超越人类,不一定会在整体全面超越人类。”[18]

可见,在奇点到来之前,人工智能领域还有很多难题和挑战需要攻克:如何将计算机内部的程序算法透明化、准确化?如何让计算机的符号语言与人类的自然语言无缝对接,并执行和人类行为一样的因果推理?如何让计算机获得自由意志,进行自由决策行为?如何将计算机内部的各类单一算法整合成终极算法。

五、结 语

透过图灵测试以及人工智能发展道路上的批评派与乐观派对比可以得出,图灵将人类智能的本质归结为计算的观点显然是不恰当的,人类丰富而复杂的智能行为以及无限多变的外部宇宙世界也不能完全被形式化、数字化,被机器完全复制和模仿,机器也不能做到完全理解人类的行为和外部宇宙世界。换言之,思维机器的建构基础和方法在技术和逻辑上还缺乏强有力的支撑,实现奇点的条件还需要重新审视。但即便如此,从另一个角度来说,通过人工智能领域不断突破的现实技术成果,毋庸置疑的一点是,机器已经可以在某些单一领域内凭借算法程序进行深度学习,并且出色地完成人类的指令任务,即实现弱人工智能。然而,未来想要制造出更高智能水平的思维机器,实现强人工智能,一方面要解决当前存在的技术限制和伦理限制等问题,另一方面还需要攻克很多尚未明朗的挑战和难题。因此,奇点时代可能在短暂的时间还无法到来,人工智能领域还有很长的路要走。