卷积神经网络结合显著性目标掩图的红外与可见光图像融合

万刘永程健庆刘义海

(江苏自动化研究所,江苏 连云港 222006)

0 引言

图像融合是一项增强技术,旨在组合不同类型传感器获得的图像,以生成稳健或信息丰富的图像,便于进行后续处理和决策。随着传感器技术的迅速发展,可获得的图像类型也越来越多。在某些复杂的场景中,单一类型图像分析已经很难满足现实需要,必须综合多种图像信息进行综合分析。不同类型的图像,例如可见光、红外线、X 射线、计算机断层扫描以及磁共振成像都可以采用适当的算法进行融合。可见光图像通常具有高分辨率和丰富的纹理特征和细节信息,适合人类的视觉感知。但是,可见光的传播很容易受到环境条件的制约,而红外图像受环境天气等条件的制约较少,因此,红外与可见光图像的融合可以实现信息的有效互补。

传统的基于多尺度变换的图像融合方法提取的特征单一,在一些场景多变的条件下难以取得良好的效果,同时因为融合规则往往需要手动设计,运算效率也较低。近年来,卷积神经网络在图像处理领域取得了长足的发展,具有强大的特征提取能力,能够自动从数据中提取特征而无需人工干预。因此,本文使用卷积神经网络并结合显著性目标掩图的方法对图像融合进行研究。

1 本文模型介绍

本文基于卷积神经网络和显著目标掩图相结合的方法,首先从红外图像获得目标显著性掩图,从而得到红外图像的显著目标区域和可见光图像的背景、纹理区域;然后根据得到的掩图,定义像素值损失函数和梯度损失函数,进而得到整体损失函数;最后根据损失函数对网络进行训练,输出融合结果。

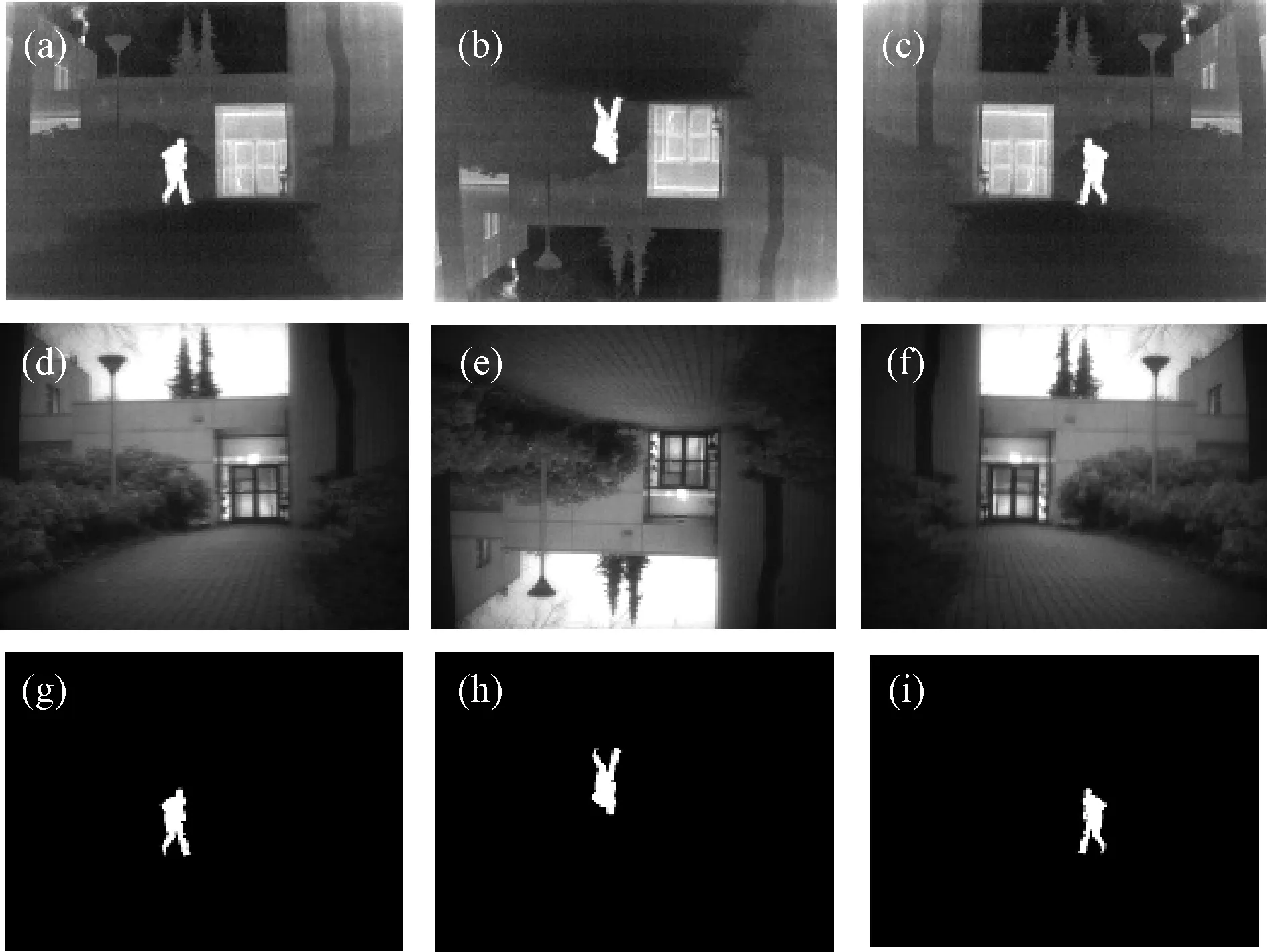

1.1 目标显著性掩图

所谓的目标显著性指的就是红外图像中热辐射较高的区域,在红外图像中具有更高的亮度。通常情况下,目标区域的温度越高,所产生的红外辐射也就越多,更容易被红外设备所采集。因此,当人们看一幅红外图像的时候,注意力往往集中在热辐射较高的区域,也就是显著性区域。典型的显著性目标有人、车辆、机器设备等。本文采用公开数据集TNO_Image_Fusion_Dataset,使用图像处理软件,如Photoshop获取目标显著性掩图mask,然后对可见光图像、红外图像及相应的目标显著性掩图统一进行旋转、镜像等变换,增强数据集。

1.2 损失函数

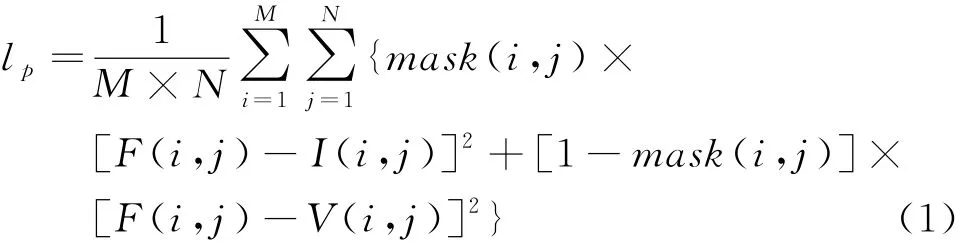

损失函数定义为像素值损失和梯度损失的加权和。像素值损失能使融合图像在像素强度上与源图像保持一致,而梯度损失函数能够使得融合图像保持更多的纹理特征和细节信息。像素值损失采用均方误差,定义如下:

图1 红外图像、可见光图像及其显著性目标掩图

式中:、分别表示像素矩阵的行数和列数;表示显著性掩图。

当像素点位于红外图像的显著性区域,(,)的值取1,反 之取0。(,)、(,)、(,)分别表示融合图像、红外图像和可见光图像对应点的像素值。

同时定义梯度损失。本文设计了一阶梯度损失和二阶梯度损失。通常情况下:一阶梯度可以反映出图像灰度梯度的变化情况,如图像中产生较为粗糙的边缘;而二阶梯度对精细细节(如细线、细小的纹理)有较强的响应,可以提取出图像的细节,同时双响应图像梯度变化情况,能够指导融合图像保留更多的源图像细节信息。梯度损失定义如下:

最终的损失函数定义如下:

式中:和为超参数。

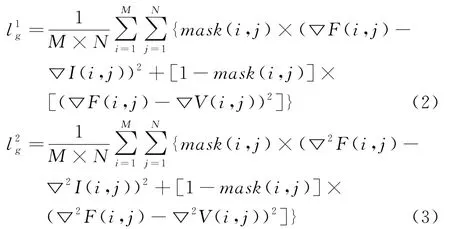

1.3 网络架构

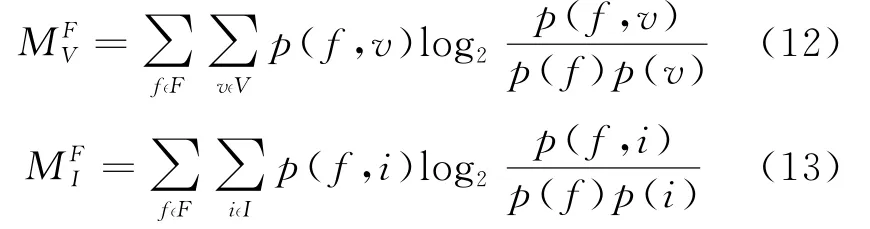

如图2所示,网络结构包含2个部分:特征提取网络和融合网络。

图2 卷积神经网络架构

(1) 特征提取网络:特征提取网络由darknet53受到启发,采取残差块与卷积核串联的方式构建。引入残差块可以减轻梯度消失或爆炸的问题。特征提取网络由红外和可见光2个通道构成,每个通道都具有相同的结构。

(2) 融合网络:融合网络由残差块与卷积核串联而成,特征提取网络的输出作为融合网络的输入,输出结果为融合图像。整个网络的卷积层都没有进行下采样,这样做的目的是为了使融合图像与源图像保持同样的大小尺寸。整个网络采用Relu函数作为激活函数。

2 实验对比

使用公共数据集TNO_Image_Fusion_Dataset对网络模型进行训练,训练完成后随机选取3组图片并采用不同的图像融合算法对融合结果进行横向比较,与之比较的算法为离散小波变换(DWT)、非下采样剪切波变换(NSST)、非下采样轮廓波变换(NSCT)3种方法。本文从主客观角度对融合结果进行评价,主观质量评价主要是通过人眼对实验结果进行定性的评价,评价结果可能受人的习惯、聚焦的角度等主观因素的影响而不同。客观评价往往是采用客观评价指标来实现,这些客观评价指标有着严格的数学定义。本文采用的客观评价指标为平均梯度、空间频率、熵、互信息、交叉熵。以下是关于各评价指标的定义与解释。

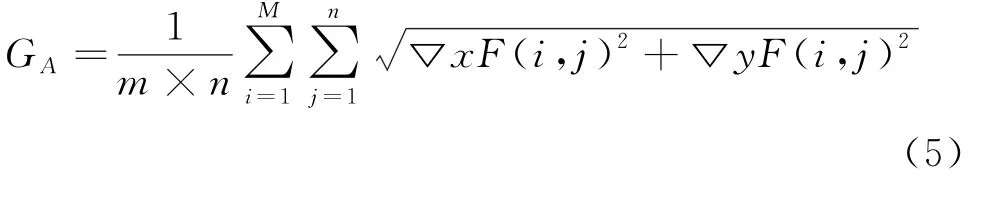

(1) 平均梯度(AG):

式中:▽和▽分别为融合图像矩阵上的水平梯度算子和垂直梯度算子。

平均梯度反映了融合图像的细节反差和纹理特征,相邻像素之间的灰度变化越大,平均梯度就越大,表明融合图像纹理特征越清晰,细节表达能力越强。

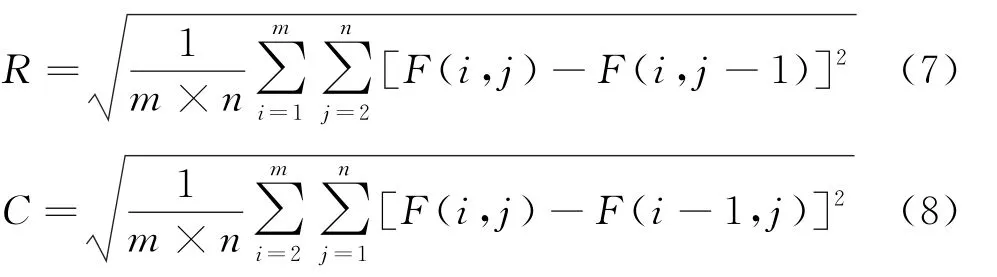

(2) 空间频率(SF):

式中:和分别表示融合图像的空间行频率和空间列频率,定义如下:

空间频率表征的是图像的边缘化程度,反映融合图像的整体活跃程度。

(3) 熵(E)

式中:为图像的灰度级数;P 为灰度值为的频率值,计算如下:

式中:N 为像素值为的元素个数;为像素总数。

熵表示图像信息的丰富程度,熵越大,信息越丰富,效果越好。

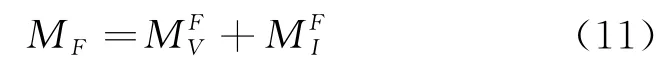

(4) 互信息(MI)

式中:(,)和(,)分别表示融合图像与可见光图像和红外图像的联合概率分布;()、()、()分别表示融合图像、可见光图像、红外图像的边缘分布。

互信息是衡量融合图像从源图像中获取信息的多少,互信息值越大,表明融合图像从源图像获取的信息量越多,融合效果越好。

(5) 交叉熵(CE)

式中:P P 、P 分别表示融合图像、可见光图像、红外图像的灰度概率分布。

交叉熵反映了融合图像与源图像对应灰度的分布差异,值越小,表明融合图像与源图像越相似。

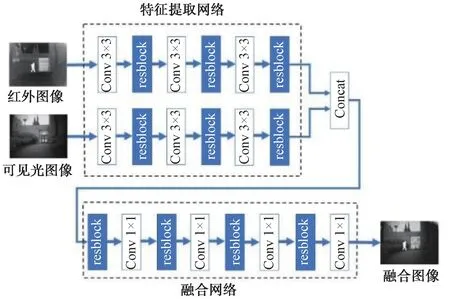

2.1 主观评价

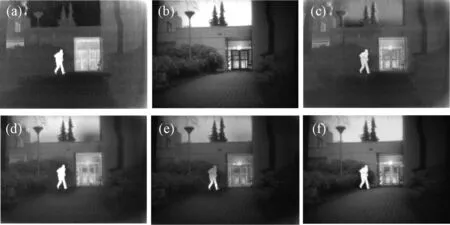

如图3所示,第1组图像是Kaptein_1123红外与可见光的融合,(a)、(b)分别为红外与可见光源图像;(c)为DWT 方法融合的结果,人物较为暗淡,背景模糊,基本丧失纹理等细节信息;(d)图能够呈现背景细节信息,但不够自然;(e)图也能呈现纹理信息,但色调偏暗,而且引入了噪声;(f)图的融合效果最佳,地面和墙面的纹理信息以及树叶与树枝等细节信息都较为丰富。

图3 “Kaptein_1123”红外和可见光图像以及融合结果

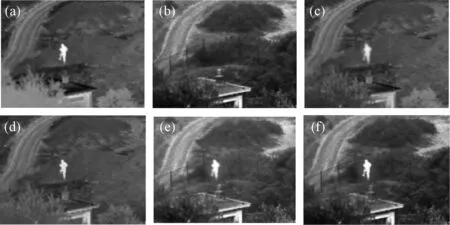

第2 组图像是Sandpath,如图4 所示。图4(a)、图4(b)是红外和可见光图像;图4(c)的人物和背景都较为模糊;图4(d)中的人物得到较好的呈现,但背景信息保留不够;图4(e)中的树枝等背景纹理信息比较丰富,但红外目标不够明显;图4(f)中人物明亮,背景信息也保存较好,综合而言融合效果更佳。

图4 “Sandpath”红外和可见光图像以及融合结果

第3组图像是选自Nato_camp_sequence中的1组图像,如图5所示。图5(c)人物图像边缘出现虚影,过渡不自然;图5(d)背景模糊,人物特征也保留不够完整;图5(e)和图5(f)都保存了背景和红外目标的特征;但图5(e)中的人物旁边存在一定的光晕;图5(f)更符合人眼的视觉感受。

图5 “Nato_camp_sequence”红外和可见光图像以及融合结果

2.2 客观评价

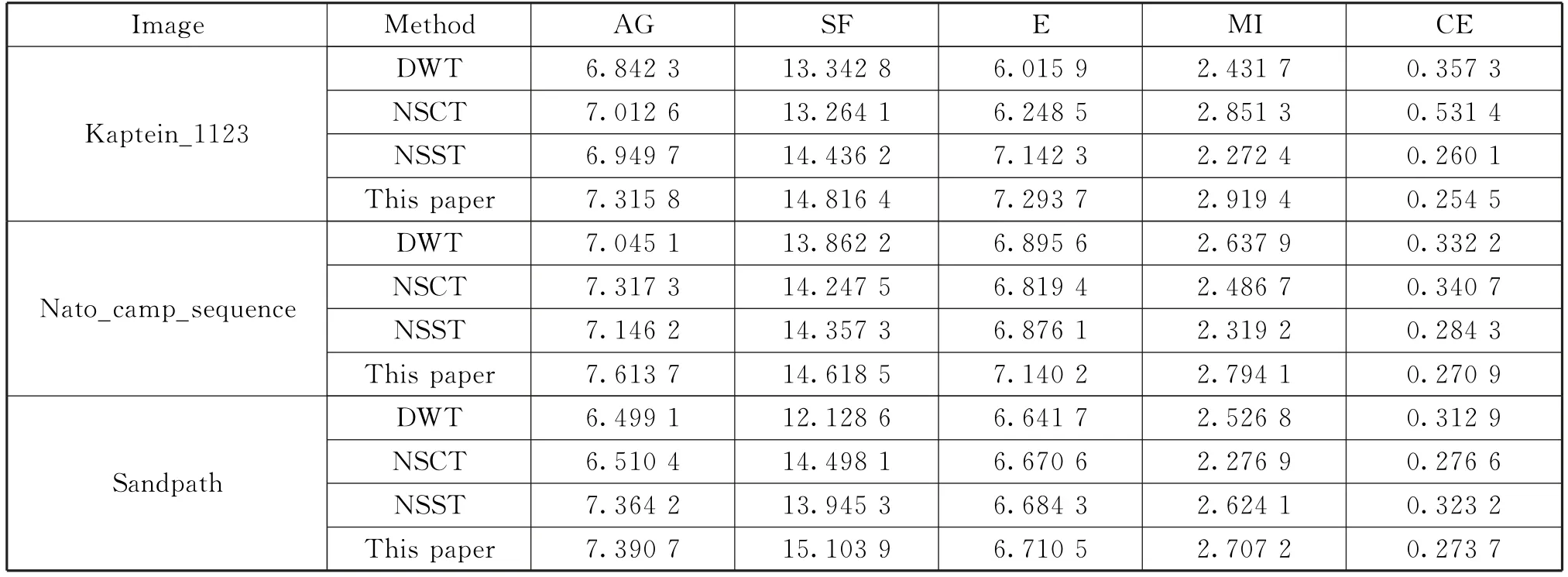

本文采取平均梯度(AG)、空间频率(SF)、信息熵(E)、像素互信息(MI)、交叉熵(CE)5个指标来对融合结果进行客观评价,表1 为融合结果的客观评价。

由表1可知,本文方法在一定程度上均优于对比方法。对于“Kaptein_1123”融合图像,平均梯度、空间频率、信息熵、互信息、交叉熵分别提高了4.32%、2.63%、2.12%、2.39%、2.20%;对 于“Nato_camp_sequence”融合图像,平均梯度、空间频率、信息熵、互信息、交叉熵分别提高了4.05%、1.82%、3.55%、5.92%、4.94%;对于“sandpath”融合图像,平均梯度、空间频率、信息熵、互信息、交叉熵分别提高了0.36%、4.18%、0.39%、3.17%、1.06%。

表1 融合结果客观评价指标

3 结束语

本文使用集特征提取与融合于一体的卷积神经网络对红外和可见光进行了融合,区别于以往神经网络只进行特征提取而采用其他方法进行融合。同时引入像素损失、一阶梯度损失和二阶梯度损失构成损失函数对神经网络进行训练。采用显著性掩图提取红外显著目标并同时获得更多可见光图像的背景信息。对实验结果从主客观2 个角度进行了评价,评价结果均优于对比方法。