教育人工智能伦理:内涵框架、认知现状与风险规避

胡小勇 黄婕 林梓柔 黄漫婷

摘要:人工智能在赋能教育高速发展的同时,也面临着严峻的伦理挑战。厘清教育人工智能伦理的内涵框架,刻画当代大学生伦理认知的现状,进而提炼可行的风险规避策略,成为重要的研究问题。基于对国家政策和国内外文献的研读,运用德尔菲法经两轮修订和完善,最终确定的教育人工智能伦理内涵框架包括“人机协同与自立自主”“学生福祉与发展”“公平与持续发展”“安全与可控可信”4个一级维度和12个二级维度。以此为基础编制问卷并进行调查分析的结果表明,大学生对教育人工智能伦理的认知存在不均衡现象,在“公平与持续发展”“安全与可控可信”两个维度上得分较低,且学历层次、年级以及对人工智能的了解程度等均对大学生的教育人工智能伦理认知产生了显著影响。当前教育人工智能伦理建设存在缺乏精准的规范与指引、人文关怀与价值引领缺位、技术自身存在局限、学习资源建设粗放等难题,未来可采取树立以立德树人为核心价值导向的教育人工智能伦理建设原则、编制教育人工智能伦理规范指南、提升教师智能教育素养水平、以智能技术反向赋能伦理建设,以及建设公益性学习资源等策略来规避风险。唯有将伦理规范嵌入到教育人工智能全生命周期,才能更好地构建新型智能教育生态。

关键词:教育人工智能;伦理内涵;伦理认知;伦理风险;德尔菲法

中图分类号:G434 文献标识码:A 文章编号:1009-5195(2022)02-0021-09 doi10.3969/j.issn.1009-5195.2022.02.003

基金项目:2019年度国家社科基金重大项目“人工智能促进未来教育发展研究”(19ZDA364);2022年广东省科技创新战略专项资金(“攀登计划”专项资金)“面向大学生的教育人工智能伦理内涵与风险规避对策研究”(pdjh2022b0146)。

作者简介:胡小勇,博士,教授,博士生导师,华南师范大学教育人工智能研究院,华南师范大学教育信息技术学院(广东广州 510631);黄婕,硕士研究生,华南师范大学教育信息技术学院(广东广州 510631);林梓柔(通讯作者),博士研究生,华东师范大学教育信息技术学系(上海 200062);黄漫婷,硕士研究生,华南师范大学教育信息技术学院(广东广州 510631)。

一、引言

如果人工智能变得太聪明,做出超出人类思维能力的决策怎么办?美国前国务卿亨利·基辛格(Henry Kissinger)在《启蒙如何终结》中提出警告,“技术革命的秩序动荡不安,我们最终将处于依据算法和数据驱动、不受伦理道德规范的机器世界”(Kissinger,2018)。伴随人工智能在教育领域中的规模化应用,诸如教育隐私数据泄露、算法歧视与不透明、教育主体情感交流危机等伦理风险已经引起世界各国关注。美国与英国分别颁布《为人工智能的未来做好准备》和《人工智能:未来决策制定的机遇与影响》政策文件,为人工智能的发展和应用提供了路径指引。我国也陆续出台了《新一代人工智能治理原则——发展负责任的人工智能》和《新一代人工智能伦理规范》(以下简称《伦理规范》)等政策文件,对人工智能发展和应用中的伦理问题进行了规范指引。为推动人工智能在教育领域的健康发展,联合国教科文组织(UNESCO)亦研制了《教育中的人工智能:可持续发展的机遇与挑战》和《北京共识——人工智能与教育》(以下简称《北京共识》)等报告,呼吁和引领人工智能教育应用的健康且可持续发展。

在此背景下,国内已有学者对教育人工智能的伦理内涵与特征(赵磊磊等,2021)、伦理原则(邓国民等,2020)、伦理风险规避的有效路径(于英姿等,2020)等进行了有益研讨。这些研究偏向于宏观的思辨探讨,尚未有研究聚焦可操作、量化的教育人工智能伦理内涵分析和实践调研。大学生处于更加自由、弹性和泛在化的学习环境中,既是使用人工智能的重要群体,亦是重要的利益相关者,他们在与人工智能协同共处的过程中更容易出现隐私泄露、信息茧房、价值冲击等伦理风险。因此,本研究力图构建针对大学生的教育人工智能伦理内涵框架,并开展大规模调研以探究大学生对教育人工智能伦理认知的现状。

二、当前教育人工智能伦理研究的焦点

当前学界对教育人工智能伦理的研究主要聚焦在伦理内涵、伦理原则、伦理风险规避三大方面。

1.伦理内涵:探究教育活动中的人机伦理关系

何为伦理?伦理是指人与人相处应遵循的道德准则,它包括客观的伦理关系及其外在规约(李建华,2020)。目前,人工智能引发的伦理风险已受到各国政府、组织和学者的关注,并引发了其对人与技术间伦理关系的进一步审视。例如,中国发布的《伦理规范》(中华人民共和国科学技术部,2021)和美国发布的《合乎伦理的人工智能框架》(Hogenhout,2021)均强调人工智能要为人类带来福祉,促进两者和谐美好。

教育人工智能作为教育领域的人工智能技术及系统,遵循人工智能的发展理念和以人为本的教育理念,关注人与机器的协作与交互,旨在赋能教育发展与变革(徐晔,2018;郝祥军等,2019)。面向新型人机关系的构建,《北京共识》强调教育人工智能要以人为本,考虑其对人和教育的多重影响,形成系统战略(中华人民共和国教育部,2019)。杜静等(2019)指出人机如何和谐共处是教育人工智能伦理建构的关键。刘三女牙等(2021)也指出,教育主体与教育人工智能之间的关系是教育人工智能伦理研究的重要内容。综上而言,厘清人工智能与人的关系,构建伦理框架、规范及原则为教育主体带来福祉(Siau et al.,2020),促进两者协同共生,是教育人工智能伦理内涵研究的核心。

2.伦理原则:尊重和体现学生主体的发展需求

已有研究探讨了人工智能伦理原则,要求从有益、安全、可释、公平、穩健等方面打造合乎伦理的人工智能(Hogenhout,2021),做到透明可释、公平公正、科技向善、责任担当、保护隐私等(Jobin et al.,2019;AI HLEG,2019),充分体现了作为主体的人的发展需求。

除了遵循上述一般性的伦理原则,教育人工智能亦需遵循教育规律,尤其要考虑教育主体中学生的发展需求。对教育主体而言,教育人工智能应以算法、关系、情感、资源为视角(赵磊磊等,2021),以仁爱为出发点,确保教育公平公正,且能最大程度地支持教育决策(邓国民等,2020)。针对学习者,李晓岩等(2021)还提出形塑自我原则,包含良善、诚信与节制。综上,学生作为人工智能的使用者和受用者,应秉持善用、恰用的准则,并有权力管控隐私数据(沈苑等,2019)、享受学习乐趣(Aiken et al.,2000)、依据技术做出决策(Nichols et al.,2018),从而享有更加公平且高质量的教育,促进自身健康、全面和个性化发展。因此,教育人工智能伦理原则须以人工智能伦理原则为基础,彰显公平、包容与数据算法使用合乎伦理的理念,尊重和凸显学生的发展需求。

3.伦理风险规避:技术设计与教育价值的双向规约

教育人工智能的伦理问题百般复杂,但主要来源于两个方面。一是技术设计与开发方面,算法易导致学生发展路径固化并带来偏见(Tuomi,2018),数据过度采集易加剧学生隐私数据泄露的风险(李世瑾等,2021)。二是教育实践方面,人工智能的应用可能导致教育不公平问题,以及师生关系、学生与技术的关系发生异化(吴河江等,2020)。针对上述问题,一方面要明确技术开发理念,遵循教育价值引导下的技术规范和科学标准(冯锐等,2020),不断优化算法。另一方面,学生应成为伦理的积极实践者(罗生全等,2020),对可能出现的风险持有清晰的认知,端正态度,掌握知识,遵循规范,合理运用技术,接受他人监督(李晓岩等,2021)。学校层面应开设人工智能课程,从意识态度、知识理解、应用实践等方面渗透伦理教育(Burton et al.,2017)。但伦理风险规避不是一蹴而就的,仍面临严峻的挑战与考验。例如,面对复杂的教育场景,宏观的人工智能伦理规范虽为教育人工智能提供了前瞻性认识指导,但仍未形成公认的规范准则(沈苑等,2019),其深入应用过程仍存在困难。另外,人工智能风险分析研究尚不深入,难以提供预警防范;以及人工智能课程资源有限,亦为伦理原则实践增加了难度(杨现民等,2018)。

综上所述,如何从学生的伦理认知角度破题析因、找寻对策,是支撑教育人工智能与学生协同共处,促进学生全面发展的关键。因此,研究基于综述分析,构建了面向大学生的教育人工智能伦理内涵框架,通过调研了解大学生对教育人工智能伦理认知的现状,并从自上而下和自下而上相结合的视角提出了伦理风险规避对策,以期为教育人工智能助力构建新型智能教育生态提供指导建议。

三、研究设计与实施

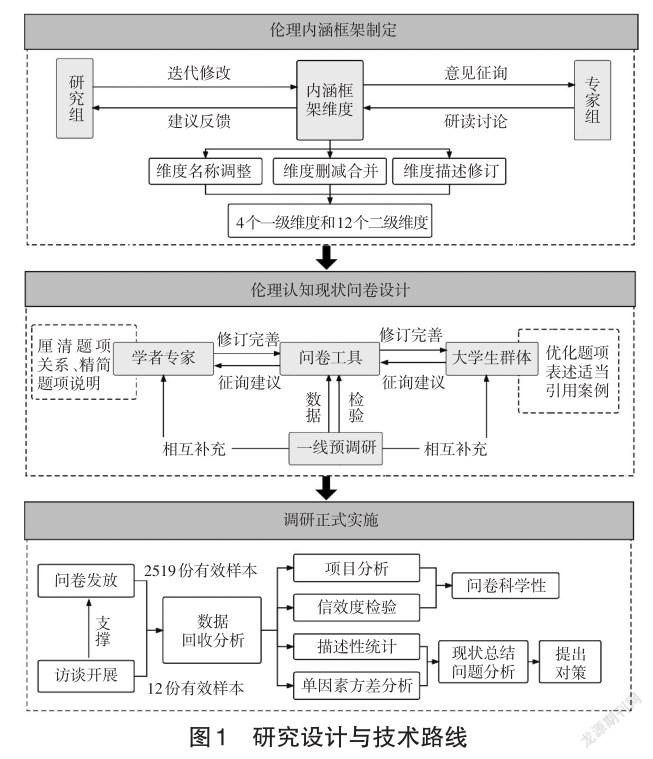

研究设计与实施分为三个阶段,如图1所示。在伦理内涵框架制定阶段,依据政策和文献研究,经过专家咨询及多轮迭代制定并修改伦理内涵框架。在伦理认知现状问卷设计阶段,针对大学生群体制定问卷并开展预调研。在调研正式实施阶段,以问卷调查为主、以访谈为辅探究大学生对教育人工智能伦理的认知现状。在此基础上,研究还剖析了伦理建设难点问题,并提出相应的对策建议。

1.伦理内涵框架制定

研究以教育人工智能伦理内涵为出发点,遵循人工智能伦理规范与要求,结合教育发展特征和学生发展需求,主要参考《合乎伦理的人工智能框架》,初步构建了教育人工智能伦理内涵框架。例如,借鉴《合乎伦理的人工智能框架》中的“有益”“公平”“数据”“安全可释”而改编为本研究的“发展助力”“多元包容”“数据管理”“安全可靠”4个维度,同时基于智能依赖、价值冲击等伦理风险及形塑自我原则,提出“自主维护”维度。最终,面向大学生的教育人工智能伦理内涵框架由自主维护、发展助力、多元包容、数据管理和安全可靠5个维度构成,并将其进一步细分为17个子维度,包括自主思考、自我肯定、自我约束、学习提升、健康保障、人际交往、情感引导、尊重差异、多元丰富、反馈说明、环境友好、数据授权、数据知情、数据保护、稳健可靠、风险抵御、透明可释。

为确保框架的科学合理性,研究采用德尔菲法,邀请16名专家开展了两轮咨询,以变异系数高于0.25为维度筛选标准来修改和完善框架。

在第一轮咨询中,专家对各维度设置表示肯定,但认为维度命名与描述仍需优化。(1)“自主维护”:维度命名容易与“技术系统维护”相混淆;(2)“发展助力”:可删除“身体健康”,并将关于学习发展的内容纳入其中;(3)“多元包容”:“环境友好”与“节省资源”表述欠佳;(4)“数据管理”与“安全可靠”:合并两个维度的内容。结合专家建议,研究将“环境友好”改为“可持续发展”,将“自主维护”改为“自立自主”,合并“数据管理”与“安全可靠”,并修订部分维度的描述。

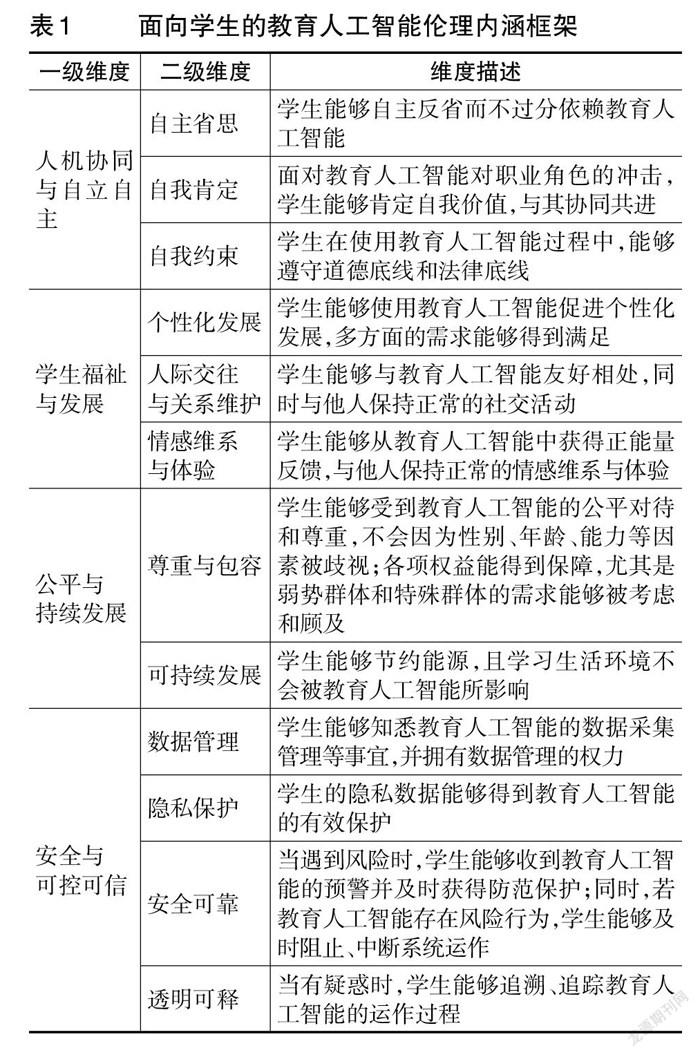

在第二轮咨询中,专家对各维度的平均分、标准差和变异系数分别在8.19~9.38(满分为10分)、0.86~2.01、0.09~0.23的范围内,表明专家意见分歧大幅减少,伦理内涵框架构建的科学性获得较高认同。同时,专家建议将“反馈解惑”删除,维度命名还应体现《伦理规范》的要求。通过进一步优化维度名称及其表述,研究最终提出了涵盖“人机协同与自立自主、学生福祉与发展、公平与持续发展、安全与可控可信”4个一级维度以及12个二级维度的伦理内涵框架(如表1)。

2.调研对象

研究选取大学生为调研对象,主要基于两点考虑:一是大学生是使用智能技术的主要群体,他们对教育人工智能的伦理认知比中小学生更为深刻,且学习生活更具弹性也相对自由,但其尚未形成良好的自我管理能力(张敏等,2021),缺乏来自外界的规约,面临较为严峻的伦理风险。二是高校人工智能伦理教育推进缓慢(任安波等,2020),因此亟需全面了解大学生群体的伦理认知现状,以为高校伦理教育改革提供证据。

3.调研设计与实施

根据已确定的面向大学生的教育人工智能伦理内涵框架,编制调查问卷。问卷包括导语、基本信息及认知现状调研主体三部分。其中,认知现状调研共有23道题,题项均采用李克特5点量表。要求大学生根据实际情况作答,数值越高,表示符合程度越高。该问卷主体部分的信效度良好(Cronbach’s α=0.912,KMO=0.944,Sig.=0.000),达到了施测的要求。问卷以在线形式随机发放,共回收3474份。在清洗數据时,删除以下样本:(1)问卷填写对象不是大学生;(2)填写时间过短;(3)有效性检验题未通过;(4)题项标准分|Z|>=3。最终,研究得到有效问卷2519份,有效率为72.5%。回收的有效问卷中,本专科生有2274名,研究生有245名。

四、数据结果分析

1.大学生对教育人工智能伦理认知的画像

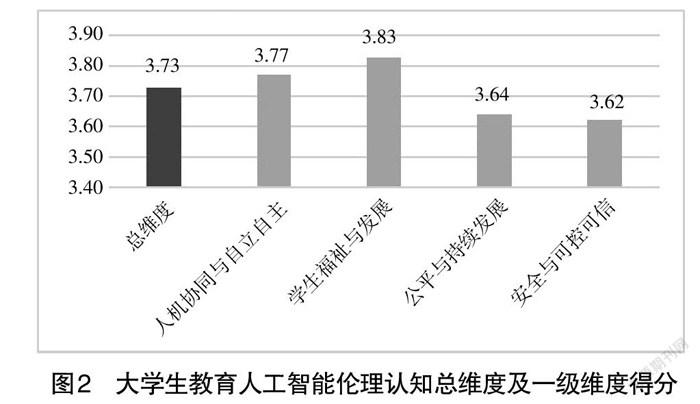

从图2可知,整体而言,大学生对教育人工智能伦理认知的总维度得分均值为3.73分,尚未达到“比较满意”的程度。各一级维度得分均值均高于3分,但彼此之间存在差距。其中“公平与持续发展”和“安全与可控可信”得分相对较低。由此可见,教育人工智能在设计、开发、应用中的公平性、普惠性、安全性与可靠性还有待改善。

从“人机协同与自立自主”的二级维度得分可知(见图3),大学生能坚守道德底线和法律底线,有意识地成为一名诚信的技术使用者,与教育人工智能实现基本的协同,不会轻易否认自身价值。但他们对教育人工智能的依赖性较强,使得思考的独立性和自主性有所降低,维度均值仅为3.53分。对数据的进一步分析表明,近40%的大学生可能由于课业压力大、管理能力不强等原因而面临这方面的伦理风险。

从“学生福祉与发展”的二级维度得分可知(见图3),教育人工智能能够基本满足大学生的个性化学习需求,固化成长路径的现象并不严重。沟通能力是智能时代大学生协同合作的重要能力。但大学生的人际交往和情感交流能力在一定程度上被削弱。统计得出,43%的大学生容易忽视了与他人的正常交往;35%的大学生正面临情感交流危机。

从“公平与持续发展”的二级维度得分可知(见图3),教育人工智能的公平性和包容性相对较弱,未能兼顾所有大学生的发展需求,对弱势群体和特殊群体的关照不到位。同时,该维度下的“可持续发展”得分也相对更低(得分为3.50分),表明大学生不太关注教育人工智能可能带来的环境影响,其可持续性有待加强。

从“安全与可控可信”的二级维度得分可知(见图3),教育人工智能的安全性、可靠性、可释性有待提高,尤其对隐私数据的保护亟待加强。“隐私保护”维度得分仅为3.37分,为所有二级维度最低得分。结合问卷与访谈分析可知,约55%的大学生正在经受这一伦理风险,这表明教育人工智能技术还存在缺陷,不足以提供强大的隐私安全保障。

2.不同大学生群体对教育人工智能伦理认知差异分析

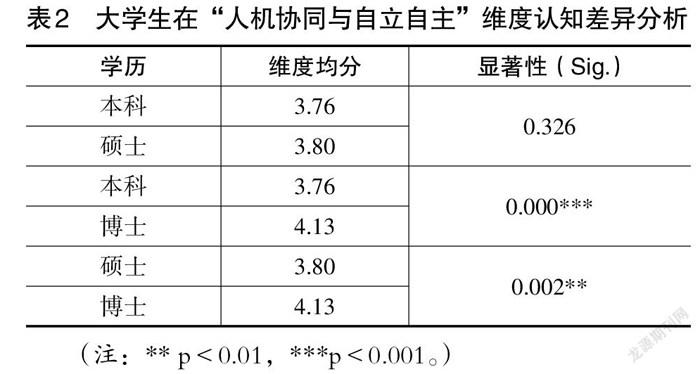

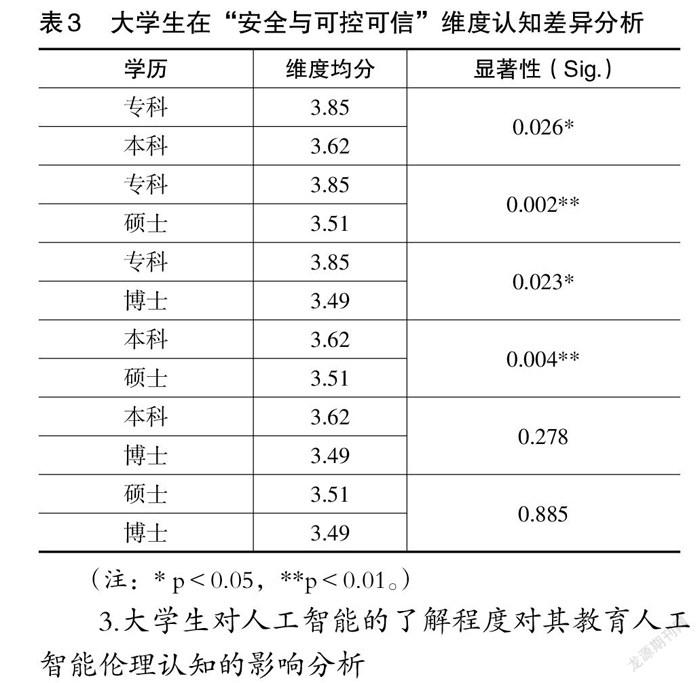

以单因素方差分析的方式对不同学历和不同年级学生在各维度上的得分进行了差异检验,结果显示,不同学历的大学生在“人机协同与自立自主”“安全与可控可信”两个维度上均存在显著差异(Sig.=0.002)。

具体而言,在“人机协同与自立自主”维度,博士生的得分远比本科和硕士生的得分要高,两者之间的差异均达到显著水平(见表2)。可能的原因在于,博士生在与教育人工智能协同共处的过程中表现出更强的自我管理能力,其思考的独立性和自主性也较强。同时,本科各年级在该维度上的得分由高到低依次为大一、大二、大四、大三;除大三与大四之间外,其余各年级之间均表现出显著差异(Sig.<0.01)。结合访谈得知,大一新生相较于大三和大四的学生,也表现出更好的自我管理和独立思考能力,这可能与其刚步入大学有教师的正确引导有关。

在“安全与可控可信”维度,除博士生与本硕生以外,其余学历之间均存在显著差异,按照得分由高到低依次为专科生、本科生、硕士生与博士生(见表3)。由此可见,随着学历的不断提升,大学生的安全防范意识更为强烈,更能清楚认识到人工智能在与人类共处过程中可能存在的安全隐患,因而也能更好地应对教育人工智能伦理风险。

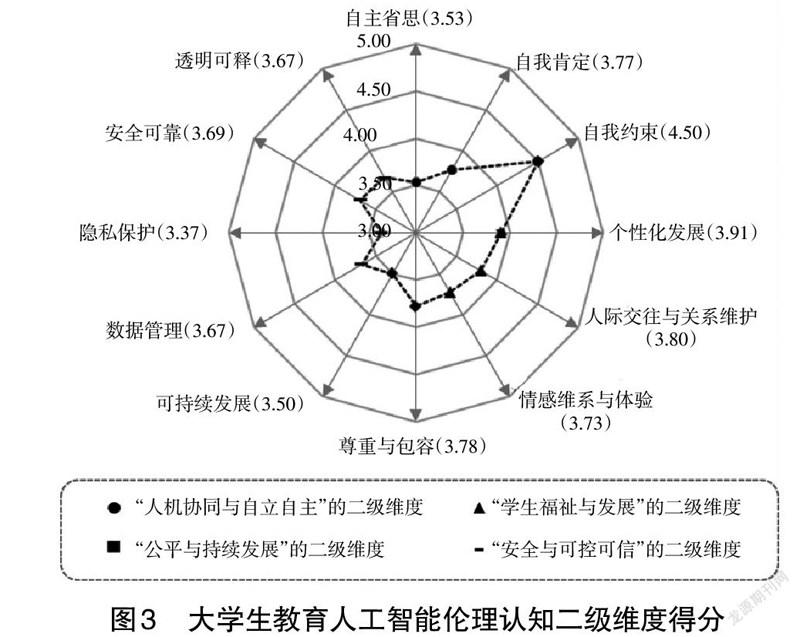

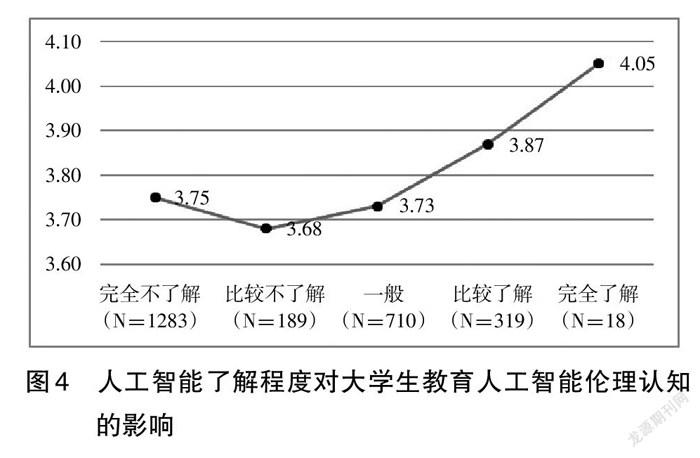

3.大学生对人工智能的了解程度对其教育人工智能伦理认知的影响分析

由图4可知,除去对人工智能“完全不了解”的情况,随着对人工智能了解程度的增加(从“比较不了解”到“完全了解”),大学生对教育人工智能伦理认知的得分均值在不断增加。这进一步表明,对人工智能更为了解的大学生其对伦理风险的关注度更高,能更为清晰地认识到风险产生的原因和类型,也更能有效协调彼此的关系。

五、教育人工智能伦理建设的四大难题

既然大学生对教育人工智能伦理认知的现状 不容乐观,那么就有必要分析当前教育人工智能伦理建设存在的难题,以便针对性地提出其伦理建设路径。通过文献梳理和调研剖析发现,目前教育人工智能伦理建设主要面临四大难题。

1.教育人工智能伦理建设缺乏精准的规范与指引

当前研发者、使用者和管理者在研发、应用、管理人工智能的过程中,对技术给社会带来的潜在影响的考虑还不够充分(新华社,2019)。对于智能教育企业而言,一方面,研发者缺乏必要的教育知识与经验,可能会无意间创造出阻碍人类发展的技术结构(颜士刚,2015),进而带来教育数据过度收集和算法偏见等问题。另一方面,部分企业出于逐利目的而存在恶意收集、使用学生隐私数据的行为,从而对学生的安全造成威胁。此外,由于学校管理者和教师考虑欠佳,在引进、管理与使用技术的过程中,还可能会造成数据管理不当、学生过于依赖人工智能技术等问题。归根到底,造成这些问题的主要原因在于当前教育人工智能伦理建设在顶层设计层面缺乏精准的规范与指引。

2.教育人工智能技术自身局限不利于伦理规约建立

教育人工智能在数据、技术和安全方面的特性限制了其倫理建设与规约。其一,教育人工智能以海量数据为支撑,以此构建算法模型支持教育活动的开展。但在教育体系中,数据来源散乱,数据形式复杂,数据质量不高(杨现民等,2018),算法模型有所欠缺,难以兼顾所有学生的发展需求。其二,包容性不高,存在技术操作繁复、智能产品设备要求高与快速迭代等情况,为弱势群体、特殊群体、边缘群体带来困扰,甚至使其排斥、厌恶智能产品,可能会加剧教育的不公平。其三,技术安全保障不到位。当前,教育人工智能的安全风险保障主要采用被动应急的措施,暂未能做到预警防范,技术安全保障措施亟待加强。

3.教师对学生的人文关怀与价值引领有所缺位

教师对学生的影响深远。因此,教师在引导和指导学生养成良好的技术使用习惯、提高学生智能教育素养、促进学生与人工智能的人机协同发展等方面占据重要地位。调研结果表明,当前大学生思考的独立性和自主性有所降低,人际交往与情感交流受到冲击,与教师、同伴之间的交流质量有所降低。固然由于自尊心强、技术心流、便捷性等因素,学生更愿意直接求助于教育人工智能,但当教师在学生人际交往、情感交流中缺少主动性时,也可能会进一步加剧师生之间的“冷漠”。同时,教师对智能技术操作的不娴熟和对伦理风险的忽视,也可能导致其在教学过程中缺乏对学生的针对性指导和引导。

4.教育人工智能学习资源建设粗放

我国一直在鼓励大中小学开设人工智能相关课程,走好人工智能普及之路。但调研发现,部分大学生对教育人工智能伦理问题的关注度不高,且有近80%的大学生未接触过人工智能相关课程。大学生对人工智能伦理问题的忽视,乃至其思考独立性和自主性下降、人际交往和情感交流弱化等问题,某种程度上也源于高校人工智能教育及伦理教育的缺失。可能的原因有二:一是部分高校缺乏人工智能学习资源建设的支持服务,不足以开展常态化的课程和活动;二是不同群体特征的大学生对教育人工智能伦理认知现状存在显著差异,由于缺乏前期调研工作的支撑,因而资源建设存在针对性不强、质量参差不齐的情况。

六、教育人工智能伦理建设的五条路径

立足于当前大学生对教育人工智能伦理认知的现状,以及教育人工智能伦理建设存在的难题,笔者提出如下伦理建设路径。

1.正确规约以立德树人为核心导向的教育人工智能伦理

立德树人是教育的根本任务。教育人工智能的“价值取向”会对学生产生深刻影响,而技术的价值是由技术设计者和创造者共同赋能的(祝智庭,2018)。为此,应加快落实面向设计者和创造者的伦理教育,要求其践行伦理规范与准则,从系统设计的根源上规避和减少伦理风险的产生。同时,技术设计者、创造者应与教育工作者保持紧密合作,结合教育需求,不断升级改良合乎教育伦理价值的技术,使其做到可控、可靠、可信赖,从而实现技术理性标准与人的价值取向相一致(于英姿等,2020)。唯有夯实智能教育的发展基础,才能实现教育“立德树人、全面育人、公平普惠”的目标。

2.合理编制教育人工智能伦理规范指南

当前部分企业过度收集和利用学生隐私数据、学生利用智能工具作弊等新闻事件时有发生,已引起国家和社会的广泛关注。教育是一个复杂的系统,与技术的研发、使用、管理环环相扣,每一环节都至关重要,需要更为精准细致的伦理规范作为指导和支撑。因此,面对教育人工智能应用过程中凸显出来的伦理失范问题,应在现有的人工智能伦理规范体系下,编制教育人工智能伦理规范指南,并围绕伦理规范指南,出台相应的法律法规、责任清单和问责机制,为研发者、使用者、受用者和管理者四大主体提供正确的行动引领,明确技术与人的权力边界,规范各类主体的行为。

3.提高教师智能教育素养水平并发挥其示范引领作用

技术在教育中的价值彰显不在于技术本身,而在于其教学实践应用。教师在运用各类智能技术开展实践教学的过程中,需要充分发挥其主观能动性,做出合乎教育效益、伦理规范和技术效能的教学安排与决策。为此,提升教师的智能教育素养水平成为规避伦理风险的必然选择。一方面,智能教育要求教师秉持人本主义的教育人工智能应用理念与原则,明确伦理与安全规范(胡小勇等,2021),不断向深度高效的“人机协同”目标靠拢。另一方面,教师在课程教学、教书育人过程中应自觉融入人文与技术相结合的伦理原则和规范,引导学生合理合法地使用技术,正确处理、看待自身与教育人工智能的协同关系。

4.探索智能技术赋能的伦理风险精准预警机制

科技向善,一切技术都应以某种善为目标。当前因技术异化而导致教育生态失衡问题日益严重,因此应当充分发挥人的主观能动性,积极提出应对举措并付诸行动。为加强技术安全保障,企业可与国家相关部门、高校合作,充分利用智能技术赋能伦理建设,细分伦理挑战风险类型,针对不同的风险类型制定解决预案,开发合乎伦理的风险预警系统,以此持续监测教育人工智能伦理风险情况。一旦发现异样,及时给执法部门、教育部门、学校、教师、学生、家长等发送预警信息,从而实现精准施策。但当前的风险预测分析等技术研究主要基于大数据的应用,集中在金融、公共信息安全等领域,而涉及教育领域的智能技术风险分析的研究很少。因此,国家相关部门和高校专家学者应重视该领域的研究,不断加快发展其风险监测技术。

5.建设公益性教育人工智能学习资源并鼓励公众学习参与

我国教育部前部长陈宝生(2019)在国际人工智能与教育大会上曾强调,要让人工智能新技术、新知识、新变化从教学中进入大中小学生头脑,从职业培训中培养教师实施智能教育的能力,更要从全民科普活动中推进全民智能教育。调研表明,大学生的教育人工智能伦理认知现状与其人工智能知识水平相关。因此,当前应由国家相关部门牵头,以高校为主导力量,探索建设一批公益性教育人工智能学习资源,助力提升全民智能教育素养。伦理教育更是学习资源建设的重要一环,需要不同领域(如哲学、教育学、生态学、计算机科学等)的专家学者协同设计和实施,以助力伦理原则与规范的普及和实践。

毋庸讳言,对学生的现在负责,就是对社会的未来发展负责。学校作为教育的重要场所,在伦理风险规避上有着不可推卸的责任。为此,可结合不同阶段的学生特性进行施策,具体而言,中小学可将教育人工智能伦理教育融入信息技术课程和校本课程中,举办趣味活动激发学生学习的熱情。高校可针对不同学历和不同年级学生的需求,将伦理教育融入计算机等必修课程或所开设的通识教育课程中,通过组织主题讲座、企业学习参观、创意话剧表演等活动,不断提高大学生对伦理问题的关注度与认知度,进而促进其形成正确的技术思考与行为习惯。

七、结语

人工智能时代机遇丛生,也充满挑战。著名物理学家霍金曾表示:“人工智能发展到极致时,我们将面临着人类历史上的最好或者最坏的事情。”(British Broadcasting Corporation,2014)教育人工智能为教育事业的发展作出了积极的贡献,但也给人类带来了严峻且迫切的挑战。如何最大程度地规避教育人工智能的伦理风险,稳步推进教育高质量发展,是值得深入探讨的问题。针对当前伦理风险频发及调研工作缺失的情况,本研究面向大学生开展了教育人工智能伦理认知现状调研,剖析了教育人工智能伦理建设的难点问题,并提出了具有前瞻性和针对性的政策建议。未来研究团队将继续面向中小学生深入开展调研,以更系统地探索其教育人工智能伦理认知现状及伦理建设难题,从而提出更全面的对策建议。但无论如何,人类都应充分发挥其主观能动性,直面可能产生的伦理风险并将伦理规范嵌入教育人工智能的全生命周期中,不断夯实智能教育发展和智慧社会建设的根基。

参考文献:

[1]陈宝生(2019).走好智能时代中国教育发展道路[J].中国教育网络,(6):20-21.

[2]邓国民,李梅(2020).教育人工智能伦理问题与伦理原则探讨[J].电化教育研究,41(6):39-45.

[3]杜静,黄荣怀,李政璇等(2019).智能教育时代下人工智能伦理的内涵与建构原则[J].电化教育研究,40(7):21-29.

[4]冯锐,孙佳晶,孙发勤(2020).人工智能在教育应用中的伦理风险与理性抉择[J].远程教育杂志,38(3):47-54.

[5]郝祥军,王帆,祁晨诗(2019).教育人工智能的发展态势与未来发展机制[J].现代教育技术,29(2):12-18.

[6]胡小勇,徐欢云(2021).面向K-12教師的智能教育素养框架构建[J].开放教育研究,27(4):59-70.

[7]李建华(2020).伦理与道德的互释及其侧向[J].武汉大学学报(哲学社会科学版),73(3):59-70.

[8]李世瑾,胡艺龄,顾小清(2021).如何走出人工智能教育风险的困局:现象、成因及应对[J].电化教育研究,42(7):19-25.

[9]李晓岩,张家年,王丹(2021).人工智能教育应用伦理研究论纲[J].开放教育研究,27(3):29-36.

[10]刘三女牙,刘盛英杰,孙建文等(2021).智能教育发展中的若干关键问题[J].中国远程教育,(4):1-7,76.

[11]罗生全,王素月(2020).人工智能背景下的大学教学伦理重建[J].大学教育科学,(5):96-102.

[12]任安波,叶斌(2020).我国人工智能伦理教育的缺失及对策[J].科学与社会,10(3):14-21.

[13]沈苑,汪琼(2019).人工智能在教育中应用的伦理考量——从教育视角解读欧盟《可信赖的人工智能伦理准则》[J].北京大学教育评论,17(4):18-34,184.

[14]吴河江,涂艳国,谭轹纱(2020).人工智能时代的教育风险及其规避[J].现代教育技术,30(4):18-24.

[15]新华社(2019).发展负责任的人工智能:我国新一代人工智能治理原则发布[EB/OL].[2021-07-03].http://www.gov.cn/xinwen/2019-06/17/content_5401006.htm.

[16]徐晔(2018).从“人工智能教育”走向“教育人工智能”的路径探究[J].中国电化教育,(12):81-87.

[17]颜士刚(2015).教育技术哲学[M].北京:中国社会科学出版社:170.

[18]杨现民,张昊,郭利明等(2018).教育人工智能的发展难题与突破路径[J].现代远程教育研究,(3):30-38.

[19]于英姿,胡凡刚(2020).隐忧与消解:智能技术之于教育的伦理省思[J].远程教育杂志,38(3):55-64.

[20]张敏,王朋娇,孟祥宇(2021).智能时代大学生如何破解“信息茧房”?——基于信息素养培养的视角[J].现代教育技术,31(1):19-25.

[21]赵磊磊,张黎,代蕊华(2021).教育人工智能伦理:基本向度与风险消解[J].现代远距离教育,(5):73-80.

[22]中华人民共和国教育部(2019).联合国教科文组织正式发布国际人工智能与教育大会成果文件《北京共识——人工智能与教育》[EB/OL].[2021-07-03].http://www.moe.gov.cn/jyb_xwfb/gzdt_gzdt/s5987/201908/t20190828_396185.html.

[23]中华人民共和国科学技术部(2021).《新一代人工智能伦理规范》发布[EB/OL].[2021-10-12].http://www.most.gov.cn/kjbgz/202109/t20210926_177063.html.

[24]祝智庭(2018).教育从不单纯根据技术需求来变革[EB/OL].[2021-11-02].http://nic.upc.edu.cn/2018/0613/c7404a

155602/pagem.htm.

[25]AI HLEG (2019). Ethics Guidelines for Trustworthy AI[EB/OL]. [2021-07-03]. https://op.europa.eu/en/publication-

detail/-/publication/3988569-0434-11ea-8c1f-01aa75ed71a1.

[26]Aiken, R. M., & Epstein, R. G. (2000). Ethical Guidelines for AI in Education: Starting a Conversation[J]. International Journal of Artificial Intelligence in Education, 11:163-176.

[27]British Broadcasting Corporation (2014). Stephen Hawking Warns Artificial Intelligence Could End Mankind[EB/OL]. [2021-10-18]. https://www.bbc.com/news/technology-30290540.

[28]Burton, E., Goldsmith, J., & Koenig, S. et al. (2017). Ethical Considerations in Artificial Intelligence Courses[J]. AI Magazine, 38(2):22-34.

[29]Hogenhout, L. (2021). A Framework for Ethical AI at the United Nations[EB/OL]. [2021-07-03]. https://unite.un.org/sites/unite.un.org/files/unite_paper_-_ethical_ai_at_the_un.pdf.

[30]Jobin, A., Ienca, M., & Vayena, E. (2019). The Global Landscape of AI Ethics Guidelines[J]. Nature Machine Intelligence, 1:389-399.

[31]Kissinger, H. A. (2018). How the Enlightenment Ends[EB/OL]. [2021-07-08]. https://www.henryakissinger.com/articles/how-the-enlightenment-ends/.

[32]Nichols, M., & Holmes, W. (2018). Don’t Do Evil: Implementing Artificial Intelligence in Universities[C]// Proceedings of the European Distance and E-Learning Network (EDEN) Conference:110-118.

[33]Siau, K., & Wang, W. (2020). Artificial Intelligence (AI) Ethics: Ethics of AI and Ethical AI[J]. Journal of Database Management, 31(2):74-87.

[34]Tuomi, I. (2018). The Impact of Artificial Intelligence on Learning, Teaching, and Education[R]// Cabrera, M., Vuorikari, R., & Punie, Y. (Eds.). Policies for the Future. Luxembourg: Publications Office of the European Union.

收稿日期 2021-10-12 責任编辑 刘选

Research on Ethics of Educational Artificial Intelligence: Connotation Framework,

Cognitive Status and Risk Avoidance

HU Xiaoyong, HUANG Jie, LIN Zirou, HUANG Manting

Abstract: While the artificial intelligence enables education to develop rapidly, it is also facing urgent ethical challenges. Therefore, it is important to clarify the connotation of ethics of educational artificial intelligence (EAI), describe the status of college students’ ethical cognition and refine feasible strategies of risk avoidance. Based on the research into government policies and literature, after two rounds of revision and improvement by Delphi, an ethical connotation framework of EAI was constructed. It consists of four first-level dimensions including “man-machine coordination and independence”“well-being and development of students”“fairness and sustainable development”“safety and reliability” dimensions and twelve second-level dimensions. The questionnaire survey on the basis of this framework shows that college students’ ethical cognition of EAI is unbalanced, and they get low scores in the dimensions of “fairness and sustainable development” and “safety and reliability”. And the educational background, the grade and the understanding of AI all have a significant influence on college students’ ethical cognition of EAI. Currently, the construction of EAI ethics is confronted with difficulties such as the lack of precise norms and guidance, the absence of humanistic care and value guidance, limitations of technology and extensive construction of learning resources. In the future, strategies should be adopted to avoid ethical risks, such as standardizing the ethic of EAI correctly, developing ethical guidelines for EAI, improving intelligent education literacy for teachers, making intelligent technology support ethical construction and developing non-profit learning resources and so on. Only by embedding ethical standards into the whole lifecycle of EAI can we construct new intelligent education ecology.

Keywords: Educational Artificial Intelligence; Ethical Connotation; Ethical Cognition; Ethical Risk; Delphi Method