基于遥感大数据的信息提取技术综述

刘伟权,王程,臧彧,胡倩,于尚书,赖柏锜

1. 厦门大学信息学院,福建 厦门 361005;2. 福建省智慧城市感知与计算重点实验室,福建 厦门 361005

0 引言

随着对地观测技术的快速发展,我国逐步形成了全天候、全球覆盖的对地观测能力,并建立了比较完善的航天遥感和灵活多样的航空遥感数据获取体系。依据遥感平台的高度,遥感技术可划分为地面遥感、航天遥感以及航空遥感。地面遥感指将地物波谱仪或各种传感器安装在船、车、高塔等平台上的遥感技术系统;航天遥感指以载人飞船、太空站、人造卫星等各种太空飞行器为平台,搭载照相机、多谱段扫描仪、合成孔径雷达(synthetic aperture radar,SAR)等传感器的遥感技术系统;航空遥感指利用飞艇、飞机、气球等平台完成对地观测任务的遥感技术系统。航空遥感影像成像比例尺大,地面分辨率高,测量精度高,适合小区域的资源探测和环境监测。但航空遥感平台高度和续航时间有限,成像质量也易受天气影响。航天遥感以卫星遥感为主,卫星的轨道高度可高达900多千米,其影像覆盖面积大,能提供大范围的地表信息。

近年来,高分辨率对地观测系统的实施、商业遥感卫星的投入运行以及无人机的普及,极大地丰富了遥感数据资源。目前,遥感技术已被广泛应用于环境保护、城市建设、灾害预报与灾情评估等领域;同时,智慧城市等国家重大战略需求也与遥感技术息息相关,这意味着我国对遥感数据的需求急剧增长,也意味着遥感大数据时代已经来临。

遥感大数据以海量遥感数据为主,综合其他多源遥感数据,运用大数据思维与手段,发掘海量数据中的知识规律和高价值信息[1]。遥感大数据虽然能够多粒度、多时相、多方位和多层次地反映地物信息,但其数据量与日俱增、种类日益增多,且存在大量的冗余信息,使得从遥感数据中提取有效信息具有一定的挑战。当前,我国遥感信息提取利用率还不到数据获取量的5%[2],这表明遥感大数据的高价值信息尚未被充分挖掘。

遥感信息提取经历了3个主要发展阶段。第一阶段(20世纪60年代至80年代)主要采用数字信号处理方法完成遥感数据分析任务[3]。Swain P H等人[4]运用统计模型从遥感数据中提取信息,并在此基础上研究了各种数据采集系统,为开发应用于遥感数据分析的统计建模技术奠定了基础。常用的信息提取模型有模糊聚类[5]、目视解译[6]、决策树分类[7]等。然而,由于各地区地形特征不同,统计方法很难应用于不同的区域和环境。1990年,随着“定量遥感时代”的来临,遥感信息提取技术步入了第二阶段。此时,美国EOS(Earth Observation System)卫星开始通过中分辨率成像光谱仪(middle resolution imaging spectrometer,MODIS)提供全球定量遥感产品,使得研究人员可以利用这些产品开发物理模型。与统计模型相比,物理模型可以解决更多不同的应用问题,但物理模型通常基于复杂的非线性方程式,并且需要许多输入参数和先验知识。由于遥感大数据体量巨大、种类繁多、动态多变、冗余模糊,统计模型和物理模型需耗费大量人力资源,且处理效率低。到了21世纪初期,遥感信息提取技术步入第三阶段,包括人工神经网络、支持向量机(support vector machine,SVM)在内的浅层学习方法已被广泛运用于遥感信息提取任务。但是,浅层学习方法中使用的样本数据较小,其建模得到的模型参数的数量也非常有限。因此,这些模型的泛化能力较弱,从而限制了模型的通用性。为了解决上述问题,已有许多学者将深度学习方法应用于遥感数据,如高空间分辨率图像分割[8]、高光谱图像分类[9]、遥感图像变化检测[10]等。深度学习方法侧重于从数据本身提取特征和信息,而不是依靠专家的先验知识,因此可以降低传统遥感信息处理方法对先验知识的依赖性。虽然深度学习方法可以显著提高模型的准确性,但其仍然面临着诸多挑战,如遥感数据体量巨大,存储、读取和分析如此大量的遥感数据非常困难;在实际应用中,接近实时的遥感大数据处理和信息提取非常具有挑战性;遥感图像质量易受到大气影响、环境干扰、传感器抖动等因素的影响,使获取的数据存在不确定性,从而难以从数据中获取有价值的信息。

本文调研了近年来基于遥感大数据的信息提取技术的研究工作,从遥感目标检测、遥感地物分割、遥感变化检测三方面阐述了遥感信息提取技术的发展历程,对遥感目标检测、遥感地物分割、遥感变化检测3个任务的各个发展阶段及代表性方法进行了梳理,并对遥感信息提取技术进行了展望。

1 遥感目标检测

遥感图像数据集[11-12]通常包含图像和实例,涵盖若干个对象类,如飞机、机场、棒球场、篮球场、桥梁、烟囱、水坝、高速公路服务区、高速公路收费站、港口、高尔夫球场、地面田径场、天桥、船舶、体育场、储罐、网球场、火车站、车辆等。其中有些涵盖了人类居住环境的部分类型地面特征,有些则包括了冰川、沙漠和戈壁等极端陆地环境。数据库中除了包含很小的目标,还表现出不同的可变性,例如多个方向的光照或阴影变化、镜面反射或遮挡。相比传统数据,遥感数据因其分辨率等问题更加难以检测,如大场景的快速检测、目标检测的领域迁移、小样本下的目标检测、SAR图像和光学的融合检测以及云雾干扰下的检测等。随着手工特征的性能趋于饱和,目标检测在2010年之后达到了一个稳定的水平。2012年,卷积神经网络再次兴起,逐渐被研究学者们应用在各种计算机视觉任务中。由于深度卷积网络能够学习图像的鲁棒性和高层次特征表示,2014年有研究团队提出利用具有卷积神经网络特征的区域进行目标检测。目前,结合深度学习进行遥感图像目标检测是解决问题的有效手段之一,下面将归纳遥感图像的各种目标检测技术,并解释概念细节。

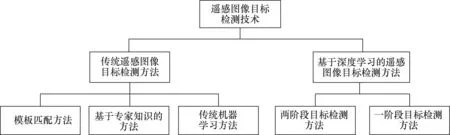

遥感图像目标检测方法主要包括两个分支:传统遥感图像目标检测和基于深度学习的遥感图像目标检测,如图1所示。其中,传统遥感图像目标检测主要包括3类方法:一是模板匹配方法,该类方法使用相应的模板对目标图像进行比对,找出图像中符合模板特征的事物,但该方法缺乏鲁棒性;二是基于专家知识的方法,该类方法主要通过专家定义的规则对目标进行定义和选择,从而达到目标检测的目的;三是传统机器学习方法,该类方法通过人工设计的图像特征,对目标进行定义和检测。基于深度学习的遥感图像目标检测主要分为两类方法:一是两阶段目标检测方法,该类方法需要先提取目标的边界框,再对目标进行分类;二是一阶段目标检测方法,该类方法将边界框检测和目标分类两个任务合并为一步完成。

图1 遥感图像目标检测技术路线

相对于普通图像目标检测,遥感图像目标检测存在以下挑战。一是图像分辨率高。图像分辨率高会带来尺度效应,不同分辨率导致图像目标检测出现不同的结果,遥感图像目标检测过程中,需要选择不过低也不过高的分辨率,以得到可用的检测结果。二是图像多光谱数据。相比普通三波段图像,遥感图像的光谱分辨率高、数据冗余性高,在基于深度学习的遥感图像目标检测过程中容易产生过拟合。因此选择基于深度学习的遥感图像目标检测方法时,通常采用具有代表性的波段进行算法分析。三是图像遮挡。遥感图像容易受到云雾的遮挡,导致目标检测算法无法检测相关目标,现有的研究中使用的数据预处理[13]和修正算法适用于薄云薄雾场景。

随着遥感图像分辨率达到亚米级的形态,高分辨率的图像提供了更丰富的颜色、纹理、轮廓等信息。传统遥感图像目标检测算法依赖于先验知识与图像处理技术,对特征设计和图像质量有较高的要求,可以在简单的场景中取得不错的结果,但是,传统遥感图像目标检测算法只针对某一个特定的场景设计,其泛化性弱且难以在复杂的环境中提供稳定的鲁棒性;基于深度学习的遥感图像目标检测方法可以处理大规模的高分辨率图像,并在遥感图像云雾遮挡方面提供解决方案,在准确率和召回率方面领先于传统遥感图像目标检测方法,但是仍存在对计算资源要求高、目标检测的实时性低问题。

1.1 传统遥感图像目标检测

传统遥感图像目标检测方法可以分为以下几类:模板匹配方法、基于专家知识的方法和传统机器学习方法。

(1)模板匹配方法

模板匹配方法是最早被提出的遥感图像目标检测方法[14],其过程如下:首先建立检测目标的标准模板库,然后从遥感图像中提取特征向量进行检测,并将其与模板对应的特征向量进行比较。这种方法依赖于手动设计的先验知识模板库,且计算复杂。根据用户选择的模板类型,通常将基于模板匹配的对象检测方法分为两类:刚性模板匹配和可变形模板匹配。

刚性模板匹配方法需设计多种刚性模板用于检测具有简单外观和较小变化的特定对象。例如McKeown D M等人[15]提出基于道路轮廓相关性的道路跟踪方法,通过识别偏移和宽度这两个几何参数,以及亮度的两个辐射度参数,测量参考轮廓和目标轮廓的失真。Zhou J等人[16]提出两个配置条件(一个与道路方向正交,另一个与道路方向平行)并引入了一种道路跟踪系统。Kim T等人[17]利用矩形模板而不是轮廓,构建了最小二乘相关模板匹配方法来跟踪道路的中心线。Zhang J X等人[18]提出了一种半自动的道路跟踪模板匹配方法,该方法通过用户在所选道路上输入种子点,使用辐条轮(spoke wheel operator)算法获取道路方向和宽度来生成矩形参考模板及其起点,并计算参考模板和目标模板灰度值的差异及欧几里得距离变换来执行匹配。虽然刚性模板匹配在某些特定遥感目标检测中是有效的,但要求模板非常精确,因此该类方法对形状和密度的变化较为敏感。在实际应用中,由于视点变化或对象之间的类内差异较大,通常无法获得对象的精确几何模板。

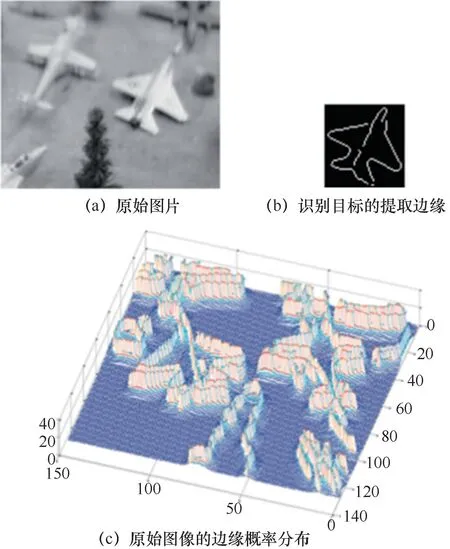

可变形模板匹配[19]在处理形状变形和类内变化方面比刚性模板匹配更加强大和灵活,其既可以对形状施加几何约束,又可以整合局部图像证据。可变形模板通过约束常规规则(例如连续性、平滑度等)表示对象形状,其中比较流行的方法包括主动轮廓模型,其也被称为蛇形(snake)模型。简而言之,“snake”能够弹性变形,但任何变形都会增加其内部能量,进而引起回复力,试图使其恢复原始形状[20]。Peng J等人[21]提出了一种改进的蛇形模型,通过修改传统蛇形模型中初始种子的选择标准和外部能量函数,进行灰度航拍图像的建筑物检测。Niu X T[22]设计了一种基于几何主动轮廓模型的半自动框架,用于高速公路提取和航空摄影中的车辆检测。Liu G等人[23]提出了一种使用基于形状的全局最小化主动轮廓模型提取具有规则形状的地理空间对象的算法。Xu C F等人[24]描述了一种形状匹配方法用于在低空识别飞机(如图2所示),并提出了一种具有边缘势场函数(edge potential function,EPF)的人工蜂群(artificial bee colony,ABC)算法。

图2 利用形状匹配方法进行飞机检测[24]

(2)基于专家知识的方法

基于专家知识的方法是光学遥感图像中对象检测的另一种流行方法。基于专家知识的目标检测已有大量的研究工作以及通用的对象提取应用程序,例如滑坡、桥梁、车辆、城市土地变化、农作物、排水渠、森林等目标提取。基于专家知识的目标检测方法通过建立各种知识和规则将对象检测问题转换为假设测试问题。其中,知识和规则的建立是最重要的步骤,广泛运用的知识是几何知识和上下文知识。几何知识是建模对象的外观形状,上下文知识则是建模对象与背景之间以及对象与对象之间的空间约束关系[25]。在几何知识和上下文知识能有效减少噪声干扰的基础上,基于专家知识的方法的关键步骤是建立专家知识。但基于专家知识的人为构造过于依赖主观因素,会导致误报和漏检,进而造成检测效果差。

几何知识是用于对象检测的非常重要和广泛使用的知识,它采用参数特定或通用形状模型对先验知识进行编码。Trinder J C等人[26]提出了一种包含几何和辐射特性的道路模型,使用手工规则生成道路假设,并采用自上而下的过程验证道路假设。Huertas A等人[27]假定建筑物是矩形或由矩形组件组成的,并使用这些通用模型检测建筑物。Weidner U等人[28]通过建立和使用参数化与棱柱形建筑模型形式的显式几何约束知识,从高分辨率数字高程模型(digital elevation model,DEM)中提取建筑的3D形状。McGlone J C等人[29]提出将目标几何和度量知识加入建筑物提取系统中,以生成建筑物假设模型,并最终用阴影信息验证所生成的假设。

上下文知识是基于专家知识的对象检测的另一关键感知信息,非常广泛使用的上下文知识是对象与背景之间的空间约束或关系,以及相关对象与其邻近区域进行交互的信息。阴影信息被认为是建筑物检测的重要线索之一。Irvin R B等人[30]利用人造结构与其投射阴影之间的关系预测建筑物的位置和形状,Liow Y T等人[31]使用阴影信息完成边界分组过程。Ok A O[32]使用阴影信息从单目超高分辨率图像中自动检测具有任意形状的建筑物,并提出一种新的模糊景观生成方法,对建筑物及其阴影之间的定向空间关系进行建模。Lin C G等人[33]提出了一种从倾斜航拍图像中检测建筑物的方法,其遵循建筑物形状为直线的基本假设,用阴影和墙壁信息对假设的矩形建筑物进行验证。Peng J等人[34]开发了一个阴影上下文模型,通过将阴影信息与上下文结合来验证建筑物区域,从而在密集的城市航拍图像中提取建筑物。基于专家知识的方法的核心是有效地将目标对象的隐性知识理解转化为显式检测规则。

(3)传统机器学习方法

传统机器学习方法首先从图像中提取感兴趣的区域,然后提取这些感兴趣区域的特征,并将这些特征输入经过训练的分类器中进行判断,最后通过非极大值抑制去除多余的候选区域,进而得到检测结果。

方向梯度直方图(histogram of oriented gradient,HOG)特征最早由Dalal N等人[35]提出,其通过空间分布区域中的梯度强度和方向分布表示对象,已被广泛认为是捕获对象的边缘或局部形状信息的优秀功能之一。Zhang W C等人[36]通过尺度不变特征变换(scaleinvariant feature transform,SIFT)描述符主导方向的坐标和梯度方向实现旋转不变HOG特征提取。Shi Z W等人[37]将圆周频率特征和HOG特征结合,提出了一种用于船只检测的圆周频率HOG特征,如图3所示。Zhang W C等人[38]提出GDPBM(generic discriminative partbased model),引入了一种生成HOG变体的策略,即将每个像素的梯度方向都通过极角进行归一化,然后根据新像素生成HOG特征,并用于车辆检测。

图3 遥感图像船只检测结果[37]

词袋(bag-of-word,BoW)模型[39]是过去比较流行的目标检测模型之一。BoW模型在视点变化和背景比较混乱的情况下具有简单性、效率高和不变性的优点,并在地理图像分类和地理空间物体检测方面表现良好。构造BoW模型通常可分为5个步骤:①从图像中检测关键点,例如Harris-Laplacian检测器[40]和高斯差分(difference of Gaussian,DoG)检测器[41];②对检测到的图像关键点计算局部描述符,例如SIFT描述符[41];③对局部描述符使用聚类技术(例如k均值算法)构建视觉词汇并创造字典;④将每个关键点矢量量化为字典中的可视单词,这一步骤通常被称为编码模块;⑤合并步骤,该步骤将已编码的本地描述符合并为全局直方图表示形式,例如均值合并。Lazebnik S等人[42]的研究表明,在合并步骤中考虑关键点的空间布局非常重要。空间金字塔匹配(spatial pyramid matching,SPM)是BoW模型的一个常用例子,它将图像划分为越来越精细的空间子区域,并分别为每个子区域构建直方图。例如Bai X等人[43]将BoW和SVM运用于遥感图像飞机场、船舰、房屋、运动场、桥梁和绿地的目标检测。

1.2 基于深度学习的遥感图像目标检测方法

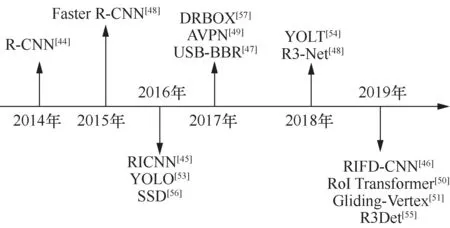

当前主流的基于深度学习的遥感图像目标检测框架按任务分解可分为一阶段目标检测方法和两阶段目标检测方法。两阶段目标检测方法基于多级深度特征预测几个候选对象的区域,然后将其送到分类/回归网络中以获得对象的类别和位置。一阶段目标检测方法可分为两类,一类是基于锚点的方法,另一类是无锚的方法。一阶段目标检测方法运用回归思想,不需要额外提取候选目标区域,而是直接从多级深度特征图中进行目标分类和位置回归,最后输出目标检测结果。基于深度学习的遥感图像目标检测方法发展历程如图4所示。

图4 基于深度学习的遥感图像目标检测方法发展历程

(1)两阶段目标检测方法

基于目标区域的两阶段目标检测框架主要基于多层深度特征预测可能包含目标的多个候选区域,并将它们输入分类和回归网络中,以预测目标的类别和位置。Girshick R[44]等人基于区域提取的算法提出了R-CNN(regions with CNN feature),主要包括4个步骤:候选区域提取、特征提取、基于SVM分类器的对象类别分类和边界框回归。首先,利用选择性搜索算法提取约2000个候选区域;其次,将每个候选区域调整为固定大小,并送至卷积神经网络模型;然后,获得固定长度的特征向量;最后,将特征向量输入经过训练的SVM分类器中,以预测候选区域中的目标属于每个类别的概率,并通过线性回归完善预测框的位置。

为了解决R-CNN在遥感图像中无法克服旋转不变性的问题,RICNN(rotation-invariant CNN)[45]在RNN的基础上,学习一个旋转不变层,保证了目标在不同的角度下保持旋转不变性,实现了遥感图像的车辆检测。RIFDCNN[46]在RICNN的基础上,通过改进特征描述符,引入了一个新型的损失函数,并结合正则化和Fisher描述符模块,实现了遥感图像的车辆检测。USB-BBR[47]通过训练不断地优化回归框的预测,以无监督训练方式提高了目标检测的性能,实现了油塔、飞机、天桥和操场的目标检测任务。

针对Fast R-CNN算法的不足,Ren S Q等人[48]在2015年提出了Faster R-CNN。Faster R-CNN算法使用区域提议网络(region proposal network,RPN)代替Fast R-CNN中的选择性搜索方法,并将框架分为两部分:候选区域提取网络,以及分类或回归网络。提取的候选区域被嵌入深度卷积神经网络中,通过联合损失和交替训练建立统一的目标检测网络,进一步提高了算法的准确性和速度。

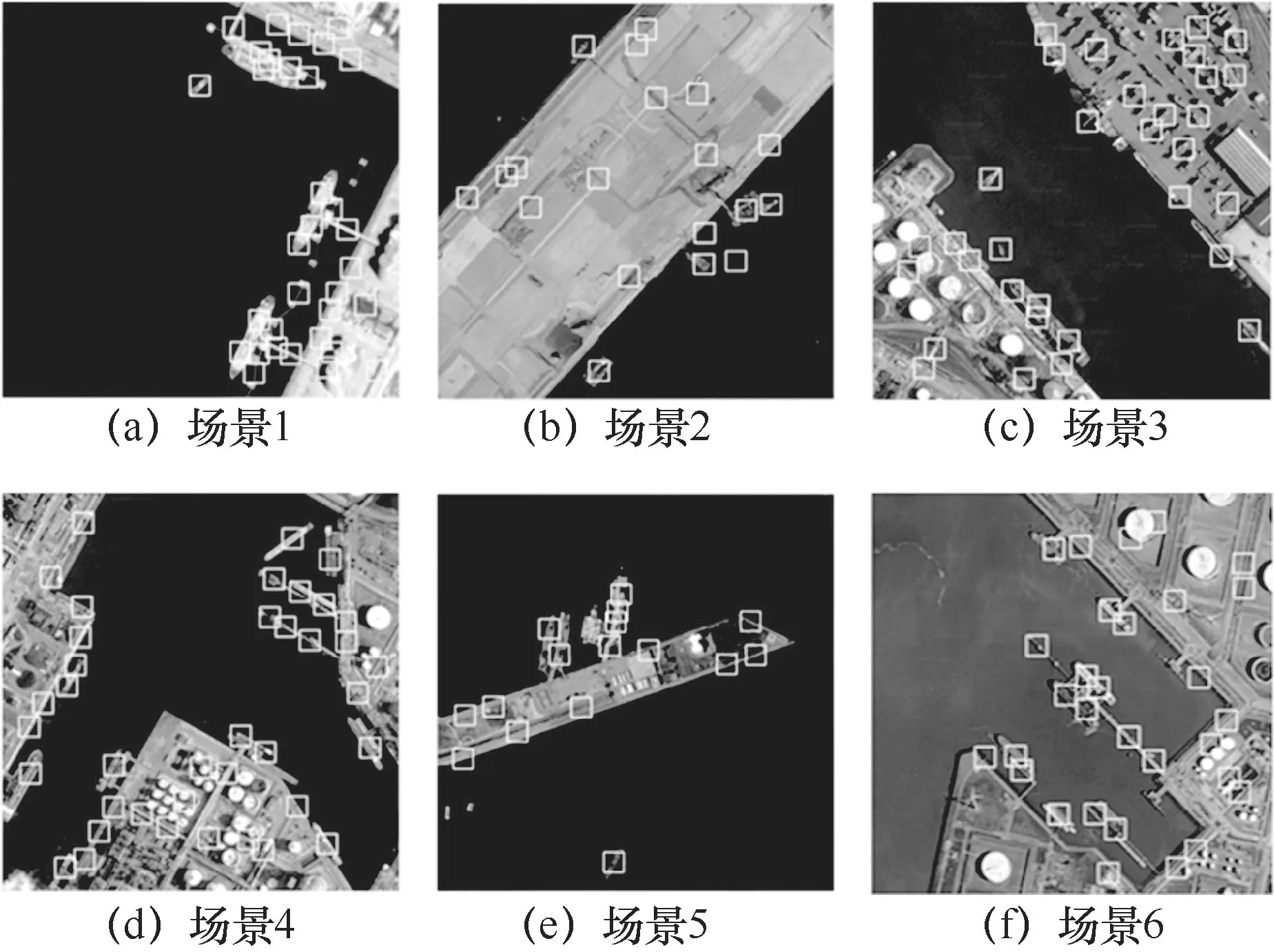

基于Faster R-CNN的遥感图像处理网络R3-Net[48]通过在区域提取网络中引入旋转角度获得了旋转不变性,并运用于车辆目标检测。AVPN[49]将Fast R-CNN运用于车辆形状的锚点设计。RoI Transformer[50]将网络学习得到的水平框改为拥有6个自由度的旋转框,解决了目标的旋转问题,在DOTA数据集和船只检测中得到了验证。RoI Transformer方法的检测结果如图5所示。Xu Y C等人[51]提出直接使用网络准确描述旋转框各个方向和位置的方法,并将其运用于DOTA数据集[52]的目标检测和船只检测。

图5 RoI Transformer方法的检测结果

(2)一阶段目标检测方法

一阶段目标检测方法属于端到端检测框架,其基于回归的检测框架策略不需要额外提取候选区域,而是直接从多层特征图中进行目标分类和位置回归,并输出目标检测结果。

Redmon J[53]于2016年提出了目标检测框架YOLO。与将目标检测分为两个阶段的基于区域提取的算法不同,YOLO直接将目标检测视为回归问题。YOLO采用单个卷积神经网络,并使用整个图像作为训练的输入,只需一次操作即可获得边界框和类别概率的预测结果,具体过程如下:首先将输入图像划分为S×S的网格,每个网格仅负责该网格的分类和边界框预测;其次,在特征提取后,每个网格采用softmax分类器和线性回归输出对象检测结果。YOLO并不是候选区域生成网络,因此大大减少了网络的计算量并极大提高了检测速度,从而可以几乎实时地完成目标检测任务。然而,由于粗略的网格划分,小物体和紧密相连物体的检测性能较差。YOLT[54]旨 在从大范围的遥感图像中快速检测感兴趣目标,其借鉴YOLO的思想设计了新的检测建筑模型,检测速度能够达到0.5 km2/s以上,如图6所示。R3Det[55]为了解决基于回归方法提取的特征未对齐问题,设计了一个特征细化模块,通过特征插值实现特征重构和对齐,极大提升了目标检测精度,并应用于遥感图像的飞机检测中。

图6 利用YOLT[54]从大范围遥感图像中快速检测感兴趣目标

为了解决YOLO框架的对象位置预测性能差的问题,Liu W等人[56]于2016年提出了SSD(single shot multibox detector)算法。SSD引入了锚定机制,在特征图上定义了一组具有不同大小和纵横比的默认边界框,然后使用卷积神经网络提取特征并进行分类和回归后,立即采用不同大小的卷积核为特征图上每个默认边界框对应区域中的对象类别生成相应的概率得分,进而不断调整默认边界框位置以实现准确的定位。最后,通过非极大值抑制(nonmaximum suppression,NMS)筛选获得最终的检测结果[56]。为了提高检测精度,SSD还采用多尺度策略在不同尺度的特征图上进行预测,使得能够进行端到端训练,且速度比YOLO更快,同时在检测精度上与Faster R-CNN相当。DRBOX[57]在基于SSD的遥感图像任务上加入了适应旋转特性目标的多角度变化,并通过基于车辆、船舰、飞机的目标检测实验,系统地分析了相比旋转框,水平框在遥感图像目标检测中的不足。

1.3 小结

遥感图像的目标检测前期研究主要通过手工设计模板匹配方法和基于专家知识的方法,由于该类方法在模型的构造与匹配过程中采用规则算法,导致此类算法适用于形状比较规则的刚性物体,鲁棒性差,难以应用于环境多变的场景,因此早期的目标检测运用场景比较局限且简单。传统机器学习方法将统计规则应用于目标检测中,统计方法与像素计算有效地检测线、角点等规则结构,在检测目标形状方面有较好的鲁棒性,但由于其在纹理感知和细节感知方面的缺陷,难以表征复杂的物体。基于深度学习的遥感图像目标检测方法将深度神经网络应用于遥感图像的目标检测,增强了算法图像纹理感知能力和目标变化适应能力,因此在检测性能上有了较大的提升,且可用于检测复杂物体。但该方法仍受限于图像分辨率、天气和计算能力等因素,提高其对外界环境的适应性仍是研究的难点。

2 遥感地物分割

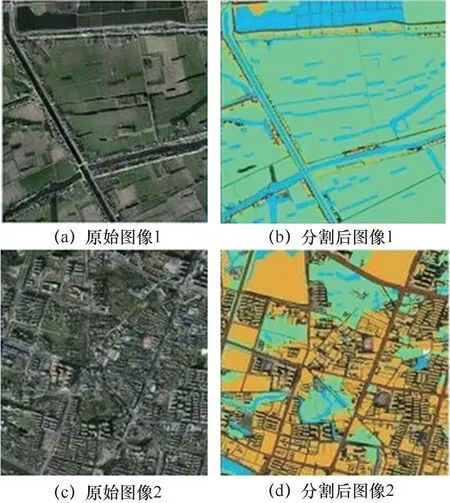

遥感图像分割是基于地理对象进行图像分析的关键和重要步骤,一般定义为将图像划分为同质组的过程,即每个区域都是同质的,但相邻的两个区域的并集都不是同质的。实际上,不同的应用对图像分割有不同的解释,例如,在机器视觉应用中,其被看作低水平和高水平视觉子系统之间的桥梁;在医学成像中,其被作为一种用于描述感兴趣的解剖结构的工具;在遥感图像中,它通常被视为景观变化检测和土地利用/覆被分类的辅助手段,可通过输入卫星遥感影像,自动识别道路、河流、庄稼、建筑物等,并且对图像中的每个像素进行标注。图7展示了遥感图像语义分割结果。

图7 遥感图像语义分割结果示例

遥感图像分割数据集[58-59]中有来自不同地区、国家和城市的像素级的建筑、道路和背景标签,覆盖区域有柏林、芝加哥、巴黎、波茨坦、上海、莫斯科和苏黎世等城市。地物真实图像通常包括一张遥感图像,以及手动生成的具有像素级标签的建筑、道路和背景。上述具有像素级标签的遥感图像在进行智能处理时,将以RGB顺序进行排序的三通道PNG图像作为输入,通常被标记为建筑物、道路和背景等的像素级标签。目前国际上采用的数据集大多为公开的标准航空数据集,这为高光谱遥感图像分割技术的发展提供了极大的帮助。然而,随着地物特征提取技术与分类分割理论的发展,许多遥感数据集因空间分辨率有限、标注标签样本占比少、类别精细度不高等问题,已经难以满足研究人员对于地物的进一步精细分类分割的需求,亟须一套新型的具有更高的空间分辨率、地物精细度和样本占比率的遥感地物分类分割数据集。遥感图像通常具有幅面大、内容复杂、目标朝向任意、尺度范围大、排布密集、对比度低等问题,这些都是在分割任务中会遇到的问题。

图像分割的目标是将图像分割成一组脱节的区域,这些区域因纹理、颜色、形状、大小和灰度等特定属性而不同。从20世纪末开始,大量的遥感图像分割方法涌现出来。首先是基于边缘检测的图像分割算法和基于区域分割的图像分割算法,这两种方法是早期遥感图像分割领域的主流方法,分别从待分割目标的边缘和内部区域着手进行分割。紧接着,有研究人员提出将这两种方法结合以弥补相互之间的缺点,进而出现了混合分割的方法。近几年,随着机器学习尤其是深度学习的迅猛发展,常见的残差网络(residual network,ResN et)和U-Net都是通过卷积神经网络实现分割的先进方法,还有大量基于深度神经网络的分割算法取得了非常好的效果。后文综述了遥感图像的各种图像分割技术,并解释了这些技术的概念细节和相互关系。

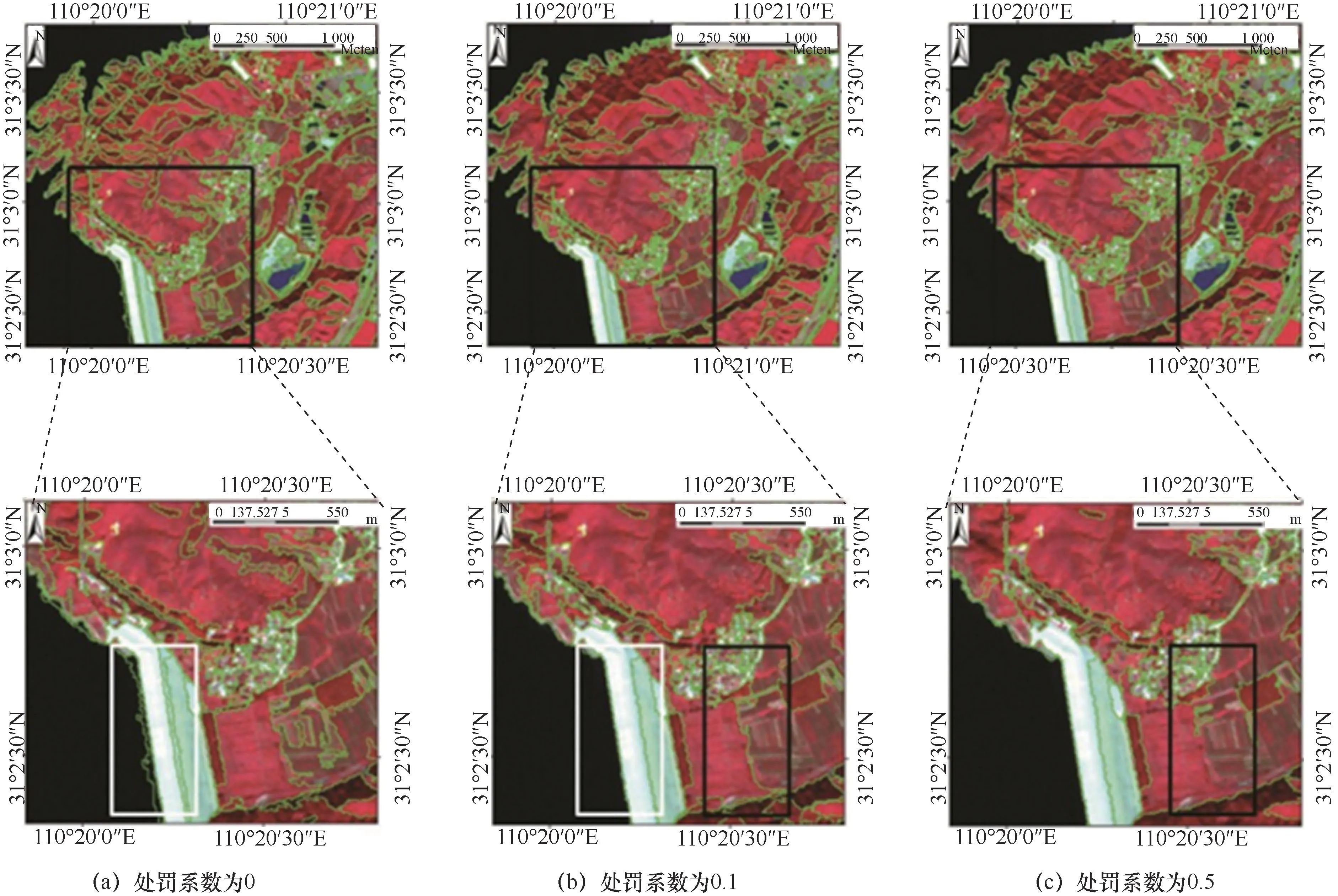

2.1 遥感图像边缘检测分割

遥感图像中目标的边缘是最能代表图像信息的线索,这些边缘标示了图像在灰度、彩色、纹理等方面不连续的位置。遥感图像边缘检测分割技术首先识别边缘,然后使用轮廓算法关闭它们。它假设在边缘之间,像素属性会突然改变。从这个角度来看,边缘被视为物体之间的边界,并位于发生变化的地方。通过边缘检测进行分割是早期的分割方法之一,且至今其仍然是非常重要的方法。目前有很多算法可以用来识别目标的边缘,进而捕捉图像目标的几何和物理特征。然而,边缘分割的最常见问题是在没有边界的地方出现了边缘以及在实际存在边界的地方没有出现边缘,这些由图像噪声或图像中的不良信息造成的干扰会影响分割的精度。图8展示了不同边缘惩罚的分割结果[60],其中下排图像是上排图像目标区域对应放大后的效果。

图8 不同边缘惩罚的分割结果[60]

Jain R C等人[61]将边缘检测分为3个步骤:滤波、增强和检测。不同的滤波方法被用来产生最小的模糊和边缘位移。增强则是指局部强度值有显著变化的像素[62],其中增强数据用于检测真实边缘。然而,所有的边缘检测算子都会产生断边,并错过一些基本的边,研究人员通常会根据伪边缘、缺失边缘、边缘角度、与真边缘的距离和失真度对每个算子的性能进行评估。识别完边缘后,下一步就是将边缘转换为封闭边界。这个步骤通常包括排除由噪声产生的边缘和决定连接哪些边缘部分,组成一个单一的对象,从而实现了分割。研究人员还利用邻域搜索来寻找候选连接的边缘像素。谭玉敏等人[8]提出了基于边界引导的多尺度遥感图像分割算法,他们将该算法用于解决高分辨率遥感图像分割过程中的区域合并复杂性问题。然而,通过识别完美的边缘来创建图像对象仍然是一个挑战。

在边缘检测分割方法中,还有一种常见的分割方法是基于数学形态学的边缘检测算法,即分水岭变换(watershed transform,WT)[63]。数学形态学比传统的边缘检测算法更有效,因此,小波变换成为遥感领域最流行的图像边缘检测分割方法。分水岭变换方法借助地形学概念分割图像,并将图像转换为梯度,识别具有地形表面的对象。小波变换首先识别段边界,然后创建对象,因此可以认为它是一种基于边缘的方法。例如,肖鹏峰等人[64]依据分水岭的思想,提出了基于相位一致的高分辨率遥感图像分割方法,其考虑到领域相位信息对图像具有一定的表征能力,于是通过相位一致来计算图像特征,并运用Log-Gabor小波提取图像的多尺度梯度,该方法的性能很大程度上依赖于计算待分割图像的梯度。在分水岭分割中,由于噪声或纹理模式,典型的梯度算子会产生过分割的结果,其性能仍有待提升。

2.2 遥感图像区域分割

图像中某个物体的区域即物体或物体表面的像元集合通常表现为二维的团块状,这是区域的基本形状特点之一。图像区域分割通过利用图像中同一区域的均匀性来识别不同的区域,从而进行分割,与边缘检测分割方法一样,其同样属于早期的分割方法大类之一。图像区域分割可能产生与图像边缘检测分割截然不同的结果,其假设同一区域内的相邻像素具有相似的值,具体的分割流程为:获得一个初始图像的分割结果,然后合并或分裂相似或不同的区域,最后通过重复前面的步骤直到没有区域应该合并或分裂。该类方法计算简单,适用于小目标结构,但其对噪声敏感,经常导致抽取的区域有空洞,并且不同的合并顺序也会出现不同的合并结果。图9展示了居住和森林混合试验区的尺度参数最低的分割结果[65]。

图9 居住和森林混合试验区的尺度参数最低的分割结果[65]

利用图像中同一区域的均匀性来识别不同的区域是区域分割方法的核心。陈忠等人[66]提出了一种基于区域生长结合多种特征的多尺度分割算法,首先利用图像梯度信息选取合适的种子点,再把高分辨率遥感图像地物的局部光谱信息和全局形状信息结合起来,把其作为区域生长的准则进行区域生长,最终实现分割。Drǎguţ L等人[65]提出了一种基于Definiens Developer的遥感图像分割尺度参数估计方法。该方法提出对图像内部的异质性程度进行度量,通过一种被称为尺度参数的主观度量进行控制。Wang Z W等人[67]提出了一种基于k-means聚类的区域自动图像分割算法(region-based image segmentation algorithm,RISA)。该算法包括k-means聚类、段初始化、种子生成、区域生长和区域合并5个步骤。RISA的评估使用了一个案例研究,重点是两个地点的土地覆盖分类:南非共和国的一个农业区和加利福尼亚州弗雷斯诺的一个居民区。Neubert M等人[68]分析了图像中目标的差异,即线段与参照对象之间的拓扑和几何关系,并利用参考对象周围的缓冲区,通过特定缓冲区内的比例来评估轮廓的一致性,得出关于分割轮廓几何正确性的结论。Michel J等人[69]定义了一个新的性质,称之为分割算法的稳定性,并证明了一个稳定的分割算法的块或块计算可以在处理整个图像的同时获得相同的结果。Zanotta D C等人[70]介绍了一种基于截取分割阶段的同步方法。通过迭代更新先前生成区域的标签来优化分类过程,只有在新分类中获胜类别的后验概率估计增加时进行迭代更新,才能实现更高的分割精度。

2.3 遥感图像混合分割

边缘检测分割的方法在检测边缘方面是精确的,但是在生成封闭的段时面临严重的问题。如果关于边界的信息很少,则分割方法必须考虑更多的局部图像信息,并将其与应用领域的一般性特殊知识结合起来。相比之下,区域分割的方法会产生封闭区域,但如果区域分裂合并不准确,就不能用于评价分割结果的信度,因此就没有反馈矫正分割结果的基础。为了使多区域分割后的图像边缘更加清晰,将边缘检测与区域分裂合并相结合的多区域图像分割方法成为主流方法之一。其基本思想是用边缘检测算子与分裂合并法分别对同一幅图像进行分割,然后应用信息融合技术将经过上述处理后的两幅图像融合,得到新的图像。许多研究综合了这两种方法,以克服基于边缘和基于区域的方法的局限性。图10展示了不同尺度下的分割结果[71]。

图10 不同尺度下的分割结果[71]

混合分割方法首先使用边缘检测的方法勾画出初始段,然后使用基于区域的方法进行合并。这种方法既利用了边界像素勾勒出初始段,也利用了内部像素合并相似的段。Mueller M等人[72]结合基于边缘和基于区域的方法来提取大型人造物体(如农田)。在第一阶段,他们提取形状信息,边缘地图为决策提供了额外的标准。在第二阶段,他们利用这些信息来控制区域增长算法。Weidner U[73]基于面向对象或基于分段的分类方法,提出了一种有效的混合分割方式。Johnson B等人[74]没有使用全局阈值,而是使用局部措施识别在选定的最优尺度参数下未被分割的片段,并通过适当的分割和合并进一步细化它们。这种局部细化策略在提高分割质量方面是有效的,这是因为它解决了分割不足和过分割的问题。此外,这些方法将相邻段之间的异质性作为合并的标准。段内的均质性和段间的非均质性都应同等考虑,Wang Y J等人[75]因此提出了一种考虑合并过程中异质性和相对同质性目标的混合分割方法。

2.4 神经网络遥感图 像分割

近年来,机器学习在遥感领域中取得了重大的突破。机器学习算法专门研究计算机如何模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。其中深度学习是代表性方法,其在近几年取得了重大的突破。随着深层网络的构建,全卷积网络(fully convolution network,FCN)、ResNet等网络架构成为分割任务的通用框架。

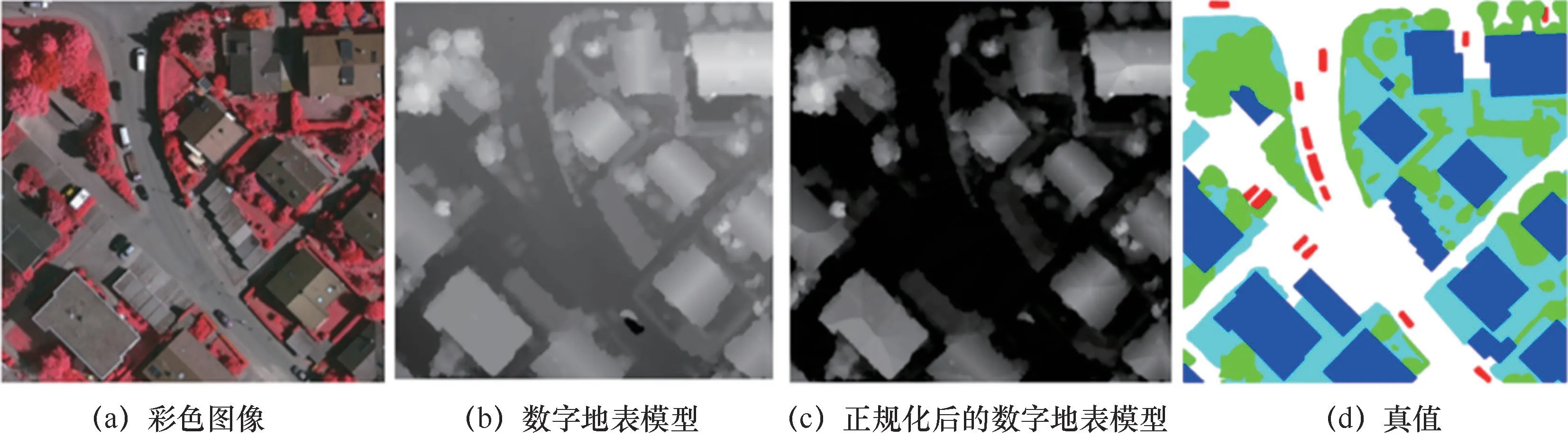

在图像分割任务中,每个像素都被分配一个包含对象的类标签。Mitra P等人[76]研究了在有监督的像素分类框架下遥感卫星图像分割面临的像素缺乏问题。其采用支持向量机将像素分类为不同的地表覆盖类型。它最初设计时使用一组小的标记点,随后通过从一个未标记的数据池中主动查询像素的标记来改进,在每一步中查询最有趣或不明确的无标记点标签。Kampffmeyer M等人[77]提出了一种用于遥感图像土地覆盖制图的深度卷积神经网络,并将研究重点放在城市地区。其提出了一种新颖的方法来实现较高的整体精度,同时仍然可以实现小目标的良好分割精度。图11展示了基于神经网络的遥感图像分割结果[77]。Nogueira K等人[78]提出了一种新的技术来实现遥感图像的语义分割。该技术利用多上下文范式,不增加参数的数量,同时在训练时间内定义最佳的图像块大小。其主要思想是用不同的图像块大小训练一个扩展的网络,允许它从异构的上下文中捕获上下文特征。在处理这些不同的图像块时,网络为每个图像块提供一个分数,帮助定义当前场景的最佳图像块大小。耿艳磊等人[79]提出了一种基于半监督全卷积网络的高分辨率遥感影像语义分割方法,其将有标签样本上的监督分类损失和无标签样本上的无监督一致性损失结合,以完成端到端的语义分割网络训练。苏健民等人[80]提出基于U-Net改进的深度卷积神经网络方法,该方法旨在提高高分辨率图像的分割效果,其采用了集成学习的策略,实现了端到端的像素级语义分割,并取得了不错的分割效果。该方法在“CCF卫星影像的AI分类与识别竞赛”数据集上取得了94%的训练准确率和90%的测试准确率。

图11 基于神经网络的遥感图像分割结果[77]

2.5 小结

随着遥感技术的发展,高空间分辨率遥感图像以其丰富的光谱和纹理信息在各个领域得到了广泛的应用。作为遥感的关键组成部分,图像分割算法近年来一直是研究热点。虽然该方向已经提出了很多算法,但是所有算法都有优缺点。例如,边缘检测分割的算法容易实现,但是缺少上下文信息。与基于边缘的方法相比,区域分割的方法产生了更好的结果,然而,在这种情况下,找到合适的种子和其他参数是真正的挑战。为了解决种子点选择问题,可以将超像素算法引入遥感图像分割中。未来可以通过混合分割方法来解决不同方法的弊端。

近几年基于深度学习的方法逐渐成为主流方法之一。目前基于有监督的深度学习的遥感影像语义分割方法中,基于滑动窗口的方法由于采用的窗口大小是固定的,会存在感受域大小不确定的问题,进而导致结果不准确;基于对象分割思想的方法会因为边界框(bounding box)里面拥有的领域信息较少而导致精度下降。基于全卷积网络的方法目前比较流行,精度也是最高的,但遥感图像标签不足或者部分标签不准确导致这类全监督的方法在很多场景难以得到实际应用。而在基于非监督的方法中,基于像素比较的方法依赖于特征聚类的结果,而特征相似度的学习通常依赖于有效的标注。基于对象比较的方法在融合不同时相的图像时,属于不同时相的特征可能会相互影响,导致原始影像的高维特征难以保持。目前,更深入的遥感分割技术还有待研究,许多研究人员仍在试图找出能够准确识别图像个体目标的分割算法。

3 遥感变化检测

变化检测是对地物或现象进行多次观测从而识别其状态变化的过程[81]。人与自然相互依存,实时检测地表变化信息有利于人类管理自然资源,保护生态环境,对理解人与自然之间的交互作用有重要意义。目前,遥感变化检测技术已成功应用于环境保护、城市规划、军事侦察等领域,其具体应用见表1。

表1 遥感变化检测技术应用领域

遥感影像变化检测数据集[95]主要用于进行场景变化检测的方法理论研究与验证。场景变化检测就是在场景语义的层次上,对一定范围区域的土地利用属性变化情况进行检测和分析。OSCD(onera satellite change detection)数据集[96]包含2015年至2018年之间Sentinel-2卫星拍摄的24对多光谱图像,图像拍摄位置包含世界各地。对于每个城市中的位置,均提供了Sentinel-2卫星获得的13个波段的多光谱卫星图像的配准对。其中,遥感图像的空间分辨率在10 m、20 m和60 m之间变化。其中,14对图像提供了像素级变化的标签真值。带注释的更改集中于城市变化,例如新的建筑物或新的道路等。此外,还有美国地质调查局、武汉大学智能感知与机器学习组等许多机构开源了遥感变化检测的数据。这类数据通常包含语义信息层面上的变化,很难进行传统意义上的检测。

遥感影像变化检测技术是遥感应用与新技术结合的产物。20世纪70年代,数字遥感的出现推动了遥感影像数字处理的发展;90年代早期,地理信息系统(geographic information system,GIS)技术与数字图像处理技术的一体化,使遥感数据与其他辅助数据相融合,形成了更强大的数据集;90年代中期开始,各大研究机构对遥感影像变化技术展开了研究[97]。由于当时技术有限,各国获取的遥感影像空间分辨率较低,像素比较模糊。随着近年来遥感技术迅速发展,遥感影像也由中低空间分辨率转向了高空间分辨率、高光谱分辨率。图12展示了3种不同分辨率的遥感图像,其中图12(a)是广东省深圳市南部地区的中低空间分辨率遥感影像,图12(b)是无人机高光谱分辨率遥感影像下的作物长势分布图,图12(c)是上海陆家嘴地区高空间分辨率遥感图像。由图12可知,与低空间分辨率的遥感影像相比,高空间分辨率的遥感影像能展示更丰富的地表信息和地物纹理特征。

关于《文心雕龙》思想倾向的研究主要是从建国后开始兴起的,《文》一书与道家关系的探讨更是日渐深入,论文文献较多。如张启成的《〈文心雕龙〉中的道家思想》[1]、王运熙《文心雕龙原道和玄学思想的关系》[2]、皮朝纲《〈文心雕龙〉与老庄思想》[3]、严寿澂《道家玄学与文心雕龙》[4]和蔡钟翔的《论刘勰的“自然之道”》[5]等都是早期的论文,这些论文中均提到道家“自然之道”的思想是贯穿《文》一书始末的重要指导思想,《文》一书的文学观和创作思想都源于道家(或玄学思想)。

图12 遥感影像

当前存在的一些变化检测工作是针对特定类型的数据进行的。吴柯等人[98]使用2000年9月5日和2002年11月12日两个时期在广东省深圳市南部地区拍摄的图像进行变化检测。该图像是400×400像素的中低空间分辨率的遥感图像。针对中低空间分辨率的遥感影像中广泛存在混合像元的情况,吴柯等人提出了混合像元分解技术,深入像元内部检测变化,从而获取亚像元级的变化信息。Usman M等人[99]考虑到中低空间分辨率图像的数据结构比较简单,适合大面积的变化检测任务,便使用MODIS 250 m×250 m空间分辨率数据分析2005年至2012年巴基斯坦Chenab河灌溉区的土地利用变化。Wen D W等人[100]针对高空间分辨率图像数据维度高的问题,利用WorldView-2卫星获取的深圳市2010年和2012年空间分辨率为2 m的城市变化图像进行实验,提出了高分辨率图像适用的多指标自动变化检测方法。Zhou Z J等人[101]考虑到高空间分辨率图像中丰富的信息,使用由WorldView-2卫星获得的高分辨率图像,提出了一种适用于珊瑚礁环境的高精度变化检测方法。Wang Q等人[102]提出了一个新的高光谱分辨率数据集HIS。HIS中的图像选自Earth Observing-1(EO-1)Hyperion采集的图像。EO-1 Hyperion覆盖了0.4~2.5 μm的光谱范围,具有242个光谱带。Wang Q等人针对以往子像素级别的信息通常没有得到充分利用的问题,提出了一种高光谱图像通用的端到端二维卷积神经网络框架。López-fandiño J等人[103]在由Hyperion传感器于2004年和2007年在Hermiston获取的高光谱图像集上进行实验,提出了一种通过堆叠自动编码器为高光谱数据集提取特征,从而检测变化信息的方案。

遥感技术能提供多种类型的影像数据,不同类型的遥感数据各有特点,下面将针对不同类型的数据,总结遥感变化检测技术的最新发展。

3.1 中低空间分辨率遥感影像变化检测

现代遥感技术起源于20世纪60年代,在1986年法国发射SPOT-1卫星之前,各国获取的遥感影像都是中低空间分辨率图像。中低空间分辨率的遥感影像像素模糊,单个像元内可能包含多种地物,对局部区域的变化进行检测是一项富有挑战性的任务。但是中低空间分辨率图像数据结构比较简单,适用于对大面积地物进行变化检测,如土地利用检测、土地覆盖检测、植被检测、森林火灾监测等。

Abd El-Kawy O R等人[104]对一段时间内收集的4幅Landsat图像(1984年、1999年、2005年和2009年)进行监督分类,分类后的结果表明,1984—1999年、1999—2005年、2005—2009年分别有28%、14%、9%的贫瘠土地被改为农业用地。Abd El-Kawy O R等人还观察到土地退化主要是由人类活动造成的,比如建立采石场。Gandhi G M等人[85]把遥感技术和GIS结合,对印度Vellore地区的植被进行变化检测。Gandhi G M等人提出的方法是基于归一化植被指数(normalized difference vegetation index,NDVI)的增强型变化检测方法,使用多光谱遥感数据技术来查找植被指数,通过计算土地覆盖分类的归一化植被指数,可以轻松解译影像[85]。Yuan F等人[105]采用先分类再分析变化情况的方法检测城市土地覆盖变化,图13展示了某地区在1986—2002年间的城市数量增长情况,该方法量化了大都市圈的土地覆盖模式。

图13 1986—2002年城市数量变化[105]

3.2 高空间分辨率遥感影像变化检测

高空间分辨率遥感影像包含丰富的空间信息、纹理信息,所能识别的目标也更小。与低分辨率遥感影像相比,其数据量更大,处理速度更慢。自法国1986年发射SPOT-1卫星后,高空间分辨率卫星遥感图像的应用就引起了世界各国的普遍关注。

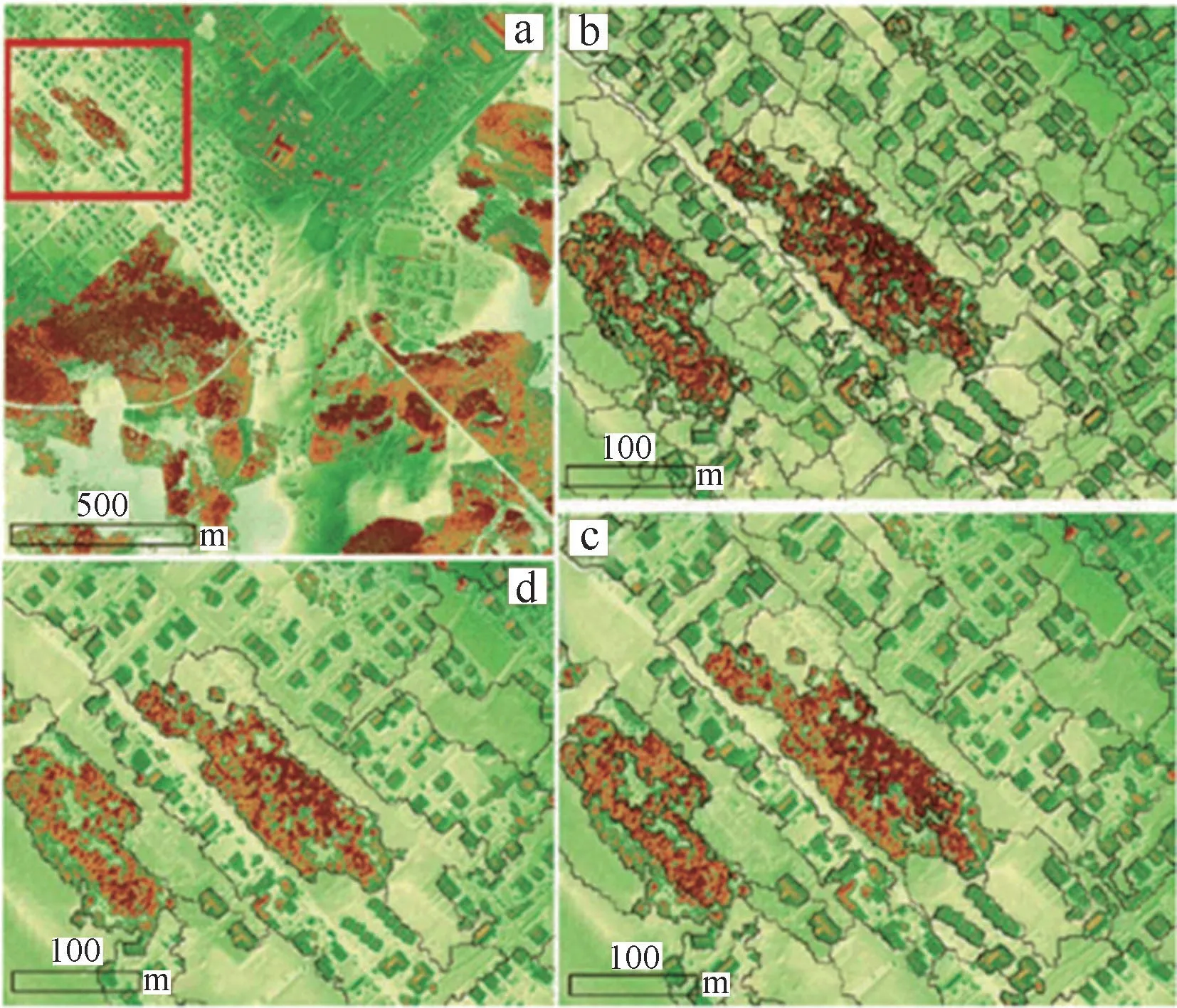

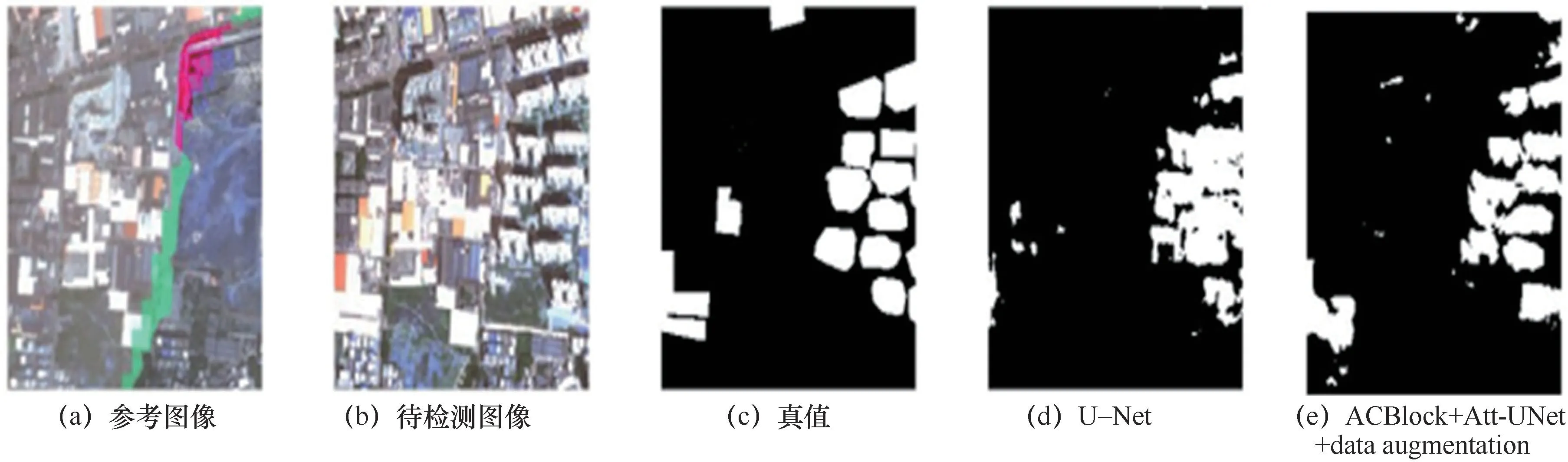

随着遥感影像的分辨率越来越高,变化检测不仅要能够检测出大目标的变化,还要检测出小目标变化。胡蕾等人[106]提出了一种多尺度稀疏卷积模型,把不同通道中相关性高、同一空间位置的特征聚合在一起,有效减少了参数的相互依存关系,一定程度上缓解了过拟合情况,并在孪生网络和多通道网络下对该模型进行了实验分析。实验结果如图14所示,图14(c)表示孪生网络下多尺度稀疏卷积模型的实验结果,图14(d)表示的是多通道网络下多尺度稀疏卷积模型实验结果。实验结果表明该方法能够检测出小目标的变化情况。Hao M等人[107]提出了模糊C均值和马尔可夫随机场相结合的方法FCMMRF,其检测结果如图15所示。该方法顾及领域空间像素信息,很好地保留了变化细节。张翠军等人[108]提出了一种改进U-Net的遥感图像建筑物变化检测方法ACBlock+Att-UNet+data augmentation。他们利用U-Net模型把图中的每个像素划分为变化类或非变化类,分类完成后再依据变化类的像素检测建筑物的变化情况,检测结果如图16所示。如此,变化检测问题就成为二分类问题。该方法把注意力模型引入U-Net中,加强变化类像素特征学习,使得模型对建筑物变化更敏感,其检测效果也更好。

图14 变化检测结果

图15 FCMMRF检测结果

图16 建筑物变化检测

3.3 高光谱分辨率遥感影像变化检测

高光谱分辨率遥感起源于20世纪80年代,但正式进入航天高光谱遥感时代的时间是1999年年底,美国新千年计划EO-1卫星搭载了具有200多个波段的Hyperion航天成像光谱仪[109],这使得高光谱分辨率遥感影像的获取难度大大降低。在对地观测中,高光谱遥感的成像通道增加,使得在分析遥感影像时能分析更多的目标物体,如识别不同的矿物、不同的树种。

图17 CSNLRT检测结果

近年来,深度学习由于其出色的表征能力,逐渐被应用于高光谱图像变化检测中。深度学习是能处理高维数据和非线性建模的有效工具,能有效地处理高光谱数据。但是深度学习方法往往需要大量的训练样本,而这些用于变化检测的训练数据缺少标签,人工标记又极其耗时。为此,Yuan Z H等人[112]提出了一种应用于高光谱图像变化检测的无监督的卷积神经网络RPCANet。他们将RPCANet与变化向量分析结合起来,提取到更有效的特征,从而取得了不错的实验结果。Li X L等人[113]提出利用现有的无监督变化检测方法的变化检测图来训练深度卷积神经网络,然后在端到端的训练过程中去噪,从而提升网络的鲁棒性。Wang Q等人[102]引入了集成亚像素表征的混合亲和矩阵,以便挖掘更多的跨通道特征,并融合多源信息从而提升算法的泛化能力。

赵春晖等人[114]提出一种基于多路径卷积网络的高光谱变化检测方法,该方法通过训练堆叠降噪自动编码器对高光谱数据进行降维,缓解了高光谱信息冗余的情况,并通过多路径卷积网络提取空间信息。实验表明,赵春晖等人[114]提出的方法总体误差低,准确率高,图18展示了该方法在Bay Area数据集上的检测结果。

图18 Bay Area数据集检测结果

3.4 小结

以往获得的遥感影像都是中低空间分辨率的影像,大多数变化检测研究也以中低空间分辨率的遥感影像为主。然而,遥感技术的迅速发展使得遥感图像的分辨率越来越高。高空间分辨率、高光谱分辨率的遥感影像已经引起了大量研究人员的注意。当前,深度学习方法已经被广泛应用于变化检测任务中。由于各种分辨率的遥感影像的自身特点,各种变化检测方法都存在优缺点。

有监督的深度学习方法需要大量有标签的训练数据,而获取大量有标签的遥感数据是非常困难的。无监督的深度学习方法不需要有标签的数据,具有良好的抗噪性,因而成为变化检测的一个研究趋势。在中低分辨率的遥感图像中,普遍存在“同物异谱,同谱异物”的现象,这使得地表的真实变化难以检测。同时,中低分辨率图像中的混合像元较多,提高了变化检测任务的难度。虽然基于深度学习的方法能够自动地、多尺度地提取图像特征,大幅提高变化检测任务的精度,但是往往存在部分类别间边界不明显的情况。

高分辨率图像能更精细地反映像元的内部信息,提供更丰富的细节信息,从而实现深入像元内部的检测,但是基于高分辨率的深度学习方法运行时间成本高,因而如何降低时间成本也是一个应考虑的问题。

高光谱图像能够精细地刻画地物的反射光谱,从而提升识别地物的能力,但深度学习方法在高光谱图像中的应用仍有不足。一方面,高光谱数据的高维度使得特征提取困难,即使是在高级语义特征学习方面具有优势的卷积神经网络也未必能提取出让人满意的特征;另一方面,高光谱数据的亚像素中的丰富信息并没有得到充分的利用。

遥感技术能提供多种类型的数据,除了中低空间分辨率图像、高空间分辨率图像、高光谱分辨率图像之外,还有高时间分辨率的图像。从数据源的角度来看,融合各类数据的信息进行集成检测能弥补各类数据的不足,从而提升检测的精度。因此,基于融合影像的变化检测方法会是未来的一大趋势。

4 结束语

遥感信息提取技术在自然资源管理、国防安全、生态保护等方面有重要意义。本文总结了遥感目标检测、遥感地物分割、遥感变化检测这三大研究热点的发展情况。尽管当前基于遥感大数据的遥感信息提取技术已经取得了比较丰硕的成果,然而面对人们日益增长的应用需求,依旧存在诸多挑战,具体如下。

一是在目前的遥感图像分割过程中,用得较多的是传统的模式识别方法,其结果由于遥感图像本身的分辨率限制以及同物异谱、异物同谱现象的存在,往往出现较多的错误和遗漏现象。由于遥感图像数据的复杂性,更深入的遥感分割算法还有待研究。

二是针对不同类型的遥感数据,需要有效结合其特点加以利用,探索适合各种数据类型的遥感图像分割算法,以达到更高的精度。

三是当前基于高光谱分辨率的影像变化检测方法还未建立起多时相影像中端元的光谱相关性,也没有出现多时相光谱混合模型[115]。