基于R-CNN的学生课堂管理系统

田刚

(中共陕西省委党校(陕西行政学院),陕西,西安 710061)

0 引言

学生课堂行为分析不仅是评价教学质量的重要环节,而且有助于预测学生的长远发展[1-2]。然而,以往的学生行为分析很大程度上依赖于教师的观察,费时费力,不能满足大规模的实际需求。因此,需要一个自动的学生行为检测系统来进行全面深入的分析。本文设计了一个学生课堂行为管理系统。该系统是基于一种改进的Fast R-CNN算法。主要的改进有两点:首先针对不同尺寸的感兴趣区域(ROI),提出了一种不同膨胀率的尺度感知检测头,解决了尺度变化的难题;其次,提出了一种简单而有效的特征融合策略,融合不同层次的特征,实现低层次的高分辨率细节和高层次的语义信息,并检测出较小的目标。最后,联机挖掘难样例(OHEM)用于集中处理更难的示例。通过这个系统,可以有效地观测学生在课堂上的表现,并对学生的课堂表现进行统计,在一定程度上能够预测学生相关课程的成绩,以及评估授课老师的课程欢迎度。

1 Fast R-CNN原理介绍

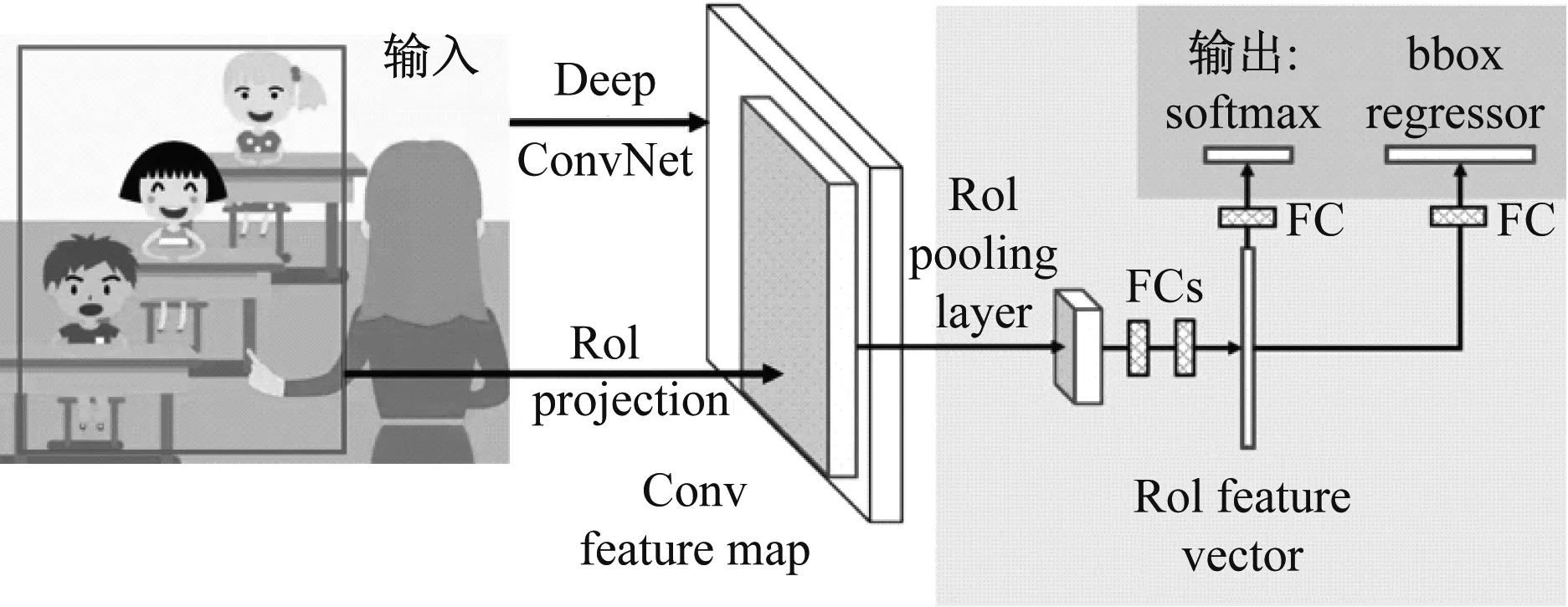

Fast R-CNN网络将整个图像和一组对象建议作为输入[3-5]。通过使用几个卷积层和最大池化层处理整个图像来生成卷积图。然后,对于每个对象建议一个RoI,从特征图中提取固定长度的特征向量。每个特征向量都作为输入提供给一系列完全连接的(fc)层。最后一个完全连接的层分为2个同级输出层,一层在K个对象类加上一个笼统的“背景”类上生成softmax概率估计,另一层为K个对象类中的每一个给出4个实数值输出。每组4个值是K个类别之一的边界框位置,如图1所示。

图1 Fast R-CNN的网络结构

1.1 候选区域

有多种方法可用于生成类别独立的区域建议[6]。Fast R-CNN使用选择性搜索“边缘框”定位对象建议方法从图像中的边缘生成ROI。

并集上的交集(IoU),用于测量边界框的度量。IoU计算对象建议框(由RPN生成)和地面真值框的交集,除以它们的并集面积。一般要求IoU分数大于0.5。IoU为0.7提供了非常宽松(IoU为0.5)和非常严格(IoU为0.9)重叠值之间的合理折衷。图2给出一个示例。

图2 IoU为0.5、0.7和0.9的示例

1.2 ROI池化

ROI池化层使用最大池化将感兴趣的有效区域内的特征转换为固定空间范围为H×W的小特征映射,其中H和W是独立于任何特定ROI的层超参数。ROI是通过ROI投影进入conv特征图的矩形窗口,如图1所示。每个ROI由4个值(r,c,h,w)定义,这些值指定了ROI的左上角(r,c),高度宽度(h,w)。

1.3 训练

Fast R-CNN使用了一个简化的训练过程,其中有一个微调阶段可以联合优化softmax分类器和边框回归器,并在3个单独的阶段进行回归。这个过程的组成部分是丢失、小批量采样策略、通过ROI池化层的反向传播和SGD超参数。

1.4 SGD超参数

初始化用于softmax分类和边界框回归的完全连接层。偏差初始化为0。所有层使用的每层学习率为1表示权重,2表示偏差,全局学习率为0.001。

1.5 尺度不变性

为了实现尺度不变的目标检测,图像金字塔通过图像金字塔向网络提供近似的尺度不变性。在测试时,图像金字塔被用来缩放标准化每个对象的建议。

1.6 检测

一旦对Fast R-CNN网络进行微调,该网络将以图像和R对象建议列表(约2 000)作为输入。使用图像棱锥体时,每个ROI都被分配给比例,这样缩放后的ROI最接近45×30像素的区域。对于每个测试ROI,前向通过输出一个类的后验概率分布p和一组相对于r的预测包围盒偏移量(K个类中的每一个都得到自己的精确包围盒预测)。使用估计概率pk,为每个对象类别k的r分配检测置信度pr。

2 系统原理

在这一部分中,首先详细介绍了学生课堂行为分析系统,包括举手、站立和睡觉。然后详细阐述了为减轻真实数据集中的挑战而设计的策略。

2.1 系统概述

整个系统采用教室录制的视频流作为模型输入。然后,提出的算法将输出检测结果以供进一步分析和可视化,如图3所示。通过设在教室中的监控,获取教室的课堂视频流,然后对视频流进行分析,通过对视频流中的图像进行处理后用提出的Fast R-CNN算法对图像进行检测,获取检测结果,最终将结果传送到终端,进行可视化和分析。

图3 学生课堂活动管理系统的总体架构

具体来说,提出的行为检测算法基于更快的R-CNN。在此采用包含5个块的ResNet-101[7]作为特征提取网络,这些剩余块分别表示为{conv1、conv2、conv3、conv4、conv5}。与原来的Fast R-CNN不同,首先对不同大小的ROI分别使用扩张率为1、2、4的conv5的3个分支。然后,将conv3和conv4的输出特征进行融合,得到低层次的高分辨率特征映射和高层次的语义信息。最后,在训练中应用OHEM,重点是这些检测困难的例子,以解决班级不平衡的问题。

2.2 尺度感知的检测头

在基于ResNet-101的Fast R-CNN中,conv5层作为子网(检测头)进行分类和回归。然而,更快的R-CNN将不同大小的ROI连接到同一个检测头上,并且在大尺度方差方面表现不佳。在中国,班级规模不仅因班级的不同而有很大的差异,比如站姿行为的差异,而且由于班级内部的原因,导致了教室的拥挤。受SNIP[8]启发,在此提出了一种基于尺度感知的检测头,该检测头使用不同的膨胀率来检测不同大小的物体。

具体地说,使用conv5块的3个分支,分别基于主干的特征映射,使用1、2、4的膨胀率。理由是需要不同的接收场来探测不同大小的物体。利用尺度感知策略,为每个分支分配一个特定的尺度范围,以匹配每个感受野。对于大小范围为(0,80)、(40,160)和(120,∞)的ROI,分别形成相应的扩张率为1、2、4的检测头来捕获不同尺度的特征。在训练和推断过程中,根据大小范围对ROIs应用不同的检测头,如图4所示。

(a)Fast R-CNN中的原始探测头

通过使用扩张卷积,这3个分支可以共享相同的网络结构和参数,但具有不同的感受野。通过这种设计,提出的模型可以在不增加模型大小的情况下,在不同的感受野上检测不同尺度的物体。消融实验证明了这种多扩张支设计的有效性。

2.3 特征融合策略

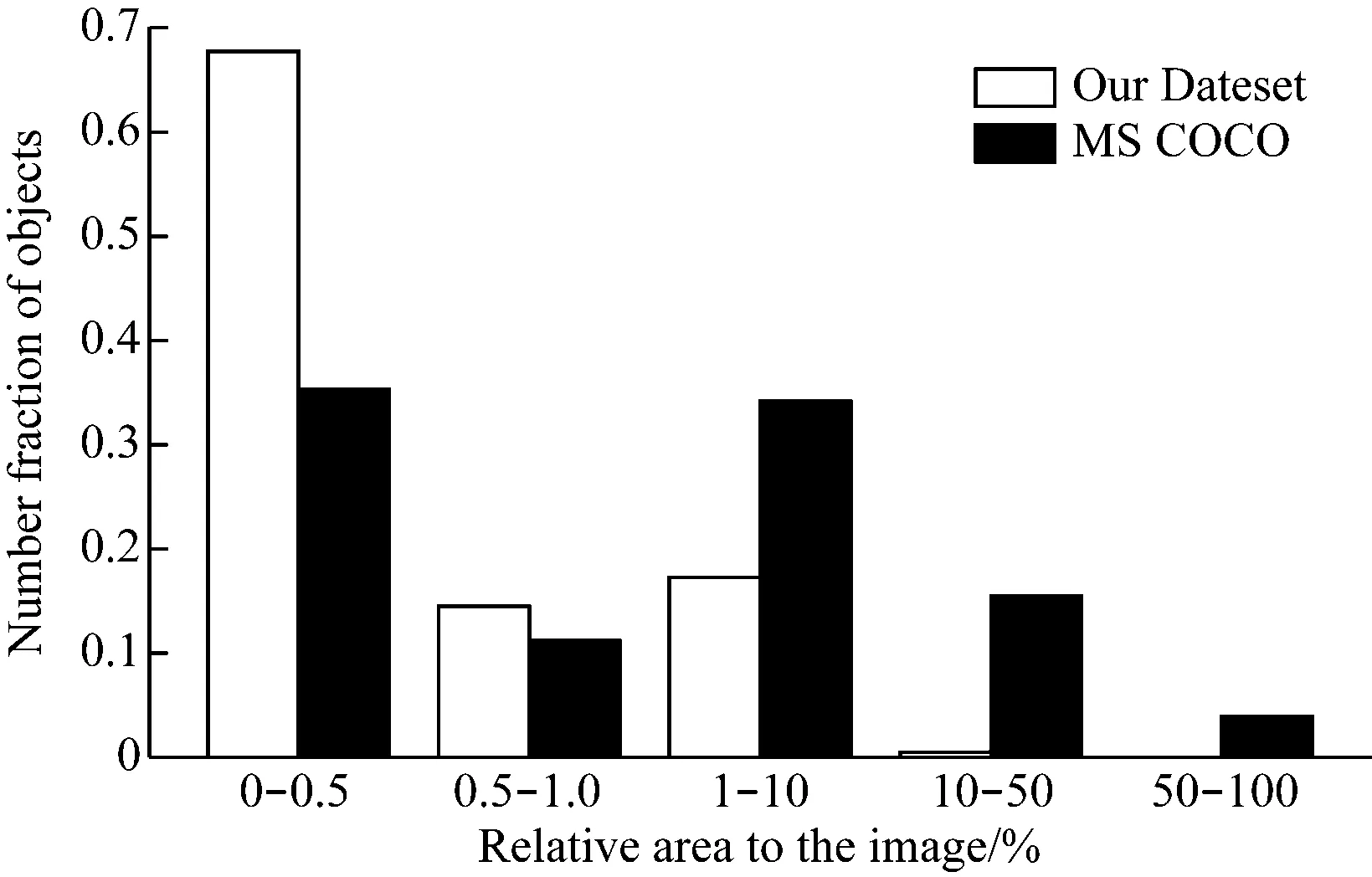

具有ResNet骨干网的Fast R-CNN采用conv4输出特征图作为最终检测特征。但是,这种低分辨率的特征地图不足以检测小于其步幅的物体。在真实的课堂中,大多数行为相对于原始图像的大小来说是相当小的。如图5所示,采用的数据集中近70%的对象只占整个图像不到0.5%。探测如此微小的物体是很有挑战性的,特别是对于低分辨率和各种手势的举手。

图5 使用的数据集对比

在这里,不使用像FPN这样昂贵的金字塔,而是提出用一种简单而有效的方式来融合特征。具体来说,结合conv3层和conv4层的输出,构建既具有高分辨率特征又具有高层次语义信息的检测特征图。首先使用1x1卷积滤波器对conv3的输出进行降维,然后将相邻的特征叠加到不同的通道中,生成一个类似于YOLOv2[9]的更小的特征映射。该降采样特征映射与conv4层的输出相连接,然后是1×1卷积滤波器,以将输入通道与conv5层匹配。提出的特征融合策略引入了很少的开销,实验表明,它大大提高了小物体(睡觉和举手)的准确性。

2.4 在线难样例挖掘

但使用的数据集面临很大的类别不平衡。首先,睡眠样本比其他类别的样本少了近5-24倍,这导致了原始的Fast R-CNN睡眠检测性能较差。其次,举手样本的分辨率较低,手势多样,遮挡严重,与较大的站立行为相比更难学习,这导致了难易例子之间的类不平衡。

为了解决上述类不平衡问题,在训练期间使用了OHEM(在线难样例挖掘)[10]。在前向通道中,评估所有提议的损失,然后按损失对所有ROI进行排序。选择损耗最大的top-K ROI,并根据所选的例子进行反向传播。这个模型被学习去关注这些困难的例子,比如不常见的睡眠例子和各种各样的举手例子。实验表明,使用OHEM可以大大提高模型处理复杂场景的能力。

3 实验

为了证明提出算法的有效性,对学生行为数据集和从数据集中选择的难集进行了广泛的实验。对于这2个数据集,在此用COCO-style:平均精度(mAP)、APs、APm和APl的度量来显示结果。符号APs、APm和APl分别表示小、中、大对象的地图百分比。

3.1 实验数据集

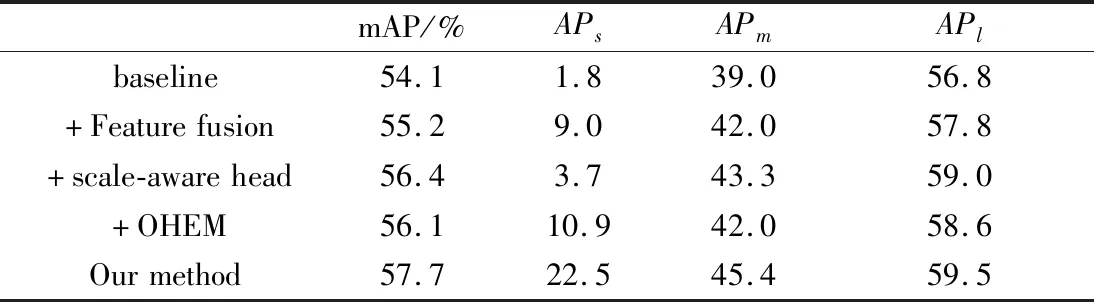

在学生行为数据集上执行改进的Fast R-CNN网络,包括70 k手举样本、20 k站立样本和3 k睡眠样本。使用的数据来自中国某市30多所不同的中小学。由于复杂的场景和各种各样的手势,在数据集中捕获的行为样本对于检测来说非常具有挑战性。使用29 k个图像(总共40 k个图像)样本进行训练,然后在11 k个子集上验证性能。以原始更快的R-CNN为Baseline进行比较,证明了本文方法的有效性。测试结果如表1所示。

表1 基于学生行为数据集的不同测试方法结果

如表1所示,提出的模型比原来更快的R-CNN取得了更好的性能。这些结果表明提出的方法不断改进。这3种方法结合后的最终mAP比Baseline提高了3.4%。另外,APs的增加了20.6%,这反映了提出的方法是有效的。

Baseline和提出方法的检测结果如图6所示。与Baseline检测结果相比,该方法能够检测出更多低分辨率、严重遮挡的行为。

(a)Baseline方法检测结果

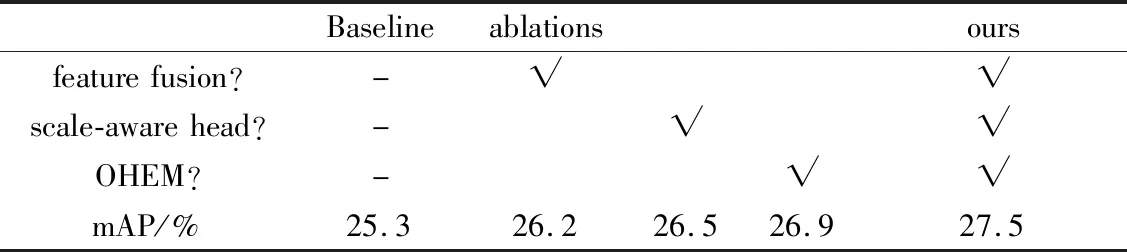

3.2 选定难集的实验

从学生行为数据集中构造一个选定的难集,以证明提出的方法对于难场景的有用性。具体来说,从11 k测试集中根据相对对象大小(仅占整个图像部分以下0.1%)选择4.7 k个样本,主要包括睡眠样本和低分辨率的手举样本。如表2所示,提出的方法将mAP的结果提高了2.2%,在解决这一极其困难的场景时尤其有效。

表2 基于难集的实验结果对比

4 总结

为了提高教学质量,提出了一种改进的Fast R-CNN网络,用于真实课堂场景中的学生行为检测。提出了一种基于不同膨胀率的尺度感知检测头,用于检测不同尺寸的目标。提出了一种新的特征融合策略,用于检测较低分辨率的目标。在训练过程中使用OHEM来缓解使用的数据集中的班级不平衡。这些改进的整合在真实的课堂上取得了令人印象深刻的效果。