基于维和训练的控制系统仿真技术研究

田聚波,赵建,李宝莲,岳云鹤,刘晶

摘要:为了解决联合国维和行动长期存在的国内训练基础环境难逼真、执行任务标准运用不熟练、突发情况应急处置不到位的问题,开展了基于维和训练的控制系统仿真技术研究。运用虚拟现实、建模仿真、沉浸体验、人工智能等先进技术,提出一种大空间定位和姿态捕获方法,研发空间位置与动作姿态数据融合算法,灵活支撑对抗仿真;提出一种三维影像构建方法,建立人员、装备、设施、建筑、道路等三维模型,构建国外任务区虚拟战场环境,支持开展沉浸式模拟演练。研究结果表明,新方法能帮助维和官兵提前逼真体验,规范执行标准,模拟红蓝对抗,尤其是大空间定位技术的研究可有效延伸虚拟战场环境,显著提高联合训练效果,并可节省训练经费,避免训练事故,提高训练的针对性。虚拟仿真训练技术研究能够有效支撑多分队协同处置训练,甚至多兵种联合训练,在军事训练领域有较大的推广价值。

关键词:控制系统仿真技术;虚拟现实;建模仿真;沉浸体验;人工智能;大空间定位技术

中图分类号:TP183文献标识码:ADOI: 10.7535/hbgykj.2021yx06004

Research on simulation technology of control system based on

peacekeeping training

TIAN Jubo,ZHAO Jian,LI Baolian,YUE Yunhe,LIU Jing

(The 54th Research Institute of CETC,Shijiazhuang,Hebei 050081,China)

Abstract:The research on simulation technology of control system based on peacekeeping training was developed in order to solve the long-standing problems in the United Nations peacekeeping operations,such as unlifelike basic domestic training environment,unskilled implementation of mission standards and inadequate emergency response.By using virtual reality,modeling and simulation,immersive experience,artificial intelligence and other advanced technologies,a large space positioning and attitude acquisition method was proposed,and the spatial position and action attitude data fusion algorithm was developed to flexibly support confrontation simulation.A three-dimensional image construction method was proposed to establish three-dimensional models of personnel,equipment facilities,buildings and roads,then the virtual battlefield environment in foreign mission areas was built to support immersive simulation exercises.The results show that it can help soldiers experience realistically in advance,standardize the implementation of standards,simulate red-blue confrontation.And the research of large space positioning technology can effectively extend the virtual battlefield environment,significantly improve the effect of joint training,save training funds,avoid training accidents and improve the training pertinence.The research on virtual simulation training technology can effectively support multi unit cooperative disposal training and even multi arms joint training,and has great popularization value in the field of military training.

Keywords:simulation technology of control system;virtual reality;modeling and simulation;immersive experience;artificial intelligence;large space positioning technology

虛拟现实(VR)技术是20世纪末以来逐渐兴起的一项先进的综合性信息技术,该技术融合了计算机图形学、仿真学以及传感器应用等多学科专业,为作战训练等高风险类型的仿真研究探索出了一条新的道路[1]。VR技术具有3个突出特征:沉浸性、交互性和想象性[2],与传统的桌面虚拟现实系统相比,虚拟仿真训练将用户所处场景封闭,使用户完全置身于虚拟环境中,强调将人在现实世界中的各种行为和虚拟环境融为一体,使人们能像控制现实物体一样控制虚拟环境中的物体[3]。近年来,世界军事强国将虚拟现实技术运用于新型军事战争的情况层出不穷,而且特别注重利用虚拟现实技术进行信息战的演练和研究[4]。美国陆军2012年推出步兵训练系统(DSTS),是世界上首次投入使用的沉浸式战术级模拟训练系统。英国耗资 260 万美元研制了炮兵虚拟训练系统,并在炮兵部队投入使用[5]。21世纪以来,中国陆续将 VR 应用于包括飞行员、舰艇、炮兵、坦克等多个兵种的军事训练中。

联合国维和行动环境复杂危险,形势严峻,冲突不断,突发情况频发。传统的维和部队行前训练采用实兵实装模式,训练效果难以保证。有必要开展基于VR技术的维和仿真训练研究,融合并运用先进仿真技术手段,逼真模拟维和任务区环境,构建维和训练场景,模拟训练对手和突发事件,开展标准作业训练和应急处置訓练,促进维和部队高效遂行维和任务。

1虚拟仿真关键技术研究

1.1大空间定位和姿态捕捉技术

大范围空间定位系统包括发射端和接收端两部分,为了实现一发多收、便携性等功能多采用收发分离式设计[6],发射端包括光塔、HUB和控制器组成,光塔包含激光扫描装置及过零信号发射装置,接收端包括追踪器和定位计算单元。利用激光定位技术延迟低、受遮挡干扰小等特点,在室内训练环境四周覆盖激光发射塔,保证追踪器在任何位置都能够捕获。

1.1.1定位系统部署原理

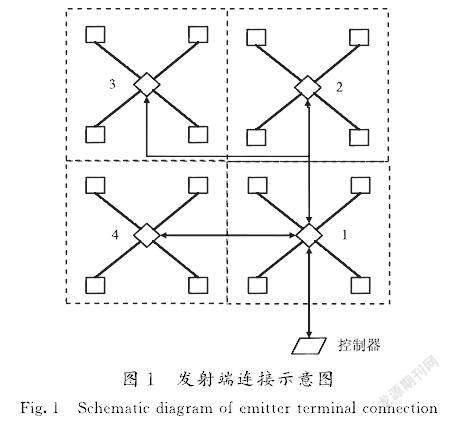

1)发射端

在单个定位空间内,各个光塔与HUB呈星形连接,每个光塔都与单位区间内唯一的面光源相连,各个定位空间之间依靠HUB连接,如图1所示,矩形代表光塔,菱形代表HUB,形成星形结构。

2)接收端

追踪器内,所有的Sensor传感器与九轴传感器将所接收到的数据信息传给CPU及内存,进行自身的位姿计算,然后通过网络传输给计算单元,如图2所示。

1.1.2定位及姿态捕捉工作原理

定位及姿态捕捉工作原理如图3所示。主HUB控制各分HUB的同步,分HUB控制本单元的4个光塔同步,光塔分时工作,发射过零信号和扫描信号,追踪器接收到光塔信号后,自行计算位姿信息,传递给计算单元处理,最终传给显示单元进行显示。由于激光雷达系统需要有很好的实时性,因此算法的计算复杂度与计算时间都需要低于一帧数据的采样周期,即需要在下一组数据导入算法之前,完成上一次数据的计算[7]。本课题以卡尔曼滤波算法作为基础跟踪算法,研发能够满足姿态动作和位置数据进行融合的算法。

1.2三维影像构建技术

虚拟环境的建立是虚拟现实技术的核心内容,环境建模的目的是获取实际环境的三维数据,并根据应用需要,利用获取的三维数据建立相应的虚拟环境模型[8]。

美军采用综合了航空照片、卫星影像和数字高程地形数据来分析生成高分辨率的作战区域三维地形环境,以几乎一致的三维环境来训练参战人员[9]。

本文采集任务区多源数据,包括建筑物信息、开源影像数据、人员装备等近景数据,无人机航拍影像、直升机航拍影像等航空遥感影像数据,突破三维影像特征检测与匹配、三维影像表面重建技术,构建逼真三维影像。

1.2.1三维影像特征检测与匹配技术

三维影像特征检测与匹配技术主要包括三维特征检测、三维特征快速匹配和自动剔除粗差。三维特征检测技术采用SURF特征检测算子,研究多特征融合检测技术、特征描述符提取技术和GPU并行优化加速技术;三维特征快速匹配技术采用基于FLANN的快速检索算法、基于哈希表的快速检索算法和基于GPU并行加速检索算法等,研究多基线立体匹配基准、多基线立体匹配模型和多基线立体匹配约束技术;自动剔除粗差技术采用RANSAC算法加归一化的DLT算法鲁棒估计基础矩阵、重投影误差最小化估计基础矩阵,局部单应约束剔除粗差点,具体流程如图4所示。

在特征点检测与提取上,目前匹配能力较强的特征点检测算法是SIFT算法,具有较高的重现性和满覆盖性,但其提取过程时间复杂度和空间复杂度较高,无法直接应用到三维影像的特征提取,本文主要采用SURF算法和KAZE算法进行特征点检测。

1)SURF算法

步骤1:计算积分图像

积分图像可通过卷积的盒子滤波器进行快速计算,在I∑(x)的位置输入卷积图像,X=(x,y)T代表了包括原点和x的输入图像I的所有像素之和。

I∑(x)=∑i≤xi=0∑j≤xj=0I(i,j)。(1)

步骤2:计算基于兴趣点的Hessian矩阵

给定点为x=(x,y),计算其Hessian矩阵H(x,σ)行列式的决定值,来判断特征点。

H(x,σ)=Lxx(x,σ)Lxy(x,σ)

Lxy(x,σ)Lyy(x,σ)。(2)

步骤3:构建尺度空间

使原始图像保持不变,通过变化模板大小对原图像进行滤波,从而构建出尺度金字塔,把相应图像分成多组,每组由多层组成,各组采用逐渐增大的滤波器尺寸进行处理[10],不需对图像进行二次抽样,从而提高算法性能。

步骤4:精确定位特征点

检测过程中使用与该尺度层图像解析度相对应大小的滤波器进行检测,丢弃所有小于预设极值的取值,最终保留几个特征最强点。

2)KAZE算法

步骤1:对图像进行高斯滤波,计算图像的梯度直方图,利用AOS算法来构造非线性尺度空间。

Li+1=I-(ti+1-ti)∑ml=1Al(Li)Li+1。(3)

步骤2:检测感兴趣特征点,通过判断经过尺度归一化后的Hessian局部极大值来实现。判断过程中,每一个像素点和周围的相邻点比较,当其大于图像域和尺度域的所有相邻点时,即为感兴趣特征点。

L(hessian)=σ2(LxxLxy-L2yy)。(4)

步骤3:计算特征点的主方向,并且基于一阶微分图像提取具有尺度和旋转不变性的描述向量。对图像搜索圈内所有邻点的一阶微分值进行高斯加权,将这些微分值视作向量空间中的点集,在一个角度为60°的扇形滑动窗口内对点集进行向量叠加,遍历整个区域,获得最长向量的角度就是主方向。

1.2.2三维影像表面重建技术

三维表面重建技术主要是实现散乱点云数据的曲面重建,重建三维模型。先对模型表面采样的有向点云数据集进行粗差探测与分块,同时进行稠密点云抽稀,以提高系统运行效率;在曲面生成之后,进行曲面优化重建结果;最后进行网格简化,减少重建模型中的冗余数据,为模型的存储与浏览提供方便。

1)點云数据的粗差探测与分块技术

点云数据的粗差探测技术如下:首先,计算待测点p的k个最邻近点。然后计算k+1个点的高程平均值Mp ,对于点p ,可以得到一个高程差值Vp ,计算公式如式(5)所示:

Vp=Mp-Hp。(5)

所有点的高程差值都将用来计算统计值,作为决定最终阈值的基础。算术平均值U与标准偏差 SD分别按照式(6)计算:

U=∑ni=1Vin,SD=∑ni=1(Vi-U)2/(n-1),(6)

式中:n为点的总个数。若|Vp-U|>T,则点p被判断为粗差点,否则就认为点p不是粗差点,其中阈值T一般设置为SD的3倍。

点云数据的分块首先根据影像及其空三参数,获取整个测区的地理坐标范围,规划设置分块参数D,较平缓的数据可以将D适当放大,这样可以提高重建效率,比较复杂时,可以适当缩小D的取值[11],保证整个测区分块格网的精度。然后按分块参数对测区进行划分,得到整个测区的分块格网。

2)三维影像数据的密集点云抽稀技术

为解决数据密度和应用精度不符的情况,采用基于TIN的抽稀方法和基于网格流的抽稀方法使其达到平衡。

基于TIN的抽稀方法,输入数据,构建不规则三角网DEM模型。在TIN模型上,抽稀是对模型影响最小的点。首先加载点云数据,构建TIN;选取数据点,查找以这个点为顶点的所有三角形;求该点的相邻三角形的两两法向量的夹角,并求最大夹角max θ;将max θ与设定的阈值T作比较,如果小于T,则删除这个点,否则保留;继续处理不规则网中的下一个点,直到所有数据处理完。

基于网格流的抽稀方法,每次网格流处理构建TIN的时候,当读取到格网稳定标识时,就要判断稳定三角形,将当前条件成熟的活跃三角形变化为稳定三角形;查找在内存中的数据点,并找到这些点的相邻三角形,当点的所有相邻三角形都稳定了,对该点进行抽稀处理,采用基于TIN的压缩方法,判断该点的两两三角面的最大夹角是否大于阈值,来决定是否保留该点,并标记该点已经作了抽稀处理;如果三角形参与了3次抽稀计算,即它的3个顶点都已经进行了抽稀处理,那么将该三角形的内存释放。如果点的所有相邻三角形都参与了3次抽稀计算,就可以释放该点的内存;直到将格网流中的点数据处理完成。

3)基于区域生长策略的构网重建技术

针对三维影像匹配点云数据量大的特点,采用基于局部区域生长的构网算法来进行三维表面重建,然后利用网格的简化策略生成多层次的网格模型。算法流程如图 5所示。

其中,良好的种子三角形的选取是快速进行区域生长的关键:根据空间索引理清点云的空间分布状况,设置多个起始点,搜索各起始点的最邻近点,连接起始点与其最邻近点,将其作为待选种子三角形的一条边。以该边的中点为球心,边长的k倍为半径,建立搜索球,遍历搜索球内的每一个点,将其与已知边组成三角形,验证该三角形的最小外接球内是否存在其他点。如果不存在,则该三角形为待选种子三角形,验证该三角形是否在点云数据表面,如果满足要求则种子三角形构建完成。

区域生长策略是整个点云数据进行构网的关键步骤:首先搜索活动边指定范围内的候选点,在活动三角形所在的平面上作活动边的中垂线,在其中垂线上距活动边一定距离处确定搜索球的球心。根据球心和球上的两点即活动边的端点确定搜索球的半径,根据球心和半径计算球内所包含的点,即活动边指定范围内的待选点。根据待选点和活动边确定多个搜索球,比较后确定最佳候选三角形,对新增的两条活动边进行验证,判断其是否属于其他三角形,根据判断情况,修改活动边列表,递归完成构网。

2综合仿真研发

研发综合仿真引擎技术,融合仿真引擎和游戏渲染引擎,采用基于步长的连续型时间步进仿真机制,把仿真时间等分为时间序列,按时间步长依次推进,通过一步一步地重复计算仿真新状态来填充时空图。同时实现实时仿真和超实时仿真的时空一致性,为战术级对抗仿真提供灵活的引擎支撑。

2.1双引擎工作机制

双引擎工作机制下的基本工作流程如图 6所示。

仿真开始后进行仿真初始化,主要完成配置信息的读取、环境数据加载、仿真任务的加载等,然后进入系统主循环,处理对应的仿真任务。其中仿真引擎和融合引擎相互融合,分别负责不同的工作,完成虚拟想定和虚拟场景的结合。

仿真引擎根据仿真时间的驱动机制不同,采用线程同步和线程非同步2种仿真推进策略,同步线程负责与主线程交互的任务,非同步线程负责数据加载等非实时处理类辅助工作。

渲染引擎具有更高维度布局空间以及性能上的优势[12],根据初始参数完成虚拟战场的渲染,按照时间轴的方式进行计算渲染,按照无限循环的模式处理Windows消息,完成三帧预测、阈值检测、仿真倍率以及虚拟战场空间中的各类活动检测,及时调用引擎各子系统更新状态。

2.2仿真任务中的时间管理

时间管理上重点处理2个时间:仿真时间(Glob.Time)和真实时间(Glob.uiTime)。其中(Glob.uiTime)从引擎启动完成初始化操作后开始累计,是仿真运行所流逝的真实时间;(Glob.Time)是仿真系统中表现出来的时间,是仿真开始后累加的时间,受时间加速因子影响,可以加速、减速和暂停。

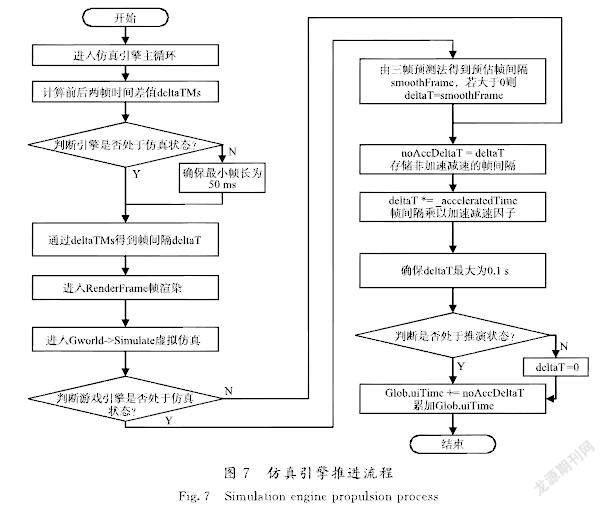

在仿真引擎中,帧间隔以ms为单位,采用32位的浮点数来存储,推进流程如图 7所示。

第1步:deltaTMs=(当前系统Tick-上次系统Tick)×0.001;//Tick是启动后所经历的毫秒数;

第2步:判断是否处于仿真状态,是跳转到第4步,否则,执行第3步;

第3步:如果deltaTMs<0.05时,等待(0.05-deltaTMs),deltaTMs=0.05;

第4步:通过deltaTMs得到帧间隔deltaT;

第5步:判断游戏引擎是否处于仿真状态,如果是进行三帧预测,重置deltaT;

第6步:将deltaT值存储到真实步长noAccDeltaT;

第7步:deltaT*=加速减速时间因子,此时deltaT变为仿真步长;

第8步: 如果deltaT大于0.1,则deltaT=0.1;

第9步:判断是否处于推演状态,如果是,真实时间累加仿真步长,否则deltaT=0,真实时间不变。

仿真任务启动后在不同场景下仿真推进时,仿真时间与真实时间的对应情况如图 8所示。

3仿真验证与结果分析

3.1搭建仿真训练平台

搭建一个仿真训练平台,利用单兵虚拟现实设备、空间定位设备、VR眼镜等硬件设备配合开展大空间定位和姿态捕捉技术研究;利用实体模型、装备模型和影像数据配合开展三维影像构建技术研究;研发软件统一架构、接口规范、场景构建工具等开展综合仿真引擎技术研究;研发业务软件验证虚拟仿真技术研究成果。

测试场地长×宽为24 m×18 m,安装布设大范围空间定位设备一套,4个HUB,31个光塔,仿真控制计算机3台,仿真训练平台业务软件一套,可安排24人的分队进行联合训练,每人穿戴一套头戴式单兵虚拟训练套装,VR眼镜中显示预定的战场环境,空间定位设备捕捉人员位置和姿态信息,传递到电脑,进行三维场景更新。搭建环境如图 9所示。

本文选择Unity 3D作为仿真训练平台业务软件的开发工具。Unity 3D是应用于实时视景仿真、虚拟现实及其他可视化领域的主流软件之一[13],可以轻松地创建诸如三维视频游戏,建筑可视化以及三维动画等效果,是一个全面整合的专业游戏引擎。Unity 3D里面提供了声音、图形、渲染和物理等多种功能,内置了强大的编辑器,支持 3D Max,Maya等多种文件格式[14]。

3.2仿真结果分析

3.2.1实现大空间定姿捕获

目前市场上大量的沉浸式体验都是基于小范围、固定空间的设备,大范围定位技术还没有应用到沉浸式体验,尤其没有应用到维和训练中。小范围空间定位技术的有效定位面积一般为4.5 m× 4.5 m,而本文实现了400 m2以上面积的有效空间定位和姿态捕捉;另外通过模拟武器上配备万向轮装置,在软件中进行虚拟场景和室内训练环境的映射转换,使得室内训练环境在虚拟场景中实现上万倍延伸。该技术研究能够有效支撑多分队协同处置训练,甚至多兵种联合训练。

在大空间定姿捕获试验中,随机选择训练位置进行测试,测试记录如表1所示。

测试过程中,在测试人员身上多个部位分别部署接收端追踪器,采集测试人员的姿态及位置信息,同时接收光塔信号,然后进行自身的位姿计算,测试者手持模拟武器,在测试场地随机选取位置,按照站立姿态、举手姿态、跪地姿态、俯卧姿态的次序进行动作,在显示端虚拟场景中,同步显示测试人员的位姿信息,记录各个姿态的定位误差和动作时延,取平均值作为该位置的最终结果。在定位误差的测试结果中,最大为0.36 cm,定位精度为毫米级,对于虚拟场景中的战术动作计算没有影响,在动作时延的测试中,最大时延为25 ms,从视觉感受方面也察觉不到,保证指挥员口令、参训人员动作、虚拟场景展现的一致性。通过对定位设备进行随机抽检测试,验证大空间定位设备工作正常,在规定的训练范围内,定位姿态捕获动作姿态无误、定位精度均小于1 cm,动作时延小于30 ms,能够满足训练系统的需要。

3.2.2构建虚拟训练场景

构建大范围野外地形环境、城市街区环境、重点目标设施模型、建筑物室内环境、人物角色、交通工具等实体模型和装备模型,构建相应的行为组件模型和服务组件模型,随后全部导入到Unity资源中,进行规划和摆放,最终形成虚拟场景的整体模型[15]。仿真试验创建了数千个模型,构建了50多个典型国外任务场景,帮助官兵提前体验任务区环境。

系统构建的训練场虚拟场景如图 10所示。

3.2.3双引擎机制支撑灵活对抗仿真

传统的仿真引擎机制和渲染引擎机制各有优点,仿真引擎偏数据计算服务,渲染引擎偏展现画面呈现服务,但分别使用、交叉切换时,操作繁琐,界面不一致,操作不友好,随遇接入困难。

综合仿真引擎机制解决了上述不便,支持实时仿真和超实时仿真的时空一致性,并可同步提供三维态势展现,为战术级对抗仿真提供灵活支撑。

4结语

虚拟现实技术是未来军事模拟训练的关键技术之一[16]。开展虚拟仿真技术在维和训练中的应用研究,是利用虚拟仿真和人工智能技术解决维和任务训练中的实际问题。尤其是开展大空间定位和姿态捕捉技术、三维影像构建技术和综合仿真引擎技术等关键技术研究,并设计了一种“体验逼真、要素齐全、集约高效、扩展灵活”的虚拟仿真训练平台。

通过平台可以构建维和任务区虚拟场景,利用三维影像构建技术将真实场景高度还原到虚拟平台中,维和官兵可以头戴VR眼镜在虚拟场景中沉浸式漫游,足不出户即可熟悉万里之外的维和任务区环境;通过平台可以进行想定编辑,将联合国标准作业程序、任务区突发情况处置规范融入想定事件中,利用空间定位和姿态捕捉技术和综合仿真引擎技术,维和官兵可以穿戴单兵背包,在虚拟场景中沉浸式模拟演练,扮演想定中的各种角色,体验维和任务区中突发事件的处置流程。依托该平台开展虚拟仿真训练,能有效解决目前维和实战训练中存在的任务区作业环境不熟悉、执行任务作业程序不标准、突发情况应急处置不到位等问题。让维和官兵在国内行前训练就对任务区环境、标准作业程序、突发事件处置流程有着深度体验,到达任务区后马上能够投入维和任务中,大大缩减维和官兵对任务区新环境的适应时间,面对突发情况时减少不必要的伤亡。为培养维和官兵过硬军事技能、有效遂行维和任务提供了有益探索。

受目前VR技术局限性和硬件条件限制,虚拟仿真训练平台尚不能逼真模拟人体触感和对环境的感受,在VR头显分辨率、处理技术等方面也无法达到最优效果。未来随着触觉沉浸、嗅觉沉浸、身体感受沉浸等系列VR技术的成熟,虚拟仿真训练必将引领中国军事训练领域的发展趋势。

参考文献/References:

[1]陈志,凌丽,王程,等.基于虚拟现实技术的便携式防空导弹训练装备研究[J].飞航导弹,2016(6):39-42.

[2]高博,黄昉,侯春牧.虚拟现实技术在美军实战化训练中的应用及启示[J].国防科技,2014,35(2):94-97.

GAO Bo,HUANG Fang,HOU Chunmu.Virtual reality technology in the U.S.army combat training and its implications[J].National Defense Science & Technology,2014,35(2):94-97.

[3]郎跃东.面向装配的球面虚拟环境系统的建立以其关键技术研究[D].哈尔滨:哈尔滨工业大学,2010.

LANG Yuedong.Research on the Key Technologies of Assembly-Oriented Virtual Environment with Spherical Screen[D].Harbin:Harbin Institute of Technology,2010.

[4]许路铁,张猛,俞卫博.虚拟作战训练的研究现状[J].飞航导弹,2017(6):58-62.

[5]周宝林,刘军,董晓峰.VR技术在军事训练中的研究与应用[J].科技传播,2017,9(11):38-39.

[6]向振佼.高精度激光定位系统的性能提高研究[D].哈尔滨:哈尔滨工业大学,2019.

XIANG Zhenjiao.Research on Performance Improvement of High-Precision Laser Positioning System[D].Harbin:Harbin Institute of Technology,2019.

[7]赵弋峰.激光运动目标空间定位与KF算法跟踪研究[D].西安:西安电子科技大学,2016.

ZHAO Yifeng.Spatial Orientation and KF Algorithm Tracking of Moving Target in Laser[D].Xi′an:Xidian University,2016.

[8]张育军.虚拟现实技术在军事领域的应用与发展[J].科技创新与应用,2014(15):290-291.

[9]徐军,安宝航.军事训练中的虚拟现实技术现状及启示[J].产业与科技论坛,2015,14(1):51-52.

[10]王晓红,邓仕雄,何志伟,等.结合SURF算法和单应性矩阵的无人机影像匹配[J].测绘通报,2018(7):38-42.

WANG Xiaohong,DENG Shixiong,HE Zhiwei,et al.Study of UAV image matching based on SURF algorithm and homography matrix[J].Bulletin of Surveying and Mapping,2018(7):38-42.

[11]苍鹏.基于激光雷达点云数据的建筑物三维重建技术[D].长春:长春理工大学,2019.

CANG Peng.3D Reconstruction of Buildings Based on Lidar Point Cloud Data[D].Changchun:Changchun University of Science and Technology,2019.

[12]唐前昭.基于三维图像引擎实时渲染复杂网络数据的研究与应用[D].成都:电子科技大学,2018.

TANG Qianzhao.Research and Application of Real-Time Rendering of Complex Network Data Based on 3D Render Engine[D].Chengdu:University of Electronic Science and Technology of China,2018.

[13]李志,李舰,付玉峻.基于Unity 3D的某型地空导弹战斗场景可视化研究[J].电脑编程技巧与维护,2016(3):71-72.

[14]乔毛毛.基于Unity3D的虚拟仿真训练系统的设计与实现[D].西安:西安电子科技大学,2014:14.

QIAO Maomao.Design and Implementation of Virtual Simulation Training System Based on Unity3D[D].Xi′an:Xidian University,2014.

[15]张策.基于Unity3D的三維游戏场景设计与实践[D].合肥:合肥工业大学,2016.

ZHANG Ce.Practice of 3D Game Scene Design Based on Unity3D[D].Hefei:Hefei University of Technology,2016.

[16]张玉军,邢辉,洪增.沉浸式虚拟战场3维音效仿真研究[J].兵工自动化,2017,36(1):59-63.

ZHANG Yujun,XING Hui,HONG Zeng.Research on immersive virtual battlefield 3D sound effect simulation[J].Ordnance Industry Automation,2017,36(1):59-63.