中文领域命名实体识别综述

焦凯楠,李 欣,2,朱容辰

1.中国人民公安大学 信息网络安全学院,北京100038

2.安全防范技术与风险评估公安部重点实验室,北京100026

命名实体识别(Named Entity Recognition,NER)是自然语言处理(Natural Language Processing,NLP)领域的子任务,通常解释为从一段非结构化文本中,将那些人类通过历史实践规律认识、熟知或定义的实体识别出来,同时也代表了具有根据现有实体的构成规律发掘广泛文本中新的命名实体的能力。实体是文本中意义丰富的语义单元,识别实体的过程分为两阶段,首先确定实体的边界范围,然后将这个实体分配到所属类型中去[1]。

1991年Rau[2]隐式地提出了NER任务,需求是从文本中提取公司名称。在1996年之后,NER作为信息抽取的一项子任务的属性在第六届消息理解会议(Message Understanding Conference 6,MUC-6)上被正式确立。

NER的提取对象随着相关评测会议的进行不断丰富。最先开始的英文文本实体集中在三大基本类[3]——person(人物)、organization(组织机构)、geographical location(地理位置)上,同时辅助于currency(货币)、time(时间日期)、percentage expression(百分数表达式)的识别,前者属于实体类(entity type),后者属于数字类(numeric type)。而person类下包含了名字、昵称、代称[4]、外文译名[5]等识别任务,location类对城市、道路、区划等名词进行识别。随着NER研究的推进,提取实体范围更广,实体分类更加精细,不同语种、不同学科领域被包含进来。

NER技术随着相关评测会议的举办逐渐明确研究目标[6]。英文NER技术对于中文NER发展具有借鉴意义,中英文的构成差异和中文显著区别于英文的特性,促进了相关中文评测会议的发展。英文是单词和符号的组合,英文单词由空格隔开,具有大小写、词根词缀等特性。中文由单个汉字和符号组成,因此中文NLP研究最初集中在汉语自动化分词[7]上,中文NER相较于英文文本缺少了一些单词粒度信息。

促进中文NER发展的会议有SigHAN、863中文IP评测会议等。NER在SIGHAN Bakeoff-2010之后[6],不再作为评测任务出现,后续如命名实体消歧、命名实体链接任务被加入信息抽取任务中,NER最新进展被发表在ACL、AAAI、COLING、EMNLP、NAACL等NLP顶级会议中[1]。

1 中文领域命名实体识别

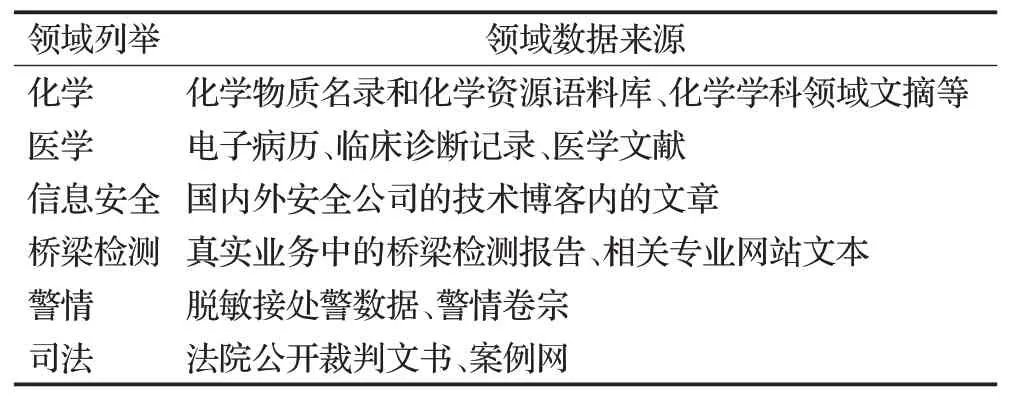

面向特定领域的NER任务——领域命名实体识别(Domain Named Entity Recognition,DNER)产生于工业界对于NER业务场景的开放与扩展。中文DNER是在中文NER所识别的基本实体类别上提出的领域适应分类方案。表1列出了部分领域与所识别实体的对应关系。

表1 特定领域与对应实体Table 1 Specific domain and corresponding entities

这些领域的实体类型不尽相同,却是组成各自领域文本的基本语义单元。部分实体也是对三大类基本实体的细粒度在场景下的扩充,如诉讼当事人、恐怖分子等实体类型是person类实体在具体场景下的细化。

1.1 中文领域命名实体识别分类

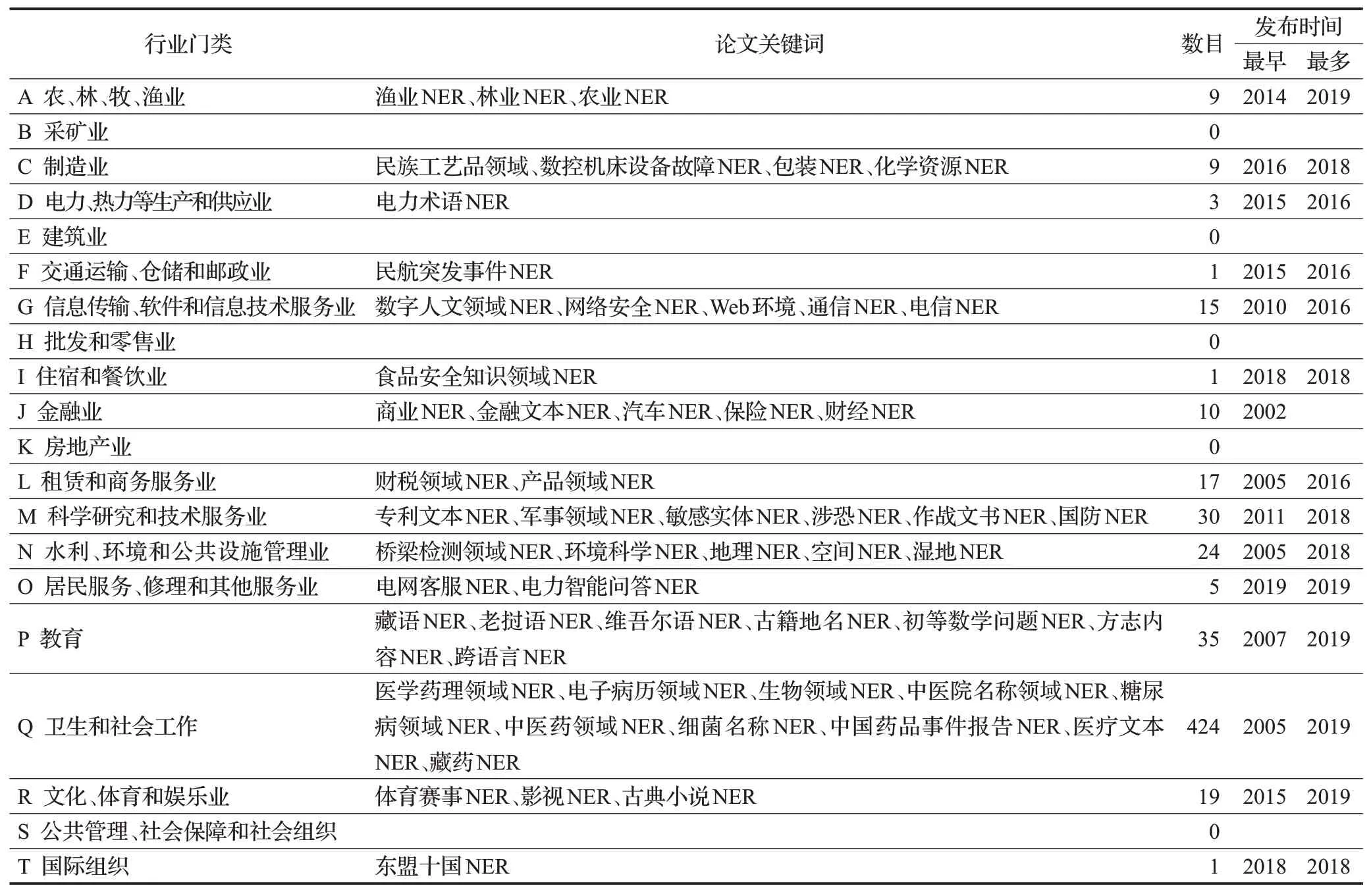

DNER属于NER面向不同行业领域的子任务,DNER技术依赖于NER技术发展,DNER广度取决于我国工业化场景的集合,依据2017年国家标准《国民经济行业分类》将我国行业分为20个门类、97个大类等。表2分别展示了行业门类信息和根据该分类标准统计所得的DNER研究及论文情况。

以搜索条件“篇名:实体识别”在知网得到的603篇文献标题经过jieba分词、去除论文标题常用停用词作为统计总数。因搜索条件严格限制了领域关键词必须出现在论文标题内,同时未纳入同时段英文论文发表数目,因此所得数目与实际研究数量会有稍许差异。表2说明了卫生和社会工作类研究比例突出,占所有文献的70.3%。

1.2 中文领域命名实体识别的作用

由表2可知,某一个领域频繁地被选择代表该领域对于NER技术的迫切需求,如通过挖掘日产且数量巨大的半结构化电子病历以助力现代化医疗的建设,通过挖掘日产且庞杂的社交媒体信息反映大众偏好,通过挖掘涉恐新闻报道中潜在恐怖组织痕迹对于维护现代化社会的和平稳定具有重要意义。

研究集中的领域使得NER技术的迭代速度加快,使复用到其他领域的可能性验证实验周期缩短。技术与产业的结合作为驱动力,使某个趋于成熟的DNER形成了一套从数据预处理、模型选择、领域内新实体的处理框架,复用至其他DNER中,加快产业文本的结构化速度。表2隐含的DNER不均衡发展情况是领域迁移能力不成熟的体现,这受限于NER技术基础。DNER不仅致力于特定领域实体识别准确率的提高,也对新领域实体提取效率的提高提出了要求。

表2 行业门类所对应领域NERTable 2 Industry category corresponding to domain NER

NER是NLP领域的重要基础任务,其基础性正体现在NER任务性能的提高进一步有利于非结构化文本朝结构化文本的转化,有利于大数据时代中分类别大型知识库的构建,有利于问答对话系统的精准意图识别,有利于机器翻译中正确的槽位填充等。随着NER识别自然语言中已有类别的新实体的能力和新类别的新实体的能力的提高,现有知识库得到了扩充,从而推动了在此基础上人工智能与自然语言知识图谱的发展[1]。

2 中文领域命名实体识别构成

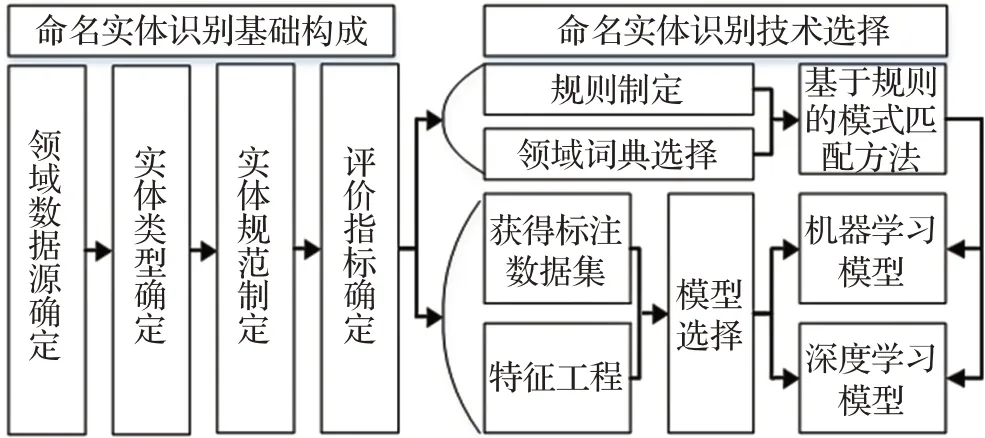

2.1 中文领域命名实体识别框架

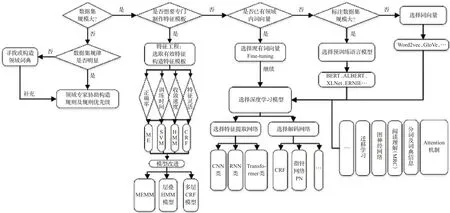

DNER框架参照NER的一般研究流程,如图1所示。当DNER研究领域确定后,需要完成的NER基础操作如数据源的获取、评价指标的确立等,之后在技术选择阶段根据领域及数据集特点制定相应的方法。

图1 中文领域命名实体识别框架Fig.1 Chinese domain named entity recognition framework

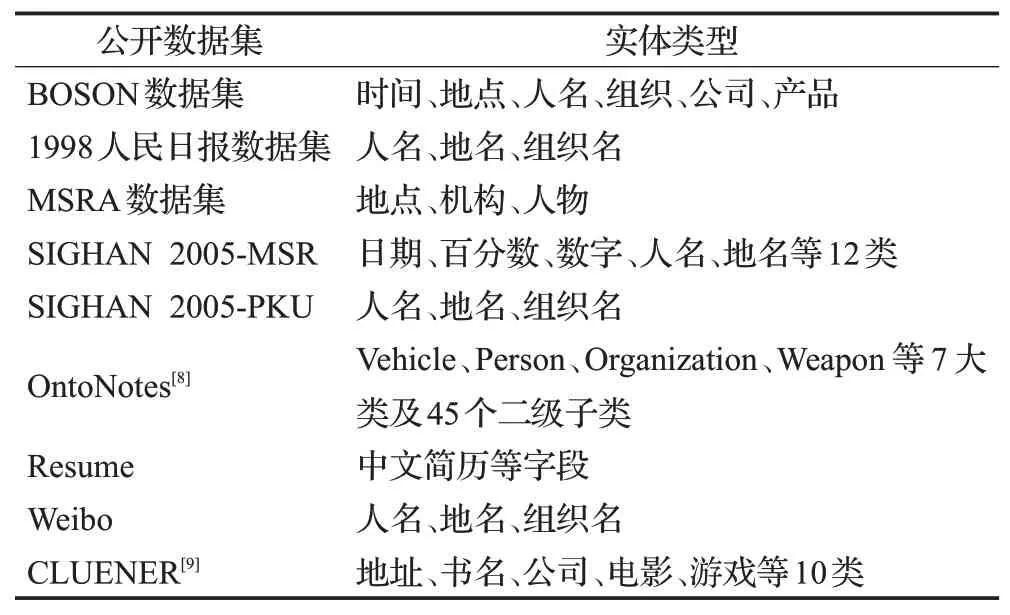

2.2 领域数据源确定

确定提取领域后,根据领域数据来源的差异来辅助确定实体类型。当数据源包含新闻文本时,实体类型需包含person、location、organization三类基本实体在领域内的细粒度角色。如在制定影视DNER实体标签时,明星、电视剧都是构建影视知识图谱所需的基本实体单元,明星既是person类实体在娱乐领域的细化,亦是娱乐领域的独有实体,即训练好的NER模型会把娱乐新闻中出现的人名识别为明星、导演等细化角色。三类基本实体的数据来源多为评测会议数据集,多由新闻文本组成,如表3所示。因此当研究领域的数据源包含新闻时,待识别实体类型需包含以上三类基本实体。

表3 公开数据集与实体类型Table 3 Exposed data sets and entity types

领域数据源还包括领域专业文本,此时需要根据专业文本特点制定实体规范。如涉恐、军事领域的数据既包含了互联网公开数据,也囊括了保密数据如作战文书、专业数据,如GTD[10](Global Terrorism Database)。表4列出了一些领域的专业文本来源。领域专业文本有相关规范文件予以背书,识别需求与任务关系明确,将专业相关术语、文献配合以任务驱动,使得实体规范不易产生歧义并能迅速投入标注过程。

表4 领域的专业数据来源Table 4 Professional domain data sources

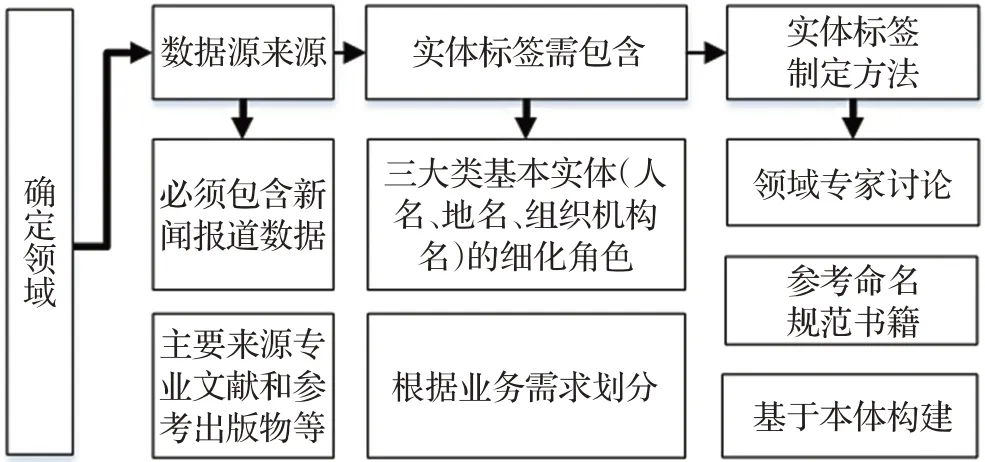

2.3 领域实体类型及规范制定

DNER需要严格实体标签,也称为实体类型。领域内实体各具特点,需制定适应实体识别框架的领域实体规范。如图2所示,确定领域后,若领域数据包含新闻类数据源,则实体类型需要包含三大类基本实体——person、location、organization在领域场景下的细化角色;若数据来源主要为专业文献及出版物,则实体类型根据业务需求制定。细化角色的确定及具体的实体类型规范由领域专家参考命名规范类书籍讨论或依据本体构建。

图2 中文领域实体规范Fig.2 Chinese domain entity specification

实体规范制定难点之一在于工业场景对于实体的细粒度化。细粒度实体识别是在基本实体范畴下的细化方案,如person类下的明星实体。OntoNotes[8]数据集最早提出细化实体粒度方案,在7大类下制定了45个子类,为相关领域具体实体制定提供了解决思路。表5列出了三类基本实体的细化方案,当前基本实体的识别效果出色,但在具体领域下,尽管识别的实体属于三类的子类,但因子类标签固有的一层语义关系易使识别产生混淆,从而对此类DNER提出了挑战。

表5 三大类实体细化方案列举Table 5 Enumeration of detailed schemes for three major categories of entities

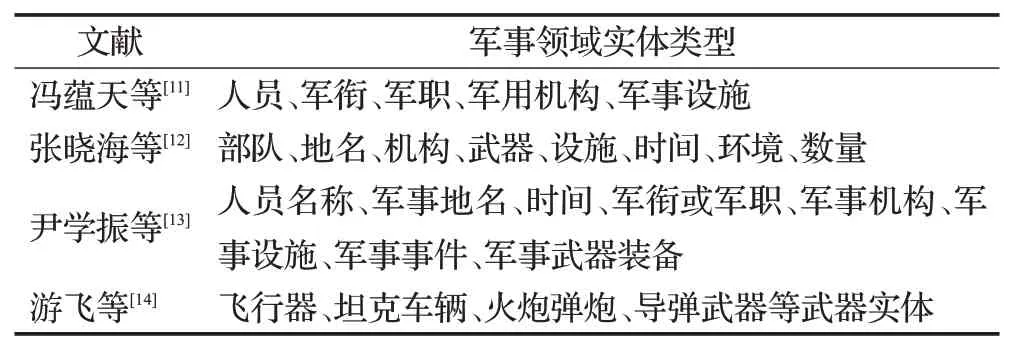

难点二是特定领域内实体标准未被唯一确定,领域语料库无法融合。表6中的军事实体类型的制定依据均为具有军事意义的实体,但差异在于实体类型名、实体类数目、细粒度实体定义、数据来源的确定,这四点差异使得不同学者构建的军事实体语料集和提出的相关算法无法及时迁移和比较。

表6 军事领域实体细化方案列举Table 6 Enumeration of detailed schemes for military entities

领域实体规范一般由领域专家参考相关专业规范根据业务联合确定。如表4所示,专业特征极强、区分力强的实体领域包括医学、数学等学科领域,桥梁检测、航天等工业领域。医学领域的蛋白质、疾病等实体,化学领域的有机物等实体不属于三大基本类别,不因数据源的不同而产生歧义,同时有权威出版规范加以背书,实体规范更易制定,标注更易进行,面对新实体的出现也更易进行更新和补充。

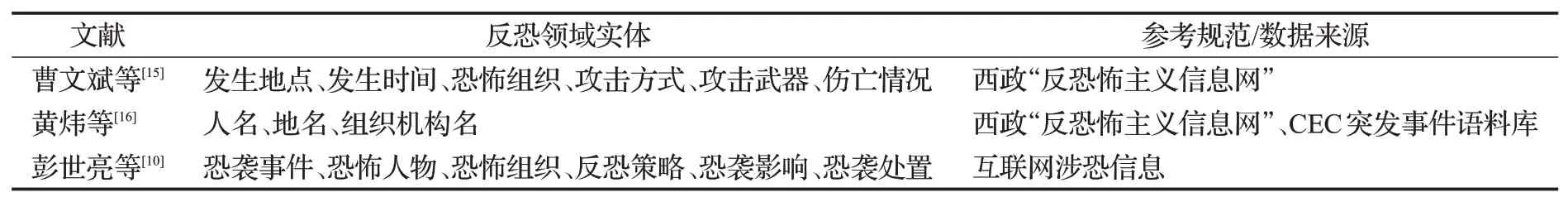

在制定领域实体规范时参考与之任务相近领域的实体规范,能够减少实体类别歧义,如表7所示,军事、涉恐领域因涉及国际形势研判,数据源存在交叉,制定出的实体有相似之处。

表7 反恐领域实体及数据来源Table 7 Entities and data sources in field of counter-terrorism

基于本体理论[17]制定领域实体类型,以文本结构化为目标,将提取的实体作为实例化本体元素并按照本体结构存入知识库中,是知识库填充的技术基础。有学者[17]归纳总结领域知识,构建了审判文书本体提取司法领域实体。本体推理技术的发展如类的一致性检查[18],可以避免定义本体直接运行后出现的类不一致错误,在理论层面解决实体类型之间的矛盾。

较低的领域实体规范认同度使得人类表现低于深度学习NER模型的表现。有学者提出限制性标注原则[19],明确了实体标注不重叠、不嵌套、不包含标点符号。强制规定实体不会跨越标点符号有助于标注方案的实际执行,从制定实体规范到标注工程仍然富含挑战,不仅需要培训专业标注人员保证标注不能自相矛盾,还需检验标注数据集质量。医学领域提出了IAA检测[20],标注后由不同专家进行交叉检验,根据指标估计标注体系的合理性,该方法逐渐被其他领域采用。

综上可知,DNER的第一步是数据源的选取,第二步是根据任务需求严格制定实体类型并制定提取标准。健壮的实体类型规范有助于领域语料库汇集,表3中的评测会议数据集具有质量高但覆盖领域不全面的特点,此时领域语料集的补充显得尤为重要。

2.4 领域标注数据集的标注规范

数据集标注规范即命名实体输入模型前的表示。主要标准标注规范由评测会议制定,为多数研究所认可,也可根据实体类型自行制定。常见标注规范如下:

(1)BIO,自CoNLL 2003使用。创新性提出以flagcategory方式进行标注,B代表实体首部,B-school表示一个school实体首部;I代表实体内部或结束,I-person表示一个person实体内部或尾部;O代表非命名实体,标注规范约束了B-school后应为I-school而非I-person。根据模型需要利用的信息以及原始数据集是否需预先分词,标注粒度可分为词语级和字级,如图3所示。

图3 BIO标注规范Fig.3 BIO annotation specification

(2)BIOES,BIO的扩展。在BIO的基础上,使E表示实体尾部;I仅表示实体内部成分;S表示由一个词或字构成的单独命名实体,区别于B(I*)E形式的复杂实体;O含义不变。

(3)Markup标注,为OntoNotes[8]使用,是一种类XML规范。使用字段设置类型,

图4 Markup标注规范Fig.4 Markup annotation specification

有学者使用中文分词任务的BMES标注规范[21]进行实体标注,BMES字母含义类似于BIOES;在此基础上有学者扩充了刑事案件文本实体标签[22],提出含7个标注符号的bmelros体系,其中b、e是实体左右边界,m是实体内部,l、r分别为实体左、右提示词,s和o继承自BIOES。具体标注规范的选择由数据集及训练方式决定,选择字或词来标注取决于算法利用字级别或词级别信息。BIOES标注规范因更准确地指代了实体的内部特征,被证明能提高识别效率[23],但后续深度学习出现的预训练语言模型使用了BIO标注,BIO与BIOES格式可轻松进行转化。

2.5 领域评价指标确定

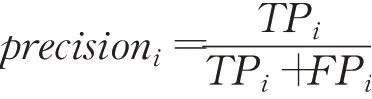

NER常用评价指标有precision(精确率)、recall(召回率)、F1,有时以Micro-F1、Macro-F1来辅助评定识别效果。

对输入模型句子中的每一个token进行多分类。NER中的gold_tag代表真实标签,predict_tag代表预测标签,若需要识别出N类实体,则为任一类实体i,i∈N,计算:

TPi:gold_tag与predict_tag均为i的token数目。

TNi:predict_tag、gold_tag均非i的token数目。

FPi:predict_tag为i、gold_tag非i的token数目。

FNi:predict_tag非i、gold_tag为i的token数目。

precision:识别正确的实体标签数量占全部predict_tag标签为该实体标签标记数量的比例。

recall:识别正确的实体标签数量占全部gold_tag为该实体标签的比例。

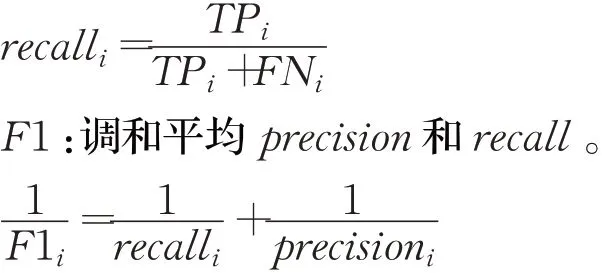

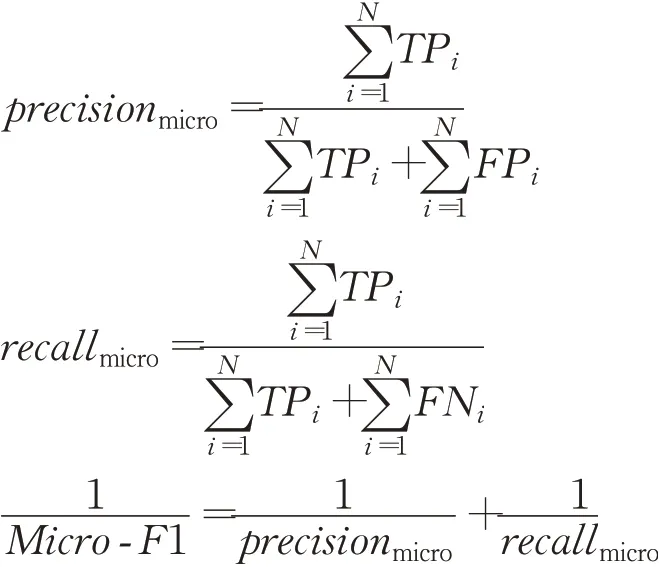

Micro-F1:将为每一类实体i计算precisioni和recalli时所需的基础因子TPi、FPi、FNi加权求和运算得到precisionmicro和recallmicro,并代入F1的运算公式。

由公式可以看出,Micro-F1受各类别实体数目分布的影响,若数据集中实体分布不均,则Micro-F1能够客观描述提取效果。

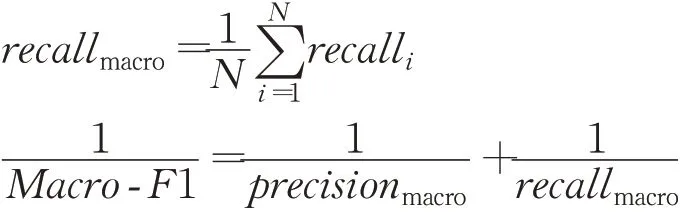

Macro-F1:将所有类别的precision总和与recall总和分别求平均值,并代入F1公式进行运算。

由公式可以看出,Macro-F1不考虑各类别实体数目具体分布的影响,被具有较高precision和recall的实体类别所影响。

由上述计算公式可知,NER评估指标一般在token级别上计算,即在逐字标注的基础上,判断每个字与对应答案是否一致,而不考虑字前后是否属于相同实体等约束条件。但当识别出的命名实体被用于下游任务时,在完整实体级别计算上述指标会更有用。实体级别即同时考虑实体边界和实体类型,在表8所示六种情形下,CoNLL[24]、ACE[25]、MUC[3]、SemEval[26]等评测会议规定了细致的解决方案。如SemEval提出的精确模式规定只将情形1计入识别正确时会导致准确率较低,可以把情形2、情形3也计入识别正确[27]以提高相关指标。某些DNER应用只需识别句子中的实体边界即可计入识别正确,如影视文本将《红玫瑰与白玫瑰》识别为书名或电影名均计为正确,前提是将这7个字视为完整实体。

表8 实体标注结果Table 8 Entity labeling results

综上所示,若领域内没有公开用于评测的数据集,则同领域内不同方法的优劣很难在不同数据集上比较,误差可能出现在:

(1)实体标注种类和数目的不同。

(2)评价指标在计算实现上的不同。

3 中文领域命名实体识别技术发展

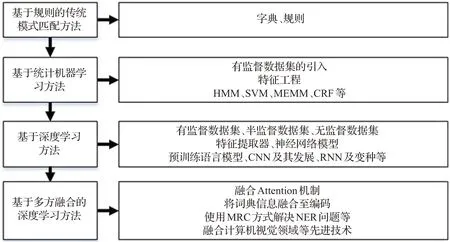

DNER技术依赖于NER技术的发展。NER从基于词典、规则的模式匹配方法,到统计机器学习方法、深度学习神经网络方法,再到基于融合其他研究方向先进技术的思想,如应用计算机视觉(Computer Vision,CV)领域取得成功的图神经网络,或NLP另一个子任务“机器翻译”提出的Attention机制,NER技术发展路线如图5所示。

图5 NER技术发展路线Fig.5 Technical development route of NER

3.1 基于词典和规则的模式匹配方法

模式匹配方法应用最早,也被称作NER专家系统方法(Expert System,ES)。ES要求包含专业最高水平知识,提取专家知识并将其转换为规则形式。基于词典和规则的模式匹配方法需要领域专家由语法规则等构造大量的规则模板,符合ES知识获取的定义。

模式匹配方法包括:

(1)维护一个数量大且全的词典,如鉴于少数民族人名特点,有学者构建了维吾尔语人名数据词典进行维吾尔语NER[28],若文本中有实体未被词典收录,则手动录入词典以供下一次识别。

(2)在词典基础上,增加实体的构造规则,据此提取实体。典型的规则[1]包括关键词、位置词、中心词等元素。如中文译名NER[29]利用普通人名的构成规律——全称如[姓+名],代称如[姓+职位]、[老(小)+姓]等模式进行识别;化学物质NER利用化学物质的构成模式——化学介词+化学词头+化学符号[30],使用正则表达式进行化学物质名称提取。

基于模式匹配方法的NLP系统如University of Sheffield NLP开发的NLP框架GATE[31],有着清晰 的NER规范。GATE下的JAPE组件是一种专属于GATE的模式匹配语言,编写语法与正则表达式相似,由实体在文本中的特征来确定构造规则。不同的构造规则会产生冲突,如[武汉市长江大桥]能被分成[武汉市长|江大桥]或[武汉市|长江大桥]等两种合乎语法规范的实体,此时主要使用基于前向匹配或后向匹配或两者结合的算法[32]来解决此类冲突。亦可借鉴英文词干算法原理[33],统计实体出现的频率作为实体分割优先级的依据,缺点是不易变通。

模式匹配方法准确率高,但众多实体识别规则的制定依赖领域专家,领域间基本无复用。此外,领域词典需定期维护,不断涌现的新实体与实体的不规则性使得难以构造完备的词典。即使存在缺点,模式匹配方法依旧被应用,因为某些领域实体的规则可以被穷举95%以上,规则仍是提取裁判文书部分实体[17]的首选,同时在之后的机器学习、深度学习NER模型中加入规则和字典能够提高准确率。

3.2 基于统计机器学习的方法

统计机器学习时代,NER的发展基于大规模有标注语料库(监督数据集)的出现,从编制全面的不易变通的规则系统到期待机器通过大规模语料库的训练自动识别语言规律。语料库中的语言学知识体现在用特征模板来解释实体上下文的特征,使机器理解实体周围成分的含义,这称为特征提取,目的是为了提高统计模型的准确率。

文本特征是指将文本的特点转换成数值[32]。针对中国人名识别和性别判断问题[32],特征定为名字中是否包含某个特征字,并将名字用特征表示。如“余秋雨”是一位男性作家,名字由“秋”“雨”组成,但许多女性名字中包含了“雨”字,此时无法直接通过“雨”字判断性别,因此将名字表示为多个特征字的组合,从而让机器通过大量语料来学习。特征的种类不定,数量不定,若将中国人名的特征字增加到5个,如表9所示,人名中的单字都从特征字中选取,则“余秋雨”可表示为5维向量[1,1,0,0,0]后再输入机器学习模型。当特征条件包括了所有常用汉字后,就可以给常见人名向量化的特征表示。

表9 特征模板Table 9 Characteristics of template

特征模板用来自动化提取特征,挑选特征并设计特征模板的过程是特征工程[32]。统计机器学习的NER的关键在于特征选取,这些特征来自于反映某类实体特性的特征集合。特征集合通过统计分析训练语料反映了待提取实体的特性,包括具体的汉字特征、上下文特征、词典及词性特征等[34]。有学者[35]为实体设计了包含只考虑单元素原子特征模板和多原子特征模板结合的组合特征模板的特征工程,并通过原子特征模板的加入顺序验证了特征模板的有效性,得出特征模板并非越多越好的结论。有学者提出在训练时应优先选择贡献度大的特征[36],并证明组合特征模板可以提升系统的性能。同时一些外部资源如分词结果[7]、外部知识库如知网[37]也被当作特征录入特征集合中。

随着将标注语料集和选定的特征模板输入到隐马尔科夫模型[38](Hidden Markov Model,HMM)、最大熵[39](Maximum Entropy,ME)、支持向量机[40](Support Vector Machine,SVM)、决策树[29](Decision Tree,DT)、条件随机场[36](Conditional Random Fields,CRF)等统计机器学习模型中,NER作为序列标注任务的属性被固定下来,即通过预测文本中的每个字的标签判断其是否为一个实体。

上述机器模型各有所长,HMM作为概率图模型以发射概率、隐藏概率、初始概率对应了中文人名识别的角色标注[4]问题,使用viterbi算法找到最佳标记序。ME在给定数据集上选择一个模型使未知结果的分布尽可能与现有分布实现一致均匀分布。CRF作为生成图模型,吸收了ME综合有效语言信息的优点,不依附于HMM严格的独立性假设,并排除了其他非生成图模型的标记偏置缺点,逐渐成为DNER应用的主要模型。针对上述优缺点,有学者利用模型改进思想,利用层叠CRF进行旅游领域NER[41]。汉语词法分析系统ICTCLAs采用层叠HMM[4]去识别三大类基本实体,底层实体识别的结果为高层实体识别提供特征。

统计机器学习的NER受限于高质量的大规模标注语料库以及对丰富的、不畏惧语料变迁挑战的特征模板的需要,构建特征模板开销巨大但准确率会相应提高,因此在后续NER发展中,特征工程的保留也可助力实体识别。

3.3 基于深度学习的方法

深度学习提供了代替复杂庞大的特征工程的解决方案,让机器自动找出潜在的特征模板集合。End-to-End解决问题的思路是将数据输入模型,由模型得到结果,第一步是如何更好地表示文本。

3.3.1词向量与预训练语言模型发展

文本中的词语最初表示为one-hot编码向量,即仅以该词在词典中的位置作为代表词语的向量,受制于词典的覆盖能力,也无法表示词语之间的联系。将文本表示成机器能理解的向量而非简单的数字组合,是词向量相对于one-hot编码所做的贡献。

CV领域利用神经网络从图像里提取特征的思路被NLP借鉴。神经网络语言模型[42](Neural Network Language Model,NNLM)被用来训练词向量,目的是通过无监督训练方法得到合理存在的语句。Word2vec[43]是NNLM后提出的词向量训练方式,包括两种训练步骤,分别是根据中心词推理上下文窗口内单词的skip-gram和根据上下文窗口推理中心词的CBOW。GloVe[44]克服Word2vec只能看到窗口内上下文信息的缺点,由词向量共现理论通过矩阵分解利用了全局信息。GloVe和Word2vec根据后续任务的不同而各有优势,如有学者[40]指出GloVe训练出的词向量后接SVM效果更好。

文本词向量表示后,神经网络被用来提取向量化的文本特征。CV领域的卷积神经网络(Convolutional Neural Network,CNN)被最早应用于NER[45],提取句子级别的特征。CNN卷积运算与文本序列输入的特征不符,具有时间序列特征的循环神经网络(Recurrent Neural Network,RNN)被用于深层次的语义特征提取,为了使未来的状态也能预测当前时刻的输出,双向RNN如BI-LSTM[46]、BI-GRU[47]被提出。RNN的训练速度受限于其时间序列性,CNN模型卷积核权值共享可降低计算复杂度、多卷积核可并行计算的优点被重新重视。有学者[46]提出了空洞迭代卷积神经网络进行特征提取,通过叠加CNN扩大模型的感受野,提高模型的训练和预测速度。提取特征后的文本输入至解码网络得到最佳预测标签序列。

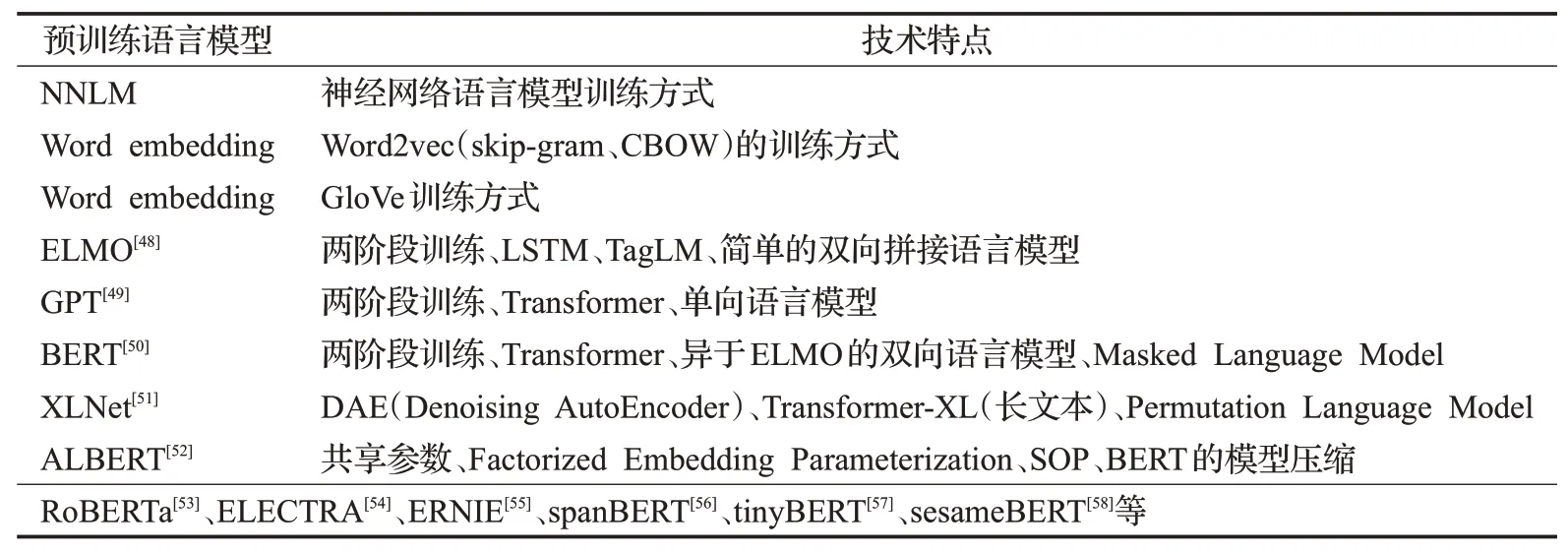

如表10所示,一系列预训练语言模型(Pre-trained Language Model,PLM)的产生使得Word2vec和GloVe这两种词向量被称作静态词向量,无法解决一词多义现象,训练结果是一个固定的词向量矩阵,不能被动态修改,也就无法真正理解文本语义。PLM通过两阶段来训练词向量,首先使用NNLM来训练,然后根据下游任务进行微调。ELMO为了达到更好的效果,在第一阶段使用BILSTM作为特征提取器提取双向文本信息;GPT则采用Transformer特征提取器[59]提取单向文本信息,Transformer特征抽取器在机器翻译任务上效果显著,训练的词向量可以解决一词多义;BERT使用Transformer提取双向文本特征,并采用CBOW方式训练双向语言模型,通过MLM训练方式随机去除文本中的一些实体去训练语言模型,使得训练效果显著高于GPT。

表10 文本向量化表示的发展Table 10 Development of textual vectorization

BERT的出色表现使一些学者开始思考如何降低BERT训练所需的资源而达到同样效果,因此RoBERTa[53]、AlBERT[52]、TinyBERT[57]、SpanBERT[56]等PLM被相继提出。BERT类模型的输入长度偏短,在生成式任务如文本摘要上表现不佳,因此XLNet[51]提出了自回归语言模型和自编码语言模型来贴合生成式文本规律,并应用Transformer-XL解决长文本特征提取问题。百度提出了ERNIE[55]模型专门训练中文的词向量,GPT模型也已经发展到了GPT-3[60]。

3.3.2深度学习模型解决NER问题架构

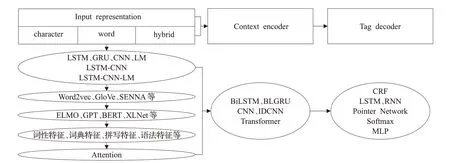

PLM动态训练词向量使文本获得更好的向量化表示,进而利用特征提取器提取文本特征,再通过解码器获得预测的序列标签,具体如下:

(1)对输入文本基于静态词向量或者动态的PLM进行向量化表示(Input Representation,IR),具体分为基于字(character)或单词(word)的方式,或融合两种方式的信息(hybrid)进行向量化。IR阶段需要有效地融合词和字的信息[61],还可辅助以统计机器学习方法使用的特征工程。

(2)文本编码层(Context Encoder,CE)或序列建模层,对于IR阶段输出的向量化文本采用特征提取器进一步提取文本特征。

(3)标签解码层(Tag Decoder,TD),将CE层输出的向量输入解码网络得到最佳序列标签。

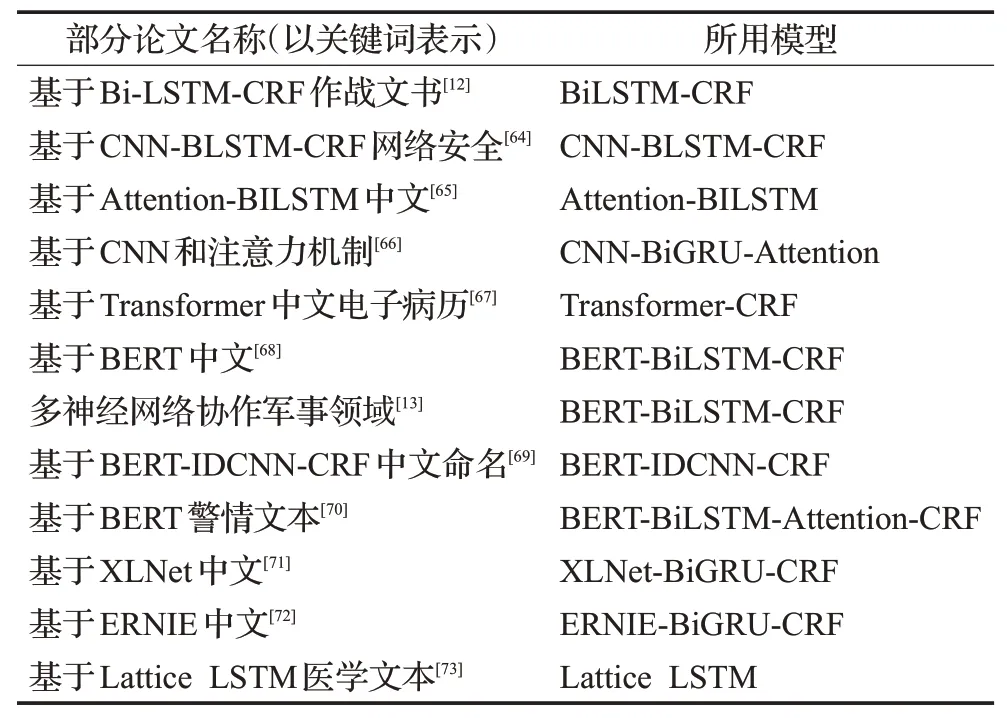

图6 展示了根据领域文本特征选择不同的文本向量化方法与特征提取器的组合。Word2vec-BILSTMCRF[62]的组合取得了当时英文NER最佳的效果,之后被应用到中文NER中,深度学习时代BERT-BILSTM-CRF的组合[63]也成为了性能提升时的参照。表11列出的论文标题展示了DNER的研究趋势,符合图6的深度学习模型架构。深度学习准确率高,但仍需要大规模的标注数据集和高资源的算力,PLM的应用对于小模型的训练是一种负担。

图6 深度学习模型解决NER架构Fig.6 Architecture of deep learning models to solve NER

表11 基于深度学习的论文标题Table 11 Titles of paper based on deep learning

3.4 基于多方融合的深度学习方法

一些NLP书籍[74]将分词放在NER章节前,产生一种先分词再进行NER的认识,但这两个任务并非严格的前驱后继关系。有学者将这两个任务都看成序列标注问题,采用相同模型[61]进行训练,同时提高两个任务的准确率,这是多任务方法解决NER的应用。多任务也被用于关系抽取,先进行NER,将NER识别结果输入关系抽取模型是关系抽取的pipeline方法[75]。

有学者[75]提出阅读理解式的解决方案,将实体规范编码成问题代入模型查找实体,在部分数据集上取得了较好效果。有学者[76]提出利用词典信息的深度学习NER框架,具有更高的准确率,不同于模式匹配方法中词典信息的利用方式——将文本与词典碰撞,若存在该词语就以触发词的方式进行识别,这样会存在一些规则冲突问题。此处是在对输入文本进行编码时,将词典信息作为特征融入到输入表示中,形成Lattice结构[76]或使用基本图网络[77]、多维图网络[78]来融合词典信息。为了避免对CE层进行繁琐的设计,保持CE层继续使用BiLSTM,有学者[21]提出了soft-lexicon,通过设计IR层来利用词典中的所有词。在此基础上FLAT结构[79]被提出,为lattice中的每一个字再编码其所属词中对应的位置信息。

3.5 中文领域命名实体识别技术框架

图7 给出了DNER的技术解决框架。首先根据领域获得的数据集规模及实体规律性选择使用机器学习方法或模式匹配方法;在大数据集前提下,根据工程量确定是否使用特征工程,特征工程与HMM、SVM等机器学习模型联合使用;若不使用特征工程,则利用神经网络训练词向量或PLM,领域内已训练的词向量可以被微调复用;深度学习时代的NER没有摒弃规则或者特征工程等方法,在将词典信息融合至模型的过程中,还可应用Attention机制[80]、图神经网络[77]、迁移学习[81]等其他领域的新技术。

图7 领域NER解决框架Fig.7 Domain NER solution framework

4 中文领域命名实体识别发展

4.1 应用发展

DNER系列研究体现了NER既是信息抽取的重要子任务,也是业务文本结构化的基本步骤这两大特点,DNER有助于完成以下工作:

(1)构建领域高质量标注语料库

目前研究集中在有监督数据领域的学习,CLUENER语料[9]构建过程中提到了机器训练的样本数多于人类,是人类表现不如机器理解样本标签含义从而表现不佳的理由之一。深度学习需要质量高的标注数据集,DNER的研究必然会为领域贡献一部分语料知识,如何整合语料促进语料融合,从而实现技术迁移是当前DNER的研究趋势。同属领域的不同研究因受限于业务的细节,从而决定了在制定规范时实体类型和数量的差异,造成子业务提取指标增加的同时迁移能力减弱。因此在DNER研究之初,需要构思数据集及标注规范问题,这也是不可避免的步骤。制定优秀强壮的标注规范,借鉴该领域前人的标注规范,或是触类旁通与子任务相近领域的实体制定规范,充分利用有限的语料,能够为NER后续任务提供帮助。

(2)能够构建领域知识库

涉恐DNER是为了我国网络恐怖信息数据库而构建[82],因我国目前还没有自己的网络恐怖信息数据库。随着在本体概念上构建知识库的观念的回归,在领域本体架构下,通过DNER方法提取本体架构中的各项实例并录入数据库中是可选择的途径。知识库涉及的内容庞杂,但其基础属性是由本体的基本单元所构成,随着NER技术的成熟,新涌现实体被识别并被自动添加到现有知识库中,文本中的关键信息也能被挖掘。在反恐领域,恐怖组织的准确识别能够为恐怖形势的研判提供帮助,可以通过关联恐怖组织周围实体关注动态,此外通过提取的反恐领域实体内在地构成了反恐事件的框架,因反恐实体标签在定义时就内化了一层与事件的语义关系信息。一些公司将知识库应用于搜索查询任务,并通过知识库构建相关比赛促进了NER的发展。

(3)能够构建领域知识图谱

与构建知识库的原理相似,知识图谱更关注于智能问答,林业领域植物知识图谱[83]的构建是为了林业病虫害研究,影视知识图谱[84]的构建是为了展示作品与影视行业工作人员、影视公司之间的关系。知识图谱中所包含的基本单元就是有意义的实体,而知识库包含实体及实体附加的其他属性。从实体流转到知识库再到知识图谱是被认可的路径。知识图谱构建技术不仅在于NER技术的提升,也需要其他NLP子任务的协助,如关系抽取、实体链接技术等,这也是多任务进行NER的基本目标,通过训练同一模型在节约训练资源的同时提高多重任务的效率。

4.2 研究热点

NER的发展汲取了不同阶段的优点,体现在模式匹配方法仍然可以应用在实体规律性强的领域,如司法领域提取裁判文书中某些实体的规则可以被穷举90%,以及词典信息也在更好地融入深度模型架构;统计机器学习方法提出的特征工程的概念也辅助应用于深度学习模型框架,选取分词、上下文等特征对输入信息进行编码,从而提取一些固定模板无法提取的特征;深度学习End-to-End的特性通过改变神经网络架构捕捉隐含文本信息,提高准确率却耗费算力。根据NER不同发展阶段的特点,列举如下研究热点:

(1)高质量领域数据集的获取。当前领域NER数据语料缺乏,开展一类新的DNER的首要步骤是领域数据集的构建。标注资源匮乏会导致大型深度学习模型无法有效部署和训练,有标注的高质量的监督数据集一定能为深度学习助力。在资源限制条件下,需采取其他方法来扩大领域数据集。国内对于无监督领域的学习较国外少[85],自学习算法[86]和主动学习[86]分别是两种利用半监督学习(少量标注样本)和无监督学习(大量未标注样本)的算法,其概念来源于CV领域,但这两种方式并未完全解决标注资源紧缺带来的困难。自学习算法会挑选出与初始部分样本较相近的样本,则模型学习到新的信息速度变慢,还会有标注错误的累积问题。主动学习算法依然通过人力来审查每轮的新标注样本,相当于减少了人工标注量,但可能会忽略含有其他丰富信息的样本。

(2)促进现有领域语料库的融合以实现技术迁移。由于目前一些DNER的研究并非使用了统一语料库,采用了相同的实体制定规范,这对于大规模语料库的构建提出了难题,已被训练过的资源无法得到有效扩展,无法做到资源共享,这从实体的规范制定和标注工程两方面对DNER提出了要求。

(3)DNER通用实现框架的构建。在3.3.2节中探讨了DNER对于通用NER技术的应用可行性,说明了一种深度学习时代DNER研究的一般模式,如使用PLM/Word Embedding-Encoder-Decoder(预训练语言模型或词向量-文本编码-解码)的模式。由于不同领域实体类型分布及标注规范不同,在不考虑以上差异前提下,论证特定领域NER是否可以采用一种通用方法识别各领域不同类型的实体,表11列出题目中的技术正在应用这一模式。除此之外,新模式的尝试需要各领域的反复实践以验证,通用方法的成熟会使得表2中部分领域DNER的产出速度加快。

(4)基于多方融合的深度学习时代NER技术的提高。首先是多任务进行NER的思想,DNER为下游任务提供所需实体,如准确的DNER是主题词发现技术的基础,有助于实现领域更友好的分词,有助于关系抽取中对于实体的准确定位等,多任务的共同提高能够节约训练资源。其次是将Attention机制、图神经网络、迁移学习思想等技术与现有NER模型架构融合,分别对主体架构的某些侧面进行改进,及时记录结构的改进带来效果的正负反馈。

本文从中文领域命名实体的概念开始,介绍了开展中文领域命名实体识别研究的所需基础条件,如数据集的获取和实体规范的确立,以及所需研究框架,如从模式匹配方法至深度学习方法,由于神经网络在深度学习中表现出色,着重介绍了深度学习时代从文本向量化到实体提取所需的一些模型。NER对于NLP领域重要性同样体现在中文DNER的发展促进工业场景化NLP任务的提高。目前研究热点和难点集中在多方融合技术促进实体提取方法的改进与已有研究资源的集合上,DNER的自动化发现新实体的功能能够让人们自动地监视网络中指数式增长的信息,缓解人力资源的配置。NER技术不断推陈出新,促进非结构化文本的有效信息自动结构化。