铁路基础设施检测数据综合治理技术研究

郭剑峰,刘金朝,陶凯,代春平,高佳佳,张川

(中国铁道科学研究院集团有限公司基础设施检测研究所,北京 100081)

0 引言

随着信息技术的飞速发展与业务数据的不断积累,国内外各行各业在数据应用之前都面临着对数据进行综合治理的实际问题。近年来,数据成为一种无形资产的概念逐渐深入人心,数据综合治理和数据资产管理的重要性也愈发凸显。

国内外诸多学者研究了数据综合治理技术,并将这种技术应用在对铁路基础设施检测数据的综合治理过程中。1995年,新西兰怀卡托大学的Garner等[1]开发了怀卡托智能分析环境(Waikato Environment for Knowledge Analysis),研发了首个JAVA环境下的开源数据挖掘软件,具有简单的数据治理功能,可以实现数据清洗、集成、规约、变换等基本功能。1998年,美国IBM公司研发了IBM Intelligent Miner工具[2],支持对商业数据的清洗、统计挖掘和关联分析等数据处理功能,利用模糊逻辑和神经网络技术处理原始数据中的不规范表达式等问题,使用数据的前后逻辑关系进行推理,自动填补数据中的缺失值。2005—2010年,美国谷歌公司先后研发了 Google Sawzall[3]、Google Dremel[4]和Google Flume Java[5]等工具,实现了对PB级海量结构化数据的快速查询统计、数据格式转化和数据清洗等治理功能,借助于Hadoop大数据分布式系统架构,支持简单的并行计算,形成了一系列的通用数据治理工具。利用这些交互式的通用数据治理工具,可以组建成规模上千的集群,对PB级的海量数据快速治理。

上述通用数据治理工具存在数据治理手段较为简单、对数据各个维度之间的关联关系和每一个维度时间序列的历史变化等关系处理不足等缺点,导致了通用数据治理工具对专业数据治理的操作能力不足。

在铁路基础设施检测数据综合治理技术研究方面,国内外诸多学者将上述通用数据治理思想引入到铁路基础设施检测数据综合治理问题的研究中。徐鹏[6]提出轨检车检测数据里程偏差修正的数据治理方法,利用阈值处理、地图匹配、相关分析和动态规划等技术建立了一个修正轨检车检测数据里程与线路设备里程之间偏差的模型,初步解决了对轨检车轨道几何检测数据的里程治理问题。许贵阳等[7-8]基于相关系数最大化,提出对检测数据里程自动修正的数据治理方法,并通过对高速铁路大量实测数据的处理验证了方法的有效性和实用性。王同军[9]分析了我国铁路在大数据时代面临的数据治理手段缺乏等问题,提出中国铁路大数据应用顶层设计。Karakose等[10]提出接触网检测数据中网压和网流数据的治理方法,通过对网流数据低通滤波消除网流数据中的高频噪声,并在一定频率范围内取这些数据的绝对值确定无噪声数据的峰值,利用峰值对数据归一化,之后使用线性插值方法将这些点组合得到一个新的数据,利用生成的新数据对受电弓拉弧进行准确检测。秦航远等[11]提出里程偏差二次修正的检测数据治理方法,使用五点迭代法提高参考里程与待校准里程相关性分析的计算效率。武威等[12]研究了高铁运营安全规律分析数据的治理及应用方法,构建了面向高铁运营安全规律分析的数据治理架构。

虽然上述专业的铁路基础设施检测数据治理技术可以解决一些问题,但我国在铁路基础设施检测数据综合治理方面仍面临着各专业单独发展、缺少统一综合治理技术规划和标准等问题。数据综合治理包含很多内容,从数据智能清洗到数据评估模型,企业数据的综合治理越来越受到重视。因此,亟需研究一套完整的铁路基础设施检测数据综合治理技术。

1 总体技术路线

铁路基础设施检测数据综合治理总体技术路线见图1,包括数据预处理、里程修正、无效识别和质量评估4个部分。在数据预处理部分研究了基于台账信息的基准文件自动生成技术;在里程修正部分研究了基于最大相关系数的多次检测数据里程自动对准技术;在无效识别部分研究了基于人工智能的无效数据智能检测技术;在质量评估部分分别研究了数据的完整性、有效性和一致性评估技术。

图1 铁路基础设施检测数据综合治理总体技术路线

2 数据预处理

在数据预处理过程中,首先要基于线路的台账信息自动生成检测数据的基准文件。因为现有的铁路基础设施检测数据治理过程中,首先需要人工配置一个基准文件,用于后续对检测数据的里程修正。人工配置基准文件的工作量较大,并且不能根据台账的变化自动更新基准文件。人工配置基准文件的准确性与操作人员的经验水平等因素密切相关,因此配置结果具有较大的个体化差异,无法建立统一的配置标准。人工配置的基准文件见图2。

图2 人工配置基准文件

人工配置基准文件时,需要逐一手动添加索引点,例如图中需要根据线路的曲线台账信息,结合超高通道的波形变化情况,人工将检测数据中的1 611.840检测点里程修正为1 611.844。当人工配置的基准文件不够准确时,后续数据治理算法可能不会得到满意的治理结果,可见后续数据治理算法对基准文件的依赖性较强。若能基于台账信息自动生成检测数据基准文件,可有效解决人工配置基准文件效率较低、标准不统一和配置差异性较大等问题。

为解决上述问题,研究了基于台账信息的基准文件自动生成技术。人工配置基准文件时,通常基于台账中的曲线信息,结合检测数据的超高信息,手动寻找对应的索引点。基于台账信息的检测数据基准文件自动生成技术通过将检测数据的超高通道与曲线台账信息使用5点迭代法寻找最佳匹配点[10],再对匹配后的数据做插值处理,从而实现对基准文件的自动生成预处理。

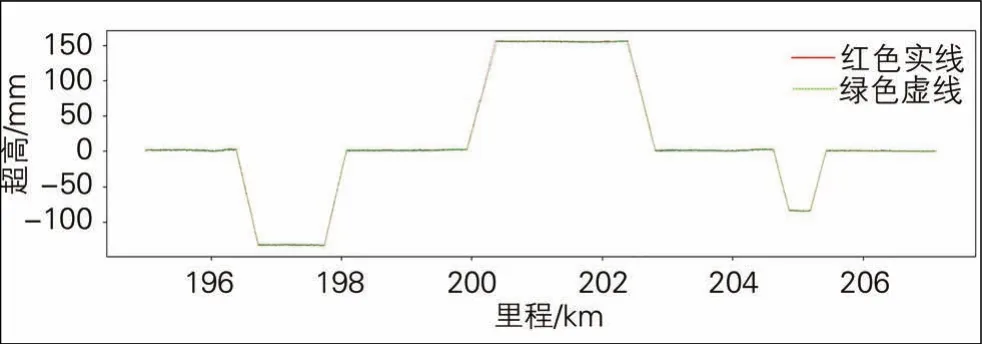

某高速铁路的曲线台账信息自动生成的检测数据基准文件示意见图3。

图3 基于台账自动生成的检测数据基准文件示意图

图中红色实线为台账的原始信息,绿色虚线为自动生成的基准文件,两线高度重合,基准文件包含自动获得的超高通道里程信息。

基于台账信息的检测数据基准文件自动生成技术可彻底解决人工配置基准文件效率低和差异性大等问题,不仅提高了配置基准文件的工作效率,且具有较高的配置精度和配置结果唯一性。

3 多次检测数据里程自动对准技术

由于检测车在不同时期运行过程中会产生一定范围内的里程偏差,因此对于同一条铁路线路不同时期采集的多次检测数据,通常存在着一定范围的里程偏差(见图4)。

图4 多次检测数据里程偏差示意图

对多次不同时期采集的检测数据进行里程修正是开展数据分析工作的前提,准确的里程信息可以辅助养护维修人员快速、准确地定位病害所在位置,此外还可辅助数据分析人员利用多次检测数据对比分析轨道几何状态变化趋势、利用大数据技术深度挖掘数据价值等研究工作。

3.1 算法实现

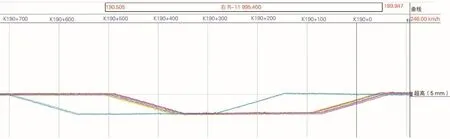

多次检测数据里程自动对准技术的总体流程见图5。主要包括自动生成基准文件、定时获取数据、里程重构、里程校正、断链里程调整和校正效果评价6个部分。

图5 多次检测数据里程自动对准技术总体流程

基于相关系数最大化原理,提出一种更加稳健的多次检测数据里程自动对准算法。使用轨距、超高、左右高低等通道,计算多次检测数据各通道对应的相关系数。设基准文件片段x有m个数据点,目标文件片段y有n个数据点,考虑到多次检测数据的里程误差,通常建议m≥800,n≥4m,则相关系数r的计算方法为:

式中:r(k)为第k次比较得到的相关系数;i为数据片段中的第i个数据点;k为比较次数;x(i)为基准文件片段中第i个数据点的值;y(i)为目标文件片段中第i个数据点的值;为基准文件片段的平均值;为目标文件片段的平均值。

计算得到相关系数后,寻找最大相关系数所在位置。为提升算法的稳健性,由于数据中存在着无效数据的干扰,会导致在计算过程中出现各通道的最大相关系数位置差异较大。基于异常检测技术,将差异较大的通道进行剔除,从而减少对里程修正结果的干扰,确保了算法的稳健性。此外,测试结果表明该算法即使在未对检测数据中的无效区段进行预处理的情况下,仍可减少无效数据对里程修正算法的影响。

3.2 实验结果

利用上述基于最大相关系数的检测数据里程自动对准算法对某条高速铁路的多次实际轨道几何检测数据进行里程自动修正,实测结果见图6。

图6 里程修正前后超高通道对应波形

图6中所示为算法对超高通道里程修正结果,图6(b)上方红色曲线为根据线路曲线台账自动生成的基准文件超高数据,下方曲线为里程修正后的多次检测数据目标文件的超高数据。

基于最大相关系数的多次检测数据里程自动对准算法与目前已有检测数据里程自动修正算法相比,具有如下两方面的优势:

(1)准确性提高。通过对轨距、超高、左右高低等通道的相关匹配,可以准确找到基准文件中所有的里程修正点,提高了里程修正算法的准确性。使用新算法和传统算法对某高速铁路轨道几何检测数据进行里程修正时的计算结果比较见表1。

表1 两种算法计算结果比较 km

从表1中可见,在预设的10个修正点中,传统的里程修正算法未找到其中4个修正点,会导致后续里程校准工作在插值时整个区段的匹配精度降低。新算法能找到全部预设里程修正点,可更加准确地进行后续里程修正工作。

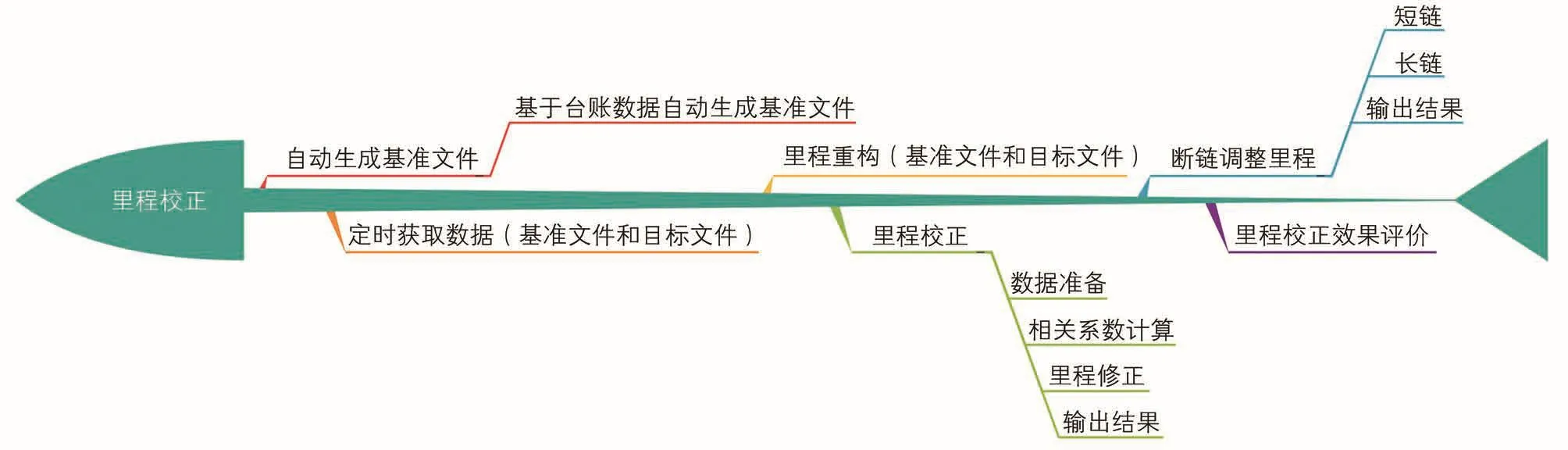

(2)计算效率提高。以不同线路长度的高速铁路实测轨道几何检测数据为例,分别使用传统算法和新算法对检测数据进行里程修正,计算时间对比见图7。

图7 算法计算时间对比

图7中所示的计算结果是利用Jupyter Notebook运行在Win10 64位操作系统、Intel Core i7处理器、8G RAM的实验环境下得到的结果。与已有算法相比,新算法在处理短线路时具有更高的计算效率。

4 基于人工智能的无效数据智能检测技术

由于在检测过程中,阳光、雨雪天气和电磁环境等因素会对传感器造成干扰,部分传感器可能会发生故障,因此铁路基础设施检测数据中通常存在部分无效数据。目前对这些无效数据识别通常采用特征提取方式,通过匹配无效特征来识别无效数据。随着人工智能技术的发展,深度学习为无效数据的智能检测提供了一条新的途径。传统的特征提取方法在一些特征明显的单通道数据无效识别上有较好的应用效果,但在对具有复杂特征和复合特征的无效数据上识别效果有待提高。此外,基于特征提取的单通道无效识别方式较难识别出多通道数据的复合无效。深度学习作为目前人工智能领域中有效的特征提取和分类手段,已被广泛应用到数据治理无效识别的实际工程问题中,并取得了较好的应用效果。

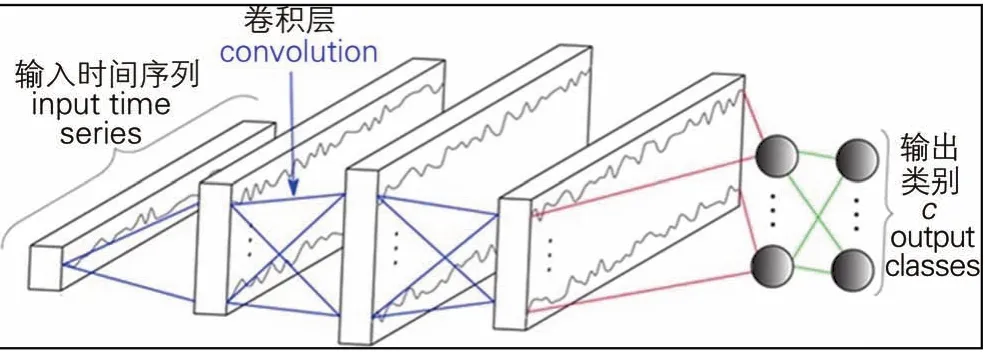

基于全卷积神经网络架构深度学习的无效数据智能检测技术,可根据输入的铁路基础设施检测数据自动识别数据中的无效区段,并输出相应的无效类型、判断为无效的概率和无效的里程范围。该全卷积神经网络架构见图8。

图8 全卷积神经网络架构

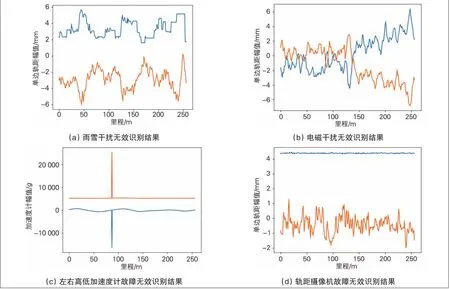

以多通道的轨道几何检测数据为例,使用图8中所示深层神经网络训练模型,以包含有效数据和无效数据的数据集作为输入,对这些输入数据进行切片处理,以256个测量点的多通道检测数据为一个片段,混合这些片段得到处理后的数据集,以其中80%的片段作为训练集,20%的片段作为测试集训练深层神经网络,对雨雪干扰、电磁干扰、左右高低加速度计故障、轨距摄像机故障引起的无效数据进行识别,结果见图9。

图9 基于人工智能的无效数据智能检测结果

5 检测数据质量自动评估技术

5.1 数据完整性评估

数据完整性通常指归集存储的检测数据的所有数据值均应处于完整的状态,如果数据中缺少了某些数据值,例如检测系统在死机重启后部分数据未正常采集,则该数据集丧失了部分完整性。由于铁路基础设施检测数据通常以一定的时间或空间采样频率进行采样,例如:轨道几何和接触网几何检测数据的空间采样频率通常为0.25 m,可结合线路的台账信息,估算出检测数据文件的样本数量,再与实际检测数据的样本量进行比较,定义阈值ε,一旦比较结果超过定义的阈值,则认为检测数据完整性缺失,并可量化评估检测数据的完整性。检测数据完整性评估示例见图10。

图10 不完整检测数据波形图

图中K37+400—K50+600区段,由于检测设备处于死机状态,造成了部分检测数据缺失。结合台账信息,该线路区段的实际检测里程应为496 km,其中缺失数据13.2 km,则可计算出该线路检测数据的完整性为97.34%。

5.2 数据有效性评估

数据完整性是对检测数据样本数量的定量评估方法,而数据有效性则是对检测数据样本质量的定量评估方法。利用人工智能的无效数据智能检测技术,可以自动获得某次检测数据中的无效区段列表,进而对检测数据的有效性进行量化评估。

例如对某条实际线路,首先利用基于人工智能的无效数据智能检测算法得到无效数据所在区段后,分别统计无效和有效区段的长度、检测数据长度、无效数据和有效数据占比,然后可进行数据有效性评估,结果见表2。

表2 数据有效性评估结果

从表2中可以看出,对于某条线路的某次检测数据,根据人工智能的无效数据智能检测技术识别出的无效区段结果,可以自动统计计算出该次检测数据的检测有效率,用于对数据的有效性进行量化评估。

5.3 数据一致性评估

经过里程修正处理后的铁路基础设施检测数据之间具有较好的数据一致性。已有的里程修正算法,仅能够从修正之后的图形效果上观察修正结果的准确性,因此里程修正效果评估受个人主观因素的影响较大,不仅不能直观反映数据的一致性,且不能准确地对修正算法做出评价。由于缺少数据一致性评估标准,需要设计数据一致性评估方法,从数值上量化评估数据的一致性。

在对多次检测数据一致性评估过程中,通过计算对比对准前后检测数据通道的平均误差值评估数据的一致性。由于不同检测数据样本数量存在差异,因此在计算平均误差值时不可逐点计算误差值,应通过两次检测数据曲线包围的区域计算每公里波形面积差值作为平均的误差值。对某高速铁路轨道几何检测数据一致性评估结果见图11。

图11 里程修正前后数据一致性对比

从图11中可以看出,与基准文件相比,里程修正后偏差减少,数据一致性提高。数据一致性评估方法的计算效率远高于逐点计算的效率,并且不影响评估结果的准确程度,因此可以量化评估数据的一致性。

6 结论与展望

围绕铁路基础设施检测数据中的里程偏差、无效数据和质量评估等共性数据管理问题,研究了一套铁路基础设施检测数据综合治理技术。在数据预处理阶段,首先基于台账信息自动生成基准文件,之后利用自动生成的基准文件基于最大相关系数原理实现多次检测数据里程自动对准,并利用人工智能深度学习研究检测数据的无效区段自动识别方法,最终初步实现对铁路基础设施检测数据完整性、有效性、一致性的质量评估目标。

数据的自动化和智能化处理是数据分析处理技术发展的趋势,目前铁路基础设施检测数据综合治理的研究仍处于起步阶段,自动化和智能化程度仍有待提高。伴随着大数据和人工智能等新技术的发展,未来铁路基础设施检测数据综合治理技术研究将借助大数据平台、云计算等手段,向高效、并行、智能的方向发展。