基于区域亮度自适应校正的茶叶嫩芽检测模型

吕 军,方梦瑞,姚 青,武传宇,贺盈磊,边 磊,钟小玉

基于区域亮度自适应校正的茶叶嫩芽检测模型

吕 军1,方梦瑞1,姚 青1※,武传宇2,贺盈磊2,边 磊3,钟小玉4

(1. 浙江理工大学信息学院,杭州 310018;2. 浙江理工大学机械与自动控制学院,杭州 310018;3. 中国农业科学院茶叶研究所,杭州 310008;4. 浙江茗皇天然食品开发股份有限公司,杭州 310030)

自然光照下不同时间采集的茶叶图像存在亮度不均的现象。由于高亮度图像对比度差且嫩芽特征显著性弱,造成高亮度图像中存在较多嫩芽的漏检。针对现有茶叶嫩芽图像自动检测方法对光照变化的敏感性,该研究提出一种基于区域亮度自适应校正的茶叶嫩芽检测模型。首先,对不同时间采集的龙井43茶叶图像进行灰度化;然后,计算灰度图的平均灰度(Average Gray,AG)值,对AG值在[170,230]的高亮度图像进行不同尺寸的分块处理和局部区域伽马亮度自适应校正;最后,在相同的训练集和测试集训练多个深度学习检测模型。测试结果表明,基于YOLOv5+CSPDarknet53的检测模型比SSD+VGG16、Faster RCNN+VGG16、YOLOv3+Darknet53和YOLOv4+CSPDarknet53模型具有更优的嫩芽检测性能,精确率和召回率分别为88.2%和82.1%。对YOLOv5检测结果进行检测抑制,有效避免了同一目标被多次框选的冗余现象。[30,90)和[90,170)亮度区间内嫩芽图像具有较强的显著性特征和较高的检测精度与召回率。相较于AG值在[170,230]的高亮度原始图像的检测结果,对高亮度图像进行2×3分块和局部区域亮度自适应校正后,YOLOv5嫩芽检测召回率提高了19.2个百分点。对不同光照条件下采集的茶叶图像进行测试,基于区域亮度自适应校正的茶叶嫩芽YOLOv5检测模型获得了92.4%的检测精度和90.4%的召回率。该模型对光照强度变化具有较强的鲁棒性,研究结果可为自然光照条件下茶叶嫩芽机械采摘作业提供参考。

机器视觉;目标检测;茶叶嫩芽;光照强度;分块;亮度自适应校正;YOLOv5

0 引 言

茶叶采摘是一项时效性、季节性很强的精细工作,采摘嫩芽的时间和嫩芽完整性直接影响成品茶的品质与价格[1]。目前中国茶叶采摘有人工采茶和机械采茶两种方式[2]。由于茶叶种植面积广,种植环境多变,茶叶生长具有不同步性,人工采茶存在劳动强度大、效率低和成本高等问题;机械采茶虽降低了经济成本和提高了工作效率,但对茶园环境要求较高,且缺乏对老叶与嫩芽的选择,给后期人工挑选与茶叶分拣增加了工作量[3]。因此,需要智能检测茶叶嫩芽,以满足依靠视觉引导的机器手进行智能采茶的需求。

随着机器视觉和人工智能技术的日臻成熟与不断应用,基于图像的嫩芽检测为茶叶智能采摘提供了理论基础。嫩芽智能检测一般分两种方法:一种是根据嫩芽呈现的特征进行图像分割,然后对嫩芽区域进行识别[4-6]。杨福增等[7]采集白色背景下“午子仙毫”茶叶图像,采用双阈值法对茶叶RGB图像的绿分量进行嫩芽“一心”部位的分割,嫩芽检测准确率为94%,但该分割方法受光照影响易产生偏差。Shao等[8]对茶叶嫩芽图像进行直方图均衡化后,对茶叶HSI图像的饱和度分量进行-means聚类,结果表明,聚类数值取3时获得较好的分割效果。姜苗苗等[9]利用小波变换对超绿、超红超绿之差、改进的超绿因子和颜色组合分量进行图像融合,根据嫩芽与背景的比例面积确定分割阈值,并对茶叶俯视图和侧视图进行分割试验,平均分割正确率为60.09%。自然环境下茶叶生长环境的复杂性和茶叶重叠、遮挡等增加了嫩芽分割难度,夏华鹍等[10]采用简易线性迭代聚类SLIC算法获取茶叶彩色合成图像的超像素块,利用阈值分割获得75.6%的平均分割精度,比对单一-分量阈值分割的平均分割精度提高了16.6%。毛腾跃等[11]利用显著性检测提高嫩芽与背景的对比度,结合GrabCut算法实现了嫩芽图像分割。针对不同长度的嫩芽识别,Karunasena等[12]提取正、负样本的方向梯度直方图特征,训练了Cascade分类器,对0~10 mm、>10~20 mm、>20~30 mm、>30~40 mm 4组长度嫩芽样本的平均识别率为55%。以上传统茶叶图像识别算法的精确率过于依赖茶叶图像特征提取的有效性,且受光照影响较大,算法普适性和鲁棒性较差。

另一种是基于深度学习的嫩芽检测[13-14]方法,该方法直接将茶叶图像作为输入,通过卷积层、池化层等网络结构学习茶叶更深层次的特征,有效避免了人工特征提取的弊端。王子钰等[15]比较了传统颜色分割和基于SSD、YOLOv3的茶叶嫩芽检测结果。结果发现,基于YOLOv3的嫩芽检测精度和耗时更适合茶叶智能采摘的要求。孙肖肖等[16]利用YOLOv3的13×13和26×26两个尺度进行嫩芽检测,平均检测精度达84.2%,但所研究的茶叶图像中仅包含1个或多个嫩芽区域,且嫩芽区域无遮挡。Yang等[17]通过金字塔结构获取不同尺度的茶叶特征图、下采样部分添加残差网络和输出端利用1×1卷积操作代替全连接的方式改进YOLOv3模型,平均检测精度达90%以上,但研究对象仅限单个嫩芽图像并且背景简单。在无遮挡情况下,Chen等[18]利用Faster RCNN实现了对TTES-8、TTES-18、CSO和SJC 4种茶叶的检测,并分析了上采样步长对全卷积网络FCN特征提取的影响。测试结果表明,对4种茶叶一芽两叶的平均检测精度为79.4%,采摘点定位平均准确率为84.91%,但此方法对高亮度图像和重叠较大的情况存在较多漏检。针对茶叶嫩芽生长姿态对检测结果的影响,Li等[19]按照一芽一叶图像中芽与叶是否有明显的角度分离进行分类标定,相较于标定单一姿态的检测结果,基于姿态分类的YOLOv3模型检测精度提高了1.9%,召回率提高了40.3%。基于深度学习的茶叶嫩芽检测方法在一定量训练样本基础上可以取得较好的检测效果,但嫩芽检测模型对光照强度变化的敏感性较差,难以满足自然条件下嫩芽机械智能采摘的工作需求。

自然环境下采集的茶叶图像质量受光照强度影响较大,严重制约了茶叶智能采摘模式的落地与实施,需要研究具有高鲁棒性和低光敏度的茶叶检测模型。本文利用区域亮度自适应校正和深度学习检测算法,研究不同光照条件下茶叶嫩芽的智能检测,以期为自然环境下茶叶机械智能采摘提供理论依据。

1 材料与方法

1.1 图像采集与预处理

利用数码相机(Canon EOS 200D II)采集自然光照条件下龙井43茶叶图像(图1),拍摄角度为30°~60°,拍摄距离为30~50 cm,图像大小为6 000×4 000像素,以jpg格式存储。拍摄时间为2020年和2021年的3月中旬至4月中旬8:00—17:00,共采集了7 660幅茶叶图像。所有茶叶图像采集于中国农业科学院茶叶研究所嵊州茶叶综合实验基地和杭州市茶叶科学研究所。

从正视图和侧视图捕获的一芽一叶嫩芽呈现出不同的姿态,为获得更好的检测结果,按一芽一叶嫩芽是否有明显角度分离进行分类标记,然后按照9∶1划分为训练集和测试集,便于后期的模型训练和测试。利用labelimg软件标记两类嫩芽,以Pascal VOC格式制作茶叶训练集,共78 953个样本。为了提高模型的鲁棒性,采用添加高斯噪声和水平镜像方法进行数据增强,增强后有236 859个训练样本,茶叶增强过程如图2所示。

1.2 茶叶图像区域亮度自适应校正

不同光照强度下,茶叶嫩芽与老叶之间的对比度直接影响嫩芽自动检测的结果。对茶叶图像进行亮度校正,改善嫩芽与老叶在图像中的对比度,使茶叶嫩芽特征具有强显著性,以降低嫩芽特征对光强变化的敏感性和提高嫩芽检测结果的鲁棒性。

1.2.1 茶叶图像亮度分析

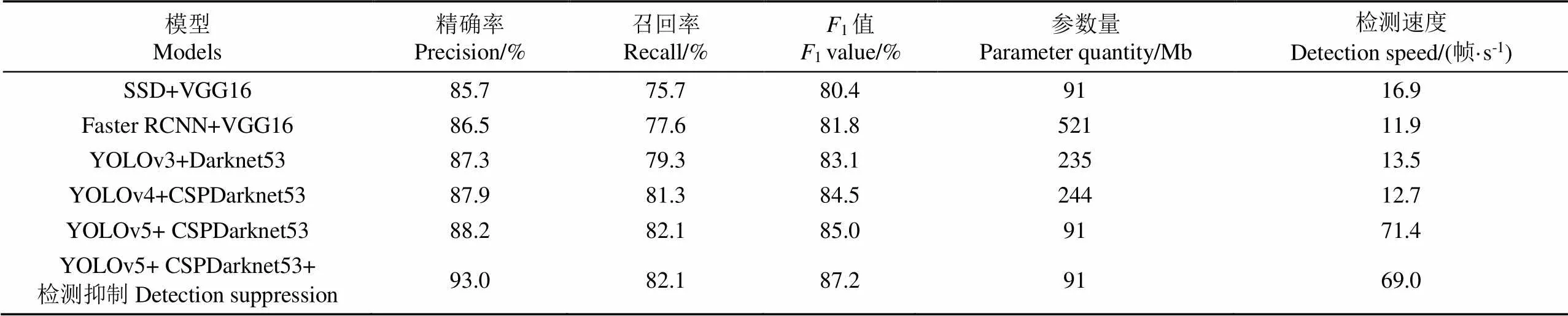

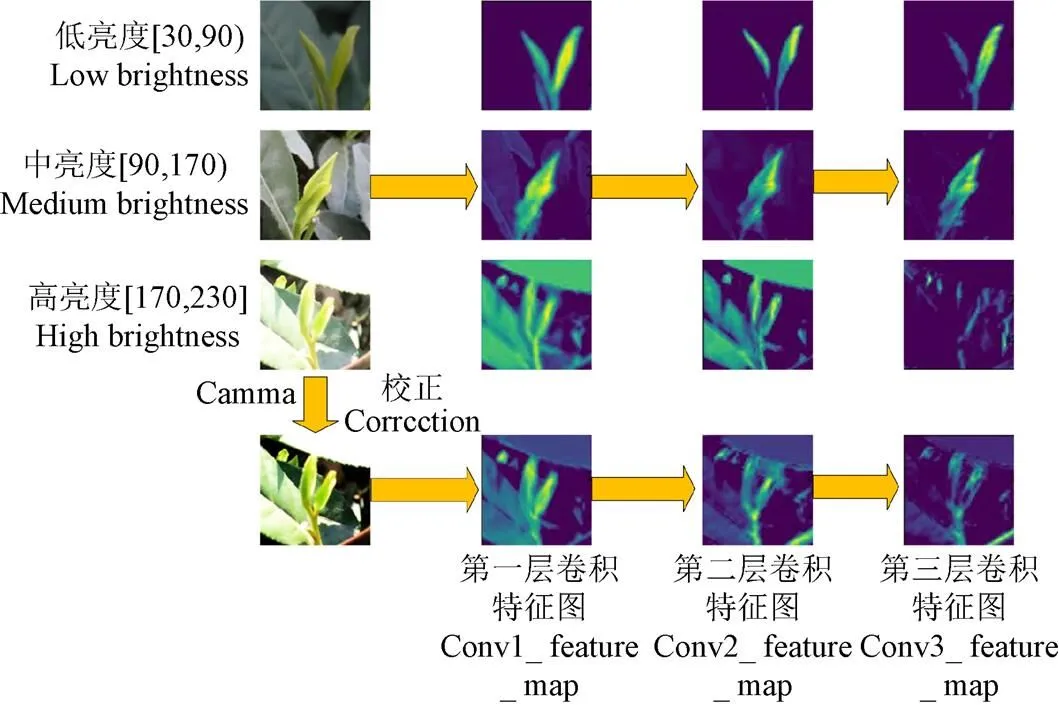

采用灰度图的平均灰度(Average Gray,AG)值表示图像亮度[20-21]信息。计算所有茶叶灰度图像的AG值发现,所采集的茶叶图像AG值全部集中在30~230。根据图像所呈现的明暗程度以及尽可能保证各亮度范围内样本量相对均衡,将茶叶图像AG值划分成[30,90)、[90,170)和[170,230] 3种灰度区间,分别表示低亮度、中亮度和高亮度图像,如图3所示。

1.2.2 Gamma亮度自适应校正

由图3c可以发现,高亮度茶叶图像整体泛白,嫩芽与老叶对比度差,且嫩芽颜色、纹理等特征显著性弱,易造成高亮度茶叶图像中嫩芽检测存在较多漏检。为提高嫩芽特征提取的有效性和降低嫩芽的漏检率,提出基于区域分块和伽马(Gamma)亮度自适应校正的图像增强方法[22]。在亮度自适应校正之前,利用区域分块的思想,充分考虑区域内特征的相似性和区域间特征的差异性,以提高区域自适应校正的有效性。将高亮度图像进行2×2、2×3和3×4分块处理,对每个区域块进行AG值提取,若区域AG值大于等于170,则对该区域进行Gamma亮度自适应校正,否则区域亮度保持不变。

2)构建两个自适应Gamma函数,分别对图像的高亮度和低亮度区域进行自适应校正。在高亮度区域自适应过程中通过对原始图像亮度值取倒数和对输出结果进行加权处理,以避免高亮度像素点无法校正和减小校正后图像亮度过低的问题。公式如下:

3)自然环境下光照不均匀,易出现非单一亮度图像,需要对上述校正后的图像进行自适应融合。利用校正后图像的标准差计算融合权重,计算公式如下:

4)采用亮度校正后图像的、、分量对图像进行色彩饱和度恢复,提高校正后图像色彩的视觉效果,公式如下:

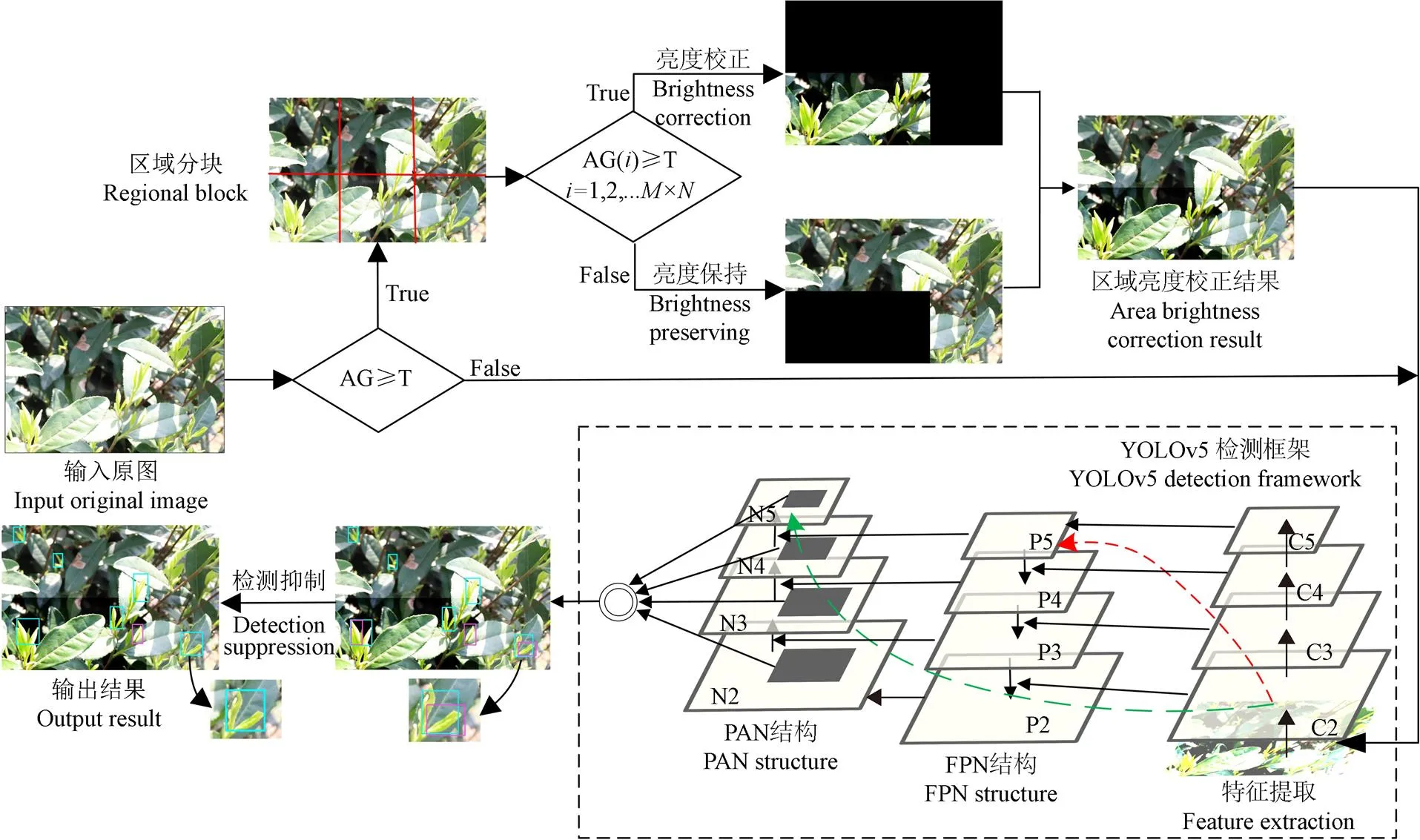

1.3 茶叶嫩芽YOLOv5检测模型

在常用的目标检测网络中,YOLOv5表现出较强的检测性能[24]。YOLOv5共有4个版本[25]:YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x,其中YOLOv5s模型的宽度和深度都是初始值,模型小速度快,适用于小型简单数据集的检测,其次是YOLOv5m,YOLOv5x模型的深度最深,适用于大型复杂数据集的检测。随着网络深度的加深,提升检测精度的同时也会降低检测速度。在保证检测精度的基础上,最大程度地提升检测速度,本文采用YOLOv5l作为嫩芽检测模型。该模型采用CSPDarknet53特征提取网络,将梯度变化集成在特征图中,有效提高了神经网络的学习能力,减少计算量的同时保持了较高的检测精度。采用特征金字塔网络[26](Feature Pyramid Networks,FPN)和路径聚合网络[27](Path Aggregation Networks,PAN)进行特征融合,缩短各层特征融合的路径,提高了学习效率,避免了低层特征信息的丢失。采用自适应锚框对图像特征进行预测,设定交并比为0.5和采用非极大值抑制剔除冗余预测框。

茶叶嫩芽姿态的多样性易造成检测结果存在同一目标被识别为同类多个目标或被识别成两类的问题。由图 4a可见,一芽两叶被检测为两个一芽一叶,图4b为“V”型嫩芽的一芽被识别成“I”型目标。通过对YOLOv5检测结果增加检测抑制,计算两个相交检测框重叠的面积,当重叠面积大于最小检测框面积的1/2时,剔除得分低的检测框,可有效减少同一目标被多次框选的影响。

基于区域亮度自适应校正的茶叶嫩芽YOLOv5检测模型如图5所示。图中C2~C5表示特征提取网络的卷积层输出;P2~P5表示特征金字塔FPN中第2级到第5级的特征层;N2~N5表示路径聚合网络PAN中第2级到第5级的特征层;红色虚线箭头表示FPN中浅层特征自底向上至顶层的长路径;绿色虚线箭头表示浅层特征自底向上至顶层的横向连接路径。

注:T为平均灰度值阈值;C2~C5为特征提取网络的卷积层输出;P2~P5为特征金字塔FPN中第2到第5级特征层;N2~N5为路径聚合网络PAN中第2级到第5级特征层;红色虚线箭头表示浅层特征自底向上至顶层的长路径;绿色虚线箭头表示浅层特征自底向上至顶层的横向连接路径;AG(i)为第i分块区域的平均灰度值。

1.4 模型评价方法

为了验证茶叶嫩芽YOLOv5检测模型的有效性,在同一训练集上训练了SSD[28]+VGG16[29]、Faster RCNN[30]+VGG16、YOLOv3[31]+Darknet53、YOLOv4+ CSPDarknet53、YOLOv5+CSPDarknet53和YOLOv5+ CSPDarknet53+检测抑制共6个模型。在同一测试集比较不同模型对嫩芽的检测效果。

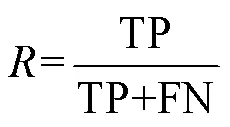

为了评价不同模型对嫩芽的检测效果,选择精确率(Precision,)、召回率(Recall,)、F[32]和PR曲线评价不同网络模型的检测效果。精确率和召回率的计算公式见式(7)和(8)。F是精确率和召回率的加权调和平均数,其中为加权调和系数,计算公式见式(9);当=1时,精确率和召回率占有相同权重,1值越大,表示模型的性能越好。

式中TP代表将嫩芽被正确识别的检测框数,FP代表将非嫩芽被识别为嫩芽的检测框数,FN代表嫩芽被识别为非嫩芽的检测框数,即嫩芽漏检数量。

1.5 模型的运行环境

计算机配置CPU型号为Intel(R) Core(TM) i7-9700 CPU @ 3.00GHz,GPU型号为NVIDIA GTX 2080Ti,内存为64 G,1 T固态硬盘。计算机操作系统为CentOS 7,配置darknet、Tensorflow2.0和PyTorch深度学习框架用于所有模型的训练和测试,图像亮度校正、数据增强、结果统计等程序均在Python语言环境下编制。

2 结果与分析

2.1 不同嫩芽检测模型的比较

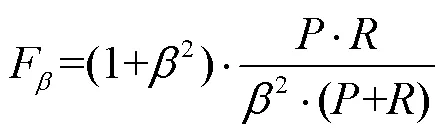

在未经分块和亮度校正的茶叶图像测试集上,测试不同检测模型对嫩芽检测的性能,结果如表1所示。由表1可知,检测精度和召回率由低到高分别为:SSD、Faster RCNN、YOLOv3、YOLOv4、YOLOv5;对YOLOv5模型检测结果进行检测框抑制后,检测精度提高了4.8个百分点。

在模型大小和检测速度上,YOLOv5与SSD模型大小相当,但YOLOv5检测速度为71.4帧/s,远远快于SSD模型的检测速度。YOLOv5模型小、速度快,便于移动平台和服务器的部署,适用于茶叶实时检测和机械采摘。

2.2 光照强度对模型的影响

2.2.1 不同光照强度对嫩芽特征提取的影响

为分析光照强度对嫩芽检测模型的影响,将不同光照强度下茶叶图像卷积特征图进行可视化,如图6所示。从特征图可以看出,中、低亮度的茶叶图像在前三层卷积特征图中,嫩芽特征清晰稳定,老叶特征随着网络层数提高有较明显的减弱。高亮度图像中老叶与嫩芽具有较高的相似性,嫩芽特征显著性较差,且随着网络层数增加,图像有效特征越弱,可见高亮度下茶叶图像不利于机器学习和检测,严重影响模型的检测性能。针对[170,230]区间内高亮度茶叶图像,采用Gamma亮度自适应校正进行图像对比度增强。由Gamma校正后的图像特征图可见,第一层卷积和第二层卷积特征图上虽存在老叶轮廓特征,但嫩芽信息显著性更强,且随着网络层数加深,老叶特征干扰减弱。因此,利用Gamma亮度校正对高亮度图像进行对比度增强,能够有效提高模型对高亮度图像的特征提取能力,提升模型的检测性能。

表1 六种检测模型的嫩芽检测结果

注:参数量表示模型的大小。 Note: The parameter quantity indicates the size of the model.

图6 不同光照强度下的茶叶图像特征图

2.2.2 亮度校正对嫩芽检测的影响

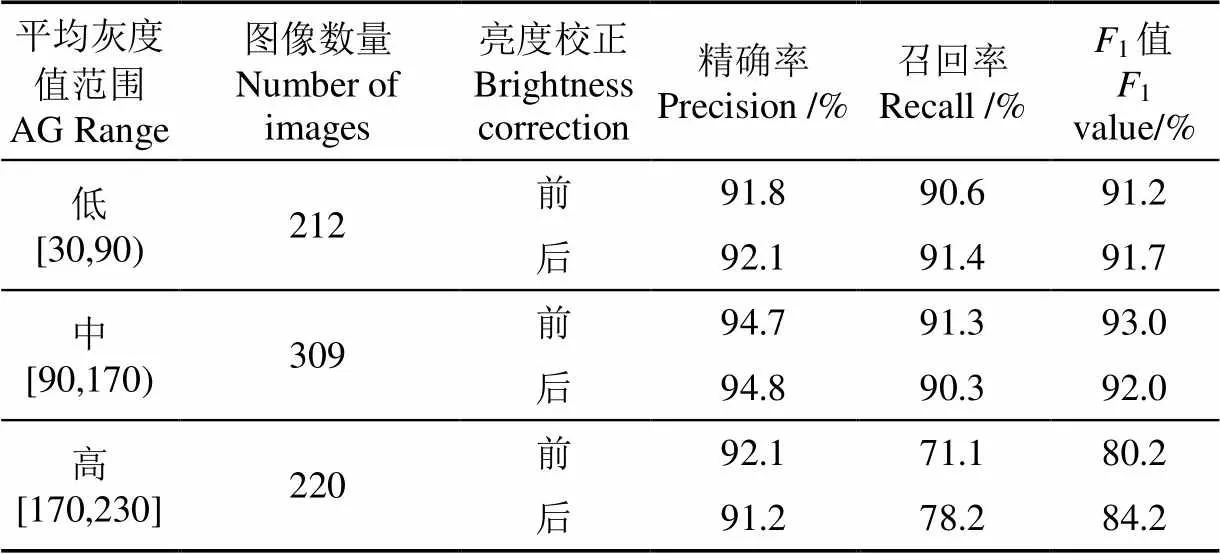

利用YOLOv5模型对3种亮度的原始图像和亮度校正后图像进行测试,检测结果如表2所示。针对低亮度和中亮度茶叶图像,亮度校正前后的模型检测精度和召回率均在91%左右,表明Gamma亮度自适应校正对中、低亮度图像的检测影响不大。高亮度图像嫩芽检测精度为92.1%,但检测召回率仅为71.1%,说明高亮度图像中存在较多嫩芽的漏检;经过Gamma亮度自适应校正后,召回率提高了7.1个百分点。结果表明,亮度自适应校正能够提高高亮度图像中嫩芽特征的显著性,改善嫩芽与老叶的对比度,降低漏检率。

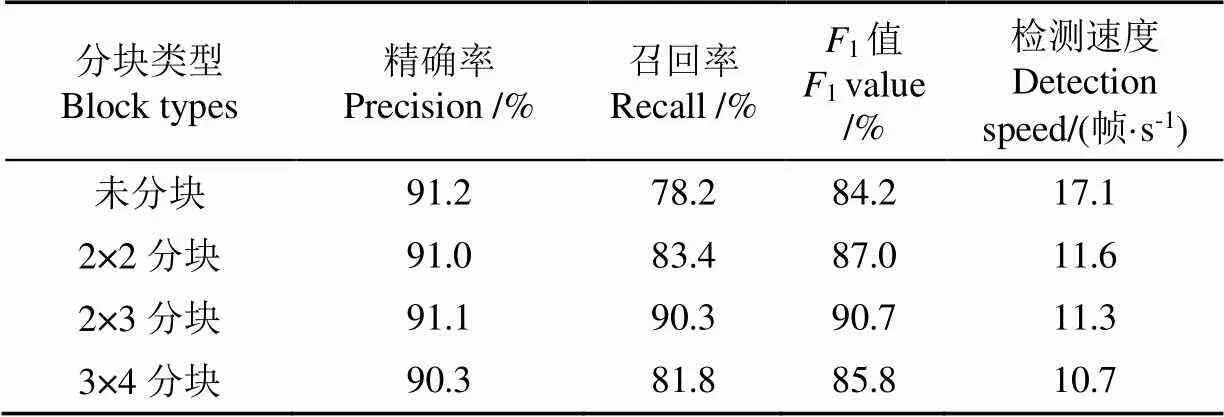

对高亮度茶叶图像进行不同尺寸的分块测试。由表3可见,与未分块的嫩芽检测结果相比,2×2、2×3和3×4三种区域分块对嫩芽检测精度影响不大,但分块后都有效地提高了嫩芽检测召回率。随着区域分块数量增加,需要亮度校正的区域块和边界线上嫩芽数量也随之变多。经区域亮度校正后,边界线上嫩芽特征不均衡,造成嫩芽漏检。检测速度随着分块数量的增加有所降低,但区域分块后的检测速度仍可满足机械采摘的速度需求。从检测精度和召回率的角度综合考虑,选取2×3作为茶叶图像区域亮度自适应校正的分块尺寸。

表2 不同光照强度下亮度校正对茶叶检测结果的影响

表3 不同分块尺寸下Gamma校正对茶叶检测结果

对[170,230]区间内高亮度茶叶图像进行2×3分块和区域Gamma亮度自适应校正后,基于YOLOv5模型的嫩芽检测精度为91.1%,检测召回率为90.3%,亮度校正前后的嫩芽检测结果见图7。较表2中原始高亮度图像的检测结果,经2×3分块和区域Gamma亮度自适应校正后,嫩芽检测的召回率和F值分别提高了19.2个百分点和10.5个百分点,有效降低了嫩芽漏检率和嫩芽检测对光照强度变化的敏感度。

对自然光照下不同时间采集的茶叶图像进行测试,基于区域亮度自适应校正的茶叶嫩芽YOLOv5检测模型对低亮度、中亮度和高亮度图像分别获得91.8%、94.7%、91.1%的精确率和90.6%、91.3%、90.3%的召回率。模型对所有测试集样本的检测精确率为92.4%,召回率为90.4%,相比于SSD、Faster RCNN、YOLOv3和YOLOv4模型,召回率分别提高了14.7个百分点、12.8个百分点、11.1个百分点和9.1个百分点。模型对不同光照强度下的茶叶图像检测效果如图8所示。

3 结 论

不同光照强度下采集的茶叶嫩芽图像,随着光照强度的增加,嫩芽与老叶的对比度变差,且嫩芽特征显著性减弱,造成高亮度图像中存在较多嫩芽的漏检,本文提出了基于区域亮度自适应校正的YOLOv5检测模型。利用图像分块和阈值判断获取茶叶图像中高亮度区域,然后对高亮度区域块进行Gamma亮度自适应校正,提高了嫩芽特征显著性和检测召回率,为茶叶智能化采摘提供理论依据。

1)训练SSD+VGG16、Faster RCNN+VGG16、YOLOv3+Darknet53、YOLOv4+CSPDarknet53、YOLOv5+ CSPDarknet53、YOLOv5+CSPDarknet53+检测抑制共6种检测模型,YOLOv5模型的检测效果较佳,精确率和召回率分别为88.2%和82.1%,检测速度为71.4帧/s,模型大小为91Mb。对YOLOv5结果进行检测抑制,检测精度提高了4.8个百分点,有效减少了同一目标被多次检出的干扰。

2)统计分析了不同时间节点的光照强度分布,并采用平均灰度值进行量化,按照不同亮度下茶叶图像呈现的特征差异,将光照强度分成低、中、高3个亮度级,灰度区间分别为[30,90)、[90,170)、[170,230]。对3种亮度茶叶图像的卷积特征图进行可视化,随着光照强度提高,茶叶图像对比度变差且嫩芽显著性减弱,无法提取有效的特征;对3种亮度的茶叶图像进行YOLOv5检测,低、中、高亮度图像中嫩芽检测精度分别为91.8%、94.7%和92.1%,嫩芽检测召回率分别为90.6%、91.3%和71.1%,说明高亮度图像中嫩芽特征提取能力差,存在较多漏检。

3)对3种亮度的茶叶图像进行Gamma亮度自适应校正,采用YOLOv5模型进行检测。测试结果表明,YOLOv5检测模型对低亮度和中亮度图像的检测结果具有较强的鲁棒性,且亮度校正前后检测效果无显著影响。对高亮度图像进行2×3分块和区域Gamma亮度自适应校正,嫩芽检测精度和召回率达91.1%和90.3%,与未经分块区域亮度自适应校正的高亮度茶叶图像嫩芽检测结果相比,嫩芽检测召回率提高了19.2个百分点。对不同光照强度下采集的茶叶图像进行检测,基于区域Gamma亮度自适应校正的茶叶嫩芽YOLOv5检测模型对所有测试集的检测精度和召回率分别为92.4%和90.4%。该模型可有效降低高亮度茶叶图像中嫩芽漏检率,对光照强度变化具有较强的鲁棒性和低敏感度,对自然环境下茶叶机械智能采摘工作的开展具有指导意义。

[1] 石建军,黄彪,陈玮珩,等. 茶叶采摘技术研究进展[J]. 农业科学,2021,11(2):150-155.

Shi Jianjun, Huang Biao, Chen Weiheng, et al. Some developments in the research of tea picking technology[J]. Agricultural Science, 2021, 11(2): 150-155. (in Chinese with English abstract)

[2] 袁加红,张中正,朱德泉,等. 名优绿茶嫩芽识别与定位方法研究[J]. 安徽农业大学学报,2016,43(5):676-681.

Yuan Jiahong, Zhang Zhongzheng, Zhu Dequan, et al. Approach for recognition and positioning of tea shoots[J]. Journal of Anhui Agricultural University, 2016, 43(5): 676-681. (in Chinese with English abstract)

[3] 张博. 基于RGB-D的茶叶识别与定位技术研究[D]. 沈阳:沈阳工业大学,2020.

Zhang Bo. Research on Tea Recognition and Positioning Technology Based on RGB-D[D]. Shenyang: Shenyang University of Technology, 2020. (in Chinese with English abstract)

[4] 郝淼. 高档名优绿茶嫩芽识别与仿生采摘指研究[D]. 南京:南京林业大学,2019.

Hao Miao. Research on the Identification of Tender Leaves and Bionic Plucking Fingers for High-quality Green Tea[D]. Nanjing: Nanjing Forestry University, 2019. (in Chinese with English abstract)

[5] 邵佩迪,吴明晖. 基于视觉测量的茶叶嫩芽定位方法研究[J]. 农业装备与车辆工程,2020,58(9):50-53.

Shao Peidi, Wu Minghui. Tea bud positioning method based on visual measurement[J]. Agricultural Equipment & Vehicle Engineering, 2020, 58(9): 50-53. (in Chinese with English abstract)

[6] 方坤礼,廖建平,刘晓辉. 基于改进JSEG技术的茶叶图像嫩芽分割与识别研究[J]. 食品工业,2017,38(4):134-138.

Fang Kunli, Liao Jianping, Liu Xiaohui. Research on tea leaf of image segmentation and recognition using improved JSEG algorithm[J]. The Food Industry, 2017, 38(4): 134-138. (in Chinese with English abstract)

[7] 杨福增,杨亮亮,田艳娜,等. 基于颜色和形状特征的茶叶嫩芽识别方法[J]. 农业机械学报,2009,40(Z1):119-123.

Yang Fuzeng, Yang Liangliang, Tian Yanna, et al. Recognition of the tea sprout based on color and shape features[J]. Transactions of the Chinese Society of Agricultural Machinery, 2009, 40(Z1): 119-123. (in Chinese with English abstract)

[8] Shao P, Wu M, Wang X, et al. Research on the tea shoot recognition based on improved k-means algorithm[C]// Proceedings of 2018 2nd International Conference on Electronic Information Technology and Computer Engineering. Shanghai, China. 2018: 846-850.

[9] 姜苗苗,问美倩,周宇,等. 基于颜色因子与图像融合的茶叶嫩芽检测方法[J]. 农业装备与车辆工程,2020,58(10):44-47.

Jang Miaomiao, Wen Meiqian, Zhou Yu, et al. Tea shoot detection method based on color factor and image fusion[J]. Agricultural Equipment & Vehicle Engineering, 2020, 58(10): 44-47. (in Chinese with English abstract)

[10] 夏华鹍,方梦瑞,黄涛,等. 基于SLIC超像素的茶叶嫩芽图像分割方法研究[J]. 西昌学院学报:自然科学版,2019,33(4):75-77.

Xia Huakun, Fang Mengrui, Huang Tao, et al. Study on the method of image segmentation of tea sprouts based on SLIC super-pixel[J]. Journal of Xichang College: Natural Science Edition, 2019, 33(4): 75-77. (in Chinese with English abstract)

[11] 毛腾跃,张雯娟,帖军. 基于显著性检测和Grabcut算法的茶叶嫩芽图像分割[J]. 中南民族大学学报:自然科学版,2021,40(1):80-88.

Mao Tengyue, Zhang Wenjuan, Tie Jun. Image segmentation of tea shoot based on salient object detection and grabcut[J]. Journal of South-Central Minzu University: Natural Science Edition, 2021, 40(1): 80-88. (in Chinese with English abstract)

[12] Karunasena G, Priyankara H. Tea shoot leaf identification by using machine learning and image processing techniques[J]. International Journal of Scientific and Engineering Research, 2020, 11(8): 624-628.

[13] 许高建,张蕴,赖小燚. 基于Faster R-CNN深度网络的茶叶嫩芽图像识别方法[J]. 光电子激光,2020,31(11):1131-1139.

Xu Gaojian, Zhang Yun, Lai Xiaoyi. Recognition approaches of tea bud image based on faster R-CNN depth network[J]. Journal of Optoelectronics Laser, 2020, 31(11): 1131-1139. (in Chinese with English abstract)

[14] 孙肖肖. 基于深度学习的茶叶嫩芽检测和叶部病害图像识别研究[D]. 泰安:山东农业大学,2019.

Sun Xiaoxiao. The Research of Tea Buds Detection and Leaf Diseases Image Recognition Based on Deep Learning[D]. Tai’an: Shandong Agricultural University, 2019. (in Chinese with English abstract)

[15] 王子钰,赵怡巍,刘振宇. 基于SSD算法的茶叶嫩芽检测研究[J]. 微处理机,2020,41(4):42-48.

Wang Ziyu, Zhao Yiwei, Liu Zhenyu. Research on tea shoot detection based on SSD algorithm[J]. Microprocessors, 2020 41(4): 42-48. (in Chinese with English abstract)

[16] 孙肖肖,牟少敏,许永玉,等. 基于深度学习的复杂背景下茶叶嫩芽检测算法[J]. 河北大学学报:自然科学版,2019,39(2):211-216.

Sun Xiaoxiao, Mou Shaomin, Xu Yongyu, et al. Detection algorithm of tea tender shoot under complex background based on deep learning[J]. Journal of Hebei University: Natural Science Edition, 2019, 39(2): 211-216. (in Chinese with English abstract)

[17] Yang H, Chen L, Chen M, et al. Tender tea shoots recognition and positioning for picking robot using improved YOLO-V3 model[J]. IEEE Access, 2019: 180998-181011.

[18] Chen Y T, Chen S F. Localizing plucking points of tea leaves using deep convolutional neural networks[J]. Computers and Electronics in Agriculture, 2020, 171(9): 1-7.

[19] Li Y T, He L Y, Jia J M, et al. In-field tea shoot detection and 3D localization using an RGB-D camera[J]. Computers and Electronics in Agriculture, 2021, 185: 1-7.

[20] 龚聪,徐杜. 光源强度变化对图像检测精度的影响及其解决方法[J]. 科学技术与工程,2014,14(13):236-239.

Gong Cong, Xu Du. Impact and solution of light source intensity changes to image measuring precision[J]. Science Technology and Engineering, 2014, 14(13): 236-239. (in Chinese with English abstract)

[21] 赵博华,王伯雄,罗秀芝. 光切法形貌测量系统的图像照度质量评价方法[J]. 清华大学学报:自然科学版,2011,51(4):448-451.

Zhao Bohua, Wang Boxiong, Luo Xiuzhi. Illumination quality evaluation method for images sampled by a 3-D measuring system based on light-sectioning[J]. Journal of Tsinghua University: Science and Technology, 2011, 51(4): 448-451. (in Chinese with English abstract)

[22] 廖娟,陈民慧,汪鹞,等. 基于双重Gamma校正的秧苗图像增强算法[J]. 江苏农业学报,2020,36(6):1411-1418.

Liao Juan, Chen Minhui, Wang Yao, et al. Image enhancement algorithm for seedling image with dual gamma correction[J]. Jiangsu Journal of Agricultural Sciences, 2020, 36(6): 1411-1418. (in Chinese with English abstract)

[23] 姬伟,吕兴琴,赵德安,等. 苹果采摘机器人夜间图像边缘保持的Retinex增强算法[J]. 农业工程学报,2016,32(6):189-196.

Ji Wei, Lyu Xingqin, Zhao Dean, et al. Edge-preserving Retinex enhancement algorithm of night vision image for apple harvesting robot[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(6): 189-196. (in Chinese with English abstract)

[24] Yap M H, Hachiuma R, Alavi A, et al. Deep learning in diabetic foot ulcers detection: A comprehensive evaluation[J]. Computers in Biology and Medicine, 2021, 135: 104596.

[25] Malta A, Mendes M, Farinha T. Augmented reality maintenance assistant using YOLOv5[J]. Applied Sciences, 2021, 11(11): 4758.

[26] Lin T Y, Dollar P, Girshick R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Honolulu, USA. 2017: 2117-2125.

[27] Li H, Xiong P, An J, et al. Pyramid attention network for semantic segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA. 2018.

[28] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multiBox detector[C]// European Conference on Computer Vision. Springer International Publishing, 2016: 21-37.

[29] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. Computer Science, 2014: 1409-1556.

[30] Ren S, He K, Girshick R, et al. Faster R-CNN: Towardsreal-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & MachineIntelligence, 2017, 39(6): 1137-1149.

[31] Redmon J, Farhadi A. YOLOv3: An Incremental Improvement[J]. arXiv e-prints, 2018: 1804-2767.

[32] 陈善雄,伍胜,于显平,等. 基于卷积神经网络结合图像处理技术的荞麦病害识别[J]. 农业工程学报,2021,37(3):155-163.

Chen Shanxiong, Wu Sheng, Yu Xianping, et al. Buckwheat disease recognition using convolution neural network combined with image processing[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(3): 155-163. (in Chinese with English abstract)

Detection model for tea buds based on region brightness adaptive correction

Lyu Jun1, Fang Mengrui1, Yao Qing1※, Wu Chuanyu2, He Yinglei2, Bian Lei3, Zhong Xiaoyu4

(1.,,310018,;2.,,310018,;3.,,310008,;4.,310030,)

An Accurate and rapid detection of tea buds can be a critical precondition in an intelligent tea-picking system. Nevertheless, it is still lacking in the robustness, universality, and accuracy during the segmentation of tea buds images under natural light. Fortunately, deep learning can greatly contribute to the artificial extraction of features for higher accuracy of tea bud detection in recent years. However, the current detection of tea bud can also be affected by the light to a great extent. Thus, it is very necessary to establish a new model of tea bud detection with high robustness and low sensitivity for intelligent tea picking in a natural environment. A novel automatic detection model of tea buds was proposed using a regional brightness adaptive correction and deep learning, in order to improve the robustness under different light intensities. First, the Longjing 43 tea was taken as a research object to collect the images under various light intensities. A labelling software was then used to label for the “V” and “I” posture of one bud and one leaf. After that, a data enhancement was performed by adding the Gaussian noise and horizontal mirroring. Second, the RGB images were converted to the grayscale images, of which the gray values were averaged. Subsequently, the distribution of the Average Gray (AG) values and convolution feature diagram were utilized to classify the grayscale images under different illumination intensities. Specifically, three levels were obtained, including the low, medium, and high brightness, corresponding to the intervals [30, 90), [90, 170), and [170, 230], respectively. A gamma brightness adaptive correction was then performed on the images with high brightness using different sizes of partitioning. At last, the multiple models of tea buds detection using deep learning were trained on the same training and test set. The results showed that the YOLOv5+CSPDarknet53 presented an optimal performance of tea bud detection, with the detection precision of 88.2% and recall rate of 82.1%, compared with SSD+VGG16, Faster RCNN+VGG16, YOLOv3+Darknet53, and YOLOv4+CSPDarknet53 models. The precision of detection was improved by 4.8 percentage points after a detection suppression on the YOLOv5 model. Thus, there was much less phenomenon that the same target was boxed for several times. Moreover, the image features of tea buds were of high significance in the brightness intervals [30, 90) and [90, 170), indicating that there was a much fewer influence of the brightness adaptive correction on the detection of the images with the medium or low brightness. There was also a relatively lower contrast between the tea buds and old leaves in the high brightness images. Furthermore, the significance of tea buds was weakened with the deepening of network layers, indicating that the effective features of tea buds cannot be extracted so far. As such, the recall rate of bud detection was only 71.1% for the high brightness images, indicating a relatively high missing detection rate. More importantly, the recall rate of bud detection was promoted by 19.2 percentage points than before, particularly after 2×3 block and regional gamma adaptive brightness correction for the high brightness images. The testing of tea images under various light intensities demonstrated that the YOLOv5 detection model using a regional brightness adaptive correction achieved the detection precision of 92.4% and the recall rate of 90.4%, indicating high robustness and low sensitivity to light changes. Therefore, the finding can provide a promising theoretical basis for the intelligent tea-picking system under natural light conditions.

computer vision; target detection; tea buds; light intensity; block; brightness adaptive correction; YOLOv5

吕军,方梦瑞,姚青,等. 基于区域亮度自适应校正的茶叶嫩芽检测模型[J]. 农业工程学报,2021,37(22):278-285.doi:10.11975/j.issn.1002-6819.2021.22.032 http://www.tcsae.org

Lyu Jun, Fang Mengrui, Yao Qing, et al. Detection model for tea buds based on region brightness adaptive correction[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(22): 278-285. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.22.032 http://www.tcsae.org

2021-07-22

2021-09-10

国家茶叶产业技术体系(CARS-19)

吕军,讲师,研究方向为农业智能信息处理。Email:lv_jun@zstu.edu.cn

姚青,博士,教授,研究方向为农业病虫害图像处理与智能诊断。Email:q-yao@zstu.edu.cn

10.11975/j.issn.1002-6819.2021.22.032

TP391.9

A

1002-6819(2021)-22-0278-08