一种提取抖动视频中前景目标的新方法

顾 扬,曾凡意,应昊然,王丽平

(1.南京航空航天大学 理学院,江苏 南京 211106;2.南京航空航天大学 自动化学院,江苏 南京 211106)

0 引 言

随着图像传感器的普及和广泛使用以及大数据时代的降临,计算视觉与模式识别领域快速发展,监控视频的智能化成为相关领域的前沿热点[1-4]。在大部分情况下,所有需处理的视频在录制过程中难免会受到各种外界因素尤其是自然因素的干扰,导致视频背景连续帧之间的不连续变化,视频往往具有复杂、多变、动态的背景,如抖动、阴影等多种非前景目标的噪声干扰[5-6]。如何剔除各种因其他误入的噪声干扰及虚假目标,并快速、高质量、精准有效地从大量视频中提取出所需的全部真实运动目标是当前国内外民用及军用视觉监控领域研究的热点和难点之一。近年来,高斯混合模型(Gaussian mixture model,GMM)与小波变换(wavelet transform,WT)是处理抖动视频前景提取的十分有效的方法。前者能很好地拟合背景颜色信息的变化,后者又能较好地提取图像的纹理特征,二者的结合互补对抖动视频的前景提取具有极佳的效果。

针对抖动视频前景提取所带来的挑战,2010年张宗彬[7]研究了一种基于混合高斯模型的运动目标检测算法,并针对“鬼影”问题和光线突变造成的大面积误检问题提出了一种改进算法。2011年蔡念等[1]提出了融合高斯混合模型和小波变换的运动目标检测方法,利用小波变换提取的图像纹理信息和高斯混合模型拟合的背景信息,对提取算法进行完善。2016年葛鹤银等[2]针对抖动视频提出了一种融合小波变换及自适应SIFT(scale invariant feature transform)算法的运动补偿方案,应用Mallat小波提取图像纹理信息,将亮度信息与纹理信息进行线性组合来检测和提取运动目标。2018年吴玉香等[8]公开了一种融合高斯混合模型和H-S光流法的视频前景目标提取方法,对原始图像先进行混合高斯模型和H-S光流法处理再进行小波变换与滤波去噪。

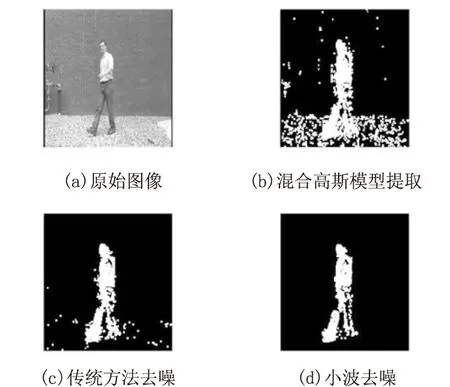

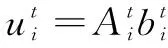

考虑到小波变换和高斯混合模型的稳定的提取效果,该文进一步探索研究更快速、更高效地提取抖动视频前景的方法。对于抖动视频的移动性,该文采用在线仿射变换[9]进行去抖动,纠正图片的姿态,将抖动的背景变为相对固定的背景。但仿射变换会带来随机噪声点问题,为去除随机噪声点,对在线混合高斯模型(OMoGMF)提取后的前景图像采用传统方法和小波变换方法进行去噪,发现小波变换相关性去噪法[10]在去噪的同时可以有效提取并保留图片纹理信息(如图1所示),进而提出了融入小波变换的在线校准混合高斯模型。但该模型会遇到在线校准“学习准确度”不高和小波去噪不彻底的问题,因此进一步改进,建立了一个前景提取的自适应校准模型。

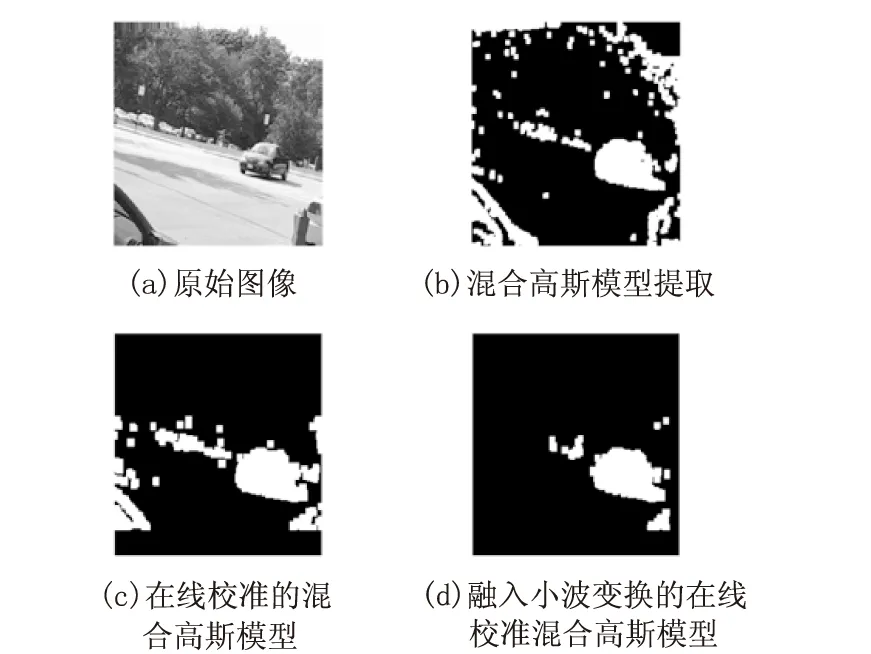

在每完成一次校准和去噪的迭代后,计算图像的F值,当下一次迭代得到的F值比本次更小时,将停止迭代。处理之后,采用在线混合高斯模型来提取前景得到最终结果。

图1 不同方法去噪效果对比

该文的主要贡献在于综合地运用仿射变换、小波变换、在线混合高斯模型,设计出一套针对抖动视频能够合理、显著地提取前景的自适应循环算法体系,获得了较为理想的实验结果。

1 在线混合高斯模型

1.1 混合高斯模型

对智能视频监控来说,摄像机处于静止情况。假设视频图像中背景像素点的特征在一段时间内变化不大,则可以认为在这一段时间内,背景像素点服从高斯分布。但是在实际情况中,存在树枝晃动、水波等干扰,背景像素点会呈现出双峰或者多峰的现象,因此必须采用多个高斯分布的混合方式来描述背景像素点的特征,以降低干扰[11]。

对于输入视频流,可理解为一个3维数据X∈Rw×h×t,其中w,h代表视频帧的长,宽,t代表视频帧的帧数。为方便处理,采取如下方法将视频流转化为一个矩阵:对于视频的每一帧,将它的每一列首尾相连,组成一个列向量,然后把每一个列向量按行排列组成一个矩阵,即视频流X∈R(w×h)×t。

在低秩矩阵分解(LRMF)中,对输入阵X每一个元素xij(i=1,2,…,w×h,j=1,2,…,t)可以建立如下模型:

xij=(ui)Tvj+εij

(1)

其中,UTV是低秩子空间,ui和vi分别为U和V的第i列向量,εij表示xij中的噪声。已知足够多的高斯分布之和可以以任意精度拟合任意连续分布。因此对于分布未知的噪声εij,可以通过多个高斯分布的混合来拟合它。假设噪声εij采样于一个混合高斯模型p(ε):

(2)

(3)

观测到X的概率为观测到X的每个元素概率之积:

p(X|U,V,Π,Σ)=Πp(xij|(ui)Tvj,Π,Σ)=

(4)

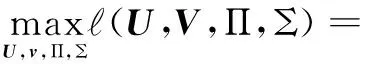

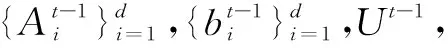

这样一来就得到了观测X的概率表达式,然后选择最优的参数U,V,Π,Σ使得X出现的概率最大,即如下的极大似然估计法。

(5)

1.2 在线混合高斯模型

假设式(1)中每一帧xt上都有一个独立的MoG噪声分布,可以由MAP(最大后验)估计推导出OMoGMF的模型。于是得到:

(6)

(7)

对于背景子空间,可以很容易地为其每一行向量设置高斯分布的先验如下:

(8)

maxLt(Π,Σ,v,U)=-lnp(xt|Π,Σ,v,U)+

(9)

2 融入小波变换的在线校准混合高斯模型

在现实生活中,监控摄像头由于设备老化、外在干扰等因素不可避免地会发生晃动或偏移,此时视频也会发生短暂的抖动现象,一些旋转平移可能导致像素点的位置发生较大的移动。由于在很多情况下视频的抖动是随机的,无法通过将一个统一的仿射变换算子作用在视频流X上来完成对整个视频的校准,因此该文选用了在线更新的算法来对视频进行逐帧校准。

2.1 在线校准的混合高斯模型

2.1.1 嵌入变换算子

假设选用的变换算子为τ,在视频的第一帧xt将τ设定为一个初始值,随后对于视频的每一帧观测到当前帧xt的对数似然,利用变换算子来对当前帧进行校准,与此同时,还要根据当前帧的偏移情况来更新变换算子τ,即要在整个视频流中动态地学习变换算子,而不是对于每一帧都选用一个恒定的算子。这种处理方式不需要借助太多的先验知识来建模摄像机的抖动轨迹,而是能够自适应地学习到一系列用于校准的变换算子。

对于视频分解的每一帧新图像xt,在当前子空间U的基础上得到相应的变换算子τ。定义MoG的噪声为:

(10)

其中,ε'=xt∘τ-Uv,xt∘τ表示对当前帧的校准。对此,可以构建最优化目标函数:

maxL(Π,Σ,v,U,τ)=-lnp(xt∘τ|Π,Σ,v,U)+

(11)

解决此问题的关键在于得到更新τ的方程,由于xt∘τ是一个非线性的几何变换,所以重新定义了最优化目标函数,如式(12)所示,J是反映变换算子τ的雅可比矩阵。

maxL(Π,Σ,v,U,Δτ)=-lnp(xt∘τ+JΔτ|Π,Σ,

(12)

该方法采用局部线性逼近法对原始非线性变换进行迭代逼近。利用以下公式更新v,τ。

(13)

(14)

其中,T=[U,-J]。在得到Δτ后,更新变换算子τ,最后使用与混合高斯模型相同的方法更新子空间U。

2.1.2 在线EM算法求解

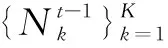

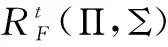

初始化:{Π,Σ}={Πt-1,Σt-1},v,τ。

1.执行以下步骤直至目标函数收敛。

3.执行以下步骤直至收敛:

5.在线M-step:

(2)通过式(14)计算参数{v,Δτ}。

6.执行结束后更新变换算子τ=τ+Δτ。

10.结束。

2.2 融入小波去噪的自适应提取

由于视频成像的颗粒性质,图像的噪声是客观存在的。尤其针对来源于生活的监控视频,由于摄像头的抖动、背景的变化等都不可避免地会污染视频、带来噪声,因此在对信号做进一步分析之前,需要进行去噪处理,将有效的信号提取出来。

传统的去噪方法主要包括线性滤波方法或平均方法,而具有“数字显微镜”之称的小波变换具有良好的时频特性,从而为其在信号降噪中的应用提供了广阔的前景,开辟了用非线性方法除噪的先河[14]。小波去噪的方法大致可以分为三大类:模极大值去噪法[15]、相关性去噪法、阈值去噪法[16]。小波系数相关性去噪方法效果稳定,且在分析边缘方面有优势,计算量在三种方法中位于中等,因此针对随机抖动的监控视频所带来的随机噪声,该文采取相关性去噪法进行噪声消除。

根据上面的分析,采用在线校准的混合高斯模型可以提取出抖动视频中的前景目标,但是实验结果表明仿射变换虽然能纠正图片的姿态,但同时会产生很多随机的噪声点,导致提取效果并不理想。一帧图片的信息大致可分为亮度信息和纹理信息,在线混合高斯模型能很好地拟合背景颜色信息的变化,小波变换能较好地提取图像的纹理特征,而纹理特征反映了图像的区域局部信息,通常区域空间结构信息可以消除噪声及亮度变化影响[2]。并且小波变换对随机噪声具有较强的适应性,因而该文在上述模型的基础上加以改进,融入相关性小波去噪,实验结果发现提取效果得到明显改进,如图2所示。

图2 不同提取方法对比

该文进一步分析,由于仿射变换是一个在线学习的过程,不可避免地会遇到“学习准确度”不高的问题,同时一次小波去噪也基本无法将噪声全部去除,因此将算法进一步改进,提出自适应提取的迭代模型,对每一帧图像在线校准和小波去噪后引入评价指标,定量判断提取的效果。算法流程如图3所示。

图3 算法流程

该文对仿射变换后的每帧图片都运用小波相关性去噪法进行去噪,这样既能保存原来图片的纹理,又能有效地去除噪声点。实验结果表明,小波去噪之后前景得到了明显的改善。同时考虑到在线校准和小波去噪的次数不同结果可能会产生较大的差异,建立了一个前景提取的自适应模型。

在每完成一次校准和去噪的迭代后,判断图像的F值,理论上来说在线校准会引入新的随机噪声,而当噪声去除到一定程度时,图像的纹理信息也会遭到破坏,因此迭代次数不是越多越好。当第i+1次迭代得到的F值比第i次更小时,停止对图片的校准和去噪。根据实验结果,该文得到的迭代次数一般以两到三次为优。接着再运用在线混合高斯模型提取得到最终的前景结果。

3 实验结果及分析

为验证文中算法,采用Matlab R2016a编写相关算法,采用标准视频监控数据库里的两段视频(http:

//cvlab.epfl.ch)对算法进行了验证,运行环境为Win10,Intel(R)Core(TM)i7-6500U CPU @2.50 GHz,8 GB内存。这两段视频分别含有单目标和多目标的前景,且都出现了摄像头抖动的情况。

3.1 实验参数设置

图4 σ对结果的影响

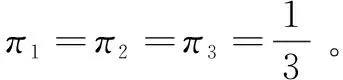

表1 σ对结果的影响

从图4中可以看出当σ过小时会导致算法错误地将一些噪声点识别为前景,而当σ过大时则会使提取的前景产生较大的失真。从表1中可以得到,σ取6时各项评价指标均达到最优。在实际应用中,综合考虑噪声的抑制和前景提取的品质,σ取5~10为宜。

3.2 实验结果

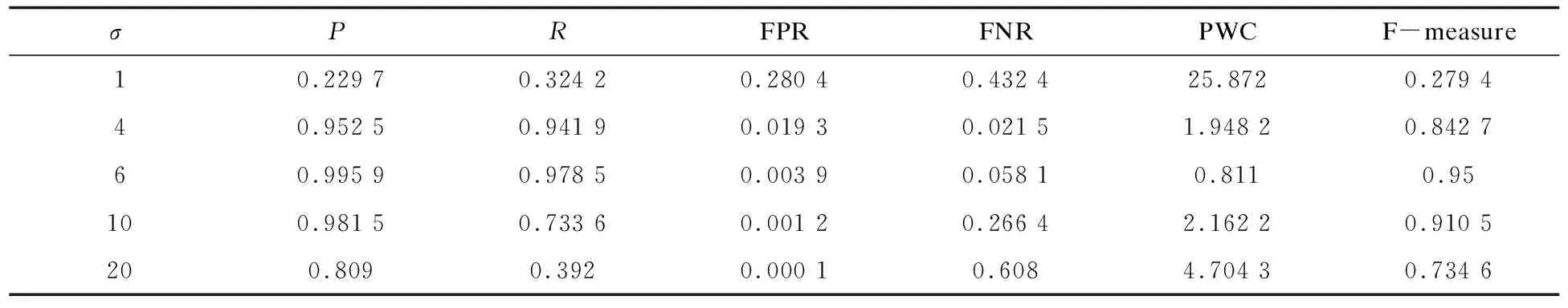

综合以上实验参数的分析,采用混合高斯模型和文中算法对单目标和多目标的抖动视频进行前景提取的实验,结果如图5所示。

图5 实验结果

从图5可以看出,针对单目标视频虽然混合高斯模型可以提取一定前景,但轮廓不明显。而文中算法经过三次自适应迭代之后所提取出的前景与之相比有了较为明显的改善,轮廓清晰、无多余噪声点。由于视频发生抖动时背景变化较大,通过仿射变换将图片“校正”会带来一定误差,显然在线高斯混合模型更能适应这种误差。同时由于小波变换能够有效地提取图片的纹理信息,并且对随机噪声具有较强的适应性,这样在消除噪声的同时能尽量保存图片的轮廓,最终获得比较完整的前景目标。

针对多目标视频,混合高斯模型已无法正确地分辨噪声点和前景点,该算法显然效果更好。同时观察结果可知二次迭代的效果明显优于三次迭代,原因是去噪次数过多会在一定程度上破坏前景目标的纹理信息,因此该文提出的前景提取自适应模型是有必要的。

最后,采用IEEE change detection workshop(CDW)评价检测标准来定量地进行客观评价分析,定义TP为提取到的正确目标点数,FP为错误目标点数,TN为正确背景点数,FN为错误背景点数。评价内容包括:

Precision=TP/(TP+FP)

Re(Recall)=TP/(TP+FN)

FPR(False Positive Rate)=FP/(FP+TN)

FNR(False Negative Rate)=FN/(TP+FN)

PWC(Percentage of Wrong Classifications)=100×(FN+FP)/(TP+FN+FP+TN)

F-Measure=(2×Precision×Recall)/(Precision+Recall)

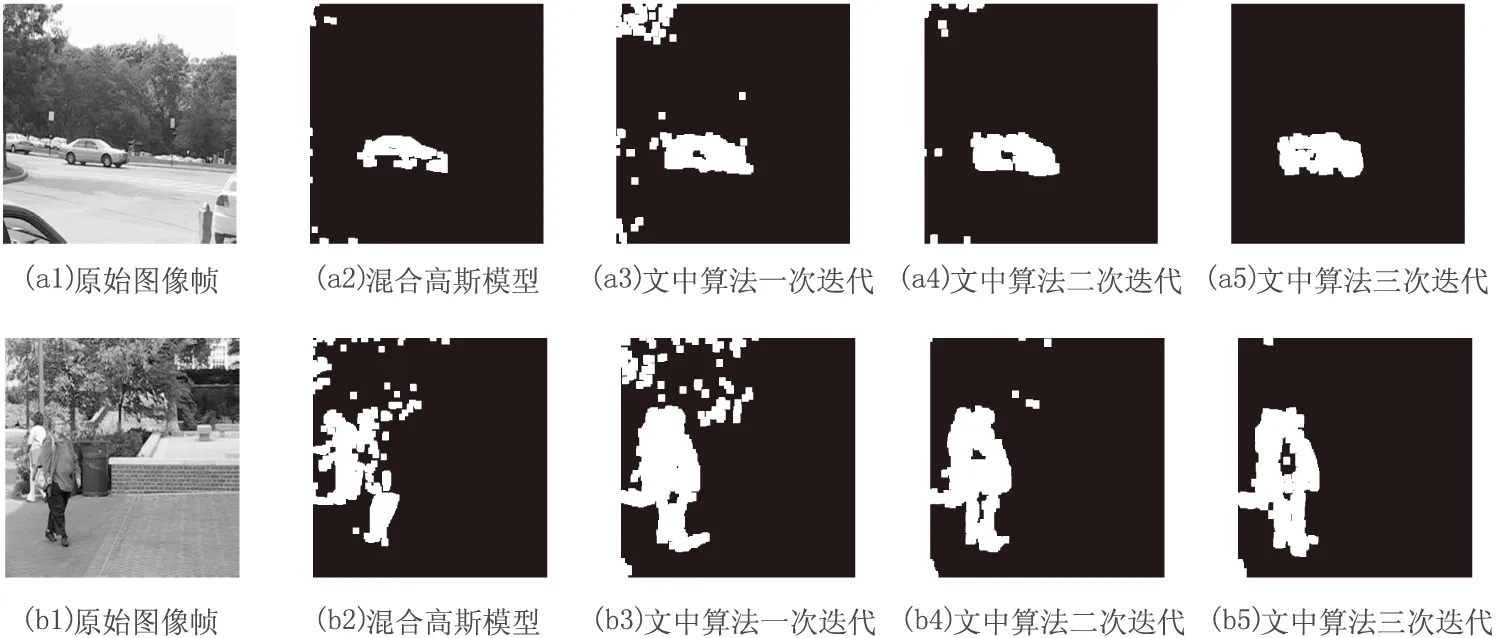

对实验采用的两段视频分别统计上述参数,结果如表2所示。

表2 评价参数比较

针对第一段视频(单目标提取),在进行三次迭代之后,文中算法的六个统计参数除了FPR系数比混合高斯得到的结果稍大,其余参数如错误率、正确检测率和精度等都要优于经典算法。针对第二段视频(多目标提取),在经过两次迭代之后得到的六个参数都明显优于经典算法。由此可见,该模型具有较强的先进性,故采用文中算法对抖动视频的前景提取具有良好的效果。

4 结束语

针对抖动视频的前景提取问题,提出了一种基于小波变换和在线混合高斯模型的提取方案。采用文中算法体系对抖动视频进行校正,利用在线学习的混合高斯模型进行目标提取。同时,融入自适应的在线校准和小波变换去噪,可以有效去除抖动和校正过程产生的随机噪声并减少计算量,在小波变换和在线混合高斯模型处理方法的基础上进一步提高了前景提取目标的精度与算法的鲁棒性。