基于深度卷积神经网络的图像着色

刘建民 陆萍 张小雪

摘要:对黑白或灰度照片进行着色处理可以给宝贵的历史影像资料带来更好的视觉效果。当前的图像着色处理方法存在需要用户交互、需要提供参考图像等诸多局限。该文设计了一种基于深度卷积神经网络的图像着色模型,该模型采用了端到端的编码与解码架构,能够从大规模数据学习颜色的分布,实现颜色传播与预测,从而把灰度图像映射为彩色图像。实验结果表明该模型具有良好的图像着色效果。

关键词:图像着色;灰度图像;颜色分布;深度卷积神经网络

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2020)28-0021-02

Abstract: Better visualization can be obtained by applying colorization to valuable historical image data which are usually in grayscale. However, there are a few shortcomings in traditional colorization methods, such as heavy human interactions and exemplar image dependency. In this paper, we propose an automatic colorization model on the basis of deep convolutional neural networks. The model employs the classical encoder-decoder framework, it can learn the color distribution from large scale data and then propagate and predict the colors in a point-point way. Experiments show that favorable colorization can be achieved.

Key words:colorization;grayscale image; color distribution;deep convolutional neural networks

1背景

色彩信息是彩色图像蕴含的一种重要视觉信息,它与图像中各类事物的形状、纹理等共同展现场景的语意信息。对图像着色是数字图像处理的一项重要任务,它通过数字化方法为黑白或灰度图像添加色彩,能够使得给宝贵的历史影像资料带來更好的视觉效果,提高图像的表现力及使用价值。在对图像进行着色处理时,传统的着色方法严重依赖于处理人员的个人经验与技巧,存在一定的局限性。在数字化图像处理中,对图像着色可以大致分为以下三种方法:1)基于用户引导的颜色传播[1];2)基于指定函数或参数的颜色映射[2];3)基于参考图像的着色方法[3]。这三类方法中用户引导的颜色传播方法需要用户对部分图像区域进行指导性着色,需要较多的用户交互;第二类方法需要建立颜色映射关系或变换函数;第三类方法需要提供内容相似的参考图像作为匹配模板,在使用上均具有一定的局限性。

随着深度学习技术在图像处理与计算机视觉中获得广泛应用,利用深度学习模型强大的拟合能力来获得灰度空间与图像色彩之间的映射关系,捕捉图像颜色的分布,进而实现对灰度或黑白图像的着色,为处理图像着色问题开辟了新的方向[4-5]。本文基于深度学习技术,使用卷积神经网络构建了编码-解码的图像着色网络,构造了着色网络的损失函数,训练后的深度模型能够取得比较优秀的图像着色效果,使得图像的视觉显示效果得到明显改善。

2深度残差网络

卷积神经网络现已在图像识别、场景理解、语音分析等诸多领域中获得广泛应用。与全连接网络相比,卷积神经网络中的参数具有局部共享、参数量较少等优点,适合处理二维的图像。在图像分析应用中,可以直接将图像输入到网络中实现特征提取与分类过程中的融合,构建端到端的网络架构。当前在通用的深度卷积网络架构上,已经设计出VGG、GoogLeNet、ResNet与DenseNet等多种优秀的网络模型,在图像分类、特征提取中广泛应用。在本文设计的着色网络中采用了ResNet作为骨架网络。

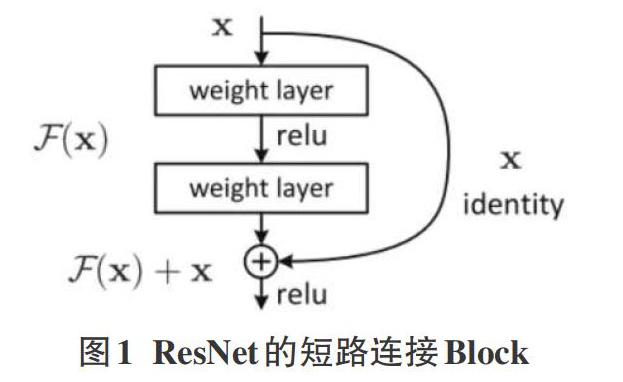

在深度网络架构中,随着网络层数的加深,极易发生梯度消失或梯度爆炸问题,使得靠近输入层的各隐藏层无法获得有效的更新,学习不到有效的模式。为了解决这一问题,ResNet使用了如图1所示的短路连接,使得整体网络具有至少不弱于恒等变换的效果,有效地抑制了网络层次加深时的梯度消失问题。

3图像着色网络结构

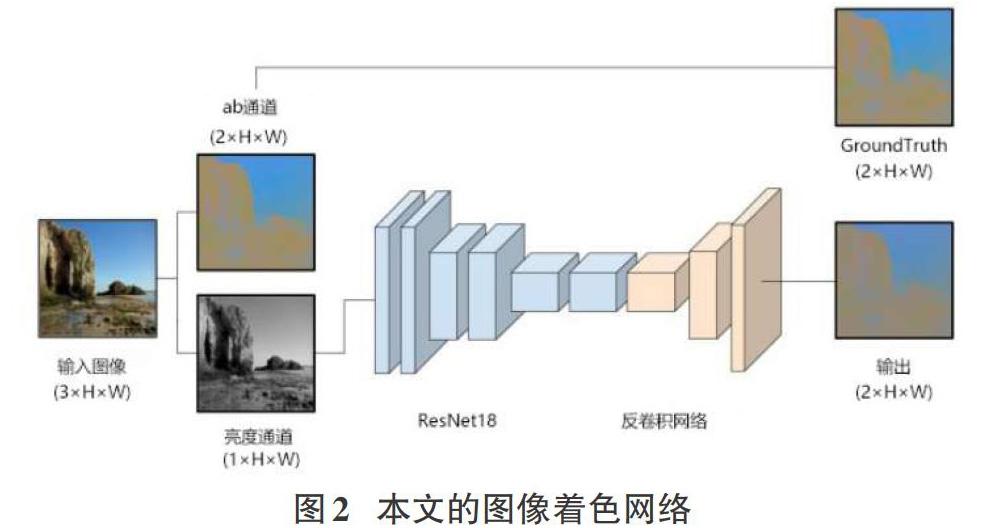

本文创建的图像着色网络结构如图2所示。由于CIE Lab颜色空间与人眼视觉特性非常接近,而且其色域比较广且又具有设备无关性,能够有效地弥补RGB色彩模型中颜色分布不足的局限,因此本文选择了将RGB图像转换Lab颜色空间后,选用其中亮度通道图像作为训练数据,而其色通道用作为GroundTruth标签数据。

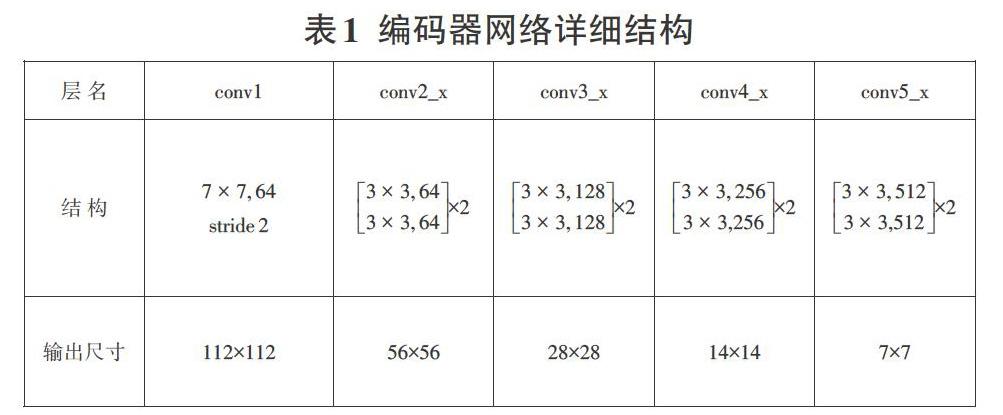

在着色网络结构的设计上,本文采用了典型的编码器-解码器结构。在编码器结构中采用了ResNet-18的网络结构来提取图像的特征。ResNet-18使用了如图1所示短路模块进行堆叠,整体结构可以被分为5组。第1组为基本卷积模块,输入图像为224×224像素大小,分别经过7×7,步幅为2与3×3步幅为2的卷积;第2组至第5组均采用了两个图1短路模块形成的组合,卷积核大小均为3×3大小,卷积后的特征图分别为64、128、256、512。与标准的ResNet框架不同,本文使用的框架中取消了最后的全局池化层与分类网络中的全连接层。编码器中ResNet18的整体结构如表1所示。

本文采用了在ImageNet数据集训练好的RestNet-18分类器网络,而不是从头重新训练。在ImageNet数据集训练的ResNet-18可以获得近80%的分类准确率。在本文模型中采用丢弃最后全局平均池化层与全连接层的方式接入后续的解码器网络。由于使用训练好的编码器网络,不仅可以借用迁移学习带来更快的训练效果,还能够利用学习参数中的颜色模式。

网络编码器经过编码器处理获得的特征图将被进一步送入反卷积网络处理。在着色网络的解码器反卷积网络中,对接收的特征图作了5层卷积-上采样操作处理,每层的卷积核大小均为3×3大小,移动步幅为1,padding为1。在每个卷积-上采样层中的处理顺序为:卷积-批归一化-ReLU激活-上采样,上采样的尺度均为2倍。这样即保证了经过反卷积网络后的图像大小与原始图像大小一致。各层的特征图数量上分别被设置为:128、64、64、32、2。反卷积网络的具体结构如表2所示。

在網络损失函数的选择上,本文选择了均方误差损失函数,通过最小化预测的颜色值与真实的颜色值之间的平方距离来约束网络。

4实验结果

在实验中采用了MIT Places205Database数据集中的数据对网络进行训练,该数据集中含有205个场景的250多万张图片。由于本文的网络架构相对较小,这里仅采用了MIT Places数据集中的places、landscapes与buildings三个子集进行训练。

本文选择了PyTorch深度学习框架进行网络的训练与测试。在创建训练与测试数据时,所有的图片先被缩放到统一的256×256大小并转入CIELab颜色空间。在数据扩增上使用了随机水平翻转与随机中心裁切,最终送入网络的张量大小为224×224。实验采用的批次大小为64,即每个批次中包含有64张图片。在训练模型时采用了Adam优化器,学习率为0.01,权重衰减系数为0.5,训练时设置了最大epoch数量为100。

在图像着色效果的评价上,当前还没有比较好的度量方案,因为图像着色是一个病态的任务,即在图像着色时可以有很多种着色方案。不过可以采用着色图像与原始图像的像素值间的均方误差来衡量两者之间的差异。表3给出了在训练不同阶段中的均方误差变化,实验中发在迭代的epoch数达到50次后,模型训练基本上进入稳定阶段,着色图与原始图像像素均方误差基本上维持不变。

在完成图像着色模型的训练后,使用获得的模型对灰度处理后的图像进行着色的部分示例如图3所示:其中最右列为原始彩色图像,最左列为去除了颜色的灰度图,中间为使用本文模型的上色图像。从图中可以看出本文模型取得了比较不错的着色效果,着色后的图像在色彩上丰富了许多,能够比灰度图像具有更好的表现力。但由于模型较为简单,获得的着色图像与原始图像的色彩相比在细节上还具有一定的不足,在整体颜色相差较大的情况下着色效果不够理想(如第2行)。

5结束语

本文设计了一个基于深度卷积神经网络的图像着色模型,该模型能够从大规模的彩色图像数据中自动学习颜色的分布,在应用于黑白或灰度图像时能够实现颜色传播与预测,即完成图像的自动着色工作。该深度着色模型结构简单易于实现,在下一步工作将进一步引入其他引导信息,实现更优的着色效果。

参考文献:

[1] Levin A,Lischinski D,Weiss Y,et al.Colorization using optimization[C]//International conference on computer graphics and interactive techniques,2004,23(3):689-694.

[2] ShahA A,GandhiM,ShahK M.Medical image colorization using optimization technique[J].Acta Medica Okayama,2013,62(141):235-248.

[3] Liu Y M,Cohen M,Uyttendaele M,et al.AutoStyle:automatic style transfer from image collections to users' images[J].Computer Graphics Forum,2014,33(4):21-31.

[4] 张娜,秦品乐,曾建潮,等.基于密集神经网络的灰度图像着色算法[J].计算机应用,2019,39(6):1816-1823.

[5] 徐中辉,吕维帅.基于卷积神经网络的图像着色[J].电子技术应用,2018,44(10):19-22.

[6] Deshpande A,Rock J,Forsyth D.Learning large-scale automatic image colorization[C]//2015 IEEE International Conference on Computer Vision (ICCV).7-13 Dec.2015,Santiago,Chile.IEEE,2015:567-575.

【通联编辑:谢媛媛】