数据骨干网SDN 域控制器与超级控制器建设方案

张文迪 陈鹏宗

(广东南方电信规划咨询设计院有限公司,广东 深圳518038)

目前运营商缺乏云网协同能力,而阿里、腾讯等均已具备网络基础能力,可以提供企业一站式上云服务。运营商将面临失去业务入口和失去客户界面的市场挑战,传统专线市场会被侵蚀。由此可见,运营商数据网网络亟待补齐云网协同能力,增强市场竞争力。

1 网络结构总体演进目标

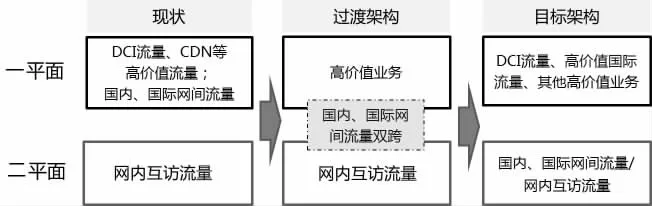

数据骨干网包含有一/二两个平面,每个平面均为骨干核心层、骨干汇聚层二层结构,二平面主要疏导网内流量;一平面主要疏导国内/国际网间的流量,流量疏通效率有了较大的提高。

综合考虑现网的业务功能、网络设备演进及新技术发展等主要因素,按照确保网络架构平滑演进的原则,制定数据骨干网业务承载目标架构:业务承载优化,分平面承载大流量业务、高价值流量业务,积极引入SDN,提升网络智能化。

目前二平面承载数据网网内流量,一平面承载网间流量。将在一平面引入SDN技术,承载数据中心互联DCI 流量、CDN等高价值互联网流量,一平面的国内国际网间流量将逐步迁移到二平面,最终二平面将承载普通互联网流量,包括网内互访流量和网间流量,一平面作为云专网,承载DCI、CDN等高价值业务。

数据骨干网业务承载目标架构详见图1。

图1

2 现网问题分析

2.1 现网链路利用率分析

(1)数据网城域网出口带宽的建设较好的匹配了流量增长的需求,链路利用率保持平稳。

(2)数据网省际中继带宽超前了现网的流量需求,链路利用率有较大的增长空间。

(3)国内、国际互联出口开通带宽受限于政策,链路利用率基本保持在60%~70%。

2.2 第一平面网络改造分析

根据骨干网两个平面定位,第一平面需要进行改造,适配云服务业务承载需求。随着新业务的高速发展,新技术的不断出现,对现有第一平面的设备性能、网络架构和智能化提出了更高的要求,具体分析如下:

(1)设备性能。第一平面路由器设备大部分平台能力为100G,对SDN技术支持能力不足,需大范围改造。

(2)网络架构。由于工程历史建设原因,第一平面多个省份设置多个节点,网络流量疏导策略复杂。结合新兴云业务网络承载需求,需优化网络架构,提高流量转发效率。

(3)智能化。云业务DC间东西向流量要求流量的灵活调度和高QoS保证,同时云互联/云专线等新兴业务对承载网提出按需配置、快速发放、能力开放等更高的网络要求。

为满足以上需求,需要提高全网流量集中调度能力,因此需要引入SDN新技术,以提升网络的智能化需求。

3 建设原则

原则一:网络架构优化。

(1)节点设置。为保持结构简洁、疏导高效,每个省异局址成对设置2 个BB/BC 节点;云PE、网PE 异局址成对设置,云PE 就近云资源池设置,网PE 就近BB/BC 设置,云网PE 就近接入本省BB/BC。

(2)省际中继。POS端口不支持SDN,撤销现网POS链路;原有省份节点较少至2 个节点,通过转接电路利旧省际中继。

(3)上连云专网。省内落地设备、IT云资源池直连云网PE,IT云资源池直连BB/BC;撤销省网、城域网和其余IDC上连电路。

原则二:利用私有云资源,搭建SDN控制器硬件能力。

利用私有云资源池硬件资源,满足控制器计算、存储、备份等需求。

原则三:规范控制器软件功能、接口技术要求等,便于两阶段建设的承载网络有效融合。

为满足两阶段建设的网络实现有效融合,规范域控制器和超级控制器南北向接口,软件功能、相关接口的定制开发应遵循技术标准规范。

4 技术方式及建设方案

进一步提升网络智能化,升级改造数据骨干网第一平面,实现P 设备支持SDN,增强业务开通、流量调度、网络维护及系统可靠性等方面能力。

改造全网BB/BC兼具P/PE 功能,优化网络架构,新增省份网PE,并将紧急试商用需求承载网络融入云专网;新建超级控制器,统一管理云专网域控制器,实现业务自开通、流量调优等功能;在此基础上,新增软件许可、集成开发及南北向接口软件扩展功能;若新增设备与先期网络不同厂商,需新建域控制器;利旧数据骨干网第一平面RR 作为云专网网络路由反射器,通过数据骨干网两个平面的连接疏通网管流量和SDN 控制器流量。具体SDN 功能如下:

(1)基于SDN 技术、TE 隧道(不接受LDP),实现用户自助分钟级开通;基于SDN 技术,实现用户自助分钟级开通;基于SR-TE(SRV4/SRV6),实现路径可编程;基于SDN 技术,实现带宽调整自助分钟级;基于SR Policy,实现用户细颗粒带宽调速。

(2)具备调优功能,基于带宽资源/时延实现调优;具备用户自助服务功能,实现自助开通,带宽随选。

(3)具备360 可视功能,实现VPN/隧道图形化可视,以及指标、故障360 度完整呈现;具备路径可视功能,基于TE 隧道实现用户的路径可视化;具备自愈功能,实现隧道自愈;具备故障仿真功能,实现对网络健壮性做主动性检测;具备流量仿真功能,实现对网络性能做主动性检测;具备秒级监控功能,基于Telemetry 实现指标实时监控。

5 功能架构

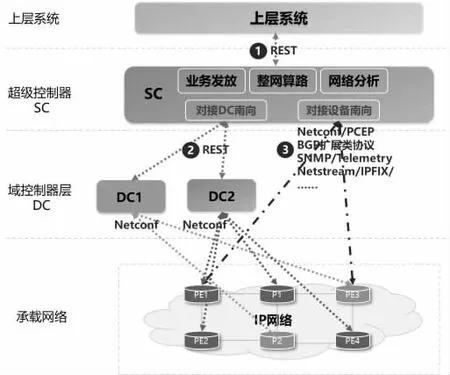

在当前SDN架构下,域控制器(DC)和超级控制器(SC)须协同工作共同构建完整SDN架构,单独域控制器或超级控制器无法实现系统全部功能。DC可以集成在SC内部,以内部驱动方式提供。

DC负责域内厂家设备纳管,实现存量发现和Netconf翻译。

SC实现业务发放管理、整网算路、网络分析功能全集,配置下发可以通过DC下发,不强制要求SC支持和设备的Netconf 配置接口。其他所有协议均为SC直对设备。其技术架构见图2。

图2

6 路由组织策略

6.1 域内路由协议

数据骨干网采用IS-IS 协议,所有链路在1 个Level-2 Area内。数据骨干网承载方式为IPv4/IPv6 双栈,可以提供在骨干网的IPv6 业务接入能力;数据骨干网选择IS-ISv6 作为承载IPv6 路由的IGP 协议,骨干网网内所有路由器和交换机设备均需启用IS-ISv6、运行多拓扑,并设置为Level-2。

6.2 域间路由协议

数据骨干网与国际、国内互联网之间运行BGP-4 路由协议。数据骨干网骨干节点路由器之间建立IBGP 邻居,为了减少IBGP邻居数量,采用路由反射技术。采用RR 分设方式,各自独立设置多对BGP-RR,多对RR 间建立Full-mesh IBGP 邻居,第一第二平面互不通告路由。数据骨干网与省网之间运行BGP-4 路由协议。

数据骨干网承载方式为IPv4/IPv6 双栈,骨干网网内所有路由器设备均需启用基于IPv6 的BGP4+路由协议。

6.3 双跨城域网和骨干网之间的路由策略

满足阈值的城域网可同时接入省网汇接节点和骨干网节点,以减少对省网汇接路由器背靠背端口的占用,推进网络结构的扁平化。路由策略规划如下:

(1)骨干网第二平面到城域网。仅将接入骨干网第二平面的省网、城域网、IDC路由发布给城域网。

(2)骨干网第一平面到城域网。仅将接入骨干网第一平面的省网、城域网、IDC路由发布给城域网。

(3)省网到城域网。仅将本地省网路由、缺省路由发布给城域网。

6.4 省内IDC网络和骨干网之间的路由策略

省内IDC直连骨干网时,优选第二平面;原双跨接入骨干网和省网的IDC可双跨骨干网的两个平面。对于双跨骨干网两个平面、省网的省内IDC出省网流量,若流量目标在骨干网第二平面,原则上优选第二平面疏导;若流量目标在骨干网第一平面,则通过第一平面直接疏导。对仅双跨骨干网第二平面、省网的IDC,若流量目标在第二平面,原则上优选第二平面疏导;若流量目标在第一平面,则通过省网汇接节点转接到骨干网第一平面疏导。路由策略如下:

(1)骨干网第二平面到IDC网络。仅将接入第二平面的省网、城域网、IDC路由发布给IDC网络。

(2)骨干网第一平面到IDC网络。仅将接入第一平面的省网、城域网、IDC路由发布给IDC网络。

(3)省网到IDC网络。仅将本地省网路由、缺省路由发布给IDC网络。

7 安全、可靠性方案

(1)支持两套不同物理位置的主备控制器容灾保护,单控制器故障时可快速恢复服务,支持主备站点同步机制。

(2)支持本地HA 保护方案,通过集群或主备方式实现微服务模块的高可靠保护。

(3)支持通过自动备份策略配置来实现全系统的备份恢复;支持通过手动导出数据方式进行数据备份。

(4)支持配置全节点事务一致性,当进行业务配置时,如果中间节点出现异常,支持配置回滚。

(5)支持与统一的账号管理中心对接,支持账号、认证、鉴权的统一管理,实现一套账号能够登录所有相关子系统,降低使用成本。

8 结论

引入SDN 新技术,可提高全网流量集中调度能力,提升网络的智能化水平;同时满足云互联/云专线等新兴业务对承载网提出按需配置、快速发放、能力开放等更高的网络要求。