基于CMT的红外可见融合跟踪算法

刘轶伦 奚峥皓

摘 要:现有大部分融合跟踪算法都使用分类器型跟踪算法,这种算法在目标尺度发生变化时会存在一定误差。虽然已有一些解决方案,但仍不能从根本上解决该问题,而且一般无法估算目标的旋转状态。为此,基于CMT算法提出一种新的基于点的多传感器融合跟踪算法。在获取目标状态上综合了多传感器信息,并对目标中心使用卡尔曼滤波进行修正,能够跟踪目标并获得目标的尺度及旋转信息。实验结果表明,该算法在常见分辨率下跟踪非旋转目标,重叠率与现有算法相当,在分辨率较高的情况下,在实时性上具有优势。

关键词:融合跟踪;CMT;红外视频;可见视频;特征点

DOI:10. 11907/rjdk. 192043 开放科学(资源服务)标识码(OSID):

中图分类号:TP317.4 文献标识码:A 文章编号:1672-7800(2020)007-0210-05

Infrared Visible Fusion Tracking Algorithm Based on CMT

LIU Yi-lun,XI Zheng-hao

(School of Electronic and Electrical Engineering, Shanghai University of Engineering Science, Shanghai 201620, China)

Abstract: Most of the fusion tracking algorithms use the classifier-type tracking algorithm. This algorithm has certain errors when the target scale changes. Although there are certain solutions, it can not be solved fundamentally, and generally can not estimate the rotation state of the target. In order to solve these problems, a new point-based multi-sensor fusion tracking algorithm based on CMT is proposed. The multi-sensor information is integrated on the acquisition target state, and the target center is corrected by using Kalman filtering, and the target can be tracked and the scale and rotation information of the target can be obtained. Experiments show that the algorithm tracks non-rotating targets at common resolutions and the overlap ratio is comparable to existing algorithms, and it has advantages in real-time performance at higher resolutions.

Key Words: fusion tracking; CMT; infrared videos;visible video; feature point

0 引言

目標跟踪一直是计算机视觉的研究热点之一,在军事、医学、监控等多个领域都应用广泛。一般使用可见光摄像头作为目标跟踪的图像源,但在光照条件恶劣的环境下,可见光图像会丢失一定的场景信息。热红外传感器能适应光照条件恶劣的环境,但其具有亮度、对比度与清晰度低,以及缺乏丰富的颜色纹理信息等缺点[1]。因此,需要综合利用不同传感器信息,以获得更好的跟踪效果。

已有很多学者对融合跟踪进行了研究,如文献[2]提出一种基于多视图多核融合模型的可见光与红外融合跟踪算法,该模型考虑了可见光与红外视图的多样性,并嵌入了来自它们的补充信息;文献[3]在彩色图像基础上,通过核函数建立红外目标模型的颜色直方图,采用粒子滤波算法实现对红外目标的稳定跟踪;文献[4]设计联合稀疏表示相似结构,构造粒子滤波跟踪器的似然函数,可以融合彩色可见光谱与红外热图像进行目标跟踪。其中文献[3]属于基于像素级融合的跟踪,在跟踪步骤之前执行融合,文献[2]、[4]属于基于特征级融合的跟踪,特征级融合跟踪不直接对图像进行融合,而是通过跟踪器从各种图像源中提取有效特征,将原始图像数据转换为更具信息性的表达,确保成功使用不同模态之间的自然互补性,在提取特征之后结合不同模态特征分析目标运动状态,因此比其它级别更适用于跟踪[5]。

现有大部分融合跟踪算法都使用分类器型跟踪算法,但这种算法在目标尺度或旋转状态发生变化时会存在一定误差。文献[6]提出的SAMF(A Scale Adaptive Kernel Correlation Filter Tracker with Feature Integration)算法,利用图像金字塔方法解决目标尺度变换问题,但存在运算速度慢,且无法精确处理目标旋转的问题。基于特征点的跟踪算法能够很好地处理目标尺度变换及旋转问题,一般属于生成类算法;文献[7]提出一种基于关键点匹配与超像素匹配的跟踪方法,该方法不仅使用对象的初始特征信息,还使用相邻帧之间的特征信息;文献[8]采用两阶段匹配方法提高SURF(Speeded Up Robust Features)匹配点的准确性,并使用模板更新方法解决对象外观变化的问题。但目前针对基于特征点的红外可见融合跟踪算法的研究还很少,因此本文提出一种基于CMT(Consensus-based Matching and Tracking of Keypoints for Object Tracking)[9]的红外可见融合跟踪算法,并使用卡尔曼滤波估计目标运动状态。

1 改进CMT算法

1.1 算法原理

跟踪是指使用图像信息估计目标状态,本文图像信息为红外与可见光连续图像序列[{I(t),V(t)}],由于红外图像与可见光图像序列不一定在几何上对齐,因此需要对其进行配准[10],其中[I(t)]与[V(t)]是指经过配准在几何上已对齐的图像。需要估计的目标状态包括中心[ct=(xt,yt)]、尺度[st]与角度[at]。

在红外与可见光连续图像序列[{I(t),V(t)}]的图像各自第一帧[{I(0),V(0)}]中初始化目标,目标模型包括完全静态外观模型以及自适应模型,二者均由特征点表示[11],将其融合为两组特征点[Pt={Pvt,Pit}]作为目标模型,包括可见光图像特征点[Pvt={ptv1,?,ptvn}]与红外图像特征点[Pit={pti1,?,ptim}],用于描述目标可见光与红外部分的特征点数量分别为[nv]和[ni]。获取第[j]个特征点在第[t]帧点与第0帧点的匹配关系称为[mtj=(p0j,ptj)],则存在匹配集[Lt={Lvt,Lit}],[Lt={m1,?,mnv+ni}],包括可见光匹配集[Lvt={mv1,?,mvnv}]与红外匹配集[Lit={mi1,?,mini}] 。

1.2 点匹配与跟踪

靜态外观模型在[t]帧的匹配[Lst]依靠第[0]帧静态外观模型的特征匹配,每一个特征点[ptj]都具有其对应的特征描述子[dtj]。静态外观模型需要在目标发生任何改变时,特征点仍能被正确匹配。使用FAST[12](Features from Accelerated Segment test)作为特征点检测器,BRISK[13](Binary Robust Invariant Scalable Keypoints)作为特征描述子,分别在各自的图像中按照第二最邻近距离标准搜索[p0j] 在对应视频[t] 帧的匹配点[ptj][14]。第二最邻近距离标准即在[t]帧图像下,搜索与特征描述子距离最近的两个点,其特征描述子称为[dtj]、[dtk],若满足等式(1),则认为[p0j]与[ptj]匹配成功。

其中[θ]、[γ]均为阈值,搜索采用快速最近邻搜索包(FLANN,Fast Library for Approximate Nearest Neighbors)方法。

自适应模型在[t]帧的匹配[Lat]依靠对[t-1]帧目标特征点的跟踪,假设特征点都满足LK光流法[15]条件,即运动物体灰度在很短的时间间隔内保持不变,且给定邻域内的速度向量场变化缓慢,则自适应模型的匹配通过LK光流跟踪产生,并采用前后向误差[16]滤除错误匹配关系。

依靠静态模型优先原则[17-18],融合[Lst]与[Lat]获得初步的匹配集[Lt]。

1.3 状态估计

首先借助初步匹配集[Lt]中的匹配对[mtj]、[mtk],获得尺度[st]与角度[αt],当[mtj]来自可见光时,[mtk]也来自可见光。该规则对红外特征点同样适用,即选取点对可同时由可见光图像或红外图像检测出,并定义点对向量如式(2)所示。

对于尺度[st]的求取,使用[ltjk]表示求取[ptj]与[ptk]的欧氏距离。为了保证尺度求取对异常值的鲁棒性,选择所有比例的中位数作为目标尺度,即满足式(3)。

对于尺度[αt]的求取,[atan2(ltjk)] 指求取[ltjk]的向量角[9],[αt]满足等式(4)。

等式(3)、(4)的算法复杂度为[O(n2)],其中[n]取决于特征点总量,在[n]过多时,会在一定程度上影响计算速度。对于本文算法而言,由于存在红外与可见光两个目标模型,若简单代入将使复杂度增加,即[O(n2),(n=ni+nv)],采用仅来自同类图像的点对求取[ltjk],并统计与[ltjk]相关的值,则能够使复杂度变为:[O(n2),(n=max(ni,nv))]。

可以获得包括尺度和旋转的映射矩阵[Ht],如式(5)所示。

每对[mtj]、[mtk]映射一个目标的中心[19],通过聚类求取目标中心[ct],同时通过聚类结果去除错误匹配,并获得正确匹配集[L*t]。定义每组投票向量之间的差异[Dt],并由此构成距离矩阵[19],用于反映目标的变形状态,[Dt]被定义为式(6)。

同时,定义投票集合[19]如式(7)所示。

对[Ut]使用凝聚聚类[20]分割[Lt],假设最大的聚类簇[L+t]反映正确的匹配,其余簇均为错误匹配。

中心偏移度[μ]由[L+t]内包含的点决定,即由满足正确跟踪的内点决定,由于[L+t]中匹配的点对包括红外的点以及可见光的点,因此可被分割为红外匹配集[L+it]与可见光匹配集[L+vt]。[μ]的求取如式(8)所示。

则目标中心[ct=(xt,yt)]根据时间的变换可以表示为[ct=c0+μ],其中[c0]表示初始目标中心。

2 运动状态修正

目标中心[ct]在[t]时刻的状态包括目标位置[xt]、[yt]及速度[xt]、[yt],则目标状态向量被表示为式(9)。

目标运动模型可以被表示为式(10)、(11)。

其中[Yt]即为观测到的目标坐标,[Wt]表示在[t]时刻存在的噪声。假设噪声满足卡尔曼滤波条件,即假设[Wt=][Kt(Yt-CX-t)]。

使用卡尔曼滤波[21]求取运动状态及其噪声,满足式(12)-(16)。

式(12)借助[t-1] 帧的运动模型对当前帧运动结果进行预测,式(13)结合预测修正观测值,式(14)用于计算卡尔曼增益,式(15)、(16)对噪声进行预测。其中[Q]、[R]表示协方差矩阵,根据实验实际情况进行选取。通过式(12)-(16)获得经过卡尔曼滤波修正后的目标中心状态[Xt],最后再根据式(9)得到最终估计的目标位置[ct]。

3 主循环流程

在进入主循环前,首先对目标进行手动框选,并在框内初始化目标模型[{p0j}]及背景模型。主循环使用[t-1]帧的目标模型信息[{pt-1j}],估计[t] 帧的目标模型信息[{ptj}],同时计算目标中心[ct=(xt,yt)]、尺度[st]与角度[at]。本文方法主循環流程如下:

主循环流程

输入: 红外图像序列[I(t)],可见光图像序列[V(t)]

输出: 目标中心[ct],尺度[st] ,角度[at]

1 While (图像序列未结束)

2 读取[I(t)]、[V(t)]

3 获取与静态外观模型的匹配[Lst]

4 获取与自适应模型的匹配[Lat]

5 融合[Lst]、[Lat]获得[Lt]

6 通过式(2)-(5)获得[st] 、[at],进而求取[Ht]

7 通过式(6)、(7)获得[Dt]、[Ut]

8 对[Ut]聚类分割[Lt]获得[L+t]

9 通过式(8)求取中心[ct]

10 按式(9)-(16)对[ct]使用卡尔曼滤波,获得修正后的中心[ct]

18 End while

4 实验与结果分析

本文算法在文献[18]提供的开源代码上进行修改,并在cpp+opencv2.14中实现了多模态的跟踪算法,本文实验环境使用的CPU为I5CPU,频率为2.60GHZ,内存为4G。其中参数设置与文献[18]相同,采用默认设置。

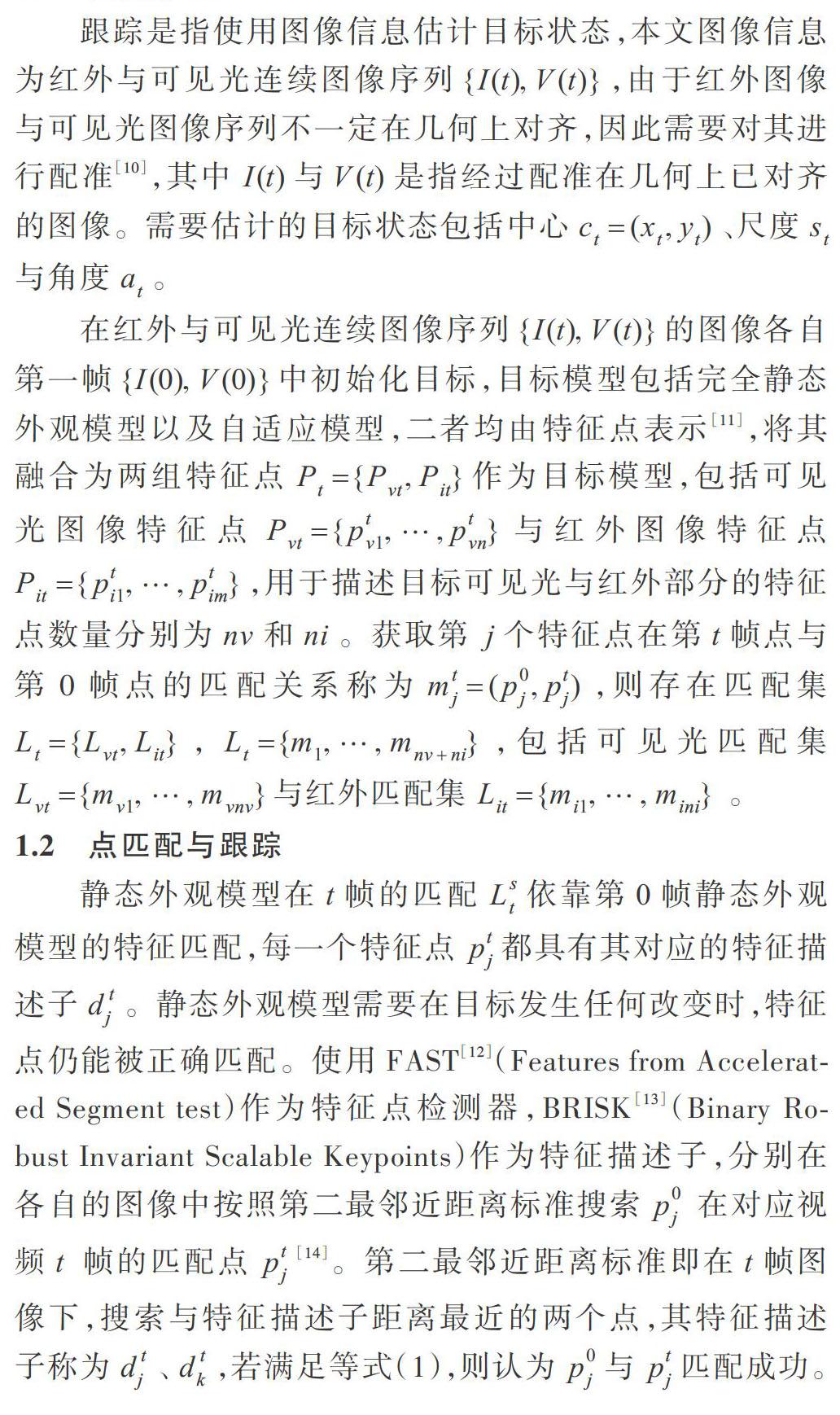

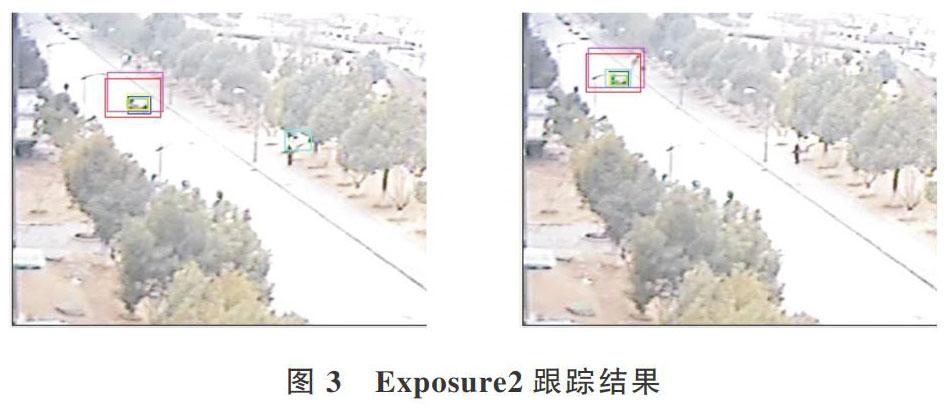

文献[22]总结了大多数公共红外和可见光图像序列数据集以及融合跟踪方法。本文使用该数据集以及对比的融合跟踪方法,但该数据集中未能测试旋转目标的视频序列,因此本文也使用了部分自行拍摄的数据集。在数据集[22]跟踪图像的标注框及重叠率表中,用红色表示STRUCK(Structured Output Tracking with Kernels)算法,青色表示TLD(Tracking-Learning-Detection)算法,紫色表示KCF(High-Speed Tracking with Kernelized Correlation Filters)算法,黄色表示SAMF算法,绿色表示本文算法,蓝色表示地面实况。

跟踪器输出[bt]表示为一个矩形,由[ct]、[st]进行求取,[bt]与目标基准位置数据[bGt]获得标准重叠率[?],如式(17)所示。

4.1 文献[22]数据集实验与结果分析

本节选取数据集[22]中名称为BlackCar与Exposure2的图像序列进行实验,两者尺寸均为[384×288],跟踪目标均为车辆,跟踪结果如图2、图3所示(彩图扫描OSID码可见)。

根据每帧重叠率能够获得重叠率—帧的图像如图4、图5所示(彩图扫描OSID码可见),坐标中横轴表示图像序列的帧序号,纵轴表示帧对应的重叠率。

由于本文算法能够适应目标发生的尺度变化,因此与没有尺度变化的跟踪器如KCF和STRUCK算法相比,在重叠率上具有显著优势。针对BlackCar数据,除SAMF外的大部分跟踪器均在目标受遮挡后发生错误,导致重叠率下降,但本文跟踪器由于静态模型的作用,在丢失目标后仍能再次成功跟踪,表现为后期重叠率上升;针对Exposure2数据,本文算法能够获得与SAMF接近的跟踪效果,而TLD算法却在部分帧上丢失了目标。

4.2 自行拍摄数据集实验与结果分析

本节使用自行拍摄的红外与可见光视频进行实验,图像序列尺寸为[704×576],目标为视频中出现的手。由于缺乏客观、合适的目标基准位置数据,因此不使用重叠率进行比较,仅展现跟踪的框选效果。本节跟踪目标中心使用[ct],而非修正后的[ct]。

在分辨率较高的视频下,本文算法在实时性上体现出优越性,每帧平均花费时间少于其它算法,如表1所示。

由于STRUCK与TLD算法的运算实时性较差,KCF不存在尺度检测,因此仅与SAMF跟踪效果进行对比。蓝色表示本文算法,绿色表示SAMF算法,如图6所示(彩图扫描OSID码可见),带旋转检测的本文算法相比SAMF算法能更准确地跟踪目标。

5 结语

本文在CMT跟踪算法框架下进行扩展,提出一种多传感器的CMT跟踪算法,同样采用对应聚类作为区分内部与外部关键点的中心思想。在目标尺度、旋转、中心的估计上结合了多传感器信息,并使用卡尔曼滤波对目标中心进行修正,解决了传统融合跟踪算法无法高效估计目标尺度、旋转变化等问题。实验结果表明,本文算法在常见分辨率下跟踪不旋转的目标,重叠率与现有算法相当,在较高分辨率下,本文算法在实时性上具有优势。在未来研究工作中,可以对目标的运动模型进行优化,使之适应更复杂的运动目标。

参考文献:

[1] GADE R, MOESLUND T B. Thermal cameras and applications: a survey[J]. Machine Vision and Applications, 2014,25(1SI):245-262.

[2] YUN X,JING Z,JIN B. Visible and infrared tracking based on multi-view multi-kernel fusion model[J]. Optical Review, 2016,23(2):244-253.

[3] LI W,PAN F,XIAO Y, et al. Infrared target tracking based on color fusion image and particle filter[C]. International Conference on Instrumentation Measurement Computer Communication and Control,2015:1424-1428.

[4] LIU H,SUN F. Fusion tracking in color and infrared images using joint sparse representation[J]. Science China-Information Sciences, 2012,55(3):590-599.

[5] LUO C,SUN B, DENG Q, et al. Comparison of different level fusion schemes for infrared-visible object tracking: an experimental survey [C]. Wuhan:The 2nd International Conference on Robotics and Automation Sciences,2018.

[6] LI Y,ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[M]. Lecture Notes in Computer Science,2015:254-265.

[7] SHEN M,ZHANG Y,WANG R, et al. Robust object tracking via superpixels and keypoints[J]. Multimedia Tools and Applications, 2018,77(19):25109-25129.

[8] ZHOU D, HU D. A robust object tracking algorithm based on SURF[C]. Hangzhou: International Conference on Wireless Communications and Signal Processing,2013.

[9] NEBEHAY G,PFLUGFELDER R. Clustering of static-adaptive correspondences for deformable object tracking[C].IEEE Conference on Computer Vision and Pattern Recognition, 2015:2784-2791.

[10] BARBARA ZITOVá,FLUSSER J. Image registration methods: a survey[J]. Image and Vision Computing,2003,21(11):977-1000.

[11] SANTNER J,LEISTNER C,SAFFARI A,et al. PROST: parallel robust online simple tracking[C]. IEEE Conference on Computer Vision and Pattern Recognition,2010:723-730.

[12] ROSTEN E,PORTER R,DRUMMOND T. Faster and better: a machine learning approach to corner detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(1):105-119.

[13] LEUTENEGGER S, CHLI M, SIEGWART R Y. BRISK: binary robust invariant scalable keypoints[C].IEEE International Conference on Computer Vision, 2011:2548-2555.

[14] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2):91-110.

[15] LUCAS B D,KANADE T. An iterative image registration technique with an application to stereo vision [C]. Proceedings of the International Joint Conference on ArtificialIntelligence,1997:674-679.

[16] KALAL Z,MIKOLAJCZYK K,MATAS J. Forward-backward error: automatic detection of tracking failures[C]. The 20th International Conference on Pattern Recognition,2010:?2756-2759.

[17] SANTNER J, LEISTNER C, SAFFARI A, et al. PROST: parallel robust online simple tracking[C].IEEE Conference on Computer Vision and Pattern Recognition, 2010:723-730.

[18] NEBEHAY G, PFLUGFELDER R. Clustering of static-adaptive correspondences for deformable object tracking[C].IEEE Conference on Computer Vision and Pattern Recognition,2015:2784-2791.

[19] 閆旭伟. CMT目标跟踪算法研究与异构系统实现[D].西安:西安电子科技大学,2017.

[20] XU R,WUNSCH D C. Survey of clustering algorithms[J]. IEEE Transactions on Neural Networks, 2005, 16(3):645-678.

[21] 谢泽奇,张会敏,张佳佳,等. 复杂背景下的快速机动目标跟踪算法[J]. 传感器与微系统,2018,37(5):132-134.

[22] LUO C,SUN B, DENG Q,et al. Comparison of different level fusion schemes for infrared-visible object tracking: an experimental survey [C]. Wuhan:The 2nd International Conference on Robotics and Automation Sciences, 2018.

(责任编辑:黄 健)