NVIDIA GTC 2020大会:众多技术新品助力各行业AI技术发展

策划| 《智能制造》编辑部

2020年5月14日,NVIDIA的GTC 2020主题演讲正式上线。受新冠肺炎疫情影响,原定于2020年3月下旬在旧金山举办的GTC 2020大会不得不延期,并改在NVIDIA创始人兼首席执行官黄仁勋家的厨房中在线举行。黄仁勋依然以一身黑色皮衣出场,只是头发较往常长了不少。在线上演讲开始前的采访中,已在家工作了超过45天的黄仁勋笑称, “你们明天一定认不出我的”。

GTC大会是NVIDIA每年最重要的新品发布平台之一。这场主题演讲虽然经历了延期,还从会展中心改在了CEO的家里,但不可否认它仍然是NVIDIA和全球GPU、AI技术应用的年度重头戏。在主题演讲中,黄仁勋谈及了NVIDIA发展的各个主要方面,包括图形显卡、数据中心、AI技术、医疗,甚至还有最新收购进来的网络互联业务等。

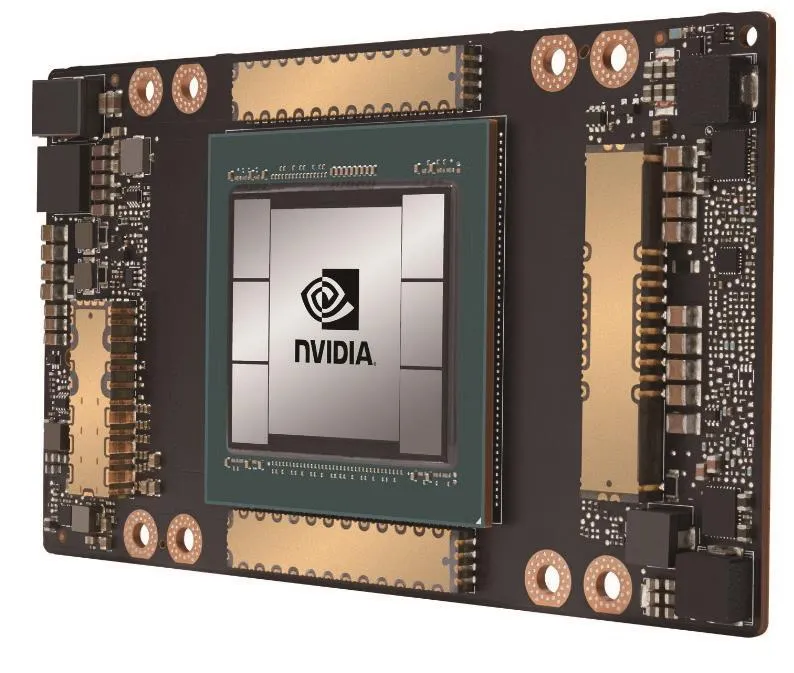

NVIDIA全新Ampere数据中心GPU全面投产

在本次GTC 2020宣布的产品中,最重磅的即是这款重达50磅的史上最大GPU——首款基于NVIDIA Ampere架构的NVIDIA A100。

NVIDIA A100采用了NVIDIA Ampere架构的突破性设计,该设计为NVIDIA第八代GPU提供了迄今为止最大的性能飞跃,集AI训练和推理于一身,并且其性能相比于前代产品提升了高达20倍。作为一款通用型工作负载加速器,A100还被设计用于数据分析、科学计算和云图形。

NVIDIA创始人兼首席执行官黄仁勋表示:“云计算和AI发展的强劲势头正在推动数据中心设计的结构性转变,过去的纯CPU服务器正在被高效的加速计算基础架构所取代。NVIDIA A100 GPU作为一个端到端的机器学习加速器,其实现了从数据分析到训练再到推理整个过程较前代产品提速20倍的AI性能飞跃。这是NVIDIA首次在同一个平台上实现对横向扩展以及纵向扩展负载的加速。NVIDIA A100将在提高吞吐量的同时,降低数据中心的成本。”

A100所采用的全新弹性计算技术能够为每项工作分配适量的计算能力。多实例GPU技术可将每个A100 GPU分割为多达七个独立实例来执行推理任务,而第三代NVIDIA NVLink互联技术能够将多个A100 GPU合并成一个巨大的GPU来执行更大规模的训练任务。

众多全球领先的云服务供应商和系统构建商正在计划将A100 GPU集成到其产品中,其中包括:阿里云、AWS、Atos、百度智能云、思科、Dell Technologies、富士通、技嘉科技、Google Cloud、新华三、HPE、浪潮、联想、Microsoft Azure、甲骨文、Quanta/QCT、Supermicro和腾讯云。

A100的五大突破

NVIDIA A100 GPU的突破性技术设计来源于五大关键性创新。

◎ NVIDIA Ampere架构:A100的核心是NVIDIA Ampere GPU架构,该架构包含超过540亿个晶体管,这使其成为全球最大的7纳米处理器。

◎ 具有TF32格式的第三代Tensor Core核心:NVIDIA第三代Tensor Core将变得更加灵活、快速且易于使用。其功能经过扩展后加入了专为AI开发的全新TF32格式,它能在无需更改任何代码的情况下,使FP32精度下的AI性能提高多达20倍。此外,Tensor Core核心现在支持FP64精度,相比于前代,其为HPC应用所提供的计算力比之前提高了多达2.5倍。

◎ 多实例GPU:全新在MIG技术可以将单个A100 GPU分割为多达七个独立的GPU,为不同规模的工作提供不同的计算力,以此实现利用率和投资回报率的最大化。

◎ 第三代NVIDIA NVLink:使GPU之间的高速联接增加至原来的两倍,实现服务器的高效性能扩展。

◎ 结构化稀疏:利用AI数学固有的稀疏性,可以使GPU性能提升了一倍。

凭借这些新功能,NVIDIA A100将成为AI训练和推理以及科学模拟、对话式AI、推荐系统、基因组学、高性能数据分析、地震建模和金融预测等各种高要求工作负载的理想选择。

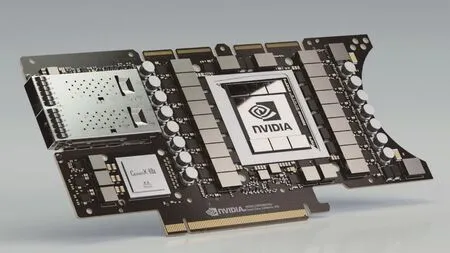

NVIDIA DGX A100新系统已搭载NVIDIA A100,很快将登陆云端

与NVIDIA A100同时发布的还有NVIDIA DGX A100系统,内置8个由NVIDIA NVLink互联的NVIDIA A100 GPU。目前阿里云、AWS、百度智能云、Google Cloud、Microsoft Azure 、甲骨文和腾讯云正在计划提供基于A100的服务。

此外,众多全球领先的系统制造商也将提供各种基于A100的服务器,包括Atos、思科、Dell Technologies、富士通、技嘉科技、新华三、HPE、浪潮、联想、Quanta/QCT和Supermicro。

为帮助合作伙伴加快服务器的开发,NVIDIA开发了HGX A100服务器构建模块,该模块采用了多GPU配置的集成基板形式。

HGX A100的4-GPU版通过NVLink实现GPU之间的完整互联,8-GPU版配置的HGX A100通过NVIDIA NVSwitch实现GPU之间的全带宽通信。采用全新MIG 技术的HGX A100能够被分割为56个小型GPU,每个GPU的速度都比NVIDIA T4更快;或者也可以将其用作一台拥有10petaflops AI性能的巨型8-GPU服务器。

DGX A100系统集成了8个全新NVIDIA A100 Tensor Core GPU,具有320GB内存,用以训练最大型的AI数据集,以及最新的高速NVIDIA Mellanox HDR 200Gbps互连。

利用A100的多实例GPU功能,每台DGX A100系统能够被分割为多达56个实例,用于加速多个小型工作负载的处理速度。凭借这些功能,企业可在一个完全集成的软件定义平台上根据自己的需求优化计算力和资源,加快数据分析、训练和推理等各种工作负载的速度。

NVIDIA打造新一代DGX SuperPOD,性能达700 Petaflops

NVIDIA还展示了新一代DGX SuperPOD。该集群由140台DGX A100系统组成,AI计算能力高达700Petaflops。利用Mellanox HDR 200Gbps InfiniBand互连技术,NVIDIA将140台DGX A100系统结合在一起,构建了DGX SuperPOD AI超级计算机,用于公司内部对话式AI、基因组学和自动驾驶等领域的研究。

为帮助客户构建他们自己的由A100赋能的数据中心,NVIDIA发布了全新DGX SuperPOD参考架构。该参考架构为客户提供了指引蓝图,使客户能够参照NVIDIA所采取的设计原则和最佳实践经验,构建他们自己的基于DGX A100的AI超级计算集群。

DGXpert计划与DGX-Ready软件

NVIDIA还推出了NVIDIA DGXpert计划,帮助DGX客户与NVIDIA的AI专家建立联系;此外还有NVIDIA DGX-Ready 软件计划,帮助客户在AI工作流程中充分利用各种经过认证的企业级软件。

DGXpert计划将聚集一批精通AI的专家。他们可以帮助指导客户完成从计划、实施到持续优化的整个AI部署流程,还可以帮助DGX A100客户构建和维护最先进的AI基础架构。

NVIDIA DGX-Ready软件计划可帮助客户快速找到和使用经NVIDIA测试的第三方MLOps软件,帮助客户提高数据科学生产效率、加速AI工作流程并增加AI基础架构的可访问性和利用率。该计划的首批NVIDIA认证合作伙伴有:Allegro AI、cnvrg.io、Core Scientific、Domino Data Lab、Iguazio 和 Paperspace。

DGX A100 技术规格

◎ 8个NVIDIA A100 Tensor CoreGPU,AI性能达5Petaflops,GPU内存共320GB,有着每秒12.4TB的带宽。

◎6个采用第三代NVIDIA NVLink技术的NVIDIA NV Switch互联结构,4.8TB每秒的双向带宽。

◎ 9个Mellanox ConnectX-6 HDR 200Gb/s网络接口,提供总计每秒3.6TB的双向带宽。

◎Mellanox网络计算和网络加速引擎,例如RDMA、GPUDirect, 以 及 SHARP技 术(Scalable Hierarchical Aggregation and Reduction Protocol),实现最高性能和可扩展性。

◎ 15TB Gen4 NVMe内存,速度比Gen3 NVMe SSDs快2倍。

NVIDIA DGX软件堆栈,其中包括专为AI和数据科学工作负载而优化的软件,能够实现性能的最大化,使企业能够更快获得AI基础架构投资回报。

一个由5台DGX A100系统组成的机架可代替一个包括了AI训练和推理基础设施的数据中心,而且功耗仅是其1/20,所占用的空间是其1/25,成本是其1/10。

A100软件优化

针对A100,NVIDIA还发布了多个软件堆栈更新,使应用程序开发者能够充分发挥A100 GPU创新技术的性能。这些更新包括了50多个新版本CUDA-X库,可用于加速图形、模拟和AI;CUDA 11;多模态对话式AI服务框架NVIDIA Jarvis;深度推荐应用框架NVIDIA Merlin;以及NVIDIA HPC SDK,其中包括能够帮助HPC开发者调试和优化A100代码的编译器、库和工具。

目前,基于NVIDIA Ampere架构的NVIDIA A100已全面投产并向全球客户交付。

NVIDA HPC SDK加速HPC应用开发

NVIDIA HPC SDK是一款用于编程加速计算系统的全套集成SDK综合套件,包含编译器和库。HPC开发者可通过它来编程整个HPC平台,从GPU基础到CPU以及整体互联。该款SDK的首个通用版本计划于2020年夏末发布。

NVIDIA HPC SDK C ++和Fortran编译器是首批同时支持C ++ 17并行算法和Fortran内联函数等标准语言结构自动GPU加速的编译器。

NVIDIA HPC SDK为GPU加速应用程序带来了以下新功能和性能优化。

◎ NVIDIA Fortran、C和C ++编译器可以使用GPU加速数学库,事实标准OpenACC和OpenMP并行指令,以及CUDA实现异构CPU + GPU服务器并行应用程序的移植、编写和调试。

◎ NVIDIA数学库为HPC基础线性代数和信号处理算法提供了高度优化的嵌入式GPU加速。除了为GPU加速提供方便的入口匝道之外,数学库还为支持的例程提供了更高的性能,并使用户能够自动获取包括最新A100 GPU在内的新型GPU架构的支持。

◎ 全新NVSHMEM库提供了可以从主机或设备启动,并可以在CUDA内核和OpenACC程序中调用的多GPU和多节点通信原语。 NVSHMEM为GPU内存实施OpenSHMEM标准,并可以通过扩展提高GPU的性能。

◎ NVIDIA Nsight计算和Nsight系统是适用于OpenMP和OpenACC中多核CPU应用程序以及OpenACC和CUDA中GPU加速应用程序的性能分析工具(目前,并非每个平台都支持所有功能)。

◎ NVIDIA调试器可以以OpenACC、OpenMP和MPI高级别第三方调试器的基础,调试CUDA应用程序。

◎ HPC容器制造商简化了构建和维护Docker和Singularity容器的过程。

NVIDIA EGX边缘AI平台将实时AI带入制造、零售、电信和医疗等行业

在边缘计算领域,NVIDIA发布了两款性能强大的EGX边缘AI 平台产品:适用于较大型商业通用服务器上的EGX A100,和适用于微型边缘服务器的微型EGX Jetson Xavier NX。这两款产品能够在边缘端提供安全、高性能的AI处理能力。

借助于NVIDIA EGXTM边缘AI平台,医院、商店、农场和工厂可以实时处理和保护来自数万亿个边缘传感器的海量数据流。该平台实现了服务器群的远程安全部署、管理和更新。

EGX A100聚合加速器和EGX Jetson Xavier NX微型边缘服务器分别被设计用于满足不同尺寸、成本和性能需求。例如搭载了EGX A100的服务器可以管理机场中的数百台摄像头,而EGX Jetson Xavier NX则可用于管理便利店中的少量摄像头。而云原生技术支持能够确保整个EGX产品家族都可以使用同一经过优化的AI软件轻松构建和部署AI应用。

由NVIDIA Ampere架构赋能的EGX A100

EGX A100是首个基于NVIDIA Ampere架构的边缘AI产品。随着AI技术的关注点日益向边缘发展,企业机构可将EGX A100添加到其服务器中,从而实时处理和保护来自边缘传感器的海量流式数据。

EGX A100结合了NVIDIA Ampere架构所具有的突破性计算性能与NVIDIAMellanox ConnectX-6 Dx SmartNIC所具备的网络加速和关键性安全功能,能将标准型和专用型的边缘服务器转变为极具安全性的云原生AI超级计算机。

NVIDIA Ampere架构是NVIDIA的第8代GPU架构,为在边缘运行AI推理和5G应用等各类计算密集型工作负载提供了有史以来最大的性能飞跃,使EGX A100可以实时处理来自摄像头和其他物联网传感器的大量流式数据,从而更快地获得洞见并提高业务效率。

借助NVIDIA Mellanox ConnectX-6 Dx板载网卡,EGX A100可以每秒接收高达200 Gb的数据并将其直接发送到GPU内存以进行AI或5G信号处理。EGX A100作为一个云原生软件定义加速器,可以处理对延迟最敏感的5G应用,为单位个行动点(如:商店、医院和工厂车间)的智能实时决策提供了高性能的AI和5G平台。

体积虽小,但性能强大的EGX Jetson Xavier NX

EGX Jetson Xavier NX是一款体积小巧、性能强大的AI超级计算机,适用于微型服务器和边缘智能物联网盒。目前,其生态圈内的合作伙伴已提供了超过20种解决方案。该产品将NVIDIA Xavier SoC的性能整合到了一个信用卡大小的模块中。运行EGX云原生软件堆栈的EGX Jetson Xavier NX可以快速处理来自多个高分辨率传感器的流式数据。

该高效节能的模块能够在15W功率下提供最高21TOPS的计算力,或在10W功率下提供最高14TOPS的计算力。因此,EGX Jetson Xavier NX为嵌入式边缘计算设备开启了大门——此类设备需要通过提高性能来支持AI工作负载,但同时又受限于尺寸、重量、功耗预算或成本等因素。

经过完整优化的跨EGX边缘AI平台云原生软件

EGX边缘AI平台的云原生架构使其可以运行容器化的软件,以支持一系列GPU加速的工作负载。

NVIDIA应用框架包括了用于医疗领域的Clara、用于电信领域的Aerial、用于对话式AI领域的Jarvis、用于机器人技术领域的Isaac,以及用于零售、智慧城市和交通等领域的Metropolis。它们可以组合使用或单独使用,为各种边缘应用场景开辟了新的可能性。

目前整个NVIDIA EGX产品家族均支持云原生技术,因此智能机器制造商和AI应用开发者们可以在嵌入式及边缘设备上构建和部署针对机器人技术、智慧城市、医疗以及工业物联网等领域先进的软件定义功能。

来自全球EGX生态圈的支持

全球企业计算服务供应商如Atos、Dell Technologies、富士通、技嘉科技、HPE、IBM、浪潮、联想、Quanta/QCT和Supermicro目前均提供通过NVIDIA EGX软件启用的边缘服务器。ADLINK和Advantech等大型服务器和物联网系统制造商也提供此类服务器。

Whiteboard Coordinator、Deep Vision AI、IronYun、Malong和SAFR by RealNetworks等软件供应商可以使用这些服务器以及经过优化的应用框架来构建和部署用于医疗、零售、制造和智慧城市等领域的解决方案。

EGX A100将于2020年年底上市。基于EGX Jetson Xavier NX的即用型微型边缘服务器现已上市,可供希望大批量生产边缘系统的公司选购。

NVIDIA为全球领先的数据分析平台Apache Spark提速

NVIDIA宣布正在与开源社区合作,为Apache Spark 3.0带来端到端的GPU加速。Apache Spark 3.0是一个热门的分析引擎,被全球范围内超过50万名数据科学家用于大数据处理。

随着Spark 3.0发布的临近,数据科学家和机器学习工程师将能够把革命性的GPU加速应用于普遍使用SQL数据库操作进行的ETL(提取、转换和加载)数据处理工作负载中。并且,能够在同一Spark集群上处理AI模型训练任务,而无需将工作负载作为单独流程在单独的基础架构上运行。这样就可以对整个数据科学的处理流程进行高性能数据分析,对从数据湖到模型训练所涉及的数十、乃至数千TB的数据进行加速,而且无需对已被应用于本地和云端Spark应用程序的现有代码进行修改。

NVIDIA企业计算主管Manuvir Das表示:“数据分析是当今企业和研究者所面临最大的高性能计算挑战。从ETL到训练再到推理,整个Spark 3.0方案的原生GPU加速为用户提供了最终将大数据潜力与AI性能相连所需的性能和规模。”

NVIDIA GPU加速Spark中的ETL和数据传输

NVIDIA正在提供一种用于Apache Spark的全新开源RAPIDS加速器,帮助数据科学家提高其数据流程的端到端性能。该加速器能够将之前需要在CPU上运行的功能,转到GPU上运行,以发挥GPU的性能。

◎ 在无需更改任何代码的情况下显著提高Spark SQL和DataFrame的运行性能,从而加速Spark中的ETL数据流程。

◎ 无需独立的机器学习和深度学习集群,即可在相同的基础架构上加速数据准备和模型训练。

◎ 加速Spark分布式集群中各节点之间的数据传输性能。这些资源库使用UCF Consortium 的开源UCX(Unified Communication X)框架,并通过使数据直接在GPU内存之间移动来最大程度地减少延迟。

NVIDIA先进的AI系统NVIDIA DGX A100助力世界对抗COVID-19

NVIDIA推出的NVIDIA DGX A100是先进的第三代AI系统,具有高达5Petaflops 的AI性能,并且首次将整个数据中心的性能和功能集成到一个灵活的平台中。

DGX A100系统已开始向全球供应。首批订单将送往美国能源部(U.S. Department of Energy,DOE)的阿贡国家实验室(Argonne National Laboratory)。该实验室将运用该集群的AI和计算力来更好地研究和应对COVID-19。

NVIDIA创始人兼首席执行官黄仁勋表示:“NVIDIA DGX A100是专为先进AI打造的高性能系统。NVIDIA DGX是首个为端到端机器学习工作流——从数据分析到训练再到推理构建的AI系统。借助于全新DGX的巨大性能飞跃,面对呈指数级速度增长的AI模型和数据,机器学习工程师们能够保持领先。”

NVIDIA扩展NVIDIA Clara,联合全球医疗合作伙伴抗击COVID-19

在医疗方面,NVIDIA宣布了NVIDIA Clara医疗平台的一些重大拓展,包括性能的提升、主要合作伙伴关系和新的功能,旨在帮助医学界更好地追踪、测试和治疗COVID-19。

该平台集AI和加速计算于一身,可以帮助医疗研究人员、技术解决方案供应商和医院以全新的方式更快地应对疫情。

◎ 打破基因组测序速度记录:为COVID-19研究人员提供90天NVIDIA Clara Parabricks免费使用权限。该软件创造了在20分钟内完成整个人类基因组DNA序列分析的记录。

◎ 疾病检测AI模型:与美国国家卫生研究院(National Institutes of Health)共同开发的AI模型已经上线。该模型可帮助研究人员通过胸部CT扫描研究COVID-19的严重程度,并开发新的工具来更好地研究、评估病毒,并进行感染检测。

◎ 专为智能医院开发的NVIDIA Clara Guardian:NVIDIA Clara Guardian采用智能视频分析和自动语音识别技术,使新一代智能医院能够在尽量避免人员接触的同时,监测病人的生命体征。

NVIDIA医疗业务副总裁Kimberly Powell表示:“COVID-19疫情促进了科技、研究和医疗行业的进一步合作,共同开发新的计算解决方案,从而加快了解该疾病的传播方式、规模和严重性。人类需要将最先进的AI和加速计算技术应用于医疗行业的各个领域当中,并将在未来的整个医疗行业中广泛地感受到其所产生的影响。”

全新AI模型帮助检测COVID-19

NVIDIA还为研究人员提供了另一组用于对抗COVID-19的AI模型可以帮助研究人员通过胸部CT扫描数据检测和研究受感染患者的病情。

这组模型已在NGC 软件中心的最新版Clara 影像中上线。这组模型由NVIDIA应用研究团队与美国国家卫生研究院(NIH)的临床医生和数据科学家共同合作开发,其所采用的数据来自中国、意大利、日本和美国等COVID-19高感染率地区。

构建该组AI模型,使用到了用于医学影像的NVIDIA Clara应用框架。NVIDIA Clara包含有相关工具,可以用于特定领域的AI训练和部署,这使得NVIDIA和美国国家卫生研究院(NIH)得以在不到三周的时间内就开发出这组模型。

目前,NVIDIA和Mass Brigham正在领导着一项新的COVID-19跨国联合研究计划,该计划将新冠病毒AI模型扩展到X光影像,这样就可以在不共享任何患者数据和保护患者隐私的情况下在本地使用这组模型。

NVIDIA Clara Guardian为一线医院提供帮助

全新的NVIDIA Clara Guardian应用框架能通过将普通传感器转换为智能传感器,为医院提供其所急需的公共安全和患者监控AI解决方案生态系统。其主要用例包括:自动体温筛查、防护口罩检测、安全性社交隔离和远程患者监测。

该生态系统中的合作伙伴正在使用预先训练的模型和迁移学习技术开发和部署AI应用程序,这些AI应用程序集视觉、语音和自然语言处理于一身。借助NVIDIA EGX边缘AI平台,解决方案供应商可以在整个医院环境中安全地部署和管理大量设备。

目前,AnyVision、BriefCam、Care.ai、Chooch AI、Deep Vision、Diycam、IntelliSite、 码 隆 科 技、Ouva、SafelyYou、SAFR、SmartCow、TeiaCare、Tonbo Imaging和 Whiteboard Coordinator等数十家解决方案合作伙伴已

NVIDIA推出25G安全智能网卡(SmartNIC)

在网络连接方面,NVIDIA推出了一款高度安全且高效的25/50Gb/s以太智能网卡(Smart Network Interface Controller ,SmartNIC) ——NVIDIA MellanoxConnectX-6 Lx SmartNIC,以满足飞速增长的大规模企业和云业务的需求。

ConnectX-6 Lx是ConnectX系列网卡的第11代产品。这款产品专为满足现代化数据中心的需求而设计,25Gb/s网络正在成为各种主流应用的标准,例如企业级应用、AI和实时分析等。

这款全新的SmartNIC充分利用了软件定义和硬件加速等先进技术,将更多的安全和网络处理工作从CPU卸载到网卡上。

NVIDIA 的Mellanox网络事业部软件和NIC产品高级副总裁Amit Krig表示:“现代云和企业数据中心需要加速网络来应对扩展性和计算方面的挑战。ConnectX-6 Lx SmartNIC就是面向新一代解耦式的、可重组的数据中心的经济高效、可加速应用的和安全的智能网卡。”

包括IPsec在线加密和硬件信任根(Hardware Root of Trust)等安全加速功能,可提升10倍性能的连接追踪(Connection Tracking)功能等,实现了整个数据中心的在零信任下的安全保障(Zero Trust security)。领先的RoCE(RDMA over converged Ethernet)技术、先进的虚拟化和容器化技术,以及NVMe over Fabrics存储卸载技术等,将成为高性能可扩展网络的保障。

Mellanox ConnectX-6 Lx提供:两个25Gb/s端口或一个50Gb/s端口、从主机到网络之间采用PCIe Gen 3.0或4.0 x8。

同时Mellanox ConnectX-6 Lx的安全功能包括硬件信任根(Hardware Root of Trust)、用于有状态L4防火墙的连接追踪(Connection Tracking)技术,IPSec在线加密加速等。

GPU Direct RDMA加速技术,专为NVMe over Fabrics(NVMe-oF)存储、可扩展加速计算和高速视频传输等应用加速。

Zero Touch RoCE(ZTR)功能,可以实现了高性能RoCE网络的可扩展和易部署,且无需配置交换机。

加速交换和数据包处理(Accelerated switching and packet processing ,ASAP2)技术,内置了面向虚拟化和容器化应用的SR-IOV和VirtIO硬件卸载引擎,可加速新一代软件定义网络,以及对于防火墙服务进行连接追踪。

目前,ConnectX-6 Lx处于样品阶段,预计将在2020年第三季度全面上市。与ConnectX系列的所有产品一样,该产品兼容所有Mellanox SmartNIC软件协议栈。ConnectXSmartNIC与MellanoxSpectrum系列交换机和LinkX系列电缆和收发器一起,可为高性能网络提供最完整的端到端解决方案。

宝马集团采用NVIDIA重新定义工厂物流管理

2020年5月14日,NVIDIA与宝马集团共同宣布,宝马集团已采用全新NVIDIA Isaac机器人平台对其汽车工厂进行优化,利用先进的AI计算与可视化技术为其打造物流机器人。

此次合作重点围绕实施基于NVIDIA技术的端到端系统展开,采用基于软件架构开发、运行于NVIDIA开放式Isaac机器人软件平台的机器人,完成从训练、测试到部署的全过程。宝马集团希望借此合作优化物流工厂的流程,从而更快捷、更高效地生产定制化配置的汽车。开发完成后,该系统将在宝马集团全球范围内的工厂进行部署。

“宝马集团采用 NVIDIA Isaac机器人平台重塑其工厂物流管理流程是一次具有革命性意义的举动。” NVIDIA创始人兼首席执行官黄仁勋表示,“宝马集团引领着机器人工厂时代,利用在人工智能和机器人领域取得的突破进展,创造出下一个高度可定制、及时且有序的制造水平。”

宝马集团物流高级副总裁Jürgen Maidl表示:“宝马秉承着将选择权交给客户的原则,为不同客户提供针对各款车型,多样化功能的量身定制产品。要想在一条生产线上,生产更高质量、高度定制化的各款车型,需要端到端的先进计算解决方案。与NVIDIA的合作使我们又更强的力量推动工厂物流技术的未来发展,并最终提升宝马集团的全球客户的满意度。”

此次合作将采用NVIDIA DGX AI系统和Isaac仿真技术对机器人进行训练和测试;采用NVIDIA光线追踪GPU对合成机器零件进行渲染,以此强化训练;并采用基于高性能NVIDIA Jetson和EGX edge计算机以及Isaac软件开发套件(SDK)构建的一组全新AI机器人。

宝马集团供应链庞大,汽车工厂要从4500个供应商那里接收数百万个零件,单一零件编号数量高达23万。随着宝马集团的汽车销售在过去10年中翻了一番,达到250万辆,这些数字还会持续增长。此外,宝马集团的车辆平均为客户提供100种不同的定制化选择,意味着99%的客户订单都各有差别,这些都给工厂物流提出了巨大挑战。

为了优化这种物料流层面极高的复杂性,如今自主AI物流机器人能够协助当前流程,在同一条生产线上,组装高度定制化的车辆。

Maidl 表示: “大量定制化配置的需求从根本上来讲,在三个基础层面对宝马集团的生产提出了挑战,即计算、物流规划和数据分析。”

为了应对这些挑战,宝马集团选择与NVIDIA合作。使用NVIDIA的Isaac机器人平台开发了五款具有AI功能的机器人,来改进物流工作流程,如用于自动运输物料的导航机器人、用于选择和整理零件的操控机器人,这些机器人都采用NVIDIA Jetson AGX Xavier和EGX 边缘计算机。

基于NVIDIA Isaac SDK开发的机器人,利用大量强大的深度神经网络,可以处理感知、分割、姿势预估和人体姿势预估等计算任务,以完成感知环境、检测物体、自动导航和移动物体。这些机器人在真实数据和合成数据上进行训练,并使用NVIDIA GPU在各种光线和遮挡条件下渲染光线追踪机器部件,以增强真实数据。然后,在NVIDIA DGX系统上,基于实际数据和合成数据来训练深度神经网络。接下来,这些机器人在NVIDIA的Isaac模拟器上进行导航和操控的连续测试,并运行于NVIDIA Omniverse虚拟环境中,在该环境中,多位来自不同地区的宝马集团员工都能够在同一个仿真环境中展开工作。